stochastischeprozesse

Werbung

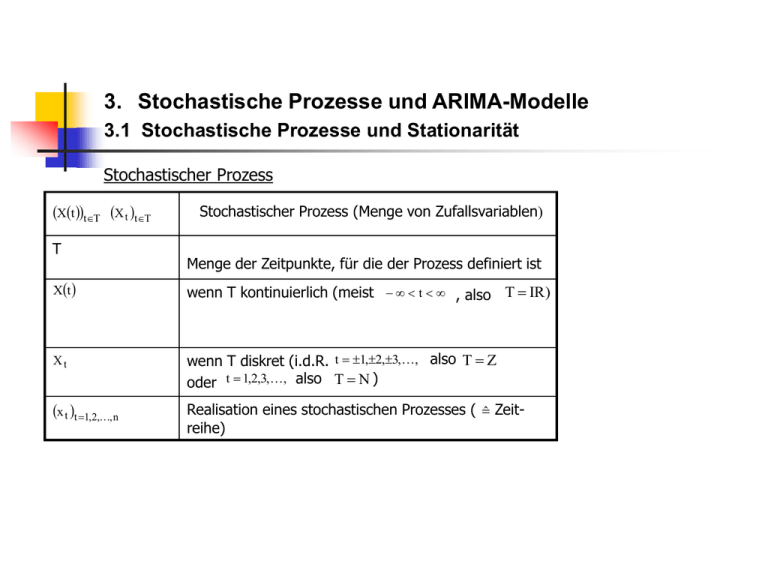

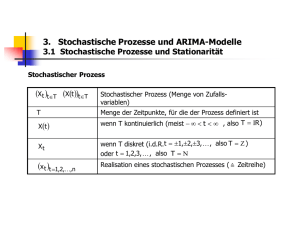

3. Stochastische Prozesse und ARIMA-Modelle 3.1 Stochastische Prozesse und Stationarität Stochastischer Prozess Xt tT X t tT T Xt Xt x t t 1,2,, n Stochastischer Prozess (Menge von Zufallsvariablen) Menge der Zeitpunkte, für die der Prozess definiert ist wenn T kontinuierlich (meist t , also T R) wenn T diskret (i.d.R. t 1,2,3,, also T oder t 1,2,3,, also T ) Realisation eines stochastischen Prozesses ( ̂ Zeitreihe) Abbildung 3.1: Stochastischer Prozess und Zeitreihe Xt,xt X t t : t t0 Zeitreihe mögliche Realisationen eines stoch. Prozesses IR Übersicht 3.1: Stochastischer Prozess und Zufallsvorgänge t fest fest variabel t variabel x t x Realisation der Zufallsvariablen X X t X x t tT Zeitreihe X t tT Zufallsvariable (zu einem best. Zeitpunkt) vollst. stoch. Prozess Definition: Ein stochastischer Prozess ist eine Folge von Zufallsvariablen, X t tT in der T die Menge der Zeitpunkte bezeichnet, für die der Prozess definiert ist. Falls T Z ist, spricht man von einem diskreten stochastischen Prozess, bei T IR von einem stetigen stochastischen Prozess. Interpretation: · Einem stochastischen Prozess liegt ein Zufallsvorgang zugrunde. Es sei ein Element des Stichprobenraums . Das Ergebnis des Zufallsvorgangs zieht somit den Wert x t der Zufallsvariablen X t X t nach sich. · Stochastischer Prozess als "ensemble" von Zeitreihen (Zeitpfaden, Trajektorien). Jedes Mitglied dieses "ensembles" (dieser Familie) ist eine mögliche Realisation eines stochastischen Prozesses. Die beobachtete Zeitreihe ist eine spezielle Realisation. Ergodizität: In der induktiven Statistik werden im Allgemeinen unabhängige und identisch verteilte Stichprobenvariablen bei der Schätzung der Parameter einer Grundgesamtheit vorausgesetzt. Es lassen sich dann i.d.R. Schätzfunktionen konstruieren, die die Konsistenzeigenschaft besitzen. Z.B. sind X und S2 konsistente Schätzer für die Parameter und 2 . In der Zeitreihenanalyse ist die Unabhängigkeitsannahme im Allgemeinen gerade nicht erfüllt. Vielmehr werden die Zeitreihenwerte als Realisationen verschiedener abhängiger Zufallsvariablen aufgefasst. Zu jedem Zeitpunkt (Periode) liegt nur eine einzige Beobachtung der betrachteten Zufallsvariablen vor. Wenn man trotzdem die n Zeitreihenwerte analog wie n Querschnittswerte zur Parameterschätzung verwenden will, müssen bestimmte Voraussetzungen erfüllt sein. Zuallererst ist zu klären, unter welchen Bedingungen das zeitliche Mittel 1 n Xn X t n t 1 gegen das Ensemble-Mittel konvergiert, d.h. eine konsistente Schätzung von durch X n möglich ist. Aufklärung hierüber geben die Ergodensätze. Die Konvergenz ist gesichert, wenn der betrachtete stochastische Prozess ergodisch ist. Wie sich zeigt, sind schwach stationäre Prozesse mit einer bestimmten Zusatzeigenschaft ergodisch. Im Falle der Mittelwertergodizität gilt z.B. 1 n lim X t 2 0, n n t 1 was bei einem (schwach) stationären stochastischen Prozess gegeben ist, wenn seine Autokovarianzfunktion absolut summierbar ist. Das Ensemblemittel lässt sich dann konsistent durch das zeitliche Mittel X n schätzen. Eine Zeitreihe ist eine spezielle Realisation aus einer i.d.R. unendlichen Menge von möglichen Realisationen von X t tT . Zu jedem Zeitpunkt liegt nur 1 Beobachtung für die Zufallsvariable Xt vor, während gewöhnlich bei statistischen Problemen mehrere Beobachtungen zur Schätzung einer Wahrscheinlichkeitsverteilung oder ihrer Charakteristiken verfügbar sind. Es werden daher zur Schätzung der gemeinsamen Wahrscheinlichkeitsverteilung von X t1 , X t 2 ,, X t n Restriktionen einzuführen sein. Eine Möglichkeit, einen stochastischen Prozess zu beschreiben, ist die gemeinsame Wahrscheinlichkeitsverteilung von X t1 , X t 2 ,, X t n für beliebige Mengen (Permutationen) von Zeitpunkten t1 , t 2 ,, t n und beliebiges n zu spezifizieren. Gemeinsame Wahrscheinlichkeitsverteilung von X t1 , X t 2 ,, X t n : x (3.1.1) x x Ft1 , t 2 ,, t n x1 , x 2 ,, x n f t1 , t 2 ,, t n 1 , 2 ,, n d1 d2 dn gemeinsame Verteilung sfunktion gemeinsame Dichtefun ktion Konsistenztheorem v. Kolmogoroff: Stoch. Prozess eindeutig, wenn man das System seiner endlich-dim. Vert.funktionen kennt. In der Praxis ist dieser Weg i.d.R. jedoch nicht gangbar. Stattdessen beschreibt man einen stochastischen Prozess durch seine Momente erster und zweiter Ordnung. Momente eines stochastischen Prozesses (Momente erster und zweiter Ordnung): Mittelwertfunktion t: (-folge) (3.1.2) t X t Varianzfunktion t : (-folge) (3.1.3) 2t Var X t Autokovarianzfunktion t ,s: (ACVF) (-folge) (3.1.4) t ,s CovX t , X s 2 X t t X s s Für die Autokorrelationsfunktion (ACF) folgt dann (3.1.5) t ,s t ,s t s (-folge) Interpretation: Die Mittelwertfolge t gibt die durchschnittliche Zeitfolge an, um die die Realisierungen des Prozesses schwanken. Mittelung über alle Zeitfolgen des "ensembles" (= Ensemblemittel). Dagegen ergibt sich bei Mittelung der einzelnen realisierten Beobachtungen über alle t das zeitliche Mittel 1 n x xt n t 1 • Die Varianzfolge 2t gibt für jeden Zeitpunkt t an, in welchem Ausmaß die Zufallsvariable X t um den Wert der Mittelwertfolge t streut. Bei einem stochastischen Prozess sind die Zufallsvariablen X ttypischerweise voneinander stochastisch abhängig. Das Hauptinteresse liegt in der Analyse der Abhängigkeitsstrukturen mittels geeigneter Modelle. Richtung und Stärke der Abhängigkeit werden mittels der Autokovarianzfolge (ACVF) t ,s und der Autokorrelationsfolge (ACF) t ,s gemessen. Streng stationärer stochastischer Prozess: (3.1.6) Ft1 , t 2 ,, t n x1, x 2 ,, x n Ft1 , t 2 ,, t n x1, x 2 ,, x n Die gemeinsame Verteilungsfunktion x t1 , x t 2 ,, x t nder Zufallsvariablen ist identisch mit der Verteilungsfunktion der um Zeitpunkte verschobenen Zufallsvariablen x t1 , x t 2 ,, x t n . Die gemeinsame Wahrscheinlichkeitsverteilung x t1 , x t 2 ,, x t n hängt also nur von den Intervallen zwischen t1 , t 2 ,, t n ab. Schwach stationärer Prozess: (3.1.7) t für alle t (3.1.8) 2t 2 (3.1.9) t ,s t s für alle t oder, wenn man t s setzt: (3.1.9‘) t ,s [Bem.: Kovarianz zwischen Xt und Xs ist nur von der zeitlichen Differenz abhängig, nicht jedoch von den Zeitpunkten.] Für die ACF folgt damit (3.1.10) t ,s t s t s 0 (3.1.10‘) t ,s 0 mit 0 2 oder mit (3.1.9) Exkurs: Trendelimination durch Differenzenbildung • Linearer Trend x t a 0 a1 t x t x t x t 1 a 0 a1 t a 0 a1 t 1 a 0 a 1t a 0 a 1t a 1 a 1 Durch Bildung der ersten Differenzen lässt sich ein linearer Trend ausschalten . • Quadratischer Trend2 x t a 0 a1 t a 2 t 2 x t x t x t 1 x t x t 1 x t 1 x t 2 x t 2x t 1 x t 2 x t x t x t 1 a 0 a1t a 2 t 2 a 0 a1 t 1 a 2 t 12 a 0 a 1t a 2 t 2 a 0 a1t a1 a 2 t 2 2 t 1 a 2 t 2 a 1 a 2 t 2 2a 2 t a 2 a 1 2a 2 t a 2 x t 1 x t 1 x t 2 a 0 a1 t 1 a 2 t 12 a 0 a1 t 2 a 2 t 2 2 a 0 a 1 t a 1 a 2 t 2 2a 2 t a 2 a 0 a 1 t 2 a 1 a 2 t 2 4 t 4 a 0 a 1 t a 1 a 2 t 2 2a 2 t a 2 a 0 a 1 t 2 a 1 a 2 t 2 4 a 2 t 4 a 2 a1 2a 2 t 3a 2 x t x t x t 1 a1 2a 2 t a 2 a1 2a 2 t 3a 2 2 2a 2 Durch Bildung der zweiten Differenzen lässt sich ein quadratischer Trend ausschalten. 3.2 Spezielle stochastische Prozesse White-Noise-Prozess Ein stochastischer Prozess U t heißt White-Noise-Prozess, wenn er die Eigenschaften i.a. wird EU t 0 gesetzt , E U t Var U t 2 und CovU t , U s 0 für t s besitzt. Beim White-Noise-Prozess werden allein die beiden ersten Momente betrachtet. Da die Autokovarianzen verschwinden, besteht keine lineare Beziehung zwischen den vergangenen, aktuellen und zukünftigen Realisationen der Zufallsvariablen ut. Das bedeutet, dass U t h , h 0 auf der Basis eines linearen Zeitreihenmodells nicht prognostiziert werden kann. Wenn allerdings höhere Momente des stochastischen Prozesses U t ungleich null sind, könnte Uggf. th unter Verwendung eines nichtlinearen Modells vorhergesagt werden. Unabhängige und identische Verteilung (i.i.d.) Eine Zufallsvariable U t ist unabhängig und identisch verteilt [independent and identically distributed (= i.i.d.)], wenn alle Terme zeitlich unabhängig sind und dieselbe Verteilung haben. Die Dichtefunktionen sind dann für alle t identisch, f t U t f U t für alle t, und die gemeinsame Dichtefunktion f1,2,,T U1, U 2 ,, U T ist dann gleich dem Produkt der T marginalen Dichtefunktionen f U t : f1,2,,T U1 , U 2 ,, U T f t U t f U t T . t 1 Die Kenntnis vergangener und aktueller Werte von Uliefert dann keine prognostisch t Uth , h 0 . verwertbaren Informationen für Martingale-Prozess Ein stochastischer Prozess X t , der die Eigenschaft (3.2.1) X t 1 X t , X t 1, X t 2 , X t besitzt, heißt Martingale-Prozess. Wenn X t der bekannte aktuelle Aktienkurs ist, dann würde für die Periode t 1 bei einem MartingaleProzess unter Kenntnis aller vergangenen Kursinformationen genau derselbe Kurs zu erwarten sein. Als "tomorrow's price" ist stets "today's price" zu erwarten. Die Verwertung vergangener Kursrealisationen führt zu keiner verbesserten Kursprognose. Vielmehr ist die beste Kursprognose im Sinne des Mean Square Errors stets einfach der aktuelle Kurs. Die Martingale-Eigenschaft lässt sich gleichwertig in der Form (3.2.2) EX t 1 X t , X t 1, X t 2 , 0 mit der "Martingale-Differenz“ X t 1 X t 1 X t darstellen. Die Martingale-Differenz hat hinsichtlich des Erwartungswerts und der Kovarianzen dieselben Eigenschaften wie der White-Noise-Prozess, doch ist die Varianz nicht notwendig konstant. Bei einer Interpretation von x t als Aktienkurs sagt die Eigenschaft (3.2.2) aus, dass die erwartete Kursänderung unter Berücksichtigung der gesamten Kurshistorie der Aktie gleich null ist. Auf bestimmten spekulativen Märkten wie z.B. auf Aktienmärkten wird ein Kapitalanleger finanzielle Mittel nur bei Erwartung einer positiven Rendite investieren. Der für die Periode t+1 erwartete Kurs (ggf. bereinigt um Dividenden, Kapitalveränderungen etc.) muss dann bei gegebenen vergangenen Kursen größer als der aktuelle Kurs sein. Lässt man die Gleichheit als Extremfall zu, dann hat man durch (3.2.3) X t 1 X t , X t 1, X t 2 , X t einen Submartingale-Prozess definiert. Die erwarteten Kurse sind hierbei stets größer oder gleich dem aktuellen Kurs. Sofern die kursrelevante Informationsmenge auf die Kurshistorie restringiert wird, sind in den Aktienkursen stets alle Informationen enthalten. Überdurchschnittliche Renditen sind daher nicht mit einem SubmartingaleProzess vereinbar. Vielmehr ist zu erwarten, dass alternative "trading rules" im Mittel keine höheren Renditen abwerfen als die einfache "buy and hold"-Strategie. Aufgrund dessen wird der (Sub-)Martingale-Prozess bei einer Anwendung auf spekulativen Märkten als eine Ausprägung eines "fair game"-Modells angesehen. Das bedeutet, dass z.B. die Investition auf einem Aktienmarkt ein faires Spiel in dem Sinne ist, dass kein Investor, der den aktuellen Kurs kennt, Vorteile gegenüber einem anderen Investor besitzt. Es gibt keine Strategien, die es ermöglichen, den Markt zu "schlagen". Bei der Definition des (Sub-)Martingale-Prozesses ist hinsichtlich der Verteilung der Zufallsvariablen X t allein eine Aussage über den (bedingten) Erwartungswert gemacht worden. Die höheren (bedingten) Momente sind dagegen unspezifiziert geblieben. So braucht z.B. bei einem (Sub-)Martingale-Prozess die bedingte Varianz nicht notwendig konstant zu sein. Allgemein sind die nichtlinearen Eigenschaften eines (Sub-)Martingale-Prozesses offen, da die bedingten Erwartungswerte X pt 1 X t , X t 1, X t 2 , für größere Werte von p nicht spezifiziert sind. Random Walk Es sei U t eine unabhängig identisch verteilte Zufallsvariable (i.i.d.) mit den Parametern Var U t 2 . Dann folgt die Zufallsvariable X t , U t 0 und (3.2.4) X t X t 1 U t einem Random Walk. Man spricht von einem Random Walk, wenn der aktuelle Wert einer Zufallsvariablen sich aus dem Vorperiodenwert plus einer Realisation einer i.i.d.-Zufallsvariablen ergibt. Auf diese Weise ergibt sich ein Zufallspfad, der nicht-stationär ist, d.h. sich beliebig von seinem Mittelwert entfernen kann. Hieraus hat sich der Begriff der Irrfahrt geprägt, die gelegentlich z.B. bei Aktienkursen und anderen spekulativen Preisen zu beobachten ist. Um den Erwartungswert und die Varianz des Prozesses zu ermitteln, setzen wir den Anfangswert X0 ohne Einschränkung der Allgemeinheit gleich null: (3.2.5) X 0 0 . Dann ergibt sich die Folge (Xt) aus X1 U1 X 2 U1 U 2 X 3 U1 U 2 U 3 (3.2.6) X t U1 U 2 U t Unter Verwendung von (3.2.6) lässt sich leicht der Erwartungswert (3.2.7) X t U1 U 2 U t U1 U 2 U t 0 ableiten. Gleichermaßen erhält man die unbekannte Varianz des Prozesses aus (3.2.8) Var X t Var U1 U 2 U t Var U1 Var U 2 Var U t t 2 unabh. [Für t , d.h. bei unendl. lang andauerndem Prozess geht die Varianz gegen unendlich.] Während der Erwartungswert eines Random Walks zeitlich konstant ist, trifft dies für seine Varianz nicht zu. Vielmehr nimmt sie mit wachsendem t zu und ist daher zeitvariabel. Der Random Walk-Prozess (3.2.4) ist daher mittelwertstationär, aber nicht varianzstationär. Wie sich zeigen lässt, ist der Random Walk (3.2.4) ebenfalls nicht kovarianzstationär. Wegen (3.2.9) Cov X t X s t 2 , 0 t s hängt seine Kovarianz wie die Varianz vom Zeitindex t ab. Die Autokorrelationsfunktion des Random Walks, (3.2.10) , t t , s ist nicht nur einesFunktion der zeitlichen Differenz |s–t|, sondern auch von den konkreten Zeitperioden t und s abhängig, für die sie betrachtet wird. Abbildung 3.2 gibt eine typische Realisation eines Random Walks in einem Zeitreihendiagramm wieder. Die im Zeitablauf zunehmende Varianz bewirkt, dass sich die Realisationen im Mittel immer weiter voneinander entfernen. Abbildung 3.2: Zeitpfad eines Random Walks Xt * * * * * * * * * * * * * * * * * * * * t Durch Differenzenbildung lässt sich der nichtstationäre Prozess X t in einen stationären Prozess X t überführen: (3.2.11) X t U t Wie aus (3.2.11) hervorgeht, ist X t ein i.i.d.-Prozess, dessen Parameter mit denen des i.i.d.ProzessesU t übereinstimmen. Der bedingte Erwartungswert X t X t 1, X t 2 ,, X1 ist unabhängig von X t 2 , X t 3 ,, X1 , X da sich modellmäßig alle Informationen bis zur Periode t–1 im Vorperiodenwert t 1 widerspiegeln: (3.2.12) X t X t 1 , X t 2 ,, X1 X t 1 U t X t 1 U t X t 1 Die Beziehung (3.2.12) kann zur Bestimmung eines Prognosewerts X̂ n ,1 für die Periode n+1 unter Berücksichtigung der gesamten Zeitreihenhistorie verwendet werden. Der Prognosewert X̂ n ,1 ist durch den bedingten Erwartungswert (3.2.13) X̂ n,1 X n 1 X n , X n 1 ,, X1 X n U n 1 X n U n 1 X n gegeben, d.h. die Ein-Schrittprognose entspricht genau dem letzten bekannten Zeitreihenwert. Analog ergibt sich der Prognosewert X̂ n,2 aus (3.2.14) X̂ n,2 ,X n 2 X n , X n 1 ,, X1 X n 1 U n 2 X n U n 1 U n 2 X n U n 1 U n 2 X n , woraus durch Verallgemeinerung leicht (3.2.15) X̂ n, h X n h X n , X n 1,, X1 X n gezeigt werden kann. Der h-Schritt-Prognosewert stimmt damit bei einem Random Walk mit dem Ein-Schritt-Prognosewert überein. Gleichwohl ist die h-Schritt-Prognose mit zunehmendem Zeithorizont mit einer immer größeren Unsicherheit behaftet. Man erkennt dies an der Varianz des Prognosefehlers. Bei der Ein-SchrittPrognose lautet der Prognosefehler e n,1 e n,1 X n 1 X̂ n,1 X n U n 1 X n U n 1 so dass seine Varianz durch Var e n,1 Var U n 1 2 gegeben ist. Der 2-Schritt-Prognosefehler e n,2 X n 2 X̂ n,2 X n U n 1 U n 2 X n U n 1 U n 2 hat dagegen die Varianz Var e n ,2 Var U t 1 U t 2 unabh. Var U t 1 Var U t 2 2 2 2 2 2 CovU , U t 1 t 2 0 Allgemein ist die Varianz eines h-Schritt-Prognosefehlers e n , h durch Var e n, h h 2 (3.2.16) gegeben, was bedeutet, dass sich der Standardfehler der Prognose (3.2.17) e h in jeder Periode um den Faktor h vergrößert. Aus Abbildung 3.3 geht die damit einhergehende Verbreiterung des Prognoseintervalls (Konfidenzintervall der Prognose) mit zunehmendem Zeithorizont hervor. Abbildung 3.3: Prognoseintervall Xt, * * * * * * * 2 e K onfidenzintervall * * * * * * X̂ n , h X n * * * * * * * * * * * * * * * * X̂ n , t * * * * n t In Gleichung (3.2.4) ist ein Random Walk ohne Drift dargestellt worden. Bei einem Random Walk ohne Drift ist z.B. die erwartete Änderung eines Aktienkurses gegeben die Informationen bis zur Periode t–1 stets gleich null: x x , x ,, x x u x t t 1 t 2 1 t 1 u t 0 t t 1 . Trendmäßig steigende Aktienkurse könnten z.B. durch Einführung eines Driftparameters in (3.2.4) berücksichtigt werden: [1] (3.2.18) x t b x t 1 u t . Gleichung (3.2.18) charakterisiert einen Random Walk mit Drift. Die bedingt erwartete Kursänderung einer Aktie würde dann genau dem Driftparameter b entsprechen: x t x t 1 , x t 2 ,, x1 b x t 1 u t x t 1 b u t b Alternative Formulierungen der Random Walk-Hypothese beziehen sich auf eine Lockerung der Annahmen hinsichtlich des Zufallsprozesses U t . Zum einen können alternativ unabhängige, aber nicht identisch verteilte Innovationen unterstellt werden. Hierunter fallen vor allem Prozesse mit heteroskedastischen Varianzen. Zum anderen wird gelegentlich die Unabhängigkeitsannahme durch die Unkorreliertheitsannahme ersetzt, was einem White-Noise-Prozess für U t impliziert. [1] Es handelt sich hierbei jedoch nicht um einen deterministischen Trend, sondern um einen stochastischen Trend, was konkreter in Kapitel 4 (Nichtstationärität und Kointegration) zu erläutern sein wird.

![Beispiel [1]](http://s1.studylibde.com/store/data/003312350_1-21765489b54a4e9a7346f43b8fcf90d0-300x300.png)