Kapitel 10 Bayes`sche Verfahren

Werbung

Kapitel 10

Bayes’sche Verfahren

10.1 Einführung

Alle bislang besprochenen Konzepte und Methoden (einschließlich der Grundstudiumsinhalte), können unter der Überschrift ”Klassische Methoden” eingeordnet werden. Es existiert ferner eine alternative Idee statistische Analysen durchzuführen. Diese Idee ist in den

sogenannten ”Bayes’schen Methoden” verankert, die eine andere Art des Denkens verfolgen, wenn es um die Gewinnung von Informationen aus Daten geht. Insbesondere ist mit

den Bayes’schen Methoden das Konzept der Apriori–Informationen verbunden, d.h. in die

Datenanalyse werden Informationen einbezogen, die bereits vor der Erhebung von Daten

vorliegen. Das Ziel der Bayes’schen Methoden ist die Kombination der beiden Informationsquellen, d.h. der Apriori–Informationen und der Daten.

Ziel dieses Abschnitts ist es, einen Einblick in die elementaren Konzepte und Vorgehensweisen der Bayes’schen Verfahren zu geben. Ein unter praktischen Gesichtspunkten bedeutender

Aspekt der Verfahren ist die Notwendigkeit der Anwendung anspruchsvoller numerischer

Verfahren. Es gibt jedoch auch einige einfache Beispiele, in denen auf rechenintensive Verfahren verzichtet werden kann, weil einfache Lösungen vorliegen. Die folgenden Ausführungen konzentrieren sich in erster Linie auf diese einfachen Fälle. Auf die komplizierteren Fälle

werden im letzten Abschnitt des Kapitel kurz angesprochen.

Eine tiefere Diskussion der Bayes’schen Idee findet man bei Lee (1997), Gelman et al. (1995)

oder Wickmann (1990). French and Smith (1997) zeigen eine Auswahl umfangreicher Fallstudien, in denen die Bayes’schen Verfahren angewendet werden.

10.2 Das Theorem von Bayes

Definition 10.1 Die Ereignisse

menge , wenn sie

a) disjunkt sind, d.h.

B1 ; B2 ; : : : ; Bk heißen eine Zerlegung der Ergebnis-

Bi \ Bj = ;

für alle i 6= j ,

b) die ganze Ergebnismenge ausschöpfen, d.h.

186

B1 [ B2 [ : : : [ Bk = .

10.2. DAS THEOREM VON BAYES

187

Beispiel 10.1 Sei = f1; 2; : : : ; 6g die Ergebnismenge beim Würfel.

a)

b)

c)

B1 = f1g B2 = f2; 3; 4g B3 = f5; 6g

B1 = f1; 2; 3g B2 = f4; 5g

ist eine Zerlegung.

ist keine Zerlegung, da B1 [ B2

6 :

=

B1 = f1; 2; 3g B2 = f3; 4; 5; 6g ist keine Zerlegung, da B1 \ B2 6= ; :

Satz 10.1 (Formel der totalen Wahrscheinlichkeit) Sei A B1 ; B2 ; : : : ; Bk eine Zerlegung der Ergebnismenge mit P (Bi)

Dann gilt

P (A) =

k

X

i=1

ein Ereignis und

> 0 für i = 1; 2; : : : k.

P (AjBi ) P (Bi ) :

Beweis:

Es gilt

A = A\

= A \ (B1 [ B2 [ : : : [ Bk )

= (A \ B1) [ (A \ B2) [ : : : [ (A \ Bk ) :

Da die Ereignisse Bi ; i = 1; 2; : : : ; k disjunkt sind, sind auch die Ereignisse A \ Bi ; i =

1; 2; : : : ; k disjunkt. Damit gilt

P (A) = P (A \ B1 ) + P (A \ B2 ) + : : : + P (A \ Bk )

= P (AjB1)P (B1) + P (AjB2)P (B2) + : : : + P (AjBk )P (Bk )

=

k

X

i=1

P (AjBi ) P (Bi) :

Dabei wurde die Definition der bedingten Wahrscheinlichkeiten

P (AjBi ) =

und die Folgerung

P (A \ Bi )

P (Bi)

P (A \ Bi ) = P (AjBi)P (Bi )

}

benutzt.

Satz 10.2 (Theorem von Bayes) Sei A ein Ereignis und B1 ; B2 ; : : : ; Bk eine Zerlegung der Ergebnismenge mit P (Bi ) > 0 für i = 1; 2; : : : k . Dann gilt

P (Bj jA) =

P (AjBj )P (Bj )

k

P

i=1

P (AjBi )P (Bi)

:

188

KAPITEL 10. BAYES’SCHE VERFAHREN

Beweis:

Durch zweimalige Anwendung der Definition der bedingten Wahrscheinlichkeit und des Satzes der totalen Wahrscheinlichkeit erhält man

P (Bj jA) =

=

P (Bj \ A)

P (A)

P (AjBj )P (Bj )

k

P

i=1

:

P (AjBi)P (Bi )

}

Beispiel 10.2 (Aus Hartung u.a., 1993)

Durch einen zu spät erkannten Fabrikationsfehler sind in einer Automobilproduktion genau 20 defekte Lenkgetriebe eingebaut worden. In einer Rückrufaktion wurden 200 000 Wagen dieser Serie

überprüft und alle als fehlerhaft identifizierten Lenkgetriebe wurden ausgetauscht. Dabei wird die

Überprüfung mit 99%-iger Sicherheit zu einem korrekten Ergebnis führen. Wie groß ist die Wahrscheinlichkeit, dass ein ausgewechseltes Lenkgetriebe auch defekt war? Wir verwenden die folgenden

Bezeichnungen:

B1

sei das Ereignis eines defekten Lenkgetriebes.

B2

sei das Ereignis eines nicht defekten Lenkgetriebes.

A

sei das Ereignis eines ausgewechselten Lenkgetriebes.

Die folgenden Informationen sind uns gegeben:

P (B1 ) =

20

= 0:0001

200 000

P (AjB1 ) = 0:99

P (AjB2 ) = 0:01

Gesucht ist die Wahrscheinlichkeit

P (B1 jA) = P (fLenkgetriebe defektgjfLenkgetriebe ausgewechselt g) :

Mit dem Theorem von Bayes folgt

P (B1 jA) =

P (AjB1 )P (B1 )

2

P

i=1

=

P (AjBi )P (Bi )

0:99 0:0001

0:99 0:0001 + 0:01 0:9999

0:0098 :

Fast alle ausgewechselten Lenkgetriebe waren demnach nicht defekt.

Beispiel 10.3 Es sei bekannt, dass in einer Familie die Großmutter und ein Sohn der Großmutter die

Bluterkrankheit (Hämophilie) haben. Die Großmutter habe auch eine Tochter, von der es unbekannt

ist, ob sie die Bluterkrankheit hat.

Wir betrachten dann die Ereignisse

B1 = fTochter hat Hämophilieg,

B2 = fTochter hat nicht Hämophilieg.

10.2. DAS THEOREM VON BAYES

Es gilt dann

189

P (B1 ) = 0:5

und

P (B2 ) = 0:5 :

Nun gebe es die zusätzliche Information, dass die Tochter zwei Söhne hat, die nicht eineiige Zwillinge

sind. Beide Söhne haben keine Hämophilie.

Wir betrachten die Ereignisse

a)

A1 = fSohn 1 hat nicht Hämopholieg,

b)

A2 = fSohn 2 hat nicht Hämopholieg,

c)

A = A1 \ A2 = fKein Sohn hat Hämopholieg.

Es gilt

P (A1 jB1 ) = 0:5 ;

P (A2 jB1 ) = 0:5 :

Da die Söhne nicht eineiige Zwillinge sind, gilt

P (AjB1 ) = P (A1 jB1 ) P (A2 jB1 ) = 0:5 0:5 = 0:25

und

P (AjB2 ) = 1 :

Wie hoch ist die Wahrscheinlichkeit, dass die Tochter (die Mutter der beiden Söhne) Hämophilie hat

(gegeben, dass beide Söhne keine Hämophilie haben)?

Gesucht ist die Wahrscheinlichkeit

P (B1 jA) :

Nach dem Theorem von Bayes gilt

P (AjB1 )P (B1 )

P (AjB1 )P (B1 ) + P (AjB2 )P (B2 )

(0:25)(0:5)

=

(0:25)(0:5) + 1 (0:5)

0:125

=

= 0:2 :

0:625

P (B1 jA) =

Für Dichtefunktion gibt es eine zum Bayes-Theorem analoge Formel. Man kann dabei an

eine stetige Zerlegung des Ergebnisraums denken.

Satz 10.3 Die gemeinsame Dichtefunktion der Zufallsvariablen

Dann gilt

f (y jx) = R1

1

f (xjy )f (y )

:

f (xjy )f (y )dy

X und Y sei f (x; y ).

190

KAPITEL 10. BAYES’SCHE VERFAHREN

Beweis:

Durch zweimalige Anwendung der Definition einer bedingten Dichtefunktion (siehe Definition 6.13) erhält man

f (y jx) =

f (x; y ) f (xjy )f (y )

= f (x) :

f (x)

Nun gilt für die Randdichtefunktion im Nenner

f (x) =

Z1

1

f (x; y )dy =

Z1

1

f (xjy )f (y )dy :

}

Damit hat man das gewünschte Ergebnis.

Wir werden das Bayes-Theorem auch in dem Fall benutzen, in dem eine Zufallsvariable, z.B.

Y , stetig und die andere diskret ist. Es gilt dann

f (y jX = x) = 1

R

1

P (fX = xgjy )f (y )

:

P (fX = xgjy )f (y )dy

(10.1)

10.3 Bayes’sche Verfahren

Beispiel 10.4 Man möchte für eine Münze die Wahrscheinlichkeit schätzen, mit der sie beim Wurf

mit ,,Kopf” auftrifft, d.h.

= P (f,,Kopf”g) :

FRAGE: Wie interpretiert man diese Wahrscheinlichkeit ?

Wir betrachten zwei mögliche Interpretationen.

a) Das klassische Verfahren interpretiert diese Wahrscheinlichkeit als relative Häufigkeit.

Die Wahrscheinlichkeit eines Ereignisses ist der Wert, gegen den die relative Häufigkeit des Ereignisses konvergiert, wenn man das Experiment unendlich oft unter gleichen Bedingungen ausführte. Diese Interpretation wird nicht von allen akzeptiert. An

dieser Vorstellung wird kritisiert, dass man solche Experimente nicht unendlich oft

durchführen kann.

b) Bei der subjektiven Interpretation von Wahrscheinlichkeiten wird ,,Wahrscheinlichkeit” als ein subjektiver Begriff aufgefasst. Er beschreibt quantitativ unsere Vorstellung, dass ein Ereignis vorkommen wird.

Man kann die Ergebnisse eines Experiments verwenden, um die bisherige Vorstellung

der Wahrscheinlichkeit eines gegebenen Ereignisses zu ändern oder zu präzisieren.

Wir betrachten das folgende EXPERIMENT:

Wir werfen dreimal eine Münze. Sei X die Anzahl der ,,Köpfe”. Wenn die drei Versuche unabhängig

sind, ist die Wahrscheinlichkeitsfunktion von X (gegeben )

P (xj) =

(

3 x

x (1

0

)3

x

x = 0; 1; 2; 3

sonst :

10.3. BAYES’SCHE VERFAHREN

191

Wir nehmen an, dass X = 2 beobachtet wurde. Wir wollen die klassische Vorgehensweise der

Bayes’schen Vorgehensweise gegenüberstellen.

a) In der typisch klassischen Vorgehensweise betrachtet man als Konstante, und X = 2 ist die

Realisation einer Zufallsvariablen. Man kann z.B. die Maximum-Likelihood-Methode verwenden, um zu schätzen, d.h. es ist

!

3 2

L(; X = 2) =

(1 )3

2

2

zu maximieren. Dies führt zum Schätzer

2

^ = :

3

Würden Sie diesem Wert glauben? Oder etwa dem noch extremeren Wert

^ = 1

X=3?

falls

b) In der typischen Bayes’schen Vorgehensweise ist wohl eine Konstante, aber sie ist unbekannt.

Das Ergebnis X = 2 ist bekannt. Bevor man das Experiment durchführt, hat man eine Vorstellung des Wertes von . Diese Vorstellung kann man als Apriori-Dichtefunktion darstellen,

etwa wie in Abbildung 10.1.

2.0

f(π)

1.5

1.0

0.5

0.0

0.0

0.5

1.0

π

Abbildung 10.1: Apriori-Verteilung von (subjektive Vorstellung)

Dabei wird als Zufallsvariable betrachtet. Wir wissen, dass X , gegeben , binomialverteilt

ist, d.h.

!

3 2

P (fX = 2gj) =

(1 )3 2 :

2

Wir können jetzt das Theorem von Bayes verwenden, um unsere Apriori-Vorstellung (d.h.

unsere Vorstellung vor der Durchführung des Experiments) von der Verteilung von zu präzisieren. Jetzt haben wir den Fall, dass eine Zufallsvariable (X ) diskret ist, während die andere

( ) stetig ist. Nach Formel (10.1) gilt, wenn f ( ) die Dichtefunktion der Apriori-Verteilung

von bezeichne,

f (jX = 2) =

R1

0

P (fX = 2gj)f ()

P (fX = 2gj)f ()d

:

192

KAPITEL 10. BAYES’SCHE VERFAHREN

Das ist die bedingte Dichtefunktion von , gegeben X = 2. Sie enthält also unser korrigiertes Wissen über die Verteilung von nach Durchführung des Experiments. Sie heißt die

Posteriori-Verteilung von (gegeben die Beobachtungen).

Abbildung 10.2 verdeutlicht den Zusammenhang zwischen Apriori- und Posteriori-Verteilung.

Vor der Beobachtung haben wir nur eine vage Vorstellung über die Verteilung des Parameters

. Mit Hilfe eines Modells (hier die Binomialverteilung) und der Beobachtungen wird diese

vage Vorstellung zu einer genaueren Posteriori-Vorstellung über den Parameter präzisiert. Diese Vorstellung soll durch die Stärke des Grautons in den Abbildungen unterstrichen werden.

Apriori

Posteriori

8

8

6

Beobachtungen

f(π)

f(π)

6

4

Modell

2

0

4

2

0

0.0

0.2

0.4

π

0.6

0.8

1.0

0.0

0.2

0.4

π

0.6

0.8

1.0

Abbildung 10.2: Apriori-Verteilung und Posteriori-Verteilung von Die eben geschilderte Vorgehensweise bei den Bayes’schen Verfahren wirft die beiden folgenden Probleme auf:

1.) Wie soll man die Apriori-Verteilung bestimmen?

2.) Wie berechnet man die Posteriori-Verteilung?

Das erste Problem ist ein Hauptkritikpunkt an den Bayes’schen Verfahren. Die subjektive

Bestimmung der Apriori-Verteilung gilt als unwissenschaftlich. Das zweite Problem kann

sehr kompliziert sein. Es geht darum, das Integral

Z1

0

P (fX = 2gj )f ( )d

zu bestimmen. Das Problem ist jedoch leicht zu lösen, wenn man für die Apriori-Verteilung

eine Verteilung verwendet die zu einer leicht integrierbaren Funktion führt, wenn man sie

mit P (fX = 2gj ) multipliziert, d.h. die Apriori-Verteilung muss in geeigneter Weise zu der

Binomialverteilung passen. Das Problem ist dann leicht zu lösen, wenn man eine konjugierte

Verteilung für f ( ) verwendet.

Die Definition einer konjugierten Verteilung werden wir später betrachten. Jetzt sei gesagt,

dass die Beta-Verteilung die konjugierte Verteilung einer Binomialverteilung ist, d.h. das

zweite Problem ist einfach zu lösen, wenn wir für die Apriori-Verteilung von eine Betaverteilung verwenden.

Wir nehmen also an, dass

Be(; ) ;

10.3. BAYES’SCHE VERFAHREN

d.h.

f ( ) =

(

193

1

1 (1

B (; ) 0

)

1

0<<1

sonst :

Abbildung 10.3 zeigt einige Beta-Apriori-Verteilungen.

12

Be(100,100)

10

f(π)

8

Be(50,20)

6

4

2

Be(10,10)

0

0.0

0.2

0.4

0.6

0.8

1.0

π

Abbildung 10.3: Einige Beta-Apriori-Verteilungen

Wir nehmen auch weiterhin an, dass

X j b(n; ) :

Dann ist

f ( jX = x) =

R1

0

P (fX = xgj )f ( )

P (fX = xgj )f ( )d

:

Das Integral im Nenner ist

Z1

0

P (fX = xgj )f ( )d =

=

Z1

0

!

n x

1 (1 ) 1

(1 )n x

d

x

B (; )

!

1

n

1 Z x+ 1(1 )n

x B (; ) 0

|

=

!

x+ 1 d

{z

B (+x; +n x)

}

n B ( + x; + n x)

:

x

B (; )

(Beachten Sie, dass wir dieses Integral schon in Kapitel 12 bei der Herleitung der BetaBinomial-Verteilung berechnet haben. Es handelt sich um die Bestimmung einer Mischverteilung. Die Binomialverteilung wird gemäß einer Betaverteilung gemischt.)

Damit ist die Posteriori-Dichte

f ( jX = x) =

n x (1 )n x 1 (1

x n B ( + x; + n

x

x

+

1 (1 )n x+ 1

= B ( + x; + n x) ;

) 1 =B (; )

x)=B (; )

194

KAPITEL 10. BAYES’SCHE VERFAHREN

d.h. die Posteriori-Verteilung von gegeben X

tern + x und + n x, d.h.

= x ist eine Betaverteilung mit den Parame-

jX Be( + x; + n x) :

(10.2)

Wir haben gesehen, dass die Posteriori-Verteilung zu der gleichen Familie von Verteilungen

gehört wie die Apriori-Verteilung.

Beispiel 10.5 Nehmen wir Be(10; 10) als Apriori-Verteilung an und, dass wie in Beispiel 10.4 n =

3 und X = 2 beobachtet wurde. Die Posteriori-Verteilung ist dann

Be(10 + 2; 10 + 3 2) = Be(12; 11) :

Abbildung 10.4 zeigt die Apriori und Posteriori Verteilung.

4

Posteriori: B(12,11)

f(π)

3

Apriori: B(10,10)

2

n=3; x=2

1

0

0.0

0.2

0.4

0.6

0.8

1.0

π

Abbildung 10.4: Apriori-Verteilung (Be(10;10)) und Posteriori-Verteilung (Be(12;11))

Hätten wir Be(100; 100) als Apriori-Verteilung verwendet, so wäre die Posteriori-Verteilung Be(102; 101).

Die beiden Verteilungen sind kaum zu unterscheiden.

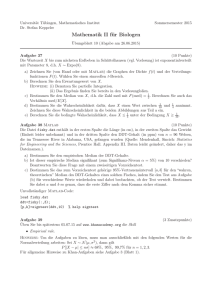

Beispiel 10.6 Nehmen wir an, dass n = 100 und X = 30 beobachtet wurde. Die Apriori-Verteilung

sei Be(100; 100). Die Posteriori-Verteilung wäre dann Be(130; 170). Abbildung 10.5 zeigt diese

beiden Verteilungen, während Abbildung 10.6 die Apriori- und Posteriori-Verteilungen für den Fall

n = 1 000 und x = 300 zeigt. Besonders die Abbildung 10.6 zeigt, dass die Apriori-Vorstellung

durch die Beobachtungen sehr stark korrigiert wird.

Zusammenfassend lässt sich sagen:

a) Die Posteriori-Verteilung hängt von

i) der Apriori-Verteilung und

ii) dem Ergebnis x ab.

b) Mit zunehmender Stichprobeninformation (hier n) wird der Einfluss der Apriori-Verteilung

immer geringer.

10.3. BAYES’SCHE VERFAHREN

195

14

Posteriori: B(130,170)

12

f(π)

10

Apriori: B(100,100)

8

6

4

n=100; x=30

2

0

0.0

0.2

0.4

0.6

0.8

1.0

π

Abbildung 10.5: Apriori-Verteilung (Be(100;100)) und Posteriori-Verteilung (Be(130;170))

30

Posteriori: B(400,800)

25

f(π)

20

n=1000; x=300

15

10

Apriori: B(100,100)

5

0

0.0

0.2

0.4

0.6

0.8

1.0

π

Abbildung 10.6: Apriori-Verteilung (Be(100;100)) und Posteriori-Verteilung (Be(400;800))

Bei den Bayes’schen Verfahren setzt man die Beobachtungen X = x ( z.B. X = 2 in

Beispiel 10.4) als bekannt voraus. Unbekannt sind die oder der Parameter ( in Beispiel

10.4).

Die gemeinsame Verteilung der Beobachtungen und der unbekannten Parameter wird in der

folgenden Weise angegeben

f (; x) = f (xj)f ()

falls X stetig ist.

Dabei ist f (xj ) die Verteilung der Beobachtungen bei gegebenem .

Man berechnet dann die bedingte Verteilung der unbekannten Parameter, gegeben die bekannten Beobachtungen. Dafür verwendet man das Theorem von Bayes.

f (jX = x) = 1

R

1

f (xj)f ()

:

f (xj)f ()d

Ist X eine diskrete Zufallsvariable, so ist die folgende Gleichung zu verwenden.

(10.3)

196

KAPITEL 10. BAYES’SCHE VERFAHREN

f (jX = x) = R1

1

P (xj)f ()

:

P (xj)f ()d

(10.4)

Definition 10.2 Sei f (xj ) die bedingte Dichtefunktion der Zufallsvariablen X bei gegebenem Parameter und f ( ) die Apriori-Verteilung des Parameters . Die PosterioriVerteilung von , gegeben X = x ist dann durch Gleichung (10.3) gegeben. Ist X eine

diskrete Zufallsvariable mit der Wahrscheinlichkeitsfunktion P (xj ), so ist die PosterioriVerteilung von , gegeben X = x durch Gleichung (10.4) gegeben.

Wir wollen jetzt besprechen, wie man die Posteriori-Verteilung einfach bestimmen kann,

wenn man konjugierte Verteilungen verwendet.

Definition 10.3 Die Verteilung f ( ) heißt die (natürliche) konjugierte Verteilung für

f (xj), wenn f (jx) und f () dieselbe Form haben, d.h. wenn die Apriori- und

Posteriori-Verteilung zu derselben Familie von Verteilungen gehören.

Beispiel 10.7 Die Betaverteilung ist die konjugierte Verteilung für den Parameter = einer Bi-

nomialverteilung. Wir hatten weiter oben angenommen, dass die bedingte Verteilung von X gegeben

eine Binomialverteilung ist, d.h.

X j b(n; ) :

Als Apriori-Verteilung von hatten wir eine Betaverteilung angenommen, d.h.

Be(; ) :

Wir konnten zeigen, dass die bedingte Verteilung von gegeben

(siehe Gleichung (10.2)

X eine Betaverteilung ist, genauer

jX = x Be( + x; + n x) :

Die Apriori-Dichte f ( ) und die Posteriori-Dichte f ( jX

= x) sind jeweils Betaverteilungen.

Wie verwendet man die Posteriori-Verteilung? Der Modalwert kann als Schätzer des Parameters aufgefasst werden. Mit Hilfe der Verteilung kann ein Vertrauensbereich für den

Parameter angegeben werden.

Betrachten wir die Situation in Abbildung 10.5. Die Posteriori-Verteilung ist die Betaverteilung mit

den Parametern 130 und 170. Sie hat den Modalwert an der Stelle (130 1)=(300 2) = 0:43, d.h.

^ = 0:43 schätzen. Um einen 90%-Vertrauensbereich zu bestimmen, berechnet

man würde durch man mit Hilfe der Umkehrfunktion der Verteilungsfunktion den 5%- und 95%-Punkt der Betaverteilung. In diesem Fall ergibt sich das Intervall (0:387; 0:481).

10.3. BAYES’SCHE VERFAHREN

197

Beispiel 10.8 Die Gammaverteilung ist die konjugierte Verteilung für den Parameter einer Poissonverteilung.

Sei X j poissonverteilt mit dem Parameter , d.h.

P (fX = xgj) =

(

x e x!

für x = 0; 1; 2; : : :

sonst :

0

Die Apriori-Verteilung von sei eine Gammaverteilung, d.h.

G( ; ) ;

d.h.

8

<

f () = :

1 e

( )

0

Dann ist die Posteriori-Verteilung von , gegeben X

f (jX = x) = 1

R

0

0

sonst :

=x

P (fX = xgj)f ()

:

P (fX = xgj)f ()d

Wir bestimmen zunächst den Zähler dieses Ausdrucks und bemerken, dass der Nenner das Integral

über den Ausdruck im Zähler ist.

P (fX = xgj)f () =

x e

x!

1

(e)

=

x+ 1

e

x! ( )

(1+)

(10.5)

Den Nenner hatten wir bereits in Kapitel 9 bestimmt, als wir die Mischung der Poissonverteilung

bezüglich der Gammaverteilung betrachtet haben (siehe Seite 178). Als Zwischenergebnis hatten wir

dort erhalten:

Z1

0

P (X = xj)f ()d =

(x + )

:

x! ( )(1 + )x+

(10.6)

Dividieren wir Gleichung (10.5) durch Gleichung 10.6, so erhalten wir:

f (jX = x) =

( + 1) +x +x 1 e

( + x)

(+1)

;

d.h. die Dichtefunktion einer Gammaverteilung mit den Parametern + x und + 1.

Wir fassen das Ergebnis des letzten Beispiels in folgendem Satz zusammen.

Satz 10.4 Die Zufallsvariable X sei bei gegebenem poissonverteilt mit dem Parameter

(d.h. X j P o()). Die Aprioriverteilung von sei G( ; ). Dann ist die PosterioriVerteilung von , gegeben die Beobachtung x

G( + x; + 1) :

198

KAPITEL 10. BAYES’SCHE VERFAHREN

Wir können dieses Verfahren auf die folgende Weise verallgemeinern:

Wenn man zwei Beobachtungen hat, wird die Posteriori-Verteilung nach Betrachtung

der ersten Beobachtung als Apriori-Verteilung für den zweiten Schritt verwendet (siehe Abbildung 10.7).

Apriori

Posteriori

0.30

0.30

0.25

0.25

Beobachtung:

0.20

0.15

0.20

0.15

0.10

x1=6

0.05

0.10

0.05

0.0

0.0

0

5

10

15

µ

20

25

30

0

5

Apriori

10

15

µ

20

25

30

Posteriori

0.30

0.30

0.25

0.25

Beobachtung:

0.20

0.15

0.20

0.15

0.10

x2=4

0.05

0.10

0.05

0.0

0.0

0

5

10

15

µ

20

25

30

0

5

Apriori

10

15

µ

20

25

30

Posteriori

0.30

0.30

0.25

0.25

Beobachtung:

0.20

0.15

0.20

0.15

0.10

x3=8

0.05

0.10

0.05

0.0

0.0

0

5

10

15

µ

20

25

30

0

5

10

15

µ

20

25

30

Abbildung 10.7: Apriori und Posteriori-Verteilungen nach Eingang von neuen Beobachtungen

Wenn man drei oder mehr Beobachtungen hat, führt man das einfach weiter.

Seien x1 ; x2 ; ; xn unabhängige Beobachtungen aus einer Poissonverteilung mit unbekanntem Parameter . Sei G( ; ).

Apriori-Verteilung

Beobachtung

Posteriori-Verteilung

..

.

..

.

..

.

G( ; )

G( + x1 ; + 1)

x1

x2

G( + x1 + + xn 1 ; + n 1) xn

G( + x1 ; + 1)

G( + x1 + x2 ; + 2)

G( +

n

P

i=1

xi ; + n)

10.3. BAYES’SCHE VERFAHREN

199

Beispiel 10.9 Wie bisher sei die Zufallsvariable bei bekanntem poissonverteilt mit dem Parameter

. Die Apriori-Verteilung von sei

G(1; 0:1) :

Es seien die folgenden Beobachtungen gegeben:

9; 7; 13; 10; 6

Die Anzahl der Beobachtungen ist 5, die Summe der Beobachtungen ist 45. Dann ist die PosterioriVerteilung

G(1 + 45; 0:1 + 5) :

Abbildung 10.8 zeigt die Apriori- und die Posteriori-Verteilung.

Apriori

0.35

Posteriori

0.35

0.30

0.30

0.25

0.25

Beobachtungen:

f(µ )

0.20

f(µ )

0.20

0.15

0.15

x1+x2+x3+x4+x5=45

0.10

0.10

0.05

0.05

0.0

0.0

0

10

20

µ

30

40

0

10

20

µ

30

40

Abbildung 10.8: Apriori- (G(1; 0:1)) und Posteriori-Verteilung (G(46; 5:1))

Bei n unabhängigen Beobachtungen x1 ; x2 ; ; xn hat man die Posteriori-Verteilung

G( +

n

X

i=1

xi ; + n) :

Beispiel 10.10 Die Zufallsvariable X sei exponentialverteilt mit dem Parameter , d.h.

f (xj) =

(

e x

0

x0

sonst :

Der Parameter besitze eine Gammaverteilung mit den Parametern und , d.h.

G( ; ) ;

d.h.

8

<

f ( ) = :

1 e

( )

0

0

sonst :

Man kann dann zeigen (es sei Ihnen als Übung empfohlen), dass die Posteriori-Verteilung von

gegeben die Beobachtung X = x wieder eine Gammaverteilung ist, und zwar

jx G( + 1; + x) :

200

KAPITEL 10. BAYES’SCHE VERFAHREN

Die Gammaverteilung ist also die konjugierte Verteilung für die Exponentialverteilung. Nach Eingang

der Beobachtungen x1 ; x2 ; : : : ; xn ist die Posterioriverteilung

G( + n; +

n

X

i=1

xi ) :

n

P

als Hazardrate und T = xi

i=1

total time on test. Die Dichtefunktion von , gegeben die Beobachtungen x1 ; x2 ; : : : ; xn ist dann

In der Zuverlässigkeitstheorie bezeichnet man den Parameter

f (jx1 ; x2 ; :::; xn ) =

(

1

+n +n 1 e (+T )

( ) ( + T )

0

0

sonst

als

:

Man kann dann schätzen durch den Erwartungswert dieser Verteilung, d.h durch

( + n)=( + T ) :

In der Zuverlässigkeitstheorie wird es häufig als gefährlich angesehen, wenn die Hazardrate einen

bestimmten Wert 0 übersteigt. Diese Wahrscheinlichkeit kann durch Integation der Posteriori-Dichtefunktion von bestimmt werden.

Unsere bisherigen Resultate können wir so zusammenfassen:

a) Die Betaverteilung ist die konjugierte Verteilung für die Binomialverteilung.

Apriori-Vert.

Modell

Be(; ) X j b(n; )

Beobacht.

X=x

Posteriori-Vert.

jX = x Be( + x; + n x)

b) Die Gammaverteilung ist die konjugierte Verteilung für die Poisson-Verteilung.

Apriori-Vert.

Modell

G( ; ) X j P0 ()

Beobacht.

X =x

Posteriori-Vert.

jX G( + x; + 1)

c) Die Gammaverteilung ist die konjugierte Verteilung für die Exponentialverteilung.

Apriori-Vert.

G( ; )

Modell

Beobacht.

X j Exp() X = x

Posteriori-Vert.

jX G( + 1; + x)

Nachdem wir unsere Verteilung über den Parameter durch die Posteriori-Verteilung korrigiert haben, wollen wir uns fragen:

Wie sind weitere zukünftige Werte der Zufallsvariablen X verteilt?

Definition 10.4

Die prädiktive Verteilung von

X.

X ist die Randverteilung eines zukünftigen Wertes von

10.3. BAYES’SCHE VERFAHREN

201

Satz 10.5

Die prädiktive Verteilung einer binomialverteilten Zufallsvariablen (X b(n; )), deren

Parameter betaverteilt (Be(; )) ist, ist die Beta-Binomialverteilung mit den Parametern n

~ ; + x und + n x. Dabei ist x der zuvor beobachtete Wert von X und n~ ist die

Anzahl der weiteren Bernoulli-Experimente.

Bevor wir diesen Satz beweisen, wollen wir die Situation in der folgenden Übersicht zusammenfassen:

Apriori

Be(; )

Modell

X j b(n; )

Posteriori

jX Be( + x; + n x)

Die Apriori-Vorstellungen über den Parameter seien in einer Betaverteilung ausgedrückt.

Das Modell für die Beobachtungen bei gegebenem Parameter sei eine Binomialverteilung.

Nach Eingang von Beobachtungen wird die Apriori-Vorstellung über in eine PosterioriVorstellung über modifiziert. Dies ist wieder eine Betaverteilung. Die Frage, die Satz 10.5

beantwortet, ist die nach der Verteilung weiterer zukünftiger Werte unter Berücksichtigung

der bisher gewonnenen Erkenntnisse.

Es werden weitere n

~ Bernoulli-Versuche durchgeführt. Sei

diesen weiteren Versuchen. Die Behauptung des Satzes ist

X~ die Anzahl der Erfolge in

X~ Beta-Binomial(~n; + x; + n x) :

Beispiel 10.11 Wir betrachten das Münzwurfexperiment aus Beispiel 10.4.

Be(; )

z.B. Be(5; 5)

X j b(n; )

z.B. b(3; )

jX Be( + x; n x + ) Be(7; 6) (falls x = 2)

~ -mal. Sei X~ die Anzahl der ,,Köpfe” in diesen weiteren Versuchen.

Wir werfen die Münze noch n

~ . Sie heißt die prädiktive Verteilung.

Gesucht ist die Verteilung von X

Apriori-Verteilung

Modell

Posteriori-Verteilung

Wie groß ist z.B.

P (fX~ = x~gjx = 2) ?

Es ist

X~ j b(~n; ) :

Aber ist nicht bekannt.

Beweis des Satzes:

P (fX~ = x~gjX = x) =

=

Z1

0

Z1

0

P (fX~ = x~gjX = x; )f ( jx)d

!

n~ x~

+x 1 (1 )+n x 1

(1 )n~ x~

d

x~

B ( + x; + n x)

202

KAPITEL 10. BAYES’SCHE VERFAHREN

=

=

!

1

Z

n~

1

+x+~x 1 (1 )+n

x~ B ( + x; + n x) 0

!

n~ B ( + x + x~; + (n x) + (~n x~))

x~

B ( + x; + n x)

Das ist die Beta-Binomialverteilung mit den Parametern n

~ ; + x und + n

x 1+~n x~ d

x.

}

Beachten Sie, dass wir wieder die Mischverteilung einer Binomialverteilung bezüglich einer Betaverteilung berechnet haben (siehe Herleitung der Beta-Binomialverteilung auf Seite

175).

Beispiel 10.12 Wir betrachten folgende Situation:

Die Apriori-Verteilung des Parameters einer Binomialverteilung sei eine Be(5; 5)-Verteilung.

In n = 3 Versuchen wurden X

= 2 Erfolge beobachtet, d.h. x = 2.

Die Posteriori-Verteilung des Parameters ist dann eine Be(7; 6)-Verteilung.

Es werden n

~ = 5 weitere Bernoulli-Versuche durchgeführt. Gesucht ist die prädiktive Vertei~ , der Anzahl der Erfolge in diesen fünf weiteren Versuchen.

lung von X

~ Beta-Binomial-verteilt mit den Parametern

Nach Satz 10.5 ist X

(~n; + x; + n x) = (5; 5 + 2; 5 + 3 2) :

0.30

0.25

0.20

0.15

0.10

0.05

0.0

0

1

2

3

4

5

Abbildung 10.9: Prädiktive Verteilung: Beta-Binomial (5; 7; 6)

~.

Abbildung 10.9 zeigt die Wahrscheinlichkeitsfunktion der prädiktiven Verteilung von X

Beispiel 10.13 Wir wollen jetzt die prädiktive Verteilung einer poissonverteilten Zufallsvariablen,

deren Parameter gammaverteilt ist, bestimmen, d.h. wir gehen von der folgenden Situation aus:

Die Apriori-Verteilung des Parameters einer Poissonverteilung sei G( ; ).

Die bedingte Verteilung von X , gegeben , sei P o().

10.3. BAYES’SCHE VERFAHREN

203

Es liegen die Beobachtungen x1 ; x2 ; :::; xn vor.

Die Posteriori-Verteilung des Parameters nach den Beobachtungen ist

n

X

G( + xi ; + n) :

i=1

Abbildung 10.10 zeigt eine mögliche Posteriori-Verteilung.

0.4

0.3

0.2

0.1

0.0

0

5

10

15

20

Abbildung 10.10: Dichte f (jx) der Posteriori-Verteilung von .

FRAGE: Welche Verteilung besitzt die nächste Beobachtung, d.h. welches ist die prädiktive Verteilung?

~ die nächste Beobachtung. Die bedingte Verteilung von X~ gegeben ist die Poissonverteilung

Sei X

mit dem Parameter , d.h.

e P (fX~ = x~gj) = x~

;

x~ = 0; 1; 2; : : : :

x~!

Die (aktuelle) Verteilung von ist

f (jx) =

wobei zur Vereinfachung der Schreibweise

n

X

0 = +

i=1

0 0

0

(0 ) 1 e ;

( 0 )

xi

und

0 = + n

gesetzt wurde.

Es ist folgendes Integral zu bestimmen:

P (fX~ = x~g) =

Z1

0

P (fX~ = x~gj)f (jx)d ;

d.h. es ist die Mischung einer Poissonverteilung bezüglich einer Gammaverteilung zu bestimmen. Als

Lösung erhalten wir die Wahrscheinlichkeitsfunktion der negativen Binomialverteilung (siehe Seite

178) mit den Parametern ( 0 ; 0 =(0 + 1)).

Wir formulieren das Ergebnis als Satz

204

KAPITEL 10. BAYES’SCHE VERFAHREN

Satz 10.6 Die prädiktive Verteilung der Poissonverteilung, deren Parameter gammaverteilt ist, ist eine negative Binomialverteilung.

Wir betrachten abschließend in diesem Abschnitt die Normalverteilung für den Fall, dass

die Varianz 2 bekannt ist. Der unbekannte Parameter ist der Erwartungswert , so dass ein

Modell für die Beobachtungen durch

X j N (; 2 ) :

beschrieben werden kann. Es gilt dann:

Satz 10.7 Die konjugierte Verteilung für den Parameter der Normalverteilung ist die

Normalverteilung.

Zunächst wird der Fall betrachtet, bei dem eine Apriori–Verteilung durch eine Beobachtung

präzisiert wird. Sei N (0 ; 02 ) die Apriori–Verteilung und x die Beobachtung, dann ist

die Posteriori–Verteilung durch jx N (1 ; 12 ) mit

1 = 0 + (x 0 )

02

2 + 02

und

1 = 1+ 1

12 02 2

gegeben.

Zunächst wird der Erwartungswert 1 der Posteriori–Verteilung betrachtet. Dieser stellt einen

Kompromiss zwischen dem Erwartungswert der Apriori–Verteilung und der Beobachtung

dar: Das Ausmaß der Aktualisierung hängt davon ab, wie weit der ursprünglich angenommene Erwartungswert und die Beobachtung auseinander liegen. Ferner ist zu erkennen, dass

die Varianz der Posteriori–Verteilung in jedem Fall kleiner ist als die der Apriori–Verteilung.

In der oben gegebenen Formel wird der Kehrwert der Varianz verwendet, der als Präzision der Verteilung interpretiert werden kann. Wie zu sehen ist, steigt die Präzision um den

Summand 1= 2

Beispiel 10.14 Angenommen es liegt eine Apriori–Verteilung Beobachtung x = 10 gemacht. Sei ferner 2 =

gegebenen Formeln für die Posteriori–Verteilung:

N (1; 4) vor und es wird eine

8, dann erhält man durch Anwendung der oben

jx N (4; 8=3)

Vergleicht man dieses Ergebnis mit dem Fall, in dem eine Beobachtung gemacht wird, die näher am

Erwartungswert der Apriori–Verteilung liegt, erkennt man dass die Posteriori– Verteilung im ersten

Fall stärker von der Apriori–Verteilung abweicht. Wäre beispielsweise x = 2 beobachtet worden, so

lautete die Posterioriverteilung jx N (4=3; 8=3).

Bemerkenswert ist auch, dass die Verringerung der Varianz unabhängig von der Beobachtung ist. Dies

gilt allerdings nur für den hier betrachteten Fall einer bekannten Varianz.

10.4. BEMERKUNGEN ZU KONJUGIERTEN VERTEILUNGEN

205

Es wird jetzt der Fall betrachtet, bei dem eine Apriori–Verteilung durch n Beobachtungen

präzisiert wird. Sei N (0 ; 02 ) die Apriori–Verteilung und x1 ; : : : ; xn die Beobachtungen, dann ist Posteriori–Verteilung durch jx1 ; : : : ; xn N (n ; n2 ) mit

n = 0 + (x 0 )

02

2 =n + 02

und

1 = 1+n

n2 02 2

gegeben. Der Erwartungswert der Posteriori–Verteilung ist jetzt ein Kompromiss zwischen

dem Erwartungswert der Apriori–Verteilung und dem Mittelwert der Beobachtungen. Ferner

ist zu sehen, dass die Varianz mit zunehmender Anzahl von Beobachtungen kleiner wird.

Mit Hilfe der Posteriori–Verteilung kann jetzt die prädiktive Verteilung beschrieben werden:

Satz 10.8 Die prädiktive Verteilung einer Normalverteilung, deren Parameter

falls normalverteilt ist, lautet:

eben-

X~ N (n ; 2 + n2 ) :

Beispiel 10.15 Angenommen es liegt eine Apriori–Verteilung N (1; 4) vor und es werden zwei

Beobachtungen gemacht: Beobachtung x1 = 11 und x2 = 1. Sei ferner 2 = 8, dann erhält man

durch Berechnung der oben gegebenen Formeln für die Posteriori–Verteilung:

jx N (3; 2)

und die prädiktive Verteilung ist:

X~ N (3; 10) :

Im Fall der Normalverteilung ist es auch denkbar, dass der Parameter bekannt ist und die

Varianz durch eine Verteilung beschrieben wird. Die konjugierte Verteilung der Varianz einer

Normalverteilung (bei bekanntem Erwartungswert) ist die inverse 2 –Verteilung (siehe dazu

Lee, 1997, Appendix A.5). Der Fall unbekannter Varianz ist kompliziert und wird daher im

Rahmen dieser Veranstaltung nicht näher diskutiert. Für Interessierte sei auf Lee (1997, Kap.

2.7) oder Gelman et al. (1996, S. 46–48) verwiesen.

10.4 Bemerkungen zu konjugierten Verteilungen

Bei den Bayes’schen Verfahren beschreibt die Apriori–Verteilung das Wissen eines ”Experten” über den Parameter. Die Verwendung der konjugierten Verteilung (wegen der einfachen

mathematischen Handhabbarkeit) schränkt die Freiheit, seine Vorstellungen über den Parameter zu quantifizieren, ein. Somit ist es beispielsweise möglich, dass man weiß, dass ein

Anteil einer Grundgesamtheit größer ist als 0.1. Die konjugierte Verteilung für die Binomialverteilung ist die Betaverteilung, für die aber in jedem Fall P ( < 0:1) > 0 gilt.

Mit anderen Worten gibt es keine Betaverteilung, die in der Lage ist, das Wissen über den

Parameter korrekt wiederzugeben.

206

KAPITEL 10. BAYES’SCHE VERFAHREN

Auf der anderen Seite sind die in der Praxis verwendeten konjugierten Verteilungen flexibel

genug um eine Verteilung zu bestimmen, die sehr nah an den Apriori–Vorstellungen liegt.

Findet man aber keine Verteilung zur Beschreibung des Parameterwissens, kann man die

Bayes’schen Verfahren trotzdem anwenden, wenngleich damit ein höherer Rechenaufwand

(Einsatz numerischer Verfahren) erforderlich wird. Im folgenden Beispiel wird das Vorgehen

für diesen Fall erläutert.

Beispiel 10.16 Betrachtet wird eine Binomialverteilung mit unbekannter Erfolgswahrscheinlichkeit

(beispielsweise ”Kauft ein Produkt”, ”besitzt ein Auto”,. . . ). Sei die Apriori–Verteilung durch

8

>

<

f ( ) = >

:

100( 0:4) 0:4 < 0:5

100(0:6 ) 0:5 0:6

0

sonst

0

2

4

f(π)

6

8

10

gegeben. Die Dichte ist in Abbildung 10.11 dargestellt.

0.40

0.45

0.50

0.55

0.60

π

Abbildung 10.11: Apriori-Verteilung von (subjektive Vorstellung)

Zur Präzisierung der Apriorivorstellung wird nun eine Stichprobe der Größe n gezogen und die Anzahl der Erfolge sei mit x bezeichnet. (Die Stichprobe wurde mit Zurücklegen gezogen, so dass x

als binomialverteilt betrachtet werden kann.) Unter diesen Bedingungen ist die Posteriori–Verteilung

durch

!

n x

f (jx) = (1 )n x f ()

x

gegeben, wobei eine Normierungskonstante darstellt, die gewährleistet, das die Fläche unter der

Posteriori–Verteilung eins ist. Man erhält die Konstante durch Berechnung des Integrals

1= =

+

0R:5

0:4

0R:6

0:5

n x (1

x

)n x 100(

n x (1

x

)n x 100(0:6 )d

0:4)d

Die Berechnung des komplizierten Ausdrucks mit Hilfe der Standardregeln ist sehr aufwendig. Es

gibt auch Situationen, in denen das entsprechende Integral gar nicht analytisch zu lösen ist. Man kann

aber die Lösung mit Hilfe numerischer Methoden immer approximieren und somit die Posteriori–

Verteilung bestimmen. Abbildung 10.12 zeigt die Posteriori–Verteilung für n = 100 und verschiedene

10.4. BEMERKUNGEN ZU KONJUGIERTEN VERTEILUNGEN

207

Beobachtungen: x = 50 (links), x = 40 (Mitte) und x = 20 (rechts). Zum Vergleich ist jeweils

die Apriori–Verteilung gezeichnet. Zu beachten ist, dass die Posteriori–Verteilung nur den Bereich

beschreibt, in dem auch die Aprioriverteilung definiert ist. Im Beispiels ist dies das Intervall [0.4,0.6].

Auch für x = 20 nimmt die Posteriori–Verteilung nur für diesen Bereich Werte größer null an.

x=40

x=20

0.40

0.45

0.50

π

0.55

0.60

10

5

0

0

0

2

2

4

4

15

6

6

20

8

8

25

10

10

30

12

12

35

x=50

0.40

0.45

0.50

π

0.55

0.60

0.40

0.45

0.50

0.55

0.60

π

Abbildung 10.12: Apriori-Verteilung und Posteriori–Verteilungen im Vergleich

Komplizierter wird der Fall, wenn mehrere Parameter unbekannt sind (beispielsweise die

Elemente der Kovarianzmatrix einer multivariaten Normalverteilung). Es ist dann notwendig

Simulationen (sogenannte Monte Carlo–Methoden) anzuwenden, um die Normierungskonstante zu bestimmen. Ein kurzer Einblick hierzu findet sich bei Lee (1997, Kapitel 9). Eine

detailliertere Beschreibung von Simulationsmethoden im Rahmen der Bayes’schen Verfahren ist beispielsweise bei Gamerman (1997) gegeben.