Java aktuell

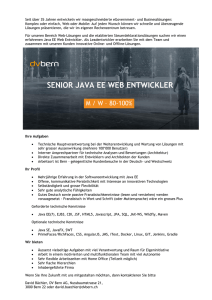

Werbung