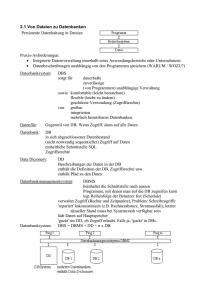

Auszug in PDF mit Kap. 1 (Architektur von DBS) und Kap. 13

Werbung