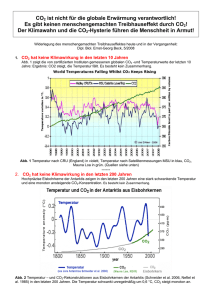

Energie und Klima

Werbung