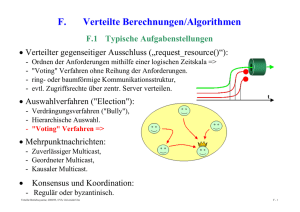

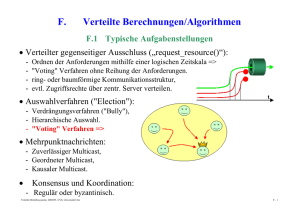

Betriebssysteme und verteilte Systeme

Werbung