Gemeinsame iterative Kanalschätzung und

Werbung

Gemeinsame iterative Kanalschätzung

und Turbodecodierung für drahtlose

Übertragungssysteme

COMLAB

University of Kassel

Diplomarbeit II

Verfasser: Stephan Matthes

Marc Selig

Februar 2007

Universität Kassel, Fachbereich 16

FG Nachrichtentechnik

Wilhelmshöher Allee 73, 34121 Kassel

1. Gutachter: Prof. Dr. sc.techn. Dirk Dahlhaus

2. Gutachter: Prof. Dr.-Ing. Henning Früchting

Betreuer: Prof. Dr. sc.techn. Dirk Dahlhaus

Erklärung

Hiermit versichern wir, dass wir die vorliegende Diplomarbeit selbstständig und ohne unerlaubte Hilfsmittel angefertigt und andere als die in der Diplomarbeit angegebenen Hilfsmittel

nicht benutzt haben. Alle Stellen, die wörtlich oder sinngemäß aus veröffentlichten oder unveröffentlichten Schriften entnommen sind, haben wir als solche kenntlich gemacht.

Kassel, den.....................................................................................

I

Danksagung

Wir möchten uns ganz herzlich bedanken bei allen, die uns in dieser Diplomarbeit unterstützt

haben. Dank geht allen voran an unsere Eltern für die unerlässliche Unterstützung, ohne die

dieses Studium nicht möglich gewesen wäre.

Weiterhin möchten wir uns bedanken bei Herrn Prof. Dr. sc.techn. Dirk Dahlhaus und Herrn

Prof. Dr.-Ing. Henning Früchting für die Übernahme der Begutachtung der Diplomarbeit.

Bei Herrn Prof. Dr. sc.techn. Dirk Dahlhaus möchten wir uns nochmals bedanken für die sehr

gute Betreuung während unserer Diplomarbeit mit vielen wertvollen Diskussionen.

Bedanken möchten wir uns auch bei Herrn Dipl.-Ing. Herbert Lindenborn und dem gesamten Team des ComLab für die gute Zusammenarbeit und das angenehme Klima. Danke auch

an Herrn Dipl.-Ing. Thomas Edlich und Herrn Dr. sc.techn. Thomas Hunziker für wertvolle

Diskussionen.

II

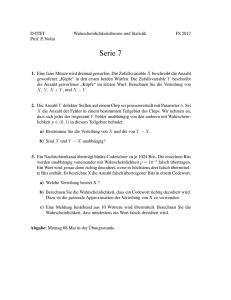

Aufgabenstellung

Turbodecodierung basiert auf iterativen Algorithmen zur Maximierung einer bestimmten Metrik. Im Fall einer drahtlosen Übertragung über frequenz-/zeit-selektive Kanäle hängt die Metrik von den Kanalparametern ab, welche komplexe Amplituden, Verzögerungen oder Einfallswinkel bei Mehrantennenübertragung mit kohärentem Combining umfassen. Bekanntlich

können iterative Kanalschätzverfahren zur Maximierung der Likelihood-Funktion die Übertragungsgüte drahtloser Luftschnittstellen massiv erhöhen. In dieser Arbeit soll die Möglichkeit der gemeinsamen iterativen Kanalschätzung und Turbodecodierung untersucht werden.

Zunächst dienen eine einfache Luftschnittstelle und ein entsprechend einfaches Kanalmodell

zur Herleitung der prinzipiellen Empfängerstruktur. Anschließend soll die Empfängerstruktur

mit einem geeigneten Kanalschätzalgorithmus kombiniert werden, sodass die Kanalparameter eines Kanals mit Rayleigh-Schwund ohne Pilotsymbole bestimmt werden können. Die

Turbocodes, Übertragungskanäle und Empfänger sind in M ATLAB® zu implementieren und

bezüglich der erreichbaren Fehlerrate und Kanalschätzgüte zu untersuchen.

III

Inhaltsverzeichnis

Erklärung

I

Aufgabenstellung

III

1

Einleitung

1

2

Mathematische Grundlagen der Informationsübertragung

3

2.1

2.2

2.3

3

Grundlagen der Wahrscheinlichkeitsrechnung . . . . . . . . . . .

2.1.1 Wahrscheinlichkeiten von zwei Ereignissen . . . . . . . .

2.1.2 Axiome von Kolmogorov . . . . . . . . . . . . . . . . .

2.1.3 Bayes’sches Theorem . . . . . . . . . . . . . . . . . . . .

2.1.4 Zentraler Grenzwertsatz und das Gesetz der großen Zahlen

Wichtige Begriffe der Statistik . . . . . . . . . . . . . . . . . . .

2.2.1 Zufallsvariable X . . . . . . . . . . . . . . . . . . . . . .

2.2.2 Zwei Zufallsvariablen . . . . . . . . . . . . . . . . . . .

2.2.3 Charakteristische Funktion . . . . . . . . . . . . . . . . .

2.2.4 Zufallsprozesse . . . . . . . . . . . . . . . . . . . . . . .

2.2.5 Log-Likelihood-Ratio (LLR) . . . . . . . . . . . . . . . .

Verteilungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.3.1 Gaußverteilung . . . . . . . . . . . . . . . . . . . . . . .

2.3.2 Rayleighverteilung . . . . . . . . . . . . . . . . . . . . .

2.3.3 Chi-Quadrat-Verteilung . . . . . . . . . . . . . . . . . . .

Der Kanal

3.1 AWGN-Kanal . . . . . . . . . . . . . . . . . . . . . . . .

3.1.1 Störabstand . . . . . . . . . . . . . . . . . . . . .

3.1.2 BPSK-Übertragung in AWGN . . . . . . . . . . .

3.1.3 Energie des codierten Bits . . . . . . . . . . . . .

3.1.4 Normierung der Ergebnisse bei Kanalcodierung . .

3.2 Kanal mit Rayleigh-Schwund . . . . . . . . . . . . . . . .

3.2.1 Was bewirkt Rayleigh-Schwund? . . . . . . . . .

3.2.2 Implementierung . . . . . . . . . . . . . . . . . .

3.2.3 Num. Berechnung der Bitfehlerwahrscheinlichkeit

IV

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

4

4

5

5

7

7

8

9

9

10

12

13

13

14

15

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

16

17

18

20

20

21

22

23

24

4

Faltungscodierung

4.1

4.2

5

6

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

26

33

34

37

37

38

38

46

Turbocodierung

54

5.1

5.2

54

60

Turboencoder . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Turbodecoder . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Kanalschätzung

6.1

6.2

6.3

7

Faltungsencoder . . . . . . .

4.1.1 Distanzeigenschaften

4.1.2 Gewichtsverteilung .

4.1.3 Punktierung . . . . .

4.1.4 Terminierung . . . .

Faltungsdecodierung . . . .

4.2.1 Viterbi-Decodierung

4.2.2 MAP-Decodierung .

26

Schätzung durch Betragsmittelwertbildung . . . . . . . .

Schätzung mit Hilfe der Maximum-Likelihood-Methode

6.2.1 Newton-Raphson-Verfahren . . . . . . . . . . .

Iterativer Ansatz . . . . . . . . . . . . . . . . . . . . . .

64

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

65

70

72

76

Ergebnisse

78

7.1

7.2

79

83

AWGN-Kanal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Kanal mit Rayleigh-Schwund . . . . . . . . . . . . . . . . . . . . . . . . . .

Abkürzungsverzeichnis

95

Abbildungsverzeichnis

97

Literaturverzeichnis

99

1 Einleitung

Durch die Übertragung von Daten über Funkkanäle kann das Sendesignal derart beeinflusst

werden, dass Fehler in der Nachricht entstehen. Die Nachricht kann ganz oder nur teilweise

zerstört werden. Bei einem Gespräch, das mit Mobiltelefonen getätigt wird, können die Fehler

dazu führen, dass der Empfänger die Nachricht nicht mehr verstehen kann. Um den Einfluss

von Störungen vermindern zu können, werden in der digitalen Übertragungstechnik der Nachricht Redundanzen hinzugefügt, die auf der Empfängerseite dazu genutzt werden können, die

Fehler in der Nachricht zu entdecken und zu korrigieren. Das Hinzufügen von Redundanz wird

Kanalcodierung genannt und wird heutzutage praktisch in jeder digitalen Datenübertragung

verwendet. Es gibt viele verschiedene Kanalcodierungen, die in zwei Gruppen, die Blockcodierung und die Faltungscodierung, unterteilt werden können. Bei der Wahl der Kanalcodierung für ein Übertragungssystem muss immer der Mittelweg zwischen Leistungsfähigkeit

und Komplexität gefunden werden. Es nützt nichts, wenn ein System sehr leistungsfähig ist,

aber die Realisierung zum Beispiel des Empfängers derart komplex und damit auch teuer ist,

dass es niemand nutzen will. Ein solcher Kompromiss zwischen Leistungsfähigkeit und Komplexität wird durch die Verkettung von verschiedenen oder auch gleichen Kanalcodierungen

erreicht. In 1993 stellten Berrou, Glavieux und Thitimajshima [BGT93] erstmals Turbocodes vor, die aus der parallelen Verkettung von Faltungscodes entstanden sind. Durch diese

parallele Verkettung verringert sich die Komplexität des Decoders, da für jeden Teilcode ein

einfacher Decoder verwendet werden kann. So kann eine hohe Leistungsfähigkeit bei relativ

geringer Komplexität erzielt werden. Ein weiterer Vorteil der Turbocodes ist die Verwendung

von Zuverlässigkeitsinformationen für jedes Bit zwischen den einzelnen Decodern in einem

iterativen Decodierprozess. So können Fehler, die zum Beispiel im ersten Decoder nicht korrigiert werden konnten, im zweiten Decoder korrigiert werden. Für den Decodiervorgang ist

es notwendig, Informationen über die Eigenschaften des zu Grunde liegenden Kanals, wie

zum Beispiel die Rauschleistung und den Einfluss von Schwundeffekten, zu haben. Da diese

Informationen nicht vorliegen, ist es notwendig, sie aus den empfangenen Daten abzuschätzen. Dazu gibt es verschiedene Möglichkeiten, wie zum Beispiel die Schätzung anhand von

vorher eingefügten und bekannten Pilotsymbolen durchzuführen oder sie „blind“ anhand der

Eigenschaften der empfangenen Bits zu schätzen. Je besser die Abschätzung der genannten

Kanaleigenschaften ist, desto besser wird die Decodierung der empfangenen Nachricht.

Ziel dieser Arbeit ist es, zuerst ein einfaches Übertragungssystem auf Grundlage von Turboco-

1

1 Einleitung

des in der Simulationsumgebung M ATLAB® zu implementieren. Dazu werden ein Sender, verschiedene Kanäle sowie der Empfänger programmiert und auf ihre Leistungsfähigkeit getestet.

Anschließend wird ein Schätzverfahren untersucht, das die Eigenschaften eines Schwundkanals in geeigneter Form abschätzt und so die Decodierung unterstützt. Auch die gefundenen

Schätzverfahren werden in M ATLAB® implementiert und auf ihre Leistungsfähigkeit untersucht.

In Kapitel 2 wird auf die mathematischen Grundlagen, die für die Informationsübertragung

und somit auch zum Verständnis der Arbeit notwendig sind, eingegangen. Es werden vor allem wichtige Aspekte der Wahrscheinlichkeitsrechnung und Stochastik beleuchtet. Die äußeren Bedingungen, die bei einer Übertragung herrschen und in Form von Kanalmodellen

wiedergegeben werden, sind Gegenstand von Kapitel 3. Hier werden der AWGN-Kanal und

der in dieser Arbeit verwendete Schwundkanal beschrieben. In Kapitel 4 wird die Faltungscodierung vorgestellt, da sie ein wesentlicher Bestandteil der Turbocodierung ist. Es werden ein einfacher Encoder erklärt und verschiedene Decodieralgorithmen vorgestellt. Auf die

Turbocodierung selbst wird dann in Kapitel 5 eingegangen. Auch hier werden ein einfacher

Encoder und die iterative Decodierung der Turbocodes vorgestellt. In Kapitel 6 wird die benötigte Kanalschätzung beschrieben und es werden die Schätzalgorithmen vorgestellt, die in

dieser Arbeit implementiert wurden. Mit dem programmierten Übertragungssystem werden

dann Simulationen durchgeführt, um das System auf seine Leistungsfähigkeit zu überprüfen.

Die Ergebnisse dieser Simulationen werden in Kapitel 7 diskutiert.

Von Herrn Matthes wurden folgende Teile der vorliegenden Arbeit bearbeitet:

•

•

•

•

•

Kapitel 2: Mathematische Grundlagen der Informationsübertragung

Kapitel 3: Der Kanal

Abschnitt 4.2.2: MAP-Decodierung

Abschnitt 5.2: Turbodecoder

Abschnitt 7.1: AWGN-Kanal.

Von Herrn Selig wurden folgende Teile der vorliegenden Arbeit bearbeitet:

•

•

•

•

Kapitel 4: Faltungscodierung (ohne Abschnitt 4.2.2)

Abschnitt 5.1: Turboencoder

Kapitel 6: Kanalschätzung

Abschnitt 7.2: Kanal mit Rayleigh-Schwund.

Die übrigen Teile wurden zusammen erarbeitet.

2

2 Mathematische Grundlagen der

Informationsübertragung

2.1 Grundlagen der Wahrscheinlichkeitsrechnung

Wir betrachten zunächst den Wurf eines Würfels. Alle möglichen Ergebnisse eines Wurfes

bezeichnen wir mit dem Ereignis

S = {1, 2, 3, 4, 5, 6},

(2.1)

das das sichere Ereignis darstellt. Die Wahrscheinlichkeit, dass S bei einem Wurf eintritt, ist

P(S) = 1,

(2.2)

denn es ist sicher, dass der Würfel auf einer Seite liegen bleibt und ein Ergebnis zeigt.

Wir legen jetzt das Ereignis A fest als ’Wurf ergibt eine Zwei’ oder ’ Wurf ergibt eine Vier’,

also ist

A = {2, 4}.

(2.3)

Da alle sechs möglichen Ergebnisse gleichwahrscheinlich sind, ist die Wahrscheinlichkeit für

das Auftreten einer bestimmten Zahl gleich 61 . Diese einzelnen Ereignisse werden Elementarereignisse genannt. Für die Wahrscheinlichkeit P(A) errechnet sich damit der Wert

2 1

= .

6 3

(2.4)

Ā = {1, 3, 5, 6}.

(2.5)

P(A) =

Die Komplementärmenge zu A ist

Die beiden Ereignisse A und Ā schließen sich gegenseitig aus, die Schnittmenge von A und Ā

ist die leere Menge:

A ∩ Ā = 0.

/

(2.6)

3

2 Mathematische Grundlagen der Informationsübertragung

Ein weiteres Ereignis sei

B = {1, 3, 6}.

(2.7)

A ∩ B = 0.

/

(2.8)

Man sieht leicht, dass sich die beiden Ereignisse A und B gegenseitig ausschließen. Die

Schnittmenge von A und B ist ebenfalls die leere Menge:

2.1.1 Wahrscheinlichkeiten von zwei Ereignissen

Wir bleiben beim Würfel und nehmen nun ein weiteres Ereignis

C = {1, 2, 3}

(2.9)

an. Die Wahrscheinlichkeit, dass bei einem Wurf C eintritt, ist P(C) = 12 , da auch hier alle

möglichen Elementarereignisse jeweils die Wahrscheinlichkeit 16 besitzen. Mit B aus (2.7) ist

ebenfalls P(B) = 12 . Die Wahrscheinlichkeit, dass beide Ereignisse gleichzeitig auftreten, ist

aber

1

(2.10)

P(B ∩C) = ,

3

wobei das gleichzeitige Auftreten von B und C durch die Schnittmenge B ∩C definiert wird.

Nun kann man sich fragen, wie hoch die Wahrscheinlichkeit von C noch ist, wenn man weiß,

dass B eingetreten ist. Man stelle sich also vor, zwei Personen sitzen an einem Tisch. Person

(1) würfelt und Person (2) hat die Augen geschlossen. Person (1) teilt Person (2) mit: „Ereignis

B ist eingetreten.“ Person (2) sagt daraufhin: „Dann ist die Wahrscheinlichkeit, dass C auch

eingetreten ist, 32 .“ Dieser Wert stellt die auf das Ereignis B bedingte Wahrscheinlichkeit von

C dar. Diese Wahrscheinlichkeit wird als P(C|B) bezeichnet und ergibt sich zu

P(C|B) =

Also ist

P(C|B) =

P(B,C)

.

P(B)

1

3

1

2

2

= .

3

(2.11)

(2.12)

2.1.2 Axiome von Kolmogorov

In der Maßtheorie hat Kolmogorov Axiome für die Berechnung von Wahrscheinlichkeiten

definiert [PP02]. Im einführenden Beispiel wurden diese Axiome vorausgesetzt.

4

2 Mathematische Grundlagen der Informationsübertragung

• 1. Axiom: Die Wahrscheinlichkeit, dass ein Ereignis (hier bezeichnet mit A) eintritt, ist

nicht kleiner als null:

P(A) ≥ 0.

(2.13)

• 2. Axiom: Die Wahrscheinlichkeit für das sichere Ereignis S ist eins:

P(S) = 1.

(2.14)

• 3. Axiom: Schließen sich zwei Ereignisse A und B gegenseitig aus, dann ist die Wahrscheinlichkeit für die Vereinigungsmenge von A und B gleich der Summe der Einzelwahrscheinlichkeiten:

wenn A ∩ B = 0/ dann ist P(A ∪ B) = P(A) + P(B).

(2.15)

2.1.3 Bayes’sches Theorem

Seien Ai Elementarereignisse und B eine Untermenge der Vereinigungsmenge aller Ai . Dann

ist

n

P(B) = ∑ P(Ai ) · P(B|Ai ).

(2.16)

i=1

P(B|Ai ) bezeichnet dabei die Wahrscheinlichkeit, dass das Ereignis B eintritt, gegeben, dass Ai

bereits eingetreten ist. Der unvollständige Ereignisbaum in Abbildung 2.1 auf Seite 6 verdeutlicht diesen Sachverhalt. Ist die Vereinigungsmenge aller Ai das sichere Ereignis S, so spricht

man bei (2.16) von der totalen Wahrscheinlichkeit für das Eintreten des Ereignisses B. Mit der

Definitionsgleichung für die bedingte Wahrscheinlichkeit (2.11) ergibt sich für P(B) > 0

P(A j |B) =

P(A j , B)

P(A j ) · P(B|A j )

= n

.

P(B)

∑ P(Ai ) · P(B|Ai )

(2.17)

i=1

(2.17) ist das Bayes’sche Theorem.

2.1.4 Zentraler Grenzwertsatz und das Gesetz der großen Zahlen

In [Roh06] wird beschrieben, dass der zentrale Grenzwertsatz eine Sammlung von Grenzwerten ist, die sich mit unbekannten Wahrscheinlichkeitsverteilungen beschäftigt. Wichtig ist

5

2 Mathematische Grundlagen der Informationsübertragung

P(A1 )

P(A2 )

P(B)

..

.

P(An )

Abbildung 2.1: Das Ereignis B ist über verschiedene „Zwischenstationen“ Ai erreichbar

[Pap05].

in diesem Zusammenhang der Grenzwertsatz von Lindeberg-Lévy: Für beliebige unabhängige

identisch verteilte Zufallsvariablen Xi mit Mittelwert mX und Varianz σX2 gilt, dass die Folge

(∑ni=1 Xi ) − nmX

q

Zn =

nσX2

(2.18)

asymptotisch eine Standardnormalverteilung

1

lim P(Zn < z) = Φ(z) = √

n→∞

2π

ξ2

dξ

exp −

2

−∞

Z z

(2.19)

besitzt. Dadurch ist die Bedeutung der Gaußverteilung für die Wahrscheinlichkeitsrechnung

besonders hervorgehoben.

Zusammen mit dem zentralen Grenzwertsatz wird häufig das Gesetz der großen Zahlen genannt, das sich aufteilen lässt in ein schwaches Gesetz der großen Zahlen und ein starkes

Gesetz der großen Zahlen. Wir betrachten hier nur das schwache Gesetz der großen Zahlen.

Hat man eine Menge von n Realisierungen einer Zufallsvariablen Xi , so konvergiert der arithmetische Mittelwert der Realisierungen mit steigender Anzahl n gegen den Erwartungswert.

Für die neue Zufallsvariable

1 n

Zn = ∑ Xi

(2.20)

n i=1

gilt:

lim P(|Zn − E{X}| > ε ) = 0

n→∞

6

(2.21)

2 Mathematische Grundlagen der Informationsübertragung

Das bedeutet, dass das Ereignis „Die Abweichung zwischen arithmetischem Mittelwert und

Erwartungswert ist kleiner als ein ε “ mit der Wahrscheinlichkeit null auftritt.

2.2 Wichtige Begriffe der Statistik

2.2.1 Zufallsvariable X

Die Zufallsvariable X ist eine Funktion, die jedem Elementarereignis ω aus der Ergebnismenge Ω eines Zufallsexperiments genau eine reelle Zahl X(ω ) = x zuordnet. Dabei ist x eine Realisierung der Zufallsvariablen X und hängt somit von den Eigenschaften von X ab. Betrachtet

man ausreichend viele Realisierungen x von unabhängigen und gleichverteilten Zufallsvariablen X, so kann man daraus nach dem Gesetz der großen Zahlen (vgl. Abschnitt 2.1.4) die

Eigenschaften von X näherungsweise bestimmen.

Die Zufallsvariable X wird durch die Verteilungsfunktion F(x) (engl.: cumulative distribution

function - CDF) beschrieben, für die

F(x) =

Zx

p(u)du

(2.22)

−∞

gilt, wobei p(u) wiederum die Wahrscheinlichkeitsverteilung bzw. Dichte (engl.: PDF - probability density function) angibt.

Die Verteilungen können durch eine Taylorentwicklung der charakteristischen Funktion (vgl.

Abschnitt 2.2.3) um den Ursprung durch ihre k-ten Momente beschrieben werden, wobei im

Allgemeinen alle Momente mit k ∈ N0 benötigt werden. Die Momente werden hier kurz erläutert.

Der Erwartungswert E {·}

E {X} ≡ mX =

Z∞

xp(x)dx

(2.23)

−∞

bildet das erste Moment. Im Englischen bezeichnet man den Erwartungswert E {X} auch als

„mean“ mX , was nicht mit dem Mittelwert von Realisierungen zu verwechseln ist. Das Moment n-ter Ordnung wird definiert als

n

E {X } =

Z∞

−∞

7

xn p(x)dx.

(2.24)

2 Mathematische Grundlagen der Informationsübertragung

Das zweite zentrale Moment bzw. die Varianz ist definiert als

σX2

=

Z∞

−∞

(x − mX )2 p(x)dx.

Mit Hilfe der ersten und zweiten Momente kann man die Varianz beschreiben als

σX2 = E (X − mX )2

= E X 2 − 2mX E {X} + m2X

= E X 2 − m2X .

(2.25)

(2.26)

2.2.2 Zwei Zufallsvariablen

Für zwei Zufallsvariablen (engl.: random variables) X1 und X2 mit der Verbundwahrscheinlichkeitsdichtefunktion (engl.: joint PDF) p(x1 , x2 ) wird das Verbundmoment (engl.: joint

moment) definiert als

o Z∞ Z∞

n

E X1k X2n ≡

x1k x2n p(x1 , x2 )dx1 dx2

(2.27)

−∞ −∞

und das zentrale Verbundmoment (engl.: joint central moment) wird definiert als

n

o Z∞ Z∞

k

n

E (X1 − m1 ) (X2 − m2 ) =

(x1 − m1 )k (x2 − m2 )n p(x1 , x2 )dx1 dx2 .

(2.28)

−∞ −∞

Besonders wichtig sind in dem Zusammenhang das Verbundmoment und zentrale Verbundmoment, bei dem k = n = 1 gilt. Sie werden Korrelation (engl.: correlation) und Kovarianz

(engl.: covariance) genannt. Für die Kovarianz gilt:

µi j ≡ E (Xi − mi )(X j − m j )

=

Z∞ Z∞

−∞ −∞

(xi − mi )(x j − m j )p(xi , x j )dxi dx j

= E Xi X j − mi m j

mit mi = E {Xi } bzw. m j = E X j .

Unkorreliert

sind zwei Zufallsvariablen, wenn

E Xi X j = E {Xi } E X j = mi m j .

In diesem Fall ist die Kovarianz µi j = 0.

8

(2.29)

(2.30)

2 Mathematische Grundlagen der Informationsübertragung

Orthogonalität

Zwei Zufallsvariablen werden zueinander als orthogonal bezeichnet, wenn

(2.31)

E Xi X j = 0

ist. Diese Bedingung ist erfüllt, wenn Xi und X j unkorreliert sind und mindestens eine der

Zufallsvariablen einen Mittelwert von null (engl.: zero-mean) hat, also mittelwertfrei ist.

2.2.3 Charakteristische Funktion

Die charakteristische Funktion einer Zufallsvariablen X vereinfacht die Berechnung der Dichtefunktion p(x), sofern X eine lineare Superposition unabhängiger Zufallsvariablen darstellt.

Die charakteristische Funktion ist die Fouriertransformierte der PDF und ist definiert als

jν X Z jν x

ψ ( jν ) ≡ E e

= e p(x)dx

(2.32)

R

mit der Rücktransformation

1

p(x) =

2π

Z

R

ψ ( jν )e− jν x dν .

(2.33)

Die Ableitung der charakteristischen Funktion ergibt

dψ ( jν )

=j

dν

Z

xe jν x p(x)dx.

(2.34)

R

Für ν = 0 ergibt sich direkt der Erwartungswert

dψ ( jν ) E {X} = mX = − j

.

dν ν =0

(2.35)

2.2.4 Zufallsprozesse

Möchte man ein Nachrichtensignal empfangen, so kennt man vorher den genauen Verlauf des

Signals nicht. Man nutzt daher die Beschreibung der Zufallsprozesse. Zufallsprozesse werden durch eine mit t parametrierte Zufallsvariable beschrieben, wobei t den zeitlichen Verlauf

9

2 Mathematische Grundlagen der Informationsübertragung

indiziert. Wir bezeichnen einen solchen Prozess, der die Menge aller möglichen Einzelrealisierungen einschließt, mit X(t). Im Allgemeinen ist der Parameter t kontinuierlich und X(t)

kann diskret oder kontinuierlich sein. Da wir einen Zufallsprozess X(t) als Gesamtheit der

Einzelrealisierungen definiert haben, können wir Werte dieses Prozesses für eine beliebige

Menge von verschiedenen Zeitpunkten t1 < t2 < · · · < tn betrachten, wobei n eine natürliche

Zahl ist. Anschaulich kann man sagen, dass eine Realisierung eines Zufallsprozesses X(t) eine Funktion x(t) ist. Die Zufallsvariablen Xti ≡ X(ti ), i = 1, 2, · · · , n, werden statistisch durch

ihre Verbunddichte p(xt1 , xt2 , · · · , xtn ) charakterisiert.

Stationarität

Gilt für beliebiges t und beliebige n

p(xt1 , xt2 , . . . , xtn ) = p(xt1 +t , xt2 +t , . . . , xtn +t ),

(2.36)

so spricht man von einem Prozess, der stationär im engeren Sinn (engl.: strict-sense stationary) ist [Pro01]. Hier ist gefordert, dass die Verbunddichte zu n beliebigen Zeitpunkten und die

Verbundichte zu n anderen beliebigen Zeitpunkten gleich sein muss. Das kann nur funktionieren, wenn man von identischen Zufallsvariablen X(t) mit gleichen Verteilungen ausgeht. Sind

die Verbunddichten nicht gleich, so ist der Prozess nichtstationär.

Ähnlich wie bei Zufallsvariablen können wir auch Zufallsprozesse durch ihre Momente ausdrücken. Betrachten wir dabei einen Zeitpunkt ti , so ist das n-te Moment

∞

n Z n

E Xti = xti p(xti )dx.

(2.37)

−∞

Ist der Prozess stationär, so ist p(xti +t ) = p(xti ). Dann ist auch das n-te Moment zeitunabhängig. Die Autokorrelationsfunktion φ (t1 ,t2 ) hängt dann nicht mehr explizit von zwei festen Zeitpunkten ab, sondern nurnoch von

der Zeitverschiebung τ . Die Autokorrelationsfunk2

tion an der Stelle null φ (0) = E X (t) bezeichnet die mittlere Leistung des Zufallsprozesses

X(t). Es gibt nichtstationäre Prozesse, für die ebenfalls die Autokorrelationsfunktion φ (τ ) nur

von der Zeitverschiebung τ abhängt. Ist diese Bedingung erfüllt, spricht man von einem Prozess, der schwach stationär bzw. stationär im weiteren Sinn (engl.: wide-sense stationary) ist

[Pro01].

2.2.5 Log-Likelihood-Ratio (LLR)

In der digitalen Kommunikation entscheidet man oft zwischen genau zwei möglichen Ereignissen, die sich gegenseitig ausschließen. Diesen Ereignissen seien die beiden Wahrscheinlichkeiten a ∈ [0, 1] und b ∈ [0, 1] zugeordnet. Sicher ist, dass einer der Zustände eintritt. Damit

10

2 Mathematische Grundlagen der Informationsübertragung

ist

1 = a + b.

Um ein einfaches Maß zu haben, wie wahrscheinlich das eine oder das andere Ereignis eingetreten ist, bildet man den Quotienten aus beiden und nimmt davon den natürlichen Logarithmus. Daraus entsteht das logarithmische Wahrscheinlichkeitsverhältnis (engl.: log likelihood

ratio - LLR)

a

a

Lab = ln = ln

, a, b ∈ (0, 1).

b

1−a

Hierbei können a und b nicht mehr im beidseitig abgeschlossenen Intervall definiert sein, da

die Grenzen sonst nicht definiert sind.

Die Darstellung mit Hilfe des LLR-Wertes hat für die Implementierung iterativer Algorithmen einige Vorteile. Allerdings birgt diese Darstellung einige Nachteile für das Verständnis.

Allgemein kann man die Darstellung einer Zufallsvariablen A durch den LLR-Wert als eine

Transformation ansehen. In dem hier betrachteten Fall einer Zufallsvariablen A mit Trägerintervall A ∈ (0, 1) bildet die bijektive1 Abbildung [Hub02]

L : eI p 7→ R : L(a) = ln

a

△

für a ∈ eI p = (0, 1)

1−a

(2.38)

das beidseitig offene Intervall eI p auf die Gesamtmenge der reellen Zahlen ab, wobei der

mittlere Term die eigentliche Transformation ausdrückt. Ist z = L(a), so ergibt sich die Rücktransformation oder Umkehrfunktion a = L−1 (z), z ∈ R zu [Hub02]:

a=

ez

1

1

z 1

=

= tanh + .

z

−z

1+e

1+e

2

2 2

(2.39)

Diese Darstellung hat einen entscheidenden Vorteil. Sämtliche Multiplikationen werden in

einfache Additionen umgewandelt. Somit ist die Darstellung und insbesondere die Implementierung wesentlich einfacher. Allerdings muss man sich über die Transformation einer Summe

Gedanken machen. Hier hilft folgender Ausdruck [VY00]:

ln(ea + eb ) = max(a, b) + ln(1 + e−|b−a| )

= max(a, b) + fc (|b − a|).

(2.40)

Die Additionen werden also zu Argumenten einer Maximumfunktion mit einer Korrekturfunktion fc . Bei Gleichheit von a und b wird der Maximalwert ln 2 von fc erreicht. Es gilt

also: fc ≤ ln 2.

1 Bijektiv

impliziert, dass die Funktion eindeutig umkehrbar ist.

11

2 Mathematische Grundlagen der Informationsübertragung

2.3 Verteilungen

Für Berechnungen mit Zufallsvariablen sind die zu Grunde liegenden Verteilungen der Zufallsvariablen von hoher Bedeutung. Die für diese Arbeit wichtigen Verteilungen sind hier

angegeben. Sie sind entnommen aus [Pro01]. Am Anfang stehen hier drei wichtige Funktionen, die ebenfalls aus [Pro01] entnommen sind.

Gammafunktion

Γ(p) =

R∞ p−1 −t

t e dt,

p>0

0

Γ(p) = (p − 1)!,

Γ(p + 1) = p!,

√

Γ( 21 ) =

π,

p ist eine natürliche Zahl > 0

Γ( 23 ) =

(2.41)

1√

2 π.

Eigenschaften der Gammafunktion:

Γ(x + 1) = xΓ(x).

(2.42)

[Pro01] Für einige Anwendungen ist die Fehlerfunktion (engl.: error function) wichtig. Sie ist definiert als

Fehlerfunktion

2

erf(x) = √

π

Z x

0

2

e−t dt.

(2.43)

Ihr Komplement ist definiert als

erfc(x) = 1 − erf(x).

(2.44)

Die Q-Funktion ist die Funktion für die Fläche unter dem Rest2 der Standardnormalverteilung N (0; 1) und ist definiert als

Q-Funktion

Z∞

2

t

dt

exp −

2

x

1

x

=

erfc √ .

2

2

1

Q(x) = √

2π

2 Mit

(2.45)

(2.46)

Rest ist hier das Integral über die Gaußdichte von einer unteren Grenze bis unendlich bezeichnet.

12

2 Mathematische Grundlagen der Informationsübertragung

2.3.1 Gaußverteilung

Die Gaußverteilung ist definiert durch ihre PDF

−

1

p(x) = √

e

2πσX

(x−mX )2

2

2σX

,

(2.47)

wobei σX2 die Varianz und mX den Erwartungswert der Gaußverteilung bezeichnen. Die CDF

berechnet sich zu

F(x) =

Z x

p(u)du,

1 1

x − mX

.

=

+ erf √

2 2

2 σX

(2.48)

−∞

Das k-te zentrale Moment ist definiert durch

(

n

o

1 · 3 · · · (k − 1)σXk

E (X − mX )k ≡ µk =

0

(für gerade k)

(für ungerade k)

(2.49)

(2.50)

und das k-te Moment ergibt sich zu

n o

k k i

k

mX µk−i .

E X =∑

i=0 i

(2.51)

Die Gaußverteilung hat die Eigenschaft, dass sie durch die beiden ersten Momente vollständig

beschrieben werden kann. Die Gauß- oder Normalverteilung mit dem Erwartungswert mX und

der Varianz σX2 wird oft durch N (mX ; σX2 ) ausgedrückt.

2.3.2 Rayleighverteilung

Die Rayleighverteilung beschreibt die Amplitude eines komplexen Signals mit gaußverteiltem

Real- und Imaginärteil. Die Dichtefunktion der Rayleighverteilung ist

pR (r) =

r − r22

e 2σ ,

σ2

r ≥ 0,

wobei σ 2 die Varianz des Real- bzw. Imaginärteils ist. Das k-te Moment von R ist

n o

1

2 k/2

k

Γ 1+ k .

E R = 2σ

2

13

(2.52)

(2.53)

2 Mathematische Grundlagen der Informationsübertragung

Der Erwartungswert der Rayleighverteilung ist

π

.

2

(2.54)

4−π 2

σ .

2

(2.55)

E {R} = σ

Die Varianz ergibt sich zu

σR2 =

r

2.3.3 χ 2 -Verteilung

Wenn X eine mittelwertfreie gaußverteilte Zufallsvariable ist, so besitzt Y = X 2 eine zentrale

χ 2 -Verteilung mit einem Freiheitsgrad. Die Dichtefunktion der χ 2 -Verteilung ist dann

2

1

e−y/2σ .

pY (y) = √

2π yσ

(2.56)

n

Ist nun Y = ∑ Xi2 , wobei n die Anzahl der Freiheitsgrade bezeichnet, so ist die Verteilungsi=1

dichte

pY (y) =

und der Erwartungswert

Die Varianz berechnet sich zu

1

yn/2−1 e−y/2σ ,

2

σ n 2n/2 Γ( 12 n)

y≥0

(2.57)

E {Y } = nσ 2 .

(2.58)

σy2 = 2nσ 4 .

(2.59)

Die zentrale χ 2 -Verteilung mit zwei Freiheitsgraden entspricht der Exponentialverteilung. Die

PDF ist

y 1

pY (y) =

(2.60)

exp − 2 .

2σ 2

2σ

Der Erwartungswert ergibt sich dann als

E {Y } = 2σ 2 .

(2.61)

Möchte man die Verteilung normieren, so ergibt sich für die normierte zentrale χ 2 -Verteilung

mit zwei Freiheitsgraden die PDF

1

y

pY (y) =

exp −

.

(2.62)

E {Y }

E {Y }

Die nichtzentralen χ 2 -Verteilungen werden hier nicht betrachtet. Nichtzentral bedeutet, dass

die zu Grunde liegenden Gaußverteilungen nicht mittelwertfrei sind.

14

3 Der Kanal

In Abbildung 3.1 erkennt man ein Übertragungssystem. Am Anfang steht die Daten- oder

Informationsquelle. Diese Daten oder Informationen werden von einem sog. Quellencodierer

(engl.: source encoder) in eine Bitfolge gewandelt. Die Information selbst hat keine oder nur

wenig Redundanz. Diese Informationsbitfolge wird nun zum Kanalcodierer (engl.: channel

encoder) geschickt. Der Kanalcodierer soll nun kontrolliert Redundanz hinzufügen, um die

Anzahl der Fehler, die durch Verluste im Kanal entstehen, gering zu halten. Dabei werden jeweils k Informationsbits durch n verschiedene Codebits repräsentiert. Die M = 2n verschiedenen Sequenzen der n Codebits nennt man Codewörter (engl.: code word). Jede k-bit Sequenz

wird so durch eine n-bit Sequenz ersetzt. Der Quotient aus n/k gibt das Maß an hinzugefügter

Redundanz an. Der reziproke Term k/n = Rc gibt die Coderate (engl.: code rate) an.

Informationsquelle

Quellcodierer

Kanalcodierer

Modulator

Kanal

Ausgangssignal

Ausgangsverstärker

Quelldecoder

Kanaldecoder

Demodulator

Abbildung 3.1: Basiselemente eines digitalen Kommunikationssystems.

Nun wird diese kanalcodierte Bitfolge an den digitalen Modulator (engl.: digital modulator)

geschickt. Je nach Art des Modulators können Ms = 2b verschiedene Wellenformen erzeugt

werden, wodurch jeweils b Bits pro Wellenform dargestellt werden können.

Dieses Signal wird über den physikalischen Kanal übertragen und anschließend vom Empfänger ausgewertet [Pro01]. Als Kanal bezeichnet man die Übertragungsstrecke zwischen Sender

15

3 Der Kanal

und Empfänger. Dies können sowohl drahtgebundene oder drahtlose Übertragungsstrecken

sein. Wir betrachten hier den Kanal für drahtlose Übertragungssysteme. Je nachdem, welche

Elemente des Übertragungssystems in den Kanal miteinbezogen werden, unterscheidet man

verschiedene Arten von Kanälen. Darunter sind [Lin05]:

der physikalische Kanal Der Kanal zwischen den beiden Antennenanschlüssen (für analo-

ge Signale).

der Modemkanal Dieser Kanal bezieht sowohl die Antennen als auch die beiden HF-Mischer

mit ein. Hier muss das Übertragungssignal schon moduliert im Basisband vorliegen.

der diskrete Kanal Dieser Kanal beinhaltet weiterhin die Digital-Analog- bzw. die Analog-

Digital-Wandlung. In der weiteren Arbeit werden wir uns auf diesen Kanal beziehen.

Weiterhin können die oben genannten Arten von Kanälen auch verschiedene Eigenschaften

aufweisen. Je nach Anwendungsgebiet kann das Signal verzerrt, verrauscht oder anderweitig

verändert sein. Eine deterministische Herangehensweise erscheint hier wenig sinnvoll. Die

Beschreibung solcher Eigenschaften mit Zufallsprozessen ist mathematisch besser fassbar.

Auf dieser Grundlage existieren einige Modelle von Kanälen. Im Folgenden wollen wir uns

mit dem sog. AWGN-Kanal beschäftigen.

3.1 AWGN-Kanal

Eine Eigenschaft, die in gewissem Maße alle Kanäle aufweisen, ist das Rauschen. Das Rauschen ist gedächtnislos. Es wird mathematisch als Zufallsprozess N(t), der eine multivariate

Normalverteilung hat, zum Übertragungssignal addiert. Dabei sind die einzelnen Zufallsvariablen N(ti ) statistisch unabhängig. Der Prozess wird beschrieben durch die ersten und die

zweiten Momente

E {N(t)}

= 0

und

∗

E {N(t − τ )N (t)} = σN2 δ (τ ).

(3.1)

Daher bezeichnet man dieses Rauschen als additives normalverteiltes Rauschen oder AWGN

(engl.: additive white Gaussian noise). Das Empfangssignal R(t) ist also gegeben durch:

R(t) = X(t) + N(t),

(3.2)

wobei X(t) das Sendesignal repräsentiert, das Ms verschiedene Signalformen annehmen kann.

Dabei wird von zeitdiskreten Werten ausgegangen. Wird das Signal zu K Zeitpunkten abgetastet, können wir das Signal als Vektor beschreiben. Es können nun K-orthonormale Signalformen gefunden werden, die den K-dimensionalen Signalraum beschreiben. Das Rauschen

16

3 Der Kanal

ist hier unendlich-dimensional. Bei der Demodulation wird das empfangene Signal mit allen

Ms Signalformen verglichen. Dabei wird nur der Teil der Rauschleistung mit dem Sendesignal

demoduliert, der in den K Dimensionen liegt [Pro01].

Üblicherweise geht man von Rauschen aus, das in der komplexen Signalebene die spektrale

Rauschleistungsdichte N0 hat (siehe Abbildung 3.2). Überträgt man nun rein reelle Signale,

wird der Imaginärteil des Rauschens bei der Demodulation ausgefiltert. Die spektrale Rauschleistungsdichte, die das reelle Signal überlagert, ist N0 /2. Das Sendesignal sei in der weiteren

Betrachtung reell.

Re{s(t)}

N0

σN2 = N0

2

εs

Im{s(t)}

t

Abbildung 3.2: Komplexes normalverteiltes Rauschen mit reellem Signal.

3.1.1 Störabstand

Wir gehen von zeitlich begrenzten Signalen aus, so dass jedes Signal endliche Energie hat.

Jedes Signal, das über den Kanal übertragen wird, hat demnach eine bestimmte Energie, die

17

3 Der Kanal

durch

εs =

Z∞

x2 (t)dt

(3.3)

−∞

gegeben ist. Die Leistung des Rauschsignals ist dessen Autokorrelation an der Stelle τ = 0

und für stationäre Prozesse ist diese unendlich:

Z∞

φnn (0) =

Φ( f )d f ,

(3.4)

−∞

= E N(t)2

σN2 δ (0).

=

(3.5)

(3.6)

Bei der Demodulation wird nun der Teil der Rauschleistung ausgefiltert, der nicht im Bereich

der möglichen Sendesignale liegt. Daher ist die Rauschleistung am Ausgang des Demodulators, die ein Signal überlagert, endlich.

Das Verhältnis von Sendeenergie und spektraler Rauschleistungsdichte wird Störabstand oder

SNR (engl.: signal-to-noise ratio) genannt. In einem optimalen Empfänger wird oft ein MFDetektor (engl.: matched filter detector) verwendet. In [Pro01] in Kapitel 5.1.2 ist der maximal

am Ausgang des MF-Detektors erreichbare Störabstand durch die Beziehung

SNR =

2ε s

N0

(3.7)

gegeben, wobei ε s die Energie eines übertragenen Symbols bezeichnet. Für eine BPSK1 Übertragung entspricht ε S auch der Energie für ein übertragenes Bit. Da die Energie eines

Symbols üblicherweise mit ε s = 1 angenommen wird, muss die spektrale Rauschleistungsdichte

N0

σN2 =

(3.8)

2

gewählt werden, damit SNR = 1/σN2 = 2/N0 gilt. Wenn man davon ausgeht, dass die Energie

des Symbols konstant ist, so kann aus dem SNRdB -Wert die Rauschvarianz berechnet werden

als

−SNRdB

(3.9)

σN2 = 10( 10 ) .

3.1.2 BPSK-Übertragung in AWGN

Wir wollen nun theoretisch die Bitfehlerrate für eine uncodierte BPSK-Übertragung in Abhängigkeit des SNR ermitteln. In Abbildung 3.3 sieht man die beiden Gaußverteilungen um

1 BPSK

- binäre Phasenumtastung (engl.: binary phase shift keying)

18

3 Der Kanal

die beiden möglichen Eingangsbits 1 bzw. −1. Ein Signal wird nur dann falsch decodiert,

wenn es zum schraffierten Bereich unter den Kurven gehört. Wurde beispielsweise eine −1

gesendet, aber eine 0.3 empfangen, so wird dieses Bit falsch decodiert. Da man null als Entscheidungsgrenze annimmt, kann man für eine gesendete −1 über die PDF der Gaußverteilung

von null bis unendlich integrieren und erhält so die Wahrscheinlichkeit für einen Fehler. Für

die Verteilung um 1 integrieren wir die PDF von minus unendlich bis null. Unter der Annahme

gleichwahrscheinlicher Symbole 1 und −1 und durch Ausnutzen der Symmetrieeigenschaften

der bedingten Fehlerwahrscheinlichkeiten in Abbildung 3.3 folgt, dass die totale Fehlerwahrscheinlichkeit gleich einer der genannten beiden bedingten Fehlerwahrscheinlichkeiten ist.

p(x)

-1

0

1

x

Abbildung 3.3: Wahrscheinlichkeitsverteilungen beider Bits für einen AWGN-Kanal.

Für den fälschlicherweise als 1 detektierten Rest der Gaußverteilung mit dem Erwartungswert

mN = −1 kann man ansetzen:

Pb =

Z∞

1

(x + 1)2

√

dx.

exp −

2σN2

2πσN

(3.10)

Z∞

!

1

x+1 2

√

exp − √

dx,

2πσN

2σN

(3.11)

0

Daraus ergibt sich weiter

Pb =

0

1

=

π

Z∞

√1

2σN

exp −y2 dy.

(3.12)

Mit der komplementären Fehlerfunktion (siehe (2.44)) und der Q-Funktion (siehe (2.46)) wird

19

3 Der Kanal

daraus

Pb

1

1

,

=

erfc √

2

2σN

!

s

1

1

=

erfc

,

2

2σN2

1

.

= Q

σN

(3.13)

(3.14)

(3.15)

Im Fall beliebiger Werte von ε S und N0 ergibt sich die Fehlerwahrscheinlichkeit entsprechend

zu

s

!

2ε s

Pb = Q

.

(3.16)

N0

3.1.3 Energie des codierten Bits

Für die digitale Übertragung ist die Energie eines einzelnen Bits mit ε b bezeichnet, wobei hier

die Modulation und die Kanalcodierung berücksichtigt werden. Das Verhältnis ε b /N0 dient

dem Vergleich von Übertragungen mit verschiedenen Modulationsarten und Kanalcodierungen. Bei einer Kanalcodierung werden k Bits durch eine Anzahl von n Bits wiedergegeben,

wobei k/n = Rc die Coderate ist. Es ist also die 1/Rc -fache Energie im Vergleich zu uncodierter Übertragung nötig, um ein Bit zu übertragen. Daher ist klar, dass für die Energie eines

codierten Bits

ε c = Rc ε b

(3.17)

gilt. Wird eine Ms -stufige Modulation verwendet, werden also log2 (Ms ) Bits pro Symbol übertragen, so wird die Symbolenergie zu

ε s = log2(Ms)ε c = log2(Ms)Rcε b.

(3.18)

Da wir für die Übertragung BPSK verwenden, Ms also zwei ist, vereinfacht sich (3.18) zu

ε s = Rc ε b .

(3.19)

3.1.4 Normierung der Ergebnisse auf ε b /N0 bei Kanalcodierung

Um die Simulationsergebnisse in ε b /N0 darstellen zu können, müssen Coderate und Bitenergie wie oben gezeigt berücksichtigt werden. In den Simulationen wird jedoch der nichtnormierte SNRdB -Wert verwendet. Daher müssen die Störabstandswerte normiert werden.

20

3 Der Kanal

Für den vorliegenden Turbocode ist die Coderate Rc = 31 . Setzt man (3.19) in (3.7) ein, so

ergibt sich

SNR = 2Rc

=

εb,

N0

2 εb

.

3 N0

Durch Umformung in dB erhält man

ε

3

b

10 log10

= 10 log10

+ 10 log10 (SNR)

N0

2

ε b = 1.76dB + SNR

dB

N0 dB

(3.20)

(3.21)

(3.22)

(3.23)

Für die praktische Realisierung ergeben sich nun zwei Möglichkeiten. Die erste Möglichkeit

besteht darin, die Simulationen mit vorgegebenen nichtnormierten SNRdB -Werten durchzuführen und die Ergebnisse anschließend zu „verschieben“. Als zweite Variante kann die Normierung bereits in der Simulation geschehen, indem man mit normierten Werten rechnen lässt.

Für Turbocodes mit einer Coderate Rc = 13 müssen für die Simulation um 1.76 dB kleinere

Werte verwendet werden. Letztere Variante fand in unseren Simulationen Anwendung.

Für Codes mit einer Coderate von Rc =

1

2

ist keine Veränderung notwendig.

Für uncodierte Übertragung gilt:

1

ε

b

= 10 log10

+ 10 log10 (SNR)

10 log10

N0

2

ε b = −3.01dB + SNR .

dB

N0 dB

(3.24)

(3.25)

Zur Darstellung einer uncodierten Übertragung in ε b /N0 müssen in der Simulation um 3 dB

größere Werte verwendet werden.

3.2 Kanal mit Rayleigh-Schwund

Bislang sind wir von einem einfachen AWGN-Kanal

R(t) = X(t) + N(t)

21

(3.26)

3 Der Kanal

ausgegangen, wobei R(t), X(t) und N(t) Zufallsprozesse des empfangenen Signals, des gesendeten Signals und des thermischen Rauschens bezeichnen.

Signale am Empfänger sind jedoch nicht nur durch Rauschen beeinflusst. Durch Mehrwegeausbreitung und Überlagerung einzelner Pfade an der Empfangsantenne können Amplitude

und Phase der entsprechenden Teilsignale variieren. Zudem können sich nacheinander gesendete Signale überlagern, was zu ISI (engl.: intersymbol interference) führt.

Das Sendesignal x(t) sei eine unmodulierte Trägerfrequenz und werde über verschiedene Pfade empfangen. Das empfangene Signal ist dann

R(t) = ∑ ai e( jθi ) x(t) + N(t),

(3.27)

i

wobei ai die Dämpfung und θi die Phase des i-ten Übertragungspfads bezeichnet. Die verschiedenen Phasen überlagern sich an der Empfangsantenne je nach Lage konstruktiv oder

destruktiv. Die Änderung der Phasenlage um 2π eines Pfads kann schon durch eine Laufzeitänderung von f1c hervorgerufen werden, wobei fc die Trägerfrequenz ist. Ist die Anzahl

der Pfade ausreichend groß und kein Pfad besonders ausgeprägt, kann diese Überlagerung

der verschiedenen Pfade mit ähnlicher Amplitude, aber unterschiedlicher Phasenlage, als rayleighverteilte Zufallsvariable A aufgefasst werden, die man Schwundamplitude nennt (vgl.

[Pro01] Kap. 14.1). Da wir von einem unmodulierten Träger ausgegangen sind, können wir

ISI ausschließen. Wir gehen weiterhin davon aus, dass wir die Phase perfekt schätzen können.

Wir nehmen also eine kohärente Detektion an. Wir erweitern das AWGN-Kanalmodell um die

rayleighverteilte Schwundamplitude A

R(t) = AX(t) + N(t),

(3.28)

wobei X(t) nun einen binären Zufallsprozess darstellt, der zu diskreten Zeitpunkten t die Werte

−1 und 1 annehmen kann. Da es sich um ein sehr schmalbandiges Signal handelt, haben wir

ISI ausgeschlossen. Wir wollen weiterhin annehmen, dass die Schwundamplitude für einen

Block konstant ist, was man insgesamt als nicht-frequenzselektiven, langsamen Schwundkanal

(engl.: non-frequency selective slowly fading channel) bezeichnet (vgl. [Pro01] Kap. 14.3).

3.2.1 Was bewirkt Rayleigh-Schwund?

Wie oben beschrieben, wird die Amplitude des Signals zu einer Zufallsvariablen A, die durch

die Rayleighverteilung beschrieben werden kann. Damit ist die Energie des Signals χ 2 -verteilt

und somit ist auch der Störabstand, gegeben als γb = a2 ε b /N0 [Pro01], χ 2 -verteilt. Für den

mittleren Störabstand Γb gilt:

22

3 Der Kanal

εb

E {Γb } = E A2

,

N0

=

Z ∞

−∞

(3.29)

γb p(γb ) dγb = Γb .

| {z }

(3.30)

χ 2 −verteilt

Die Schwundamplitude

Amuss dabei so normiert werden, dass das zweite Moment dieser

Schwundamplitude E A2 = 1 ist, damit der mittlere Störabstand nur von dem Ausdruck

ε s/N0 abhängt. Für die mittlere Bitfehlerrate ergibt sich:

BER(Γb ) = E {P(γb )} =

Z ∞

−∞

P(γb ) p(γb ) dγb ,

| {z }

(3.31)

χ 2 −verteilt

wobei P(γb ) die Bitfehlerrate im AWGN-Kanal beschreibt. Um eine Kurve der Bitfehlerwahrscheinlichkeit als Funktion des mittleren Störabstands Γb zu erhalten, muss diese Berechnung

für jeden mittleren SNR-Wert durchgeführt werden. Das Ergebnis stellt die Bitfehlerwahrscheinlichkeit für eine Übertragung mit einer rayleighverteilten Amplitude A dar.

3.2.2 Implementierung

Bislang haben wir für die Berechnung des Störabstands im AWGN-Kanal die Sendeenergie konstant gehalten und die Rauschvarianz errechnet (vgl. (3.9)). Einfacher wird es, wenn

wir im Weiteren für die Berechnung des Störabstands die Schwundamplitude A so variieren,

dass deren zweites Moment der geforderten Sendeleistung entspricht. Für die Simulation des

Rauschprozesses kann anschließend eine standardnormalverteilte Zufallsvariable hinzuaddiert

werden.

Für jede mittlere Schwundamplitude Γb ergeben sich andere Parameter der Verteilung. Erwartungswert und Varianz ändern sich dabei in Abhängigkeit des Störabstands. Sei für die

folgende Überlegung der mittlere Störabstand Γb = E A2 εN0b = 1. Damit ε b /N0 dem mitt leren Störabstand entspricht, muss das zweite Moment der Amplitude E A2 = 1 sein. Das

zweite Moment einer Rayleighverteilung ist gegeben als

2

2

2

2 2

E R

= 2σ

(3.32)

Γ 1+

= 2σ 2 ,

2

wobei σ 2 die Varianz der zu Grunde liegenden Gaußverteilung ist und Γ(·) die Gammafunktion bezeichnet. Man erkennt sofort, dass die Varianz der zu Grunde liegenden Gaußvertei-

23

3 Der Kanal

lung

2σ 2 = 1

1

σ = √

2

(3.33)

sein muss, um E A2 = 1 zu erhalten.

Die Implementierung einer Rayleighverteilung lässt sich realisieren, indem man die Wurzel

aus der Summe der Quadrate zweier Gaußverteilungen zieht. Die Standardnormalverteilung

N (0; 1) ist in M ATLAB® implementiert. Um daraus eine beliebige Gaußverteilung zu generieren, wird von der Formel

X − mX

Z=

(3.34)

σX

Gebrauch gemacht, die jede Zufallsvariable X ∼ N (mX ; σX ) in eine standardnormalverteilte

Zufallsvariable Z ∼ N (0; 1) umrechnet [Bro05]. Umgestellt nach X ergibt sich:

X = σX Z + mX .

(3.35)

Um nun die o.g. Normierung in die Gaußverteilung zu implementieren, muss man die Varianz

σX2 beider Gaußverteilungen so ändern, dass der Erwartungswert der Rayleighverteilung eins

ist. Der Normierungsfaktor ist √12 . Für jeden anderen mittleren Störabstand kann dieser Faktor

konstant bleiben, da er ein neutrales Element in der Berechnung ist. Hier der dazugehörige

Quelltext in Matlab, wobei die Variable SNR das Verhältnis ε b /N0 bezeichnet:

% Berechnung der momentanen Fadingamplitude a

a = sqrt(1/2 * (sqrt(10^(SNR/10)) * randn(1,1)).^2 ...

+ (sqrt(10^(SNR/10)) * randn(1,1)).^2);

% Berechnung der einzelnen Bits

r_ges = a*x_ges + randn(length(x_ges),1)’;

3.2.3 Numerische Berechnung der Bitfehlerwahrscheinlichkeit im

Kanal mit Rayleigh-Schwund

Die Bitfehlerkurve für eine BPSK-Übertragung im Kanal mit Rayleigh-Schwund gibt Proakis

[Pro01] mit

s

P2 =

1

1−

2

24

Γb

1 + Γb

(3.36)

3 Der Kanal

an. Um eine theoretische Bitfehlerkurve für den Fall einer Turbocodierung erzeugen zu können, braucht man eine analytische Funktion für die Bitfehlerraten des Turbocodes. Die Herleitung würde jedoch den Rahmen dieser Arbeit sprengen. Allerdings kann man annäherungsweise auch numerisch zu einer Lösung kommen. Dazu wird das Integral in (3.31) in eine

Summe gewandelt:

n

γbi

1

BER(Γb ) ≈ ∑ BER(γbi ) exp(− )∆γbi ,

(3.37)

Γb

Γb

i=0

wobei n die Anzahl der simulierten Werte ist. Die Abstände ∆γb i müssen äquidistant sein. Da

eine Berechnung mit logarithmischen Werten hier keinen Sinn ergibt, wurden hierfür Simulationen mit äquidistanten Abständen durchgeführt.

25

4 Faltungscodierung

Um die Bitfehlerwahrscheinlichkeit bei einer Übertragung über einen Kanal mit Rauschen und

Schwund zu reduzieren, wird strukturiert Redundanz zu der eigentlichen Nachricht hinzugefügt, mit deren Hilfe Fehler erkannt und teilweise korrigiert werden können. Das Hinzufügen

von Redundanz wird Kanalcodierung genannt. Ein Kanalencoder weist jeder Nachricht mit

einer Länge von k Bits ein Codewort mit der Länge n Bits zu, wobei n > k ist. Jeder Code

ist durch seine Coderate R = k/n < 1 charakterisiert. Je unterschiedlicher die Codewörter untereinander sind, desto besser ist die Fehlerkorrektur des Codes [VY00]. Die Nachteile, die

durch das Hinzufügen von Redundanz gegenüber einem uncodierten System entstehen, sind

eine verminderte Übertragungsrate oder ein größerer Bedarf an Bandbreite. Die folgenden

Beschreibungen beruhen hauptsächlich auf [VY00], [Pro01] und [Vog02].

4.1 Faltungsencoder

Die Faltungscodierung (engl.: convolutional coding) wird in dieser Arbeit kurz beschrieben,

weil sie ein Bestandteil der Turbocodierung ist. Außerdem gehören die Faltungscodes neben den Blockcodes zu den wichtigsten Codes in der Nachrichtentechnik. Die Faltungscodierung kommt in Anwendungen wie zum Beispiel der Satellitenkommunikation, im Mobilfunk

und der digitalen Videoübertragung (engl.: Digital Video Broadcasting (DVB)) zum Einsatz.

Faltungscodes sind lineare Codes, die sich relativ einfach durch eine Maximum-LikelihoodDecodierung, den Viterbi-Algorithmus, decodieren lassen [VY00], [Vog02]. Linear bedeutet

in diesem Zusammenhang, dass die Summe zweier Codeworte wieder ein Codewort ergibt.

In Bild 4.1 ist ein Faltungsencoder mit der Coderate R = 1/2 zu sehen. Dieser Encoder besteht

aus einem Schieberegister mit zwei Speicherelementen und zwei Modulo-2-Addierern. Für

ein Eingangsbit ct erzeugt der Encoder zwei codierte Ausgangsbits vt,0 und vt,1 . Die binäre

Eingangssequenz des Encoders sei

c = (· · · , c−1 , c0 , c1 , · · · , ct , · · · ),

26

(4.1)

4 Faltungscodierung

wobei t eine Zeitkonstante ist [VY00].

+

v0

c

v

v1

+

Abbildung 4.1: Ein Faltungsencoder mit der Coderate R = 1/2, [VY00].

Der Encoder erzeugt zwei ebenfalls binäre Ausgangssequenzen

v0 = (· · · , v−1,0 , v0,0 , v1,0 , · · · , vt,0 , · · · )

v1 = (· · · , v−1,1 , v0,1 , v1,1 , · · · , vt,1 , · · · ),

(4.2)

indem die Elemente der Eingangssequenz addiert werden gemäß

vt,0 = ct + ct−1 + ct−2

vt,1 = ct + ct−2 ,

(4.3)

wobei + einer Modulo-2 Addition entspricht. Da der Encoder zwei Speicherelemente hat, sagt

man, dass er ein Gedächtnis von m = 2 hat. Die Ausgangsbits werden von den zwei Bits in

den Speicherelementen und dem Eingangsbit zum Zeitpunkt t bestimmt, d.h. die drei letzten

Bits beeinflussen den Wert des Ausgangsbits. Aus diesem Grund sagt man, dass der Encoder

eine Einflußlänge (engl.: constraint length) von k = 3 hat. Die Bitsequenzen v0 und v1 werden

mittels eines Multiplexers zu einer Ausgangsbitsequenz

27

4 Faltungscodierung

v = (· · · , v−1,0 , v−1,1 , v0,0 , v0,1 , v1,0 , v1,1 , · · · , vt,0 , vt,1 , · · · )

(4.4)

zusammengefasst. Zusätzlich kann ein Encoder durch seine Generatorvektoren beschrieben

werden. Die Vektoren ergeben sich durch die Verbindungen zwischen den Speicherelementen

und den Addierern. Der obere Addierer ist zum Beispiel direkt mit dem Eingang des Encoders, dem Ausgang des ersten Speicherelements und mit dem Ausgang des zweiten Speicherelements verbunden. Daraus ergibt sich der Generatorvektor zu

g0 = (g0,0 g1,0 g2,0 ) = (111)2 = (7)8 .

(4.5)

Für den unteren Addierer ergibt sich der Vektor

g1 = (g0,1 g1,1 g2,1 ) = (101)2 = (5)8 ,

(4.6)

da er mit dem Eingang des Encoders und dem Ausgang des zweiten Speicherelements verbunden ist. In den meisten Fällen werden die Vektoren in oktaler Form angegeben. Neben (4.3)

können die Ausgangsbitsequenzen auch mit Hilfe der Generatorvektoren

vi = c ∗ gi

(4.7)

errechnet werden, wobei ∗ der Faltungsoperator ist. Aus dieser Tatsache ergibt sich auch der

Name für die Faltungscodierung [VY00]. Für einen Zeitpunkt t gilt dann entsprechend

m

vt,i =

∑ ct− j g j,i ,

i = 0, 1 ,

(4.8)

j=0

wobei m die Anzahl der Speicherelemente ist. Neben den Generatorvektoren kann ein Faltungsencoder auch durch Generatorpolynome beschrieben werden, was einer Z-Transformation

−k

−1

in den Bildbereich entspricht. Für die Z-Transformation gilt X(z) = ∑∞

k=0 xk z , mit D = z

k

folgt daraus X(D) = ∑∞

k=0 xk D . So hat der Encoder aus Abbildung 4.1 die Generatorpolynome

g0 (D) = 1 + D + D2

28

(4.9)

4 Faltungscodierung

und

g1 (D) = 1 + D2 ,

(4.10)

wobei D ein Verzögerungsoperator ist und der Exponent die Anzahl der Verzögerungsschritte

angibt. Üblicherweise werden die Generatorpolynome in der sogenannten Generatormatrix

G(D) = [1 + D + D2

1 + D2 ]

(4.11)

angeordnet [VY00]. Die Codierung kann nun folgendermaßen beschrieben werden:

v0 (D) = c(D)g0 (D)

v1 (D) = c(D)g1 (D).

(4.12)

Für die Ausgangssequenz v ergibt sich daraus

v(D) = c(D)G(D),

(4.13)

wobei

G(D) = [g0 (D) g1 (D)

···

gn−1 (D)]

(4.14)

v(D) = [v0 (D) v1 (D)

···

vn−1 (D)]

(4.15)

und

sind.

Da es sich bei einem Faltungsencoder um einen lineares Netzwerk mit festen Zuständen S

handelt, gibt es zwei gängige Methoden um einen Faltungscode grafisch zu beschreiben. Die

Methoden sind das Zustandsdiagramm und das Trellisdiagramm. In Abbildung 4.2 ist das

29

4 Faltungscodierung

Zustandsdiagramm des Faltungsencoders aus Abbildung 4.1 zu sehen. Es zeigt den Speicherinhalt der Speicherelemente innerhalb des Encoders, die als Zustand zum Zeitpunkt t beschrieben werden. Die Anzahl der Zustände ist 2m , wobei m die Anzahl der Speicherelemente ist.

Der Encoder in Abbildung 4.1 hat somit vier Zustände. Die Zustände des Encoders sind im

Diagramm als Knoten dargestellt und die Übergänge von einem Zustand zum anderen sind

als Linien zwischen den Knoten dargestellt. Die Beschriftung an den Linien zeigt zuerst das

Eingangsbit in den Encoder und dann die Ausgangsbits aus dem Encoder. Der aktuelle Zustand des Encoders ist abhängig vom vorigen Zustand und dem aktuellen Eingangsbit. Die

vier Zustände des Encoders in Abbildung 4.1 sind mit S0 , S1 , S2 , S3 benannt, wobei der Index

dem jeweiligen Integerwert des Zustands entspricht. Jeden Knoten verlassen zwei Linien, die

dem jeweiligen Zustand des Eingangsbits entsprechen.

0/00

S0 00

0/11

1/11

1/00

S1 01

10 S2

0/01

0/10

1/10

11 S3

1/01

Abbildung 4.2: Zustandsdiagramm für den Faltungsencoder in Abbildung 4.1 [VY00].

Eine Darstellung, in der zusätzlich zu den Zuständen noch die Zeitabhängigkeit gezeigt werden kann, ist das Trellisdiagramm. Bei diesem Diagramm werden alle Zustände zu jedem

Zeitpunkt und die Übergänge von einem Zustand zum anderen dargestellt. In Abbildung 4.3

ist das Trellisdiagramm des Faltungsencoders aus Abbildung 4.1 zu sehen. Es wird immer

davon ausgegangen, dass die beiden Speicherelemente des Encoders im Nullzustand starten

und somit auch das Trellisdiagramm im Nullzustand beginnt. Anschließend folgt das erste

Eingangsbit des Encoders, das entweder 1 oder 0 sein kann. Deswegen verlassen jeden Zustand zwei Linien. In Abbildung 4.3 steht eine gestrichelte Linie für eine 1 als Eingangsbit

und eine durchgezogene Linie für eine 0 als Eingangsbit. Die Anzahl der möglichen Zustände

ist abhängig vom Zeitpunkt der Codierung. Bei dem ersten Eingangsbit gibt es zwei mögliche

Zustände, den Zustand S = 10, falls es sich um eine 1 handelt und S = 00, falls es sich um

eine 0 handelt. Bei Zeitpunkt zwei gibt es schon 2 mal 2 mögliche Zustände, d.h. die An-

30

4 Faltungscodierung

zahl der Möglichkeiten verdoppelt sich von Zeitpunkt zu Zeitpunkt, bis die maximale Anzahl

erreicht ist [VY00]. Die maximale Anzahl wird nach dem Zeitpunkt m, also der Anzahl der

Speicherelemente, erreicht. Bei dem Encoder aus Abbildung 4.1 heißt das, dass zum Zeitpunkt t = m = 2 die maximale Anzahl von acht Möglichkeiten zu einem nächsten Zustand zu

gelangen erreicht ist und sich das Trellisdiagramm für die Zeitpunkte t > m wiederholt. Der

Vorteil eines Trellisdiagramms liegt darin, dass eine Eingangssequenz durch einen Pfad im

Diagramm dargestellt und codiert werden kann. Die Eingangssequenz c = (11001) führt zum

Beispiel zur codierten Ausgangssequenz v = (1110101111).

00

00

00

11

01

11

00

01

10

01

00

11

11

11

11

...

10

...

01

0

1

00

01

10

10

11

...

00

10

10

3

2

...

01

4

Abbildung 4.3: Trellisdiagramm für den Faltungsencoder in Abbildung 4.1 [VY00].

Bei der Codierung kann zwischen systematischen und nichtsystematischen Codes unterschieden werden. Ein systematischer Code ist ein Code, in dem die zu codierende Sequenz in

ihrer ursprünglichen Form enthalten ist. Bei dem Beispiel aus Abbildung 4.1 handelt es sich

um einen nichtsystematischen Code, da beide Ausgänge des Encoders durch die Generatorvektoren verändert werden. Bei einem Faltungscode kann ein systematischer Code dadurch

erzeugt werden, dass ein Ausgang direkt die Eingangssequenz weitergibt und der zweite Ausgang eine codierte Sequenz ausgibt, die durch eine Rückkopplung des Encoders erzeugt wird.

Solche Encoder werden rekursive systematische Faltungsencoder (engl.: recursive systematic convolutional-(RSC)-encoder) genannt. Ein Beispiel für einen RSC-Encoder ist in Abbildung 4.4 zu sehen. In diesem Beispiel wird der obere Zweig an den Eingang rückgekoppelt,

dadurch ergibt sich die Generatormatrix

G(D) = [1

g1 (D)

] = [1

g0 (D)

1 + D2

].

1 + D + D2

(4.16)

In Abbildung 4.5 ist das Zustandsdiagramm des RSC-Encoders dargestellt. Es hat die gleiche Struktur wie das Zustandsdiagramm des nichtsystematischen Encoders, wobei sich die

Anordnung der Zustände und die Ein- bzw. Ausgangsbits der Übergänge geändert haben.

31

4 Faltungscodierung

v0

c

+

+

v1

0/

00

Abbildung 4.4: Ein RSC-Encoder mit der Coderate R = 1/2.

00

1/11

01

10

1/

1/11

0/01

00

0/

0/01

11

1/

10

10

Abbildung 4.5: Zustandsdiagramm des RSC-Encoders aus Abbildung 4.4.

32

4 Faltungscodierung

Jeder nichtsystematische Encoder kann in einen systematischen Encoder überführt werden,

wobei die Trellisstruktur und die Codeworte gleich bleiben. Es ändern sich nur die Zuordnungen der Eingangssequenzen zu den Ausgangssequenzen. Die minimale Distanz der beiden

Encoder bleibt auch die gleiche, da sich die Codesequenzen nicht ändern. Der wichtigste Unterschied im Bezug auf die Turbocodierung ist, dass ein nichtsystematischer Encoder eine

endliche Impulsantwort (engl.: finite impuls response (FIR) ) und ein rekursiver systematischer Encoder eine unendliche Impulsantwort (engl.: infinite impuls response (IIR) ) hat, die

von seiner rekursiven Struktur herrührt. Dieser Unterschied spielt im Bezug auf die Distanzeigenschaften bzw. die Gewichte der Codesequenzen eine wichtige Rolle, wie im Abschnitt

zur Turbocodierung beschrieben wird.

4.1.1 Distanzeigenschaften

Die Distanzeigenschaften eines Codes bestimmen seine Leistungsfähigkeit. Hierbei unterscheidet man zwischen zwei Arten von Distanzen. Bei der Decodierung mit harten Entscheidungen, d.h. es wird nur anhand des Vorzeichens entschieden, welchen Wert das Bit hat,

wird im Decoder mit binären Symbolen gerechnet und die Hamming-Distanz verwendet. Die

Hamming-Distanz d ist die Anzahl der Bits, in der sich zwei Codewörter voneinander unterscheiden. Zum Beispiel ist die Hamming-Distanz d(v0 , v1 ) zwischen v0 = [101011] und

v1 = [001111] gleich zwei, da sie sich an der ersten und der vierten Stelle unterscheiden. Sie

kann durch eine XOR-Addition der beiden Sequenzen und anschließendem Aufsummieren

der Einsen berechnet werden. Je kleiner die Hamming-Distanz zwischen den einzelnen Codewörtern ist, desto leichter können Codeworte verwechselt werden, da die Anzahl der Stellen,

in denen sie sich unterscheiden, gering ist. Die minimale freie Distanz dfree gibt den kleinsten Unterschied an, der zwischen zwei unterschiedlichen Codeworten besteht. Da Faltungscodes linear sind, gibt das Gewicht der Modulo-2 Addition zweier Codewörter die minimale

Hamming-Distanz der beiden Codewörter an. Das Gewicht eines Codewortes gibt die Anzahl

der von null verschiedenen Elemente an. Daraus folgt, dass die minimale freie Distanz gleich

dem kleinsten Gewicht aller Codewörter, die verschieden von null sind, ist und somit die Nullsequenz, d.h. eine Sequenz, die nur aus Nullen besteht, als Referenz benutzt werden kann. Die

minimale freie Distanz kann nun herausgefunden werden, indem man alle Codewörter mit der

Nullsequenz vergleicht [VY00]. Die minimale freie Distanz des Encoders aus Abbildung 4.1

errechnet sich aus der v = [110111]. Es ist die Sequenz mit der geringsten Anzahl von Einsen,

die im Nullzustand startet und wieder im Nullzustand endet. Daraus folgt, das die minimale

freie Distanz des Encoders dfree = 5 ist.

Wird dagegen die Decodierung mit Zuverlässigkeitsinformationen verwendet, rechnet der Decoder mit quantisierten Werten, wobei die euklidische Distanz verwendet wird. Die euklidische Distanz ist der kürzeste Abstand zwischen zwei Punkten und wird folgendermaßen berechnet

33

4 Faltungscodierung

dE (v0 , v1 ) = |v0 − v1 | =

s

n

∑ |vt,0 − vt,1|2.

(4.17)

t=1

Auch für die euklidische Distanz gibt es eine minimale Distanz, die minimale freie euklidische

Distanz dE,free . Dabei handelt es sich um die minimale euklidische Distanz zwischen zwei

Codewörtern.

4.1.2 Gewichtsverteilung

Um einschätzen zu können, ob ein Code leistungsfähig ist, kann als erster Richtwert seine

minimale freie Distanz dfree betrachtet werden. Zur genaueren Betrachtung dient allerdings

seine Gewichtsverteilung, die aus dem erweiterten Zustandsdiagramm abgeleitet werden kann.

Dazu wurde das Zustandsdiagramm in Abbildung 4.2 erweitert zu dem Zustandsdiagramm in

Abbildung 4.6.

XY Z

S3

XY Z

Si

X 2Y Z

S2

XZ

XZ

S1

X 2Z

So

YZ

Abbildung 4.6: Erweitertes Zustandsdiagramm für den Encoder in Abb. 4.1 [VY00].

Bei dem erweiterten Zustandsdiagramm wird der Zustand S0 in den Anfangszustand Si und

den Endzustand So aufgeteilt und die Schleife, die um den Zustand S0 geht, entfernt, da sie

keinen Beitrag zur Gewichtsverteilung leistet. Jeder Pfad, der im Zustand Si startet und in

Zustand So endet, wird nun betrachtet. Dazu wird die Gewichtsverteilung eingeführt

{Adfree , Adfree +1 , · · · , Ai , · · · },

34

(4.18)

4 Faltungscodierung

wobei Ai die Anzahl der Codewörter ist, die das Gewicht i hat. Angewendet auf das erweiterte

Zustandsdiagramm ist Ai die Anzahl der Pfade mit dem Gewicht i, die den Anfangszustand Si

verlassen und den Endzustand So erreichen. In der Beschriftung im erweiterten Zustandsdiagramm in Abbildung 4.6 steht das X für eine unbestimmte Größe, deren Exponent das Gewicht

der codierten Ausgangssequenz i angibt, Y für eine unbestimmte Größe, deren Exponent das

Gewicht der Eingangssequenz j angibt und Z für eine unbestimmte Größe, deren Exponent

die Anzahl der Übergänge angibt, die zurückgelegt werden. Jeder Übergang im erweiterten

Zustandsdiagramm ist mit seiner Übergangsverstärkung in der Form X iY j Z versehen. Die Gewichtsverteilung des Codes kann nun aus der Erzeugerfunktion (engl.: generating function)

des erweiterten Zustandsdiagramms erzeugt werden. Dazu werden einige Gleichungen eingeführt, die sich aus dem erweiterten Zustandsdiagramm ergeben [VY00]:

S2

S1

S3

So

=

=

=

=

Y ZS1 + X 2Y ZSi

XZS2 + XZS3

XY ZS2 + XY ZS3

X 2 ZS1 .

(4.19)

(4.20)

(4.21)

(4.22)

Durch einige mathematische Umformungen kann die Erzeugerfunktion T (X,Y, Z) errechnet

werden [VY00] und ergibt sich zu

T (X,Y, Z) =

So

X 5Y Z 3

=

Si

1 − XY Z(1 + Z)

(4.23)

oder

T (X,Y, Z) =

+

+

+

X 5Y Z 3 + X 6Y 2 Z 4 + (X 6Y 2 + X 7Y 3 )Z 5

(2X 7Y 3 + X 8Y 4 )Z 6

(X 7Y 3 + X 8Y 4 + X 9Y 5 )Z 7

(3X 8Y 4 + 4X 9Y 5 + X 10Y 6 )Z 8 + · · · .

(4.24)

An der Erzeugerfunktion des erweiterten Zustandsdiagramms kann man nun sehen, dass die

minimale freie Distanz dfree des Codes dfree = 5 beträgt, da der Exponent von X den Wert fünf

hat. Die Anzahl der Pfade, die diese Distanz haben ist A5 = 1. Aus dem Exponent von Y ist zu

erkennen, dass die codierte Ausgangssequenz von einer Eingangssequenz mit dem Gewicht

35

4 Faltungscodierung

eins erzeugt wurde und der Exponent von Z zeigt, dass dafür drei Übergänge nötig waren.

Setzt man Z = 1 wird die Erzeugerfunktion zu

T (X,Y ) = X 5Y + 2X 6Y 2 + 4X 7Y 3 + 8X 8Y 4 + . . . .

(4.25)

Das Gleiche lässt sich auch für den RSC-Encoder aus Abbildung 4.4 darstellen. Das erweiterte

Zustandsdiagramm des RSC-Encoders ist in Abbildung 4.7 abgebildet.

XY Z

S3

XZ

Si

X 2Y Z

S2

XZ

XY Z

S1

X 2Y Z

So

Z

Abbildung 4.7: Erweitertes Zustandsdiagramm für den RSC-Encoder in Abb. 4.4 [VY00].

Für die Erzeugerfunktion ergibt sich aus Abbildung 4.7

T (X,Y ) = (X 6 − X 8 )Y 2 + (X 5 − 3X 7 )Y 3 + (−3X 6 + 2X 8 )Y 4 + 3X 7Y 5 − X 8Y 6 + · · · , (4.26)

wobei die beiden Erzeugerfunktionen (4.25) und (4.26) für unendlich lange Codesequenzen

gelten [Vit71]. Aus der Erzeugerfunktion erkennt man, dass die minimale freie Distanz für

den RSC-Encoder ebenfalls dfree = 5 ist. Der Unterschied ist, dass die minimale freie Distanz

des RSC-Encoder von einer Eingangssequenz mit einem Gewicht von drei erzeugt wurde und

nicht wie bei dem Encoder aus Abbildung 4.1 von einer Eingangssequenz mit einem Gewicht

von eins. Dieser Unterschied, der durch die unterschiedlichen Impulsantworten entsteht, spielt

bei der Turbocodierung eine wichtige Rolle.

36

4 Faltungscodierung

4.1.3 Punktierung

In manchen Fällen ist es notwendig, die Coderate zu variieren, um auf Veränderungen bei

der Übertragung reagieren zu können. Um dafür nicht jedes mal die Sender-Empfänger Kombination wechseln zu müssen, kann der Code entsprechend angepasst werden. Dazu werden

bestimmte Bits der codierten Sequenz bei der Übertragung weggelassen. Dieser Vorgang wird

Punktierung (engl.: puncturing) genannt. Wird zum Beispiel von der Ausgangssequenz des

Encoders aus Abbildung 4.1 ein Bit aus vieren punktiert, so entstehen aus zwei Eingangsbits

drei Ausgangsbits und die Coderate beträgt R = 2/3 [VY00]. Wichtig zu erwähnen ist hierbei, dass sich beim Punktieren das Trellisdiagramm nicht ändert. Erzeugt man einen Code mit

der Coderate R = 2/3 mit einem entsprechenden Encoder wird das Trellisdiagramm dagegen

komplizierter, da jetzt vier Pfade in jedem Knoten enden anstatt der zwei, die es bei dem

punktiertem Code sind. Außerdem können auch noch andere Coderaten erzeugt werden, ohne

die Struktur des Senders und des Empfängers zu verändern, was erhebliche Vorteile mit sich

bringt.

4.1.4 Terminierung

Für die Decodierung von Faltungscodes in praktischen Systemen ist es von Vorteil, mit endlichen Blocklängen zu rechnen, um die Komplexität des Decodierers möglichst in einem verträglichen Rahmen zu halten. Wie schon erwähnt, wird immer im Nullzustand des Encoders

mit der Codierung begonnen. Um eine endliche Blocklänge zu erreichen, werden an die Eingangssequenz noch sogenannte Tail-Bits angehängt, die den Encoder im Nullzustand enden

lassen. Die Anzahl der Tail-Bits ist gleich der Anzahl der Speicherelemente des Encoders.

Dies bringt deswegen Vorteile bei der Decodierung, da der Decoder dann weiß, in welchem

Zustand das Codewort begonnen und in welchem Zustand es beendet wurde. Bei einem nichtsystematischen Encoder reicht es, eine Reihe von Nullen an die eigentliche Eingangssequenz

anzuhängen. Bei einem RSC-Encoder dagegen muss der letzte Zustand bekannt sein, um zu

wissen welche Bits den Encoder dazu bringen, im Nullzustand zu enden. Dies kann im Falle

des RSC-Encoders aus Abbildung 4.4 durch eine einfache Matrix

MTail

0

1

=

1

0

0

0

1

1

(4.27)

geschehen, wobei die Zeile der Matrix dem letzten Zustand des RSC-Encoders entspricht und

die beiden Spalten das erste und zweite Tail-Bit angeben, das angehängt werden muss, um

37

4 Faltungscodierung

den RSC-Encoder zu terminieren. Ist der letzte Zustand des RSC-Encoders zum Beispiel der

Zustand S2 , muss die Sequenz cTail = (11) an die Nachricht angehängt werden. Durch die

Terminierung des Faltungscodes ändert sich die Coderate zu

RT =

τ

,

n(τ + m)

(4.28)

wobei τ die Länge eines Blocks ist, m ist die Anzahl der Tail-Bits und n ist die Länge eines

Codewortes bei einem Eingangsbit. Bei großen Blocklängen kann aber RT ≈ R angenommen

werden [Vog02].

4.2 Faltungsdecodierung

4.2.1 Viterbi-Decodierung

Der Viterbi-Algorithmus (VA) ist dazu geeignet, verschiedene Codierungen zu decodieren, die

auf zeitdiskreten Markov-Prozessen mit definierten Zuständen beruhen und sich durch Trellisdiagramme darstellen lassen. Dabei erzeugt der VA Schätzungen der Eingangssequenzen,

die durch die Markov-Quelle, wie zum Beispiel den Faltungsencoder aus Abbildung 4.1, erzeugt wurden. Der VA macht sogenannte harte Entscheidungen (engl.: hard decisions), d.h. er

entscheidet anhand von Vorzeichen, ob es sich bei dem decodierten Bit um eine 1 oder eine

0, bzw. -1 bei BPSK Modulation, handelt. Trotzdem kann er auch Eingangssignale mit Zuverlässigkeitsinformationen verarbeiten. Hier wird davon ausgegangen, dass der nichtrekursive

Encoder aus Abbildung 4.1 benutzt wird. Die Eingangssequenz ist

c = (c1 , c2 , · · · , ct , · · · , cN ),

(4.29)