Grundlagen der Verteilungskonvergenz zufälliger Funktionen

Werbung

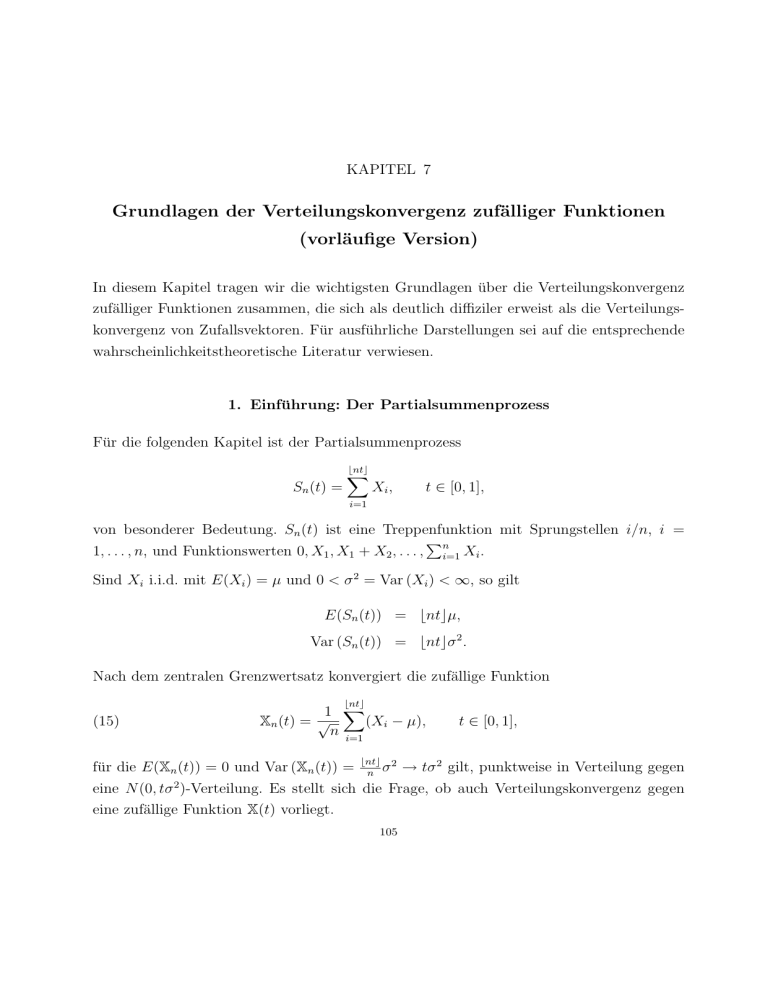

KAPITEL 7

Grundlagen der Verteilungskonvergenz zufälliger Funktionen

(vorläufige Version)

In diesem Kapitel tragen wir die wichtigsten Grundlagen über die Verteilungskonvergenz

zufälliger Funktionen zusammen, die sich als deutlich diffiziler erweist als die Verteilungskonvergenz von Zufallsvektoren. Für ausführliche Darstellungen sei auf die entsprechende

wahrscheinlichkeitstheoretische Literatur verwiesen.

1. Einführung: Der Partialsummenprozess

Für die folgenden Kapitel ist der Partialsummenprozess

Sn (t) =

bntc

X

Xi ,

t ∈ [0, 1],

i=1

von besonderer Bedeutung. Sn (t) ist eine Treppenfunktion mit Sprungstellen i/n, i =

P

1, . . . , n, und Funktionswerten 0, X1 , X1 + X2 , . . . , ni=1 Xi .

Sind Xi i.i.d. mit E(Xi ) = µ und 0 < σ 2 = Var (Xi ) < ∞, so gilt

E(Sn (t)) = bntcµ,

Var (Sn (t)) = bntcσ 2 .

Nach dem zentralen Grenzwertsatz konvergiert die zufällige Funktion

bntc

(15)

1 X

Xn (t) = √

(Xi − µ),

n i=1

für die E(Xn (t)) = 0 und Var (Xn (t)) =

bntc 2

σ

n

t ∈ [0, 1],

→ tσ 2 gilt, punktweise in Verteilung gegen

eine N (0, tσ 2 )-Verteilung. Es stellt sich die Frage, ob auch Verteilungskonvergenz gegen

eine zufällige Funktion X(t) vorliegt.

105

Die Autokovarianzfunktion des Prozesses Xn (t) berechnet sich wie folgt: Für s < t ist

bnsc bntc

bnsc

1 XX

E(Xi Xj ) = σ 2

→ s = σ 2 min(s, t).

Cov (Xn (s), Xn (t)) =

n i=1 j=1

n

Somit sollten auch alle sog. Projektionen von Xn auf k ∈ N Zeitpunkte t1 < · · · < tk asymptotisch multivariat normalverteilt sein, und zwar mit asymptotischer Kovarianzmatrix

Σt1 ,...,tk = (min(ti , tj ))i=1,...,k;

j=1,...,k

.

Satz 7.1. X1 , . . . , Xn seien i.i.d. mit 0 < σ 2 = Var (Xi ) < ∞. Für alle k ∈ N und alle

0 ≤ t1 < · · · < tk ≤ 1 gilt:

d

(Xn (t1 ), . . . , Xn (tk )) → N (0, Σt1 ,...,tk ),

für n → ∞.

Beweis. O.E. sei µ = E(Xi ) = 0. Wir wenden die Cramer-Wold-Technik an. Sei

λ = (λ1 , . . . , λk )0 ∈ Rk \{0}. Dann ist

bntj c

k

1 X X

λj Xn (tj ) = √

λj

Xi

n

j=1

j=1

i=1

k

X

bntk c

k

1 X X

√

=

λj

Xi 1(i ≤ bntj c)

n j=1

i=1

!

n

k

X

1 X

√

=

λj 1(i ≤ bntj c) Xi

n

i=1

j=1

Dies ist eine gewichtete Summe

Pn

i=1

ani Xi mit Gewichten

k

1 X

λj 1(i ≤ bntj c).

ani = √

n j=1

106

√

Es gilt maxi |ani | ≤ k maxj=1,...,k |λj |/ n → 0, für n → ∞. Ferner

n

X

n

k

k

1 XXX

=

λj λk 1(i ≤ bntj c)1(i ≤ bntl c)

n i=1 j=1 l=1

a2ni

i=1

=

k

X

λj λl n

=

j,l=1

n

X

1 (i ≤ min(bntj c, bntl c))

i=1

j,l=1

k

X

−1

λj λl

min(bntj c, bntl c)

n

Damit folgt

n

X

a2ni

i=1

→

k X

k

X

λj λl min(tj , tl ) = λ0 Σt1 ,...,tk λ,

j=1 l=1

wenn n → ∞. Sei X ∼ N (0, Σt1 ,...,tk ). Dann gilt λ0 X ∼ N (0, λ0 Σt1 ,...,tk λ). Also ist gezeigt:

Xn (t1 )

d 0

..

→ λ X,

n → ∞.

λ0

.

Xn (tk )

Dies ist äquivalent zu

d

(Xn (t1 ), . . . , Xn (tk ))0 → X,

n → ∞,

ist.

Existiert zur Familie von endlich-dimensionalen Verteilungen

{N (0, Σt1 ,...,tk ) : 0 ≤ t1 < · · · < tk ≤ 1, k ∈ N}

ein stochastischer Prozess X(t), t ∈ [0, 1], der genau diese Verteilungen als Marginalverteilungen besitzt, d.h.

(X(t1 ), . . . , X(tk )) ∼ N (0, Σt1 ,...,tk ),

also ein Gaußscher Prozess ist, dann liegt es nahe zu vermuten, dass Sn als Funktion in

Verteilung gegen X konvergiert. Dies wird sich richtig erweisen.

Wir benötigen daher einige Grundlagen über die Verteilungskonvergenz von zufälligen

Funktionen. Von Interesse ist für uns vor allem die Verteilungskonvergenz für stetige Funktionen, die oft als Limesprozesse auftreten, sowie natürlich rechtsstetige Funktionen mit

linksseitigen Grenzwerten.

107

Allgemein sei M eine Menge von Funktionen auf I ⊂ R (z.B. alle stetigen Funktionen

C(I)). d sei eine Metrik auf M . M sei zudem mit einer σ-Algebra B versehen, i.d.R. die

Borel-σ-Algebra, die von den offenen Mengen erzeugt wird, oder die σ-Algebra, die von

den offenen Bällen erzeugt wird.

Sei X : (Ω, A, P ) → (M, d) eine messbare Abbildung, d.h. es gelte X −1 (M ) ⊂ A. Dann

heißt X Zufallselement von M . Für jedes feste ω ∈ Ω heißt

t 7→ X(ω, t) := X(ω)(t),

t ∈ I,

Pfad oder Trajektorie. Die Realisationen X(ω) sind also Funktionen aus M .

Die Verteilung von X ist das Wahrscheinlichkeitsmaß PX auf M mit

PX (A) = P (X ∈ A),

A ⊂ M messbar.

Ist h : M → R eine messbare Funktion, dann gilt

Z

Z

h(X) dP = Eh(X) = h(x) dPX (x).

Für Anwendungen reicht oftmals das folgende wichtige Kriterium für Verteilungskonvergenz (schwache Konvergenz), das wir deshalb schon einmal formulieren wollen:

Hinreichendes Kriterium: Es sei Xn (t), t ∈ I = [a, b], ein stochastischer Prozess, d.h.

eine zufällige Funktion, mit beschränkten Pfaden. Für die Zuwächse gelte die MomenteBedingung

E|Xn (s) − Xn (t)|p ≤ K|s − t|r+1

für Konstanten p, K, r > 0, unabhängig von n. Gilt zusätzlich

d

(Xn (t1 ), . . . , Xn (tk )) → (X(t1 ), . . . , X(tk )),

n → ∞,

für alle a ≤ t1 < · · · < tk ≤ b und alle k ∈ N, dann existiert eine Version von X mit

stetigen Pfaden und Xn konvergiert als zufällige Funktion gegen X.

Für den Partialsummenprozess gilt für i.i.d.-Summanden:

Lemma 7.1. Seien X1 , . . . , Xn i.i.d. mit E(X1 ) = 0 und 0 < Var (X1 ) < ∞. Dann gibt

es eine Konstante C > 0, so dass für den zugehörigen Partialsummenprozess Xn - wie in

(??) definiert - gilt:

E(Xn (t) − Xn (s))4 ≤ C|t − s|2 ,

108

0 ≤ s ≤ t ≤ 1.

Beweis. Man hat wegen Xn (t) − Xn (s) =

1

E(Xn (t) − Xn (s)) ≤ 2

n

√1

n

Pbntc

i=bnsc+1

bntc

X

4

Xi

|E(Xi Xj Xk Xl )|.

i,j,k,l=bnsc+1

Der Erwartungswert E(Xi Xj Xk Xl ) ist nur dann nicht 0, wenn i = j = k = l (dies sind

bntc−bnsc Fälle) oder i = j 6= k = l (O ((bntc − bnsc)2 ) Fälle). Mit C = max((EX12 )2 , EX14 ))

folgt:

4

E(Xn (t) − Xn (s)) ≤ O

(bntc − bnsc)2

n2

Da der Bruch gegen |t − s|2 konvergiert, gibt es also eine Konstante C 0 , so dass die rechte

Seite für alle s, t ∈ [0, 1] und alle n ∈ N durch C 0 |s − t|2 beschränkt ist.

2. Einige Funktionenräume

Wir führen nun die für uns wichtigsten drei Funktionenräume ein.

2.1. Der Raum l∞ (I). Die Menge aller beschränkten Funktionen auf I sei mit

l∞ (I) = {f : I → R : kf k∞ < ∞}

bezeichnet, wobei

kf k∞ = sup |f (x)|

x∈I

die Supremumsnorm ist. Ist I = [−∞, +∞], so ist f ∈ l∞ (I), wenn

lim |f (x)| < ∞,

x→−∞

lim |f (x)|.

x→+∞

Die Supnorm induziert die Metrik

d(f, g) = kf − gk∞ ,

f, g ∈ l∞ .

Eine Menge heißt separabel, wenn sie eine abzählbar dichte Teilmenge enthält. l∞ ist

separabel, wenn I abzählbar ist. Ansonsten ist l∞ nicht separabel.

109

2.2. Der Raum C(I). Sei

C(I) = {f : I → R : f ist stetig}

die Menge aller stetigen Funktionen auf I, die wir ebenfalls durch die Supremumsnorm zu

einem normierten und damit auch metrischen Raum machen. C(I) ist vollständig, d.h. jede

Cauchyfolge konvergiert in C(I). Die Borel’sche σ-Algebra wird von den offenen Mengen

in C(I) erzeugt.

C(I) ist separabel, wenn I ⊂ Rn kompakt ist: Man nimmt die Funktionswerte von f ∈ C(I)

auf einem Gitter εZn mit Maschenweite ε > 0 und interpoliert dann linear. Da f auf I

gleichmäßig stetig ist, ist der Fehler glm. beschränkt durch sup{|f (x1 ) − f (x2 )| : kx1 −

x2 k∞ ≤ ε} → 0, ε → 0. Approximiert man nun die endlich (!) vielen Funktionswerte

an den Gitterpunkten, die in I liegen, durch rationale Zahlen, erhält man eine abzählbar

dichte Teilmenge.

2.3. Der Skorokhod-Raum D(I). Sowohl die empirische Verteilungsfunktion als

auch der Partialsummenprozess sind nicht Elemente von C(R) bzw. C[0, 1], da sie Sprünge

aufweisen.

Definition 7.1. Eine Funktion f : [a, b] → R heißt cadlag (continue à droite avec limite

à gauche), wenn für alle t ∈ [a, b) der rechtsseitige Limes,

f (t+) = lim f (s),

s↓t

existiert, für alle t ∈ (a, b] der linksseitige Limes

f (t−) = lim f (s),

s↑t

und wenn f den rechtsseitigen Grenzwert annimmt,

f (t) = f (t+).

Kurz: f ist rechtsstetig und besitzt linksseitige Grenzwerte.

Wir setzen

D(I) = {f : I → R : f ist cadlag}.

Offensichtlich gilt: C[a, b] ⊂ D[a, b] ⊂ l∞ .

110

Da Funktionen aus D[a, b] Sprünge haben dürfen, benötigen wir einen hierauf zugeschnittenen Konvergenzbegriff. Das heißt, wir müssen geeignet den Abstand zwischen Funktionen messen. Denken wir an die empirische Verteilungsfunktion Fn (x) einer Stichprobe

X1 , . . . , Xn , die an den Ordnungsstatistiken X(i) springt, so sollte gewährleistet sein, dass

Treppenfunktionen mit gleichen Sprunghöhen, aber geringfügig verschiedenen Sprungstellen, einen kleinen Abstand haben sollten. Dies ist nicht gewährleistet, wenn man die Supnorm verwendet:

Betrachten wir exemplarisch die Funktionenfolge

fn (x) = 1(x ≥ 1/2 + 1/n),

x ∈ I := [0, 1],

und die Funktion

f (x) = 1(x ≥ 1/2),

x ∈ I.

Da fn erst ab 1/2 + 1/n auf 1 springt und f (x) auf dem Invervall [1/2, 1/2 + 1/n) konstant

1 ist gilt für alle n

kfn − f k∞ = 1.

Somit konvergiert fn nicht in der Supnorm gegen f . Die Supnorm ist für Sprungfunktionen

also nicht besonders geeignet.

Das Problem kann man umschiffen, indem man vor der Abstandsmessung zweier Funktionen f, g mit der Supnorm bei einer der Funktionen die Sprungstellen durch eine Deformation des Argumentbereichs leicht verschiebt. Ist λ : I → I eine stetige Bijektion (also ein

Homöomorphismus), so können wir

sup |f (t) − g(λ(t))|

t∈I

betrachten. Für λ(t) = t erhält man die gewöhnliche Supnorm. Es ist naheliegend, die

supremale Abweichung von λ von der Identität noch in die Abstandsmessung einfließen zu

lassen. Wir definieren daher für ein festes λ

dλ (f, g) = sup |f (t) − g(λ(t))| + sup |t − λ(t)|

t∈I

t∈I

und minimieren dieses Maß über alle λ ∈ Λ, wobei

Λ = {λ : I → I : λ ist stetige Bijektion}

111

die Menge aller Homöomorphismen des Einheitsintervalls ist. Wir definieren also

d(f, g) = inf dλ (f, g).

λ

Man kann zeigen, dass hierdurch eine Metrik auf D(I) definiert wird. d heißt SkorokhodMetrik. Der metrische Raum (D(I), d) heißt auch Skorokhod-Raum. Die von d induzierte Topologie heißt Skorokhod-Topologie. Als topologischer Raum ist D(I) dann

separabel, aber nicht vollständig. Man kann die Metrik jedoch abändern, so dass sich die

Topologie nicht ändert und der zugehörige metrische Raum vollständig ist.

Konvergenz einer Folge fn gegen ein f ∈ D(I) in der Skorokhod-Metrik heißt: Es gibt eine

Folge λn ∈ Λ, so dass

lim sup |fn (x) − f (λn (t))| = 0

(16)

n→∞ t∈I

und

lim sup |λn (t) − t| = 0

(17)

n→∞ t∈I

Ist das Grenzelement f stetig, d.h. f ∈ C(I), so hat man sogar Konvergenz bzgl. der

Supnorm.

Lemma 7.2. Aus fn → f , n → ∞, bzgl. der Skorokhod-Metrik d und f ∈ C(I) folgt

Konvergenz in der Supnorm, d.h.

sup |fn (t) − f (t)| → 0,

n → ∞.

t∈I

Beweis. Nach Voraussetzung existiert eine Folge {λn }, so dass (15) und (16) gelten.

Da f als stetige Funktion auf I gleichmäßig stetig ist, folgt aus (16), also

k◦k∞

λ → id,

n → ∞,

k◦k∞

dass f ◦ λn → f ◦ id, n → ∞, d.h.

sup |f (λn (t)) − f (t)| → 0,

n → ∞.

t∈I

Die Dreiecksungleichung liefert nun

|fn (t) − f (t)| ≤ |fn (t) − f (λn (t))| + |f (λn (t)) − f (t)|,

woraus die Behauptung folgt.

112

Der Raum D(I), I = [a, b], ist separabel. Eine abzählbare dichte Teilmenge ist durch alle

Treppenfunktionen f mit rationalen Funktionswerten auf den Intervallen

i−1 i

,

,

1 ≤ i ≤ k,

k k

und rationalem Funktionswert f (b) gegeben.

Allerdings ist D(I) versehen mit der Metrik d nicht vollständig. Man kann allerdings eine äquivalente Metrik d0 betrachten, die also dieselbe Topologie erzeugt, so dass D(I)

vollständig wird.

2.4. Wahrscheinlichkeitsmaße auf C[a, b] und D[a, b]. Nach dem Konsistenztheorem von Kolmogorov existiert zu einer Familie von endlich-dimensionalen Verteilungen,

ein stochastischer Prozess X(t),

t ∈ T , T ⊂ R, welcher die vorgegebenen endlich-

dimensionalen Verteilungen als Marginalverteilungen besitzt, wenn die Konsistenzbedingung erfüllt ist.

Darüber hinaus gilt: Jedes Wahrscheinlichkeitsmaß PX auf C[a, b] bzw. D[a, b] eindeutig

durch seine endlich-dimensionalen Marginalien

P (X(t1 ) ∈ A1 , . . . , X(tk ) ∈ Ak ),

t1 < · · · < tk , k ∈ N, festgelegt.

Kennt man also die Verteilung aller Zufallsvektoren der Form

(X(t1 ), . . . , X(tk )),

so ist die Verteilung des ganzen Prozesses schon klar.

Insbesondere existieren Gaußsche Prozesse (normale Prozesse), das sind Prozesse,

deren Randverteilungen stets (multivariat) normalverteilt sind.

Ist für alle t1 < · · · < tk

Σ(t1 , . . . , tk ) ∈ Rk×k

eine k-dimensionale Kovarianzmatrix und µ(t1 , . . . , tk ) ∈ Rk , dann gibt es eine stochastischen Prozess N (t), t ∈ I, dessen k-dimensionale Marginalien multivariat normalverteilt

und durch {µ(t1 , . . . , tk ), Σ(t1 , . . . , tk ) : t1 < · · · < tk , k ∈ N} beschrieben sind:

(N (t1 ), . . . , N (tk )) ∼ N (µ(t1 , . . . , tk ), Σ(t1 , . . . , tk ))

113

3. Schwache Konvergenz in metrischen Räumen

Es ist üblich, den Begriff der Verteilungskonvergenz (schwachen Konvergenz) gleich für metrische Räume (M, d) zu definieren. In dieser Allgemeinheit bezieht er sich auf die Wahrscheinlichkeitsmaße auf M .

Sei X : (Ω, A, P ) → (M, d) ein Zufallselement und h : M → R eine messbare Funktion,

z.B. h(x) = supt∈I |x(t)|. Man kann h(x) als Kennzahl interpretieren, die x ∈ M zugeordnet

wird, und demzufolge Eh(X) als Kennzahl zur Charakterisierung des Prozesses X.

Definition 7.2. Sei {P, Pn } eine Folge von Wahrscheinlichkeitsmaßen auf M . {Pn } konvergiert schwach gegen P , wenn

Z

Z

h(x) dPn (x) → h(x) dP (x),

n→∞

für alle stetigen und beschränkten h : M → R, d.h. h ∈ Cb (M ).

Ist {Xn } eine Folge von Zufallselementen auf M , so konvergiert Xn schwach gegen X,

wenn die Folge der Verteilungen Pn = PXn definiert durch

Pn (A) = P (Xn ∈ A)

schwach gegen P konvergiert, P (A) = P (X ∈ A). Wir schreiben dann

w

Xn → X,

n → ∞,

oder auch - wenn keine Verwechslungsgefahr mit der Implikation besteht Xn ⇒ X,

n → ∞,

Xn konvergiert also schwach (in Verteilung) gegen X, wenn alle reellwertigen Charakteristika Eh(Xn ), h ∈ Cb (M ), gegen diejenigen von X konvergieren - als reelle Folge. Da eine

reelle Folge {xn } genau dann gegen x konvergiert, wenn jede Teilfolge eine weitere Teilfolge

enthält, die gegen x konvergiert, gilt:

Satz 7.2. (Folgenkriterium)

Es gilt Pn ⇒ P genau dann, wenn jede Teilfolge {Pn0 } eine weitere Teilfolge {Pn00 } enthält,

so dass Pn00 ⇒ P .

114

Satz 7.3. (Billingsley, Th. 1.3)

Zwei Wahrscheinlichkeitsmaße auf M stimmen überein, wenn

Z

Z

h(x) dP (x) = h(x) dQ(x)

für alle h ∈ C(M ).

Somit legen die Werte

R

f dP, f ∈ C(M ), schon ein Wahrscheinlichkeitsmaß fest.

Eine Menge A heißt P -stetig, wenn P (∂A) = 0. Hierbei ist ∂A der Rand von A.

Satz 7.4. (Portmanteau)

Äquivalent sind:

(i) Pn ⇒ P

R

R

(ii) h(x) dPn (x) → h(x) dP (x), n → ∞, für alle gleichmäßig stetigen und beschränkten Funktionen h : M → R.

(iii) limn→∞ Pn (A) = P (A) für alle P -stetigen Mengen A.

Per definitionem bleibt schwache Konvergenz unter stetigen Abbildungen erhalten. Man

kann dies Ergebnis ein wenig verfeinern.

Satz 7.5. (Stetigkeitssatz)

Schwache Konvergenz bleibt unter stetigen Abbildungen erhalten: Sei f : M → M 0 eine

Abbildung zwischen metrischen Räumen, jeweils versehen mit der Borel-σ-Algebra. Gilt

P (X ∈ {x : f unstetig in x}) = 0,

dann gilt:

w

Xn → X,

w

⇒

f (Xn ) → f (X)

Ist speziell M ein metrischer Raum von Funktionen f : I → R, so betrachte zu k Zeitpunkten t1 < · · · < tk die sog. k-dimensionale Projektionsabbildung

πt1 ,...,tk (f ) = (f (t1 ), . . . , f (tk )),

f ∈ M,

die jeder Funktion den Vektor ihrer Funktionswerte f (ti ) zuordnet. Man kann dies als

Approximation der Funktion f verstehen, z.B. indem man die zugehörige Treppenfunktion

oder den zugehörigen Streckenzug betrachtet. Offensichtlich ist πt1 ,...,tk stetig. Gilt nun

Xn ⇒ X,

n → ∞,

115

so folgt die Konvergenz der endlich-dimensionalen Marginalien,

πt1 ,...,tk (Xn ) = (Xn (t1 ), . . . , Xn (tk ))

d

→ (X(t1 ), . . . , X(tk )),

im Sinne der gewöhnlichen Verteilungskonvergenz einer Folge von Zufallsvektoren, und

zwar für beliebige Zeitpunkte t1 < · · · < tk und beliebiges k ∈ N. Diese Konvergenz

der endlich-dimensionalen Marginalien nennt man auch fidi-Konvergenz (engl.: finitedimensional marginals) und schreibt

Xn → X,

f idis

n → ∞,

f idis

n → ∞.

bzw.

Pn → P,

Es stellt sich die Frage, ob auch die Umkehrung gilt, also ob aus der Konvergenz der endlichdimensionalen Marginalien schon die schwache Konvergenz (Verteilungskonvergenz) der

ganzen zufälligen Funktion folgt.

Das folgende Beispiel zeigt, dass fidi-Konvergenz nicht hinreichend ist.

Beispiel 7.1. Der Prozess Xn ∈ C[0, 1] sei auf eine Funktion konzentriert, d.h.

P (Xn = xn ) = 1,

n ∈ N.

xn steige im Intervall [0, 1/n] linear von 0 nach 1 an, falle dann im Intervall (1/n, 2/m]

linear wieder auf 0 und verharre dort, d.h. xn (t) = 0, für t ∈ [2/n, 1]. Es gilt daher

kXn k∞ = 1 f.s. und für jede fest Wahl von Punkten 0 < t1 < · · · < tk < 1 gilt

(xn (t1 ), . . . , xn (tk )) → 0,

n → ∞.

Daher konvergieren die fidis gegen die Einheitsmasse in der Nullfunktion 0 ∈ C[0, 1]. Betrachte die Menge

A = {f ∈ C[0, 1] : kf k < 1/2}.

Weil kXn k∞ = 1 für alle n, gilt

P (Xn ∈ A) = 0.

Aber

P (X ∈ A) = 1,

116

da 0 ∈ A. A ist eine PX -stetige Menge, da ∂A = {f ∈ C[0, 1] : kf k = 1/2} und somit

P (X ∈ ∂A) = 0. Aber

Pn (A) = P (Xn ∈ A) = 0 6→ 1 = P (X ∈ A) = PX (A)

Dazu muss gesichert sein, dass das stochastische Verhalten von Xn (t) durch das Verhalten

an endlich vielen Zeitpunkten beliebig genau für n → ∞ beschrieben ist.

Angenommen, die Menge {Pn } der Verteilungen Pn = PXn sei folgenkompakt (relativ

kompakt), d.h. jede Teilfolge {Pn0 } enthalte eine weitere Teilfolge {Pn00 }, die schwach

gegen ein Wahrscheinlichkeitsmaß Q konvergiert:

Pn00 ⇒ Q.

Gilt zudem fidi-Konvergenz,

f idis

Pn → P,

so müssen die fidis von Q und P übereinstimmen. Somit gilt Pn00 ⇒ P und damit nach

dem Folgenkriterium

Pn ⇒ P.

fidi-Konvergenz zusammen mit Folgenkompaktheit ist also eine Lösung.

Wir benötigen nun praktikable Charakterisierungen der Folgenkompaktheit für die Räume

C(I) und D(I), um die Verteilungskonvergenz auf diesen Räumen zu beschreiben.

Vorher erwähnen wir noch den Zusammenhang zur Straffheit.

Eine Menge P von Wahrscheinlichkeitsmaßen heißt straff, wenn es zu jedem ε > 0 eine

kompakte Menge K = K(ε) gibt, so dass

P (K) > 1 − ε,

∀P ∈ P.

Ein Prozess {Xn } heißt straff, wenn die zugehorige Menge der Verteilung {PXn } straff ist,

also wenn es zu jedem ε > 0 eine kompakte Menge K gibt, so dass

P (Xn ∈ K) > 1 − ε,

∀n ≥ 1.

Dies bedeutet, dass sich die Pfade gleichmäßig in n mit beliebig großer Wahrscheinlichkeit

in einer kompakten Menge einfangen lassen.

Satz 7.6. (Prohorov)

Es gelten die folgenden Aussagen:

117

(a) Ist P straff, dann ist P folgenkompakt.

(b) Ist M separabel und vollständig, dann gilt: Ist P folgenkompakt, dann ist P straff.

3.1. Verteilungskonvergenz im Raum C[a, b]. Die Charakterisierung der relativ

kompakten Mengen liefert der Satz von Arzelà-Ascoli. Hierzu definieren wir den Stetigkeitsmodul

wf (δ; I) =

sup

|f (s) − f (t)|

|s−t|<δ, s,t∈I

als supremale Schwankung von f für s, t ∈ I mit |s − t| < δ.

Satz 7.7. Eine Teilmenge K ⊂ C[a, b] hat kompakten Abschluss genau dann, wenn

sup |f (0)| < ∞

f ∈K

und

lim sup wf (δ) = 0.

δ→0 f ∈K

Dies liefert:

Satz 7.8. {Xn } ist straff, wenn {Xn (0)} straff ist und für jedes ε > 0 ein δ ∈ (0, 1) und

ein n0 ∈ N existiert, so dass

!

(18)

P

sup

|Xn (s) − Xn (t)| ≥ ε

≤ η.

t≤s≤min(1,t+δ)

für alle n ≥ n0 und 0 ≤ t ≤ 1.

Hinreichend für (17) ist die Existenz von γ ≥ 0 und α > 1, so dass für eine nichtfallende

stetige Funktion F : I → R gilt:

(19)

P (|Xn (t1 ) − Xn (t2 )| ≥ ε) ≤

|F (t2 ) − F (t1 )|α

εγ

für alle t1 , t2 , n ≥ 1, sowie ε > 0.

Hinreichend für (19) ist die Momentebedingung

(20)

E|Xn (t2 ) − Xn (t1 )|γ ≤ |F (t2 ) − F (t1 )|α ,

die wiederum mit F (t) = t, γ = 4, α = 2 erfüllt ist, wenn

(21)

E(Xn (t2 ) − Xn (t1 ))4 = O(|t2 − t1 |2 ).

118

3.2. Verteilungskonvergenz im Raum D[a, b]. Die Kompaktheit einer Menge K ⊂

D(I), I = [a, b], wird beschrieben durch den Modul

wf0 (δ; I) = inf max wf (δ, [ti−1 , ti ])

{ti } 0<i≤r

wobei das Infimum über alle endlichen Mengen {ti } mit a = t0 < · · · < tr = b und

ti − ti−1 > δ sowie r ∈ N genommen wird. Eine Funktion f : I → R ist genau dann ein

Element von D[a, b], wenn limδ→0 wf (δ; I) = 0.

Satz 7.9. Eine Menge K ⊂ D[a, b] hat kompakten Abschluss in der Skorokhod-Topologie

genau dann, wenn K gleichgradig beschränkt ist,

sup sup |f (t)| < ∞,

f ∈K

t

und

lim wf0 (δ) = 0.

δ→0

Sei

TX = {t ∈ [a, b] : P (X(t) 6= X(t−)) = 0}

die Menge aller Punkte, in denen X f.s. stetig ist. Es gilt stets 0, 1 ∈ TX .

Satz 7.10. Es gilt

Xn ⇒ X,

in (D[a, b], d)

genau dann, wenn

d

(Xn (t1 ), . . . , Xn (tk )) → (X(t1 ), . . . , X(tk ))

für alle t1 , . . . , tk ∈ TX (Stetigkeitsstellen des Grenzprozesses),

P (X(1) 6= X(1−)) = 0,

und wenn für alle ε > 0

[F (t2 ) − F (t1 )]2α

ε2γ

für alle t1 ≤ t ≤ t2 , n ≥ 1, mit Konstanten γ ≥ 0 und α > 1/2 und einer nicht-fallenden

(22)

P (|Xn (t1 ) − Xn (t)| ≥ ε, |Xn (t2 ) − Xn (t)| ≥ ε) ≤

Funktion F (t).

Hinreichend für (21) ist

(23)

E|Xn (t) − Xn (t1 )|γ |Xn (t2 ) − Xn (t)|γ ≤ [F (t2 ) − F (t1 )]2α

119

Oftmals ist jedoch das im folgenden Abschnitt zitierte einfache und elegante hinreichende

Kriterium für Prozesse mit beschränkten Pfaden anwendbar.

3.3. Verteilungskonvergenz in l∞ . Für den Raum l∞ beschränken wir uns auf ein

einfaches hinreichendes Momenten-Kriterium für die schwache Konvergenz, welches zusätzlich die Stetigkeit des Grenzprozesses liefert.

Satz 7.11. (van der Vaart und Wellner, 1996)

Sei {Xn (t) : t ∈ [a, b]} ein stochastischer Prozess mit Pfaden in l∞ . Für die Inkremente

gelte die Momente-Bedingung

E|Xn (s) − Xn (t)|p ≤ K|s − t|r+1

für Konstanten p, K, r > 0, unabhängig von n. Gilt zusätzlich

f idis

Xn → X,

dann existiert eine Version von X mit stetigen Pfaden und Xn konvergiert schwach gegen

X:

Xn ⇒ X,

n → ∞.

3.4. Der Satz von Skorokhod/Dudley/Wichura, Skorokhod-Konstruktion.

I.F. sei der metrische Raum (M, d) versehen mit der σ-Algebra, die von den offenen Bällen

erzeugt wird. (Für den Skorokhod-Raum (D(I), d) ist diese σ-Algebra identisch mit der

Borel-σ-Algebra.)

Satz 7.12. Es gelte in (M, d)

Xn ⇒ X,

n → ∞,

und

P (X ∈ M0 ) = 1,

für eine messbare und separable Teilmenge M0 ⊂ M . Dann existiert ein Wahrscheinlichkeitsraum (Ω∗ , A∗ , P ∗ ) und

X ∗ , Xn∗ : Ω∗ → M

mit Verteilungen PX∗ n∗ = PXn und PX∗ ∗ = PX , also äquivalente Prozesse Xn∗ ≡ Xn , X ∗ ≡ X,

so dass d(Xn∗ , X) f.s. messbar ist und

f.s.

d(Xn∗ , X) → 0,

120

n → ∞.

Wir werden diesen Satz in der folgenden Situation anwenden:

Gilt im Skorokhod-Raum

Xn ⇒ X,

n → ∞,

und ist X f.s. stetig, d.h. X ∈ C(I) mit Wahrscheinlichkeit 1, dann gilt für verteilungsgleiche Prozesse Xn∗ , X ∗ fast sichere Konvergenz in der Skorokhod-Metrik,

d(Xn∗ , X ∗ ) → 0,

n → ∞.

Da X ∗ ∈ C f.s., gilt sogar

f.s.

kXn∗ − X ∗ k∞ → 0,

n → ∞.

Angenommen, man kann hieraus für eine interessierende Funktion f folgern

kf (Xn∗ ) − f (X ∗ )k∞ → 0,

n → ∞,

zumindest in Wahrscheinlichkeit. Folgt dann schon

f (Xn∗ ) ⇒ f (X ∗ ),

n → ∞,

und damit - wegen der Verteilungsgleichheit der ∗-Versionen zu den Originalprozessen,

f (Xn ) ⇒ f (X),

n→∞

?

Die Antwort ist positiv.

Corollary 3.1. X sei auf eine separable Teilmenge M0 ⊂ M konzentriert, d.h.

P (X ∈ M0 ) = 1.

Dann sind äquivalent:

(i) Xn ⇒ X,

n → ∞.

f.s.

(ii) d(Xn∗ , X ∗ ) → 0, n → ∞, für äquivalente Prozesse Xn∗ ≡ Xn und X ∗ ≡ X.

P

(iii) d(Xn∗∗ , X ∗∗ ) → 0, n → ∞, für äquivalente Prozesse Xn∗∗ ≡ Xn , X ∗∗ ≡ X.

121

Ergänzungen

Maße auf metrischen Räumen. Sei (M, d) ein metrischer Raum versehen mit der

Borel-σ-Algebra B = B(M ).

Satz 7.13. Jedes Wahrscheinlichkeitsmaß auf M ist regulär, d.h. zu jeder messbaren

Menge A und jedem ε > 0 gibt es eine abgeschlossene Menge F und eine offene Menge G,

so dass

(∗)

F ⊂A⊂G

und

(∗∗)

P (G − F ) ≤ ε.

Beweis. Sei

G = {A ∈ B : A regulär }.

Natürlich sind alle abgeschlossenen Mengen A in G, da man in diesem Fall F = A und für

G eine ’offene δ-Erweiterung’

G = {x ∈ M : d(x, A) < δ}

wählen kann. Wenn G eine σ-Algebra ist, folgt G = B. Wir verifizieren: (i) G ist abgeschlossen bzgl. der Komplementbildung. (ii) G ist abgeschlossen bzgl. abzählbarer Vereinigungen.

(i) ist klar. (ii) sieht man wie folgt: Sei An eine Folge aus G und Fn abgeschlossen und Gn

offen mit

Fn ⊂ An ⊂ Gn

und

P (Gn − Fn )leε/2n+1 .

Setze

F = ∪n≤n0 Fn ,

G = ∪n Gn

Dann ist F abgeschlossen und G offen. Wegen Fn ⊂ An gilt

F = ∪n≤n0 Fn ⊂ ∪n≤n0 An ⊂ ∪n An

und wegen An ⊂ Gn

∪n An ⊂ ∪n Gn = G.

122

Da Gn = Fn + (Gn − Fn ) folgt

P (G − F ) = P (∪n Gn − F )

≤ P (∪n Fn − F ) + P (∪n (Gn − Fn ) − F )

≤ ε/2 + P (∪n (Gn − Fn ))

X

≤ ε/2(1 +

1/2n ) = 3/2 ε.

n

123

![Vollständigkeit von C([a, b],K) - sigma](http://s1.studylibde.com/store/data/009172811_1-bd5ca2c4284ed0984363afec7e674138-300x300.png)