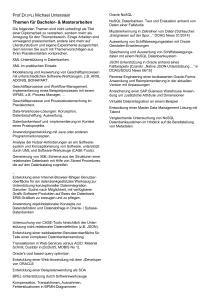

stem ns.

Werbung