Multiple lineare Regression

Werbung

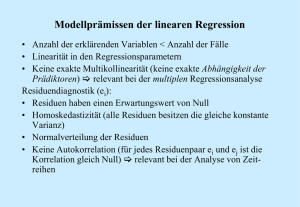

Vorlesung Wirtschaftsstatistik 2 (FK 040637) Multiple lineare Regression Dipl.-Ing. Robin Ristl Wintersemester 2012/13 1 Grundidee: Eine abhängige Variable soll als Linearkombination mehrerer unabhängiger Variablen und eines Fehlerterms erklärt werden. Modellgleichung wird also durch eine Konstante und unabhängige Variablen erklärt. Wie bei der einfachen linearen Regression setzen wir voraus: Die Fehler der einzelnen sind unabhängig. Die Fehler sind identisch normalverteilt mit Erwartungswert 0 und der Modellvarianz also und 2 , Matrixschreibweise für die Modellgleichung: ist also der Vektor der beobachteten abhängigen Werte. Die Matrix nennen wir Modell- oder Designmatrix. Sie enthält in Modellen mit einer Konstanten nur 1er. Die weiteren Spalten enthalten die Vektoren der unabhängigen Variablen bis . ist ein Vektor der als Einträge die Regressionskoeffizienten enthält und ist der Vektor der zufälligen Fehler. 3 Kleinste Quadrate Methode, um Regressionskoeffizienten zu schätzen Vorhersage Werte erhalten wir gemäß dem Modell aus den unabhängigen Größen Schätzung für die Regressionskoeffizienten als und einer Der Vektor der Residuen ist wie im einfachen Modell Wir wählen die Koeffizienten wieder so, dass die Summe der quadratischen Abstände zwischen beobachteten und vorhergesagten Werten minimal wird: Die Matrixschreibweise ist oft übersichtlicher: Die Lösung dieses Minimierungsproblems ist 4 Herleitung des kleinste Quadrate Schätzers wie im einfachen Modell durch Ableiten. Wir bilden den Gradienten , also den Vektor der partiellen Ableitungen von S nach den Einträgen von . An der Stelle eines Minimums (oder Maximums) muss der Gradient dem Nullvektor entsprechen: , wir benutzen folgende Regeln für eine symmetrische Matrix A und einen Vektor b: und , daher und daher (Die Matrix der zweiten Ableitungen ist positiv definit, damit liegt ein Minimum vor.) 5 Beispiel: Für acht Gewichtheber kennen wir ihre Höchstleistung in kg, ihre Trainingszeit pro Woche und ihre tägliche Proteinaufnahme in g/kg Körpergwicht. Wir wollen nun herausfinden, ob das gestemmte Gewicht von Trainingsintensität und Proteinzufuhr abhängt. Dazu berechnen wir ein linears Regressionsmodell der Form i 1 2 3 4 5 6 7 8 Gewicht Training Proteinzufuhr [kg] [h/Woche] [g/kg/d] 93 2 1.1 106 2 1.9 146 4 2 140 5 1.5 151 6 1.3 158 7 2.1 130 4 1.8 159 5 2.5 6 Das Modell lautet also: Wir berechnen 7 = Unser Modell lautet also Das würde bedeuten: Mit jeder zusätzlichen Trainingsstunde steigt das gestemmte Gewicht im Mittel um 11.2 kg und eine Erhöhung der Proteinzufuhr um 1 g erhöht das Gewicht im Mittel um 17.5 kg. Da der Bereich der Proteinwerte etwa zwischen 1 und 2 liegt wäre es hier sinnvoller zu sagen, eine Erhöhung der Proteinzuguhr um 0.1 g erhöht das gestemmte Gewicht um 1.75 kg. Aber wie gut erklärt unser Modell die Gewichtswerte überhaupt? 8 Quadratsummenzerlegung und (multiples) Bestimmheitsmaß Wie im einfachen Modell: Totale Quadratsumme: Erklärte Quadratsumme: Fehlerquadratsumme: Eine allgemeine Methode, um die Erklärungskraft des Modells zu prüfen, ist das darauf basierende Bestimmtheitsmaß . ist das Verhältnis aus erklärter Varianz und Gesamtvarianz: liegt zwischen 0 (keine Erklärungskraft) und 1 (perfekter Zusammenhang). 9 Im Beispiel sind die Vorhersagewerte (hier gerundet): Daraus ergibt sich Beachte: 10 Globaler F-Test Das Bestimmtheitsmaß spricht für hohe Erklärungskraft unseres Modells, wir wollen aber auch statistisch testen, ob das Modell signifikante Erklärungskraft besitzt. Dazu vergleichen wir die erklärte Varianz mit der Fehlervarianz. Wenn die erklärte Varianz signifikant größer als die Fehlervarianz ist, hat unser Modell signifikante Erklärungskraft. Das ist gleichbedeutend mit der Nullhypothese Oft wird der Test in Form einer Varianzanalysetabelle geschrieben: Erklärt Fehler Total Quadratsumme Freiheitsgrade SQE k-1 SQR n-k-1 SQT n-1 Mittlere QS MQE=SQE/(k-1) MQR=SQR/(n-k-1) F-Statistik f=MQE/MQR p-Wert P(F≥f) Erklärt Fehler Total Quadratsumme Freiheitsgrade 2 4135.88 5 3764.86 7 371.01 Mittlere QS 1882.43 74.20 F-Statistik 25.37 p-Wert 0.00241 11 Verteilung der F-Statistik und p-Wert Die F-Statistik folgt einer F-Verteilung mit Freiheitsgraden df1=k-1 und df2=n-k-1. Wir können über die Nullhypothese entscheiden, indem wir unsere F-Statistik mit dem kritischen Quantil aus dieser F-Verteilung vergleichen. Für ein Signifikanzniveau α=0.05 ist das , daher wird die Nullhypothese verworfen. Zumindest ein Koeffizient ( , ) ist daher ungleich 0. Oder mittels p-Wert: Der p-Wert ist die Wahrscheinlichkeit, dass eine F2,5 verteilte Zufallszahl größergleich f ist. Hier ist p=0.00241 < α=0.05, daher wird die H0 verworfen. 12 T-Tests für einzelne Koeffizienten folgt einer multivariaten Normalverteilung mit Erwartungswert und Varianz-Kovarianzmatrix Schätzer für VC durch einsetzen der Residuenvarianz: entspricht MQR aus der Varianzanalyse Tabelle, also Die Varianzen sind die Einträge in der Diagonale, die anderen Einträge sind die Kovarianzen. Also 13 Die Standardfehler sind die Wurzeln der Varianzen, also Wir testen H0: mit der bekannten Teststatistik Die Teststatistik folgt unter der H0 einer t-Verteilung mit n-k-1 Freiheitsgraden. Entscheiden über H0 wie im einfachen Modell mittels kritscher Grenzen oder p-Wert 14 Für H0: t liegt außerhalb der kritischen Grenzen, daher wird die H0 verworfen. Die Trainingszeit hat also signifikanten Einfluss auf das gestemmte Gewicht. Für H0: t liegt innerhalb der kritischen Grenzen, daher kann die H0 nicht verworfen werden. Wir können nicht schließen, dass die Proteinmenge signifikanten Einfluss auf das gestemmte Gewicht hat. 15 Im Output aus dem Statistikprogramm R zu unserem Beispiel sind alle bisherigen Berechnungen enthalten: Call: lm(formula = gewicht ~ training + protein) Residuals: 1 2 -4.148 -5.144 3 10.860 4 2.484 5 6 5.860 -12.259 7 -1.641 8 3.989 Coefficients: Estimate Std. Error t value Pr(>|t|) (Intercept) 55.657 13.860 4.016 0.01016 * training 11.123 1.918 5.799 0.00215 ** protein 17.496 7.437 2.352 0.06536 . --Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1 Residual standard error: 8.614 on 5 degrees of freedom Multiple R-squared: 0.9103, Adjusted R-squared: 0.8744 F-statistic: 25.37 on 2 and 5 DF, p-value: 0.00241 16 Konfidenzintervalle für Prognosen im multiplen linearen Regressionsmodell Den Prognosewert an der Stelle erhalten wir ganz einfach über die Modellgleichung als ist dabei ein Zeilenvektor der Form Prognoseintervall für erwarteten Wert an der Stelle : Prognoseintervall für einen individuellen Wert an der Stelle 17 : Beispiel: Prognoseintervalle das gestemmte Gewicht bei Training 2 h/Woche und Proteinaufname 1.5 g/Tag/kg Körpergewicht Prognosewert für das Gewicht: 104.15 95% Konfidenzintervall für das erwartete Gewicht mit diesem 95% Konfidenzintervall für Erwartungswert: 18 95% Konfidenzintervall für beobachtetes (individuelles) Gewicht mit diesem 95% Konfidenzintervall für Beobachtung: 19 Überprüfen der Modellvoraussetzungen für den Fehlerterm Varianzhomogenität kann wieder mit einem Residuenplot untersucht werden. Die Residuen werden gegen die Vorhersagewerte aufgetragen. Die Streuung der Residuen soll möglichst unabhängig von den Vorhersagewerten sein. Residuenplot für unser Beispiel. Die Darstellung spricht nicht gegen die Annahme von Varianzhomogenität, allerdings erschwert die geringe Beobachtungszahl die Interpretation. 20 Die Normalverteilungsannahme für den Fehler kann wieder mit einem Quantil-Quantil Plot der standardisierten Residuen geprüft werden. Standardisierte (oder intern studentisierte) Residuen berechnet, nur wird allgemeiner formuliert. werden wie im einfachen Modell mit ist das i-te Diagonalelement der Matrix In unserem Beispiel ist H = (die Werte sind gerundet) 0.57 0.27 0.07 0.18 0.17 -0.21 0.15 -0.2 0.27 0.45 0.22 -0.01 -0.18 -0.13 0.18 0.21 0.07 0.22 0.18 0.05 -0.01 0.11 0.14 0.24 0.18 -0.01 0.05 0.22 0.31 0.17 0.1 -0.02 0.17 -0.18 -0.01 0.31 0.51 0.26 0.07 -0.13 -0.21 -0.13 0.11 0.17 0.26 0.45 0.09 0.27 21 0.15 0.18 0.14 0.1 0.07 0.09 0.13 0.14 -0.2 0.21 0.24 -0.02 -0.13 0.27 0.14 0.49 Die standardisierten Residuen tragen wir wieder gegen die Quantile , der Standardnormalverteilung auf. i 6 2 1 7 4 8 5 3 -12.26 -5.14 -4.15 -1.64 2.48 3.99 5.86 10.86 6.37 6.4 5.63 8.02 7.61 6.17 6.05 7.81 j 1 2 3 4 5 6 7 8 -1.93 -0.8 -0.74 -0.2 0.33 0.65 0.97 1.39 0.06 0.19 0.31 0.44 0.56 0.69 0.81 0.94 -1.53 -0.89 -0.49 -0.16 0.16 0.49 0.89 1.53 i ist der ursprüngliche Index, j ist der Index der aufsteigend geordneten Residuen. ist die empirische Verteilungsfunktion. Für den Plot tragen wir also (sample quantiles) gegen (theoretical quantiles) auf. 22 Im QQ-Plot für unser Beispiel liegen die Punkte annähernd entlang einer Geraden, wir können also von normalverteilten Fehlern ausgehen. 23