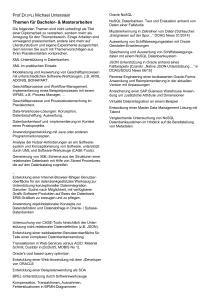

Schneller zum Wesentlichen!

Werbung