Projekt RoadRunner

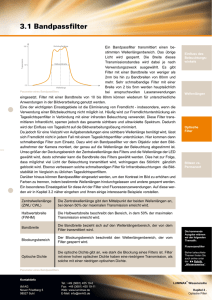

Werbung