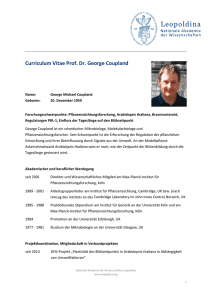

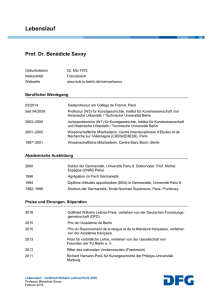

forschung

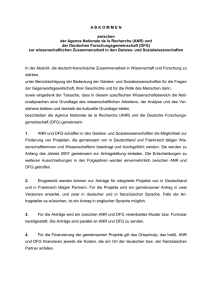

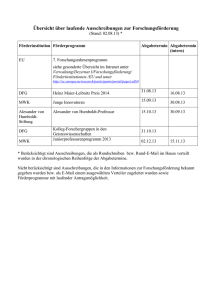

Werbung