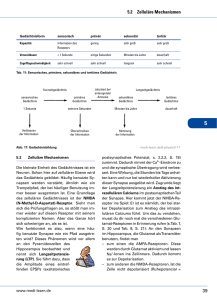

Lernen, Gedächtnis, Sprache

Werbung