Informatik I/II

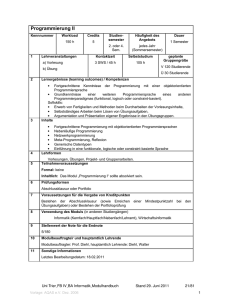

Werbung

ii

Sonstiges 1.Auflage 1993 Prof. Dr. Kupka

2.Auflage 1994 überarbeitet und erweitert von Prof. Dr. Ecker

3.Auflage 1997 überarbeitet

4.Auflage 1998 unverändert

5.Auflage 1999 überarbeitet und erweitert

An dieser Version haben mitgearbeitet:

Informatik I/II

Prof. Dr. Kupka

Institut für Informatik

Technische Universität Clausthal

Wintersemester 1998/99, Sommersemester 1999

5. Auflage

Stand 27. September 1999

Patrick Bothe

Torsten Erkens

Martin Herzog

Oliver Krüger

Stephanie Müller

Ulrike Bostelmann

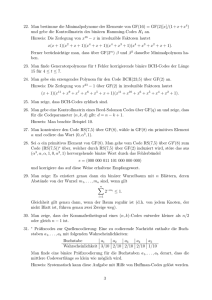

Ralf Wolters

Silke Schomann

Andrea Skala

Eva Blunk

Katrin Baptist

Michael Skubowius

Sven Witting

Alexander Neid

Robert Heine

Stephan Mühling

Florian Rilke

Michael David

INHALTSVERZEICHNIS

iv

2.5

Inhaltsverzeichnis

2.6

1 Die Entwicklung der Informatik

1

1.1 Historische Wurzeln . . . . . . . . . . . . . . . . . . . . . . . . .

1

1.1.1 Verfahren unabhängig von inhaltlichen Beziehungen . . .

1

1.1.2 Das 17. Jahrhundert: mechanische Automaten und Mechanisierung des Rechnens . . . . . . . . . . . . . . . . .

2

1.1.3 Ab Mitte des 19. Jahrhunderts: Mechanisierung des logischen Denkens, Verknüpfung von Philosophie, Logik,

Mathematik und Sprachwissenschaft . . . . . . . . . . . .

2

1.2 Die technologische Entwicklung . . . . . . . . . . . . . . . . . .

4

1.3 Die Entwicklung der Programmierung . . . . . . . . . . . . . . .

7

1.3.1 1. Phase: Entwicklung der Grundtechniken . . . . . . . .

8

1.3.2 2. Phase: Theoretische Fundierung . . . . . . . . . . . . .

9

1.3.3 3. Phase: Rückbesinnung auf die Praxis . . . . . . . . . .

9

1.3.4 4. Phase Paradigmen . . . . . . . . . . . . . . . . . . . . 10

1.4 Anwendungen der Informatik . . . . . . . . . . . . . . . . . . . 11

1.5 Informatik als Wissenschaft . . . . . . . . . . . . . . . . . . . . . 12

2 Elementare Modellbildung

2.1 Einführung . . . . . . . . . . . . .

2.2 Mengen . . . . . . . . . . . . . . .

2.3 Relationen und Funktionen . . . . .

2.3.1 Cartesisches Produkt . . . .

2.3.2 Relationen . . . . . . . . .

2.3.3 Ordnungsrelationen . . . . .

2.3.4 Operationen auf Relationen

2.3.5 Funktionen . . . . . . . . .

2.3.6 Operationen auf Funktionen

2.3.7 Darstellung von Funktionen

2.3.8 Äquivalenzrelationen . . . .

2.3.9 Darstellung von Relationen .

2.4 Beweistechniken . . . . . . . . . .

iii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

15

15

17

23

23

24

25

26

26

27

28

32

32

34

2.7

2.8

3

4

2.4.1 Widerspruchsbeweis . . . . . . . . . . . . . . . . . . . .

2.4.2 Beweis nach dem Prinzip der vollständigen Induktion . . .

Werte, Variable und Terme . . . . . . . . . . . . . . . . . . . . .

2.5.1 Werte . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.5.2 Variable . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.5.3 Terme . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Aussagenlogik . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.6.1 Boolesche Funktionen . . . . . . . . . . . . . . . . . . .

2.6.2 Aussagenlogische Formeln . . . . . . . . . . . . . . . . .

2.6.3 Konjunktive und disjunktive Normalform . . . . . . . . .

2.6.4 Schaltungstechnik . . . . . . . . . . . . . . . . . . . . .

2.6.5 Aussagenkalkül . . . . . . . . . . . . . . . . . . . . . . .

2.6.6 Die Methode der Wahrheitstafeln . . . . . . . . . . . . .

2.6.7 Der Wang-Algorithmus . . . . . . . . . . . . . . . . . . .

2.6.8 Das Resolutionsverfahren im Aussagenkalkül . . . . . . .

Prädikatenlogik . . . . . . . . . . . . . . . . . . . . . . . . . . .

Fuzzy-Logik . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Prozesse und Systeme

3.1 Prozesse und Ablaufpläne . . . . . . . . . . .

3.1.1 Diskrete Prozesse . . . . . . . . . . .

3.1.2 Sequentielle Prozesse . . . . . . . . .

3.1.3 Syntax-Diagramme . . . . . . . . . .

3.1.4 Der Backus-Naur-Formalismus (BNF)

3.1.5 Grammatik . . . . . . . . . . . . . .

3.1.6 Reguläre Ausdrücke . . . . . . . . .

3.2 Endliche Automaten . . . . . . . . . . . . .

3.3 Graphen . . . . . . . . . . . . . . . . . . . .

3.3.1 Einführende Beispiele . . . . . . . .

3.3.2 Ungerichtete und gerichtete Graphen

3.4 Petri-Netze . . . . . . . . . . . . . . . . . .

3.5 Dynamische Systeme . . . . . . . . . . . . .

34

34

35

35

36

37

39

40

43

46

50

53

56

56

58

61

67

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

69

69

70

71

72

73

74

77

79

84

84

86

93

111

Problemstrukturen und Problemsolving

4.1 Problembeschreibung und Spezifikation . . . . . . . . . . . .

4.1.1 Anforderungen an die Problembeschreibung . . . . . .

4.1.2 Notation in einer formalen Spezifikationssprache . . .

4.1.3 Formale Spezifikation, Datenspezifikation, Constraint

4.1.4 Einzelprobleme, Problemklassen, Probleminstanzen .

4.2 Problemarten und Darstellung von Problemen . . . . . . . . .

4.3 Techniken und Strategien des Problemlösens . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

113

114

114

116

116

117

118

122

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

INHALTSVERZEICHNIS

4.4

v

4.3.1 Die analytische Vorgehensweise . .

4.3.2 Die algorithmische Vorgehensweise

4.3.3 Die heuristische Vorgehensweise . .

4.3.4 Allgemeine Strategien . . . . . . .

Softcomputing-Ansätze des Problemsolving

4.4.1 Fuzzy-Technik . . . . . . . . . . .

4.4.2 Neuronale Netze . . . . . . . . . .

4.4.3 Evolutionäre Verfahren . . . . . . .

4.4.4 Simulated Annealing . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

123

124

125

126

126

127

127

128

129

7.3.1

7.3.2

7.3.3

8

5 Algorithmen und Programmierung

131

5.1 Übersicht . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

5.2 Der Algorithmusbegriff . . . . . . . . . . . . . . . . . . . . . . . 132

5.3 Nichtdeterministische Algorithmen . . . . . . . . . . . . . . . . . 134

5.4 Programmierparadigmen und Programmierstile . . . . . . . . . . 138

5.4.1 Das Paradigma der imperativen Programmierung . . . . . 138

5.4.2 Das Paradigma der funktionalen Programmierung . . . . . 143

5.4.3 Das Paradigma der regelbasierten Programmierung . . . . 146

5.4.4 Das Paradigma der logikorientierten Programmierung . . 148

5.4.5 Das Paradigma der objektorientierten Programmierung . . 149

5.5 Grundkonzepte der Programmierung . . . . . . . . . . . . . . . . 150

5.5.1 Zielsetzungen bei der Programmierung . . . . . . . . . . 150

5.5.2 Das Konzept der virtuellen Maschine . . . . . . . . . . . 151

5.5.3 Unterprogrammtechnik . . . . . . . . . . . . . . . . . . . 152

5.5.4 Variable Kontexte und Deklarationen . . . . . . . . . . . 154

6 Information und Nachricht

6.1 Information, Daten und Nachrichten . . . . . . .

6.1.1 Diskretisierung . . . . . . . . . . . . . .

6.1.2 Quantelung . . . . . . . . . . . . . . . .

6.2 Codes und Codierung . . . . . . . . . . . . . . .

6.3 Ein Einblick in die Codierungstheorie . . . . . .

6.4 Huffman-Codierung und arithmetische Codierung

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

157

157

161

163

163

169

173

7 Die Von-Neumann-Maschine

7.1 Das grundlegende Konzept . . . . .

7.1.1 Struktur des Speichers . . .

7.1.2 Struktur des Rechenwerks .

7.1.3 Struktur des Leitwerks . . .

7.2 Maschinennahe Programmierung . .

7.3 Darstellung von Zahlen im Rechner

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

175

175

178

180

181

182

186

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

INHALTSVERZEICHNIS

vi

9

Nichtnegative ganze Zahlen . . . . . . . . . . . . . . . . 186

Vorzeichenbehaftete ganze Zahlen . . . . . . . . . . . . . 187

Rationale Zahlen und Gleitpunktdarstellung . . . . . . . . 189

Datenstrukturen

8.1 Von Datentypen zu Datenstrukturen . . . . . . .

8.2 Elementare Datenstrukturen . . . . . . . . . . .

8.2.1 Boolean . . . . . . . . . . . . . . . . . .

8.2.2 Character . . . . . . . . . . . . . . . . .

8.2.3 Integer . . . . . . . . . . . . . . . . . .

8.2.4 Natural . . . . . . . . . . . . . . . . . .

8.2.5 Rational . . . . . . . . . . . . . . . . . .

8.2.6 Real . . . . . . . . . . . . . . . . . . . .

8.2.7 Aufzählungstyp . . . . . . . . . . . . . .

8.2.8 Unterbereichstyp . . . . . . . . . . . . .

8.3 Zusammengesetzte Datenstrukturen . . . . . . .

8.3.1 String . . . . . . . . . . . . . . . . . . .

8.3.2 Feld . . . . . . . . . . . . . . . . . . . .

8.3.3 Verbund . . . . . . . . . . . . . . . . . .

8.3.4 Vereinigung . . . . . . . . . . . . . . . .

8.4 Die Speicherstrukturen Stack, Queue und Deque .

8.5 Listen, Mengen und Hash-Tabellen . . . . . . . .

8.6 Rekursive Datenstrukturen und Zeiger . . . . . .

8.6.1 Symbolische Ausdrücke von LISP . . . .

8.6.2 Arithmetische Bäume . . . . . . . . . . .

8.6.3 Der Stack als rekursive Datenstruktur . .

8.6.4 Zeiger . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

195

195

198

198

200

200

201

201

201

202

203

203

203

204

205

206

206

208

211

211

213

214

215

Kontrollstrukturen

217

9.1 Übersicht . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 217

9.2 Unterprogramme . . . . . . . . . . . . . . . . . . . . . . . . . . 217

10 Programmiersprachen

10.1 Allgemeine Bemerkungen zu Programmiersprachen .

10.1.1 Syntax, Semantik und Pragmatik . . . . . . .

10.1.2 Merkmale und Ausprägungen . . . . . . . .

10.2 Funktionale Programmierung . . . . . . . . . . . . .

10.2.1 Übersicht . . . . . . . . . . . . . . . . . . .

10.2.2 APL . . . . . . . . . . . . . . . . . . . . . .

11 Literatur zu Informatik I und II

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

219

. 219

. 219

. 220

. 222

. 222

. 222

229

2

KAPITEL 1. DIE ENTWICKLUNG DER INFORMATIK

1.1.2 Das 17. Jahrhundert: mechanische Automaten

und Mechanisierung des Rechnens

1623

Kapitel 1

Wilhelm Schickard (Math. und Astronom), Tübingen, erste bekannte Rechenmaschine, zahnradgesteuert, 6 Stellen

1641

Blaise Pascal (Phil., Math. und Physiker), Paris, erste noch erhaltene

Rechenmaschine für 6-stellige Addition

Die Entwicklung der Informatik

1674

Gottfried Wilhelm von Leibniz (Phil., Math. und Jurist), Multiplikation und Division auf (konstruierter Rechenmaschine, Gleitschlitten,

Staffelwalze

1.1 Historische Wurzeln

1679

Leibniz: binäres Zahlsystem

1774

Philipp Matthäus Hahn (Pfarrer) läßt Rechenmaschinen in Serie bauen

1822

Charles Babbage (engl. Math., Techniker und Org.) entwirft seine

’Difference Engine’, eine 3-stufige, 6-stellige Addiermaschine zur

Berechnung von Funktionswerten

1833

Babbage entwirft ’Analytical Engine’, lochkartenprogrammiert, seine ’Programmiererin’: Ada Augusta, Countess of Lovelace ! Universalität des Computers

1886

Hermann Hollerith (amer. Bergwerksing.), Lochkartenmaschine für

11. amer. Volkszählung 1880: 500 Helfer / 7 Jahre 1890: 43 Maschinen und Helfer / 4 Wochen — 1896: Hollerith gründet die Firma Tabulating Machine Company 1911: Firmenverkauf, Firma wird

Vorläufer der IBM (1924)

Hilfsmittel zum Rechnen

systematische Vorgehensweisen

1800 v. Chr. Gebrauch von Rechenbrettern (Abakus in Ägypten)

1700 v. Chr. Papyrus Rhind, Ägypten, enthält die ältesten Rechenaufgaben

400 v. Chr. Griechen und Perser rechnen mit dem Abakus

300 v. Chr. Euklid (griech. Math.) beschreibt in ’Elemente’ mathematische Verfahren, ! Euklidischer Algorithmus

500 n. Chr. In Indien wird das Dezimalsystem erfunden

1.1.1 Verfahren unabhängig von inhaltlichen Beziehungen

1.1.3 Ab Mitte des 19. Jahrhunderts: Mechanisierung des logischen Denkens, Verknüpfung von Philosophie, Logik, Mathematik und Sprachwissenschaft

820 n. Chr. Al-Chowarizmi (persischer Math. und Astronom) schreibt ein Buch

über Algebra (nach Titel des Buches) ! ’Algorithmus’

1202 n. Chr. Leonardo von Pisa, genannt Fibonacci, beschreibt in ’liber abaci’

indische, arabische und eigene Rechenmethoden

1524 n. Chr. Adam Riese veröffentlicht Rechenbuch, dezimal

1

1847

George Boole (engl. Math. und Logiker 1815-1864) beschreibt den

Zusammenhang zwischen Logik und Algebra: ’The mathematical

analysis of logic, beeing an essay towards a calculus of deductive

reasoning’

1.1. HISTORISCHE WURZELN

1879

3

Gottlob Frege (deutsch. Math. 1848-1918) legt Grundlage für moderne Logik: ’Begriffsschrift, eine der arithmetischen nachgebildete

Formelsprache des reinen Denkens’

1889

Guiseppe Peano (ital. Math. 1858-1932) schreibt ’Aritnetices Principia’

1913

A. N. Whitehead (1861-1947) und Bertrand Russell (1872-1970,

Lit.-Nobelpreis), Grundlagenwerk für Mathematik und Logik: ’Principia Mathematica’

1928

David Hilbert und W. Ackermann: ’Grundzüge der theoretischen

Logik’

1934

Jacques Herbrand (franz. Philosoph) und Kurt Gödel (Österr. Math.

1906-1978) entwickeln einen mathematischen Funktionsbegriff, der

die prinzipelle Leistungsfähigkeit von Rechenmaschinen repräsentiert: ’allgemein-rekursive Funktion’

1936

Alan M. Turing (engl. Math. 1912-1954) entwickelt ein abstraktes Modell zur Untersuchung von Fragen über die Berechenbarkeit:

Turing-Maschine

1936

Alonzo Church (amer. Math. geb. 1903) entwickelt den LambdaKalkül als universelles Berechenbarkeitsmodell, Church’sche These: alle denkbaren Maschinenmodelle beschreiben die gleiche Leistung

1938

S. C. Kleene (engl. Math.) definiert partiell-rekursive Funktionen,

welche die Leistungsfähigkeit von Computer exakt beschreiben

KAPITEL 1. DIE ENTWICKLUNG DER INFORMATIK

4

1.2 Die technologische Entwicklung

Unmittelbar im Anschluß an die theoretischen Entdeckungen begann die Entwicklung und Inbetriebnahme der voll funktionsfähigen, programmierbaren, universellen Rechenmaschinen – der Computer im heutigen Sprachgebrauch.

1938 Konrad Zuse, Bauingenieur, Erfinder und Unternehmer (*1910), stellt einen

mechanischen Rechner mit Binärtechnik fertig – die Z1.

1939 Es folgt die Z2 mit elektromechanischem Rechenwerk mit ca. 200 Relais.

1941 Zuses Z3 wird fertig, die erste voll arbeitsfähige, programmgesteuerte Rechenmaschine. Sie wird in der Deutschen Forschungs- und Versuchsanstalt

für Luft- und Raumfahrttechnik (DFVLR) eingesetzt.

Einige Daten:

Rechenwerk: 600 Relais, 2 parallele arithmetische Einheiten für Exponent und Mantisse.

Speicher: 1400 Relais für 64 Worte mit je 22 Bit, Zahlendarstellung

halblogarithmisch mit einem Bit Vorzeichen, 7 Bit Exponent und 14

Bit Mantisse.

Programmsteuerung: 8-Kanal Lochstreifen.

Eingabe: spezielle Tastatur.

Ausgabe: Resultatanzeige auf Lampenreihen.

Multiplikationszeit: 3 Sekunden.

Das Original der Z3 verbrannte 1944 in Berlin. Ein Nachbau steht im Deutschen

Museum in München.

1944 Howard Hathaway Aiken, amerikanischer Mathematiker (1900–1973), baut

mit der Unterstützung von IBM den Großrechner Mark I: 15m lang, 2.5m

hoch und 35t schwer.

Einige Daten:

Relaistechnik, 60 Read-Only-Register, manuell einstellbar.

72 Read-Write-Register für 23-dezimalstellige Zahlen.

Mutiplikationszeit: 6 Sekunden.

1945 Konrad Zuse baut die Z4, die bis 1959 in Betrieb ist.

1.2. DIE TECHNOLOGISCHE ENTWICKLUNG

5

1945 John von Neumann, ungarisch amerikanischer Mathematiker, entwickelt

ein grundlegendes Konzept für programmierbare Rechner, welches bis heute tragendes Konzept geblieben ist.

1946 J. P. Eckert und J. W. Manchly bauen die ENIAC, die erste elektronische

Rechenmaschine. Sie hat 18000 Röhren und eine Multiplikationszeit von

3ms.

1949 Der Engländer M. V. Wilkes baut mit der EDSAC den ersten praktisch verwendbaren Rechner nach dem von-Neumann-Konzept.

Einige Daten:

3000 Röhren.

Speicher: 512 35-Bit-Worte.

Die weitere Entwicklung ist durch gewaltige technische Verbesserungen und

durch folgenschwere Erfindungen im Bereich der Programmierung gekennzeichnet.

KAPITEL 1. DIE ENTWICKLUNG DER INFORMATIK

6

Die Taktzeit unterschreitet 50 Nanosekunden (10;9 sec).

1977 Hochintegrierte Schaltkreise treiben die Miniaturisierung weiter. Es entstehen die Mikroprozessoren, die das gesamte Rechenwerk auf einem Chip

enthalten.

1977 Der Mikroprozessor Z 80 wird herausgebracht, neben ähnlichen Mikroprozessoren, charakterisiert durch 8 bit Wortbreite, 7000 Transistoren integriert, 1 MIPS (Million Instruktionen pro Sekunde)

1985 Es entstehen die Mikroprozessoren 80386 (Intel) und ähnliche: 32 bit Wortbreite, 10 hoch 5 Transistoren integriert, 10 MIPS

Die Halbleitertechnologie entwickelt sich exponentiell: Etwa alle 5 Jahre

vervierfacht sich die Anzahl der Transistorfunktionen pro Chip. Auch die

Verarbeitungsgeschwindigkeit wächst exponentiell.

1996 Der Mikroprozessor Pentium (und ähnliche) tritt auf den Markt: 4 mal 10

hoch 6 Transistorfunktionen, 200 MIPS

Parallel zur Chip- und Prozessortechnologie entwickelt sich das Internet.

1955 Die Elektronenröhre wird durch den Transistor abgelöst. Dies führt zur 2.

Computergeneration mit kleineren und schnelleren Rechnern. Taktzeiten

von 1–10 µsec werden realisiert. Die Speichergröße steigt in den Bereich

einiger Tausend.

1958 Mit FORTRAN beginnt die Verbreitung der höheren Programmiersprachen.

Es folgen ALGOL und COBOL.

1962 Die Miniaturisierung der Transistoren führt zur 3. Computergeneration.

SSI: small scale integration: bis 50 Transistoren pro Chip.

MSI: medium scale integration: 50–500 Transistoren pro Chip.

Es wird eine Taktzeit von 0.1–1 µsec erreicht.

1969 Das Forschungsnetz ARPANET wird in der US Defense Advanced Researech Project Agency (DARPA) eingeführt

1983 der 1. Januar 1983 gilt als Geburtsstunde des Internet: es erfolgt die

Einführung des Protokollstandards TCP/IP für ARPANET und es entstehen

die Netzwerkdienste Telnet, E-mail und FTP

Es bedeuten

TCP: Transmission Control Protocol

IP: Internet Protocol

Telnet: Dienst für Terminal-Verbindungen zu entfernten Rechnern

FTP: Dienst für Datei-Übertragungen

1965 Die Entwicklung von BASIC öffnet für Laien den Zugang zur Programmierung. Es entwickeln sich Techniken des Compilerbaus und der Betriebssysteme.

1986 Es erfolgt die überregionale Ausdehnung des Netzes, 1988 Kanada, 1989

Deutschland

1968 Es entstehen hochintegrierte Halbleiterschaltungen. Sie bilden die Grundlage der 4. Computergeneration.

1991 Der Internetdienst Gopher für die Übertragung von Text, Bild, Ton etc. wird

eingeführt

LSI: large scale integration: 500–2500 Transistoren pro Chip.

VLSI: very large scale integration: über 2500 Transistoren pro Chip.

1993 Das Internet breitet sich in allen Bereichen aus

Die Anzahl der Netzknoten verdoppelt sich alle 12 bis 15 Monate.

1.3. DIE ENTWICKLUNG DER PROGRAMMIERUNG

7

1996 Das Netz besitzt 13 mal 10 hoch 6 Knoten, in Europa 3 mal 10 hoch 6

Knoten

1996 Die Internet-Programmiersprache JAVA wird eingeführt.

KAPITEL 1. DIE ENTWICKLUNG DER INFORMATIK

8

1.3.1 1. Phase: Entwicklung der Grundtechniken

Zeitraum: 50’er-Jahre bis frühe 60’er-Jahre.

Generell gilt für die Entwickling seit den 80’er Jahren:

Weitere Steigerung der Verarbeitungsgeschwindigkeit.

Verringerung der räumlichen Abmessungen (ULSI: ultra large scale integration).

Verbilligung und Massenproduktion.

Fortschreitende Vernetzung der Computer: globale Verbindungen, extrem

hohe Übertragungsraten bei der Verwendung von Lichtleitfasern.

Anpassung der Endgerätetechnik an die sensorischen Fähigkeiten der Menschen.

Entwicklung von Vektorrechnern und Multiprozessorsystemen

1.3 Die Entwicklung der Programmierung

Die technologische Entwicklung eröffnete eine Vielzahl von Möglichkeiten, die

Universalität des Computers auszunutzen. Hierzu gehören:

die Behandlung von Programmen als Daten. Programme können vom Computer umgeformt, übersetzt, optimiert und sogar aus Beschreibungen hergeleitet werden.

Wir unterteilen die Zeit der Entwicklung der Programmierung in folgende Phasen

ein:

Einführung der symbolischen Maschinensprache:

Unterscheidung von internem Code (binär oder hexadezimal) und einem

externen Code, der mnemotechnisch aufgebaut ist (z. B. ADD für Additionsbefehl).

Entstehen des ersten Assemblers.

Zusammenfügen der Zielprogramme unter Anwendung von Symboltabellen und Makrotechnik.

Entstehen der ersten höheren Programmiersprachen; die sogenante erste

Generation höherer Programmiersprachen.

1954–57 entsteht bei IBM die Sprache FORTRAN (Formula Translation), definiert durch J. W. Backus. FORTRAN wird für lange Zeit die wichtigste

Sprache für technisch wissenschaftliche Anwendungen und wird auch

heute noch gebraucht und erweitert.

1959–60 entsteht durch ein internationales Autorengremium die Sprache ALGOL, (algorithmic language). Zugleich wird für die exakte Beschreibung der Backus-Naur-Formalismus eingeführt. ALGOL wird zum

Grundmodell für allgemeine Betrachtungen der Programmierung. Erst

die Nachfolger von ALGOL erfahren größere praktische Bedeutung.

1960

wird COBOL (common business oriented language) definiert, ebenfalls

durch eine internationale Organisation. Die Sprache ist geeignet für Anwendungen mit vielen einfachstruktuierten Daten und einfachen Verarbeitungsprozeduren. Im kommerziellen Bereich ist COBOL immer

noch die am weitesten verbreitete Sprache.

1962

wird von K. E. Iversan die Sprache APL (a programming language)

vorgestellt. Später wird sie von IBM als APL/60 verbreitet. Sie ist eine

Dialogsprache, welche direkt interpretiert wird. Ihre von der Mathematik entlehnten Konstruktionen wurden 20 Jahre später zum Vorbild für

die sogenannten funktionalen Sprachen.

die Simulation eines Computers auf einem anderen und die Simulation einer

Sprache in einer anderen.

die Umformung in beliebige Datenformen wie Zeichenfolgen, Zahlenfolgen, Bitfolgen, Bild-Matrizen usw.

Entstehung von Macros und der Makro-Technik:

Abkürzung von Befehlsfolgen durch Pseudobefehle, Abarbeitung erfolgt

durch Einsetzen.

1.3. DIE ENTWICKLUNG DER PROGRAMMIERUNG

9

1962

entsteht BASIC (beginners all purpose symbolic instruction code), eine

weitere einfache Programmier- und Dialogsprache.

1962

entsteht mit LISP (List processing language) von John McCarthy die

erste Sprache der Künstlichen Intelligenz“. Die einzige Datenstruktur

”

in LISP ist die Liste. LISP ist die erste voll funktionale Sprache.

10

KAPITEL 1. DIE ENTWICKLUNG DER INFORMATIK

1971 wird die Sprache PASCAL von N. Wirth vorgestellt. Sie korrigiert die übertriebenen theoretischen Ansätze von ALGOL68, realisiert Ideen des strukturierten Programmierens und ist für die Lehre konzipiert.

1978 erfolgt die Verbreitung der Sprache C“ von Kernigham und Ritchie. Die

”

Sprache ist eng mit dem Betriebssystem UNIX verbunden und erlaubt eine

maschinennahe Programmierung, obwohl es sich um eine höhere Sprache

handelt. C wird zu einer wichtigen Implementationssprache.

1.3.2 2. Phase: Theoretische Fundierung

Zeitraum: späte 60’er Jahre

Theoretische Erforschung der Möglichkeiten der Definition von Sprachen durch

Grammatiken und der Übersetzung von Sprachen durch Compiler.

Konstruktion von Programmiersprachen mit universellem Anspruch: die zweite

Generation höherer Programmiersprachen.

1965 entsteht PL/I (programming language I) bei IBM, im wesentlichen durch

Zusammenbringen und Verallgemeinerung von Konzepten aus FORTRAN,

ALGOL und COBOL. PL/I erreicht eine sehr weite Verbreitung, wurde meist jedoch nur teilweise implementiert (Implementation sogenannter

Subsets). PL/I ist auch die erste Sprache, deren inhaltliche Bedeutung, die

Semantik, exakt formal beschrieben wird. Hierzu entwickelt das Wiener

IBM-Labor unter H. Zemanek die Vienna-Definition-Language (VDL).

1.3.4

Es kommt die Erkenntnis zum Durchbruch, daß gänzlich andere Programmiervorstellungen zur Programmierung ebenfalls geeignet sind.

1978

verkündet J. W. Backus in seiner berühmten Turing Award Lecture“,

”

daß fast alle bisherigen Programmiersprachen, die sogenannten vonNeumann-Sprachen, eigentlich maschinennahe Sprachen sind, und daß

wirklich maschinenunabhängige Konzepte, wie man sie z. B. in LISP

findet, nötig sind.

1980

erscheint ein Aufsatz von R. Kowalski mit dem Titel Algorithm = Lo”

gic + Control“.

Hierin wird dafür plädiert, die Ausführungskontrolle aus Algorithmen

so weit wie möglich herauszuhalten. Damit wird unter anderem die Programmierung in PROLOG begründet.

1980

wird die bisher letzte große Programmiersprache des von-NeumannPrinzips, ADA (ein Pascal Nachfolger) benannt nach Ada Augusta, der

ersten Programmiererin, vorgestellt.

1967 Auf ALGOL60 aufbauend entsteht SIMULA67, eine Simulationssprache.

1968 wird durch eine Arbeitsgruppe der IFIP (International Federation of Information Processing) die Sprache ALGOL68 vorgestellt. Die Sprache besitzt

ein perfektes theoretisches Konzept, wurde aber zu spät implementiert und

konnte daher nicht in die Praxis eindringen.

4. Phase: Aufkommen der programmiersprachlichen Paradigmen

ab 1980 erscheinen in weiterer Verbreitung:

Beginn der systematischen Software-Technologie und Aufkommen des structural

”

programming“. 1968/69 fanden zwei wichtige NATO-Tagung zu dem Thema statt.

Wichtige Ideen stammen von C. A. R. Hoare und E. W. Dijkstra.

PROLOG (programming in logic) wird zur zweiten wichtigen Sprache

der künstlichen Intelligenz (KI).

FP (funktional programming) begründet die neueren funktionalen Sprachen.

1.3.3 3. Phase: Rückbesinnung auf die Praxis

Zeitraum: 70’er Jahre.

Es entstehen wieder engere Sprachkonzepte mit weniger universellem Anspruch,

aber mit besseren Realisierungsmöglichkeiten. Die Softwaretechnologie wird

weiterentwickelt, hauptsächlich das Modulkonzept.

MIRANDA, HOPE und andere funktionale Sprachen entstehen und

verbreiten sich.

SMALLTALK wird zur ersten objektorientierten Sprache.

1992

Bertrand Meyer entwickelt die objektorientierte Sprache EIFFEL.

1.4. ANWENDUNGEN DER INFORMATIK

1996

11

Auf C und der objektorientierten Erweiterung C++ setzt die Internetsprache JAVA auf.

Weitere Einflüsse auf die Programmierung ergeben sich durch:

KAPITEL 1. DIE ENTWICKLUNG DER INFORMATIK

12

zu 3.) Die Kommunikationsleistung des Computers hat sehr große Ähnlichkeit mit

der des Menschen, findet aber in streng geregelten Bahnen statt. Sowohl

Computer untereinander als auch Computer und Menschen können miteinander im Dialog Informationen austauschen.

Hier sind einige wichtige Anwendungen:

Vordringen von Architekturen mit Parallelverarbeitung.

Entwicklung von Datenbanken und Grafik-Anwendungen wie CAD

(Computer-Aided-Design).

Entstehen der Multimediatechnik.

Problemangepaßte Sprachen mit sehr leistungsfähigen Ausdrucksmitteln

1.4 Anwendungen der Informatik

Die Anwendungsmöglichkeiten der Informatik hängen von den

stungsmöglichkeiten des Computers ab. Wir müssen dabei unterscheiden:

Lei-

1. die Informationsverarbeitungsleistung des Computers,

2. die Speicherleistung des Computers und

3. die Kommunikationsleistung des Computers.

zu 1.) Die Informationsverarbeitungsleistung bezieht sich auf die Rechenleistung

im engeren und im weiteren Sinn: sie kann dabei folgende Formen annehmen, die ineinander überführt werden können:

Informationsverarbeitung auf Zahlen: Rechnen.

Informationsverarbeitung auf Texten: Textverarbeitung.

Informationsverarbeitung auf Bildmatrizen: Bildverarbeitung.

Informationsverarbeitung auf logische Aussagen: Automatische Deduktion in der KI.

Datenbanken und Systeme des Information Retrieval (InformationsWiedergewinnung):

Anwendungen in Staat, Verwaltung sowie im kommerziellen, technischen und wissenschaftlichen Bereich.

Computergraphik:

Wiedergabe von Meßwerten, Entwurf von Konstruktionszeichnungen,

Kartographie.

Bildverarbeitung:

Komplexe Meßwerterfassung, automatisches Sehen; Anwendungen in

der Medizin und in der Technik.

Prozeßautomatisierung und Robotik:

Hier geht es um die Automatisierung von chemischen bzw. technischen Produktionsprozessen.

Simulation:

Die Simulation dient der Gewinnung von Erfahrungen und Vorhersagen durch Experimente, die nach denselben Regeln wie in der Realität

im Rechner ablaufen.

Expertensysteme:

Sie halten Expertenwissen großen Umfangs verfügbar und können dieses mit Hilfe von Methoden des Wissensverarbeitung auf Probleme

anwenden. Wichtigste Beispiele sind die Diagnosesysteme in Medizin und Technik, die aus Symptomen sehr präzise auf die Ursachen

schließen können.

1.5 Informatik als Wissenschaft

Beim Menschen entspricht das Denken dieser Computerleistung.

zu 2.) Die Speicherleistung bezieht sich auf die Möglichkeit, große Datenmengen

zu speichern und geordnet zu verwalten, so daß auf die darin enthaltenen

Informationen gezielt zugegriffen werden kann. Eine Analogie beim Menschen ist das Gedächtnis.

Begreift man Informatik als Wissenschaft von Computern, wie das angloamerikanische Wort Computer Science“ nahe legt, so kann man sich schon fra”

gen, wie die Beschäftigung mit einem vom Menschen geschaffenen Gerät eine

Wissenschaft ergeben kann. Es gibt ja nicht einmal eine Wissenschaft vom Auto.

Nun ist aber der Computer, der Gegenstand der Informatik ist, eine viel abstraktere

1.5. INFORMATIK ALS WISSENSCHAFT

13

und grundsätzlichere Angelegenheit als der real käufliche Computer. Bei der abstrakten Computeridee geht es beispielsweise um die Möglichkeiten des Vorwegplanens aller realisierbaren Aktivitäten, um die Ausschöpfung von Informationen

und um die Gestaltung beliebiger Kommunikation.

In wenigen Jahrzehnten hat die Informatik außer datentechnischen Entwicklungen

auch eine stattliche Anzahl geistig-theoretischer Leistungen hervorgebracht:

14

KAPITEL 1. DIE ENTWICKLUNG DER INFORMATIK

Theoretische Informatik

Automatentheorie,

Theorie der Berechenbarkeit,

Algorithmentheorie,

Theorie der Programmierung,

Theorie der Wissensverarbeitung,

Theorie formaler Sprachen

Komplexitätstheorie,

Formale Semantik,

Theorie der Systeme und Prozesse,

Informations- und Codierungstheorie.

Praktische Informatik

Die exakte Erfassung aller mit Computern lösbaren Aufgaben (Berechenbarkeit),

die Entdeckung konkreter, nicht auf Computern lösbarer Aufgaben (Unberechenbarkeit),

die Aufdeckung der Gleichwertigkeit aller prinzipiellen Maschinenkonzepte (Churchsche These),

Datenstrukturen

Programmier- und Dialogsprachen,

Betriebssysteme,

Mensch-Maschine-Kommunikation,

Algorithmen,

Übersetzer,

Softwaretechnik,

Multi-Media-Systeme.

Angewandte Informatik

Informationssysteme,

Computergraphik,

Bildverarbeitung,

Robotik,

Wissensverarbeitung,

Simulation,

Textverarbeitung und Büro-Automation Prozeßautomatisierung.

Technische Informatik

das Auffinden des Zusammenhang zwischen Grammatiken (Sprachdefinition) und Automaten (Übersetzung) (Chomsky-Hierarchie),

die präzise Abschätzungen für Zeit- und Speicheraufwand von Programmen

(Komplexität) und

die Entwicklung von Verfahren, um die Korrektheit von Programmen sicherzustellen (Programmverifikation).

Gegenstand der Informatik ist die Verarbeitung von Informationen und alles, was

damit in engerem Zusammenhang steht. Ihr zentraler Begriff ist nicht der der Information, sondern der des Algorithmus.

Wir unterteilen die Informatik in Theoretische, Praktische, Angewandte und Technische Informatik.

Schaltnetze, Schaltwerke,

Peripheriegeräte,

Hardware-Entwurfstechniken,

Rechnerorganisation,´

Prozessoren,

Mikroprogrammierung,

Rechnerarchitektur,

Rechnernetze.

Die Informatik steht in enger Beziehung zu vielen anderen Wissenschaften. Die

folgende Liste nennt jeweils den Gegenstand gemeinsamen Interesses:

Mathematik

Physik

Maschinenbau

Nachrichtentechnik

Sprachwissenschaft

Psychologie, Physiologie

Gesellschaftswissenschaft

Wirtschaftswissenschaft

Strukturen

Prozesse

Steuerung, Datenbanken und Graphik

Daten

Sprache

Wahrnehmung

Kommunikation

Organisation

KAPITEL 2. ELEMENTARE MODELLBILDUNG

16

Die Position einer Dame ist ein Wertepaar hx; yi. Um 8 Damen zu unterscheiden,

führen für wir 8 Wertepaare

hx1 y1i hx2 y2i hx8 y8i

;

;

;

;

;

;

ein, abgekürzt:

Kapitel 2

hxi yii i = 1 2

;

;

;

; : : :;

8:

Die Bedrohungen lassen sich so ausdrücken:

Elementare Modellbildung

a) Die Damen zu den Nummern i; j ,i 6= j, liegen in derselben Zeile: yi = y j .

b) Sie liegen in derselben Spalte: xi = x j .

Wenn eine Aufgabe mit dem Computer gelöst werden soll, so braucht man ein

genaues Modell von allen Zusammenhängen, die für die Aufgabe von Bedeutung

sind. Hierzu betrachten wir

mathematische Hilfsmittel: Mengen, Funktionen, Relationen, Beweistechniken,

Grundelemente von Berechnungen: Werte, Variable, Terme, sowie

Modelle zur logischen Präzisierung von Sachverhalten: Aussagenlogik,

Prädikatenlogik.

Zur Veranschaulichung beginnen wir mit einem konkreten Problem als Beispiel.

2.1 Einführung

Wir betrachten das 8-Damen-Problem: 8 Damen sind auf einem Spielbrett aus

”

8 8 Feldern so zu positionieren, daß keine eine andere bedroht.“ Alle Begriffe

müssen nun exakt modelliert werden:

Das Spielbrett wird durch seine Koordinaten x; y 2 f1; 2; 3; 4; 5; 6; 7; 8g modelliert:

y: 8

7

6

5

4

3

2

1

x: 1

2

3

15

4

5

6

7

8

c) Sie liegen auf derselben diagonal verlaufenden Linie: jxi ; x j j = jyi ; y j j.

Jetzt können wir eine exakte Formulierung des Problems angeben:

Gesucht sind für i = 1; : : : ; 8 Wertepaare xi ; yi 2 f1; 2; : : : ; 8g, so daß für i 6= j stets

gilt:

xi 6= x j ;

yi 6= y j ;

jxi ; x j j 6= jyi ; y j j

:

Eine solche Festlegung heißt Spezifikation. In Anlehnung an die sogenannte ZNotation schreiben wir eine solche Spezifikation in der folgenden Form:

8-Damen-Problem

xi ; yi : f1; 2; : : : ; 8g; i = 1; 2; : : :; 8

i 6= j =) xi 6= x j ; yi 6= y j ; jxi ; x j j 6= jyi ; y j j

Man kann das Problem dadurch vereinfachen, daß man festlegt, die i-te Dame

genau in die i-te Zeile zu stellen. Es gilt dann yi = i; i = 1; 2; 3; :::; 8:

8-Damen-Problem

xi : f1; 2; : : : ; 8g; i = 1; 2; : : :; 8

i 6= j =) xi 6= x j ; jxi ; x j j 6= ji ; jj

Eine Lösung hierfür kann durch ein Programm bestimmt werden. Dazu braucht

man noch eine Lösungsidee. In diesem Fall kann man den Computer auch alle Möglichkeiten durchprobieren lassen. Eine heuristische Vorgehensweise liegt

vor, wenn ähnliche Überlegungen zugrunde gelegt werden, die der Mensch als

Problemlöser anwendet.

Ein Programm lohnt sich aber eigentlich nur, wenn man es oft auf verschiedene

Daten anwenden kann, d. h. wenn eine Klasse ähnlicher Probleme vorliegt. Aus

dem 8-Damen-Problem gewinnen wir das n-Damen-Problem. n ist der Eingabeparameter. Die Spezifikation wird dann so geschrieben:

2.2. MENGEN

17

KAPITEL 2. ELEMENTARE MODELLBILDUNG

18

Eine ausreichende Darstellung wäre jetzt

N-Damen-Problem (n)

n : N4

xi : f1; 2; : : :; ng; i = 1; 2; : : :; n

i 6= j =) xi 6= x j ; jxi ; x j j 6= ji ; jj

Dabei bezeichnet N die Menge der natürlichen Zahlen.

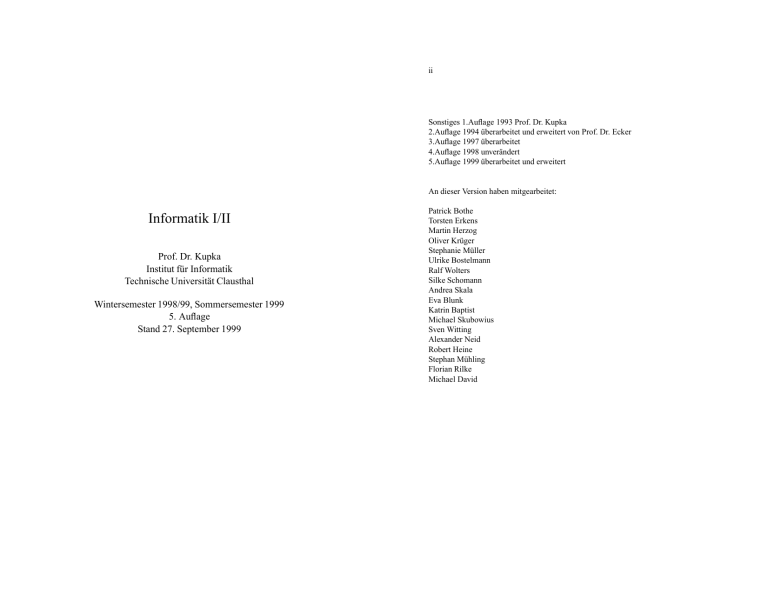

Die allgemeine Vorgehensweise zum Lösen von Problemen in der Praxis mit Hilfe

des Computers ist in Abbildung 2.1 zu sehen.

fh1 1i h2 1i h3 1i h4 1i h1 2i h2 2i h3 2i h1 5i h2 5ig

;

Die wichtigsten mathematischen Hilfsmittel zur Modellbildung sind die Mengen

und die Relationen, zu denen auch die Funktionen gehören.

;

;

;

;

;

;

;

;

;

;

;

;

;

;

;

Es genügt die Unterscheidung durch irgendwelche Merkmale vorzunehmen, z. B.

fhx 1i hy 1i hm 1i hq 1i h100 2i h1000 2i h35 2i hy 5i h100 5ig

;

;

;

;

;

;

;

;

;

;

;

;

;

;

;

;

;

oder

f1 1 1 1 2 2 2 5 5g

;

Mathematische Hilfsmittel

;

;

;

;

;

;

;

;

:

Wir sagen: Elemente einer Menge besitzen Individualität.

Beispiel 2.2.2

Weitere Beispiele für Mengen sind:

2.2 Mengen

(a) Die Menge aller von einer Dame auf Position hx; yi bedrohten Felder eines

n n - Brettes.

In der naiven Mengenlehre wird unter einer Menge eine Gesamtheit von Objekten

verstanden. Ein einzelnes Objekt heißt Element der Menge.

(b) Die Menge aller Felder auf der Hauptdiagonalen eines n n - Brettes.

Beispiel 2.2.1

Wir nehmen als Objekte die Zeichen ’A’,’B’,’C’ und die Zahlen 3,5,9,20. Die

daraus gebildete Menge schreiben wir

(c) Die Menge der Figuren eines Schachspiels.

f0 A0 0 B0 0 C0 3 5 9 20g

;

;

;

;

;

;

:

Dabei spielt jedoch die Reihenfolge der Niederschrift keine Rolle:

f3 9 0 B0 20 0 A0 5 0 C0g

;

;

;

;

;

;

bezeichnet dieselbe Menge.

Die Menge verändert sich auch dadurch nicht, daß Elemente mehrfach notiert werden: f3,3,9,3g bezeichnet dieselbe Menge wie f3,9g, f9,3g oder f9,9,3,9,9,3,3,9g.

Wie modelliert man nun den Inhalt einer Geldbörse? Es seien vorhanden

4 1DM; 3 2DM; 2 5DM:

Die Menge f1,1,1,1,2,2,2,5,5g bezeichnet dasselbe wie die Menge f1,2,5g. Man

muß daher die Münzen gleichen Wertes individualisieren:

h1 1i: Das erste 1 DM - Stück,

h2 1i: Das zweite 1 DM - Stück,

h3 1i: Das dritte 1 DM - Stück,

;

;

;

usw.

(d) Die Menge aller möglichen Züge bei einer bestimmten Stellung des Schachspiels.

(e) Die Menge aller Primzahlen.

Für einige wichtige Mengen gibt es feste Bezeichnungen:

f

g

N =Menge der natürlichen Zahlen = 1; 2; 3; : : : .

N0 =Menge der natürlichen Zahlen mit 0 = 0; 1; 2; 3; : : : .

R =Menge der reellen Zahlen.

I =Menge der abgeschlossenen Intervalle über R.

Z=Menge der ganzen Zahlen.

Q =Menge der rationalen Zahlen.

C =Menge der komplexen Zahlen.

f

g

B =ftrue, falseg = Menge der sogenannten Wahrheitswerte.

Wir verwenden folgende Schreibweisen für Aussagen über Mengen:

x 2 M:

das Objekt x ist ein Element der Menge M.

x 62 M:

das Objekt x ist kein Element der Menge M.

2.2. MENGEN

19

M1 M2 : M1 ist eine echte Teilmenge von M2 , das heißt alle Elemente von M1

sind auch Elemente von M2 , aber M2 enthält mindestens ein Element,

welches nicht Element von M1 ist.

M1 M2 : Es gilt M1 M2 oder M1 = M2 .

Ferner werden die folgenden Schreibweisen für Mengen verwendet:

1. Auflistung der Elemente, z. B.:

f’a’,’e’,’i’,’o’,’u’g , f5 10 15

;

;

; : : :;

95g, f1; 2; 4; 8; : : :g

(falls klar ist, wie die Elemente fortgesetzt werden).

KAPITEL 2. ELEMENTARE MODELLBILDUNG

20

nennt man ihn gesellig, sonst ungesellig. Die ungeselligen Einwohner der Stadt

bilden einen Club.

In dieser Geschichte steckt ein Widerspruch. Gehört der Einwohner, nach dem der

Club der Ungeselligen benannt ist, selbst zu diesem Club oder nicht? Wenn ja, so

wäre er gesellig, also könnte er nicht zum Club gehören. Wenn nein, so wäre er

ungesellig und müßte doch dazu gehören.

Die naive Modellierung hat also ihre logische Tücken. Dies gilt genauso für die

moderne Mengenlehre, wie das folgende Paradoxon, die sog. Antinomie von Bertraud Russell zeigt: Bilde

R

2. Angabe von Eigenschaften der Elemente, z. B.:

M

=

=

:

fxjx 2 N x 5g;

;

dies ist gleichwertig mit

M

=

f1 2 3 4 5g

;

;

;

;

:

R2R

)

R 62 R

R 62 R

)

R 2 R:

Das Paradoxon der Clubs ist übrigens kein Mengenparadoxon, sondern eines der

Gesamtmodellierung.

Für endliche Mengen M definieren wir jM j=card(M) durch j0/ j = 0 und

jfx1; : : : ; xngj (alle xi verschieden)=n.

M heißt unendlich, wenn jM j nicht endlich ist.

M heißt abzählbar unendlich, wenn man eine Reihenfolge der Elemente von M in

der Form

M

Spätestens hier wird klar, daß es sinnvoll ist, von der leeren Menge zu reden. Z. B.

ist

fxjx 2 N und x 5 und x 7g

die leere Menge, da es kein x 2 N gibt mit x 5 und x 7. Im obigen Beispiel (d)

M

:

sowie

fxjE (x)g

Dabei beschreibt E (x) eine Eigenschaft von x, z. B.:

M

fMjM ist Menge und M 62 Mg

=

Hierzu kann man schließen

=

ergibt sich in der sogenannten Pattstellung auch die leere Menge. Die leere Menge

wird durch 0/ beschrieben, aber auch durch fg (leere Aufzählung).

Die Problematik einer naiven Modellierung zeigt das folgende Beispiel, das von

Raymond M. Smullyan stammt:

Beispiel 2.2.3

Die Einwohner einer Stadt gehören vielen Clubs an, wobei jeder auch mehreren

Clubs angehören kann. Jeder Club ist nach einem Einwohner benannt und es gibt

zu jedem Einwohner genau einen Club, der nach ihm benannt ist. Ein Einwohner

braucht aber nicht dem nach ihm benannten Club anzugehören. Tut er dies, so

=

fx1 x2 x3 g

;

;

;:::

angeben kann. M ist dann unendlich.

Beispiel 2.2.4

1. N ist abzählbar unendlich, denn

N =

f1 2 3 g

;

;

;::: :

2. N0 ist abzählbar unendlich, denn

N0 =

fx1 x2 x3 g mit xi = i ; 1

N0 =

f0 1 2 g

;

;

;:::

d. h.

;

;

;::: :

;

2.2. MENGEN

21

KAPITEL 2. ELEMENTARE MODELLBILDUNG

22

Dann wird noch jeweils nz fortgelassen, wenn die dadurch dargestellte Zahl

schon vorkam. Dies ergibt also folgenden Anfang der Aufzählung:

3. R ist unendlich, aber nicht abzählbar unendlich. Wir zeigen die letzte Eigenschaft:

Dazu nehmen wir an, R sei doch abzählbar unendlich,

R =

0; 1;

fr1 r2 r3 g

;

;

;::: :

Wir schreiben jedes Element ri in der Dezimalschreibweise

r1

=

: : :;

r2

=

: : :;

1

1

dk1; dk1;1; : : : ; d21; d11; d01:d;

1 ; d;2 ; : : :

2

2

dk2; dk2;1; : : : ; d22; d12; d02:d;

1 ; d;2 ; : : :

=

: : :;

Wir verwenden die üblichen Operationen auf Mengen:

Es gilt r 2 R. Dies beweist man mit Hilfe der genauen Definition von R.

Nun müßte r in der Reihe r1 ; r2; : : : vorkommen, etwa r = r j . Dann wäre

=

: : :;

j

j

j

j

j

d2 ; d1 ; d0 ; d;1; d;2; : : : = r = : : : ; 0; 0; 0; e;1; e;2; : : :

2

0

3

1

1

2

1

3

4

1

4

-2

:::

:::

. % . %

; 12 ; 13 ; 14

#% . % .

-1 -1

2

:::

!0 0!

#% . % .

2

:::

2

2

2

3

2

4

:::

. % . %

-2 ; 22 ; 23 ; 24

:::

=

=

B [ A;

(A [ B) [ C;

A:

Potenzmenge:

P(A)

=

fBjB Ag

:

Statt P(A) schreibt man auch 2A .

Ist A endlich und jAj = n, so ist auch P(A) endlich und es gilt

5. Q ist abzählbar unendlich. Eine Abzählfolge ergibt sich wie folgt:

Jedes q 2 Q ist durch q = nz ; z 2 Z; n 2 Z, darstellbar. Darauf gründen wir

folgende Reihenfolge:

1

0

=

A sei eine Menge. Die Potenzmenge zu A ist definiert als

j

1

Differenz A ; B von zwei Mengen A und B.

Aus einfachen Mengen kann man komplexe Mengen aufbauen:

k für alle k gewählt. Dies ist

Also d; j = e; j . Es war aber gerade e;k 6= d;

k

ein Widerspruch. Also war die Annahme, daß R abzählbar unendlich ist,

falsch. Das bedeutet, R ist eben nicht abzählbar unendlich.

Nenner

Zähler 0

Durchschnitt A \ B von zwei Mengen A und B.

A[B

A [ (B [ C)

A[A

0; : : :; 0; e;1; e;2; : : :

k für alle k.

(als Dezimalbruch r = 0:e;1e;2 e;3 : : :) mit e;k 6= d;

k

rj

Vereinigung A [ B von zwei Mengen A und B.

Es gelten die bekannten Rechenregeln für diese Operationen, z. B.:

4. Dazu bilden wir

r

1

1 1 1 1

; ;1; 2; ; ; ; ; ; ; ;2; : : :

2

2 3 4 3

jP(A)j

=

2n:

Das Cartesische Produkt von Mengen werden wir im nächsten Abschnitt

kennenlernen.

Im Rechner werden Mengen normalerweise in einer bestimmten Reihenfolge,

d. h. als Liste abgelegt. Wir betrachten dazu verschiedene Möglichkeiten. Für jede ist zu überlegen, welcher Aufwand bei Operation auf den Mengen entsteht. Als

Operationen ziehen wir in Betracht

1. Test auf Enthaltensein eines Elementes: x 2 M,

2. Hinzufügen eines Elementes: M [fxg und

2.3. RELATIONEN UND FUNKTIONEN

23

3. Entfernen eines Elementes: M ;fxg.

2. (S1 S2 ) S3 ist ein cartesisches Produkt über den beiden Mengen S1 S2 und S3 ; es ist hier also zwischen S1 S2 S3 und S1 (S2 S3 ) zu

unterscheiden.

a) Ablage als Liste mit möglicher Wiederholung von Elementen:

1. x 2 M: Durchsuchen gegebenenfalls der ganzen Liste nach dem ersten

Auftreten des Elementes x erforderlich.

2. M [fxg: Schlichtes Anfügen an die Liste.

3. M ; fxg: Durchsuchen der ganzen Liste auf mehrfaches Vorkommen

und Entfernen jedes Elements x.

b) Ablage als Liste ohne Wiederholung von Elementen

1. x 2 M?: Durchsuchen gegebenenfalls der ganzen Liste nach dem Auftreten des Elements x erforderlich. Die Gesamtlänge der Liste ist jedoch i.a. kürzer als in der Notation von Teil a).

2. M [ fxg: Erst suchen, ob x schon vorkommt, dann gegebenenfalls an

die Liste anfügen.

3. M ;fxg: Durchsuchen bis zum ersten Vorkommen von x, dann wird x

entfernt.

Später werden wir noch bessere Möglichkeiten der Speicherung kennenlernen, bei

denen eine mögliche Ordnung auf den Elementen ausgenutzt wird.

2.3 Relationen und Funktionen

2.3.1 Cartesisches Produkt

fhs1 s2

;

; : : :;

Wenn die Mengen Sk alle gleich sind, S1 = S2 = : : : = Sk = S, dann heißt S1 S2 Sk das k-fache cartesische Produkt (von S), in Zeichen Sk .

Im Falle k = 1 degeneriert das cartesische Produkt: S1 = S.

Gelegentlich wird noch der spezielle Fall des nullstelligen cartesischen Produkts

(k = 0) gebraucht: S0 enthalte nur ein Element, das leere Tupel ε (oder:hi); dieses

enthält keine Komponenten.

:::

Beispiel 2.3.2

a) Felder eines Schachbrettes: fA,. . . ,Hgf1,. . . ,8g.

b) Sei Σ ein endliches Alphabet. Die Menge Σi heißt auch Menge der Worte

der Länge i. Für die Elemente von Σi ist die kürzere Schreibweise s1 s2 : : : sk

anstelle von hs1 ; s2 ; : : : ; sk i üblich.

S

Anmerkung: Die Menge aller Worte über Σ ist fΣi ji 2 N0 g. Diese enthält

auch das leere Wort ε. Für diese Menge wird kurz Σ geschrieben.

Spezielle Alphabete sind: B=Menge aller Großbuchstaben (einschl. dem

Leerzeichen), Menge Z der Ziffernzeichen.

c) Sei VNAME=B20 ,FNAME=B25 ,PLZ=Z5 . Die Tupel des cartesischen Produkts FNAME VNAME PLZ enthalten drei Komponenten, die der

Reihe nach für Familienname, Vorname und Postleitzahl stehen.

2.3.2 Relationen

Definition 2.3.1 (Cartesisches Produkt)

Sei k 2 N.

Cartesisches Produkt von S1; S2; : : : ; Sk:

S1 S2 : : : Sk :=

KAPITEL 2. ELEMENTARE MODELLBILDUNG

24

sk ijsi 2 Si ; i = 1; : : : ; kg

;

; : : : ; sk i heißt k-Tupel über S1 ; S2 ; : : : ; Sk .

Das cartesische Produkt über S1 ; S2; : : : ; Sk ist also die Menge aller k-Tupel über

diesen Mengen.

hs1 s2

Beachte:

1. Die Reihenfolge, in der die k Mengen notiert sind, ist relevant. D. h., werden

z. B. S1 und S2 vertauscht, dann ergibt sich ein anderes cartesisches Produkt.

Eine Teilmenge R von S1 S2 : : : Sk heißt Relation über S1 S2 : : : Sk.

Im Falle k = 2 spricht man von einer binären Relation (oder Korrespondenz von S1

nach S2 ). Für R S1 S2 heißt S1 der Definitionsbereich (Urbildbereich, domain,

kurz: dom(R) ), und S2 der Bildbereich (Wertebereich, image, range, kurz im(R) ).

Für ha; bi 2 R wird auch häufig aRb geschrieben.

Wenn R Relation ist und S1 = S2 = : : : = Sk = S, dann heißt R k-näre Relation auf

S.

Beispiel 2.3.3

Relationen sind:

a) Identische Relation auf einer Menge S (Diagonale von S): idS = fha; aija 2

Sg.

2.3. RELATIONEN UND FUNKTIONEN

25

b) Leere Relation zwischen S1 und S2 : 0/ S1 S2

c) Verschiedenheitsrelation auf S: idS = fha; bija; b 2 S; a 6= bg

d) Teilmenge der Tupel der Form FNAMEVNAMEPLZ der hier anwesenden Personen

Sei S eine Menge, und R eine binäre Relation über S. Dann ist R;1

fha bijhb ai 2 Rg die zu R inverse Relation.

;

d) S=fmo,di,mi,do,fr,sa,sog stehe für die Tage der Woche. R beschreibe die Abfolge der Tage: R=f(mo,di),(di,mi),(mi,do),(do,fr),

(fr,sa),(sa,so),(so,mo)g. Sei nun R ergänzt um alle Paare ha; bi für die gilt:

es existiert ein c; ha; ci 2 R; hc; bi 2 R. Die so erhaltene Relation R ist

keine partielle Ordnung, da sie nicht asymmetrisch ist: z. B. sind die Paare

(fr,so) und (so,fr) darin enthalten.

Eine partiell geordnete Menge (S; R) heißt total geordnet, falls die partielle Ordnung R folgende Eigenschaften hat: für alle a; b 2 S gilt: ha; bi 2 R oder hb; ai 2 R.

Einige grundlegende Begriffe bei binären Relationen:

KAPITEL 2. ELEMENTARE MODELLBILDUNG

26

=

;

2.3.4 Operationen auf Relationen

R heißt symmetrisch, wenn R;1 = R gilt, d. h. aus ha; bi 2 R folgt hb; ai 2 R.

R heißt antisymmetrisch, falls R \ R;1

hb; ai 2 R folgt a = b.

R heißt reflexiv, falls idS R, d. h. ha; ai 2 R für alle a 2 S.

R heißt irreflexiv, falls idS \ R = 0, d. h. ha; ai 2

= R für alle a 2 S.

idS gilt, d. h. aus ha bi 2 R und

;

R heißt transitiv, wenn für alle a; b; c 2 S gilt: Aus ha; bi 2 R und hb; ci 2 R

folgt ha; ci 2 R.

2.3.3 Ordnungsrelationen

Eine binäre Relation R über S heißt (partielle) Ordnung (über S) falls R reflexiv,

antisymmetrisch und transitiv ist.

Das Paar (S; R) heißt dann auch partiell geordnete Menge, oder poset.

Beispiel 2.3.4

Partiell geordnete Mengen sind:

a) S = N, und R = fhi; jiji jg.

b) Sei P(S) die Potenzmenge einer Menge S. Die Relation über P(S) ist reflexiv, antisymmetrisch und transitiv. Dagegen ist die Relation irreflexiv,

antisymmetrisch und transitiv.

c) Menge I der Intervalle über R, zusammen mit der partiellen Ordnung hI:=

f< i1; i2iji1 = [a1; b1]; i2 = [a2; b2], und b1 < a2g.

Sei R eine Relation über S1; S2; : : : ; Sk. Für i 2 f1; : : : ; kg ist die i-te Projektion

pri : R ! Si definiert durch: pri (hs1 ; : : : ; sk i) = si .

Seien R1 und R2 binäre Relationen über Mengen S1 und S2 . Dann sind auch die

Vereinigung R1 [ R2 , der Durchschnitt R1 \ R2 , und die Differenz R1 ; R2 Relationen über S1 und S2 .

Seien nun Relationen R1 S1 S2 und R2 S2 S3 gegeben. Das Relationenprodukt R1 R2 ist definiert durch R1 R2 = fha; cij9b 2 S2 mit ha; bi 2 R1 und

hb; ci 2 R2g

Ist spezieller R S S, dann werden mehrfache Relationenprodukte rekursiv definiert:

R0

R1

=

Rn+1

R+

=

R

=

=

=

idS ;

R;

R Rn ; n 2 N;

[

R1 [ R2 [ : : : = fRi ji 2 Ng ist die transitive Hülle von R, und

R0 [ R+ ist die reflexive, transitive Hülle von R:

2.3.5 Funktionen

Eine binäre Relation R über A und B heißt Funktion (von A nach B) falls aus

ha; b1i; ha; b2i 2 R die Gleichheit b1 = b2 folgt. Eine Relation mit dieser Eigenschaft heißt auch rechtseindeutig.

Üblicherweise wird die Funktionenschreibweise verwendet: fR : A ! B. Anstelle

von ha; bi 2 R schreiben wir fR (a) = b oder fR : a 7! b.

Für Funktionen gilt R;1 R idB .

Wenn idA R R;1 gilt, so heißt R (bzw fR ) total, andernfalls partiell. Für eine

totale Funktion fR : A ! B gilt somit dom( fR) = A.

R (bzw fR ) heißt surjektiv (oder auf B) wenn R;1 R = idB gilt.

2.3. RELATIONEN UND FUNKTIONEN

27

KAPITEL 2. ELEMENTARE MODELLBILDUNG

28

R (bzw fR ) heißt injektiv (oder 1-1) wenn R R;1 = idA (äquivalent dazu: aus

fR (a1 ) = fR (a2 ) folgt a1 = a2 ).

R (bzw fR ) heißt bijektiv wenn R injektiv und surjektiv ist.

Eine bijektive Funktion von A nach A selbst wird auch Permutation von A genannt.

2.3.6 Operationen auf Funktionen

durch

( p1

Dann ist f g: A ! B definiert durch

Dann ist g f : A ! C definiert durch

(f

f : A ! B;

g)(a)

=

f (a)

g(a)

benutzt man außer der Funktionsschreibweise f (a; b) auch Operatorschreibweisen wie:

a f b : Infixschreibweise, z. B. 3j + j7,

f ab : Präfixschreibweise, z. B. +j3j7 oder

ab f : Postfixschreibweise, z. B. 3j7j+.

! f (a) g(a))

! x1

;

;

p2 ! x2; : : : ; pn ! xn)(a) =

x1 , falls p1(a) =TRUE,

x2 , falls p1(a) =FALSE und p2(a) =TRUE,

=

x3 , falls p1(a) = p2(a) =FALSE und p3(a) =TRUE,

..

.

8

>

<

>

:

Dabei kürzen wir nur noch den Fall pn =TRUE,

( p1

! x1

, falls a 2dom(g)

, falls a 2

= dom(g); a 2dom( f ):

f:AB ! C

, falls p(a) = TRUE

, falls p(a) = FALSE.

und allgemeiner

( p1

f (a)

heißen auch n-stellige Funktionen. Dabei ist auch der Sonderfall der

0-stelligen Funktionen f : ! B erfaßt. Statt f (ha1 ; : : : ; ani) schreibt man

f (a1 ; : : : ; an).

Für zweistellige Funktionen

g: A ! Bundp: A ! B

Wir schreiben hierfür auch

( p(a)

g(a)

f : A1 A2 : : : An ! B

Dann ist die Funktion ( p ! f ; g) definiert durch

;

=

Funktionen der Form

Seien f , g und p Funktionen gemäß

!f

g)(a)

g( f (a)):

Verzweigung:

(p

Überschreibung:

f : A ! Bundg: A ! B:

f : A ! Bundg: B ! C:

=

pn;1 ! xn;1 ; xn)

Seien f und g partielle Funktionen gemäß

Seien f und g Funktionen gemäß

f )(a)

; : : :;

ab.

Hintereinanderausführung:

(g

! x1

:::

, TRUE ! xn )

2.3.7 Darstellung von Funktionen

Wertetabellen: Eine Funktion f : A ! B mit endlich vielen Wertepaaren

ha; f (a)i kann in einer Tabelle dargestellt werden, z. B.

a

1

2

3

4

f (a)

’xyz’

’xx’

’yzy’

’zzzz’

2.3. RELATIONEN UND FUNKTIONEN

29

Berechnungsvorschrift

Hierbei wird angegeben, wie aus dem Argument a 2 A das Bild f (a) errechnet werden soll. Dies kann durch eine Formel geschehen, z. B.

p

f (a)

=

a2 + 7a

(1 + 2a)2

Allgemeiner ist die Beschreibung mit Hilfe eines Algorithmus, d. h. einer

programmierbaren Berechnungsvorschrift.

Beispiel 2.3.5

Euklidischer Algorithmus zur Bestimmung des größten gemeinsamen Teilers:

ggT:

N

N ! N

:

Für x; y 2 N wird ggT(x; y) wie folgt bestimmt:

while x<>y do

begin

if x > y then x := x-y

else y := y-x;

ggt(x;y) := x;

end.

Dies läßt sich auch als eine rekursive Funktionsdefinition schreiben. Wir tun

dies in der Form einer Spezifikation in Z-Notation:

ggT(x,y)

x; y : N

x=y

ggT(x,y)= x < y

x>y

!x

! y;x

! x;y

Charakterisierung durch Eigenschaften

Man kann eine Funktion auch hinreichend beschreiben, ohne eine Berechnungsvorschrift dazu anzugeben. Das folgende Beispiel demonstriert dies

für die Funktion ggT:

30

KAPITEL 2. ELEMENTARE MODELLBILDUNG

ggT(x,y)

x; y : N

ggT(x,y)=x

ggT(x+y,y)=ggT(x,y)

ggT(x,x+y)=ggT(x,y)

Es gibt Programmiersprachen, in denen man einige solcher Definitionen

auch als eine Art Berechnungsvorschrift hinschreiben kann. Der Übersetzer zur Programmiersprache kann dann automatisch eine Berechnungsvorschrift ableiten.

2.3. RELATIONEN UND FUNKTIONEN

31

KAPITEL 2. ELEMENTARE MODELLBILDUNG

32

2.3.8 Äquivalenzrelationen

Eine binäre Relation R über S heißt Äquivalenzrelation (über S) falls R reflexiv,

symmetrisch und transitiv ist, d. h.

idS R;

reales Problem

R;1 = R;

R R R:

Modellierung der Problemstruktur

Für jedes a 2 S definieren wir eine Teilmenge aR von S,

Erkundung des Loesungsweges fuer

die ganze Problemklasse

fb 2 Sjha bi 2 Rg

aR heißt R-Klasse von a. Statt ha bi 2 R schreibt man oft a b (mod R).

Es gilt für alle a 2 S:

a 2 aR a b (mod R) genau dann wenn aR = bR

aR

Modell des

Problems

=

;

:

;

;

:

Speziell bilden die R-Klassen eine Partition von S, d. h. sie definieren eine Zerlegung von S in paarweise disjunkte Teilmengen (Klassen der Partition).

Loesungsverfahren

im Modell

Beispiel 2.3.6

Programmierung des Loesungsverfahrens

k 2 N; für alle m n 2 N0 gelte hm ni 2 R genau dann wenn es ein i 2 N gibt,

so daß jm ; nj = ki . Die R-Klassen sind:

;

Programm

Anwendung des Programms

jR

=

;

f j k + j 2k + j g für j = 0 1

;

;

;:::

;

; : : :;

k;1

(Restklassen modulo k).

Loesung im Modell

Interpretation

reale Loesung

2.3.9 Darstellung von Relationen

Abbildung 2.1: Lösen von Problemen mit dem Computer

Funktion f : A ! B; R = f f ;1 . Es gilt R ist Äquivalenzrelation auf A.

Tabellendarstellung

Endliche Relationen lassen sich in Tabellen darstellen, z. B.

Person Alter

Hans

19

Anna

18

Fritz

21

2.3. RELATIONEN UND FUNKTIONEN

33

Matrixdarstellung

Die Mengen A und B seien endlich, jAj = n, jBj = m. Jede Relation R A B läßt sich dann in einem rechteckigen Schema mit n Zeilen, je eine

für jedes Element aus A, und m Spalten, je eine für jedes Element aus B,

darstellen. Man zeichnet dann ein bestimmtes Zeichen (1 oder +) für das

Bestehen der Relation und ein anderes (0 oder ;) für das Nichtbestehen der

Relation.

Beispiel 2.3.7

ajb bedeute: a ist Teiler von b, a 2 f1; : : : ; 6g, b 2 f1; : : : ; 12g

j

1

1

0

0

0

0

0

1

2

3

4

5

6

2

1

1

0

0

0

0

3

1

0

1

0

0

0

4

1

1

0

1

0

0

5

1

0

0

0

1

0

6

1

1

1

0

0

1

7

1

0

0

0

0

0

8

1

1

0

1

0

0

9 10 11 12

1 1 1 1

0 1 0 1

1 0 0 1

0 0 0 1

0 1 0 0

0 0 0 1

Berechnungsvorschrift

Genauso wie eine Funktion kann auch eine Relation berechnet werden, z. B.

durch einen Algorithmus. Dies wird insbesondere klar durch die Tatsache,

daß eine Relation R A B durch eine totale Funktion

f:AB ! B

dargestellt werden kann: für R gewinnt man f durch die Festlegung

f (a; b)

=

(

ha bi 2 R ! TRUE,FALSE)

;

:

Umgekehrt wird aus f die Relation R durch

ha bi 2 R $ f (a b) = TRUE

;

2.4 Beweistechniken

Die Richtigkeit einer mathematischen Aussage kann sich auf zwei Arten ergeben.

Sie kann durch Festlegung gegeben sein.

Beispiel 2.4.1

Sei M eine Menge und x 2 M. Hier brauchen wir x 2 M nicht weiter zu beweisen.

Ist eine Aussage nicht durch unmittelbare Festlegung wahr, so muß sie bewiesen

werden, um als wahr zu gelten.

Ein direkter Beweis hat die folgende Form:

Es gibt Aussagen A1 ; : : : ; An , die durch Festlegung gelten. Durch logisches Schließen wird aus Aussagen A1 ; : : : ; Ak ; k n, jeweils eine neue Aussage Ak+1 gewonnen, solange bis die zu beweisende Aussage Ai erreicht ist.

2.4.1 Widerspruchsbeweis

Oft verwendet man keinen direkten Beweis, sondern einen Widerspruchsbeweis.

Dieser beruht darauf, daß nicht zugleich eine Aussage und ihr Gegenteil gelten

können.

Soll man nun aus A1 ; : : : ; An die Aussage B herleiten, so bildet man das Gegenteil

B von B und wendet logische Schlußverfahren auf

A1 ; : : : ; An ; B

an. Sobald eine Aussage zusammen mit ihrem Gegenteil auftritt, hat man B auf

der Grundlage von A1 ; : : : ; An bewiesen.

Beispiel 2.4.2

Es gibt unendlich viele Primzahlen. Das Gegenteil ist: Es gibt nur endlich viele

Primzahlen. Diese seien p1; p2; : : : ; pn. Bilde z = p1 p2 pn + 1. Nach den

Regeln über die Teilbarkeit ist z durch keine der Zahlen p1; : : : ; pn teilbar. Also

ist z entweder eine Primzahl, oder durch eine Primzahl p teilbar, die zu p1 ; : : : ; pn

verschieden ist. Damit haben wir das logische Gegenteil der Aussage p1 ; : : : ; pn

”

sind alle Primzahlen“ hergeleitet. Also ist die Annahme falsch und die Aussage

Es gibt unendlich viele Primzahlen“ bewiesen.

”

;

bestimmt.

KAPITEL 2. ELEMENTARE MODELLBILDUNG

34

Charakterisierung durch Eigenschaften

Eine indirekte Bestimmung einer Relation ist ebenfalls wie bei Funktionen

möglich.

2.4.2 Beweis nach dem Prinzip der vollständigen Induktion

Der Induktionsbeweis, genauer Beweis durch vollständige Induktion, ist eine spezielle Methode des logischen Schließens. Man kann auch Methoden des logischen

Schließens als Aussagen formulieren und beweisen. Als Beispiel verwenden wir

eine Variante der vollständigen Induktion.

Betrachte eine Folge von Aussagen A(1); A(2); : : ::

2.5. WERTE, VARIABLE UND TERME

35

Sei A(n) eine Aussage zu n 2 N. Es gelte A(1) und daß aus A(i) für

alle i n stets A(n + 1) folgt, n 2 N. Wir können dazu eine Folge von

Aussagen E (1); E (2); : : : angeben, für die gilt:

Sei E (n) eine Aussage zu n 2 N. Es gelte E (1) und aus E (n) folgt

stets E (n + 1), n 2 N, n > 1. Dann gilt E (n) für alle n 2 N.

Wir setzen

E (n)

=

Es gilt A(i) für alle i n“ :

”

Dann zeigen wir, daß die Schlußweise der Behauptung immer richtig

ist:

E (1)ist erfüllt.

Es gelte E (n), also A(i) für alle i n. Nach Voraussetzung gilt dann

A(n + 1) und folglich auch E (n + 1).

Das Prinzip der vollständigen Induktion besagt die Gültigkeit von

A(i) für alle i 2 N. Dann ist auch E (i) für alle i 2 N richtig.

2.5 Werte, Variable und Terme

2.5.1 Werte

Die Elemente von Mengen, die wir zur Modellierung benutzen, nennen wir Werte.

Häufig vorkommende Werte sind

Aussagenwerte oder boolesche Werte: TRUE, FALSE,

natürliche Zahlen bzw. Zahlen aus N0 ,

ganze Zahlen,

reelle Zahlen,

rationale Zahlen,

komplexe Zahlen,

Zeichen eines Alphabets und

Worte über Alphabeten.

Auch Elemente komplizierter Mengen treten als Werte auf: Paare, n-Tupel, Mengen selbst, Funktionen, Relationen.

KAPITEL 2. ELEMENTARE MODELLBILDUNG

36

2.5.2 Variable

Eine Variable ist charakterisiert durch

einem Namen x, das ist ein Element aus einer Menge von Symbolen, meist

ein Wort über einem Alphabet,

einem Wertevorrat Y, das ist eine Menge und

einer veränderlichen Zuordnung v: x 7! y mit y 2 Y , dabei bedeutet veränderlich, daß während der Verwendung der Variablen verschiedene Zuordnungen x 7! y und auch das Nichtbestehen einer solchen Zuordnung ( undefi”

nierte Variable“) in Betracht kommen.

Die Festlegung einer Variablen bezüglich ihres Wertevorrats schreiben wir in der

Form

[d. h.

x:Y

für alle Zuordnungen v gilt v(x) 2 Y ]

oder, falls M eine Obermenge von Y ist (Y

M),

x:M

p(x)

für den Fall, daß Y = fy 2 M j p(y)g gilt.

Eine solche Festlegung heißt Deklaration der Variablen.

Die Festlegung eines Wertes heißt Zuweisung. Sie wird meist in der Form

x := y

notiert. Danach gilt x 7! y. Diese Schreibweise setzt die Vereinbarung einer Funktion voraus, die die Variablen auf ihre Werte abbildet:

Sei N die Menge der Variablennamen und

W

=

[

x2N;x:Y

Y:

Eine Variablenbelegung ist eine partielle Funktion

v: N ! W mit v(x) 2 Y für x : Y :

Deklarationen in Programmiersprachen können explizit und implizit sein. Bei der

impliziten Deklaration in der Sprache APL wird der Wertebereich aus dem Kontext bei der Benutzung entnommen. Beispiel:

X ’A’ (Zuweisung des Zeichens ’A’, zugleich implizite Deklaration

X : character)

2.5. WERTE, VARIABLE UND TERME

37

Die Sprache Fortran führt implizite Deklarationen auf der Grundlage von Standards ein z. B. die Verwendung von

sofern nichts anderes explizit vereinbart ist.

Die Verwendung von Werten erfordert Methoden für ihre Beschreibung und Konstruktion. Wir unterscheiden:

Wertebeschreibungen durch sogenannte Konstanten, z. B. 3.14159 = π stellvertretend für eine solche Konstante,

Werteberechnungen durch sogenannte Terme z. B. (a + 3b)=17:2

2.5.3 Terme

Terme sind formale Ausdrücke, in denen Konstante, Variable und Funktionen vorkommen können, und die die Berechnung von Werten über null oder mehrere

Stufen hinweg beschreiben:

/

.&

+

a

.&

3

Stufe 3

17,2

*

.&

; x)

3

ein arithmetischer Term.

Beweis:

a; c; 99; x und 3 sind arithmetische Terme,

(a + c) und (99 ; x) sind arithmetische Terme,

(a + c) (99 ; x) ist ein arithmetischer Term;

(a + c)(99 ; x)

ist damit auch ein arithmetischer Term.

3

Terme werden zunächst als Zeichenreihen oder Strings aufgefaßt. Das ist möglich,

wenn man die Konstanten als Beschreibungen von Werten durch Strings auffaßt.

Die Struktur von Strings kann anschaulich durch Syntaxdiagramme dargestellt

werden.

)

)

)

Beispiel 2.5.3

m

- bm

- cm

Variable:

- a

Stufe 2

Stufe 1

b

Beispiel 2.5.2

Sei K=f0,1,: : :,99g und V=fa,b,: : :,zg. Dann ist

(a + c) (99

i, j, k für Integer und von

x, y, z für Real,

KAPITEL 2. ELEMENTARE MODELLBILDUNG

38

..

.

- z

Stufe 0

m

Die folgende exakte Definition beschreibt arithmetische Terme mittels der Funktionen für Addition, Subtraktion, Multiplikation und Division in Operatorschreibweise:

Definition 2.5.1 (arithmetischer Term)

Sei K 6= 0/ eine Menge von Konstanten und V

/

K \ V = 0.

6= 0/ eine Menge von Variablen,

1. Eine Konstante k 2 K ist ein arithmetischer Term, die einen Wert bezeichnet

(z. B. π : Wert 3:1415 : : :, 3“: Wert 3)

”

2. Eine Variable v 2 V ist ein arithmetischer Term.

3. Sind S und T arithmetische Terme, so auch (S + T ), (S ; T ), (S T ), S=T .

Hierdurch wird immer eine unendliche Menge von Termen definiert.

6

..

.

- 99

m

6

Term:

m-

- (

m

- 2m

- 3m

Konstante:

-1

-

Term

-

Konstante

-

Variable

m

;m

- m

- m

-+

-

6

6

6

6

-

6

6

- Term

m

- )

6

2.6. AUSSAGENLOGIK

39

Dabei unterscheiden wir

Boolesche Funktionen sind totale Funktionen

f : Bn ! B; n 2 N:

elementare Diagramme:

Diese enthalten nur Bestandteile in Stringform.

Diagramme mit Referenzen:

Diese enthalten Stringbestandteile in der Form von Namen, die auf andere

Syntaxdiagramme bzw. auf sich selbst verweisen. Letzteres führt auf