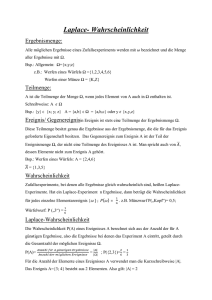

Ereignisse und ihre Wahrscheinlichkeiten Stichprobenräume

Werbung

Ereignisse und ihre Wahrscheinlichkeiten

Stichprobenräume

Handling von Aktienkursen

Ereignisse

Quiz

Wahrscheinlichkeitsverteilungen

Additionstheorem

Gleichverteilung

Bedingte Wahrscheinlichkeiten

Unabhängigkeit von Ereignissen

Gesetz der totalen Wahrscheinlichkeit

Satz von Bayes

Die Menge Ω der möglichen Ergebnisse

eines Experiments heißt Stichprobenraum1.

Beispiele:

• Werfen eines Würfels

Ω={1, 2, 3, 4, 5, 6}

• Werfen eines roten und eines grünen Würfels

Ω={(1,1), (1,2), (1,3), (1,4), (1,5), (1,6),

(2,1), (2,2), (2,3), (2,4), (2,5), (2,6),

(3,1), (3,2), (3,3), (3,4), (3,5), (3,6),

(4,1), (4,2), (4,3), (4.4), (4,5), (4,6),

(5,1), (5,2), (5,3), (5,4), (5,5), (5,6),

(6,1), (6,2), (6,3), (6,4), (6,5), (6,6)} 2

1

2

• Beurteilung einer Magisterarbeit

Ω={1, 2, 3, 4, 5}

• Messung der Arbeitslosenrate

(in %, 1 Nachkommastelle)

Ω={0.0, 0.1, 0.2, …, 99.8, 99.9, 100.0}

sample space

Im Unterschied zur Menge {6,1} kommt es beim geordneten Paar

(6,1) auf die Reihenfolge an. Daher gilt: {6,1}={1,6}, (6,1)≠(1,6).

1

Ereignisse3 sind Teilmengen des Stichprobenraums.

Beispiele:

• Werfen eines Würfels

• Messung der Arbeitslosenrate

Mögliche Ergebnisse: 1, 2, 3, 4, 5, 6

Stichprobenraum: Ω={1,2,3,4,5,6}

Ereignisse: {1,3,5}

(ungerade Zahl)

{6}

(Sechser)

{1,2,3,4,5}

(kein Sechser)

{2,3,5}

(Primzahl)

φ

(unmögliches Ereignis)

Ω

(sicheres Ereignis)

{1,2,4}

(Zweier-Potenz)

{3,6}

(Vielfaches von 3)

M

Mögliche Ergebnisse: 0.0, 0.1, 0.2, …, 100.0

Stichprobenraum: Ω={0.0,0.1,0.2,…,100.0}

Ereignisse: {0.0,0.1,…,3.4} (Vollbeschäftigung4)

{3.5,…,100.0} (keine Vollbeschäftigung)

{0.0,…,9.9} (1-stellige Arbeitslosenrate)

{3.5,…,5.0}

M

4

3

events

Vollbeschäftigung bedeutet, dass es praktisch nur zyklische

Arbeitslosigkeit gibt. Die genaue Definition (in %) hängt von

der Region und der Zeitperiode ab.

2

Der Durchschnitt5 A∩B der Ereignisse A und B enthält

genau diejenigen Elemente von Ω, die sowohl in A als

auch in B enhalten sind.

Die Vereinigung6 A∪B der Ereignisse A und B enthält

genau diejenigen Elemente von Ω, die in A oder in B

enthalten sind.

Das Komplement7 Ac eines Ereignisses A enthält genau

diejenigen Elemente des Stichprobenraumes Ω,

die nicht in A enthalten sind.

Die Ereignisse A und B heißen disjunkt8, falls ihr

Durchschnitt A∩B leer ist.

Beispiel: Werfen eines Würfels

Ω={1,2,3,4,5,6}

A={1,3,5}, B={2,3,5}

A∩B={3,5}

A∪B={1,2,3,5}

Ac={2,4,6}

Bc={1,4,6}

Die Ereignisse A∩B und Ac sind disjunkt, ebenso

die Ereignisse A∩B und Bc.

(Ac∪B)c=({1,3,5}c∪{2,3,5})c

=({2,4,6}∪{2,3,5})c

5

6

7

8

intersection

union

complement

disjoint

={2,3,4,5,6}c

={1}

3

Eine Wahrscheinlichkeitsverteilung9 P ist eine Funktion,

die jedem Ereignis A seine Wahrscheinlichkeit P(A) zuordnet.

Eine Wahrscheinlichkeitsverteilung P heißt Gleichverteilung10, wenn es nur endlich viele mögliche Ergebnisse

gibt und alle gleich wahrscheinlich sind. Es gilt dann für

jedes Ereignis A

A Anzahl der Elemente von A

P ( A) =

=

.

Ω Anzahl der Elemente von Ω

Beispiele:

• Zweimaliges Werfen eines Würfels

Ω={(1,1),(1,2),(1,3),(1,4),(1,5),(1,6),

(2,1),(2,2),(2,3),(2,4),(2,5),(2,6),

(3,1),(3,2),(3,3),(3,4),(3,5),(3,6),

(4,1),(4,2),(4,3),(4.4),(4,5),(4,6),

(5,1),(5,2),(5,3),(5,4),(5,5),(5,6),

(6,1),(6,2),(6,3),(6,4),(6,5),(6,6)}, Ω = 36

⇒ P ({(1,4), ( 2,3), (3,2), ( 4,1)}) =

(1,0,0),(1,0,1),(1,1,0),(1,1,1)} 12, Ω = 8

⇒ P ({(0,1,1), (1,0,1), (1,1,0), (1,1,1)}) = 48

Ω={1,2,3,4,5,6}, Ω = 6

⇒

{2,4,6}

P ({2,4,6}) =

=

Ω

(höchstens einmal Kopf)

3

6

(gerade Zahl)

11

12

9

10

probability distribution

uniform distribution

(Summe ist 5)

• 3-maliges Werfen einer Münze (Kopf: 0, Zahl: 1)

Ω={(0,0,0),(0,0,1),(0,1,0),(0,1,1),

• Werfen eines Würfels

11

4

36

F ⇒ G bedeutet, dass die Aussage G aus der Aussage F folgt.

Ebenso wie beim geordneten Paar (a,b) kommt es beim Tripel

(a,b,c), Quadrupel (a,b,c,d), Quintupel (a,b,c,d,e) usw. auf die

Reihenfolge an.

4

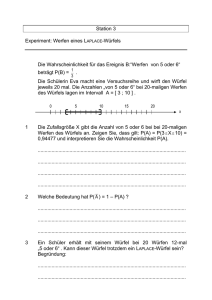

Die Wahrscheinlichkeit, dass beim Würfeln das Ereignis

{6} eintritt, ist gegeben durch:

P({6}) = 16 = 0.166666...

Würfelt man mehrmals, so kann man erwarten, dass

dieses Ereignis in ungefähr einem Sechstel der

Versuche eintritt, also z.B. bei 60 Versuchen 10 Mal.

Anstatt tatsächlich zu würfeln, verwenden wir einen

Zufallszahlengenerator. Wir erzeugen 60 Zufallszahlen

zwischen 1 und 6 mit Hilfe der R13-Funktion sample,

speichern sie im Vektor z ab und lassen sie uns anzeigen:

z <- sample(1:6,60,replace=TRUE); z

31663413553656226624

34225224234246344515

64243151346566134255

Die absoluten Häufigkeiten14 aller einelementigen

Ereignisse (Elementarereignisse15) {1},{2},…,{6}

können mit Hilfe der Funktion table berechnet werden

und ihre relativen Häufigkeiten16 in weiterer Folge

durch Division durch die Anzahl der Versuche.

table(z)

1 2 3 4 5 6

6 11 10 12 10 11

table(z)/60

1

2

3

4

5

6

0.10000 0.18333 0.16667 0.20000 0.16667 0.18333

Falls die Wahrscheinlichkeit P ( A) eines Ereignisses A

unbekannt ist, kann sie durch die relative Häufigkeit

Pˆ ( A) geschätzt werden.

14

absolute frequencies

elementary events

16

relative frequencies

15

13

Für erste Schritte mit der freien Software R siehe Appendix A.

5

Beim Werfen eines Würfels gilt einerseits

P({1,3,5} ∪ {2,4}) = 1

P({

14

,22

,34

,4,4

53

})

4

Im letzteren Fall kommt die Ungleichheit dadurch

zustande, dass die Elemente des Durchschnitts

{1,3,5}∩{2,3,5}={3,5}

5

6

=1

P4

({12

,34

,53

}) + 1

P4

({2

24

,3

4}) ,

3

6

in

2

6

P({1,3,5}∪{,2,3,5})=P({1,2,3,5})

nur einmal gezählt werden und in

weil {1,3,5} und {2,4} disjunkt sind,

und andererseits

P({1,3,5})+P({2,3,5})

doppelt.

P({1,3,5} ∪ {2,3,5}) = 1

P ({

1,2,343

,5})

42

4

6

≠1

P({

,34

,53

}) + 1

P4

({2

2,34

,3

5}) ,

412

3

6

3

6

Gleichheit wird erreicht, wenn die Wahrscheinlichkeit

des Durchschnitts von der Summe abgezogen wird.

Allgemein gilt das Additionstheorem17:

weil {1,3,5} und {2,3,5} nicht disjunkt sind.

P ( A ∪ B ) = P ( A) + P ( B ) − P ( A ∩ B )

17

additive rule of probability

6

Das sichere Ereignis Ω tritt immer ein und das unmögliche

Ereignis φ niemals.

Es gilt daher

P (Ω) = 1 18

und

P (φ ) = 0 .

Da die Ereignisse A und Ac disjunkt sind, gilt auch

P( A) + P( Ac ) = P( A ∪ Ac ) = P(Ω) = 1

bzw.

P( Ac ) = 1 − P( A) .

18

Es muss immer zumindest ein mögliches Ergebnis geben,

Ω darf also nicht leer sein.

7

Nehmen wir an, wir wüssten nur, dass eine gerade Zahl

gewürfelt wurde, nicht aber welche, dann wären die

Ergebnisse 1, 3 und 5 nicht mehr länger möglich und die

noch möglichen Ergebnisse 2, 4 und 6 wären immer noch

gleich wahrscheinlich.

Z.B. erhält man für die Ereignisse A={1,2,3,4} und Ω

Es wäre dann sinnvoll, statt der ursprünglichen Wahrscheinlichkeiten

P({1}) = P({2}) = P({3}) = P({4}) = P({5}) = P({6}) =

die durch das Eintreten des Ereignisses B={2,4,6} bedingten neuen Wahrscheinlichkeiten

Die nach dem Eintreten des Ereignisses B={2,4,6} nicht

mehr möglichen Ergebnisse 1, 3 und 5 können aus allen

Ereignissen entfernt werden, indem man alle Ereignisse

mit dem Ereignis B schneidet.

A∩B={1,2,3,4}∩{2,4,6}={2,4}

1

6

und

Ω∩B={1,2,3,4,5,6}∩{2,4,6}={2,4,6}.

Die bedingte Wahrscheinlichkeit von A, gegeben B, ist

gegeben durch

P({1} B ) = P({3} B ) = P({5} B ) = 0 ,

P({2} B ) = P({4} B ) = P({6} B ) =

zu betrachten.

1

3

P( A B ) =

=

Anzahl der noch möglichen Elemente von A

Anzahl der noch möglichen Elemente von Ω

A∩ B

2

= .

Ω∩B 3

8

Die bedingte Wahrscheinlichkeit des Ereignisses A,

gegeben dass das Ereignis B eingetreten ist19, ist im Fall

einer Gleichverteilung gegeben durch

P( A B ) =

=

Allgemein, also auch wenn keine Gleichverteilung

vorliegt, wird die bedingte Wahrscheinlichkeit20 von

A, gegeben B, definiert durch

Anzahl der noch möglichen Elemente von A

Anzahl der noch möglichen Elemente von Ω

P( A B ) =

P( A ∩ B )

.

P( B )

A∩ B

.

Ω∩B

Diese bedingte Wahrscheinlichkeit kann man auch

schreiben als

A∩ B

A∩ B

Ω

P( A ∩ B ) P( A ∩ B )

P( A B ) =

=

=

=

.

Ω∩B

Ω∩B

P (Ω ∩ B )

P( B )

Ω

19

Die Annahme, dass B eingetreten ist, macht nur Sinn, wenn P(B)≠0.

20

conditional probability

9

Zwei Ereignisse A und B heißen unabhängig21,

wenn gilt

P(A∩B)=P(A)P(B).

Sind die Ereignisse A und B unabhängig und ist

P(B)≠0,

• Werfen eines Würfels

A={1,3,5} und B={2,3,5} sind nicht unabhängig wegen

P( A ∩ B ) = P({3,5}) =

2

6

≠ P( A) P( B ) =

=

2

3

33

66

=

9

36

.

Weiters gilt:

dann ist die bedingte Wahrscheinlichkeit P( A B )

gleich der unbedingten Wahrscheinlichkeit P(A):

P( A B ) =

Beispiele:

P ( A ∩ B ) P ( A) P ( B )

=

= P ( A)

P( B )

P( B )

P( A ∩ B )

P( A B ) =

=

P( B )

2

6

3

6

≠ P ( A) =

3

6

• Zweimaliges Werfen eines Würfels

Die Ereignisse

22

Zwei Ereignisse A und B heißen abhängig ,

wenn sie nicht unabhängig sind.23

A={(6,1),…,(6,5),(6,6)} (Sechser beim 1. Wurf)

und B={(1,6),…,(5,6),(6,6)} (Sechser beim 2. Wurf)

sind unabhängig wegen

21

independent

dependent

23

Wenn zwei Ereignisse abhängig sind, muss nicht zwangsläufig

eine kausale Beziehung zwischen ihnen bestehen.

22

P ( A ∩ B ) = P ((6,6)) =

= P( A) P( B ) =

6 6

36 36

=

1

36

1

36

.

10

Beim Würfeln sind die Ereignisse

Verwendet man hingegen die relativen Häufigkeiten

6 , 11 , 10 , 12 , 10 , 11

60 60 60 60 60 60

A={2,3,5}

und

B={1,2}

der Elementarereignisse

unabhängig, weil die Wahrscheinlichkeit des Durchschnitts

P( A ∩ B ) = P({2}) =

1

6

gleich dem Produkt der Wahrscheinlichkeiten

P( A) P( B ) =

ist.

32

66

=

{1}, {2}, {3}, {4}, {5}, {6}

aus der obigen R-Anwendung anstatt der theoretischen

Wahrscheinlichkeiten

1, 1, 1, 1, 1, 1

6 6 6 6 6 6

1

6

,

so ist

Pˆ ( A ∩ B ) = Pˆ ({2}) =

11

60

ungleich

Pˆ ( A) Pˆ ( B ) =

558 .

(1160 + 1060 + 1060 )(606 + 1260 ) = 3600

Es ist aber zu erwarten, dass die Übereinstimmung besser

wird, wenn die Anzahl der Versuche zur Ermittlung der

relativen Häufigkeiten erhöht wird.

11

Downloaden und Importieren von Aktienkursen:

• Auf der Website finance.yahoo.com gibt man den

Namen eines Unternehmens, z.B. Procter & Gamble,

oder - falls bekannt - gleich das Symbol, PG, im Feld

Search ein.

• Nach dem Anklicken von Historical Data und der

Wahl von Time Period und Frequency klickt man

zunächst auf Apply und schließlich auf Download Data.

• Das heruntergeladene File table.csv24 wird in ein zuvor

angelegtes Verzeichnis, z.B. C:\R Projects\PG, kopiert.

• Nach dem Starten von R wird das Working Directory

C:\R Projects\PG gewählt, die Daten werden mit der

Funktion read.csv vom File table.csv eingelesen und im

Data Frame Y gespeichert.

• Zur Kontrolle lässt man sich die ersten und letzten

Zeilen mit den Funktionen head bzw. tail anzeigen.

24

setwd("C:/R Projects/PG") # Achtung! / statt \ in R.

Y <- read.csv("table.csv",header=TRUE)

# header=TRUE: names of variables in first line

head(Y)

Date

1 2017-03-10

2 2017-03-09

3 2017-03-08

4 2017-03-07

5 2017-03-06

6 2017-03-03

Open

90.80

90.14

90.02

90.14

89.89

90.91

High

91.16

90.49

90.35

90.49

90.51

90.91

Low Close Volume Adj.Close

90.65 91.07 6733300 91.07

90.10 90.34 5587400 90.34

89.76 90.14 5503700 90.14

90.06 90.29 5236200 90.29

89.59 90.37 6462800 90.37

89.89 90.50 8334900 90.50

tail(Y)

Date

Open High Low Close Volume

11901 1970-01-09 113.00 113.00 112.250 112.75 262400

11902 1970-01-08 111.75 113.50 111.500 113.00 531200

11903 1970-01-07 110.25 112.00 110.250 111.75 710400

11904 1970-01-06 110.25 110.25 109.250 110.00 480000

11905 1970-01-05 110.00 110.75 109.375 110.50 518400

11906 1970-01-02 109.50 110.25 109.375 110.00 832000

Adj.Close

0.464127

0.465156

0.460011

0.452807

0.454865

0.452807

PG-Kurse heruntergeladen am 13.03.2017.

12

• Die zeitlich absteigende Reihenfolge der Zeilen von Y

wird umgedreht.

• Die 7. Spalte (bereinigte Schlusskurse) wird gegen die

1. Spalte (Kalendertage) geplottet.

n <- nrow(Y)

Y[1:n,] <- Y[n:1,]; Y

d <- as.Date(Y[,1]) # Umwandlung in Datums-Vektor

y <- Y[,7]; plot(d,y,type="l") # type="l": Linienplot

# n = Anzahl der Zeilen von Y

# Zeile n wird zu Zeile 1, …

head(Y)

Date

Open High Low Close Volume Adj.Close

1 1970-01-02 109.50 110.25 109.375 110.00 832000 0.452807

2 1970-01-05 110.00 110.75 109.375 110.50 518400 0.454865

3 1970-01-06 110.25 110.25 109.250 110.00 480000 0.452807

4 1970-01-07 110.25 112.00 110.250 111.75 710400 0.460011

5 1970-01-08 111.75 113.50 111.500 113.00 531200 0.465156

6 1970-01-09 113.00 113.00 112.250 112.75 262400 0.464127

tail(Y)

Date

11901 2017-03-03

11902 2017-03-06

11903 2017-03-07

11904 2017-03-08

11905 2017-03-09

11906 2017-03-10

Open

90.91

89.89

90.14

90.02

90.14

90.80

High

90.91

90.51

90.49

90.35

90.49

91.16

Low

89.89

89.59

90.06

89.76

90.10

90.65

Close Volume Adj.Close

90.50 8334900 90.50

90.37 6462800 90.37

90.29 5236200 90.29

90.14 5503700 90.14

90.34 5587400 90.34

91.07 6733300 91.07

Die Abbildung schafft es nicht, zu vermitteln, dass für

einen Investor eine Verdoppelung des ersten Kurses von

0.452807 auf 0.905614 den gleichen Wert hat wie die

Verdoppelung des letzten Kurses von 91.07 auf 182.14.

13

Eine graphische Darstellung des Kursverlaufs wäre

wünschenswert, bei der beispielsweise der Anstieg von 1

auf 2 (eine Verdoppelung) identisch ist mit dem von 10

auf 20 (ebenfalls eine Verdoppelung). Eine solche

Darstellung erhält man, wenn man die logarithmierten

Kurse anstelle der ursprünglichen Kurse plottet.

plot(d,log(y),type="l")

Es gilt nämlich:

log(2) − log(1) = log

(21 ) = log(1020 ) = log(20) − log(10)

Die Log-Returns

rt = log( yt ) − log( yt −1 )

entsprechen ungefähr den relativen Änderungen

y − yt −1

Rt = t

yt −1

der Kurse yt gegenüber den Vortageskursen yt-1.

Beispiel: yt = 101, yt −1 = 100 ⇒ Rt = 0.01, rt ~ 0.0099503

14

Log-Returns können für die Tage 2,3,4,…,n berechnet

werden, nicht aber für den ersten Tag, weil es in diesem

Fall keinen Vorwert gibt.

r <- log(y[2:n])-log(y[1:(n-1)]) # log(y[2])-log(y[1]),…

Eine wichtige Frage in Bezug auf Log-Returns ist, ob es

Beziehungen zwischen aufeinanderfolgenden LogReturns gibt.

Wir untersuchen im Folgenden, ob sich die bedingte

Wahrscheinlichkeit

P(rt > 0 rt −1 > 0)

von der unbedingten Wahrscheinlichkeit

P (rt > 0)

c1 <- which((r[2:(n-1)]>0)&(r[1:(n-2)]>0))

# n-1 Log-Returns, n-2 Paare: (r[2],r[1]),(r[3],r[2]),…

c2 <- which(r[1:(n-2)]>0); c <- length(c1)/length(c2); c

0.4928485

u1 <- which(r[2:(n-1)]>0); u <- length(u1)/(n-2); u

0.4874832

Der Unterschied zwischen der (geschätzten) bedingten und

der (geschätzten) unbedingten Wahrscheinlichkeit ist nicht

so groß, dass er mit der Unabhängigkeit der beiden

Ereignisse

rt > 0

und

rt −1 > 0

unvereinbar wäre.25

unterscheidet.

25

Das ist nur eine erste, grobe Einschätzung. Ausführlicher wird

auf diese Fragestellung in einem späteren Kapitel eingegangen.

15

Multiplikationssatz26:

P ( A ∩ B ) = P ( A)

Gesetz der totalen Wahrscheinlichkeit28:

P ( B ∩ A)

= P ( A) P ( B A) 27

P ( A)

P ( A) = P ( A ∩ Ω) = P( A ∩ ( B ∪ B c ))

= P(( A ∩ B ) ∪ ( A ∩ B c )) 29

= P( A ∩ B ) + P( A ∩ B c )

P (C ∩ ( B ∩ A))

P( A ∩ B ∩ C ) = P( A ∩ B )

P ( B ∩ A)

= P( A) P( B A) P(C A ∩ B )

P( A ∩ B ∩ C ∩ D ) = P( A ∩ B ∩ C )

P ( D ∩ ( A ∩ B ∩ C ))

P( A ∩ B ∩ C )

= P( A B ) P( B ) + P( A B c ) P ( B c )

B und Bc sind zwei disjunkte Mengen, deren

Vereinigung Ω ergibt.

Allgemein gilt für n paarweise disjunkte Mengen

B1,…,Bn, deren Vereinigung Ω ergibt,

= P( A) P( B A) P(C A ∩ B ) P( D A ∩ B ∩ C )

P ( A) = P ( A ∩ B1 ) + ... + P ( A ∩ Bn )

= P( A B1 ) P( B1 ) + ... + P( A Bn ) P ( Bn ) .

26

27

chain rule

Hier und im Folgenden nehmen wir immer an,

dass alle auftretenden Nenner ungleich 0 sind.

28

29

law of total probability

Distributivgesetze: A∩(B∪C)=(A∩B)∪(A∩C)

A∪(B∩C)=(A∪B)∩(A∪C)

16

Satz von Bayes30:

P( B A) =

Im Fall der Log-Returns von PG lassen sich beispielsweise

die bedingten Wahrscheinlichkeiten

P( A ∩ B )

P ( B ∩ A)

=

P ( A)

P( A ∩ B ) + P( A ∩ B c )

P(rt≥0||rt|≥1%), P(rt<0||rt|≥1%), P(rt≥0||rt|<1%), P(rt<0||rt|<1%)

genauso einfach schätzen wie

=

P( A B ) P( B )

P( A B ) P( B ) + P( A B c ) P( B c )

Oder allgemeiner:

Sind B1,…,Bn paarweise disjunkte Mengen, deren

Vereinigung Ω ergibt, dann gilt für alle i∈{1,…,n}

P ( Bi A) =

P ( A ∩ Bi )

P ( Bi ∩ A)

=

P ( A)

P ( A ∩ B1 ) + ... + P ( A ∩ Bn )

=

30

P ( A Bi ) P ( Bi )

.

P ( A B1 ) P ( B1 ) + ... + P ( A Bn ) P ( Bn )

P(|rt|≥1%|rt≥0), P(|rt|<1%|rt≥0), P(|rt|≥1%|rt<0), P(|rt|<1%|rt<0).

length(which((r>=0)&(abs(r)>=0.01))) /

length(which(abs(r)>=0.01))

0.52962

length(which((abs(r)>=0.01)&(r>=0))) /

length(which(r>=0))

0.353219

Das ist auch in vielen anderen ökonomischen Anwendungen

so. Die umständliche Berechnung/Schätzung von bedingten

Wahrscheinlichkeiten mit Hilfe des Satzes von Bayes ist nur

in seltenen Ausnahmefällen nötig.

Bayes‘ theorem

17

Quiz

Lösungen

Ω={0,1,…,5}, A={1,3,5}, B={0,1}, |A∩Bc|=?

A∩Bc={1,3,5}∩{2,3,4,5}={3,5}, |A∩Bc|=2

P({0,1,…,4})= 79 , P({3})= 29 , P({0,4})= 19 , P({1,2})=?

P({0,1,…,4})=P({3})+P({0,4})+P({1,2}) ⇒ P({1,2})= 49

4 , P(A∪B)= 10 , P(A∩B)= 2 , P(B)=?

P(A)= 11

11

11

8

P(A∪B)=P(A)+P(B)−P(A∩B) ⇒ P( B ) = 10 −114 + 2 = 11

P(A∩B∩C)= 19 , P(A)= 12 , P(C|A∩B)= 13 , P(B|A)=?

P(A∩B∩C)=P(A)P(B|A)P(C|A∩B) ⇒ P(B|A)= 191 =

1

⋅

2 3

P(A)= 12 , P(A|B)= 23 , P(A|Bc)= 13 , b=P(B)=?

1 =P(A)=P(B)P(A|B)+P(Bc)P(A|Bc)=b 2 +(1−b) 1

2

3

3

P(B)= 53 , P(A|B)= 73 , P(A|Bc)= 27 , P(B|A)=?

P(B|A) =

h <- which(1:5+2*c(1,2,1,0,3)>4) # R code # length(h)=?

h=which(c(3,6,5,4,11)>4)=c(2,3,5), length(h)=3

P( A B) P( B)

P( A B) P( B) + P( A B c ) P( B c )

=

3⋅3

7 5

3⋅3 + 2⋅2

7 5 7 5

2

3

⇒ b= 12

= 139

18