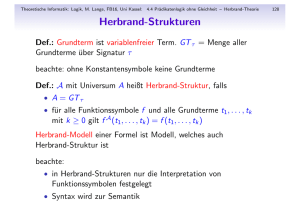

Logik, Berechenbarkeit und Komplexitaet

Werbung