Kapitel 3 Schließende Statistik

Werbung

Kapitel 3

Schließende Statistik

Beschreibende Statistik:

Analyse von Meßreihen

Wahrscheinlichkeitstheorie:

Mathematische Beschreibung von Zufallsexperimenten; dabei wurde stets angenommen, daß die Verteilungsfunktion F , die das Zustandekommen der Ergebnisse beschreibt, vollständig bekannt ist.

Schließende Statistik:

Es wird davon ausgegangen, daß die Verteilungsfunktion F (das Zufallsgesetz) nicht

vollständig bekannt ist.

Ziel: Rückschlüsse ziehen auf F auf der Basis vorliegender Beobachtungsdaten (Meßreihen).

Beispiel

Es sei p der relative Anteil der Individuen einer Population, die an einer ganz bestimmten

Krankheit leiden. Wegen des zu großen Populationsumfangs ist ein Untersuchen aller Individuen

nicht möglich. Zur Bestimmung des unbekannten relativen Anteils p wird daher folgendermaßen

vorgegangen: Der Gesamtpopulation wird eine Stichprobe von n Individuen entnommen und

es wird festgestellt, wieviele Individuen innerhalb der Stichprobe an der Krankheit leiden.

Fragen:

• Wie groß ist p ?

−→

Schätzproblem

• Zwischen welchen Grenzen liegt p ?

• Gilt p = 1% ?

−→

Testproblem

−→

Konfidenzintervall

3.1

Empirische Verteilungsfunktion

Meßreihe bzw. Stichprobe

x1 , . . . , x n

wobei

n = Stichprobenumfang

Stochastisches Modell

x1 , . . . , x n

Realisation von Zufallsvariablen X1 , . . . , Xn

X1 , . . . , Xn

unabhängig

X1 , . . . , Xn

identisch verteilt mit Verteilungsfunktion F , also

F (x) = P (Xi ≤ x) , i = 1, . . . , n

Problem:

Ziel:

3.1.1

F unbekannt !

Rückschlüsse auf F auf der Basis der vorliegenden Stichprobe !

Zentralsatz der Statistik

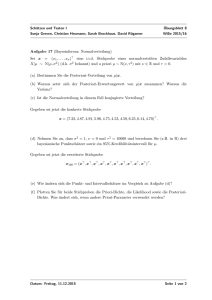

Bilde aus der Meßreihe x1 , . . . , xn die empirische Verteilungsfunkion

Fn ( · ; x1 , . . . , xn ) : R → [0, 1]

mit

1

Fn (z; x1 , . . . , xn ) =

(Anzahl der Meßwerte ≤ z)

| {z }

n

vorliegende

Meßreihe

= rel. Häufigkeit der Meßwerte ≤ z

1.0

r

6

....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ..

......................................................................................................

...........................

.

...............

. ..................

.

.

.

.

.

.

.

.

......

....... .

......

.

......

......

.

.

.

.

.

.....

.

.....

.

.

.

.

. ....

.

.

.

.......

.

.....

....

..... .

..... .

....

.

.

.

.

.

...

.

...

. .....

. .....

.

.

.

...

....

...

... .

... .

.

.

..

.

...

. .....

. ........

.

.....

....

..... .

.....

.... .

.

.

.

.

.....

.....

.

.....

.

.....

.....

.

.

.

.

.

.

...

.

.

.

.

.

.

......

.

........

........ .

.........

..........

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

............

....................................................................................................

.

F (z)

r

0.8

F5 (z; x1 , . . . , x5 )

r

0.6

r

0.4

r

0.2

0.0

-

x2

x4

x1

x5

z

x3

Idee

Fn ( · ; x1 , . . . , xn ) ≈

F( · )

| {z }

unbekannte

Verteilungsfunktion

betrachte

Fn ( · ;

X1 , . . . , Xn )

| {z }

Zufallsvariablen

zufällige Funktion“

”

Frage: Zusammenhang Fn ( · ; X1 , . . . , Xn ) ←→ F (z) ?

Zentralsatz der Statistik (Satz von Glivenko/Cantelli)

zufälliger maximaler Unterschied“ zwischen empirischer Verteilungsfunktion und wahrer Ver”

teilungsfunktion:

Dn (X1 , . . . , Xn ) = sup |Fn (z; X1 , . . . , Xn ) − F (z)| ,

n = 1, 2, . . .

z∈R

Es gilt:

P

lim Dn (X1 , . . . , Xn ) = 0 = 1

n→∞

(n = Stichprobenumfang)

Interpretation:

Für geeignet lange Meßreihen x1 , . . . , xn ist die empirische Verteilungsfunktion

Fn ( · ; x1 , . . . , xn ) eine beliebig gute Approximation für die wahre Verteilungsfunktion F .

Problemstellung

Können die Meßwerte x1 , . . . , xn als Realisation von normalverteilten Zufallsvariablen angesehen werden ?

Graphische Prüfmethode: Wahrscheinlichkeitspapier

Quantitative Prüfmethode: Kolmogoroff–Smirnov–Test

3.1.2

Wahrscheinlichkeitspapier

Φ = Verteilungsfunktion der N(0,1)– Verteilung

Es gilt

1

y = Φ(x) = √

2π

Z

x

t2

e− 2 dt

−∞

Graph von Φ:

100% =

1.0

....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ................................................................................................................

.....

..............

..........

........

.......

.

.

.

.

.

......

......

.....

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . ..........

.

.

.

.

.

.....

.... .

.....

.

...

.

...

.

.

.

.

...........................................................................................................................................................................................................................

...

.

.

.

.. ...

.

.

.

.. ...

.

.

.

.. ...

.

.

.

...

....

...

.

.

.

.

.

.

..

.

.

.

.

.

..

..

.

.

.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . ...

.

..

.

.

.

.. .

....

... .

.

.

.

.

.

.

..

.

.

.

.

.

.

.

..

.

.

.

.

.

.

.

..

.

.

.

.

.

.

...

....

...

.

.

.

.

.

.

.

..

.

.

.

.

.

.

.

..

.

.

.

.

.

.

..

...

.

.

.

.

...

....

....

.

.

.

.

.

.

.

.

.

...

.

.

.

.

.

.

.

.

.

..

. . . . . . . . . . . . . . . . . . . . . ..........

.

.

.

.

.

.

.

.

.

.

.

.

.

.

..... .

....

...... .

.

.

.

.

.

.

.

.

.

.

....

.

.

.

.

.

.

.

.

.

.

.

....

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.......

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.................................................................................

.

.

..

.

84.1% = 0.841

y

50% =

0.5

15.9% = 0.159

0% =

0.0

-

−3.0

−2.0

−1.0

0.0 x 1.0

2.0

3.0

Idee

Änderung der Skala der y–Achse so, daß sich der Graph von Φ im

neuen Koordinatensystem zu einer Geraden streckt.

Skalaänderung:

v = Φ−1 (y) ,

0<y<1

wobei

Φ−1 = Umkehrfunktion von Φ

Damit gilt für den Graph von Φ im x − v–Koordinatensystem:

v = Φ−1 (Φ(x)) = x

| {z }

=y

also: Graph von Φ im x − v–Koordinatensystem = 1. Winkelhalbierende

Das x − v–Koordinatensystem bezeichnet man als Wahrscheinlichkeitsnetz

v6

84.1% →

1

50% →

0

15.9% → −1

......

........

........

.........

........

.

.

.

.

.

.

.

....

.........

........

........

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .................

.

.

.

.

.

.

.

...

.

.........

.

........

........

.

.........

........

.

.

.

.

.

.

.

.

......

.

.

.

.

.

.

.

.

....

. . . . . . . . . . . . . . . . . . . . . . . . . . . ...................

.

.

.

.

.

.

..

.

.

.........

........

.

.

.

.

.

.

.

.

.

......

.

.

.

.

.

.

.

.

.

......

.

.

.

.

.

.

.

.

.

......

.

.

.

.

.

.

.

.....

.

.

. . . . . . . . . . . . . ..................

.

.

.

.

.

.

.

......

.

.

.

.

.

.

.

.

.

.

......

.

.

.

.

.

.

.

.

.

.

......

.

.

.

.

.

.

.

..

.

.

.

.........

........

.

.

.

.

.

.

.

.

.

.

......

.

.

.

−2.0 −1.5 −1.0 −0.5

0.0

x

0.5

1.0

1.5

v=x

2.0

Achtung

Im Wahrscheinlichkeitsnetz wird die v–Achse mit den entsprechenden

Prozentzahlen beschriftet !

Allgemein

Fµ,σ2 = Verteilungsfunktion einer N (µ, σ 2 )–Verteilung

Im x-y–Koordinatensystem:

y = Fµ,σ2 (x) = Φ

x−µ

σ

Im x-v–Koordinatensystem:

v=Φ

−1

x−µ

x−µ

=

Φ

σ

σ

Fazit:

Die Verteilungsfunktion einer Normalverteilung ist also im Wahrscheinlichkeitsnetz stets eine Gerade !

Näherungswerte für die Parameter µ und σ 2 einer Normalverteilung:

setze v = 0 (entspricht 50%–Linie)

=⇒ x = µ

setze v = 1 (entspricht 84.1%–Linie) =⇒ x = µ + σ

v

6

84.1%

50%

....

..............

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . ..............................

...............

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

....

.

...............

..............

.

...............

...............

.

...............

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.........

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . ......................

.

.............

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.........

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.........

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

..........

.

.

.

.

.

.

.

.

.

.

.

.

.

..

.

.

...............

...............

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

..........

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

...............

.

.

.

.

.

.

.

.

.

.

Fµ,σ2

←−−−−−−− σ −−−−−−−→

µ

µ+σ

-

x

Vorgehen

1. Den Graphen der empirischen Verteilungsfunktion zur Meßreihe x1 , . . . , xn in das x − v–

Koordinatensystem (Wahrscheinlichkeitsnetz) eintragen.

2. Die approximierende Näherungsgerade einzeichnen

3. Falls die Abweichungen zwischen dem Graphen der empirischen Verteilungsfunktion (Treppenfunktion) und der Näherungsgeraden nicht zu groß sind: Näherungswerte für µ und σ

bestimmen.

Hinweis:

Bei klassierten Daten müssen die summierten relativen Klassenhäufigkeiten als

Punkte über den rechten Klassengrenzen in das Wahrscheinlichkeitsnetz eingetragen werden. Dann Gerade durch diesen Punkteschwarm legen.

3.1.3

Kolmogoroff–Smirnov–Test

Hypothese H0 :

F = F0

wobei

F0 beliebige stetige Verteilungsfunktion, F0 vorgegeben

Beispiel

F0 = Verteilungsfunktion einer Normalverteilung

Also insbesondere

µ und σ 2 vorgegeben

Vorgehen

Berechne

Dn (x1 , . . . , xn ) = sup |Fn (z; x1 , . . . , xn ) − F0 (z)|

z∈R

= max |Fn (x(i) ; x1 , . . . , xn ) − F0 (x(i) )| , |Fn ( x(i) − 0 ; x1 , . . . , xn ) − F0 (x(i) )| , i = 1, . . . , n

| {z }

linksseitiger

Grenzwert

Dabei ist

x(1) , . . . , x(n)

die geordnete Meßreihe.

1.0

r

6

....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ....... ..

..........................................................................................................

........................

.

..............

. .................

.....

.

.

.

.

.

.

.

.......

...... .

......

.

......

.

.....

.

.

.

.

..

.

.....

. .........

.........

.

.

.

.....

....

..... .

..... .

....

.

.

.

...

.

...

. .....

.

. ....

......

.

....

...

... .

... .

.

.

.

.

...

. .....

. ........

.

.

.

....

....

..... .

..... .

..... .

.

.

.

.

.....

.

.....

.....

.

.....

. ...........

............

.....

........

........ .

..........

............

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

..

....................................................................................................

.

F (z)

r

0.8

F5 (z; x1 , . . . , x5 )

r

0.6

r

0.4

0.2

r

0.0

-

x2

x4

x1

x5

x3

z

Falls alle Meßwerte verschieden sind, gilt

i

Dn (x1 , . . . , xn ) = max − F0 (x(i) )

n

i − 1

, − F0 (x(i) ) , i = 1, . . . , n

n

Entscheidung:

Hypothese F = F0“ verwerfen, falls

”

Dn (x1 , . . . , xn )

zu groß“ ,

”

d. h. falls

Dn (x1 , . . . , xn ) > c

Problem:

Vorgehen:

Wahl von c ?

Bei Gültigkeit der Hypothese H0 (also F = F0 ) soll gelten

P (Dn (X1 , . . . , Xn ) > c) ≈ α ,

wobei 0 < α < 1 vorgegeben.

Interpretation:

Die Wahrscheinlichkeit dafür, die Hypothese zu verwerfen, obwohl

sie wahr ist, d. h. die Wahrscheinlichkeit dafür, die Hypothese

fälschlicherweise zu verwerfen (Fehlentscheidung !), soll ≈ α betragen

Die festzulegende Konstante c hängt also vom gewählten α ab:

c = cα

Da α die Wahrscheinlichkeit für eine Fehlentscheidung ist, wird α in der Regel klein gewählt:

α = 1%

oder

α = 5%

Man bezeichnet α als Signifikanzniveau des Tests.

Zur Festlegung von cα benötigt man die Verteilung von Dn (X1 , . . . , Xn ), falls F = F0 gilt.

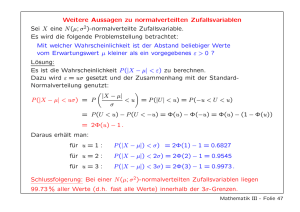

Satz (Kolmogoroff)

X1 , . . . , Xn unabhängige und identisch verteilte Zufallsvariablen mit stetiger Verteilungsfunktion F . Dann gilt:

lim P

√

n→∞

n · Dn (X1 , . . . , Xn ) ≤ y = K(y) ,

wobei K : R −→ [0, 1] gegeben durch

∞

X

2 2

1+2

(−1)k e−2k y

K(y) =

k=1

0

y>0

y∈R

Kolmogoroffsche

Verteilungsfunktion

y≤0

Werte von K in Tabellen !

Kolmogoroffsche Verteilungsfunktion

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

0

0.2

0.4

0.6

0.8

1

1.2

1.4

1.6

1.8

2

Bestimmung von cα :

P (Dn (X1 , . . . , Xn ) > cα ) = 1 − P (Dn (X1 , . . . , Xn ) ≤ cα )

√

√

= 1−P

n · Dn (X1 , . . . , Xn ) ≤ n · cα

√

≈ 1 − K( n · cα )

!

= α

Daraus folgt:

√

K( n · cα ) = 1 − α

Vorgehen: α vorgeben, 1−α berechnen, der Tabelle den Wert für

cα ermitteln

√

n·cα entnehmen und daraus

Beispiel

Vorgabe: α = 5%

√

K( n · cα ) = 1 − 0.05 = 0.95

Der Tabelle entnimmt man:

√

Man erhält:

n · cα = 1.36

1.36

cα = √

n

Im Falle n = 100 gilt also cα = 0.136.

Die Entscheidung bei der Durchführung des Kolmogoroff–Smirnov–Tests zum Signifikanzniveau α = 5% lautet also: Falls

1.36

Dn (x1 , . . . xn ) > cα = √

n

wird die Hypothese F = F0“ verworfen, sonst kann gegen H0 nichts eingewendet werden.

”

Beachte:

F0 muß vollständig bekannt sein !

3.2

Schätzverfahren

Gegeben: Stichprobe x1 , . . . , xn ; n = Stichprobenumfang ;

Modell:

• Realisierung von unabhängigen Zufallsvariablen X1 , . . . , Xn ;

• alle Zufallsvariablen identisch wie X verteilt mit einer Verteilungsfunktion Fθ , θ ∈ Θ ;

• Θ = Indexmenge“ (Menge der möglichen Parameterwerte)

”

Ziel:

Angabe eines Schätzwerts für θ bzw. für τ (θ), wobei τ : Θ → R ,

also τ (θ) ein reellwertiger Parameter“

”

Beispiel

Es sei X ∼ N (µ, σ 2 ), also

θ = (µ, σ 2 )

Θ = R × R+

und

• Schätzen des Erwartungswertes

τ (θ) = µ

• Schätzen der Varianz

τ (θ) = σ 2

Schätzer

Tn : Rn −→ R

Zuordnung

(x , . . . , x ) 7−→ Tn (x1 , . . . , xn )

| 1 {z n}

|

{z

}

Stichprobe

Schätzwert für τ (θ)

Schätzvariable

Tn (X1 , . . . , Xn )

(Zufallsvariable)

Schreibweisen:

Eθ (X) ,

V arθ (X) ,

Pθ (X ≤ x) ,

Eθ (Tn ) = Eθ (Tn (X1 , . . . , Xn )) ,

...

Index θ bedeutet: Der Wert der jeweiligen Größe hängt davon ab, welches θ ∈ Θ das zutreffende

ist !

Beispiele

• Das arithmetische Mittel

n

Tn (x1 , . . . , xn ) = x(n) =

1X

xi

n i=1

ist ein Schätzer für

τ (θ) = Eθ (X)

• Die Stichprobenvarianz

n

Tn (x1 , . . . , xn ) =

s2(n)

2

1 X

=

xi − x(n)

n − 1 i=1

ist ein Schätzer für

τ (θ) = V arθ (X)

Frage: Welche speziellen Eigenschaften sollten vernünftige Schätzer besitzen ?

3.2.1

Erwartungstreue

Beispiel

Schießen mit einem Gewehr

normale Streuung !

systematischer Fehler !

Idee:

T

T

τ(θ)

τ(θ)

Schätzer soll im Mittel richtig schätzen !“

”

Der Schätzer Tn heißt erwartungstreu, falls für alle θ ∈ Θ gilt:

Eθ (Tn (X1 , . . . , Xn )) = τ (θ)

Beispiele

• Es sei

τ (θ) = Eθ (X)

und

Tn (X1 , . . . , Xn ) = X (n)

Dann gilt:

n

1X

Xi

n i=1

Eθ (Tn (X1 , . . . , Xn )) = Eθ

n

1X

=

Eθ (Xi )

n i=1 | {z }

τ (θ)

1

· n · τ (θ)

n

= τ (θ)

=

d. h. X (n) ist erwartungstreu für τ (θ) = Eθ (X) .

!

• Es sei

τ (θ) = V arθ (X)

und

n

Tn (X1 , . . . , Xn ) =

2

S(n)

1 X

=

(Xi − X (n) )2

n − 1 i=1

Es gilt mit µ = Eθ (X):

n

X

2

(Xi − X (n) )

i=1

n

X

2

=

(Xi − µ) − (X (n) − µ)

=

i=1

n

X

(Xi − µ)2 − 2

n

X

(Xi − µ)(X (n) − µ) + n(X (n) − µ)2

(Xi − µ)2 − 2

n

X

(Xi X (n) − µXi − µX (n) + µ2 )

i=1

=

n

X

i=1

i=1

i=1

2

+ n(X (n) − µ)

n

X

2

=

(Xi − µ)2 − 2[nX (n) − 2nµX (n) + nµ2 ] + n(X (n) − µ)2

i=1

=

=

n

X

i=1

n

X

(Xi − µ)2 − 2n(X (n) − µ)2 + n(X (n) − µ)2

(Xi − µ)2 − n(X (n) − µ)2

i=1

Daraus erhält man:

2

Eθ S(n)

= Eθ

1

n−1

1

Eθ

=

n−1

n

X

(Xi − X (n) )2

!

i=1

n

X

(Xi − µ)2 − n(X (n) − µ)2

!

i=1

n

X

1

2

2

=

E

[(X

−

µ)

]

−

n

E

[(X

−

µ)

]

θ

i

θ

(n)

{z

}

n − 1 i=1 |

|

{z

}

V arθ (Xi )

1

=

n−1

1

n−n·

n

1

V arθ (X (n) )= n

V arθ (X)

V arθ (X)

= V arθ (X)

2

d. h. S(n)

ist erwartungstreu für τ (θ) = V arθ (X) .

Für den Schätzer

n

n−1 2

1X

Tn (X1 , . . . , Xn ) =

· S(n) =

(Xi − X (n) )2

n

n i=1

gilt:

Eθ (Tn (X1 , . . . , Xn )) = Eθ

n−1 2

· S(n)

n

=

n−1

n−1

2

· Eθ S(n)

=

V arθ (X)

n

n }

| {z

<1

Dieser Schätzer ist also nicht erwartungstreu für τ (θ) = V arθ (X) ( wahre Varianz wird

”

im Mittel unterschätzt“).

Deshalb

3.2.2

1

1

und nicht als Faktor !

n−1

n

Konsistenz

Idee: Wenn n groß genug wird, schätzt man beliebig genau.“

”

Gegeben sei für jedes n ∈ N ein Schätzer Tn : Rn → R für τ (θ).

Eine Schätzerfolge T1 , T2 , T3 , . . . heißt konsistent für τ : Θ → R , falls für jedes > 0 und für

jedes θ ∈ Θ gilt:

lim Pθ (|Tn (X1 , . . . , Xn ) − τ (θ)| > ) = 0

n→∞

Kriterium zum Prüfen, ob Konsistenz vorliegt:

Sind die Schätzer T1 , T2 , T3 , . . . erwartungstreu für τ : Θ → R und gilt

lim V arθ (Tn (X1 , . . . , Xn )) = 0 für alle θ ∈ Θ ,

n→∞

so ist die Schätzerfolge T1 , T2 , T3 , . . . konsistent für τ : Θ → R.

Beispiel

Es sei

τ (θ) = Eθ (X)

Schätzen des Erwartungswertes

Der Schätzer

Tn (X1 , . . . , Xn ) = X (n)

ist erwartungstreu für τ (θ) (siehe oben).

arithmetisches Mittel

Wegen

n

V arθ (Tn (X1 , . . . , Xn )) = V arθ

1

=

n2

1X

Xi

n i=1

n

X

!

!

V arθ (Xi )

i=1

1

=

· n · V arθ (X)

n2

1

=

V arθ (X)

n

gilt

1

V arθ (X) = 0 ,

n→∞

n→∞ n

d. h. das arithmetische Mittel ist konsistent für τ (θ) = Eθ (X) .

lim V arθ (Tn (X1 , . . . , Xn )) = lim

Problem:

Wie kann man Schätzer bestimmen, wenn Fθ , θ ∈ Θ , gegeben ist ?

3.2.3

Momentenmethode

k–tes Moment der Zufallsvariable X (siehe Abschnitt 2.4.1 bzw. 2.4.2):

m(k) (θ) = Eθ (X k )

Betrachte den Schätzer

n

Tn(k) (x1 , . . . , xn )

(k)

Tn

1X k

=

x

n i=1 i

k–tes Stichprobenmoment“

”

ist ein erwartungstreuer Schätzer für das k–te Moment von X:

!

n

X

1

Eθ Tn(k) (X1 , . . . , Xn ) = Eθ

Xk

n i=1 i

1

· n · m(k) (θ)

n

= m(k) (θ)

=

Es sei

θ ∈ Θ ⊂ Rl

l–dimensionaler Parameter

Prinzip:

Wähle als Schätzwert θ̂ denjenigen Parameterwert aus

Θ, für den gilt:

n

m(k) (θ̂) =

1X k

x

n i=1 i

für k = 1, . . . , l

Beispiele

• X exponentialverteilt mit Parameter θ

Θ = R+ ,

also l = 1

1. Moment (= Erwartungswert) von X:

m(1) (θ) = Eθ (X) =

1

θ

Gleichung zur Bestimmung von θ̂:

1

θ̂

n

=

1X

xi =: x(n)

n i=1

Es folgt:

θ̂ =

1

x(n)

Man erhält also als Schätzer für den Parameter θ einer Exponentialverteilung:

Tn (x1 , . . . , xn ) =

1

x(n)

• X normalverteilt mit Parametern µ und σ 2

θ = (µ, σ 2 ) ,

Θ = R × R+ ⊂ R2 ,

also l = 2

1. und 2. Moment von X:

m(1) (θ) = Eθ (X) = µ

m(2) (θ) = Eθ (X 2 ) = V arθ (X) + [Eθ (X)]2 = σ 2 + µ2

Es sei

θ̂ = (µ̂, σb2 )

Man erhält zunächst:

n

µ̂ = m(1) (θ̂) =

1X

xi = x(n)

n i=1

Die zweite Gleichung

n

1X 2

σb2 + µ̂2 = m(2) (θ̂) =

x

n i=1 i

liefert

n

n

2

2

1X 2

1X

σb2 =

xi − x(n) =

xi − x(n)

n i=1

n i=1

Bei Anwendung der Momentenmethode erhält man also folgende Schätzer:

Tn (x1 , . . . , xn ) = x(n)

und

für µ

n

2

1X

Tn (x1 , . . . , xn ) =

xi − x(n)

n i=1

für σ 2

• X ∼ B(1, θ) , Schätzen der Erfolgswahrscheinlichkeit θ

Θ = [0, 1] ⊂ R ,

also l = 1

1. Moment (= Erwartungswert) von X:

m(1) (θ) = Eθ (X) = θ

Nach der Momentenmethode erhält man folgenden Schätzwert für θ:

n

θ̂ = m(1) (θ̂) =

1X

xi

n i=1

Es sei k die Anzahl der Versuche mit xi = 1 (Anzahl Erfolge). Dann gilt:

θ̂ =

k

n

relative Häufigkeit der Erfolge

Die zugehörige Schätzvariable hat also folgende Gestalt:

K

Tn (X1 , . . . , Xn ) =

n

wobei K =

n

X

Xi

i=1

Frage: Ist dieser Schätzer erwartungstreu für θ ?

Die Zufallsvariable K ist B(n, θ) verteilt. Daraus folgt:

K

1

1

= · Eθ (K) = · n · θ = θ

Eθ

n

n

n

Der Schätzer ist also erwartungstreu für θ.

Frage: Ist die Schätzerfolge konsistent für θ ?

Wegen

V arθ

K

n

=

1

1

θ · (1 − θ)

· V arθ (K) = 2 · n · θ · (1 − θ) =

2

n

n

n

gilt

lim V arθ

n→∞

Die Schätzerfolge ist also konsistent für θ.

K

n

=0

3.2.4

Maximum–Likelihood–Methode

Beispiel

Gegeben sei eine Urne mit 10 Kugeln (schwarze und weiße). Die Anzahl θ der schwarzen Kugeln

in der Urne ist nicht bekannt. Es gilt

θ ∈ Θ = {0, . . . , 10}

Es wird aus der Urne dreimal ohne Zurücklegen eine Kugel gezogen. Unter den gezogenen

Kugeln befinden sich 2 schwarze Kugeln. Wie kann man mit dieser Information einen geeigneten

Schätzwert für θ gewinnen ?

Es sei

X = Anzahl der gezogenen schwarzen Kugeln

Frage: Welche Verteilung besitzt die Zufallsvariable X ?

Hypergeometrische Verteilung

Gegeben sei eine Population von N Individuen. M der Individuen seien markiert“. Es werden

”

der Population insgesamt n Individuen entnommen (Ziehen ohne Zurücklegen). Die Zufallsvariable Y beschreibe die Anzahl der markierten“ Individuen in der Stichprobe. Es gilt:

”

M

N −M

·

k

n−k

P (Y = k) =

, k = max(M − (N − n), 0), . . . , min(M, n)

N

n

hypergeometrische Verteilung“

”

Schreibweise: Y ∼ H(n, N, M )

Die Verteilung der Zufallsvariable X, die die Anzahl der gezogenen schwarzen Kugeln beschreibt, hängt natürlich vom zutreffenden, jedoch unbekannten, θ ∈ Θ ab. Es gilt:

X ∼ H(3, 10, θ)

Idee: Es wurde das Ereignis {X = 2} beobachtet. Jenes θ paßt am besten zu diesem Ereignis,

für das die Wahrscheinlichkeit des Eintretens dieses Ereignisses am größten ausfällt. Das ist das

plausibelste θ !

Maximum–Likelihood–Prinzip = Prinzip der größten Plausibilität

Zu bestimmen ist also jenes θ ∈ Θ, für das die Wahrscheinlichkeit Pθ (X = 2) am größten ist.

Es gilt für θ = 0, 1, 10:

Pθ (X = 2) = 0

sowie für θ = 2, . . . , 9 (hypergeometrische Verteilung):

θ

10 − θ

·

1

2

Pθ (X = 2) =

10

3

Die Berechnung der Werte ergibt folgende Tabelle:

θ

Pθ (X = 2)

0 1

2

3

4

5

6

7

8

9

0 0 0.067 0.175 0.300 0.417 0.500 0.525 0.467 0.300

10

0

Die größte Wahrscheinlichkeit ergibt sich für θ = 7. Man erhält also als Maximum–Likelihood–

Schätzwert für θ:

θ̂ = 7

Allgemeines Vorgehen:

1. Fall: X diskret verteilt

Betrachte die Likelihood–Funktion zur Stichprobe x1 , . . . , xn :

L(θ ; x1 , . . . , xn ) = Pθ (X1 = x1 ) · Pθ (X2 = x2 ) · . . . · Pθ (Xn = xn ) ,

| {z }

|

{z

}

Stichprobe

Wahrscheinlichkeit dafür, daß die beobachtete Stichprobe auftritt, falls θ zutrifft

Prinzip:

Wähle als Schätzwert θ̂ denjenigen Parameterwert aus

Θ, bei dem die Likelihood–Funktion L(θ ; x1 , . . . , xn ) ihr

Maximum annimmt !

Der zugehörige Schätzer

Tn (x1 , . . . , xn ) = θ̂(x1 , . . . , xn )

heißt Maximum–Likelihood–Schätzer (ML–Schätzer).

Beispiel

θ∈Θ

X sei B(1, θ) verteilt mit Parameter θ ∈ [0, 1].

Als Likelihood–Funktion zu einer Stichprobe (x1 , . . . , xn ) ∈ {0, 1})n erhält man:

L(θ ; x1 , . . . , xn ) = θx1 · (1 − θ)1−x1 · . . . · θxn · (1 − θ)1−xn = θ

Pn

i=1

xi

· (1 − θ)n−

Pn

i=1

xi

Man betrachtet die sogenannte Log–Likelihood–Funktion ln L(θ ; x1 , . . . , xn ), welche die

gleichen Maximalstellen wie die Likelihood–Funktion besitzt:

ln L(θ ; x1 , . . . , xn ) = ln θ ·

n

X

xi + ln(1 − θ) · (n −

i=1

n

X

xi )

i=1

Nullsetzen der 1. Ableitung der Log–Likelihood–Funktion ergibt:

Pn

P

n − ni=1 xi ) !

d ln L

i=1 xi

=

−

=0

dθ

θ

1−θ

Auflösen der Gleichung liefert folgenden Schätzwert für θ:

θ̂ =

1

(x1 + . . . + xn ) = x(n)

n

arithmetisches Mittel

Die 2. Ableitung der Log–Likelihood–Funktion ist < 0 an der Stelle θ̂, so daß die Funktion an

dieser Stelle tatsächlich ihr Maximum annimmt !

2. Fall: X stetig verteilt

Die Verteilungsfunktion Fθ sei gegeben durch eine Dichte fθ .

Man verwendet folgenden Übergang:

Pθ (Xi = xi ) −→ fθ (xi )

Die Likelihood–Funktion zur Stichprobe x1 , . . . , xn ist hier also folgendermaßen definiert:

L(θ ; x1 , . . . , xn ) = fθ (x1 ) · fθ (x2 ) · . . . · fθ (xn ) ,

Die weitere prinzipielle Vorgehensweise ist die gleiche wie im 1. Fall.

Beispiel

X ∼ Ex(θ) , θ > 0.

θ∈Θ

Es gilt also (siehe Abschnitt 2.3.5):

0

fθ (x) =

θe−θx

für x < 0

für x ≥ 0

Die Likelihood–Funktion zur Stichprobe x1 , . . . , xn , wobei xi > 0 für alle i, ist gegeben durch:

L(θ ; x1 , . . . , xn ) = θe−θx1 · θe−θx2 · . . . · θe−θxn

= θn · e−θ(x1 +...+xn )

Die Log–Likelihood–Funktion lautet:

ln L(θ ; x1 , . . . , xn ) = n ln θ − θ(x1 + . . . + xn )

Nullsetzen der 1. Ableitung ergibt:

d ln L

n

!

= − (x1 + . . . + xn ) = 0

dθ

θ

Daraus folgt:

n

= (x1 + . . . + xn )

θ

Man erhält also als Maximum–Likelihood–Schätzer für θ:

θ̂(x1 , . . . , xn ) =

n

1

=

x1 + . . . + xn

x(n)

(Kehrwert des arithmetischen Mittels)

Die 2. Ableitung der Log–Likelihood–Funktion ist an der Stelle θ̂ negativ, so daß die Funktion

an dieser Stelle ihr Maximum annimmmt.

Hinweis: Die Momentenmethode und die Maximum–Likelihood–Methode führen im Falle der

Exponentialverteilung zum gleichen Schätzer.

3.3

Konfidenzintervalle

Gegeben: Stichprobe x1 , . . . , xn ; n = Stichprobenumfang ;

Modell:

• Realisierung von unabhängigen Zufallsvariablen X1 , . . . , Xn ;

• alle Zufallsvariablen identisch wie X verteilt mit einer Verteilungsfunktion Fθ , θ ∈ Θ ;

• Θ = Indexmenge“ (Menge der möglichen Parameterwerte)

”

Frage: In welchen Grenzen liegt θ bzw. τ (θ) ?

Ziel: Angabe eines Schätzintervalls für θ bzw. τ (θ)

I(x1 , . . . , xn ) = [ U (x1 , . . . , xn ) , O(x1 , . . . , xn ) ]

|

{z

}

Stichprobe

gesucht: Funktionen

U : Rn → R

untere Grenze des Schätzintervalls

O : Rn → R

obere Grenze des Schätzintervalls

und

Problem: Intervall muß θ nicht enthalten !

8. Stichprobe

7. Stichprobe

!

6. Stichprobe

5. Stichprobe

4. Stichprobe

3. Stichprobe

!

2. Stichprobe

1. Stichprobe

θ

Θ

Es soll gelten:

(∗) Pθ ( U (X1 , . . . , Xn ) ≤ θ ≤ O(X1 , . . . , Xn ) ) ≥ 1 − α

für alle θ ∈ Θ

mit α vorgegeben (α klein, z. B. α = 0.05 , 5% oder α = 0.01 , 1%).

Das zufällige Intervall

I(X1 , . . . , Xn ) = [ U (X1 , . . . , Xn ) , O(X1 , . . . , Xn ) ]

mit der Eigenschaft (∗) heißt Konfidenzintervall für θ bzw. τ (θ) zum Konfidenzniveau

1 − α ( Konfidenzschätzverfahren“).

”

I(x1 , . . . , xn ) = [ U (x1 , . . . , xn ) , O(x1 , . . . , xn ) ] ist ein konkretes Schätzintervall zur Stichprobe x1 , . . . , xn .

Interpretation: α = 0.05 bedeutet, daß höchstens ungefähr 5% der entstehenden konkreten

Schätzintervalle θ nicht enthalten.

3.3.1

Konfidenzintervalle bei Binomialverteilungsannahme

X1 , . . . , Xn unabhängig, identisch B(1, θ)–verteilt, θ ∈ Θ = (0, 1).

Es gilt

Y = X1 + . . . + Xn ∼ B(n, θ)

Grenzwertsatz von Moivre–Laplace (siehe Abschnitt 2.5):

Y − nθ

p

nθ(1 − θ)

∼ N (0, 1)

(näherungsweise)

Dichte der N(0,1)-Verteilung

α

2

u α2 = −u1− α2

α

2

u1− α2

Es gilt also für alle θ ∈ Θ:

Pθ

−u1− α2

Y − nθ

≤ u1− α2

≤p

nθ(1 − θ)

!

≈ 1−α

Die Ungleichung

Y − nθ

−c ≤ p

≤c ,

nθ(1 − θ)

wobei c = u1− α2 , ist für folgende Werte von θ erfüllt:

1

n + c2

|

!

r

c2

Y (n − Y ) c2

1

Y + −c

≤θ≤

+

n

4

2

n + c2

|

{z

}

=: U (Y ) = U (X1 , . . . , Xn )

!

r

Y (n − Y ) c2

c2

Y + +c

+

2

n

4

{z

}

=: O(Y ) = O(X1 , . . . , Xn )

Für dieses zufällige Intervall gilt also:

Pθ ( U (X1 , . . . , Xn ) ≤ θ ≤ O(X1 , . . . , Xn ) ) ≈ 1 − α

für alle θ ∈ Θ

Das zufällige Intervall

I(X1 , . . . , Xn ) = [ U (X1 , . . . , Xn ) , O(X1 , . . . , Xn ) ]

ist somit ein approximatives Konfidenzintervall für θ, das für großes n näherungsweise mit dem

Intervall

"

!

!#

r

r

1

Y

(n

−

Y

)

1

Y

(n

−

Y

)

Y − u1− α2

I 0 (X1 , . . . , Xn ) =

,

Y + u1− α2

n

n

n

n

=

"

X (n) − u1− α2

r

1

X (n) (1 − X (n) ) , X (n) + u1− α2

n

r

1

X (n) (1 − X (n) )

n

übereinstimmt.

Hinweise:

• X (n) ist ein erwartungstreuer Schätzer für θ.

q

1

•

n X (n) (1 − X (n) ) ist ein Schätzer für die Streuung von X (n) , denn

1

V arθ X (n) = · θ · (1 − θ)

n

#

3.3.2

χ2 –Verteilung

Die Zufallsvariablen X1 , . . . , Xn seien unabhängig und identisch N(0,1) verteilt. Für die Zufallsvariable Y gelte:

P (Y ≤ y) = P (X12 + . . . + Xn2 ≤ y) , y ∈ R

Dann heißt Y χ2 –verteilt mit n Freiheitsgraden, kurz:

Y ∼ χ2n

Dichten von χ2n –verteilten Zufallsvariablen:

Dichte der Chi-Quadrat-Verteilung mit n Freiheitsgraden

0.5

n=2

0.4

0.3

0.2

n=3

n=6

0.1

n = 10

0

0

2

4

6

8

10

12

14

16

18

20

Hinweise:

• Negative Werte treten nicht auf.

• Es gilt

E(Y ) = n

und

V ar(Y ) = 2n

• Für großes n ist nach dem Zentralen Grenzwertsatz Y näherungsweise N (n, 2n)–verteilt.

Es gilt dann:

Y −n

≤ y ≈ Φ(y) , y ∈ R

P √

2n

• Für 0 < α < 1 sind die α–Quantile χ2n;α bzw. χ2n;1−α der χ2 –Verteilung mit n Freiheitsgraden in Tabellen gegeben.

Dichte der Chi-Quadrat-Verteilung mit n Freiheitsgraden

α

α

χ2n;1−α

χ2n;α

• Für großes n gilt näherungsweise:

χ2n;α ≈ n + uα ·

√

2n

Dabei ist uα das entsprechende α–Quantil der N(0,1)–Verteilung.

3.3.3

t–Verteilung

Es sei X ∼ N (0, 1) sowie Y ∼ χ2n . Ferner seien die Zufallsvariablen X und Y unabhängig. Für

die Zufallsvariable Z gelte:

X

P (Z ≤ z) = P

r 1 ≤ z

Y

n

Dann heißt Z t–verteilt mit n Freiheitsgraden, kurz:

Z ∼ tn

Dichten von tn –verteilten Zufallsvariablen:

,

z∈R

Dichte der t-Verteilung mit n Freiheitsgraden

0.4

n = 20

0.35

n=5

0.3

0.25

0.2

0.15

n=1

0.1

0.05

0

-4

-3

-2

-1

0

1

2

3

4

Hinweise:

• Es gilt

E(Z) = 0

n

V ar(Z) = n −

2

für

n≥2

für

n≥3

• Für großes n ist Z näherungsweise N (0, 1)–verteilt, d.h. es gilt

P (Z ≤ z) ≈ Φ(z) ,

Grund: Für den Nenner

q

y∈R

1

Y

n

gilt

1

E

Y =1

n

sowie

V ar

1

Y

n

=

2

n

und X ∼ N (0, 1).

Vergleich der t-Verteilung mit der N(0,1)-Verteilung

0.4

N(0,1)-Verteilung

0.35

0.3

0.25

0.2

0.15

0.1

n=2

0.05

0

-4

-3

-2

-1

0

1

2

3

4

• Für 0 < α < 0.5 sind die 1 − α–Quantile tn;1−α der t–Verteilung mit n Freiheitsgraden in

Tabellen gegeben. Die Quantile tn;α für 0 < α < 0.5 erhält man aus der Beziehung

tn;α = − tn;1−α

Dichte der t-Verteilung mit n Freiheitsgraden

α

α

tn;α = −tn;1−α

tn;1−α

0

• Für großes n gilt näherungsweise:

tn;1−α ≈ u1−α

Dabei ist u1−α das entsprechende (1 − α)–Quantil der N(0,1)–Verteilung.

3.3.4

Konfidenzintervalle bei Normalverteilungsannahmen

Die Zufallsvariablen X1 , . . . , Xn seien unabhängig und identisch N (µ, σ 2 )–verteilt.

θ = (µ, σ 2 )

und

Θ = R × R+

1. Fall: Konfidenzintervall für τ (θ) = µ, wobei σ 2 = σ02 bekannt

Es gilt:

n

X (n)

1X

=

Xi ∼ N

n i=1

σ02

µ,

n

Daraus folgt:

X (n) − µ

σ0

√

n

∼

N (0, 1)

Dichte der N(0,1)-Verteilung

α

2

α

2

u1− α2

u α2 = −u1− α2

Man erhält also für alle θ ∈ Θ:

1 − α = Pθ −u1− α2 ≤

X (n) − µ

≤ u1− α2

σ0

√

n

= Pθ X (n) − u1− α2

σ0

σ0

· √ ≤ µ ≤ X (n) + u1− α2 · √

n

n

Hinweise:

• X (n) ist ein erwartungstreuer Schätzer für τ (θ) = µ.

σ0

• √ ist die Streuung von X (n) .

n

Das zufällige Intervall

σ0

σ0

I(X1 , . . . , Xn ) = X (n) − u1− α2 · √ , X (n) + u1− α2 · √

n

n

ist also ein Konfidenzintervall für µ zum Konfidenzniveau 1 − α bei bekannter Varianz σ02 .

2. Fall: Konfidenzintervall für τ (θ) = µ, wobei σ 2 unbekannt

Idee: σ 2 durch

n

2

S(n)

2

1 X

=

Xi − X (n)

n − 1 i=1

schätzen.

Es gilt:

X (n) − µ

r

2

S(n)

n

∼

tn−1

Dichte der t-Verteilung mit n-1 Freiheitsgraden

α

2

α

2

−tn−1;1− α2

tn−1;1− α2

0

Man erhält also für alle θ ∈ Θ:

X (n) − µ

α

α ≤

r

≤

t

1 − α = Pθ

−t

n−1;1−

n−1;1−

2

2

2

S(n)

n

Hinweise:

• X (n) ist ein erwartungstreuer Schätzer für τ (θ) = µ.

s

2

S(n)

•

ist ein Schätzer für die Streuung von X (n) .

n

Das zufällige Intervall

I(X1 , . . . , Xn ) = X (n) − tn−1;1− α2

s

2

S(n)

n

, X (n) + tn−1;1− α2

s

2

S(n)

n

ist also ein Konfidenzintervall für µ zum Konfidenzniveau 1 − α bei unbekannter Varianz σ 2 .

3. Fall: Konfidenzintervall für τ (θ) = σ 2 , wobei µ = µ0 bekannt

Es sei

Q(n) =

n

X

(Xi − µ0 )2

i=1

Es gilt:

Q(n)

σ2

∼

χ2n

Dichte der Chi-Quadrat-Verteilung mit n Freiheitsgraden

α

2

α

2

χ2n; α

χ2n;1− α

2

2

Man erhält also für alle θ ∈ Θ:

1 − α = Pθ

= Pθ

Q(n)

2

≤ 2 ≤ χn;1− α

2

σ

!

Q

Q(n)

(n)

≤ σ2 ≤ 2

χ2n;1− α

χn; α

χ2n; α

2

2

2

Das zufällige Intervall

"

Q(n)

Q(n)

I(X1 , . . . , Xn ) =

, 2

2

χn;1− α χn; α

2

#

2

2

ist also ein Konfidenzintervall für σ zum Konfidenzniveau 1−α bei bekanntem Erwartungswert

µ0 .

4. Fall: Konfidenzintervall für τ (θ) = σ 2 , wobei µ unbekannt

Es sei

n

2

S(n)

2

1 X

=

Xi − X (n)

n − 1 i=1

Stichprobenvarianz

Es gilt:

(n − 1) 2

· S(n)

σ2

∼

χ2n−1

Dichte der Chi-Quadrat-Verteilung mit n-1 Freiheitsgraden

α

2

α

2

χ2n−1; α

χ2n−1;1− α

2

2

Man erhält also für alle θ ∈ Θ:

1 − α = Pθ

= Pθ

(n − 1) 2

≤

· S(n) ≤ χ2n−1;1− α

2

σ2

!

2

2

(n − 1)S(n)

(n

−

1)S

(n)

≤ σ2 ≤

2

2

α

α

χn−1;1−

χn−1;

χ2n−1; α

2

2

2

Das zufällige Intervall

I(X1 , . . . , Xn ) =

"

2

(n − 1)S(n)

χ2n−1;1− α

2

,

2

(n − 1)S(n)

χ2n−1; α

#

2

ist also ein Konfidenzintervall für σ 2 zum Konfidenzniveau 1 − α bei unbekanntem Erwartungswert µ.

3.4

Tests bei Normalverteilungsannahmen

Problem:

Paßt eine Stichprobe x1 , . . . , xn zu einer bestimmten Verteilungsannahme (Nullhypothese) ?

3.4.1

Einstichprobentests

Gegeben: Stichprobe x1 , . . . , xn ; n = Stichprobenumfang ;

Modell:

• Realisierung von unabhängigen Zufallsvariablen X1 , . . . , Xn ;

• alle Zufallsvariablen identisch N (µ, σ 2 )–verteilt

Gauß–Test

µ unbekannt, aber σ 2 = σ02 bekannt. µ0 vorgegeben.

Nullhypothese H0

Alternative

H1

: µ = µ0

: µ 6= µ0

zweiseitige Fragestellung

Idee:

Vergleiche X (n) (erwartungstreuer Schätzer für µ) mit µ0 .

Testgröße:

√

T (X1 , . . . , Xn ) =

n

σ0

(X (n) − µ0 )

Verteilung von T bei Gültigkeit von H0 :

T ∼ N (0, 1)

Es sei α ∈ (0, 1) das Signifikanzniveau“ des Tests.

”

Idee:

Nullhypothese verwerfen, falls der Wert von T zu klein“ oder zu groß“ ist.

”

”

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

√

n

|x(n) − µ0 | > u1− α2 ,

|T (x1 , . . . , xn )| =

σ0

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Dichte der N(0,1)-Verteilung

α

2

α

2

u α2 = −u1− α2

u1− α2

Interpretation:

Das Signifikanzniveau α beschreibt die Wahrscheinlichkeit dafür, die Nullhypothese H0 fälschlicherweise zu

verwerfen.

Den Fehler, die Nullhypothese H0 fälschlicherweise zu verwerfen, bezeichnet man als den Fehler 1. Art. Somit beschreibt α die Wahrscheinlichkeit dafür, daß dieser Fehler auftritt.

Also: α klein wählen (α = 0.05 , α = 0.01)

Einseitige Fragestellungen

• Nullhypothese H0 : µ ≤ µ0 ,

Alternative H1 : µ > µ0

Testgröße (wie vorher):

√

T (X1 , . . . , Xn ) =

n

σ0

(X (n) − µ0 )

Man erkennt, daß große Werte von T gegen die Hypothese H0 sprechen.

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

√

n

T (x1 , . . . , xn ) =

x(n) − µ0 > u1−α ,

σ0

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Dichte der N(0,1)-Verteilung

α

u1−α

• Nullhypothese H0 : µ ≥ µ0 ,

Alternative H1 : µ < µ0

Testgröße (wie vorher):

√

T (X1 , . . . , Xn ) =

n

σ0

(X (n) − µ0 )

Man erkennt, daß kleine Werte von T gegen die Hypothese H0 sprechen.

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

√

n

T (x1 , . . . , xn ) =

x(n) − µ0 < uα = −u1−α ,

σ0

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Dichte der N(0,1)-Verteilung

α

uα = −u1−α

Merke:

Bei einseitigen

Fragestellungen werden die α– bzw. (1 − α)–Quantile anstelle der

α

α

– bzw. 1 −

–Quantile verwendet !

2

2

Allgemeines Vorgehen beim Signifikanztest“

”

• Verteilungsannahmen spezifizieren

• Nullhypothese H0 und Alternativhypothese H1 formulieren

• Wahl der Testgröße T

• Bestimmung der Verteilung von T unter H0

• Entscheidungsregel angeben in Abhängigkeit vom Signifikanzniveau α

t–Test

µ und σ 2 unbekannt, µ0 vorgegeben.

Nullhypothese H0

Alternative

H1

: µ = µ0

: µ 6= µ0

zweiseitige Fragestellung

2

schätzen, wobei

Idee: σ 2 durch S(n)

n

2

S(n)

=

2

1 X

Xi − X (n)

n − 1 i=1

Stichprobenvarianz

Testgröße:

T (X1 , . . . , Xn ) =

√

n·

X (n) − µ0

q

2

S(n)

Verteilung von T bei Gültigkeit von H0 :

T ∼ tn−1

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

|T (x1 , . . . , xn )| =

√

n·

|x(n) − µ0 |

q

> tn−1;1− α2 ,

s2(n)

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Dichte der t-Verteilung mit n-1 Freiheitsgraden

α

2

α

2

−tn−1;1− α2

0

tn−1;1− α2

Einseitige Fragestellungen

• Nullhypothese H0 : µ ≤ µ0 ,

Alternative H1 : µ > µ0

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

T (x1 , . . . , xn ) =

√

x(n) − µ0

> tn−1;1−α ,

n· q

s2(n)

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

• Nullhypothese H0 : µ ≥ µ0 ,

Alternative H1 : µ < µ0

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

T (x1 , . . . , xn ) =

√

x(n) − µ0

n· q

< tn−1;α = −tn−1;1−α ,

s2(n)

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

χ2 –Streuungstest

µ und σ 2 unbekannt, σ02 vorgegeben.

2

σ02

2

σ02

Nullhypothese H0 : σ =

H1 : σ 6=

Alternative

zweiseitige Fragestellung

Idee:

2

Vergleich von S(n)

(erwartungstreuer Schätzer für σ 2 ) mit σ02

Testgröße:

T (X1 , . . . , Xn ) =

n−1 2

· S(n)

σ02

Verteilung von T bei Gültigkeit von H0 :

T ∼ χ2n−1

Dichte der Chi-Quadrat-Verteilung mit n-1 Freiheitsgraden

α

2

α

2

χ2n−1; α

2

χ2n−1;1− α

2

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

T (x1 , . . . , xn ) =

n−1 2

· s(n) < χ2n−1; α

2

σ02

oder

n−1 2

· s(n) > χ2n−1;1− α ,

2

2

σ0

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

T (x1 , . . . , xn ) =

Einseitige Fragestellungen

• Nullhypothese H0 : σ 2 ≤ σ02 ,

Alternative H1 : σ 2 > σ02

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

T (x1 , . . . , xn ) =

n−1 2

· s(n) > χ2n−1;1−α ,

σ02

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

• Nullhypothese H0 : σ 2 ≥ σ02 ,

Alternative H1 : σ 2 < σ02

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

T (x1 , . . . , xn ) =

n−1 2

· s(n) < χ2n−1;α ,

σ02

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

3.4.2

Operationscharakteristik und Gütefunktion

Einstichprobenfall, d. h. gegeben ist eine Stichprobe x1 , . . . , xn , wobei n = Stichprobenumfang

Modell:

• Realisierung von unabhängigen Zufallsvariablen X1 , . . . , Xn ;

• alle Zufallsvariablen identisch wie X verteilt mit einer Verteilungsfunktion Fθ , θ ∈ Θ ;

• Θ = Indexmenge“ (Menge der möglichen Parameterwerte)

”

Disjunkte Zerlegung der Indexmenge Θ:

Θ = Θ0 ∪ Θ1

,

wobei Θ0 ∩ Θ1 = ∅

Bezeichnung:

Θ0 = Nullhypothese

Θ1 = Alternativhypothese (Alternative)

Sprechweisen:

• θ ∈ Θ0 :

Nullhypothese trifft zu“

”

• θ ∈ Θ1 :

Alternative trifft zu“

”

Ein statistischer Test zur Prüfung des Vorliegens der Nullhypothese Θ0 ist gegeben durch

den kritischen Bereich

K ⊂ Rn

Entscheidungsregel: Gilt für die vorliegende Stichprobe

(x1 , . . . , xn ) ∈ K

,

so wird die Nullhypothese verworfen, andernfalls wird gegen Θ0 nichts eingewendet.

Bemerkung: Der kritische Bereich K wird meist mit Hilfe einer sogenannten Testgröße T festgelegt.

Beispiel

Einstichproben–t–Test

Verteilungsannahme:

X ∼ N (µ, σ 2 ) ,

also

Θ = R × R+

Nullhypothese beim einseitigen Einstichproben–t–Test:

Θ0 = {µ : µ ≤ µ0 } × R+

Alternative:

Θ1 = {µ : µ > µ0 } × R+

Dabei ist µ0 ein vorgegebener Wert.

Testgröße:

T (X1 , . . . , Xn ) =

√

n·

X (n) − µ0

q

2

S(n)

Kritischer Bereich bei festgelegtem α ∈ (0, 1):

Kα = {(x1 , . . . , xn ) : T (x1 , . . . , xn ) > tn−1;1−α }

Situation:

θ ∈ Θ0

θ ∈ Θ1

(x1 , . . . , xn ) ∈

/K

OK

Fehler

2. Art

(x1 , . . . , xn ) ∈ K

Fehler

1. Art

OK

Operationscharakteristik (OC–Funktion) des Tests:

β : Θ −→ [0, 1]

β(θ) = Pθ ((X1 , . . . , Xn ) ∈

/ K)

Gütefunktion des Tests:

g : Θ −→ [0, 1]

g(θ) = 1 − β(θ) = Pθ ((X1 , . . . , Xn ) ∈ K)

An der OC–Funktion bzw. der Gütefunktion können die Wahrscheinlichkeiten für das Auftreten

eines Fehlers 1. Art bzw. 2. Art abgelesen werden.

• θ ∈ Θ0 :

g(θ) = Wahrscheinlichkeit für das Auftreten eines Fehlers 1. Art

• θ ∈ Θ1 :

β(θ) = Wahrscheinlichkeit für das Auftreten eines Fehlers 2. Art

Es sei α ∈ (0, 1).

Ein statistischer Test heißt Niveau–α–Test, falls

g(θ) ≤ α

für alle θ ∈ Θ0

Fazit:

Bei einem Niveau–α–Test beträgt die Wahrscheinlichkeit für einen Fehler 1. Art höchstens α.

Bezeichnung: α = Signifikanzniveau des Tests

Bei allen in diesem Abschnitt betrachteten Tests werden zu vorgegebenem α (α klein) die

kritischen Bereiche so gewählt, daß die resultierenden Verfahren Niveau–α–Tests darstellen,

d. h. man orientiert sich bei der Festlegung ausschließlich an der Wahrscheinlichkeit für einen

Fehler 1. Art.

3.4.3

Zweistichprobentests

Liegen zwei verschiedene Meßreihen x1 , . . . , xm und y1 , . . . , yn vor, stellt sich oft die Frage,

ob für die zugrundeliegenden Zufallsvariablen gleiche Erwartungswerte oder gleiche Varianzen

angenommen werden können.

Gegeben: Stichprobe x1 , . . . , xm , m = Stichprobenumfang der x–Stichprobe ;

Stichprobe y1 , . . . , yn , n = Stichprobenumfang der y–Stichprobe ;

Modell:

• x–Stichprobe Realisierung von Zufallsvariablen X1 , . . . , Xm

• alle Zufallsvariablen Xi identisch N (µ1 , σ12 )–verteilt

• y–Stichprobe Realisierung von Zufallsvariablen Y1 , . . . , Yn

• alle Zufallsvariablen Yj identisch N (µ2 , σ22 )–verteilt

• alle Zufallsvariablen X1 , . . . , Xm , Y1 , . . . , Yn unabhängig

Zweistichproben–Gauß–Test

µ1 und µ2 unbekannt, aber σ12 und σ22 bekannt.

Nullhypothese H0

Alternative

H1

: µ1 = µ2

: µ1 6= µ2

zweiseitige Fragestellung

Idee:

Vergleich der arithmetischen Mittel X (m) (erwartungstreuer Schätzer für µ1 ) und

Y (n) (erwartungstreuer Schätzer für µ2 )

Testgröße:

Y (n) − X (m)

T (X1 , . . . , Xm , Y1 , . . . , Yn ) = r

σ12 σ22

+

m

n

Verteilung von T bei Gültigkeit von H0 :

T ∼ N (0, 1)

Dichte der N(0,1)-Verteilung

α

2

α

2

u α2 = −u1− α2

u1− α2

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xm , y1 , . . . , yn beobachtet mit

|y (n) − x(m) |

|T (x1 , . . . , xm , y1 , . . . , yn )| = r

> u1− α2 ,

σ12 σ22

+

m

n

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Einseitige Fragestellungen

• Nullhypothese H0 : µ1 ≤ µ2 ,

Alternative H1 : µ1 > µ2

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xm , y1 , . . . , yn beobachtet mit

y (n) − x(m)

< uα = −u1−α ,

T (x1 , . . . , xm , y1 , . . . , yn ) = r

σ12 σ22

+

m

n

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

• Nullhypothese H0 : µ1 ≥ µ2 ,

Alternative H1 : µ1 < µ2

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xm , y1 , . . . , yn beobachtet mit

y (n) − x(m)

> u1−α ,

T (x1 , . . . , xm , y1 , . . . , yn ) = r

σ12 σ22

+

m

n

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Zweistichproben–t–Test

σ12 = σ22 = σ 2 , σ 2 unbekannt.

Beachte:

Gleiche unbekannte Varianz σ 2 !

Nullhypothese H0

Alternative

H1

: µ1 = µ2

: µ1 6= µ2

Idee: Unbekannte Varianz σ 2 schätzen durch

m

2

1 X

2

S(m) =

Xi − X (m)

m − 1 i=1

bzw.

zweiseitige Fragestellung

Stichprobenvarianz der x–Werte

n

2

S̃(n)

=

2

1 X

Yi − Y (n)

n − 1 i=1

Stichprobenvarianz der y–Werte

Testgröße:

T (X1 , . . . , Xm , Y1 , . . . , Yn ) =

r

Y (n) − X (m)

mn(m + n − 2)

·q

m+n

2

2

(m − 1) · S(m)

+ (n − 1) · S̃(n)

Verteilung von T bei Gültigkeit von H0 :

T ∼ tm+n−2

Dichte der t-Verteilung mit m+n-2 Freiheitsgraden

α

2

α

2

−tm+n−2;1− α2

0

tm+n−2;1− α2

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xm , y1 , . . . , yn beobachtet mit

r

|y (n) − x(m) |

mn(m + n − 2)

·q

|T (x1 , . . . , xm , y1 , . . . , yn )| =

m+n

(m − 1) · s2 + (n − 1) · s̃2

(m)

(n)

> tm+n−2;1− α2 ,

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Einseitige Fragestellungen

• Nullhypothese H0 : µ1 ≤ µ2 ,

Alternative H1 : µ1 > µ2

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xm , y1 , . . . , yn beobachtet mit

T (x1 , . . . , xm , y1 , . . . , yn ) < tm+n−2;α = −tm+n−2;1−α ,

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

• Nullhypothese H0 : µ1 ≥ µ2 ,

Alternative H1 : µ1 < µ2

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xm , y1 , . . . , yn beobachtet mit

T (x1 , . . . , xm , y1 , . . . , yn ) > tm+n−2;1−α ,

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Problem:

Wie kann die Annahme gleicher Varianzen, die beim Zweistichproben–t–Test getroffen wird, mit einem vorgeschalteten Test überprüft werden ?

F –Verteilung

Es sei X ∼ χ2r sowie Y ∼ χ2s . Ferner seien die Zufallsvariablen X und Y unabhängig. Für die

Zufallsvariable Z gelte:

1

X

P (Z ≤ z) = P r

≤ z , z ∈ R

1

Y

s

Dann heißt Z F –verteilt mit r und s Freiheitsgraden, kurz:

Z ∼ Fr,s

Dichten von Fr,s –verteilten Zufallsvariablen:

Dichte der F-Verteilung mit r und s Freiheitsgraden

0.9

r = 10 , s = 20

0.8

0.7

r = 6 , s = 12

0.6

0.5

0.4

r=5,s=5

0.3

0.2

0.1

0

0.5

1

1.5

2

2.5

3

Hinweise:

• Es gilt

E(Z) =

V ar(Z) =

s

s−2

für

s≥3

2s2 · (r + s − 2)

r · (s − 2)2 · (s − 4)

für

s≥5

• Der wesentliche Teil der Verteilung liegt in der Nähe von 1, da

1

1

E

X =1

und

E

Y =1

r

s

• Ist Z ∼ Fr,s , so gilt

1

∼ Fs,r

Z

• Für 0 < α < 0.5 sind die (1 − α)–Quantile Fr,s;1−α der F –Verteilung mit r und s Freiheitsgraden in Tabellen gegeben.

• Die Quantile Fr,s;α für 0 < α < 0.5 erhält man aus der Beziehung

Fr,s;α =

1

Fs,r;1−α

Dichte der F-Verteilung mit r und s Freiheitsgraden

6

α

α

-

Fr,s;α

Fr,s;1−α

1

F–Test

µ1 und µ2 sowie σ12 und σ22 unbekannt.

Nullhypothese H0 :

σ12

Alternative

σ12

H1 :

=

σ22

6=

σ22

zweiseitige Fragestellung

Idee:

2

2

Vergleich der Stichprobenvarianzen S(m)

(erwartungstreuer Schätzer für σ12 ) und S̃(n)

(erwartungstreuer Schätzer für σ22 )

Testgröße:

T (X1 , . . . , Xm , Y1 , . . . , Yn ) =

2

S(m)

2

S̃(n)

Verteilung von T bei Gültigkeit von H0 :

T ∼ Fm−1,n−1

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xm , y1 , . . . , yn beobachtet mit

T (x1 , . . . , xm , y1 , . . . , yn ) =

s2(m)

s̃2(n)

< Fm−1,n−1; α2

oder

T (x1 , . . . , xm , y1 , . . . , yn ) =

s2(m)

s̃2(n)

> Fm−1,n−1;1− α2

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Dichte der F-Verteilung mit m-1 und n-1 Freiheitsgraden

6

α

2

α

2

-

Fm−1,n−1; α2

Fm−1,n−1;1− α2

1

Hinweis:

Falls der F –Test bei zwei Meßreihen zu einer Ablehnung der Nullhypothese H0 :

σ12 = σ22 führt, kann der Zweistichproben–t–Test nicht zur Überprüfung der Nullhypothese H0 : µ1 = µ2 herangezogen werden.

Einseitige Fragestellungen

• Nullhypothese H0 : σ12 ≤ σ22 ,

Alternative H1 : σ12 > σ22

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xm , y1 , . . . , yn beobachtet mit

T (x1 , . . . , xm , y1 , . . . , yn ) =

s2(m)

s̃2(n)

> Fm−1,n−1;1−α

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

• Nullhypothese H0 : σ12 ≥ σ22 ,

Alternative H1 : σ12 < σ22

Entscheidungsregel: Wird eine Stichprobe x1 , . . . , xm , y1 , . . . , yn beobachtet mit

T (x1 , . . . , xm , y1 , . . . , yn ) =

s2(m)

s̃2(n)

< Fm−1,n−1;α

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

3.5

χ2–Anpassungstests

Gegeben: Stichprobe x1 , . . . , xn ; n = Stichprobenumfang ;

Modell:

• Realisierung von unabhängigen Zufallsvariablen X1 , . . . , Xn

• alle Zufallsvariablen identisch wie X verteilt mit der Verteilungsfunktion F

Ziel:

Prüfen einer Annahme über die Verteilung von X (vgl. Kolmogoroff–

Smirnov–Test, Abschnitt 3.1.3)

3.5.1

Prüfen bei endlich vielen Merkmalswerten

Historisches Beispiel

Mendels Erbgesetz

Kreuzungsversuch von weißblühenden mit rotblühenden Pflanzen; r = 3 verschiedene Phänotypen bei den Nachkommen: weiß, rosa, rot;

Nach Mendels Erbgesetz gilt:

Verhältnis

1:2:1

Es sei

p1 = Wahrscheinlichkeit für weiß

p2 = Wahrscheinlichkeit für rosa

p3 = Wahrscheinlichkeit für rot

Nach Mendels Erbgesetz lautet also die Hypothese H0 :

(p1 , p2 , p3 ) = p01 , p02 , p03

mit

p01 =

1

4

,

p02 =

1

2

,

p03 =

Alternative H1 :

(p1 , p2 , p3 ) 6= p01 , p02 , p03

1

4

Daten: n = 112 Kreuzungen;

Phänotyp weiß“ : n1 = 22 mal

”

Phänotyp rosa“ : n2 = 53 mal

”

Phänotyp rot“ : n3 = 37 mal

”

Daraus ergibt sich:

Phänotyp

beobachtete

Häufigkeit

nj

Wahrscheinlichkeit

pj

unter H0

erwartete

Häufigkeit

n · p0j

22

0.25

28

53

0.50

56

37

0.25

28

weiß“

”

rosa“

”

rot“

”

Idee:

Die Daten sprechen nicht gegen das Erbgesetz (die Hypothese), falls

nj ≈ n · p0j

Betrachte die χ2 –Abstandsfunktion (Testgröße):

(22 − 28)2 (53 − 56)2 (37 − 28)2

T =

+

+

28

56

28

=

2 · 36 + 9 + 2 · 81

56

=

243

≈ 4.339

56

Frage:

Ist das zu groß“, d. h. soll die Hypothese bei diesem Wert verworfen werden ?

”

Allgemeines Vorgehen

Wertebereich von X: {i1 , i2 , . . . , ir } (r verschiedene Werte insgesamt)

n = Stichprobenumfang (Anzahl der Beobachtungen)

Es sei

pj = P (X = ij ) ,

j = 1, . . . , r

Hypothese:

(p1 , p2 , . . . , pr ) = (p01 , p02 , . . . , p0r )

|

{z

}

vorgegebene

Werte

mit

r

X

p0j = 1

j=1

Alternative:

(p1 , p2 , . . . , pr ) 6= (p01 , p02 , . . . , p0r )

Testgröße: Es sei Nj die zufällige Anzahl des Auftretens von ij innerhalb der Stichprobe, j =

1, . . . , r. Es gilt

r

X

Nj = n

j=1

χ2 –Abstandsfunktion:

r

X

Nj − n · p0j

T (N1 , N2 , . . . , Nr ) =

n · p0j

j=1

2

=

r

X

Nj 2

n · p0j

j=1

!

−n

Verteilung von T bei Gültigkeit der Nullhypothese H0 : Die exakte Verteilung von T ist schwierig

zu bestimmen. Es gilt näherungsweise:

T ∼ χ2r−1

Anmerkung: Die Näherung ist nach einer vielfach zitierten Faustregel als gut zu bezeichnen,

falls n · p0j ≥ 5 für j = 1, . . . , r gilt.

Es sei α ∈ (0, 1) das vorgegebene Signifikanzniveau des Tests.

Entscheidungsregel: Große“ Werte von T sprechen gegen die Hypothese.

”

Dichte der Chi-Quadrat-Verteilung mit r − 1 Freiheitsgraden

6

α

χ2r−1;1−α

-

Also: Wird eine Stichprobe x1 , . . . , xn beobachtet mit

!

2

r

r

X

X

nj − n · p0j

nj 2

=

− n > χ2r−1;1−α ,

T (n1 , n2 , . . . , nr ) =

0

0

n

·

p

n

·

p

j

j

j=1

j=1

so wird die Nullhypothese H0 verworfen, sonst wird gegen H0 nichts eingewendet.

Historisches Beispiel

Mendels Erbgesetz

Für r = 3 und α = 5% ergibt sich:

χ23−1;1−0.05 = χ22;0.95 = 5.991

Wegen

T = 4.339 < 5.991

wird gegen H0 nichts eingewendet, d. h. die Beobachtungen stehen nicht im Widerspruch zu

dem Erbgesetz.

3.5.2

Prüfen auf eine bestimmte Verteilung

Hypothese:

F = F0

(F0 vorgegeben)

Alternative:

F 6= F0

Es sei

R = I1 ∪ I2 ∪ . . . ∪ Ir

eine Zerlegung des Wertebereichs von X in r disjunkte Teilintervalle und Halbachsen und

pj = P (X ∈ Ij ) ,

....

..

....

...

..

....

..

....

...

..

I1

I2

q

j = 1, . . . , r

q

....

..

....

...

..

q

I3

....

..

....

...

..

...........

......

Ir−1

R

Ir

Hypothese:

(p1 , p2 , . . . , pr ) = (p01 , p02 , . . . , p0r )

wobei

p0j =

...

....

.. ...

P0 (X ∈ Ij )

| {z }

Berechnung unter

Zugrundelegung von F0

,

j = 1, . . . , r

F0 (x)

1 ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ...........................................................................................................................................................................................................

...

.................

..............

............

.........

.

.

.

.

.

.

.....

.....

.....

.....

.....

.

.

.

.

.....

....

.....

.......................

.....

....

..................

.

.

.

..................

....

....

..................

....

..................

.....

....

..................

.

.

.

.

..................

....

....

....

.......................

....

....

..................

....

.

.

.

....

.....

.....

.....

.....

.

.

.

....

......

......

......

.......

.

.

.

.

.

.

.......

.......

........

........

.........

.

.

.

.

.

.

.

.

.

.

.................................

F0

p0j

I1

Ij

...........

......

Ir

Alternative:

(p1 , p2 , . . . , pr ) 6= (p01 , p02 , . . . , p0r )

Es gilt:

r

X

j=1

p0j = 1

x

jetzt:

Nj = Anzahl Meßwerte in Ij

,

j = 1, . . . , r

Testgröße T, Verteilung von T bei Gültigkeit von H0 sowie Entscheidungsregel wie im vorangegangenen Abschnitt.

Beispiel

1000 Zufallszahlen zwischen 0 und 1 aus einem Taschenrechner.

Hypothese: Gleichverteilung im Intervall [0,1], d. h. die Verteilungsfunktion F0 ist gegeben

durch folgende Dichte f0 (vgl. Abschnitt 2.3.4):

......

... ..

f0 (x)

1

.

.

.

.

.

.

.

.

.

.

.

.

.

0

.

.

.

.

.

.

.

.

.

.

.

.

.

.

0.4

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

...

.

...

.

...

.

...

.

...

.

...

.

...

.

...

.

...

.

...

.

...

.

...

.

...

.

...

.

...

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

0.5

1

Daten:

j

Ij

nj

1

(−∞, 0.1]

68

2

(0.1, 0.2]

116

3

(0.2, 0.3]

101

4

(0.3, 0.4]

107

5

(0.4, 0.5]

92

6

(0.5, 0.6]

100

7

(0.6, 0.7]

136

8

(0.7, 0.8]

101

9

(0.8, 0.9]

79

10

(0.9, ∞]

100

1000

..........

......

x

Berechnung der Testgröße T :

(nj − n · p0j )2

n · p0j

p0j

n · p0j

0.1

100

10.24

0.1

100

2.56

0.1

100

0.01

0.1

100

0.49

0.1

100

0.64

0.1

100

0.00

0.1

100

12.96

0.1

100

0.01

0.1

100

4.41

0.1

100

0.00

1.0

1000

31.32

Entscheidung: Für r = 10 und α = 5% erhält man

χ29;0.95 = 16.919

Wegen

T = 31.32 > 16.919

ist die Nullhypothese daher zu verwerfen.

3.6

3.6.1

Verteilungsunabhängige Tests

Zweistichprobentest von Wilcoxon–Mann–Whitney

Bezeichnungen: U–Test von Mann–Whitney“

”

Wilcoxon Rangsummentest“

”

2 Meßreihen

x 1 , x2 , . . . , x m

und

y 1 , y2 , . . . , y n

Frage:

So

oder

so ?

x 1 , x2 , . . . , x m

x 1 , x2 , . . . , x m

y 1 , y2 , . . . , y n

y 1 , y2 , . . . , y n

Modell (Verteilungsannahmen):

Stichprobe x1 , . . . , xm ;

Realisierung von Zufallsvariablen X1 , . . . , Xm ;

alle Zufallsvariablen Xi identisch verteilt mit stetiger Verteilungsfunktion F

Stichprobe y1 , . . . , yn ;

Realisierung von Zufallsvariablen Y1 , . . . , Yn ;

alle Zufallsvariablen Yj identisch verteilt mit stetiger Verteilungsfunktion G

alle Zufallsvariablen X1 , . . . , Xm , Y1 , . . . , Yn unabhängig

Nullhypothese H0 :

F =G

......

... ..

..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... .....

........................................................................................

........................

................

.............

...........

.

.

.

.

.

.

.

......

......

.....

.....

.....

.

.

.

.

.....

....

.....

....

...

.

...

...

...

..

.

...

...

...

..

.

..

..

...

..

..

.

...

...

...

....

.

.

...

....

.....

....

....

.

.

.

.

...

.....

.....

.....

.....

.

.

.

.

.

.....

......

.......

...........

............................................................................................................

...........

......

1

F=G

Alternative H1 :

F <G

.

.....

... ...

..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ........................................ ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ............................................ ..... ..... ..... ..... .....

................

...............

...........................

............................

..........

..........

.....

.....

....

....

....

....

.

.

.

.

.

.

.

.

...

...

...

...

...

...

..

..

.

.

..

..

..

..

..

..

...

...

..

..

.

.

..

..

..

..

..

..

...

...

..

..

.

.

...

...

...

...

...

...

..

..

.

.

...

...

...

...

...

...

..

..

.

.

...

...

...

...

...

...

..

..

.

.

.

.

...

...

...

...

..

..

..

..

.

.

.

.

.

.

...

...

..

..

..

..

...

...

.

.

.

.

.

.

.

.

....

....

....

....

.....

.....

.....

.....

................................

...............................

...........

......

......................................................

.....................................................

......................................................

.....................................................

...........................

...........................

1

G

y-Werte

F

<

x-Werte

oder

F >G

.

.....

... ...

..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ....................................... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ..... ............................................. ..... ..... ..... ..... .....

................

................

..................................

..................................

......

......

.....

.....

....

....

.

.

.

.

.

.

.

.

....

....

...

...

...

...

..

..

.

.

.

..

...

..

..

..

..

..

..

..

..

.

.

...

...

...

...

..

..

...

...

.

.

...

...

...