SAP Predictive Analytics

Werbung

Wissen aus erster Hand.

Leseprobe

Immer einen Schritt voraus! Lernen Sie mit diesem Buch, wie Sie aus

Ihren Daten mit SAP Predictive Analytics künftige Entwicklungen

herauslesen. In dieser Leseprobe erfahren Sie, wie Sie den Modus

»Automated Analytics« nutzen und Ihre Daten für eine Klassifikations- bzw. Regressionsanalyse vorbereiten.

»Mit dem Modus ‚Automated Analytics‘

arbeiten« (Auszug)

»Einleitung«

Inhaltsverzeichnis

Index

Die Autoren

Leseprobe weiterempfehlen

Nargiz Bakhshaliyeva, Jian Liang Chen, Ulrich Dommer,

Ekaterina Samlenski, Helge Schmedt, Nico Schulze, Robert Wilczek

SAP Predictive Analytics

Vorausschauende Analysen mit SAP

433 Seiten, gebunden, Juli 2017

79,90 Euro, ISBN 978-3-8362-4415-2

www.sap-press.de/4276

Kapitel 4

Mit dem Modus »Automated Analytics«

arbeiten

4

In diesem Kapitel werden wir die Datenvorbereitung und -analyse

der wichtigsten Algorithmen thematisieren, die im Modus Automated

Analytics zur Verfügung stehen.

4.1 Grundlagen

Bevor wir auf den eigentlichen Prozess der Modellerstellung im Detail eingehen, geben wir einen Überblick über die theoretischen Grundlagen des

Modus Automated Analytics. Die Bezeichnung Automated wird damit

begründet, dass viele Rechenschritte bei der Datenanalyse in diesem

Modus automatisiert werden. Deshalb ist Automated Analytics für die

Data-Mining-Spezialisten und Endanwender oftmals eine »Black Box«, da

es für Nutzer nahezu unmöglich ist, die Analyse im Detail nachzuvollziehen und nachberechnen zu können. In diesem Abschnitt werden die

Grundlagen des Lernprozesses, der Datencodierung und Unterteilungsstrategie erläutert.

4.1.1 Unterteilungsstrategie

Vor der Analyse werden die Trainingsdaten im Modus Automated Analytics in zwei obligatorische und eine optionale Datenmenge aufgeteilt. Der

Datenaufteilungsprozess nennt sich Unterteilungsstrategie (engl. Cutting

Strategy) und spielt eine wichtige Rolle bei der Modellerstellung in Automated Analytics.

Die Daten aus der ersten obligatorischen Datenmenge werden Schätzungsdaten (engl. Estimation Sub-set) genannt. Die Schätzungsdaten dienen dem

Trainieren des Modells. Auf Basis dieser Daten werden in mehreren Iterationen verschiedene Modelle erstellt und deren KI-Koeffizient für jedes dieser Modelle bestimmt (KI und KR wurden in Abschnitt 1.2.5, »Ergebnisvisualisierung und -bewertung«, beschrieben).

Schätzungsdaten

und Validierungsdaten

113

4

Mit dem Modus »Automated Analytics« arbeiten

Die Daten aus der zweiten obligatorischen Datenmenge werden Validierungsdaten (engl. Validation Sub-set) genannt. Mittels dieser Daten werden

die Modelle auf Konsistenz und Robustheit geprüft. Hierbei wird der KRKoeffizient berechnet. Das Modell mit dem höchsten KI- und KR-Koeffizienten wird anschließend ausgewählt.

Testdaten (optional)

Die Aufteilung der Trainingsdaten in eine dritten Datenmenge (Testdaten)

kann optional gewählt werden. Entscheidet sich der Anwender für diese Art

der Aufteilung, so wird eine finale Prüfung der Performance-Indikatoren

über diese Daten durchgeführt.

Standardmäßig werden die Trainingsdaten im Modus Automated Analytics

zufällig in Schätzungs- und Validierungsdaten unterteilt. Eine individuelle

Anpassung der Unterteilungsstrategie kann unter Datenquelle auswählen

angepasst werden (siehe Abbildung 4.1).

4.1

Grundlagen

wert, sich für eine zufällige Unterteilungsstrategie zu entscheiden. So kann

sichergestellt werden, dass in allen aufgeteilten Datensätzen ähnliche

Datensätze vorhanden sind.

4

4.1.2 Modellerstellung und Evaluierung

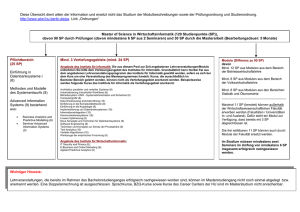

Abbildung 4.2 verdeutlicht, wie ein Modell im Modus Automated Analytics

bezüglich der Datensätze erstellt und evaluiert wird. In Schritt 1 haben wir

die Daten anhand der ausgewählten Unterteilungsstrategie in mindestens

zwei und maximal drei Datenmengen aufgeteilt.

Modell 1

Modell 2

…

Schätzungsdaten

Modell N

Erstellung von n

Modellen

Trainingsdaten

Unterteilungsstrategie

Validierungsdaten

Evaluierung der Modelle und

Auswahl des besten Modells

Unterteilung der

Trainingsdaten

Testdaten

Performancetest im

ausgewählten besten Modell

Abbildung 4.2 Unterteilungsstrategie und Auswahl des besten Modells

(Quelle: SAP)

Abbildung 4.1 Einstellungen der Unterteilungsstrategie

Benutzerdefinierte

Unterteilungsstrategie

Bei Bedarf kann eine benutzerdefinierte Unterteilungsstrategie verwendet

werden, wobei für jede Unterteilung eine entsprechende Datenmenge geladen wird (siehe auch Abschnitt 4.4.1, »Datenquelle auswählen«). Automated

Analytics unterstützt acht vordefinierte Unterteilungsstrategien: Sequenziell, Sequenziell ohne Test, Periodisch, Periodisch mit Test am Ende, Periodisch ohne Test, Zufällig, Zufällig mit Test am Ende und Zufällig ohne Test

(Standardeinstellung).

Die Auswahl einer Unterteilungsstrategie sollte anhand der vorhandenen

Daten und der auszuführenden Analyse stattfinden. Wenn in den Daten die

Variablen z. B. nach ihren Ausprägungen sortiert sind, ist es empfehlens-

114

Im Schritt 2 werden iterativ n Modelle erstellt. Bei der Erstellung eines

Modells werden alle erklärenden Variablen analysiert. An dieser Stelle wird

geprüft, welche der Variablen entweder keinen oder einen sehr geringen

Einfluss auf die Zielvariable haben. Je nach Einstellung in der automatischen

Auswahl (dazu mehr in Abschnitt 4.4.6, »Erweiterte Modellparameter«) werden die Variablen mit geringstem Einfluss auf die Zielvariable ausgeschlossen. Ist der Prozess abgeschlossen, wird in der nächsten Iteration ein neues

Modell mit den übrig gebliebenen Variablen erstellt und geprüft.

Mehrere Modelle

erstellen

Im Schritt 3 werden die erstellten Modelle evaluiert und das Modell mit

den besten Performance-Indikatoren ausgewählt. Optional können in

einem weiteren Schritt 4 die Performance-Indikatoren des ausgewählten

Modells nochmals geprüft werden.

Das beste Modell

auswählen

115

4

Mit dem Modus »Automated Analytics« arbeiten

4.1

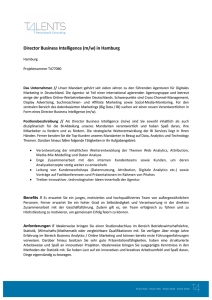

Abbildung 4.3 verdeutlicht den Lernprozess eines Modells schematisch.

Validierung

Schätzung

h= minimale

Komplexität

Modelltest auf

Basis der Validierungsdaten

Ist Error größer

geworden?

h=h+1

Das Modell mit

der Komplexität = h

wird generiert.

4.1.3 SRM-Grundlagen

Im Modus Automated Analytics wird das Prinzip der Structural Risk Minimization (SRM) verwendet, um ein optimales Modell zu finden. Die zugrunde

liegende Theorie wurde von Vladimir Vapnik und Alexey Chervonekis erarbeitet und findet Anwendung im Bereich des maschinellen Lernens.

Training

Nein

Ja

Grundlagen

Structural Risk

Minimization

4

Einfach interpretiert, wird mithilfe der SRM-Theorie in Automated Analytics ein optimales Modell bestimmt, wenn es nicht zu komplex (übertrainiert) ist und trotzdem eine möglichst niedrige Anzahl von Fehlern

aufweist.

Wie oben beschrieben, werden während des Trainingsprozesses im Hintergrund mehrere Vorhersagemodelle automatisch erstellt. Abbildung 4.4 verdeutlicht, wie sich diese Modelle voneinander unterscheiden und welches

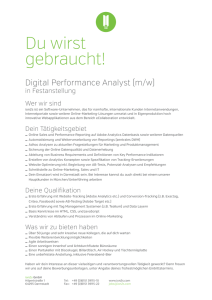

davon ausgewählt werden sollte.

Fehler

(Validierungsdatenset)

Fehler

h wird erhöht

finales Modell = bestes

Modell mit h – 1

das beste

Modell

Modellkomplexität

Fehler

Abbildung 4.3 Lernprozess im Modus Automated Analytics (Quelle: SAP)

Der Parameter h gibt die Komplexität eines Modells an (Grundlagen der

Structural Risk Minimization oder SRM vermitteln wir in Abschnitt 4.1.3).

Am Anfang der Trainingsphase ist die Komplexität h des erstellen Modells

minimal. Ein Modell wird immer auf Basis eines Schätzungsdatensatzes

erstellt. Nach dem Erstellen eines Modells 1 werden die Fehleranzahl (Vergleich der Vorhersage mit den tatsächlichen Werten der Zielvariablen) und

Performance-Indikatoren dieses Modells auf dem Validierungsdatensatz

geprüft.

Nachdem die Prüfung abgeschlossen wurde, wird ein weiteres Modell 2

erstellt, dessen Komplexität h+1 beträgt. Die Fehler dieses Modells werden

mit demselben Validierungsdatensatz berechnet. Weist das Modell 2 der

Komplexität h+1 weniger Fehler auf als das vorige Modell 1 der Komplexität

h, wird ein weiteres Modell 3 mit der Komplexität h+2 erstellt. Die Komplexität des nächsten Modells wird so lange inkrementiert, bis die Anzahl der

Fehler, die auf Basis des Validierungsdatensatzes berechnet wurde, steigt

(siehe Abbildung 4.4 im folgenden Abschnitt, Graph 2). Ist das Fall, wird das

Modell mit der geringsten Fehleranzahl als das beste Modell ausgewählt.

116

(Schätzungsdatenset)

Modellkomplexität

underfitting

overfitting

Abbildung 4.4 Das beste Modell nach der SRM-Theorie

Auf der x-Achse wird die Modellkomplexität h dargestellt, die y-Achse

repräsentiert die Anzahl der Fehler. Graph 1 zeigt die Anzahl der Fehler an,

die sich während des Trainingsprozesses (basierend auf dem Schätzungsdatensatz) ändert. In Allgemeinen weist das erste Modell im Erstellungsprozess relativ viele Fehler auf. Das heißt, dass sich die vorhergesagten Werte

dieses Modells oft von den historischen Werten unterscheiden. Mit jedem

Durchlauf im Trainingsprozess wird das Modell korrigiert, so dass die

Anzahl der Fehler des Modells nach jeder Iteration reduziert wird.

Graph 2 gibt die Komplexität des Modells an. Je mehr das Modell »antrainiert« wird, desto komplexer wird es.

117

4

Mit dem Modus »Automated Analytics« arbeiten

Graph 3 zeigt die Anzahl von Fehlern an, die bei dem Modelltest (basierend

auf dem Validierungsdatensatz) identifiziert wurden. Anhand genau dieser

Linie wird das Modell als bestes ausgewählt, das nach SRM die minimalste

Anzahl an Fehlern aufweist.

4.2

Datencodierung

Zielvariablenmittelwerte

Bitte beachten Sie, dass die Zielvariablenmittelwerte in Abbildung 4.5 als

Beispiel zufällig generiert wurden. Die tatsächlichen Zielvariablenmittelwerte der Variablen Education in der Census-Beispieldatei können sich

unterscheiden.

4

4.2 Datencodierung

In Automated Analytics werden die Variablen der Daten anhand des Wertes

codiert. Hier ist zu beachten, dass der Wert der Variablen den Typ dieser

Variablen bezeichnet und nicht die Ausprägung, die eine Variable annehmen kann. Der Wert einer Variablen wird anhand der Ausprägungen definiert, die diese Variable annehmen kann (siehe Beispiel einer

Klassifikationsanalyse in Abschnitt 4.4.2, »Datenbeschreibung«).

Danach werden die errechneten Zielvariablenmittelwerte der beiden Datensätze miteinander verglichen. Wenn sich diese Werte voneinander unterscheiden, d. h., wenn sie nicht robust sind, werden diese der Kategorie

KxOthers zugeordnet. Wenn die Werte gleich sind, werden sie zusammen

gruppiert, wie z. B. {Assoc-acdm; Assoc-voc} oder {5th-6th;7th-8th;9th;

10th;11th;12th} in Abbildung 4.5.

Education

4.2.1 Codierung nominaler Variablen

Die Variablen, die diskrete und nicht geordnete Ausprägungen beinhalten,

werden mit dem Wert nominal definiert. Das kann etwa der Familienstand

(ledig, verheiratet, geschieden etc.), die Autofarbe (Silber, Schwarz, Rot, Blau

etc.) oder die Postleitzahl sein. Die Encodierung nominaler Variablen

besteht aus mehreren Schritten. Zuerst werden die Zielvariablenmittelwerte (Target Mean) auf Basis des Schätzungs- und Validierungsdatensatzes

mittels Chi-Quadrat-Test miteinander verglichen.

Chi-Quadrat-Test

(χ2-Test)

Der Chi-Quadrat-Text

ist ein Signifikanztest, der zur Analyse von

zwei Variablen anhand der beobachteten Häufigkeiten ihrer Merkmalsausprägungen benutzt wird. Der Test wird oft zur Überprüfung der Unabhängigkeit zweier Variablen verwendet.

Angenommen, es sollen auf Basis historischer Kundendaten zukünftige

potenzielle Kunden einer Bank identifiziert werden. Diese Daten beinhalten 15 verschiedene Attribute, unter anderem den akademischen Grad der

Kunden, der als die Variable Education bezeichnet wird. Der Wert der Variablen Education wird als nominale Variable festgelegt.

Zielvariablenmittelwerte berechnen

und vergleichen

118

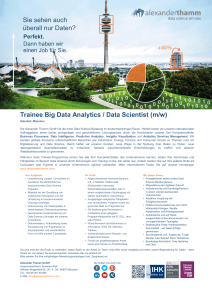

Während der Codierung werden zuerst die Zielvariablenmittelwerte für

jede Ausprägung der Variablen Education für den Schätzungs- und den Validierungsdatensatz berechnet (siehe Abbildung 4.5).

Zielvariablenmittelwert

(Schätzungsdatenset)

Zielvariablenmittelwert

(Validierungsdatenset)

1st-4th

0,15

0,25

5th-6th

0,20

0,20

7th-8th

0,20

0,20

9th

0,20

0,20

10th

0,20

0,20

{5th-6th;7th-

11th

0,20

0,20

{1st-4th;Masters}=

{KxOther}

0,20

12th

0,20

0,20

Assoc-acdm; Assoc-voc

0,45

Assoc-acdm

0,45

0,45

Bachelors

0,50

Assoc-voc

0,45

0,45

Bachelors

0,50

0,50

Doctorate

0,60

0,60

Prof-school

0,60

0,60

HS-grad

0,55

0,55

Masters

0,30

0,10

Preschool

0,25

0,25

Some-college

0,35

0,35

Education

Zielvariablenmittelwert

(Schätzungsdatenset)

0,20

Doctorate; Prof-school

0,60

HS-grad

0,55

Preschool

0,25

Some-college

0,35

Abbildung 4.5 Encoding nominaler Variablen

Nicht robuste Variablen

Wenn sich die Zielvariablenmittelwerte einer Variablen, die auf Basis der

Schätzungs- und Validierungsdaten berechnet werden, unterscheiden,

wird die Variable als nicht robust bezeichnet.

119

4

Mit dem Modus »Automated Analytics« arbeiten

Anschließend können die gebildeten Gruppen/Kategorien in einer grafischen Darstellung nach der Wichtigkeit der Kategorie betrachtet werden

(siehe Abbildung 4.6). In Abschnitt 4.4.8, »Modellverwendung: Anzeigen«,

beschreiben wir im Detail, wie die Ergebnisse dargestellt werden.

4.2

Wenn die ordinale Variable in Bezug auf den Zielvariablenmittelwert

codiert wird, werden die von 0 bis n davor erstellten Kategorien dann gruppiert, wenn die nacheinanderfolgenden Kategorien den gleichen Zielvariablenmittelwert haben. Bei der Gruppierung der Kategorien muss die

Reihenfolge unbedingt beibehalten werden. So sind z. B. bei der Codierung

der Variablen education-num, die 16 Ausprägungen enthält (von 1 bis 16), die

Kategorien [2,5] und [3,4,8] nicht zulässig. Die Kategorien [1:9[, [9:10[,

[10:11[ und [11:13[ hingegen sind plausibel (siehe Abbildung 4.7).

Datencodierung

Codierung in Bezug

auf Zielvariablenmittelwert

4

Abbildung 4.7 Wichtigkeit der ordinalen Variablen »education-num«

Abbildung 4.6 Wichtigkeit der nominalen Variablen »education«

4.2.2 Codierung ordinaler Variablen

Variablen, die diskrete und geordnete Ausprägungen annehmen können,

werden in Automated Analytics als Variablenwert ordinal definiert. Zum

Beispiel bilden Schulnoten zur Beurteilung von Studenten eine ordinale

Variable. Die ordinalen Variablen können entweder als Standard oder in

Bezug auf den Zielvariablenmittelwert codiert werden.

Standardcodierung

120

Im Fall einer Standardcodierung werden die Variablenwerte in den Kategorien von 0 bis n codiert. Die Anzahl n gibt die Menge der Ausprägungen der

Variablen an, die in den Trainingsdaten erfasst wurden. Eine standardcodierte ordinale Variable wird in der anschließenden Oberfläche zur Auswertung des Modells als <Variablenname> angezeigt, z. B. education-num.

Die ordinalen Variablen, die in Bezug auf den Zielvariablenmittelwert

codiert wurden, werden als c_<Variablename> angezeigt (siehe die Bezeichnungen education-num und c_education-num in Abbildung 4.41).

Fehlt in der Variablen eines Datensatzes die Ausprägung, so wird diese der

Kategorie KxMissing zugeordnet, die nicht robusten Ausprägungen dagegen der Kategorie KxOther.

Fehlende Werte

Bewertung als ordinale Variable

Eine Variablenordnung im Sinne einer ordinalen Variablen erfolgt über

Buchstaben oder Zahlen. Daher kann beispielsweise eine Variable Bewertung, dessen Ausprägungen gut, durchschnittlich und schlecht sind,

nicht direkt als ordinale Variable in Automated Analytics behandelt werden. Hier würden die Werte in alphabetischer Reihenfolge sortiert (durchschnittlich, schlecht, gut). Die Codierung dieser Ausprägungen nach

Zahlen kann in diesem Fall Abhilfe schaffen.

121

4

Mit dem Modus »Automated Analytics« arbeiten

4.2

Datencodierung

4.2.3 Codierung stetiger Variablen

Sind die Ausprägungen einer Variablen stetige Zahlen mit Nachkommastellen, werden solche Variablen mit dem Wertetyp continuous deklariert. Beispiele von stetigen Variablen sind z. B. Umsätze, Temperaturmessungen oder Körpergrößen. Die stetigen Variablen können sowohl

standardmäßig als auch stückweise codiert werden.

Standardcodierung

Im Fall der standardmäßigen Codierung werden alle Ausprägungen der

Variablen so normalisiert, dass der Median gleich 0 und die Standardabweichung gleich 1 sind. Bei einer solchen Codierung wird die Variable in der

anschließenden Oberfläche zur Auswertung des Modells als <Variablename>

angezeigt.

Stückweise

Codierung

Bei der stückweisen Codierung einer stetigen Variablen werden initial alle

Ausprägungen in n gleichmäßige Gruppen aufgeteilt (Standard in Automated Analytics ist n = 20). Bei 20 Gruppen entspricht die Größe der Aufteilung in etwa 5 % der vorkommenden Ausprägungen.

Die Gruppierung kann anhand der Variablen age aus den Census-Beispieldaten verdeutlich werden. Nachdem das Modell im Modus Automated Analytics erstellt wurde, kann der Anwender unter Statistische Berichte weitere

Berichte zum Modell einsehen. Dort kann unter anderem entnommen werden, dass die Ausprägungen der Variablen age im Schätzungs- und Validierungsdatensatz im Bereich von 17 bis 90 liegen (siehe Abbildung 4.8).

4

Abbildung 4.9 Statistische Berichte: Häufigkeiten der Kategorie

Einige der initial vordefinierten Bins werden mit dem nächsten »benachbarten« Bin zusammengefasst, wenn diese auf Basis des gesamten Datensatzes nicht robust sind. Ist der Zielvariablenmittelwert eines Bins ähnlich

dem des angrenzenden Bins, werden auch diese zusammengeführt. So werden im Beispiel die Bins [30;36[, [36;42[, [42;56[ und [56;90] erstellt (siehe

Abbildung 4.10).

Abbildung 4.8 Statistische Berichte: stetige Variablen

Die generierten Bins der Variablen age werden im statistischen Bericht

Häufigkeiten der Kategorie dargestellt (siehe Abbildung 4.9).

122

Abbildung 4.10 Statistische Berichte: Kreuzstatistik für gruppierte Kategorien

123

4

Mit dem Modus »Automated Analytics« arbeiten

Die restlichen Ausprägungen werden der Kategorie KxMissing zugeordnet.

Stückweise codierte stetige Variable werden in der Modellauswertung durch

das Präfix c_<Variablenname> charakterisiert (vergleichen Sie auch die Beiträge der Variablen age und der Variablen c_age im Abschnitt »Beiträge nach

Variablen« in Abschnitt 4.4.8, dort Abbildung 4.41).

4.2.4 Manuelle Variablencodierung

Wenn Sie eine eigene Codierung für eine Variable erstellen möchten, muss

unter Umständen die Struktur dieser Variablen festgelegt werden (siehe

dazu Abschnitt 4.4.2, »Datenbeschreibung«).

Fachliche Sicht der Datencodierung

Das Verfahren der Datencodierung im Modus Automated Analytics wird

ausschließlich über die vorhandene Datengrundlage determiniert. Die

fachliche Anforderung an eine Variable wird hier nicht berücksichtigt. Das

heißt, dass eine manuelle Korrektur des Wertetyps in solchen Fällen notwendig ist (siehe Beispiel zur Struktur in Abschnitt 4.4.2, »Datenbeschreibung«).

4.2.5 Behandlung fehlender Werte in Automated Analytics

Wie in Abschnitt 4.2.2, »Codierung ordinaler Variablen«, bereits angeschnitten, werden fehlende Ausprägungen in Automated Analytics gesondert behandelt. Fehlende Ausprägungen im Schätzungsdatensatz werden

bei nominalen Variablen der Kategorie KxMissing zugeordnet. Die Kategorie wird genauso wie alle anderen Kategorien behandelt. Bei stetigen Variablen können die fehlenden Ausprägungen hingegen mit einer anderen

Gruppierung zusammengefasst werden.

4.3

4.3.1 Datenvorbereitung mit dem Data Manager

Im Data Manager kann die Datengrundlage der bevorstehenden Analyse

auf Basis unterschiedlicher Zeitpunkte, z. B. jeden ersten Tages des Monats,

vorbereitet werden. Dabei können die angepasste Variable Definition und

weitere Features, wie beispielsweise Filter oder Prompt, ohne Änderungen

wieder genutzt werden. Die so erstellte Datengrundlage wird als analytischer Datensatz (engl. Analytical Data Set, ADS) bezeichnet.

Ein analytischer Datensatz im Data Manager wird in folgenden drei Schritten vorbereitet:

1. Im ersten Schritt wird eine Entität (engl. Entity) definiert. Sie ist das

kleinste Objekt in dem Datensatz und kann beispielsweise ein Kunde,

eine Ware, eine Bankkontonummer etc. sein.

Der Data Manager in Predictive Analytics beinhaltet Funktionen, die Sie bei

der Datenvorbereitung unterstützen. Der immense Aufwand zur Vorbereitung der Daten ist den Anwendern oft nicht bewusst. Erfahrungsgemäß

nimmt dieser Teil der Datenvorbereitung in der Praxis ca. 80 % des

Gesamtaufwands für die Erstellung eines Modells in Anspruch. Mit Automated Analytics kann der dafür benötigte Aufwand deutlich verkürzt werden. Im Folgenden stellen wir Ihnen diese Funktionen vor.

124

4

Erstellung eines

analytischen

Datensatzes

2. Als Nächstes wird ein analytischer Datensatz angelegt, der die eben

erstellte Entität näher beschreibt. Ferner kann eine Entität über mehrere

analytische Datensätze charakterisiert werden (siehe 1:n-Beziehung zwischen der Entität und dem analytischen Datensatz in Abbildung 4.11). Die

Attribute des analytischen Datensatzes können sowohl statisch als auch

zeitabhängig sein.

Define Entity

1.

2.

1

1

n

n

Define

Analytical Record

Set Time-Stamped

Population

1

1

n

3.

4.3 Datenzugriff und -vorbereitung mit

dem Data Manager

Datenzugriff und -vorbereitung mit dem Data Manager

Create

Temporal Data Set

Abbildung 4.11 Die Methodik des analytischen Datensatzes

Definition der Zielvariablen

Definieren Sie keine Zielvariable im analytischen Datensatz. Diese wird im

Zeitstempel definiert.

Ein Zeitstempel kann sowohl einen dynamischen Filter enthalten als auch

einen aktuellen Zeitstempel (KxTimeStamp), der erstellt wird, wenn Sie

einen Snapshot von der Population machen.

125

4

Mit dem Modus »Automated Analytics« arbeiten

3. Im letzten Schritt wird das Produkt aus dem analytischen Datensatz und

der Population mit dem Zeitstempel erstellt. Dieses Produkt wird als

temporaler analytischer Datensatz bezeichnet.

Die erstellten Objekte können Sie so als Datenquelle für die weiterführende

Analyse verwenden (siehe Abbildung 4.12).

4.4

Klassifikations-/Regressionsanalyse

쐍 Außerdem können mit Neue Bedingung dynamische Filterung und Vari-

ablenbelegung angelegt werden.

쐍 Über Neue Lookup-Tabelle können für einzelne Variablen einer Tabelle

Abfragen definiert und dahin gehend manipuliert werden. Beispielsweise kann so die Variable Bewertung mit den Ausprägungen gut, durchschnittlich, schlecht als numerisch geordnete Größe festlegt werden

(gut: 1, durchschnittlich: 2, schlecht: 3),

4

쐍 Die Option Neue Normalisierung wird auf eine stetige Variable angewen-

det, um die zugrunde liegende Ausprägung zu normalisieren (im Bereich

0 und 1 normieren).

쐍 Mittels Neuer SQL-Ausdruck kann der Datensatz anhand von SQL-

Abfragen beliebig transformiert werden.

Abbildung 4.12 Auswahl einer Datenquelle im Data Manager

4.3.2 Datenmanipulation mit dem Data Manager

Der Data Manager bietet außerdem weitere Möglichkeiten zur Datenmanipulation. Hierbei muss eine neue Datenmanipulation angelegt und die

zugrunde liegende Tabelle ausgewählt werden. Ist dies erfolgt, gelangen Sie

in den Editor für Datenmanipulation (siehe Abbildung 4.13). Folgende Funktionen können durch Anlegen eines neuen Ausdrucks verwendet werden:

쐍 Der Ausdruckseditor bietet eine breite Palette an Funktionen, um Varia-

blen zu manipulieren. Diese umfasst arithmetische, boolesche, Datums-,

Konvertierungs-, Zeichen-, Zeichenfolgen- und sonstige Operatoren.

쐍 Über Neues Aggregat kann eine weitere Tabelle mit der bestehenden

zusammengeführt werden. Die Schlüssel beider Tabellen für die Zusammenführung und die Art der Aggregation der jeweiligen Kennzahlen

(Durchschnitte, Summen, Aufzählungen, Minimum und Maximum etc.)

müssen hier angegeben werden. Im Register Periodeneinstellungen können Start- und Enddatum festlegt werden. Im Register Filter und Pivoteinstellungen können zusätzliche Filter festgelegt oder für jeden

ausgewählten Wert eine Variable anlegt werden.

126

Abbildung 4.13 Datenmanipulation mit dem Data Manager

4.4 Klassifikations-/Regressionsanalyse

Klassifikations- und Regressionsanalysen sind zwei der bekanntesten DataMining-Verfahren und gehören zu den Stärken von Automated Analytics.

Beim Data Mining sind die Klassifikations- und Regressionsanalyse

127

4

Mit dem Modus »Automated Analytics« arbeiten

4.4

Klassifikations-/Regressionsanalyse

getrennt zu betrachten. Für jede dieser Analysen gibt es eigene Algorithmen. Im Modus Automated Analytics stehen jedoch beide Analysetypen

unter einem Menüpunkt, da der Modellansatz der Ridge Regression (siehe

Abschnitt 1.4.1, »Regressionsanalyse«) und die zugrunde liegende Engine

für diese Analysen die gleichen sind.

Differenzierung

der Analysen

4

Die Differenzierung erfolgt bei der Wahl einer Zielvariablen. Ist die Zielvariable stetig, wird eine Regression durchgeführt. Bestimmt der Nutzer eine

binäre Zielvariable, erfolgt eine Klassifikation.

Mehrere Zielvariablen

Automated Analytics ist in der Lage, eine Regressions- und eine Klassifikationsanalyse gleichzeitig durchzuführen. Der Anwender muss hierbei zwei

Zielvariablen mit unterschiedlichen Wertetypen festlegen. Beispielsweise

können die Zielvariable Kredit aufnehmen (1 für ja und 0 für nein) und die

Zielvariable Insolvent (mit einer Wahrscheinlichkeit von 0 bis 1) angenommen werden. In diesem Fall werden für beide Variablen im Modus Automated Analytics zwei Modelle generiert: eines für die Regression und ein

weiteres für die Klassifikation. Es können darüber hinaus mehrere Zielvariablen vom gleichen Wertetyp ausgewählt werden.

Analyse binärer

Klassifikationen

Die Klassifikationsanalyse im Modus Automated Analytics ist eine binäre

Klassifikation. Das heißt, dass das erstellte Modell über Automated Analytics nur zwischen zwei Klassen unterscheiden kann. Die Klassifizierung in

drei, vier oder mehr Klassen wird hierbei nicht unterstützt. Die Zielvariable

kann sowohl binäre Zahlen (0 oder 1) als auch andere Werte wie Yes/No

oder True/False enthalten.

Mit der Regressionsanalyse in Automated Analytics kann eine abhängige

Variable (z. B. Sales) mithilfe von unabhängigen (erklärenden) Variablen

bestimmt werden.

Abbildung 4.14 Klassifikations-/Regressionsanalyse: Auswahl der Datenquelle

Sie haben die Möglichkeit, eine lokale Datei, eine Datenbanktabelle oder

einen bereits angelegten, analytischen Datensatz aus dem Data Manager

als Datenquelle für die Analyse zu verwenden 1. Bei der ersten Option können Sie folgende Datentypen auswählen 2:

Unterstützte

Dateiformate

쐍 Textdateien: .dat, .data, .csv und .txt

쐍 Datenbank: Verbindung zu HANA und anderen ODBC-Datenquellen,

die auf Ihrem Rechner angelegt sind

4.4.1 Datenquelle auswählen

Für die Erstellung eines Klassifikations- und/oder Regressionsmodells wählen Sie in der Startoberfläche von Predictive Analytics Modeler 폷 Klassifikations-/Regressionsmodell anlegen. Im darauffolgenden Fenster Datenquelle auswählen (siehe Abbildung 4.14) können Sie die Trainingsdaten für

Ihre Analyse bestimmen.

쐍 Flat Memory: das Laden der Datei aus dem aktiven Speicher

쐍 SAS-Dateien: aus bestimmter Version und unterstützendem

System (SAS-Dateien v6 oder v7/8/9, Win oder Unix) oder

SAS-Transportdateien (.xpt)

쐍 SPSS-Dateien: .sav

쐍 Excel: Arbeitsmappen der Version 97-2003 (.xls) oder 2007 (.xlsx)

Nachdem Sie einen Datentyp ausgewählt haben, setzen Sie den Vorgang

mit der Wahl des Ordners und der Quelldatei fort (3 und 4).

128

129

4

Mit dem Modus »Automated Analytics« arbeiten

Beispieldateien

Mit der Installation von SAP Predictive Analytics werden Beispieldaten

(Samples) bereitgestellt, die im Modus Automated Analytics direkt verwendet werden können und Ihnen den Einstieg erleichtern. Diese finden

Sie unter Datei oder Datenbanktabelle verwenden 폷 Datentyp 폷 Textdateien 폷 Ordner 폷 Durchsuchen und dort im Ordner ../../../Samples (siehe 4

in Abbildung 4.14). Vielen Samples ist eine entsprechende Datei zur

Beschreibung ihrer einzelnen Variablen beigelegt. Die Daten liegen bereits

in der Struktur/Form vor, die insbesondere für Zeitreihenanalysen oder

Analysen sozialer Netzwerke benötigt wird. Der erste Buchstabe K im

Datennamen stammt ursprünglich von der Firma KXEN und wurde beibehalten. Um sich mit Automated Analytics vertraut zu machen, empfehlen

wir, für den Anfang die folgenden Daten zu verwenden:

4.4

Klassifikations-/Regressionsanalyse

Wenn die Datenquelle ausgewählt wurde, kann die Beispieldatenansicht in

Automated Analytics mit dem Icon

angesehen werden (siehe 6 in Abbildung 4.14). Es öffnet sich das Fenster Beispieldatenansicht. Innerhalb dieses

Fensters können drei verschiedene Reiter ausgewählt werden: Daten, Statistik und Graph.

Beispieldatenansicht öffnen

4

Im Register Daten werden die Variablen und die Daten in dem vom Benutzer definiertem Bereich (erster Zellindex und letzter Zellindex definieren

und auf den Button

klicken) angezeigt. Die Daten können auch in zwei

vertikalen ( ) oder horizontalen ( ) Fenstern gleichzeitig abgebildet

werden (siehe Abbildung 4.15).

쐍 Census: Klassifikations- und Regressionsanalyse

쐍 GeoLoc: Analyse der häufigen Pfade, Kollokationsanalyse

쐍 JapaneseData: Assoziationsanalyse (Association Rules = AR),

Recommendation

쐍 KAR: Assoziationsanalyse (AR)

쐍 KelData: Klassifikations- und Regressionsanalyse

쐍 KSN: Analyse sozialer Netzwerke (Social Network = SN)

쐍 KTC: Textanalyse

쐍 KTS: Zeitreihenanalyse (Time Series = TS)

Census-Datei

In diesem Abschnitt werden die Beispieldaten in der Datei Census01.csv

analysiert. Die Census-Datei enthält die Daten von 48.842 Kunden aus den

Vereinigten Staaten von Amerika, die mindestens 17 Jahre alt sind. Jeder

einzelne Kunde wird anhand von 15 Variablen beschrieben: age, workclass,

fnlwgt (gewichtete Variable), education und education-num, marital-status,

occupation, relationship, race, sex, capital-gain, capital-los, native country und class. Die Zielvariable class beinhaltet die Werte 0 oder 1, wobei 1

für Personen steht, die ein Jahresgehalt von mindestens 50.000 US$ beziehen, und 0 für Personen, deren Gehalt unter 50.000 US$ liegt. Unser Ziel ist

es, anhand von 15 Attributen vorherzusagen, ob eine Person mehr als

50.000 US$ verdient und somit zur Klasse 1 gehört oder nicht.

Abbildung 4.15 Klassifikations-/Regressionsanalyse: Beispieldatenansicht

Im Register Statistik können Sie die deskriptive Statistik für die gesamten

Daten oder einen Teil davon ansehen. Dazu gehören:

Deskriptive Statistik

쐍 die Zeilenanzahl in der Quelldatei

쐍 von Automated Analytics geschätzter Wert jeder Variablen

130

Bedeutung der Zielvariablen »Class«

쐍 von Automated Analytics geschätzter Speichertyp jeder Variablen

Für das Beispiel in diesem Kapitel wurde die ursprüngliche Bedeutung der

Zielvariablen Class geändert. Hier meinen wir mit der Ausprägung 1, dass

der Kunde das Produkt einer Bank gekauft hat. Die Ausprägung 0 gibt Personen an, die das Produktangebot einer Bank abgelehnt haben.

쐍 die Anzahl der fehlenden Werte (in diesem Fall nur leere Werte)

쐍 die Häufigkeit der Kategorie für jede Variable

131

4

Mit dem Modus »Automated Analytics« arbeiten

4.4

쐍 nur für die stetigen Variablen die wichtigsten statistischen Parameter

(sowie Min, Max, Mittelwert und Standardabweichung)

Über die Schalfläche kann die webbasierte Form des Berichts nach Excel

transportiert werden. Neben der tabellarischen Form gelangen Sie über den

Reiter Graph zu der grafischen Darstellung. Die x- und y-Achsen müssen

hier definiert werden. Anschließend wird der Graph über Graph anzeigen

dargestellt. Diese Funktion ist besonders bei der Zeitreihenanalyse sehr

hilfreich.

Sollte bei der Datenvorschau die Kopfzeile(-n) oder die grundlegende

Datenformatierung nicht wie gewünscht angezeigt werden, können Sie

weitere Anpassungen mit der Funktion

vornehmen (siehe 5 in Abbildung 4.14). Hier stehen die Einstellungen für Teilstichprobe, Datei oder

Kopfzeile zur Auswahl. In dem Abschnitt Teilstichprobe können Sie die

erste und die letzte Zeile für Ihre Stichprobe auswählen (um den gesamten

Datensatz auf eine Teilmenge einzuschränken), die Zufallsauswahl aktivieren, den zufälligen Initialwert sowie den prozentualen Anteil definieren. Im

Abschnitt Dateieinstellungen können Sie die Trennzeichen (Tabulator,

Komma, Semikolon, Leerzeichen etc.) für Ihre Textdatei festlegen, das

Datumsformat und -trennzeichen anpassen (Jahr/Monat/Tag oder

Tag.Monat.Jahr), das Erzwingen der Codierung aktivieren (UTF-8, UTF-16,

systemeigen oder Latin-1) und das Winkelformat für geografische Daten

auswählen. Automated Analytics unterstützt die Winkelformate aus

Tabelle 4.1 für die Breiten- und Längengrade.

Winkelformat

Winkelformat

Format

Grad dezimal

[–+]ddd,ddddd

Beispiel

+32,30642

–122,61458

Grad Minuten dezimal

Grad 100 Minuten dezimal (NMEA)

[–+]ddd° mm,mmmm'

[SNWE]

[–+]dddmm,mmm

+32° 18,385'

–122° 36,875'

+3218,3852

Klassifikations-/Regressionsanalyse

Wählen Sie Unterteilungsstrategie (siehe 7 in Abbildung 4.14), um die entsprechende Unterteilungsstrategie festzulegen. In unserem Beispiel wird

die Standardeinstellung zufällig ohne Test ausgewählt.

Über die Auswahl Metadaten (siehe 8 in Abbildung 4.14) können Einstellungen zum Metadaten-Repository vorgenommen werden. Die gleichen

Optionen finden Sie auch unter Datei 폷 Einstellungen… 폷 Metadaten-Repository. Damit wird der Pfad der Metadaten festgelegt. Mehr darüber lesen Sie

in Abschnitt 4.4.10, »Modellverwendung: Sichern/exportieren«.

4

Schritt zurückgehen oder Modellaufbauprozess abbrechen?

Bitte beachten Sie, dass Sie mit Klick auf den Button Abbrechen den

gesamten Modellaufbauprozess beenden und zur Startseite des Tools weitergeleitet werden. Wollen Sie einen Schritt zurückgehen, nutzen Sie bitte

den Button Zurück. Sie können auch die automatische Sicherung des

Modells aktivieren (siehe dazu Abschnitt 4.4.5, »Zusammenfassung der

Modellierungsparameter«). Dadurch wird das Modell in jedem Schritt

automatisch gespeichert.

Klicken Sie nach der Datenquellenauswahl auf den Button Weiter (siehe 9

in Abbildung 4.14) zur Fortsetzung der Modellerstellung.

4.4.2 Datenbeschreibung

Im nächsten Schritt des Modellaufbaus Datenbeschreibung (siehe Abbildung 4.16) werden Sie die Variablen (Spalten) aus der Datenquelle beschreiben, insbesondere die Einstellungen zu Speicherformat, Typ, Struktur etc.

Klicken Sie zur Datenbeschreibung entweder auf den Button Analysieren 1,

oder öffnen Sie eine bereits vorhandene Beschreibung 2.

Ist eine Datei zur Beschreibung der Daten vorhanden, so können Sie über

den Button Analysieren die Daten analysieren und sich eine vorgeschlagene Beschreibung geben lassen.

–12236,8748

Grad Minuten Sekunden

[–+]ddd° mm' ss,ss"

+32° 18' 23,1"

–122° 36' 52,5"

Tabelle 4.1 Einstellungen für die Winkelformate

Vorgeschlagene Beschreibungen

Beachten Sie, dass die von Automated Analytics vorgeschlagenen

Beschreibungen unter Umständen den fachlichen Anforderungen der

jeweiligen Variablen angepasst werden müssen (z. B. Prüfung auf fehlende

Werte und Werttypen).

Unter Kopfzeile wird festlegt, ob die Quelldatei eine Kopfzeile enthält und

wie viele oberste Zeilen als Kopfzeilen dienen sollen.

132

133

4

Mit dem Modus »Automated Analytics« arbeiten

4.4

Klassifikations-/Regressionsanalyse

4

Abbildung 4.17 Klassifikations-/Regressionsanalyse: Struktur der

Beschreibungsdatei

Zu der Datenbeschreibung gehören:

쐍 Index: Nummerierung der Variablen. Die Nummer wird automatisch

vergeben, eine Anpassung durch den Nutzer ist nicht möglich.

Abbildung 4.16 Klassifikations-/Regressionsanalyse: Datenbeschreibung

쐍 Name: Name der Variablen. Der Name wird automatisch aus den Quell-

daten gelesen, kann aber nur in der Datenquelle angepasst werden.

Die Datei zur Beschreibung des Datensatzes beinhaltet die Information zu

Rank, Name, Storage, Value, KeyLevel, OrderLevel, MissingString, Group und

Description der einzelnen Variablen (siehe Abbildung 4.17).

Datenbeschreibungen laden

134

In diesem Bespiel laden wir die Beschreibungen aus der Beispieldatei Desc_

Census01.csv. Wenn Sie den Button Beschreibung öffnen (siehe 2 in Abbildung 4.16) anklicken, können Sie den Pfad zu der Beschreibungsdatei

bestimmen und mit OK bestätigen. Die vordefinierte Datenbeschreibung

wird in der Toolansicht entsprechend Ihrer Beschreibungsdatei angezeigt.

Neben der Beschreibung der gesamten Datenquelle können Sie auch einzelne Beschreibungen zu Variablen korrigieren und speichern. Dafür markieren Sie eine Variable und klicken den Button Im Variablenpool sichern

an (siehe 3 in Abbildung 4.16).

쐍 Speicher: Art der in dieser Variablen gesicherten Werte (siehe 4 in Abbil-

dung 4.16). Mögliche Ausprägungen:

– number: stetige Zahlen (Kontonummer, Kunden-ID oder

Telefonnummern sollten nicht als Zahl angelegt werden.)

– integer: Ganzzahlen

– string: Zeichenfolgen

– DateTime: Datum und Zeitstempel

– Datum: Datumsangaben

쐍 Wert: Art des Wertes (siehe 5 in Abbildung 4.16).

Mögliche Ausprägungen:

– continuous: reale Zahlen mit beliebigem Wert (auch mit Bruchteilen

und Nachkommastellen, wie z. B. Bankkontostand, Geburtsdatum

und anderen Werten)

135

4

Mit dem Modus »Automated Analytics« arbeiten

4.4

Klassifikations-/Regressionsanalyse

– nominal: diskrete und nicht georderte Werte, wie z. B. Autofarbe

(Blau, Silber, Schwarz) oder Postleitzahl

– ordinal: diskrete numerische Variable, bei der die relative

Reihenfolge wichtig ist

4

– textual: textuelle Variable, die Phrasen, Sätze oder vollständige

Texte enthält

쐍 Schlüssel: Schlüsselvariable oder Identifikation für den Datensatz.

Mögliche Ausprägungen:

– 1: primärer Schlüssel (Bei der Klassifikations-/Regressionsanalyse ist

der Schlüssel automatisch die erstellte Variable KxIndex.)

– 2: sekundärer Schlüssel

– 0: Variable ist kein Schlüssel.

쐍 Reihenfolge: Gibt an, ob eine Variable bereits vorsortiert ist (siehe 6 in

Abbildung 4.16). Mögliche Ausprägungen:

– 1: Variable stellt eine natürliche Reihenfolge dar (sehr wichtig bei

Datumsvariablen der Zeitreihenanalyse). Das heißt, dass die Daten in

dem Datensatz bereits vorsortiert sind, ausgehend vom Variablenwert.

– 0: Variable stellt keine natürliche Reihenfolge dar.

쐍 Fehlt: Zeichenfolge, mit der in der Datenbeschreibungsdatei fehlende

Werte dargestellt werden (siehe 7 in Abbildung 4.16). Die Ausprägungen

legt der Nutzer selber an, wie z. B. 99999, ?, # oder leer.

쐍 Gruppe: Name der Gruppe, zu der die Variable gehört. Jede Variable kann

maximal einer Gruppe zugeordnet werden. Alle Variablen derselben

Gruppe enthalten dieselben Informationen. Daher erfolgt keine Kreuztabellierung der Gruppen, wenn das Modell eine Reihenfolge mit einer

Komplexität über 1 aufweist.

쐍 Beschreibung: ein optionaler Kommentar zu der Variablen

Mehrere Variablen

markieren

136

Sollen die Beschreibungen mehrerer Variablen angepasst werden, so können Sie diese Variablen mithilfe der gedrückten Tasten (Strg) oder (ª) auswählen, das Kontextmenü per Rechtsklick aufrufen und die Beschreibung

der Variablen anpassen. Die gleichen Optionen finden Sie ebenfalls im

Register Bearbeitung (siehe 1 in Abbildung 4.18).

Abbildung 4.18 Klassifikations-/Regressionsanalyse: Datenbeschreibung

Sie können zu einer Variablen auch eine Struktur anlegen (siehe 8 in Abbildung 4.16). Diese Option ist nützlich, wenn Sie z. B. die Variable Land codieren möchte. Mit einer Struktur können Sie Länder den Kontinenten oder

länderspezifischen Märkten zuordnen, so wird z. B. die Variable Land mit

dieser Struktur entschlüsselt.

Struktur anlegen

Sollen die Kategorien der Variablen in verschiedene Sprachen übersetzt

werden, so können Sie im Register Bearbeitung den Button Kategorien

übersetzen (siehe 3 in Abbildung 4.18) anklicken und die Übersetzungen in

den entsprechenden Sprachen anlegen und abspeichern. Sie müssen dann

für jede neue Kategorie der Variablen einen dazugehörigen Text in der entsprechenden Sprache eintragen.

Über den Button Zusammengesetzte Variablen (siehe 4 in Abbildung 4.18)

können die zusammengehörigen Variablen wie z. B. bei Längen- und Breitengraden vereinigt werden. Im Kontextmenü können Sie die natürliche

Codierung einer Variablen erlauben oder untersagen (siehe Abbildung

4.19). Mehr zur Codierung der Variablen finden Sie in Abschnitt 4.2, »Datencodierung«.

137

4

Mit dem Modus »Automated Analytics« arbeiten

4.4

Klassifikations-/Regressionsanalyse

4

Abbildung 4.20 Klassifikations-/Regressionsanalyse: Filter in Datensatz

hinzufügen

Umgang mit Filtern

Abbildung 4.19 Klassifikations-/Regressionsanalyse: Datenbeschreibung –

Codierung ändern

4.4.3 Filter

In Automated Analytics können Sie beim Erstellen des Modells einen Filter

für Ihre Datenquelle anlegen. Setzen Sie dafür ein Häkchen bei Filter in

Datenset hinzufügen (siehe 9 in Abbildung 4.16) unter Datenbeschreibung,

und klicken Sie auf den Button Weiter. Nach erfolgreicher Ausführung werden Sie automatisch zum Fenster Filter im Datenset hinzufügen weitergeleitet (siehe Abbildung 4.20). Wenn das Häkchen nicht gesetzt wird,

gelangen Sie zum Schritt Auswahl von Variablen (siehe Abschnitt 4.4.4).

Um einen Filter anzulegen, klicken Sie auf Bedingung hinzufügen, und wählen Sie dann im Dialogfenster Bedingung definieren eine Variable, einen

Operator und einen Wert aus. Sie können mehrere Filter mit einer Und-/

Oder-Logik für mehrere Variablen verknüpfen. Wenn Sie eine bereits

erstellte Bedingung auswählen, können Sie mit dem Klick auf die Reihenfolge in der Filterliste anpassen.

138

Wenn Sie in diesem Schritt einen Filter setzen, wird er nur für diese Analyse relevant sein. Wenn Sie initial gefilterte Daten als Grundlage für alle

Analysen erstellen möchten, ist der Data Manager besser geeignet. Sie

können einen Filter auch speichern (Funktionen Filter sichern und Vorhandenen Filter laden in Abbildung 4.20) und für eine andere Analyse laden.

4.4.4 Auswahl von Variablen

In Automated Analytics können Sie bei der Erstellung einer Klassifikations-/

Regressionsanalyse die Variablen aus Ihren Daten in vier Typen unterteilen

(siehe Abbildung 4.21):

1. Zielvariablen: Es muss mindestens eine Variable als Zielvariable deklariert werden. Bei der Auswahl der Zielvariablen entscheiden Sie, ob ein

Klassifikations- oder Regressionsmodell erstellt wird. Ist Ihre Zielvariable stetig, wird Automated Analytics ein Regressionsmodell erstellen.

Enthält Ihre Zielvariable binäre Werte (0/1, Yes/No, True/False, Won/Lost),

wird eine Klassifikationsanalyse erstellt.

139

4

Mit dem Modus »Automated Analytics« arbeiten

4.4

Klassifikations-/Regressionsanalyse

4. Gewichtungsvariable: Automated Analytics bietet die Möglichkeit, eine

Gewichtungsvariable zu deklarieren (z. B. Variable fnlwgt). In diesem Fall

wird allen Zeilen eine relative Gewichtung zugeordnet. Die Angabe einer

solchen Variablen ist optional.

Unter Auswahl von Variablen können Sie diese als Variablenliste sichern.

Dies kann besonders nützlich sein, wenn das Modell besonders viele Variablen berücksichtigt und Sie die Variablendeklarierung vereinfachen möchten. Wenn Sie beispielsweise Ihre ausgeschlossenen Variablen definiert

haben, klicken Sie auf den Button

unterhalb des Bereichs Ausgeschlossene Variablen und vergeben einen beliebigen Namen für Ihre Datei.

4

Variablenliste

Fehlerhinweis

Neue Dateien können nicht im Ordner ../../../Samples/Census erstellt werden. Die Variablenliste muss z. B. lokal in einem anderen Ordner hinterlegt

werden.

Abbildung 4.21 Klassifikations-/Regressionsanalyse: Auswahl von Variablen

Mehrere Zielvariablen

Im Modul Automated Analytics ist es möglich, mehrere Zielvariablen zu

deklarieren. Diese können sowohl vom gleichen Typ sein (dann werden

mehrere Klassifikations- oder Regressionsmodelle erstellt) als auch von

unterschiedlichen Typen (in diesem Fall erfolgt die Regressions- und Klassifikationsanalyse gleichzeitig).

Falls beim Ladevorgang in der Variablenliste der erklärenden Variablen und

der Liste der auszuschließenden Variablen identische Variablen vorgefunden werden, so wird die Variable der zuletzt geladenen Liste übernommen

und in der vorigen ausgeschlossen. Zum Beispiel sehen Sie in Abbildung 4.22

die Variable workclass, die doppelt vorkommt. Sie wird dann in dem Bereich

deklariert, in dem die Variablenliste zuletzt geladen wurde. Haben Sie zuerst

die Liste mit ausgeschlossenen Variablen geladen (siehe 2 in Abbildung 4.21)

und anschließend die Liste mit erklärenden Variablen (siehe 1 in Abbildung

4.21), so wird die Variable workclass als erklärende deklariert.

2. Ausgeschlossene Variablen: Die vom Modul Automated Analytics

erstellte KxIndex-Variable wird automatisch den ausgeschlossenen Variablen zugeordnet. Variablen, die sehr stark miteinander korrelieren, sollten ausgeschlossen werden (wie z. B. Kundennummer, Kunden-ID,

Kundentelefonnummer etc.). Auf die gleiche Weise können entdeckte

Leakers verworfen werden (mehr über Leakers erfahren Sie in Abschnitt

4.4.8, »Modellverwendung: Anzeigen«).

3. Erklärende Variablen: Zu den erklärenden Variablen gehören alle Variablen, die nicht ausgeschlossen und nicht als Zielvariablen definiert wurden. Sie werden zur Berechnung des Modells verwendet.

Abbildung 4.22 Erklärende und ausgeschlossene Variablen

140

141

4

Mit dem Modus »Automated Analytics« arbeiten

4.4

Klassifikations-/Regressionsanalyse

Die Kopfzeilen der Variablenlisten werden ignoriert, somit können Sie die

Datei ExcludedVariables.txt in den Bereich Ausgewählte erklärende Variablen laden.

4

Variablenlisten nur für erklärende und ausgeschlossene Variablen

Eine Variablenliste kann entweder für erklärende oder für ausgeschlossene Variablen erstellt werden. Zielvariablen und Gewichtungsvariable

müssen dennoch immer geprüft und bei Bedarf manuell anpasst werden.

Mit einem Häkchen vor Alphabetische Sortierung können die Variablen

entsprechend sortiert werden (siehe 3 in Abbildung 4.21). Insbesondere bei

vielen Variablen ist eine Sortierung für eine bessere Übersicht sinnvoll.

Wenn Sie alle Variablen wie gewünscht deklariert haben, können Sie mit

dem nächsten Schritt der Modellerstellung fortfahren, indem Sie auf Weiter klicken.

Beispiel

In unserem Beispiel sind die Variablen wie in Abbildung 4.21 zu definieren.

Abbildung 4.23 Zusammenfassung der Modellierungsparameter

4.4.5 Zusammenfassung der Modellierungsparameter

Einstellungen

prüfen

In der Oberfläche Zusammenfassung der Modellierungsparameter (siehe

Abbildung 4.23) können die bisherigen Einstellungen zur Modellerstellung

nochmals geprüft werden, wie etwa die Quelldatei, die Art der Unterteilungsstrategie und die Setzung der Ziel- und Gewichtungsvariablen 1.

Wenn alles korrekt ist und keine Anpassungen mehr vorgenommen werden müssen, prüfen Sie bitte den Modellnamen. Der Name des Modells

wird nach dem Muster <Analysename>_<Quelldateiname> automatisch vergeben 2. Bei der Erstellung von mehreren Modellen bietet sich die Vergabe

einer sprechenden Beschreibung an. So können Sie später besser nachvollziehen, welches Modell für welches Ziel und mit welchen Parametern

erstellt wurde.

Hier kann auch festgelegt werden, ob Automated Analytics einen Entscheidungsbaum als Ergebnisdarstellung erstellen soll 3 oder ob eine automatische Auswahl aktiviert werden soll 4. Das Feld Automatische Auswahl

aktivieren ist standardmäßig aktiviert. Diese Funktion reduziert automatisch die Anzahl der Variablen im Modell entsprechend bestimmter Qualitätskriterien (KI und KR).

142

Mit der Einstellung Automatisch sichern 5 können Sie sicherstellen, dass

das Modell am Ende des Lernprozesses gespeichert wird, auch wenn Sie in

den darauffolgenden Schritten versehentlich den gesamten Prozess abbrechen. Bei der Aktivierung der automatischen Sicherung wird auf dem Button Automatisch sichern ein grünes Häkchen angezeigt, und nach dem

Trainieren des Modells erhalten Sie eine Informationsmeldung, dass Ihr

Modell gespeichert wurde.

Modell automatisch

sichern

Der Button 6 öffnet den Bereich, in dem Sie ein KxShell-Skript generieren

können, das das aktuelle Modell reproduziert. Klicken Sie auf den Button 7,

wenn Sie weitere Einstellungen vornehmen möchten. Die erweiterten Einstellungen werden in Abschnitt 4.4.6, »Erweiterte Modellparameter«,

behandelt. Diese Anpassungen sind optional. Sie können die Generierung

des Modells jetzt starten 8.

4.4.6 Erweiterte Modellparameter

Per Klick auf den Button Erweitert (siehe 7 in Abbildung 4.23) können Sie

die folgenden Einstellungen anpassen.

143

2

Einleitung

Liebe Leserin, lieber Leser,

die Möglichkeit, in die Zukunft zu schauen und Vorhersagen oder Prognosen zu treffen, ist für uns alle sehr faszinierend wie auch ein wichtiger Teil

für die eigene Planung. So ist es uns wichtig, das morgige Wetter zu kennen,

um die richtige Kleidung zu wählen. Ebenso sind wir daran interessiert, den

am Wochenende zu erwartenden Autoverkehr gut einschätzen zu können

und somit einer möglichen Staugefahr zu entgehen. Diese Beispiele zeigen,

dass es sich lohnt, zukünftige Ereignisse gut einschätzen zu können, um

somit die eigene Planung zu optimieren. Und dies gilt nicht nur für uns als

Privatpersonen, sondern insbesondere für staatliche und betriebswirtschaftliche Organisationen. Gerade für Unternehmen ist es wirtschaftlich

sehr entscheidend, Nachfrage- und Preisentwicklungen, Zahlungs- und

Logistikströme oder auch Maschinenverschleiß und Materialverbrauch

vorhersagen zu können und darauf optimal zu reagieren.

Dem Informationsbedarf steht im Zeitalter der fortschreitenden Digitalisierung eine zunehmend hohe Datenverfügbarkeit gegenüber. Je mehr

Daten über Kunden, Märkte und eigene Prozesse zur Verfügung stehen,

desto besser lassen sich Prognosen über künftige Entwicklungen treffen.

Und so entstehen in vielen Unternehmen riesige Datenmengen, wenn

nicht sogar »Datenberge«, die mit aufwendigen Business-Intelligence(BI-)Systemen verwaltet werden. Die Weiterentwicklung von BI-Systemen

sind Big-Data-Technologien, die es ermöglichen, Hochfrequenz- (engl. High

Frequency Data) oder gar Echtzeitdaten (engl. Realtime Data) zu verwalten

und für Analysen bereitzustellen. Mit diesen Technologien ist es unter

anderem möglich, Sensordaten zu verarbeiten, das Klickverhalten von

Kunden eines Onlineshops zu analysieren oder unstrukturierte Daten wie

Texte, Bilder oder Webinhalte nach versteckten Informationen zu durchleuchten.

Für Vorhersagen oder Optimierungen genügt es allerdings nicht, Daten

lediglich zu sammeln und zu verwalten, sondern dazu bedarf es Algorithmen und Heuristiken, um aus dem Datenbestand wertvolle Informationen

abzuleiten. Auch die angewandte Mathematik und Statistik entwickeln sich

rasant weiter. So werden in der Forschung gängige statistische Methoden,

wie z. B. die Regressions- und Zeitreihenanalyse, unablässig weiterentwickelt und optimiert. Darüber hinaus bieten verschiedene Technologien

und Software eine einfache Handhabung der unterschiedlichen Algorithmen. Insbesondere die statistische Open-Source-Programmiersprache R

15

Einleitung

Einleitung

spielt eine zunehmend wichtige Rolle für Wissenschaft und Wirtschaft.

Neue statistische Verfahren aus der Wissenschaft sind hier schnell für alle

Nutzer verfügbar und einfach anzuwenden. Aus dieser Zusammenführung

von Methodik und Technologien entwickelten sich optimierende Verfahren wie das maschinelle Lernen (engl. Machine Learning), bei dem ein statistisches Modell computergestützt fortlaufend mit neuen Daten trainiert

wird, um das Modell somit permanent zu verbessern. Dies ermöglicht es,

verlässliche Prognosen zu berechnen und somit den wachsenden Informationsbedarf der Unternehmen zu decken.

In diesem Buch werden wir Ihnen zeigen, wie Sie dieses Zusammenspiel

von Methodik, Daten und Technologie in einer SAP-Systemumgebung

umsetzen. Wir werden Ihnen dabei einen Einstieg in die Anwendung SAP

Predictive Analytics geben und dabei auf verschiedene Ansätze eingehen,

wie Sie mithilfe von SAP Predictive Analytics auch in Ihrem Unternehmen

die richtigen Vorhersagen treffen können.

Für diejenigen Leser, die bereits einen soliden Kenntnisstand in der Anwendung von prädiktiven Analysen besitzen, bietet das Buch einen umfangreichen Überblick der verschiedenen Modi, die Sie gewinnbringend auf

praktische Probleme anwenden können. Zusätzlich werden sie von dem

Hintergrundwissen profitieren, wie z. B. den Unterschieden zwischen überwachtem und unüberwachtem Lernen, das in diesem Buch zur Verfügung

gestellt wird.

Zu beachten ist jedoch, dass sich dieses Buch auf die Anwendung von SAP

Predictive Analytics konzentriert und deshalb kein Lehrbuch zu Data

Mining ersetzt.

Aufbau des Buches

Im Wesentlichen besteht das Buch aus drei übergreifenden Teilen:

쐍 Einführung und theoretische Grundlagen (Kapitel 1–2)

쐍 Arbeiten mit dem Tool SAP Predictive Analytics (Kapitel 3–8)

Erforderliches Vorwissen für das Verständnis des Buches

쐍 Erweiterungen (Kapitel 9–10)

Wie im vorhergehenden Absatz erwähnt, wird das Buch insbesondere darauf eingehen, wie Methodik, Daten und Technologie in SAP Predictive

Analytics verwendet werden. Aus diesem Grund ist es natürlich sehr hilfreich, sowohl über ein hinreichendes Grundwissen in Mathematik und Statistik als auch über technologisches Verständnis zu verfügen.

Wir empfehlen Ihnen, die Kapitel in der angegebenen Reihenfolge zu lesen.

Jedoch können Sie einzelne Bereiche je nach Interessenlage auch separat

durcharbeiten.

Da die Anwendung auf Basis einer SAP-HANA-Datenbank wie auch verschiedener MS-Excel-Dateien veranschaulicht wird, sind Vorkenntnisse zu

Datenbanken (speziell SAP HANA) sowie zum Umgang mit MS Office (insbesondere Excel) durchaus von Vorteil.

Zielgruppen des Buches

In diesem Buch lernen Sie, wie Sie effizient mit SAP Predictive Analytics

arbeiten. Zusätzlich bieten wir Ihnen einen Einstieg in die Themen Data

Mining und Predictive Analytics im Allgemeinen. Es wird also jeder angesprochen, der sich für die Anwendung tief gehender und vorausschauender

Analysen sowie für deren technische Umsetzung interessiert. Dies können

IT-Spezialisten sein, die vorwiegend die technologische Komponente von

Data-Mining-Anwendungen im Blick haben. Aber natürlich empfiehlt sich

das Buch auch für Anwender aus Fachabteilungen, die sich auf substantielle

Analysen spezialisieren.

16

Kapitel 1: Einführung in Predictive Analytics

Das Buch beginnt mit einer allgemeinen Einführung in das Thema Predictive Analytics. Wir vermitteln Ihnen wesentliche theoretische Grundlagen

des Data Minings und definieren die wichtigsten Termini. Hierbei gehen

wir insbesondere auf die Datenvorbereitung und die Auswahl geeigneter

Algorithmen ein. Schließlich wird Predictive Analytics in den Gesamtkontext des Data Minings eingeordnet.

Kapitel 2: Mehrwert durch Predictive Analytics

In Kapitel 2 wollen wir Ihnen den Nutzen des Einsatzes von Predictive Analytics für Ihr Unternehmen aufzeigen. Wir stellen Ihnen dabei konkrete

Anwendungsfälle für den praktischen Einsatz von SAP Predictive Analytics

vor.

Kapitel 3: SAP Predictive Analytics

Kapitel 3 gibt eine allgemeine Einführung in SAP Predictive Analytics.

Dabei ordnen wir das Produkt in das SAP-Produktportfolio ein und geben

Ihnen einen grundsätzlichen Überblick der Architektur sowie eine konkrete Anleitung zum Installationsvorgehen. Das Kapitel schließt mit einem

17

Einleitung

Einleitung

allgemeinen Überblick der Benutzeroberfläche und der verschiedenen Einstellungsmöglichkeiten.

Kapitel 4: Mit dem Modus »Automated Analytics« arbeiten

In Kapitel 4 erhalten Sie eine detaillierte Einführung in den Modus Automated Analytics. Nach einer allgemeinen Einführung werden die Navigationsund Einstellungsmöglichkeiten dieses Modus vorgestellt. Anschließend

lernen Sie verschiedene Datenvorbereitungsmöglichkeiten kennen. Außerdem beschreiben wir, wie Sie die wesentlichen Algorithmen anwenden.

Dabei gehen wir insbesondere auf die Bewertungs- und Interpretationswerkzeuge ein.

Kapitel 5: Mit dem Modus »Expert Analytics« arbeiten

Kapitel 5 beschreibt den zweiten Modus, Expert Analytics. Auch hier geben

wir Ihnen eine kurze Einführung in die Navigations- und Einstellungsmöglichkeiten. Sie erhalten einen umfassenden Einblick in die Möglichkeiten

zur Datenvorbereitung und die Anwendung der wichtigsten Algorithmen.

Da der Umfang des Buches es nicht erlaubt, die Anwendung aller Algorithmen im Detail zu beschreiben, fassen wir weniger bedeutsame Algorithmen in einem weiterführenden Abschnitt »Weitere Algorithmen«

zusammen.

Kapitel 6: Integration von R im Modus »Expert Analytics«

Kapitel 6 bietet einen Exkurs in die R-Programmierung, die Ihnen vielfältige Erweiterungen (Customizing) im Modus Expert Analytics ermöglicht.

Hier zeigen wir Ihnen die Integration in SAP Predictive Analytics anhand

eines Beispiels.

Kapitel 7: Visualisierungen

In Kapitel 7 finden Sie verschiedene Beispiele an Visualisierungsmöglichkeiten, insbesondere für den Modus Expert Analytics. Darüber hinaus stellen wir Ihnen anhand eines konkreten Beispiels die Erweiterungsmöglichkeiten in Expert Analytics vor.

Kapitel 8: Model Management mit der Predictive Factory

In Kapitel 8 erhalten Sie einen allgemeinen Einblick in die aktuellen Erweiterungsmöglichkeiten mit der Predictive Factory. Konkret zeigen wir

Ihnen, wie Sie diese sowohl im Automated als auch im Expert-Modus einsetzen.

Kapitel 9: SAP-HANA-integriertes Data Mining

Wie Sie SAP Predictive Analytics in SAP HANA integrieren, erfahren Sie in

Kapitel 9. Nach einer kurzen Einführung in SAP HANA Native stellen wir

Ihnen die SAP HANA Predictive Analysis Library (PAL), die Automated Predictive Library (APL) und weitere Integrationsszenarien vor.

18

Kapitel 10: Integration von R in SAP HANA

Weitere Erweiterungsmöglichkeiten von SAP Predictive Analytics lernen

Sie in Kapitel 10 kennen. Wir führen Sie dort in die Erstellung und Integration eigener Algorithmen mit der R-Programmiersprache ein.

Kapitel 11: Ausblick und Zusammenfassung

Zum Abschluss wagen wir noch eine Prognose, wie es mit SAP Predictive

Analytics weitergeht.

In Kästen, die mit Hinweis-Symbol gekennzeichnet sind, finden Sie Informationen zu weiterführenden Themen oder wichtigen Inhalten, die Sie

sich merken sollten.

Die mit dem Tipps-Symbol gekennzeichneten Kästen geben Ihnen spezielle

Empfehlungen, die Ihnen die Arbeit erleichtern können.

Kästen mit dem Achtung-Symbol weisen Sie auf mögliche Fehlerquellen

und Probleme hin.

Danksagung

Ohne die Unterstützung unsere Kollegen wie auch Partner hätten wir dieses Buch nicht fertigstellen können. An dieser Stelle möchten wir all jenen

danken, die durch ihr fachliches und persönliches Engagement zum Gelingen dieses Buches beigetragen haben. Ein besonderer Dank geht hier zuallererst an die Geschäftsführung der CONOGY GmbH. Sie hat uns, dem

Autorenteam, den entsprechenden Freiraum zum Schreiben dieses Buches

eingeräumt und uns motivierend unterstützt. Besonderer Dank gilt hier

auch unseren Kolleginnen und Kollegen Andreas Behrendt, Jeannine Fode,

Alexander Kalinin, Philipp Metzger und Lars Valentiner, die mit ihrem tatkräftigen Einsatz maßgeblich zur Fertigstellung dieses Buches beigetragen

haben. Ganz herzlich bedanken wir uns bei Frau Billen und Frau Karrasch

vom Rheinwerk Verlag für die sehr gute und angenehme Zusammenarbeit.

Wir wünschen Ihnen nun viel Spaß bei der Lektüre des Buches und viel

Erfolg beim Anwenden des Gelernten im spannenden Bereich der Predictive Analytics!

Ihr Autorenteam

Nargiz Bakhshaliyeva, Jian Liang Chen, Ulrich Dommer,

Ekaterina Samlenski, Helge Schmedt, Nico Schulze und Robert Wilczek

19

Auf einen Blick

1

Einführung in Predictive Analytics ...................................................

21

2

Mehrwert durch Predictive Analytics .............................................

61

3

SAP Predictive Analytics ......................................................................

77

4

Mit dem Modus »Automated Analytics« arbeiten .................... 113

5

Mit dem Modus »Expert Analytics« arbeiten .............................. 225

6

Integration von R im Modus »Expert Analytics« ........................ 307

7

Visualisierungen ..................................................................................... 325

8

Model Management mit der Predictive Factory ......................... 341

9

SAP-HANA-integriertes Data Mining .............................................. 361

10

Integration von R in SAP HANA ......................................................... 407

11

Zusammenfassung und Ausblick ..................................................... 419

Inhalt

Einleitung ..........................................................................................................................

15

1

Einführung in Predictive Analytics

21

1.1

Grundlagen des Data Minings ..................................................................

21

1.1.1

1.1.2

Der Begriff »Data Mining« und seine Historie ......................

Typische Anwendungsfälle von Data Mining ........................

21

23

Der Data-Mining-Prozess ............................................................................

25

1.2.1

1.2.2

1.2.3

1.2.4

1.2.5

1.2.6

Problemdefinition ...........................................................................

Datenanalyse ....................................................................................

Datenvorbereitung .........................................................................

Modellierung ....................................................................................

Ergebnisvisualisierung und -bewertung .................................

Deployment des Modells ..............................................................

27

28

28

29

30

32

Methoden der Datenvorbereitung .........................................................

32

1.3.1

1.3.2

1.3.3

1.3.4

1.3.5

1.3.6

1.3.7

Variablen ............................................................................................

Deskriptive Statistik .......................................................................

Integration und Transformation ................................................

Sampling ............................................................................................

Ausreißerbehandlung ....................................................................

Binning ................................................................................................

Missing Values .................................................................................

32

33

36

37

38

39

41

Algorithmen und Methoden des Data Minings ................................

42

1.4.1

1.4.2

1.4.3

1.4.4

1.4.5

1.4.6

1.4.7

Regressionsanalyse ........................................................................

Zeitreihenanalyse ...........................................................................

Klassifikations- und Clusterverfahren .....................................

Assoziationsanalyse .......................................................................

Entscheidungsstrukturen .............................................................

Künstliche neuronale Netze ........................................................

Weitere Algorithmen .....................................................................

43

45

47

50

51

53

54

Einordnung von Predictive Analytics in den

Bereich Data Mining .....................................................................................

56

1.5.1

1.5.2

57

57

1.2

1.3

1.4

1.5

Was ist Predictive Analytics? .......................................................

Abgrenzung von Predictive Analytics .......................................

7

Inhalt

Inhalt

2

Mehrwert durch Predictive Analytics

2.1

Warum Predictive Analytics? ...................................................................

61

2.2

Warum Predictive Analytics mit SAP? ..................................................

68

2.3

Anwendungsbeispiele .................................................................................

70

2.3.1

2.3.2

3

3.1

Anwendungsbeispiel 1:

Preiselastizitäten im Einzelhandel ...........................................

Anwendungsbeispiel 2:

Absatzprognosen in der Musikindustrie ................................

SAP Predictive Analytics

4.2

4.3

71

73

4.4

77

Datencodierung ..............................................................................................

118

4.2.1

4.2.2

4.2.3

4.2.4

4.2.5

Codierung nominaler Variablen .................................................

Codierung ordinaler Variablen ...................................................

Codierung stetiger Variablen ......................................................

Manuelle Variablencodierung ....................................................

Behandlung fehlender Werte in Automated Analytics ......

118

120

122

124

124

Datenzugriff und -vorbereitung mit dem Data Manager ............

124

4.3.1

4.3.2

Datenvorbereitung mit dem Data Manager ..........................

Datenmanipulation mit dem Data Manager ........................

125

126

Klassifikations-/Regressionsanalyse .....................................................

127

4.4.1

4.4.2

4.4.3

Datenquelle auswählen ...............................................................

Datenbeschreibung ........................................................................

Filter .....................................................................................................

128

133

138

4.4.4

4.4.5

4.4.6

4.4.7

4.4.8

4.4.9

4.4.10

Auswahl von Variablen .................................................................

Zusammenfassung der Modellierungsparameter ...............

Erweiterte Modellparameter ......................................................

Trainieren des Modells und Modellübersicht ........................

Modellverwendung: Anzeigen ...................................................

Modellverwendung: Ausführen .................................................

Modellverwendung: Sichern/exportieren ..............................

139

142

143

148

151

174

187

Einführung und Einordnung in das SAP-Produktportfolio .........

77

3.1.1

3.1.2

3.1.3

Einführung in SAP Predictive Analytics ...................................

Zielgruppen ......................................................................................

Produktportfolio .............................................................................

77

79

81

Plattformintegration und Architektur .................................................

84

3.2.1

3.2.2

Plattformintegration .....................................................................

Architektur ........................................................................................

84

86

4.5

Zeitreihen ..........................................................................................................

191

Installation .......................................................................................................

88

4.6

Clustering ...........................................................................................................

196

SAP Download Center ...................................................................

Desktop-Installation ......................................................................

Serverinstallation ...........................................................................

Predictive-Factory-Installation ...................................................

Hardwarevoraussetzungen ........................................................

88

90

94

98

101

4.7

Analyse sozialer Netzwerke ......................................................................

200

Weitere Algorithmen und Toolkit ..........................................................

207

3.4

Benutzeroberfläche und Navigation ...................................................

102

3.5

Einstellungen ...................................................................................................

104

4.8.1

4.8.2

4.8.3

4.8.4

4.8.5

4.8.6

4.8.7

207

210

212

214

217

218

223

4

Mit dem Modus »Automated Analytics«

arbeiten

113

Grundlagen ......................................................................................................

113

4.1.1

4.1.2

4.1.3

113

115

117

3.2

3.3

3.3.1

3.3.2

3.3.3

3.3.4

3.3.5

4.1

8

61

Unterteilungsstrategie .................................................................

Modellerstellung und Evaluierung ...........................................

SRM-Grundlagen ............................................................................

4.8

5

Kollokationsanalyse .......................................................................

Analyse der häufigen Pfade .........................................................

Recommendation ............................................................................

Assoziationsanalyse .......................................................................

Sequenzanalyse ...............................................................................

Textanalyse .......................................................................................

Toolkit .................................................................................................

Mit dem Modus »Expert Analytics«

arbeiten

225

5.1

Funktionen von Expert Analytics ............................................................

225

5.2

Navigation und Einstellungen in Expert Analytics .........................

226

9

Inhalt

Inhalt

5.2.1

5.2.2

5.3

5.4

5.5

5.6

10

Einstellungen und Navigation im Tool ....................................

Ansichten in Expert Analytics .....................................................

226

230

Datenvorbereitung .......................................................................................

234

5.3.1

5.3.2

Vorbereitungssicht ........................................................................

Data Type Definition .....................................................................

234

239

5.3.3

5.3.4

5.3.5

5.3.6

5.3.7

5.3.8

5.3.9

5.3.10

Filter ....................................................................................................

Formula ..............................................................................................

Normalization ..................................................................................

Partition .............................................................................................

Sample ...............................................................................................

Model Statistics ..............................................................................

Model Compare ..............................................................................

SAP-HANA-Datenvorbereitungskomponenten ....................

239

241

242

243

243

244

246

248

Assoziationsanalyse .....................................................................................

251

5.4.1

5.4.2

5.4.3

Grundlegende Begriffe .................................................................

R-Apriori .............................................................................................

Anwendungsbeispiele ..................................................................

251

252

257

Clustering und Klassifikation ...................................................................

257

5.5.1

5.5.2

5.5.3

5.5.4

5.5.5

5.5.6

5.5.7

5.5.8

Auto Clustering ...............................................................................

R-K-Means .........................................................................................

SAP-HANA-Clustering-Algorithmen .........................................

Auto Classification .........................................................................

R-Bagging Classification ..............................................................