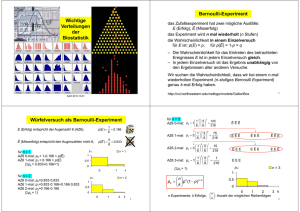

Wichtige Verteilungen der Biostatistik Bernoulli

Werbung

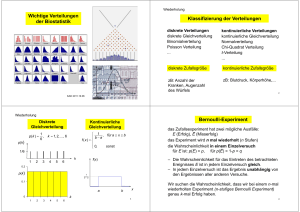

Bernoulli-Experiment Wichtige Verteilungen der Biostatistik das Zufallsexperiment hat zwei mögliche Ausfälle: E (Erfolg), Ē (Misserfolg) das Experiment wird n mal wiederholt (n Stufen) die Wahrscheinlichkeit in einem Einzelversuch für E ist: p(E) = p, für p(Ē) = 1-p = q – Die Wahrscheinlichkeit für das Eintreten des betrachteten Ereignisses E ist in jedem Einzelversuch gleich. – In jedem Einzelversuch ist das Ergebnis unabhängig von den Ergebnissen aller anderen Versuche. Wir suchen die Wahrscheinlichkeit, dass wir bei einem n-mal wiederholten Experiment (n-stufiges Bernoulli Experiment) genau k-mal Erfolg haben. http://ccl.northwestern.edu/netlogo/models/GaltonBox KAD 2016.09.29 für n = 3 0 3 125 1 5 AZ6 0-mal: p0 1 Würfelversuch als Bernoulli-Experiment E (Erfolg) entspricht der Augenzahl 6 (AZ6), 1 p(E ) 0.166 6 Ē (Misserfolg) entspricht den Augenzahlen nicht 6, 5 p(E ) 0.833 6 für n = 1 AZ6 0-mal: p0 = 1-0.166 = p(Ē) AZ6 1-mal: p1 = 0.166 = p(E) (pk = 0.833+0.166=1) pk 1 2 3 0 pk k n pk p k (1 p )n k k n=2 1 0.5 0 0 1 2 k 3 EĒĒ ĒEĒ ĒĒE ĒEE EĒE EEĒ 1 0 1 1 5 AZ6 3-mal: p3 1 216 6 6 (pk = 1) 0.5 ĒĒĒ 2 15 1 5 AZ6 2-mal: p2 3 6 6 216 1 1 216 75 1 5 AZ6 1-mal: p1 3 216 6 6 n=1 0 für n = 2 AZ6 0-mal: p0=0.833·0.833 AZ6 1-mal: p1=0.833·0.166+0.166·0.833 AZ6 2-mal: p2=0.166·0.166 (pk = 1) 6 6 2 EEE pk n=3 1 0.5 0 0 1 2 3 k n n Experimente, k Erfolge, : Anzahl der möglichen Reihenfolgen k 4 1 für n = 7 k 7 1 5 pk k 6 6 p(E ) 7 k 1 0.8 1 6 0.6 0.4 0.2 7 0 0 1 0.8 1 6 7 1 5 p1 0.391 1 6 6 2 5 7 1 5 p2 0.234 2 6 6 3 5 7 1 5 p3 0.078 3 6 6 0.45 0.4 0.35 0.3 0.25 0.2 0.15 0.1 0.05 0 ... n=7 pk 2 2 3 4 5 0.7 0.6 0.5 0.4 0.3 0.2 0.1 0 3 1 2 3 4 5 6 0.4 7 8 0.3 0.1 0 0 1 2 3 0.6 0.5 0.4 0.3 0.2 0.1 0 0 4 1 2 3 4 5 6 7 0.4 8 9 0.3 0.2 0.1 0 1 2 3 4 5 0.4 0.3 0.1 1 2 3 4 5 0 1 2 3 4 5 6 7 8 0.35 0.3 0.25 0.2 0.15 0.1 0.05 0 9 10 6 0 1 2 3 4 5 6 7 8 9 Kombinatorik: Sollen k Objekte in beliebiger Reihenfolge aus n Objekten ausgewählt werden, ergeben sich: pk ist die Wahrscheinlichkeit, dass wir bei einem n-stufigen Bernoulli-Experiment genau k-mal Erfolg haben n n ( n 1) ... ( n k 1) n! 1 2 ... k k! ( n k )! k die Wahrscheinlichkeit dass die ersten k Versuche Erfolg haben und die anderen misserfolglich sind: p(E, E,...E, E , E ,...E ) p(E ) p(E ) ...p(E ) p(E ) p(E ) ...p(E ) p k (1 p )n k Möglichkeiten, wobei n! = 1·2·... ·(n-1)·n. (Kombination aus n Elementen zur Klasse k ohne Wiederholung) zB: n = 3, k = 2 k 7 0.2 0 n-k 6 0.4 0 0 k 5 0.5 1 0.5 Binomialverteilung 4 0 0 0.2 Bernoulli-Experiment 3 0.1 0 5 2 0.2 0.2 6 7 1 0.3 0 0 1 0 0.4 k 0.3 0.1 0 Binomialverteilung 0 6 0.4 0.2 0.6 7 1 5 p0 0.279 0 6 6 0.5 n-k Jede andere Reihenfolge der k Ergebnisse und n-k Gegenergebnisse haben die selbe pk(1-p)n-k Wahrscheinlichkeit. Wieviele mögliche Reihenfolgen gibt es? EEĒ 7 EĒE 3 3! 1 2 3 3 2 2!1! 1 2 1 ĒEE 8 Münzenversuch als Bernoulli-Experiment 1 p(E ) 2 zwei Münzenversuche: E (Erfolg) entspricht Zahl n=2 0.5 n 0.4 0.3 0.2 2 1 1 p0 1 4 2 0.1 Binomialverteilung pk n 1 für p=1/2 vereinfacht sich: pk k 2 1 0 p=1/2, 1- p =1/2, n=2 n pk p k (1 p )n k k 0.6 0.5 0.4 0.3 0.2 0.1 0 0 2 0.6 0.5 0.4 0.3 0.2 0.1 0 2 0 3 0.3 0.2 0.1 0 0.4 2 k 0 9 1 4 IA i iIA 1 4 1 4 1 4 A 0 Wahrscheinlichkeit 3 4 1 4 1 2 3 5 2 3 4 5 6 6 1 2 3 4 5 6 8 9 0 1 2 3 4 5 6 7 0.3 0.25 0.2 0.15 0.1 0.05 0 5 7 7 0.3 0.25 0.2 0.15 0.1 0.05 0 4 4 4 8 8 9 10 10 0 1 2 3 4 5 6 7 8 9 n: Anzahl der Kinder, k: Anzahl der Kinder mit BG0 pk für n = 1 (BG0 0-mal:) p0=0,75=p(Ē) (BG0 1-mal:) p1=0,25=p(E) (pk = 0,75+0,25=1) ii Fenotyp 3 5 0 IA IA 2 0.35 0.3 0.25 0.2 0.15 0.1 0.05 0 p0+p1+p2=1 Blutgruppenversuch als Bernoulli-Experiment 1 1 0 4 0.3 3 0.3 0.25 0.2 0.15 0.1 0.05 0 3 0 1 2 Wahrscheinlichkeit 2 2 7 0 0.4 1 1 0.3 0.25 0.2 0.15 0.1 0.05 0 1 0 6 0 0.1 0 1 1 p2 1 4 2 Genotyp 1 0.2 2 1 1 p1 2 2 4 2 0.35 0.3 0.25 0.2 0.15 0.1 0.05 0 1 n=1 0.5 0 0 IAi ? IAi Nennen wir als „Erfolg” (E), wenn das Kind eine Blutgruppe 0 hat und „Misserfolg” (Ē), wenn seine Blutgruppe nicht 0 ist. p(E)=1/4=0.25 p(Ē)=3/4=0.75 p(E)+p(Ē)=1 Die Familie hat n Kinder. Wie hoch ist die Wahrscheinlichkeit, dass k Kinder eine Blutgruppe 0 haben? 11 für n = 2 (BG0 0-mal:) p0=0,75·0,75 =0,5625 (BG0 1-mal:) p1=0,75·0,25+0,25·0,75=0,375 (BG0 2-mal:) p2=0,25·0,25 = 0,0625 (pk = 0,5625+0,375+0,0625=1) allgemein: Sei: p(E)=p p(Ē)=1-p=q 1 k pk 0.6 0.4 0.2 0 n=2 0 1 2 k n Experimente, k Erfolge n k n k pk p (1 p ) n : Anzahl der möglichen Reihenfolgen k k 12 0.8 1 p(E ) 4 1 0.6 0.2 0.2 0.1 0 6 0.3 0.4 Bernoulli-Experiment, Binomialverteilung zB: 60% der Patienten haben Grippe. Heute kommen 4 Patienten. p=0,6 n=4 0 0 Binomialverteilung 0.4 1 0.6 0.5 0.4 0.3 0.2 0.1 0 0 2 0 3 0.4 0.3 0.2 0.1 0 1 2 0.3 0.2 0.1 0 0 1 2 3 0.3 0.2 0.1 0 0 1 2 3 4 5 6 2 3 4 5 6 1 2 3 4 5 6 7 1 2 3 4 5 6 7 0.3 0.25 0.2 0.15 0.1 0.05 0 13 1 2 3 4 5 6 7 8 p = 0.5 p = 0.75 > 0.5 rechtsschief symmetrisch linksschief 0.05 0 4 4 0 p4 0.6 0.4 0.1296 4 0 1 2 3 Erwartungs wert( x i ) 1 p 0 (1 p ) p Erwartungs wert( X ) E ( x i ) np 0.4 i (identische Einzelprozesse) 0.3 0.3 0.2 0.2 0.2 theoretische Streuung: 0.1 0.1 0.1 Varianz( x i ) E ( x i ) (E ( x i ))2 12 p 0 2 (1 p ) p 2 p p 2 p(1 p ) 0 0 1 2 3 4 5 6 7 8 k np(1 p ) 2 Varianz( X ) Varianz( x i ) np(1 p ) 0 0 1 2 3 4 5 6 7 8 k Tritt ein bestimmtes Ergebnis mit Wahrscheinlichkeit p ein, so haben wir bei n-maliger Wiederholung etwa np solche Ereignisse zu „erwarten”. 0.3 0 4 14 = np Erwartungswert: pk pk 0.4 0.1 Erwartungswert und Streuung der Binomialverteilung p = 0.25 < 0.5 0.4 0.15 9 Binomialverteilung pk 0.2 4 3 1 p3 0.6 0.4 0.3456 3 10 0 0.25 4 2 2 p2 0.6 0.4 0.3456 2 9 n=4 0.3 8 8 pk 0.35 4 1 3 p1 0.6 0.4 0.1536 1 9 4 k 4k pk 0.6 0.4 k 0.4 4 0 4 p0 0.6 0.4 0.0256 0 7 8 0 5 0.4 5 0.35 0.3 0.25 0.2 0.15 0.1 0.05 0 4 0.5 1 0 4 0.4 4 0.35 0.3 0.25 0.2 0.15 0.1 0.05 0 3 0.5 3 7 0 0.5 2 0.35 0.3 0.25 0.2 0.15 0.1 0.05 0 1 0 1 0 1 2 3 4 5 6 7 8 k k Die Funktion wird generell für wachsendes n immer „symmetrischer”. 15 i zB: 12 Würfelexperimente: Wie oft tritt „6” auf? n = 12, p = 1/6, = 2 60 1.29 6 16 Poisson Verteilung: Beispiel Poisson: Verteilung der seltenen Ereignisse n pk p k q n k k n p0 np= Die Wahrscheinlichkeit, dass man eine Krankheit bekommt, ist p=0.001. Wie groß ist die Wahrscheinlichkeit, dass es in einer Stadt mit n = 2000 Einwohner k = 0,1,2… Kranken gibt? k pk e k! k 2k 2 pk e e k! k! =np=2 Es ist eine gute Näherung für große n und kleine p Werte pk Schätzung der seltener Ereignisse 0.3 p0 20 2 e e 2 0,135 0! p1 21 2 e 2e 2 0,271 1! p2 22 2 e 2e 2 0,271 2! p3 23 2 8 2 e e 0,181 3! 6 0.25 0.2 Beispiel: 0.15 Die Wahrscheinlichkeit, dass man eine Krankheit bekommt, ist p=0.001. Wie groß ist die Wahrscheinlichkeit, dass es in einer Stadt mit n = 2000 Einwohner k = 0,1,2… Kranken gibt? 0.1 0.05 0 0 1 2 3 4 5 6 pk 0.4 Poisson Verteilung 1 2 3 4 5 6 7 8 9 10 0.3 0.25 0.2 0.15 0.1 0.05 8 9 10 ... 18 Erwartungswert und Streuung der Poisson-Verteilung 0.35 7 k 17 Erwartungswert: Varianz: Theoretische Streuung: Varianz(x)= Eine Verteilung, wo der Erwartungswert und die Streuung voneinander nicht unabhängig sind! k 0 0 5 10 15 20 19 20 Normalverteilung (Gauss-Verteilung) Die ausgezeichnete kontinuierliche Verteilung: Normalverteilung 1 e 2 Verteilungsdichtefunktion: f (x) Parameter der Normalverteilung: Erwartungswert: Streuung: f(x) für die dargestellte Funktion: ( x )2 2 2 Wendepunkte (die Krümmung der Kurve ändert sich) x 21 Position des Maximums und die Breite der Kurve ex Glockenkurve 2 e ( x ) 2 1 e 2 ( x )2 e 2 2 0 Position des Maximums bei x Normalverteilung die Breite der Kurve: ~2 ( x )2 22 x 0 die Fläche unter der Kurve ist 1 2 2 0 x 0 3, = 1 x 23 24 Standard - Normalverteilung f (x) 1 e 2 x2 2 t-Verteilungsfamilie 0.5 N (0,1) 0 0 -4 1 -3 -2 -1 0 1 2 3 „Glockenkurven” 4 0.5 Je größer ist der Freiheitsgrad, desto schmaler ist die Kurve. 0 -4 -3 -2 -1 0 1 2 3 25 t N (0, 1) 4 26 Pr.Buch Anhang S.27.2 Verteilung der Summe von Zufallsvariablen Verteilung der Summe von Zufallsvariablen Beispiel x1 und x2 sind unabhängige Zufallsvariablen. Beide folgen dergleichen Verteilung mit Erwartungswerten 1 bzw. 2 und Streuungen 1 bzw. 2. Welcher Verteilung folgt die Summe: x = x1 + x2 ? Wir werfen mit ein/zwei Würfeln. Welche Verteilung hat die Summe der Augenzahlen? mit einem Würfel – Gleichverteilung mit zwei Würfeln? – keine Gleichverteilung! p(Augenzahl) 1/ 6 1/ 6 1/ 6 1 1/ 36 1 2 3 4 5 6 7 8 9 10 11 12 1 2 3 4 5 6 Augenzahl Augenzahl 27 f( x ) 2 1 1 2 3 4 5 6 Augenzahl p(Augenzahl) f(x2) f( x1) p(Augenzahl) x1 2 x2 x x hat eine Verteilung mit Erwartungswert =1+2 und Varianz 2 12 22 die additive Größe ist die Varianz, nicht die Streuung! 28 Stabile und nicht stabile Verteilungen Zentraler Grenzwertsatz Der Verteilungstyp ist stabil, wenn die Summe von zwei unabhängigen indentisch verteilten Zufallsvariablen auch denselben Verteilungstyp besitzt. stabile Verteilungen: Normal-, Binomial-, Poisson- nicht stabile Verteilungen: Gleich- i 1 Die Summe der Verteilungsfunktionen konvergiert gegen eine Normalverteilung auch wenn die einzelnen Zufallsgrößen keine Normalverteilung haben. Beispiel: x1 und x2 sind unabhängige Zufallsgrößen. Beide folgen einer Normalverteilung mit Erwartungswerten 1 bzw. 2 und Streuungen 1 bzw. 2. x1 x 2 ? Welcher Verteilung folgt der Durchschnitt x 2 x hat eine Normalverteilung mit Erwartungswert 2 und Varianz 2 1 2 Biologische Bedeutung: Wenn ein Parameter (zB. Körpergröße, Blutzuckerkonzentration) durch viele (n →) anderen Faktoren (Zufallsgrößen) beeinflusst wird, folgt dieser Parameter einer Normalverteilung. 1 2 2 ( ) 2 2 1 2 22 Es seien x1, x2,….xn unabhängige Zufallsgrößen, die alle derselben Verteilung haben. Die Verteilung der Summe n nähert sich einer Normalverteilung, wenn n→ . Sn x i 2 2 29 30 Wichtige Verteilungen der analytischen Statsitik 0.025 Khi-Quadrat (2) Verteilung x x ... x 2 2 2 n 0.02 n 2 2n x, x1, x2 ,... xn sind unabhängige, standardnormalverteilte Zufallsgrößen. Dann die Größe 3 4 0.015 eine sogenannte 2 –Verteilung mit n Freiheitsgraden 0.005 2 1 2 0 2 n t-Verteilung (Student-Verteilung) 1 tn 5 6 0.01 Wenn x1, x2,….xn unabhängige standardnormalverteilte Zufallsgrößen sind, dann hat die Zufallsgröße Wichtige Verteilungen der analytischen Statistik 0 2 4 6 der Modalwert der Verteilungen mit Freiheitsgrad n > 2: (n-2) 8 10 31 x ( x x ... x n2 ) n 2 1 2 2 folgt einer t-Verteilung mit Freiheitsgrad n. Die t-Verteilung ist symmetrisch, n=0 (n ≥ 2), die Streuung ist: (n ≥ 3) n n2 32 Überblickstabelle Die Kurven der t-Verteilungen 0.4 200 f(t) Die Verteilungskurve der t-Verteilung ähnelt einer Glockenkurve (wenn n→). Lagemaße Freiheitsgrad i i 10 x 4 0.2 2 ( x i )2 p( x i ) x i p( x i ) diskrete Verteilung 20 Die t-Verteilung ist breiter als die Normalverteilung. Variabilitätsmaße xi x x i h( x i ) s2 t x -5 -3 -1 1 3 2 i i n xi i n 2 ( x )2 f ( x )dx xf ( x )dx 335 Überblickstabelle 2 0 2 n i kont. Verteilung x i i n empirische Werte 2 s2 i x 34 Überblickstabelle Kontinuierliche Verteilungen Diskrete Verteilungen x ( x x ... x n2 ) n 2 1 x12 x 22 ... x n2 kontinuier. NormalGleich- Standardnormal- KhiQuadrat- 2 2 t- diskrete Gleich- Binomial- pk 1 n n k n k k p (1 p ) n 1 2 np ab 2 0 n 0 n≥2 2 n2 1 12 np(1 p ) 2 ( b a )2 12 2 1 2n n n2 n≥3 Poisson- k k! 1 ( x )2 , 1 2 e 2 f (x ) b a 2 axb e 35 1 e 2 x2 2 n 1 n 1!2 2 n 2 1 x2 e x 2 t x s/ n f (t ) K t2 1 f 36 f 1 2