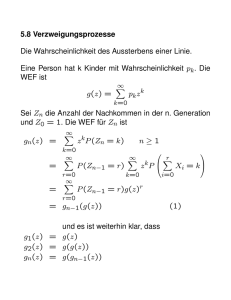

Wahrscheinlichkeitsrechnung

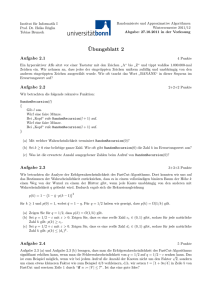

Werbung