Vorlesung "Mathematik und Statistik" WS 2006 / 2007 Teil II

Werbung

Vorlesung

"Mathematik und Statistik"

WS 2006 / 2007

Teil II

Statistik und Stochastik

Oktober 2006

Dozent: Dr. Norbert Marxer

2

Skript Statistik und Stochastik

0. Inhaltsverzeichnis

0. Inhaltsverzeichnis .................................................................................................

2

1. Einleitung ..................................................................................................................

7

Vorbemerkung ...............................................................................................

Einleitung ..........................................................................................................

Referenzen ......................................................................................................

7

7

9

2. Wahrscheinlichkeitstheorie .............................................................................. 10

Was ist Wahrscheinlichkeit? ................................................................. 10

Ergebnisraum und Ereignisraum .......................................................... 11

Zufallsexperiment ......................................................................................... 11

Illustration: Drei Mal eine Münze Werfen ................................................. 12

Illustration: Zwei Mal Würfeln ................................................................ 12

Empirisches Gesetz der grossen Zahlen ....................................................... 13

Kolmogorov'sches Axiomensystem ..................................................... 13

Eigenschaften von Wahrscheinlichkeitsmassen ............................................ 14

Beispiel 1 .............................................................................................. 14

Beispiel 2 .............................................................................................. 14

Venn Diagramme .......................................................................................... 15

3. Elementare Kombinatorik .................................................................................. 16

Einleitung .......................................................................................................... 16

Laplace Experimente .................................................................................. 16

Laplace Wahrscheinlichkeit .........................................................................

Mehrstufige Laplace Experimente - Baumdiagramme .................................

Bernoulli Experimente ................................................................................

Summenregel .................................................................................................

Produktregel ....................................................................................................

Permutationen und Binomialverteilung ..............................................

16

17

17

17

18

18

Einleitung .....................................................................................................

Kombinatorik ........................................................................................

Mengenlehre ..........................................................................................

Ohne Zurücklegen - alle verschieden ...........................................................

Beispiel .................................................................................................

Ohne Zurücklegen - mehrere Klassen ...........................................................

Ohne Zurücklegen - mit 2 Klassen ...............................................................

18

18

19

19

19

19

20

Urnenexperimente bei verschiedenen Elementen ....................... 20

Urnenexperimente ........................................................................................

Mit Zurücklegen und Geordnet (k-Tupel) ....................................................

Beispiel .................................................................................................

Mit Zurücklegen und Ungeordnet (k-Repetition) .........................................

Beispiel .................................................................................................

Ohne Zurücklegen und Geordnet (k-Permutation) .......................................

Beispiel .................................................................................................

Ohne Zurücklegen und Ungeordnet (k-Kombinationen) ..............................

20

20

21

21

21

21

22

22

3

Skript Statistik und Stochastik

Beispiel .................................................................................................

Zusammenfassung - Ziehen mit verschiedenen Elementen ...........................

22

22

Verteilungen in Behälter ............................................................................ 23

Beispiel .................................................................................................

23

Urnenexperimente bei teilweise gleichen Elementen ................. 24

Einleitung ..................................................................................................... 24

Ziehen mit Zurücklegen - Variationen und Kombinationen ......................... 24

Beispiel ................................................................................................. 25

Beispiel ................................................................................................. 25

Ziehen ohne Zurücklegen - Variation und Kombination .............................. 25

Beispiel ................................................................................................. 25

Beispiel ................................................................................................. 25

4. Bedingte Wahrscheinlichkeiten ...................................................................... 26

Einleitung .......................................................................................................... 26

Bedingte Wahrscheinlichkeit .................................................................. 26

Beispiel .................................................................................................

27

Stochastische Unabhängigkeit .............................................................. 27

5. Zufallszahlengenerator ....................................................................................... 28

Einleitung .......................................................................................................... 28

6. Zufallsvariablen und ihre Verteilungen ........................................................ 29

Einleitung .......................................................................................................... 29

PDF und CDF ................................................................................................. 30

Diskrete Verteilung ................................................................................

33

Erwartungswert .............................................................................................. 33

Beispiel Würfeln ..........................................................................................

34

Diskrete Verteilungen ................................................................................. 34

Einleitung .....................................................................................................

Gleichverteilung (DiscreteUniformDistribution) ..........................................

Einleitung ..............................................................................................

Eigenschaften ........................................................................................

Bernoulli Verteilung (BernoulliDistribution) ...............................................

Einleitung ..............................................................................................

Eigenschaften ........................................................................................

Binomial Verteilung (BinomialDistribution bzw. BINOMVERT) ...............

Einleitung ..............................................................................................

Eigenschaften ........................................................................................

Die Anzahl der Erfolge beim n-maligen Münzen werfen. ...........................

Beispiel 1 ..............................................................................................

Beispiel 2 ..............................................................................................

Beispiel 3 ..............................................................................................

Poisson Verteilung (PoissonDistribution bzw. POISSON) ..........................

Einleitung ..............................................................................................

Eigenschaften ........................................................................................

34

35

35

36

36

36

37

38

38

39

39

39

40

40

41

41

41

Stetige Verteilungen .................................................................................... 41

Einleitung ..................................................................................................... 41

Normalverteilung (NormalDistribution bzw. NORMVERT, STANDNORMVERT)

....................................................................................................................... 42

4

Skript Statistik und Stochastik

Einleitung ..............................................................................................

Eigenschaften ........................................................................................

Standardnormalverteilung .......................................................................

c2 Verteilung (ChiSquareDistribution bzw. CHIVERT) .............................

Einleitung ..............................................................................................

Eigenschaften ........................................................................................

Student t Verteilung (StudentTDistribution bzw. TVERT) ..........................

Eigenschaften ........................................................................................

42

43

43

44

44

44

44

45

Zentraler Grenzwertsatz ............................................................................ 46

Einleitung .....................................................................................................

Experiment ...................................................................................................

Kugeln aus einer Urne ziehen .......................................................................

46

46

47

7. Statistik und empirische Daten ....................................................................... 49

Einleitung .......................................................................................................... 49

Datentypen ...................................................................................................... 50

8. Beschreibende Statistik ...................................................................................... 51

Einleitung .......................................................................................................... 51

Graphische Darstellungen ....................................................................... 52

Einleitung .....................................................................................................

Diskrete Datenreihe (n klein) ...................................................................

Diskrete Daten (n gross: 1000) ................................................................

Stetige Daten (n gross: 1000) ..................................................................

8i, xi < .............................................................................................................

Diskrete Daten (n klein) ..........................................................................

Diskrete Daten (n gross) .........................................................................

Stetige Daten (n gross) ............................................................................

8i, xsort,i < ........................................................................................................

Diskrete Daten (n klein) ..........................................................................

Diskrete Daten (n gross) .........................................................................

Stetige Daten (n gross) ............................................................................

Häufigkeitsfunktionen: 8xsort,i , ni <, 8xi , hi < ...................................................

Diskrete Daten (n klein) ..........................................................................

Diskrete Daten (n gross) .........................................................................

Stetige Daten (n gross) ............................................................................

Verteilungsfunktion: 8xi , ⁄ij=1 h j < .................................................................

52

52

53

53

53

53

54

54

55

55

55

56

56

57

58

59

61

Weitere graphische Darstellungen ................................................................ 62

Box-And-Whisker Plot ........................................................................... 62

Masszahlen - Nominalskala .................................................................... 63

Masszahlen - Ordinalskala ...................................................................... 64

Masszahlen - Metrisch skalierte Daten .............................................. 65

Lagemasse (Lokalisationsmasse) ..................................................................

Streuungsmasse ............................................................................................

Formmasse ....................................................................................................

Zentrierung und Standardisierung ................................................................

Additionssätze für êêx und s2 ..........................................................................

65

68

71

73

73

Daten mit diskreter Klassierung und

Stetig klassierte Daten .............................................................................. 74

Daten mit diskreter Klassierung ...................................................................

74

5

Skript Statistik und Stochastik

Stetig klassierte Daten .................................................................................

74

Konzentrations- und Disparitätsmessung ......................................... 77

Konzentration ...............................................................................................

Disparität ......................................................................................................

Zusammenhang zwischen Konzentrationsindizes und Disparitätkoeffizienten

.......................................................................................................................

Kurven ..................................................................................................

Zahlen ...................................................................................................

Gemeinsame Prinzipien ..........................................................................

Unterschiede ..........................................................................................

77

79

80

80

80

80

81

9. Induktive Statistik .................................................................................................. 82

Einleitung .......................................................................................................... 82

Punktschätzungen ....................................................................................... 83

Punktschätzung für den Mittelwert ...............................................................

Punktschätzung für den Anteilswert .............................................................

Punktschätzung für die Varianz ....................................................................

Eigenschaften von Punktschätzungen ...........................................................

83

83

83

84

Intervallschätzungen ................................................................................... 84

Einleitung .....................................................................................................

Stichprobenverteilungen ...............................................................................

Verteilung des Stichprobenmittelwerts .....................................................

Lösung a ...............................................................................................

Lösung b ...............................................................................................

Intervallschätzung bei grossen Stichproben .................................................

Intervallschätzung bei kleinen Stichproben ..................................................

Lösung ..................................................................................................

84

84

84

85

85

86

86

87

Statistische Tests ......................................................................................... 87

Einleitung ..................................................................................................... 87

Testen von Hypothesen über Mittelwerte ..................................................... 88

Zweiseitige Fragestellung ........................................................................ 88

Beispiel ................................................................................................. 88

Schritte ................................................................................................. 90

10. Zweidimensionale Verteilungen ................................................................... 91

Einleitung .......................................................................................................... 91

Kontingenztabelle ......................................................................................... 92

Einleitung .....................................................................................................

Randverteilung .............................................................................................

Bedingte Wahrscheinlichkeiten ....................................................................

Berechnung von Mittelwerten und Varianzen für X und Y ..........................

92

92

93

94

Kovarianz und Korrelationskoeffizient ................................................ 94

Einleitung .....................................................................................................

Beispiel 1 ......................................................................................................

Beispiel 2 ......................................................................................................

94

95

96

11. Regression und Korrelation ........................................................................... 97

Einleitung .......................................................................................................... 97

Scatter Plot ...................................................................................................... 98

Korrelation ........................................................................................................ 99

6

Skript Statistik und Stochastik

Einleitung .....................................................................................................

Berechnung des Korrelationskoeffizienten ...................................................

Grenzen der Korrelationsanalyse ..................................................................

Nichtlinearität ........................................................................................

Ausreisser .............................................................................................

Signifikanz des Korrelationskoeffizienten ....................................................

99

99

100

101

101

102

(Lineare) Regression .................................................................................. 103

Einleitung .....................................................................................................

`

`

Berechnung der (geschätzten) Regressionskoeffizienten b0 und b1 ..............

Eigenschaften der Regressionsgerade .......................................................

Berechnung der Residualvarianz s2 (standard error of estimate) .................

`

`

Berechnung der Varianzen für b0 und b1 ......................................................

Bestimmtheitsmass R2 (coefficient of determination) ..................................

Intervallschätzung und Tests ........................................................................

Prognose .......................................................................................................

`

`

Mathematica Lineare Regression - b0 und b1 Berechnungen .......................

Beispiel mit Covariance und Mean ...........................................................

103

104

105

105

106

106

108

109

110

110

12. Zeitreihen ................................................................................................................ 111

Einleitung .......................................................................................................... 111

Trendschätzung ............................................................................................

Saisonale Variation .......................................................................................

Zyklische Variation ......................................................................................

Irreguläre Variaton .......................................................................................

Achtung bei Extrapolationen ........................................................................

Simulation ....................................................................................................

111

112

112

112

112

113

13. Stochastische Differentialgleichungen ..................................................... 114

Einleitung .....................................................................................................

Aktie .............................................................................................................

Stochastiche Differentialgleichung ...........................................................

Brown'sche Bewegung ............................................................................

Monte-Carlo Lösung der SDE ................................................................

Symbolische Lösung der SDE .................................................................

Mehrere Aktien ......................................................................................

114

114

114

115

115

116

117

Skript Statistik und Stochastik

7

1. Einleitung

Vorbemerkung

Die Vorlesung "Mathematik und Statistik", die im WS 2006 / 2007 an der Hochschule Liechtenstein angeboten wird,

beinhaltet nach einer allgemeinen Repetition von vorausgesetzten mathematischen Grundlagen die Gebiete Taylor

Entwicklung und Partielle Differentiation, Zeitreihenanalyse, Regression und allgemeine Optimierung sowie aus dem

Gebiet der Statistik und Stochastik die Gebiete Deskriptive Statistik, Induktive Statistik und Stochastic Calculus.

Der ganze Vorlesungsstoff wird in zwei Dokumenten bzw. Skripten präsentiert.

Das mit "Skript Statistik" bezeichnete Dokument beinhaltet die Gebiete, die dem Gebiete der Statistik und Stochastik

zugerechnet werden können.

Das mit "Skript Abbildungen" bezeichnete Dokument beinhaltet die Gebiete, die nicht dem Gebiete der Statistik und

Stochastik zugerechnet weden können.

Einleitung

Dieses Dokument ("Skript Statistik") enthält die Gebiete, die dem Gebiet der Statistik und Stochastik zugerechnet

werden können.

Die Graphik StatistikUebersicht.jpg zeigt, wie die verschiedenen (im Folgenden behandelten Themen) miteinander in

Beziehung stehen.

Einige Bemerkungen dazu:

† Sowohl Zufallsexperimente als auch empirische Befragungen liefern Daten zur Analyse mit den Methoden der

Beschreibenden Statistik.

† Die Induktive Statistik versucht aus Stichproben Aussagen über die empirische Verteilung der Grundgesamtheit zu

machen.

† Die Wahrscheinlichkeitstheorie liefert theoretische Verteilungen, die zum Teil auch für empirische Daten verwendet werden können.

Skript Statistik und Stochastik

8

Die Kapitel dieses Dokuments enthalten die folgenden Inhalte.

Das Kapitel "Wahrscheinlichkeitstheorie" nähert sich dem Begriff der Wahrscheinlichkeit und erklärt die wichtigen

Begriffe der Wahrscheinlichkeitstheorie wie Ergebnis, Ereignis und Wahrscheinlichkeit. Ausserdem wird mit dem

Kolmogorov'schen Axiomensystem die mathematische Grundlage der Wahrscheinlichkeitstheorie gelegt.

Das Kapitel "Elementare Kombinatorik" beschäftigt sich intensiv mit Zufallsexperimenten (vor allem Urnenexperimenten) und den dazugehörigen Formeln zur Berechnung von verschiedensten experimentellen Situationen.

Das Kapitel "Bedingte Wahrscheinlichkeiten" untersucht das Vorgehen, wenn Teilinformationen von Experimenten

vorliegen, gibt verschiedene Formeln dazu and und definiert den Begriff der stochastischen Unabhängigkeit.

Das Kapitel "Zufallszahlengenerator" ist ein kleiner Einschub, der Funktionen zur Erzeugung von Zufallszahlen, die

für spätere Simulationen und Computerexperimente wichtig sind, erklärt.

Das Kapitel "Zufallsvariablen und ihre Verteilungen" geht dann näher ein auf die wichtigen Funktionen PDF

(probability density function) und CDF (cumulative probability density function), die sowohl bei diskreten als auch bei

stetigen Verteilungen benutzt werden können, um aus Messintervallen auf Wahrscheinlichkeiten zu schliessen. Es wird

auch das umgekehrte Prozedere angesprochen, nämlich aus einem Wahrscheinlichkeitsbereich auf ein Messintervall zu

schliessen. Es werden auch die Begriffe Erwartungswert erklärt sowie die wichtigsten diskreten und stetigen Verteilungen diskutiert. Weiters wird der zentrale Grenzwertsatz anschaulich mit Computerexperimenten plausibilisiert.

Das Kapitel "Statistik und empirische Daten" beginnt dann die Behandlung von empirisch erhaltenen Daten. Nach

einer Übersicht über die Bereiche der Statistik wird auf die einzelnen Datentypen eingegangen.

Das Kapitel "Beschreibende Statistik" behandelt die Methoden, mit denen sich riesige Datenmengen anschaulich

mittels Graphiken oder kurz und prägnant mit Kennzahlen für die Lage und die Streuung der Daten sowie die Form der

Verteilung beschreiben lassen.

Das Kapitel "Induktive Statistik" behandelt die Methoden, wie sich aus einer Stichprobe auf die Eigenschaften der

Grundgesamtheit schliessen lässt. Es werden Punktschätzungen, bei denen es um die Abschätzung eines einzelnen

Werts (z.B. Mittelwert) geht, Intervallschätzungen, wo es um die Abschätzung von Konfidenzintervallen geht sowie

statistische Test, wo es um die Annahme bzw. Verwerfung von Hypothesen über die Grundgesamtheit geht, behandelt.

Die Induktive Statistik ist das Gebiet, wo die verschiedenen Methoden der vorangehenden Kapitel (Verteilungen, PDF,

CDF, Beschreibende Statistik etc.) eingesetzt werden können.

Das Kapitel "Zweidimensionale Verteilungen" beschäftigt sich mit multivariaten Daten, mit Kontingenztabellen und

Korrelationen von bivariaten Daten.

Das Kapitel "Zeitreihen" behandelt bivariate Daten und Zeitreihen sowie verschiedene Methoden, um aus diesen

Daten Informationen herauszuziehen.

Das Kapitel "Regression und Korrelation" behandelt bivariate Daten und Zeitreihen sowie verschiedene Methoden,

um aus diesen Daten Informationen herauszuziehen.

Abschliessend noch zwei Definitionen zum Titel dieses Notebooks

Die Statistik ist die Wissenschaft von der Gewinnung, Aufbereitung und Auswertung von Informationen / Daten. Viel mehr

dazu im Kapitel 7.

Die Stochastik ist die Beschreibung und Untersuchung von Zufallsexperimenten und deren Ausgang, von zeitlichen

Entwicklungen und räumlichen Strukturen, die wesentlich vom Zufall beeinflusst werden.

Skript Statistik und Stochastik

9

Referenzen

Das in der Vorlesung behandelte Gebiet ist sehr weit und es gibt natürlich eine Unmenge an Literatur zu den verschiedenen Themen.

So wie man sich im Wald dieser Literatur verlieren kann, so kann man sich auch im Wald einer zu langen Literaturliste

verlieren. Ich möchte deshalb im Folgenden nur sehr wenige, meines Erachtens nützliche, Hinweise geben.

Sehr kostengünstig sind natürlich die im Internet verfügbaren Informationen. Diese Informationen werden auch von

Jahr zu Jahr besser. Interessant sind sicherlich die unter

http://de.wikipedia.org/wiki/Mathematik

vorhandenen Beiträge: über Mengenlehre, Analysis, ...

Sehr gut und hilfreich können als Zusatzinformation zur Vorlesung im Gebiete der Statistik auch die beiden folgenden

Bücher (zusammen 600 Seiten) sein:

† "Wahrscheinlichkeitsrechnung und schliessende Statistik" von K. Mosler und F. Schmid, Springer, 2. Auflage,

2006.

www.uni-koeln.de/wiso-fak/wisostatsem/buecher/wrechng_schliessende/index.htm

† "Beschreibende Statistik und Wirtschaftsstatistik" von K. Mosler und F. Schmid, Springer, Berlin, 2. Auflage,

2005.

www.uni-koeln.de/wiso-fak/wisostatsem/buecher/beschr_stat/

Skript Statistik und Stochastik

10

2. Wahrscheinlichkeitstheorie

Was ist Wahrscheinlichkeit?

Wahrscheinlichkeitstheorie ist der Zweig der Mathematik, der sich mit Zufallsexperimenten befasst, mit ihrer Beschreibung und der Aufdeckung von Gesetzmässigkeiten. Es wird versucht mathematische Modelle zu finden für Experimente, bei denen mehrere verschiedene Verläufe möglich sind und deren Ergebnisse ganz oder teilweise vom Zufall

abhängen. Insbesondere sollen die Gesetzmässigkeiten bei vielfacher Wiederholung des Experiments aufgespürt

werden.

Bei einem Würfelexperiment kann nicht vorausgesagt werden, welche Augenzahl eintreten wird. Bei

vielfachen Wiederholungen des Experiments scheint jedoch der Anteil der Experimente, bei denen 1, 2,

... 6 gewürfelt wird, einer festen Grösse zuzustreben.

Eine zentrale und naheliegende Frage lautet: "Was ist Wahrscheinlichkeit?".

Auf diese Frage gibt es keine befriedigende Antwort. Intuitive Antworten können folgendermassen lauten.

Laplace'sche Wahrscheinlichkeitsdefinition

Ein unverfälschter (d.h. symmetrischer, unmanipulierter) Würfel werde geworfen und wir fragen nach der Wahrscheinlichkeit, dass die geworfene Augenzahl gerade ist. In diesem Beispiel wird wohl jeder antworten, dass die Wahrscheinlichkeit 50% sei, da die Hälfte der möglichen Ergebnisse (d.h. die Augenzahl 2, 4, 6) günstig und die andere Hälfte der

Ergebnisse (d.h. die Augenzahlen 1, 3, 5) ungünstig ist. Die Laplace'sche Wahrscheinlichkeit wird als Quotient der

Anzahl günstiger Ereignisse und der Anzahl möglicher Ereignisse definiert. Diese Definition bedeutet auch, dass alle

Ergebnisse eines Experiments gleich wahrscheinlich sind.

Wahrscheinlichkeit als relative Häufigkeit in einer endlichen Grundgesamtheit.

Eine andere intuitive Wahrscheinlichkeitsvorstellung folgt aus dem folgenden Beispiel. In einer Gruppe von 100'000

Personen seien 20'000 zwischen 10 und 20 Jahren alt. Wie gross ist die Wahrscheinlichkeit, dass eine zufällig aus der

Gruppe ausgewählte Person in diese Alterskategorie fällt. Intuitiv würde man sagen 20%, d.h. der Quotient aus 20'000

und 100'000, d.h. die relative Häufigkeit eines Merkmals in einer endlichen Grundgesamtheit (dazu mehr später). Auch

hier wird - wenn man nicht mehr dazu weiss - vorausgesetzt, dass jede der 100'000 Personen die gleiche Wahrscheinlichkeit hat, dieser Alterskategorie anzugehören.

Wahrscheinlichkeit als Grenzwert der relativen Häufigkeit bei wachsender Anzahl von Wiederholungen des Experiments

Bei den bisherigen zwei Möglichkeiten konnte man (oder musste man, da man keine Zusatzinformationen hatte) auf

Grund von Symmetrieeigenschaften annehmen, dass die Wahrscheinlichkeiten (eine bestimmte Augenzahl zu würfeln

bzw. einer bestimmten Alterskategorie anzugehören) gleich gross waren. Im folgenden Beispiel können keine solchen

Symmetrieeigenschaften verwendet werden. Es wird z.B. gefragt, wie gross die Wahrscheinlichkeit ist, dass beim Wurf

eines unsymmetrischen Gegenstands der Gegenstand auf einer bestimmten Fläche landet. Hier liefert uns weder die

Theorie (Symmetrie) noch die relative Häufigkeit einer endlichen Grundgesamtheit eine Antwort. Wir müssen das

Experiment durchführen und die relative Häufigkeit für eine grosse Anzahl an Versuchen bestimmen. Wir gehen dann

davon aus, dass im Grenzübergang für n gegen ¶ die relative Häufigkeit einem Grenzwert, den wir als Wahrscheinlichkeit dieses Experiments bezeichnen, zustrebt.

Diese verschiedenen Ansätze sind für die Mathematik und rigorose Behandlung nicht geeignet. Die Wahrscheinlichkeitstheorie wurde jedoch mit dem weiter unten behandelten Axiomensystem auf eine feste Grundlage gestellt. Zum

Verständnis des Axiomensystems müssen wir jedoch ein wenig ausholen.

Skript Statistik und Stochastik

11

Ergebnisraum und Ereignisraum

Zufallsexperiment

Wichtige Begriffe im Zusammenhang mit der Wahrscheinlichkeitstheorie sind "Zufallsexperiment", "Ergebnis",

"Elementarereignis", "Ereignis" und "Wahrscheinlichkeit". Diese Terminologie soll in diesem Abschnitt definiert und

erläutert werden.

Ein Zufallsexperiment ist ein Experiment

- mit mehreren (mindestens 2) möglichen Ergebnissen;

- dabei lässt sich nicht sicher voraussagen, welches Ergebnis eintritt;

- die Ergebnismenge ist jedoch festgelegt; d.h. alle potentiell möglichen Ergebnisse sind bekannt;

Bei einem Zufallsexperiment spielt also der Zufall eine wesentliche Rolle.

Beispiele für Zufallsexperimente sind:

† Einmaliges Werfen einer Münze;

† Das Ziehen einer Karte (z.B. aus einem Quartett);

† Die Ziehung der Lottozahlen (6 aus 49);

† 1x Würfeln;

† Gleichzeitiges Werfen eines roten und grünen Würfels;

Die Menge aller möglichen Ergebnisse w eines Zufallsexperiments ist die Ergebnismenge W.

Die Ergebnismenge wird mit dem griechischen Buchstaben W bezeichnet, die einzelnen Ergebnisse allgemein mit dem

kleinen griechischen Buchstaben w.

Die Ergebnismenge

† ist eine nichtleere Menge;

† kann endlich sein: z.B. 81, 2, 3, 4, 5, 6< beim einmaligen Würfeln;

† kann abzählbar unendlich sein; z.B. beim Würfeln bis zum ersten 6-er;

Die Ergebnismengen für die obenstehenden Beispiele von Zufallsexperimenten sind:

† W = 8Kopf, Zahl<

† W = 8Herz As, Herz König, Herz ....<; d.h. die Menge aller Karten

† W = 8 8a, b, c, d, e, f < mit a, b, c, d, e, f œ 81, 2, ... 49< und je zwei nicht gleich <

† W = 8 1, 2, 3, 4, 5, 6 <

† W = 8 81, 1<, 81, 2<, ... 81, 6<, 82, 1<, 82, 2<, ... 86, 6< <

Oft ist man jedoch nicht am genauen Ergebnis w eines Experiments interessiert, sondern an einem allgemeineren

Ereignis. Formal wird ein allgemeineres Ereignis A definiert als Teilmenge des Ergebnisraums. Z.B. könnte im obigen

Experiment "1x Würfeln" das Ereignis "Würfeln einer geraden Zahl" lauten und dieses Ereignis würde der Teilmenge

{2, 4, 6} des Ergebnisraums 8 1, 2, 3, 4, 5, 6 < entsprechen. Ein Ereignis kann also mehrere Ergebnisse umfassen.

Spezielle Ereignisse sind sogenannte Elementarereignisse, die genau einem Ergebnis (z.B. "Würfle eine 6", d.h. 86<)

entsprechen.

12

Skript Statistik und Stochastik

Ein Ereignis A ist eine Teilmenge der Ergebnismenge W.

Die Ergebnismenge W heisst das sichere Ereignis, die leere Menge 8< das unmögliche Ereignis.

Die Elemente w aus W heissen auch Elementarereignisse.

Es gibt sehr viele Ereignisse (z.B. "Gerade Augenzahl würfeln", "2 oder 4 würfeln", "Keine 5 würfeln", etc.) und jedes

Ereignis ist eine Teilmenge des Ergebnisraums.

Für die obenstehenden Zufallsexperimente können wir z.B. folgende Ereignisse A wählen:

† A = 8Kopf<; Kopf wird geworfen;

† A = {Herz As, Karo As, .... As} ; es wird ein As gezogen;

† A = 8 81, b, c, d, e, f < mit b, c, d, e, f œ 81, 2, ... 49< und je zwei nicht gleich <; es wird sicher eine 1 gezogen;

† A = 8 2, 4, 6 <; es wird eine gerade Zahl gewürfelt;

† A = 8 85, 6<, 86, 5<, 86, 6< <; die Summe der Augenzahlen ist grösser als 10;

Der Ereignisraum ist die Menge aller Ereignisse und entspricht zumeist der Potenzmenge (d.h. der Menge aller Teilmengen)

des Ergebnisraums. Der Ereignisraum kann sehr schnell sehr gross werden.

Im Folgenden werden an Hand zweier (leicht komplizierterer) Experimente die Begriffe Ergebnis w, Ergebnisraum W,

Elementarereignis, Ereignis A und Ereignisraum noch etwas ausführlicher behandelt. Man sieht anschaulich, dass

die Grösse des Ereignisraums sehr schnell anwachsen kann.

Illustration: Drei Mal eine Münze Werfen

In diesem Experiment wird drei Mal hintereinander eine Münze geworfen, wobei bei jedem Wurf Kopf (0) oder Zahl

(1) als Ergebnis möglich ist. Bei dreimaligem Würfeln ergibt sich der folgende Ergebnisraum:

880, 0, 0<, 80, 0, 1<, 80, 1, 0<, 80, 1, 1<, 81, 0, 0<, 81, 0, 1<, 81, 1, 0<, 81, 1, 1<<

Der Ergebnisraum W enthält die Ergebnisse bzw. Elementarereignisse {0,0,0}, {0,0,1}, ... und umfasst insgesamt 8

verschiedene Ergebnisse (Elementarereignisse).

Die Anzahl der möglichen Ereignisse (d.h. die Menge aller Teilmengen des Ergebnisraums bzw. die Potenzmenge von

W) ist bereits 256 gemäss der allgemeinen Formel zur Berechnung der Mächtigkeit der Potenzmege von W (

2n = 28 = 256 ), wobei n die Mächtigkeit (Anzahl Elemente) von W ist. Die Begriffe werden in Kürze näher erklärt.

Illustration: Zwei Mal Würfeln

In diesem Experiment wird zwei Mal hintereinander gewürfel, wobei bei jedem Wurf die Augenzahlen 1, 2, 3, 4, 5

oder 6 als Ergebnis möglich sind. Bei zweimaligem Würfeln ergibt sich der folgende Ergebnisraum:

881,

82,

84,

85,

1<,

4<,

1<,

4<,

81,

82,

84,

85,

2<,

5<,

2<,

5<,

81,

82,

84,

85,

3<,

6<,

3<,

6<,

81,

83,

84,

86,

4<,

1<,

4<,

1<,

81,

83,

84,

86,

5<,

2<,

5<,

2<,

81,

83,

84,

86,

6<,

3<,

6<,

3<,

82,

83,

85,

86,

1<,

4<,

1<,

4<,

82,

83,

85,

86,

2<,

5<,

2<,

5<,

82,

83,

85,

86,

3<,

6<,

3<,

6<<

Es gibt also 36 (d.h. 6 mal 6) verschiedene Ergebnisse.

Der Ereignisraum umfasst alle Teilmengen des Ergebnisraums. Diese Menge hat sehr viele Elemente, nämlich 236

oder fast 70 Milliarden (genau: 68719476736).

Skript Statistik und Stochastik

13

Empirisches Gesetz der grossen Zahlen

Das wesentliche Merkmal eines Zufallsexperiments ist, dass wir vor seiner Durchführung nicht wissen, welches der

möglichen Ergebnisse eintreten wird. Für ein bestimmtes Ereignis A können wir nicht mit Sicherheit voraussagen, ob

es eintreten wird oder nicht; es sei denn, A ist entweder das sichere Ereignis W oder das unmögliche Ereignis 8<.

Wir wollen im Folgenden zahlenmässig zu erfassen versuchen, wie "stark" mit dem Eintreten des Ereignisses A zu

rechnen ist. Dazu bietet sich der folgende experimentelle Weg an: wir führen ein Zufallsexperiment mehrfach nacheinander durch und notieren die (sogenannte absolute) Häufigkeit Hn HAL des Auftretens des Ereignisses A bei n-facher

Hn HAL

ÅÅÅÅÅÅ .

Wiederholung sowie die davon abgeleitete relative Häufigkeit hn HAL = ÅÅÅÅÅÅÅÅ

n

Man beobachtet nun im Allgemeinen, dass die relative Häufigkeit mit wachsendem n in der Regel immer weniger um einen

festen Wert schwankt. Dieser sogenannte Stabilisierungseffekt ist eine Erfahrungstatsache und wird das empirische Gesetz der

grossen Zahlen genannt.

Kolmogorov'sches Axiomensystem

Nachdem wir die unbefriedigende Situation mit dem Begriff bzw. der Definition der Wahrscheinlichkeit diskutiert

sowie wichtige Begriffe von Zufallsexperimenten erläutert haben, können wir den axiomatischen Wahrscheinlichkeitsbegriff bzw. den mathematischen Ansatz, die Wahrscheinlichkeitstheorie auf ein Fundament zu stellen, behandeln.

Wir geben im Folgenden das Kolmogorov'sche Axiomensystem (1930er Jahre), die Grundlage der Wahrscheinlichkeitstheorie, wobei W die endliche (oder abzählbar unendliche) Ergebnismenge eines Zufallsexperiments bedeutet.

Ein Wahrscheinlichkeitsraum ist ein Tripel HW, , PL, wobei

W eine nichtleere Menge ist,

eine s-Algebra von Teilmengen von W, d.h.

ist nicht leer,

aus B œ folgt Bc œ und

aus A1 , A2 , ... œ folgt A1 ‹ A2 .... œ , und

P : Ø @0, 1D ist eine Abbildung mit folgenden Eigenschaften:

Axiom1: PHWL = 1

Axiom 2: PHA ‹ BL = PHAL + PHBL für disjunkte Ereignisse A und B

Axiom 3: wie Axiom 2 für eine ¶ Folge von paarweise disjunkten Ereignissen

Die Funktion P : Ø @0, 1D heisst Wahrscheinlichkeitsmass, Wahrscheinlichkeitsabbildung, Wahrscheinlichkeitsverteilung

oder auch kurz Wahrscheinlichkeit.

Wie man leicht einsehen kann, decken sich diese Axiome mit der intuitiven Vorstellung von Wahrscheinlichkeit:

† Gemäss Axiom 1 ist die Wahrscheinlichkeit, irgendein Ergebnis des Ergebnisraums zu erzielen, gleich eins (d.h.

völlige Sicherheit).

† Gemäss Axiom 2 ist die Wahrscheinlichkeit eine 1 oder eine 2 zu würfeln (dies sind disjunkte Ereignisse) gleich

der Summe der Wahrscheinlichkeiten der beiden (Elementar)ereignisse, d.h. ÅÅÅÅ26 .

† Die Wahrscheinlichkeit ist nie grösser als 1 (das sicherer Ereignis) und nie kleiner als 0 (das unmögliche Ereignis).

Eigenschaften von Wahrscheinlichkeitsmassen

In der Praxis ist es oft so, dass die Wahrscheinlichkeit eines Ereignisses nicht direkt ausgerechnet werden kann. Dann

kann man versuchen, das Ereignis als Vereinigung, Durchschnitt, Differenz oder Komplement von Ereignissen, deren

Wahrscheinlichkeit einfacher berechnet werden kann, zu schreiben und die folgenden Beziehungen anzuwenden. Diese

Beziehungen können aus dem Axiomensystem abgeleitet werden:

† PH«L = 0

14

Skript Statistik und Stochastik

† 0 § PHAL § 1

† PHAc L = 1 - PHAL

† A Õ B fl PHB \ AL = PHBL - PHAL

† A Œ B fl PHAL § PHB

† PHB \ AL = PHBL - PHA › BL

† PHA ‹ BL = PHAL + PHBL - PHA › BL

† PHA ‹ BL § PHAL + PHBL

† PHA1 ‹ A2 ‹ ... ‹ An L § ⁄ni=1 PHAi L

In dieser Zusammenstellung sind A und B Ereignisse des Wahrscheinlichkeitsraums HW, , PL und Ac das Komplement von A.

Beispiel 1

Wie gross ist die Wahrscheinlichkeit, beim n-maligen Würfeln wenigstens eine 6 zu würfeln?

Lösung

Das Ereignis "Würfle mindestens eine 6 bei n-maligem Würfeln" ist das Komplement des Ereignisses A "Würfle nur

die Zahlen 1, 2, 3, 4, 5 bei n-maligem Würfeln".

Der Ergebnisraum W beim n-maligen Würfeln hat die Grösse 6n .

Die Anzahl der möglichen Ergebnisse, das Ereignis A zu erzielen (d.h. die Grösse von A), beträgt 5n , da bei jedem

Wurf nur 5 verschiedene Zahlen möglich sind.

Die Wahrscheinlichkeit, das Ereignis A zu erzielen beträgt demnach H ÅÅÅÅ56 L .

n

Die Wahrscheinlichkeit, das Komplement, d.h. beim n-maligen Würfeln wenigstens eine 6 zu würfeln, beträgt demn

nach 1 - H ÅÅÅÅ56 L und strebt für n gegen ¶ gegen 1.

Beispiel 2

In einer Stadt erscheinen zwei Zeitungen A und B. Die Wahrscheinlichkeit, dass ein Einwohner

- die Zeitung A liest sei 60%;

- die Zeitung B liest sei 50%;

- die Zeitung A oder B oder beide liest sei 90%.

Wie gross ist die Wahrscheinlichkeit, dass ein Einwohner

- a. beide Zeitungen liest;

- b. keine der beiden Zeitungen liest;

- c. nur eine der beiden Zeitungen liest.

Lösung

Wenn A das Ereignis ("Lesen der Zeitung A") und B das Ereignis ("Lesen der Zeitung B") bezeichnet, dann gilt:

a. PHA › BL = PHAL + PHBL - PHA ‹ BL = 60 % + 50 % - 90 % = 20 %

êêê êê de Morgan êêêêêêêêê

b. PHA › BL = PHA ‹ BL = 1 - PHA ‹ BL = 100 % - 90 % = 10 %

c. PHA ‹ BL \ PHA › BL = PHA ‹ BL - PHHA › BL › HA ‹ BLL = PHA ‹ BL - PHA › BL = 90 % - 20 % = 70 %

Skript Statistik und Stochastik

15

Venn Diagramme

Mit Hilfe der Venn Diagramme lassen sich die Beziehungen zwischen Ereignissen, die symbolisch oder in Worten

gegeben sind, auch anschaulich graphisch darstellen.

Siehe dazu im Kapitel "Mengenlehre" des Skripts "Abbildungen".

Skript Statistik und Stochastik

16

3. Elementare Kombinatorik

Einleitung

Nachdem wir verschiedene mathematische (mengentheoretische) Beziehungen besprochen haben, möchten wir einen

etwas genaueren Blick auf verschiedene Zufallsexperimente werfen.

Dabei definieren wir zunächst den für unsere Zufallsexperimente wichtigen Begriff des Laplace Experiments, bei dem

jedes Ergebnis mit der gleichen Wahrscheinlichkeit auftritt.

Wichtige Zufallsexperimente sind auch die sogenannten Bernoulli Experimente, bei dem nur zwei Ergebnisse jedoch

mit unterschiedlicher Wahrscheinlichkeit auftreten können, sowie vor allem die mehrstufigen Bernoulli Experimente,

die aus mehreren Bernoulli Experimenten zusammengesetzt sind.

Anschliessend untersuchen wir im Detail sogenannte Urnenexperimente, bei denen aus einer Urne mit n Kugeln k

Kugeln gezogen und die möglichen resultierenden Anordnungen und deren Wahrscheinlichkeiten studiert werden. Es

gibt dabei verschiedene experimentelle Situationen zu berücksichtigen: mit oder ohne Zurücklegen der Kugel, mit oder

ohne Berücksichtigung der Anordnung sowie mit verschiedenen oder teilweise gleichen Kugeln.

Diese Analyse führt uns ins Gebiet der Kombinatorik. Es lassen sich (für Standardsituationen) explizite Formeln

herleiten, die es ermöglichen auf schnelle Art und Weise die möglichen Ergebnisse verschiedener Zufallsexperimente

und deren Wahrscheinlichkeiten anzugeben.

Es wird weiters dargelegt, dass die gleichen Formeln auch für eine andere experimentelle Situation, nämlich der

Aufgabe, k Kugeln auf n Behälter zu verteilen, angewendet werden können. Auch hier gibt es wieder verschiedene (zu

den Urnenexperimenten analoge) experimentelle Situationen.

Für kompliziertere Situationen in der Praxis (vor allem wenn das Experiment zeitabhängige Aspekte enthält) kann oft

nur eine Simulation des Experiments eine Lösung bringen. Es ist jedoch zu beachten, dass bei solchen Zufallsexperimenten die Anzahl der Möglichkeiten sehr schnell ins Unermessliche steigt, und deshalb die ganzen Berechnungen

(aus Zeit- und Memory Überlegungen) idealerweise in (durch Formeln berechenbare) Teile aufgeteilt werden.

Die verschiedenen in diesem Kapitel besprochenen Zufallsexperimente führen in natürlicher Weise auf diskrete

Verteilungen. Die wichtigsten dieser (theoretisch abgeleiteten) Verteilungen und deren Eigenschaften werden jedoch

erst in den folgenden Kapiteln behandelt.

Laplace Experimente

Laplace Wahrscheinlichkeit

In vielen experimentellen Situationen (wie: würfeln, Münze werfen, Karte ziehen etc.) ist jedes Ergebnis mit der

gleichen Wahrscheinlichkeit zu erwarten.

Die Voraussetzung der Gleichwahrscheinlichkeit heisst Laplace-Annahme.

Zufallsexperimente, bei denen die Laplace-Annahme zugrunde gelegt wird, heissen Laplace-Experimente.

Sei W = 8w1 , w2 , ... wn < die endliche Ergebnismenge eines Zufallsexperiments. Dann heisst die Abbildung P mit:

Anzahl der für das Eintreten von A günstigen Fälle

»A»

PHAL = ÅÅÅÅ

ÅÅ Å = ÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅ " A Õ W

»W»

Anzahl der möglichen Fälle

Laplace-Wahrscheinlichkeit.

Skript Statistik und Stochastik

17

Ein Laplace-Experiment geht also von der Annahme aus, dass nur endlich viele Ergebnisse möglich sind und diese alle

die gleiche Wahrscheinlichkeit haben.

Beim Werfen einer Münze ist jedes der Ergebnisse (Kopf, Zahl) mit der gleichen 50% Wahrscheinlichkeit zu erwarten.

Beim Würfeln ist jede Augenzahl (1, 2, 3, 4, 5, 6) mit der gleichen ÅÅÅÅ16 Wahrscheinlichkeit zu erwarten.

Mehrstufige Laplace Experimente - Baumdiagramme

Vorgänge, die sich aus mehreren Teilvorgängen zusammensetzen, heissen mehrstufige Vorgänge (z.B. 5x würfeln).

Den Ablauf eines mehrstufigen Vorgangs kann man oft übersichtlich als Baumdiagramm darstellen. Nach jedem

Teilvorgang verzweigt sich der Baum.

In die Knoten des Baums trägt man in Kreise das bisherige Ergebnis ein. Von jedem Knoten können Äste abzweigen;

die Äste entsprechen den möglichen Ergebnissen des nächsten Teilvorgangs. An jeden Ast schreibt man die Wahrscheinlichkeit, die besteht um von einem Knoten zum nächsten Knoten zu gelangen. Die Summe der Wahrscheinlichkeiten

bei jedem Knoten beträgt 1.

Zu jedem möglichen Ablauf des Gesamtvorgangs gehört ein Weg durch das Baumdiagramm - ein sogenannter Pfad. Es

gibt zwei Pfadregeln:

In einem Baumdiagramm für einen mehrstufigen Vorgang gilt:

Produktregel: Die Wahrscheinlichkeit eines Pfades ist gleich dem Produkt der Wahrscheinlichkeiten entlang dieses Pfades.

Summenregel: Die Wahrscheinlichkeit eines Ereignisses ist gleich der Summe der Pfadwahrscheinlichkeiten (d.h. gleich der

Summe der Wahrscheinlichkeiten, die für dieses Ereignis günstig sind).

Bernoulli Experimente

Bei einem Bernoulli Experiment interessiert nur, ob ein Ereignis A eintritt oder nicht. Im ersten Fall spricht man von Erfolg

mit der Wahrscheinlichkeit PHAL = p. Im zweiten Fall spricht man von Misserfolg mit der Wahrscheinlichkeit PHAL = 1 - p.

Wird ein Bernoulli Experiment mehrfach durchgeführt, spricht man von einer Bernoulli Kette.

Bernoulli Formel

In einer Bernoulli Kette der Länge n mit der Erfolgswahrscheinlichkeit p gilt:

n!

PHGenau k ErfolgeL = ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅ pk H1 - pLn-k k = 0, 1, ... n

k! Hn-kL!

iny

Statt ÅÅÅÅÅÅÅÅ

Ån!ÅÅÅÅÅÅÅÅÅÅÅ wird meist jj zz (sprich: n über k) geschrieben.

k! Hn-kL!

kk{

Mit Hilfe eines Baumdiagramms kann man diese Formel herleiten, bei der der Binomialkoeffizient die Anzahl der

verschiedenen Wege darstellt, die zu dem Ereignis "Genau k Erfolge" führen.

Summenregel

Bei den weiter unten zu besprechenden Urnenexperimenten wird immer wieder auf die Summenregel und die Produktregel zurückgegriffen. Sie werden in diesem und dem nächsten Abschnitt kurz erläutert.

Summenregel: Die Anzahl der Möglichkeiten n, ein Element aus einer von zwei diskunkten Mengen A und B zu wählen, ist

die Summe der Elemente der beiden Mengen: n = n A + nB

Skript Statistik und Stochastik

18

Diese Regel ist unmittelbar einleuchtend. Bei zwei disjunkten Mengen 8a, b, c< und 8d, e< gibt es insgesamt 5 verschiedene Möglichkeiten ein Element zu wählen, nämlich eines aus der Vereinigungsmenge 8a, b, c, d, e<.

Produktregel

Die Anzahl der Möglichkeiten, aus zwei Mengen ein geordnetes Paar zu wählen, ist gleich der Anzahl der Möglichkeiten, das

erste Element zu wählen, multipliziert mit der Anzahl der Möglichkeiten, das zweite Element zu wählen.

Diese Regel ist auch unmittelbar einleuchtend. Jedes Element der ersten Menge kann mit den Elementen der zweiten

Menge gepaart werden. Z.B. bei den zwei Mengen {a,b} und {c,d} gibt es die Ergebnisse {a,c}, {a,d}, {b,c}, {b,d}.

Permutationen und Binomialverteilung

Einleitung

In vielen Fällen ist zur Berechnung von Wahrscheinlichkeiten ein systematisches Abzählen von Mengen wichtig. Die

Kombinatorik ist das Teilgebiet der Mathematik, das sich damit beschäftigt. Fast alle Zufallsexperimente (mit gleichen

Wahrscheinlichkeiten) lassen sich auf die in den nächstenen Abschnitten besprochenen Urnenmodelle zurückführen.

Darin werden Experimente besprochen wo es darum geht, aus einer Urne, die n (verschiedene oder teilweise gleiche)

Kugeln enthält, k Kugeln zu ziehen (mit und ohne Zurücklegen) und zu bestimmen, wieviele verschiedene Konfigurationen (mit oder ohne Berücksichtigung der Anordnung) möglich sind.

Im Folgenden werden verschiedene Begriffe im Zusammenhang mit Listen von nummerierten Kugeln verwendet, die

hier zusammenfassend kurz erklärt und definiert sind:

Kombinatorik

† Geordnet heisst, dass es auf die Reihenfolge der Elemente ankommt.

† Variation heisst geordnet (d.h. die Reihenfolge wird berücksichtigt, z.B. aufeinanderfolgendes Ziehen).

† Kombination heisst nicht geordnet (d.h. Reihenfolge wird nicht berücksichtigt, z.B. gleichzeitiges Ziehen).

† ein k-Tupel ist eine Liste von k Elementen;

† Ein k-Tupel einer Menge mit n Elementen ist eine geordnete Folge von k Elementen, wobei Elemente auch

mehrfach vorkommen können. k-Tupels können auch als Auswahl mit Wiederholungen bzw.Zurücklegen, oder

als Stichproben oder Variationen mit Wiederholungen aufgefasst werden.

† Eine k-Repetition einer Menge mit n Elementen ist eine ungeordnete Auswahl von k Elementen, wobei Elemente auch mehrfach vorkommen können. k-Repetitionen können auch als Kombinationen mit Wiederholungen

bzw. Zurücklegen aufgefasst werden.

† Eine k-Permutation einer Menge mit n (n ≥ kL Elementen ist eine geordnete Auswahl von k paarweise verschiedenen Elementen aus der Menge. Eine n-Permutation wird auch einfach Permutation genannt. k-Permutationen können auch als Auswahl ohne Wiederholungen bzw. Zurücklegen, oder als Stichproben oder Variationen

ohne Wiederholungen aufgefasst werden.

† Eine k-Kombination einer Menge mit n (n ≥ kL Elementen ist eine ungeordnete Auswahl von k paarweise

verschiedenen Elementen aus der Menge. k-Kombinationen können auch als ungeordnete Auswahl ohne Wiederholungen bzw. Zurücklegen, oder als Kombination ohne Wiederholungen aufgefasst werden.

† n! (gesprochen: n Fakultät) entspricht dem Produkt 1 ä2 ä ... ä n.

Skript Statistik und Stochastik

19

Mengenlehre

† Beachten Sie, dass es bei Mengen auf die Reihenfolge ihrer Elemente nicht ankommt.

† Die Mächtigkeit einer Menge gibt die Anzahl ihrer Elemente an.

† Die Potenzmenge einer Menge ist die Menge aller Teilmengen dieser Menge. Wenn die Menge n Elemente hat, so

hat die Potenzmenge 2n Elemente.

† Begriffe: Vereinigungsmenge, Durchschnittsmenge, Komplementärmenge (Komplement).

Bevor wir diese allgemeinen Urnenexperimente untersuchen, soll jedoch noch auf wichtige Spezialfälle (mit k = n)

eingegangen werden.

Ohne Zurücklegen - alle verschieden

Es gibt n ! mögliche Anordnungen (Variationen), wenn n Kugeln aus einer Urne mit n verschiedenen Kugeln gezogen werden

(ohne Zurücklegen und mit Berücksichtigung der Reihenfolge). Es gibt nur eine Kombination.

Bei der ersten Kugel gibt es n Möglichkeiten, bei der zweiten nur noch (n - 1), etc. bis 1: d.h. die Anzahl der Möglichkeiten ist: n Hn - 1L Hn - 2L ... 2 1 = n!

Zur Angabe dieser Anzahl wurde eine neue Funktion (Fakultät bzw.!) definiert: es gilt

n ! = 1 ä2 ä ... ä n

Die Anzahl der Kombinationen, bei denen es auf die Reihenfolge nicht ankommt, ist gleich 1, da alle Anordnungen

(Variationen) die gleichen Elemente enthalten, nämlich alle n (verschiedenen) Kugeln.

Beispiel

Gegeben sei die Menge 8a, b, c<.

Es gibt die folgenden 3 ! = 6 Permutationen (Variationen): 88a, b, c<, 8a, c, b<, 8b, a, c<, 8b, c, a<, 8c, a, b<, 8c, b, a<<

Es gibt nur eine Kombination: 88a, b, c<<

Ohne Zurücklegen - mehrere Klassen

n!

Es gibt ÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅÅ verschiedene Möglichkeiten n Kugeln, die in m Klassen von je ki Hi = 1, .. mL nicht unterscheidbaren Kugeln

k1 ! k2 ! ... km !

eingeteilt werden können (und ⁄m

i=1 ki = n gilt), anzuordnen.

Es gibt n ! Möglichkeiten n Kugeln anzuordnen. Jede nichtunterscheidbare Art (z.B. Farbe rot) kann auf ki ! verschiedene Arten angeordnet werden, ohne dass man an der Darstellung einen Unterschied bemerkt. Man muss also

durch alle diese ki ! teilen.

n!

10!

Beispiel: 3 blaue und 7 rote Kugeln können auf ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅ = ÅÅÅÅÅÅÅÅ

ÅÅÅ = 120 verschiedene Arten angeordnet werden.

k1 ! k2 !

3! 7!

Ohne Zurücklegen - mit 2 Klassen

Ein wichtiger Spezialfall der vorherigen Situation ist der Fall, wenn zwei Klassen (d.h. m = 2) vorhanden sind.

20

Skript Statistik und Stochastik

n!

n!

Es gibt ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅ = ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅ verschiedene Möglichkeiten n Kugeln, die in 2 Klassen mit Häufigkeit k bzw. n - k eingeteilt werden

k1 ! k2 !

k! Hn-kL!

können, anzuordnen.

i 10 y

10!

Beispiel: Wir können das vorherige Beispiel verwenden und erhalten wiederum jj zz = ÅÅÅÅÅÅÅÅ

ÅÅÅ = 120 .

k 3 { 3! 7!

Urnenexperimente bei verschiedenen Elementen

Urnenexperimente

In diesem Kapitel werden wir zunächst eine Urne mit n verschiedenen (z.B. von 1 bis n durchnummerierten) Kugeln

betrachten und wir ziehen zufällig k-mal nacheinander eine Kugel aus der Urne. Die möglichen Ergebnisse und die

Mächtigkeit des Ergebnisraumes hängen dabei entscheidend von der Art der Ziehung ab.

Es kann die Reihenfolge der gezogenen Elemente berücksichtigt werden (man spricht dann von Variation oder geordneter Liste) oder nicht (man spricht dann von Kombination oder ungeordneter Liste). Die Anzahl der Variationen ist

grösser als die (oder gleich der) Anzahl der Kombinationen. Dementsprechend ist die Wahrscheinlichkeit, ein bestimmtes Ergebnis zu erzielen, bei der Variation kleiner als die (oder gleich der) Wahrscheinlichkeit bei der entsprechenden Kombination.

Bei einer Variation muss notwendigerweise nacheinander gezogen werden, bei einer Kombination könnte auch

gleichzeitig gezogen werden.

Beispiel: Bei der Variation unterscheidet man zwischen den Ergebnissen 82, 4, 8< und 84, 8, 2<, bei der Kombination

werden sie jedoch als das gleiche Ergebnis betrachtet.

Eine weitere Unterscheidung besteht darin, ob nach dem Ziehen der Kugel die Kugel zurückgelegt wird oder nicht.

Dies führt auf die Unterscheidung mit / ohne Zurücklegen. Wenn alle Elemente verschieden sind, hat man im zweiten

Fall auch im Ergebnis nur unterschiedliche Kugeln.

Diese zwei Unterscheidungen (Variation oder Kombination, mit oder ohne Zurücklegen) führen auf insgesamt 4

verschiedene experimentelle Situationen, die in diesem Kapitel genauer behandelt werden. In einem späteren Abschnitt

wird ausserdem noch die Unterscheidung gemacht, ob alle Kugeln unterschiedlich sind oder nicht. Dies führt auf

weitere unterschiedliche experimentelle Situationen.

Mit Zurücklegen und Geordnet (k-Tupel)

Experiment: Aus einer Urne mit n verschiedenen Kugeln werden k Kugeln ausgewählt. Nach jedem Zug wird die Kugel

wieder zurückgelegt. Jede unterschiedliche Anordnung von k Kugeln wird gezählt.

Anzahl Möglichkeiten:

nk = ´¨¨¨¨

n ¨¨¨≠...¨¨¨¨¨nÆ

k-mal

Es gibt nk k-Tupel, da es n Möglichkeiten zur Wahl des ersten Elements der Folge, n Möglichkeiten zur Wahl des

zweiten Elements der Folge, etc. ... gibt. Jede Möglichkeit tritt mit der Wahrscheinlichkeit ÅÅÅÅ1n auf, jedes k-Tupel tritt

mit der gleichen Wahrscheinlichkeit H ÅÅÅÅ1n L auf.

k

Beispiel

Gegeben sei die Menge 8a, b, c<.

21

Skript Statistik und Stochastik

Es gibt die folgenden nk = 32 = 8 Möglichkeiten, aus der Menge mit n = 3 Elementen k = 2 Elemente zu ziehen:

88a, a<, 8a, b<, 8a, c<, 8b, a<, 8b, b<, 8b, c<, 8c, a<, 8c, b<, 8c, c<<

Mit Zurücklegen und Ungeordnet (k-Repetition)

Experiment: Aus einer Urne mit n verschiedenen Kugeln werden k Kugeln ausgewählt. Nach jedem Zug wird die Kugel

wieder zurückgelegt. Von Tupels, die die gleichen Elemente enthalten, wird nur eines gezählt.

Anzahl Möglichkeiten:

ij n + k - 1 yz

j

z

k

k

{

Diese Herleitung ist ein wenig komplizierter. Wir können jedoch folgende Überlegung anstellen.

Da die Reihenfolge nicht interessiert, können wir eine Strichliste anlegen: d.h. wir schreiben der Reihe nach für jede

der n Kugeln Striche entsprechend der Anzahl mit der diese Kugel gezogen wurde und trennen diese Gruppe von

Strichen für benachbarte n jeweils durch ein Trennzeichen. Wir haben also insgesamt k Striche plus n - 1 Trennzeichen, die wir auf Hn + k - 1L ! verschiedene Arten anordnen können. Da jedoch die Striche und Zwischenräume nicht

unterscheidbar sind, müssen wir diese Anzahl durch k ! und Hn - 1L! teilen und erhalten als Ergebnis

i k + n - 1 yz

Hk+n-1L!

ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅÅ = jj

z.

k! Hn-1L!

k

k

{

Beispiel

Gegeben sei die Menge 8a, b, c<.

Hk+n-1L!

4!

Es gibt die folgenden ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅÅ = ÅÅÅÅÅÅÅÅ

ÅÅÅ = 6 Möglichkeiten, aus der Menge mit n = 3 Elementen k = 2 Elemente zu

2! 2!

k! Hn-1L!

ziehen:

88a, a<, 8a, b<, 8a, c<, 8b, b<, 8b, c<, 8c, c<<

Ohne Zurücklegen und Geordnet (k-Permutation)

Experiment: Aus einer Urne mit n verschiedenen Kugeln werden k Kugeln ausgewählt. Nach jedem Zug wird die Kugel nicht

wieder zurückgelegt. Jede unterschiedliche Anordnung von k Kugeln wird gezählt.

Anzahl Möglichkeiten:

n!

ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅ = n´¨¨¨¨¨¨¨¨¨¨¨¨¨¨¨¨

Hn - 1L

...¨¨≠Hn

- k +¨¨¨¨1L

¨¨¨¨¨¨¨¨

¨¨¨¨¨¨¨¨¨¨¨¨¨¨¨¨

¨¨¨¨Æ

Hn-kL!

k-mal

n!

Es gibt ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅ k-Permutationen, da es n Möglichkeiten zur Wahl des ersten Element der Folge, (n - 1) Möglichkeiten

Hn-kL!

n!

zur Wahl des zweiten Elements, etc. ... gibt, also: n Hn - 1L ... Hn - k + 1L = ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅ .

Hn-kL!

Spezialfall k = n

Es gibt n ! n-Permutationen bzw. Permutationen. Beim ersten Ziehen gibt es n Möglichkeiten, beim zweiten n - 1, etc.

.... und schliesslich beim letzten Zug eine Möglichkeit. Die Totalanzahl der Möglichkeiten beträgt demnach

n Hn - 1L ... 1 = n !

Beispiel

Gegeben sei die Menge 8a, b, c<.

22

Skript Statistik und Stochastik

3!

n!

Es gibt die folgenden ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅ = ÅÅÅÅ

ÅÅ = 6 Möglichkeiten, aus der Menge mit n = 3 Elementen k = 2 Elemente zu ziehen:

Hn-kL!

1!

88a, b<, 8b, a<, 8a, c<, 8c, a<, 8b, c<, 8c, b<<

Ohne Zurücklegen und Ungeordnet (k-Kombinationen)

Experiment: Aus einer Urne mit n verschiedenen Kugeln werden k Kugeln ausgewählt. Nach jedem Zug wird die Kugel nicht

wieder zurückgelegt. Von Tupels, die die gleichen Elemente enthalten, wird nur eines gezählt.

Anzahl Möglichkeiten:

n!

ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅ

k! Hn-kL!

n!

Es gibt ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅ k-Kombinationen, da jeweils k ! k-Permutationen zu einer k-Kombination zusammengefasst werden

k! Hn-kL!

können.

Beispiel

Gegeben sei die Menge 8a, b, c<.

3!

Es gibt die folgenden ÅÅÅÅÅÅÅÅ

Ån!ÅÅÅÅÅÅÅÅÅÅÅ = ÅÅÅÅÅÅÅÅ

ÅÅÅ = 3 Möglichkeiten, aus der Menge mit n = 3 Elementen k = 2 Elemente zu

k! Hn-kL!

2! 1!

ziehen:

88a, b<, 8a, c<, 8b, c<<

Zusammenfassung - Ziehen mit verschiedenen Elementen

In den vorigen Abschnitten wurden die möglichen Anordnungen von k Elementen aus einer Menge bzw. Liste mit n

verschiedenen Elementen diskutiert.

Übersichtsweise kann dies folgendermassen zusammengefasst werden:

Variation

HgeordnetL

Kombination

HungeordnetL

mit Zurücklegen ohne Zurücklegen

HmehrfachL

HverschiedenL

nk

J

n+k−1

N

k

n!

Hn−kL!

J

n

N

k

Bei der Benutzung dieser Tabelle ist zu berücksichtigen, dass diese expliziten Formeln gelten, wenn alle Elemente im

Ausgangstopf verschieden sind.

Verteilungen in Behälter

In den bisherigen Experimenten hatten wir n verschiedene Kugeln in einer Urne und haben die Anzahl Möglichkeiten

berechnet, k Kugeln daraus zu entnehmen und anzuordnen.

Die Anzahl der möglichen Anordnungen ergab sich dabei z.B. beim Fall mit Zurücklegen und unter Berücksichtigung

der Reihenfolge zu:

23

Skript Statistik und Stochastik

W = {w » w = (a1 , a2 , ... ak ), ai = 1, ... n}

wobei hier ai die Nummer (von 1 bis n) der i-ten gezogenen Kugel angibt.

Nun betrachten wir ein anderes Experiment, und zwar sollen k Kugeln auf n Behälter verteilt werden. Die Anzahl der

möglichen Verteilungen ist nun z.B. für den Fall mit Mehrfachbelegung und unterscheidbaren Objekten gleich:

W = {w » w = (a1 , a2 , ... ak ),

ai = 1, ... n}

wobei hier ai für jede Kugel mit der Nummer i den Behälter (von 1 bis n) angibt.

Es ist nun bemerkenswert, dass beide Experimente die gleichen Formeln liefern. Aber Achtung: die Anzahl der Kugeln ist im

ersten Fall gleich n, im zweiten Fall gleich k.

Die Tatsache, dass die gleichen Formeln angewandt werden können, gilt nicht nur für den betrachteten Fall (mit

Zurücklegen und unter Berücksichtigung der Anordnung), sondern in allen vier Fällen, wenn folgende Zuordnung

gemacht wird:

Experiment Anordnungen Experiment Verteilungen

n Kugeln

k Kugeln

davon k Kugeln ziehen

auf n Behälter verteilen

mit Zurücklegen

mit Mehrfachbelegung

ohne Zurücklegen

mit Einfachbelegung

mit Berücksichtigung der Reihenfolge

unterscheidbare Objekte

ohne Berücksichtigung der Reihenfolge

nicht unterscheidbare Objekte

Beispiel

Auf wieviele Arten können die (unterscheibaren) Objekte {a,b} auf drei Behälter mit Einfachbelegung verteilt werden?

n!

3!

ÅÅÅÅÅÅ = ÅÅÅÅ

ÅÅ = 6

† Die Formel lautet (k Kugeln und n Behälter): ÅÅÅÅÅÅÅÅ

Hn-kL!

1!

† Die Lösung lautet: auf 6 verschiedene Arten, nämlich {a,b,-}, {a,-,b}, {b,a,-}, {-,a,b}, {b,-,a}, {-,b,a}

Der analoge Fall wäre: auf wieviele Arten können zwei Objekte aus einer Urne mit den drei Objekten {a,b,c} gezogen

und angeordnet werden (ohne Zurücklegen und unter Berückischtigung der Anordnung).

n!

3!

† Die Formel lautet (n Kugeln und k-mal Ziehen): ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅ = ÅÅÅÅ

Å =6

Hn-kL!

1!

† Die Lösung lautet: auf 6 verschiedene Arten, nämlich {a,b}, {a,c}, {b,a}, {b,c}, {c,a}, {c,b}

Urnenexperimente bei teilweise gleichen Elementen

Einleitung

Bie den bisherigen Urnenexperimenten wurde immer (mit Ausnahme des Abschnitts "Permutationen und Binomialverteilung") vorausgesetzt, dass sich im Topf, aus dem die Elemente gezogen werden, nur unterschiedliche Elemente

befinden. Wir haben die folgenden 22 Fälle unterschieden:

† Erstens kann nach dem Ziehen die Kugel zurückgelegt werden oder auch nicht (mit anderen Worten Wiederholung ist erlaubt oder auch nicht). Wenn die Kugel zurückgelegt wird, ändert sich die Wahrscheinlichkeit für das

Ziehen jeder Kugel nicht, andernfalls schon.

24

Skript Statistik und Stochastik

† Zweitens kann es auf die Reihenfolge der gezogenen Kugeln ankommen (Variation) oder auch nicht (Kombination). Eine Variation kann durch aufeinanderfolgendes Ziehen, eine Kombination durch gleichzeitiges Ziehen

simuliert werden.

Im Folgenden wird nun eine neue experimentelle Situation untersucht, nämlich ...

† Drittens können alle Kugeln verschieden sein oder es können einzelne Kugeln gleich sein (z.B. gleiche Nummer

oder gleiche Farbe). Wenn einzelne Kugeln gleich sind, können sie in Kategorien oder Klassen zusammengefasst

werden.

... womit nun insgesamt 23 Fälle zu unterscheiden sind.

Dies ermöglicht neue Fragestellungen: z.B. auf wie viele Arten können (mit Zurücklegen) drei rote Kugeln gezogen

werden, wenn sich im Topf zwei rote und drei blaue Kugeln befinden?

Allgemeiner formuliert haben wir nun n Kugeln, die in m verschiedene Klassen zusammengefasst werden können und

ni die Anzahl der Kugeln in jeder Klasse angibt, wobei gilt: ⁄m

i=1 ni = n.

Es kann jetzt schon vorausgesagt werden, dass dann die oben hergeleiteten Formeln für die Anzahl der Auswahlen

nicht mehr gelten bzw. in der Bedeutung der Variablen angepasst werden müssen.

Auf diese Formeln wird im Weiteren näher angegangen.

Für die Zahl der möglichen Anordnungen von Objekten aus mehreren Klassen, die untereinander jeweils innerhalb

einer Klasse nicht unterscheidbar sind, ist es hilfreich, zunächst die mögliche Zahl der Anordnungen der Objekte zu

betrachten und dann zu überlegen, wieviele dieser Anordnungen nicht unterscheidbar sind. Die Zahl der möglichen

Anordnungen bei unterscheidbaren Objekten wird dann durch die Zahl der nicht unterscheidbaren Anordnungen

dividiert.

Ziehen mit Zurücklegen - Variationen und Kombinationen

Experiment

Aus einer Urne mit n (teilweise gleichen) Kugeln, die in m Kategorien eingeteilt werden können, werden k Kugeln ausgewählt.

Nach jedem Zug wird die Kugel wieder zurückgelegt.

Anzahl Variatonen

mk

Anzahl Kombinationen

ij m + k - 1 yz

j

z

k

k

{

Beim ersten Zug haben wir m Möglichkeiten (die Wahrscheinlichkeit, dass eine Kugel einer bestimmten Klasse

gezogen wird, hängt natürlich von der Grösse der Klasse ab), ebenso beim zweiten, ... bis zum k-ten Zug. Dies liefert

mk verschiedene Variationen.

Die Herleitung der Formel für die Anzahl Kombinationen geht analog zum Fall der unterscheidbaren Kugeln, nur muss

auch hier n (die Anzahl der Kugeln) durch m (die Anzahl der Kategorien) ersetzt werden.

Beispiel

Gegeben sei die Liste folgender Elemente (keine Menge!): l = 8a, b, b, c<

Es gibt die folgenden mk = 32 = 9 Möglichkeiten, aus der Menge mit m = 3 Kategorien k = 2 geordnete Elemente zu

ziehen:

88a, a<, 8a, b<, 8a, c<, 8b, a<, 8b, b<, 8b, c<, 8c, a<, 8c, b<, 8c, c<<

25

Skript Statistik und Stochastik

Beispiel

Gegeben sei die Liste folgender Elemente (keine Menge!): l = 8a, b, b, c<

i m + k - 1 yz ij 4 yz

Es gibt die folgenden jj

z = j z = 6 Möglichkeiten, aus der Menge mit m = 3 Kategorien k = 2 ungeordnete

k

k

{ k2{

Elemente zu ziehen:

88a, a<, 8a, b<, 8a, c<, 8b, b<, 8b, c<, 8c, c<<

Ziehen ohne Zurücklegen - Variation und Kombination

Experiment

Aus einer Urne mit n (teilweise gleichen) Kugeln, die in m Kategorien eingeteilt werden können, werden k Kugeln ausgewählt.

Nach jedem Zug wird die Kugel nicht wieder zurückgelegt.

Anzahl Variatonen

keine Formel verfügbar

Anzahl Kombinationen

keine Formel verfügbar

Beispiel

Gegeben sei die Liste folgender Elemente (keine Menge!): l = 8a, b, b, b<

Es gibt die folgenden 3 Möglichkeiten, aus der Menge mit m = 2 Kategorien k = 2 geordnete Elemente zu ziehen:

88a, b<, 8b, a<, 8b, b<<

Beispiel

Gegeben sei die Liste folgender Elemente (keine Menge!): l = 8a, b, b, b<

Es gibt die folgenden 2 Möglichkeiten, aus der Menge mit m = 2 Kategorien k = 2 ungeordnete Elemente zu ziehen:

88a, b<, 8b, b<<

26

Skript Statistik und Stochastik

4. Bedingte Wahrscheinlichkeiten

Einleitung

Bislang haben wir uns mit Fragestellungen wie ...

† "Wie gross ist die Wahrscheinlichkeit, dass bei zweimaligem Würfeln eine Summe grösser als 9 gewürfelt wird?".

... beschäftigt.

In diesem Kapitel sollen nun Fragen der folgenden Art untersucht werden:

† "Wie gross ist die Wahrscheinlichkeit, dass bei zweimaligem Würfeln eine Summe grösser als 9 gewürfel wird,

wenn wir beim ersten Wurf keine 6 erreicht haben?".

Es wird nun also nach der Wahrscheinlichkeit eines Ereignisses gesucht, wenn Zusatzinformationen vorhanden sind,

die den Ergebnisraum einschränken. Die Wahrscheinlichkeit des Ereignisses wird damit nicht mehr in Bezug zur

Mächtigkeit des ganzen Ergebnisraums gesetzt, sondern in Bezug zu einer Teilmenge des Ergebnisraums.

Bedingte Wahrscheinlichkeit

Dies führt uns auf folgende Definition:

Gegeben sei ein diskreter Wahrscheinlichkeitsraum HW, , PL und zwei beliebige Ereignisse A und B mit PHBL > 0. Dann

heisst

PHA › BL

PHA » BL = ÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅÅÅ

PHBL

die bedingte Wahrscheinlichkeit von A unter der Bedingung B. (oder lies: P von A unter der Bedingung B). Die bedingte

Wahrscheinlichkeit PHA » BL gibt die Wahrscheinlichkeit für das Eintreten von A an, wenn die Teilinformation "B ist

eingetreten" vorliegt.

Statt PHA » BL schreibt man auch PB HAL.

Beachte: Die bedingte Wahrscheinlichkeit PHA » BL wird leicht mit der Wahrscheinlichkeit des Durchschnitts

PHA › BL verwechselt.

Beispiel 1: wie gross ist die Wahrscheinlichkeit, dass eine 1 gewürfelt wurde, wenn wir wissen, dass eine ungerade

P HA › BL

1ê6

1

Zahl gewürfelt wurde? Die Antwort lautet nun P HA » BL = = P HBL

1ê2 = 3 , da der Ausgang (würfle eine 1)

zu den drei möglichen Ausgängen (1, 3, 5) in Beziehung gesetzt werden muss.

Beispiel 2: wie gross ist die Wahrscheinlichkeit, dass eine 2 gewürfelt wurde, wenn wir wissen, dass eine ungerade

Zahl gewürfelt wurde? Die Antwort lautet nun 0, da der Ausgang (würfle eine 2) nicht möglich ist (2 ist keine

ungerade Zahl, bzw. A › B = {} ).

Mit obigen Definitionen lassen sich (relativ einfach) verschiedene Formeln herleiten.

Für zwei Ereignisse A und B mit PHBL > 0 gilt:

Multiplikationsformel:

PHB »AL PHAL

PHA » BL = ÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅ

PHBL

PHA › BL = PHA » BL PHBL

Allgemeine Multiplikationsformel:

PHAn » A1 › ... › An-1 L

PHA1 › A1 › ... › An L = PHA1 L PHA2 » A1 L PHA3 » A1 › A2 L ...

27

Skript Statistik und Stochastik

Für den Fall, dass die Ereignisse A1 , A2 ... An eine Partition von W ergeben (d.h. sie schliessen sich gegenseitig aus

und ihre Vereinigung ergibt W), gelten weiter die beiden Formeln:

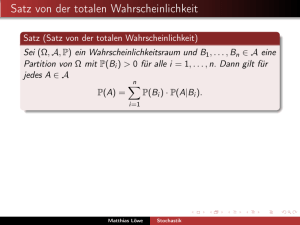

PHBL = ⁄ni=1 PHB » Ai L PHAi L

Formel von der totalen Wahrscheinlichkeit:

Formel von Bayes:

PHB »Ak L PHAk L

PHAk » BL = ÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅÅ

ÅÅÅÅÅÅÅÅÅÅ

⁄n PHB »A L PHA L

i=1

i

i

Beispiel

Zwei Laplace-Würfel, ein grüner und ein roter, werden einmal gleichzeitig geworfen.

Frage 1: Wie groß ist die Wahrscheinlichkeit, dass die Augensumme beider Spielwürfel grösser als 9 ist?

Antwort 1: Sei A das Ereignis „die Augensumme ist grösser als 9“. Dann ergibt sich wegen

A = 8H4, 6L, H6, 4L, H5, 5L, H5, 6L, H6, 5L, H6, 6L<,

»A» = 6

und

» W » = 36 die

Wahrscheinlichkeit

PHAL = 6 ê 36 = 1 ê 6.

Frage 2: Wie groß ist die Wahrscheinlichkeit, dass die Augensumme beider Spielwürfel grösser als 9 ist, wenn man

schon weiss, dass der grüne Würfel keine „6“ zeigt?

Antwort 2: Die Bedingung B „der grüne Würfel zeigt keine 6“ reduziert die Anzahl der möglichen Fälle von 36 auf