Höhere Mathematik I - Universität der Bundeswehr München

Werbung

Fakultät für Luft- und Raumfahrttechnik

Institut für Mathematik und Rechneranwendung

Universität der Bundeswehr München

Höhere Mathematik I

(Vorlesungsskript)

Univ. Prof. Dr. sc. math. K. Marti

2

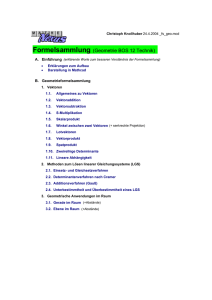

Inhaltsverzeichnis

I. Vektoren im

Rn

1. Der geometrische Vektorbegriff — Vektoralgebra

1.1. Skalare Größen oder Skalare . . . . . . . . . . . . . .

1.2. Vektoren . . . . . . . . . . . . . . . . . . . . . . . . .

1.2.1. Geometrische Darstellung von Vektoren . . . .

1.2.2. Addition von Vektoren . . . . . . . . . . . . .

1.2.3. Multiplikation eines Vektors mit einem Skalar

7

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

9

9

9

9

12

14

2. Zahlen-n-Tupel

17

2.1. Darstellung eines Vektors ~x im kartesischen Koordinatensystem . . 17

2.2. Zahlen–n–Tupel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

3. Multiplikation von n–Tupel bzw. Vektoren

3.1. Das Skalarprodukt . . . . . . . . . . . . . . . . . . . .

3.1.1. Das Skalarprodukt im Raum E 3 der Vektoren ~x,

3.1.2. Das Skalarprodukt im Rn . . . . . . . . . . . .

3.2. Die Norm (Betrag) eines n–Tuppels . . . . . . . . . . .

3.3. Die Schwarzsche Ungleichung . . . . . . . . . . . . . .

3.4. Das Vektorprodukt . . . . . . . . . . . . . . . . . . . .

3.4.1. Eigenschaften des Vektorproduktes . . . . . . .

. . . .

~y , . . .

. . . .

. . . .

. . . .

. . . .

. . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

25

25

25

29

31

31

33

34

4. Lineare Gleichungssysteme (LGS) — Teil I

37

4.1. Lineare Gleichungssysteme (LGS) . . . . . . . . . . . . . . . . . . . 38

4.1.1. Grundlegende Eigenschaften linearer Gleichungssysteme . . . 40

4.1.2. Darstellung eines LGS als n-Tupel - oder Vektorgleichung . . 44

II. Matrizen

45

5. Der Matrizenbegriff

47

3

Inhaltsverzeichnis

6. Operationen mit Matrizen

51

7. Die Inverse einer Matrix

55

8. Rang von Matrizen

8.1. Berechnung des Ranges einer (m, n)-Matrix A

8.1.1. Treppenmatrizen . . . . . . . . . . . .

8.1.2. Elementare Umformung von Matrizen .

8.1.3. Berechnung von RgA . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

59

60

60

61

62

9. Lösungsverfahren für LGS

69

9.1. Beschreibung der praktischen Durchführung des Lösungsverfahrens:

Gauss–Algorithmus . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

10.Determinanten

77

10.1. Cramersche Regel zur theoretischen Lösung von LGS: . . . . . . . . 82

III. Vektorräume

11.Definition des abstrakten Vektorraumes (VR)

Begriffen aus dem Rn

11.1. Dimensionsberechnung . . . . . . . . . . . .

11.2. Berechnung einer Basis von U . . . . . . . .

11.3. Berechnung von Orthonormalbasen . . . . .

11.3.1. Bedeutung von Orthonormalbasen . .

11.3.2. Konstruktion einer Orthonormalbasis

83

und Übertragung von

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

85

92

93

97

98

98

12.Lineare Abbildungen

103

12.1. Matrixdarstellung linearer Abbildungen . . . . . . . . . . . . . . . . 104

12.2. Produkte linearer Abbildungen . . . . . . . . . . . . . . . . . . . . 106

13.Basis– und Koordinatentransformationen

13.1. Basistransformationen und lineare Abbildungen

13.1.1. Transf. der Basis von Y . . . . . . . . .

13.1.2. Transf. der Basis von X . . . . . . . . .

13.1.3. Basistransf. von X und Y . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

IV. Eigenwerte und Eigenvektoren, Quadratische Formen

4

.

.

.

.

.

.

.

.

111

. 115

. 116

. 117

. 118

129

Inhaltsverzeichnis

14.Eigenwerte, Eigenvektoren, Quadratische Formen

131

14.1. Eigenwerte und Eigenvektoren . . . . . . . . . . . . . . . . . . . . . 131

14.2. Berechnung der Eigenvektoren zu einem Eigenwert . . . . . . . . . 133

14.3. Eigenwerte symmetrischer Matrizen . . . . . . . . . . . . . . . . . . 134

15.Hauptachsentransformation

139

15.1. Hauptachsentransformation quadratischer Formen . . . . . . . . . . 140

15.1.1. Basistransformation (Hauptachsentransformation) . . . . . . 141

15.2. Definitheitskriterien . . . . . . . . . . . . . . . . . . . . . . . . . . . 143

16.Norm einer Matrix

147

16.1. Eigenschaften der Operatornorm . . . . . . . . . . . . . . . . . . . . 148

16.2. Berechnung der Operatornorm . . . . . . . . . . . . . . . . . . . . . 150

Index

152

5

Inhaltsverzeichnis

6

Teil I.

Vektoren im

Rn

7

1. Der geometrische Vektorbegriff

— Vektoralgebra

Zur Beschreibung und theoretischen Erfassung physikalisch – technischer Beziehungen und Vorgänge (Prozesse) mit Hilfe mathematischer Modelle benötigt man

mathematische Begriffe, die alle wesentlichen Eigenschaften der betrachteten physikalischen Größen eindeutig erfassen.

Betrachtet man Größen, die in Naturwissenschaft, Technik und Ökonomie vorkommen, so findet man Skalare und Vektoren.

1.1. Skalare Größen oder Skalare

Skalare Größen oder Skalare sind z.B. Länge, Masse, Zeit, Temperatur, Energie,

Leitvermögen, Elektrizitätsmenge u.s.w.. Nach Festlegung einer Maßeinheit sind

skalare Größen eindeutig bestimmt durch eine Maßzahl λ. Maßzahlen sind reelle

Zahlen. Skalare lassen sich also auf der Zahlengeraden darstellen. Die reelle Zahl

λ gibt die Quantität der skalaren Größe an, die Maßeinheit gibt die qualitativen

Merkmale der skalaren Größen an.

Einheit

0

1

λ

Zahlengerade

1.2. Vektoren

Vektoren sind z.B. Kraft, Geschwindigkeit, Beschleunigung, Impuls, Strömung

u.s.w.. Größen, zu deren Beschreibung neben einer skalaren Größenangabe (Abmessung oder Betrag) zusätzlich eine Richtungsangabe erforderlich ist, heißen Vektoren.

1.2.1. Geometrische Darstellung von Vektoren

Vektoren werden durch gerichtete Strecken dargestellt, wobei die Länge der gerichteten Strecke die Größenordnung (Abmessung oder Betrag) des Vektors angibt.

1. Der geometrische Vektorbegriff — Vektoralgebra

Definition 1.1 (gerichtete Strecke) Für zwei beliebige Punkte P1 , P2 im Raum

−→

(Ebene, Geraden) sei P1 P2 die von P1 nach P2 gerichtete Strecke (der von P1

nach P2 weisende Pfeil).

−→

1

P2

P1 P2

P1

−→

P1 P2 ist eindeutig bestimmt durch:

• Anfangs- und Endpunkt P1 , P2 oder

• Anfangspunkt P1 und Länge und Richtung des Pfeils

Zum Vektorbegriff kommt man durch Betrachtung der gerichteten Strecken, die

äquivalent“ sind:

”

−→

Definition 1.2 (Äquivalent gerichtete Strecken) Zwei gerichtete Strecken P1 P2 ,

−→

−→

−→

Q1 Q2 nennt man äquivalent, in Zeichen P1 P2 ∼ Q1 Q2 , wenn sie dieselbe Länge

und dieselbe Richtung haben. Äquivalente Strecken können also durch Parallelverschiebung ineinander übergeführt werden.

Q0

`1

@`````

``

P

@

Q

P20 ``````

1 2

Q0000

`

@ 1

1XXX

1

Q0

@

@ X @

@

R

@

2 XXX

``

00 @ P 0 @

X

`

```

X @ P 000

Q1

1 X

Q000 ``` X

X

P1 @

@ 2

@

(

X

1

(

X

`(

@ XX 1 @

`

((

`

@

@

(

@

`@

(

X

(

`

R

@

R

@

`

XX@

(000

00

Q0000

((P

@

@

X(

2

@P2

(

X

(

X

(

Q

1

(

2

X

@

@ @

@((X

(

1(

(( @ @

@

R(((((

@

R

@

(

(

@

((

(

@(

(

Q000

Q002

2

P100

Äquivalent gerichtete Strecken werden zu sogenannten Äquivalenzklassen zusammengefasst.

Definition 1.3 (Äquivalenzklasse, Vektor) Unter einer Äquivalenzklasse, bezeichnet durch ~x, ~y , ~z, ~u, . . ., versteht man eine Menge gerichteter Strecken, so dass

−→

−→

P1 P2 , Q1 Q2 ∈ ~x

−→

⇐⇒

~x heißt dann auch freier Vektor (oder kurz Vektor).

10

−→

P1 P2 ∼ Q1 Q2

1.2. Vektoren

−→

Bemerkung: Für irgendein festes P1 P2 ∈ ~x gilt

−→

−→

−→

~x = {Q1 Q2 : Q1 Q2 ∼ P1 P2 }.

Man schreibt

−→

~x = [P1 P2 ]

−→

und sagt, der freie Vektor ~x werde durch die gerichtete Strecke P1 P2 repräsentiert.

P20000

P20

1Q

1PP

PP

Q

−→

P

P

Q

P10000

P10

PP

Q P1 P2

P

PP

1

Q

Q

PP

Q

P 00

Q

PP

2

Q

QQ PP

QQ

P

1

Q

P100

QQ

P2000

QQ

P1000

−→

kurz: ~x = [P1 P2 ]

1

P2

~x

P1

Weitere Bezeichnungsweisen für freie Vektoren:

• deutsche Buchstaben

• Fettdruck a, b

Definition 1.4 (Ursprung,Ortsvektor) Sei O ein beliebiger, aber fester Punkt

des Raumes (Ebene, Geraden). O heißt Ursprung oder Nullpunkt. Die gerich−→

−→

teten Strecken OP , OQ, . . . mit dem Ursprung O als Anfangspunkt heißen Ortsvektoren.

11

1. Der geometrische Vektorbegriff — Vektoralgebra

−→

Sei ~x = [P1 P2 ] ein beliebiger freier Vektor.

P2

*hhhhhh

h

~x hhh P hhh

h

* h

hhh

hh

P1 hh

h

h

hhhh

hhhh

hhh

hh O (Ursprung)

−→

Durch Parallelverschiebung von P1 P2 in den Ursprung O findet man einen Punkt

P , so dass

−→

−→

P1 P2 ∼ OP .

Es gilt also

−→

~x = [OP ],

d.h. freie Vektoren können durch Ortsvektoren repräsentiert werden.

1.2.2. Addition von Vektoren

−→

−→

−→

Seien ~x = [OP ], ~y = [OQ] zwei freie Vektoren, die durch die Ortsvektoren OP

−→

bzw. OQ repräsentiert werden.

Parallelogrammkonstruktion gemäß:

Newtonschem Kräfteparallelogramm

P = O00

~x 3PPP

P

PP

PP

PP

O

PP

P

~x + ~y

PP

P

P

-P

0P

P

PP

PP

PP

P

PP

P

~y

PP

P

PP

P

P

q

Q = O0

12

Q00

1.2. Vektoren

−→

Der Ortsvektor OP werde parallel verschoben

−→

OP

−→

−→ O0 P 0

−→

bis sein Anfangspunkt O0 mit dem Endpunkt Q von OQ übereinstimmt. Oder:

−→

OQ werde parallel verschoben

−→

−→

OQ −→ O00 Q00

−→

bis sein Anfangspunkt O00 mit dem Endpunkt P von OP übereinstimmt. Auch:

−→

OP wird im Punkt Q abgetragen.

−→

−→

Definition 1.5 (Summe) Seien ~x = [OP ] und ~y = [OQ] und R := P 0 = Q00

−→

wie im Newtonschen Kräfteparallelogramm konstruiert. Dann heißt ~x + ~y := [OR]

Summe von ~x und ~y , es gilt also ~x + ~y = [OP 0 ] = [OQ00 ]

Der Nullvektor ~0 wird repräsentiert durch eine Strecke deren Anfangs- und Endpunkt zusammenfallen, es gilt also

Definition 1.6 (Nullvektor) Der Nullvektor ist definiert durch ~0 = [P P ] =

[OO].

Der Nullvektor hat die Länge 0 und seine Richtung ist unbestimmt.

Definition 1.7 (Negative) Der Gegenvektor oder das Negative −~x zu einem

−→

−→

beliebigen Vektor ~x = [P1 P2 ], ist definiert durch −~x := [P2 P1 ].

((

*

(((

(

(

(

P

(

(

((

P(

2 (((

*(

r

H

HH

~x

~x HH

H

−~x (((((

O

((

(

(

(

(

(((

(

P1 rH

((

−~

H

x

HH

HH

P0

Es gelten folgende Rechenregeln

13

1. Der geometrische Vektorbegriff — Vektoralgebra

Satz 1.1 Für beliebige Vektoren ~x, ~y , ~z gilt

V 1) ~x + ~y = ~y + ~x

(Kommutativgesetz)

V 2) (~x + ~y ) + ~z = ~x + (~y + ~z)

V 3) ~x + ~0 = ~x

(Assoziativgesetz)

V 4) ~x + (−~x) = ~0

Bemerkung: Wegen (V2) schreibt man

(~x + ~y ) + ~z = ~x + ~y + ~z.

(Weglassen der Klammern)

Definition 1.8 (Differenz) Unter der Differenz ~x − ~y zweier Vektoren ~x, ~y versteht man den Vektor

~x − ~y := ~x + (−~y ).

Es gilt also für jedes ~x, ~y :

~x − ~x = ~x + (−~x) = ~0

(~x − ~y ) + ~y = (~x + (−~y )) + ~y = ~x

(gemäß Satz 1.1)

y

X

X

y

6 XXXX −~

XXX

P

XXX

XX

>

6 XXXX

XXX

XX

X

~

x

−

~

y

:

~x − ~y

~x ~x + ~y XX

XXX

O

XX

XXX

X

~y

z

X

Q

1.2.3. Multiplikation eines Vektors mit einem Skalar

−→

Definition 1.9 (λ-faches eines Vektors) Sei ~x = [P1 P2 ] irgend ein Vektor und

λ ∈ R eine beliebige Zahl.

Unter dem λ − f achen λ~x des Vektors ~x versteht man

a) λ~x := ~0

für λ = 0

−→

b) λ~x := [Q1 Q2 ]

14

für λ 6= 0,

1.2. Vektoren

−→

wobei Q1 Q2 wie folgt gewählt wird:

−→

−→

Länge von Q1 Q2 = |λ| · Länge von P1 P2

(

−→

−→

Richtung von P1 P2 f ür λ > 0

Richtung von Q1 Q2 =

−→

Richtung von P2 P1 f ür λ < 0

Es gelten folgende Rechenregeln:

Satz 1.2 Für beliebige Vektoren ~x, ~y und beliebige Zahlen λ, µ gilt:

V 5) λ(~x + ~y ) = λ~x + λ~y

Distributivgesetze

V 6) (λ + µ)~x = λ~x + µ~x

V 7) (λµ)~x = λ(µ~x)

Assoziativgesetz

V 8) 1~x = ~x

Ferner gilt:

λ~0 = ~0

0~x = ~0

(−1)~x = −~x

(−λ)~x = −(λ~x) = λ(−~x)

für

für

für

für

jedes λ ∈ R

jeden Vektor ~x

jedes ~x

jedes λ ∈ R und jeden Vektor ~x.

r 00

P

r 1

~xr P

0

r

P

1

~x

2

−~x 1

O r

)

)

1

(−

)~

x

r

2

)

(−2)~x

1

2~x

Definition 1.10 (Vektorraum) Sei E 3 bzw. E 1 die Menge alle Vektoren ~x =

−→

[P1 P2 ] mit beliebigen Punkten P1 , P2 des Raumes, einer Ebene oder einer Geraden.

Wegen der Eigenschaften (V1)-(V8) heißt E 3 (E 2 bzw. E 1 ) auch Vektorraum.

15

1. Der geometrische Vektorbegriff — Vektoralgebra

16

2. Zahlen-n-Tupel

2.1. Darstellung eines Vektors ~x im kartesischen

Koordinatensystem

Im dreidimensionalen Raum E 3 werde festgelegt:

• ein Ursprung durch Wahl eines festen Punktes O

−→

−→

−→

• ein Koordinatensystem durch 3 Ortsvektoren OE , OE , OE , die paarweise senkrecht stehen und die Länge 1 haben.

6

z – Achse

z~k = x3~k Z

Z

Z

Z

Z P

Z

E3 r~k 6

y~j = x2~j

~j

-r

y – Achse

~i Z

O Z E2

r

Z

Z

E1

Z

x~i = x1~i Z

-

x – Achse

−→

−→

Definition 2.1 (Einheitsvektoren) Die (freien) Vektoren ~i = [OE1 ], ~j = [OE2

−→

], ~k = [OE3 ] heißen Einheitsvektoren in x(x1 )- bzw. y(x2 )- bzw. z(x3 )-Richtung.

−→

Durch Projektion von OP auf die Koordinatenachsen ergibt sich:

17

2. Zahlen-n-Tupel

Satz 2.1 Jeder Vektor ~x lässt sich darstellen als Linearkombination

bzw.

~x = x1~i + x2~j + x3~k

~x = x~i + y~j + z~k

mit eindeutig bestimmten Koordinaten x1 , x2 , x3 bzw. x, y, z.

(x1 , x2 , x3 ) bzw. (x, y, z) sind natürlich die Koordinaten des Endpunktes P des

−→

Ortsvektors OP

Folgerung:

Satz 2.2 Bei festgehaltenem Koordinatensystem (O,~i, ~j, ~k) wird jeder Vektor ~x

−→

mit dem Ortsvektor OP (1-1-deutig) beschrieben durch sein Koordinatentripel

x = (x1 , x2 , x3 ) bzw.

x = (x, y, z)

(2.1)

Bemerkung: Sei (O,~i, ~j, ~k) ein festes Koordinatensystem. Wegen der 1-1-deutigen

−→

−→

Beziehung zwischen ~x = [OP ], dem ~x repräsentierenden Ortsvektor OP und dem

Koordinatentripel x von P werden diese mathematischen Objekte oft (bei geometrischen Problemen) identifiziert:

−→

−→

~x ”0=” OP ”0=” x oder kurz ~x = OP = x

Speziell gilt:

~0

−~x

”0=” 0 := (0, 0, 0)

”0=” −x := (−x1 , −x2 , −x3 )

(2.2)

(2.3)

~i ”0=” (1, 0, 0), ~j ”0=” (0, 1, 0), ~k ”0=” (0, 0, 1)

Für die Addition, Subtraktion von Vektoren und die Multiplikation von Vektoren

mit Zahlen gilt:

Satz 2.3 Seien x = (x1 , x2 , x3 ), y = (y1 , y2 , y3 ) die Koordinatentripel von ~x bzw.

~y . Dann gilt:

a) ~x + ~y hat das Koordinatentripel

x + y := (x1 + y1 , x2 + y2 , x3 + y3 )

(2.4)

koordinatenweise Addition

18

2.2. Zahlen–n–Tupel

b) für jedes λ ∈ R hat λ~x das Koordinatentripel

λx := (λx1 , λx2 , λx3 )

(2.5)

koordinatenweise Multiplikation mit λ

c) ~x − ~y hat das Koordinatentripel

x − y := (x1 − y1 , x2 − y2 , x3 − y3 )

(2.6)

koordinatenweise Subtraktion

Bemerkung: Es sei ~x ”0=” x und ~y ”0=” y. Dann gilt:

~x = ~y genau dann, wenn x = y

2.2. Zahlen–n–Tupel

In Verallgemeinerung der Koordinatentripel (2.1) findet man die Zahlen–n–Tupel:

Definition 2.2 (Tupel) Seien x1 , x2 , . . . , xn irgendwelche reelle Zahlen. Unter einem n–Tupel von Zahlen oder (Zahlen–) n–Tupel versteht man jede geordnete

Menge

x1

x2

x = (x1 , x2 , . . . , xn ) oder x = ..

.

xn

Zeilendarstellung

Spaltendarstellung

von Zahlen x1 , x2 , . . . , xn . Die Zahlen xk , k = 1, 2, . . . , n heißen die Koordinaten

des n–Tupels x.

Gleichheit von n–Tupel

Gemäß Definition 2.2 ist

x=y

⇐⇒

xk = yk für alle k = 1, 2, . . . , n

Praktische Bedeutung der n–Tupel

Mathematische Beschreibung eines Objektes, das durch n Zahlen, z.B. Messgrößen,

x1 , x2 , x3 , . . . , xn charakterisiert werden kann.

19

2. Zahlen-n-Tupel

Beispiele:

x = (x1 , x2 , x3 ) :

– Punkt P (x1 , x2 , x3 ) im Raum

– Vektor ~x = x1~i + x2~j + x3~k

– Quader mit Seitenlängen x1 , x2 , x3 > 0

u = (t, x, y, z, 0, 0, vz ) : Rakete, die sich im Zeitpunkt

t im Punkt P (x, y, z) befindet und

sich mit Geschwindigkeit vz in

z-Richtung bewegt.

Rechnen mit n–Tupeln

In Verallgemeinerung von (2.3) – (2.7) definiert man:

Definition 2.3 Seien x = (x1 , x2 , . . . , xn ), y = (y1 , y2 , . . . , xn ) zwei n–Tupel,

λ ∈ R eine beliebige Zahl

a) Summe zweier n–Tupel

x + y := (x1 + y1 , x2 + y2 , . . . , xn + yn )

Addition: durch koordinatenweise Addition

b) Multiplikation mit einem Skalar

λx := (λx1 , λx2 , . . . , λxn )

Multiplikation mit Skalar λ: durch koordinatenweise Multiplikation mit λ

c) Differenz zweier n–Tupel

x − y := (x1 − y1 , x2 − y2 , . . . , xn − yn )

Subtraktion: durch koordinatenweise Subtraktion

Weitere Bezeichnungen

0 := (0, 0, . . . , 0)

|

{z

}

Null-Tupel oder Nullelement

n Nullen

−x := (−x1 , −x2 , . . . , −xn ) das zu x negative n–Tupel

Rn := Menge aller n–Tupel, Rn heißt n–dimensionaler Zahlenraum .

Bemerkung

a)

R1 lässt sich mit R (=Menge der reellen Zahlen) identifizieren.

b) Wegen (2.1), also ~x ”0=” x = (x1 , x2 , x3 ), besteht zwischen E 3 und

tige Beziehung !

20

R3 eine 1-1-deu-

2.2. Zahlen–n–Tupel

Wie bei Vektoren gelten folgende Rechenregeln:

−x = (−1)x

λ0 = 0 für alle λ ∈ R

λx = 0 =⇒ λ = 0 oder x = 0

−(λx) = (−λ)x = λ(−x)

x − y = x + (−y)

Satz 2.4 Für beliebige n–Tupel x, y, z und Skalare λ, µ gelten dieselben Rechenregeln (V 1) – (V 8) (siehe Satz 1.1 und Satz 1.2) wie für Vektoren ~x, ~y , ~z und Skalare

λ, µ.

Spezielle n–Tupel

e1 := (1, 0, . . . , 0)

e2 := (0, 1, . . . , 0)

..

.

n Koordinaten

en := (0, 0, . . . , 1)

Offensichtlich hat jedes x ∈ Rn die Darstellung:

x = (x1 , x2 , . . . , xn ) = x1 e1 + x2 e2 + . . . + xn en =

n

X

xk ek

k=0

Vergleich: Gemäß Satz 2.1 gilt für jedes ~x ∈ E 3

~x = x1~i + x2~j + x3~k

Definition 2.4 (Linearkombination) Sind x1 , x2 , . . . , xr beliebige n–Tupel, also

xi = (xi1 , xi2 , . . . , xin ), i = 1, 2, . . . , r, und λ1 , λ2 , . . . , λr irgendwelche Zahlen, dann

heißt das n–Tupel

r

X

y=

(2.7)

λi x i

i=1

eine Linearkombination von x1 , x2 , . . . , xr .

Analog definiert man Linearkombinationen von Vektoren ~x1 , ~x2 , . . . , ~xr aus E 3 .

21

2. Zahlen-n-Tupel

Beispiele:

(a) Jedes x ist eine Linearkombination von e1 , e2 , . . . , en .

(b) Jedes ~x ist eine Linearkombination von ~i, ~j, ~k.

(c) Gegeben sei das LGS

x1 − x2 − x3 + 2x4 = 0

−x1 + 2x2 + x3 + 3x4 = 0

(∗)

x = (1, 0, 1, 0), y = (−7, −5, 0, 1) sind zwei Lösungen von

(∗)

Es gilt dann: Jede Linearkombination

z = λx + µy = (λ − 7µ, −5µ, λ, µ), λ, µ ∈ R

von x und y ist wieder eine Lösung von (∗).

=⇒

(∗) hat ∞ viele Lösungen!

Speziell ist 0 = 0x + 0y eine Lösung von (∗).

Definition 2.5 (Lineare Abhängigkeit – Unabhängigkeit) Die n–Tupel x1 , x2 , . . . , xr

bzw. Vektoren ~x1 , ~x2 , . . . , ~xr heißen linear abhängig, wenn es Zahlen λ1 , λ2 , . . . , λr

gibt, so dass

r

X

λi xi = 0 bzw.

r

X

λi~xi = ~0,

(2.8)

i=1

i=1

wobei λi 6= 0 für mindestens ein 1 ≤ i ≤ r.

Die n–Tupel x1 , x2 , . . . , xr bzw. Vektoren ~x1 , ~x2 , . . . , ~xr heißen linear unabhängig,

wenn sie nicht linear abhängig sind, d.h. wenn

r

X

λi x i = 0

=⇒

λ1 = λ2 = · · · = λr = 0

λi~xi = ~0

=⇒

λ1 = λ2 = · · · = λr = 0.

i=1

bzw.

r

X

i=1

Beispiele:

22

2.2. Zahlen–n–Tupel

a) Sei x = (1, 1, 1), y = (− 12 , 0, − 12 ), z = (0, 1, 0).

=⇒ z = x + 2y

=⇒ x + 2y + (−1)z = 0

=⇒ x, y, z sind linear abhängig.

b) e1 = (1, 0, 0), e2 = (0, 1, 0), e3 = (0, 0, 1)

Zu untersuchen:

Gleichung λ1 e1 + λ2 e2 + λ3 e3 = 0

|

{z

}

= (λ1 , λ2 , λ3 )

=⇒

λ1 = λ2 = λ3 = 0

=⇒

e1 , e2 , e3 sind linear unabhängig

Folgerung:

Wegen ~i ”0=” e1 , ~j ”0=” e2 , ~k ”0=” e3 sind auch die Vektoren ~i, ~j, ~k linear unabhängig !

Beweis: Wegen Satz 2.3 ist

λ1~i + λ2~j + λ3~k ”0=”(λ1 , λ2 , λ3 ),

also ist λ1~i + λ2~j + λ3~k = ~0

=⇒

λ1 = λ2 = λ3 = 0.

c) e1 , e2 , . . . , en sind linear unabhängige n–Tupel

d) Gegeben seien: a = (3, −2, 1), b = (0, −1, 1), c = (0, 0, 2)

Das Gleichungssystem (9) lautet hier

3λ1

=0

−2λ1 + λ2

=0

λ1 − λ2 + 2λ3 = 0.

Daraus folgt λ1 = λ2 = λ3 = 0, a, b, c sind also linear unabhängige Tripel.

Charakterisierung der linearen Abhängigkeit/Unabhängigkeit

Satz 2.5 Die n–Tupel x1 , x2 , . . . , xr bzw. Vektoren ~x1 , ~x2 , . . . , ~xr sind genau dann

linear abhängig, wenn sich mindestens ein Element xj bzw. ~xj als Linearkombination der restlichen Elemente

x1 , x2 , . . . , xj−1 , xj+1 , . . . , xr

bzw. ~x1 , ~x2 , . . . , ~xj−1 , ~xj+1 , . . . , ~xr

darstellen lässt.

Beweis:

23

2. Zahlen-n-Tupel

a) x1 , x2 , . . . , xr seien linear abhängig.

Nach Definiton 2.5 gibt es dann Zahlen λ1 , λ2 , . . . , λr , so dass

r

P

λi xi = 0 und λi 6= 0 für mindestens ein i = i0 .

i=1

Daraus folgt

0=

P

i6=i0

also wie behauptet xi0 =

b) Ist umgekehrt xj =

P

P

i6=i0

− λλii

o

λi xi + λi0 xi0 ,

xi .

µi xi für ein 1 ≤ j ≤ r, dann folgt

i6=j

0=

j−1

P

µi xi + (−1)xj +

i=1

r

P

µi x i ,

i=j+1

d.h. x1 , x2 , . . . , xr sind linear abhängig.

Korollar 2.1 Zwei n–Tupel x, y bzw. Vektoren ~x, ~y sind genau dann linear abhängig,

wenn

x = λy oder y = µx bzw. ~x = λ~y oder ~y = µ~x mit λ, µ ∈ R

Solche Vektoren nennt man auch parallel oder kollinear.

Korollar 2.2 Ein n–Tupel x bzw. ein ~x ist genau dann linear abhängig, wenn

x = 0 bzw. ~x = ~0.

24

3. Multiplikation von n–Tupel bzw.

Vektoren

3.1. Das Skalarprodukt

3.1.1. Das Skalarprodukt im Raum E 3 der Vektoren ~x, ~y , . . .

Definition 3.1 (Skalarprodukt I) Unter dem Skalarprodukt ~x · ~y oder <~x, ~y>

zweier Vektoren ~x, ~y ∈ E 3 versteht man die Zahl

~x · ~y = k~xk · k~y k · cos ϕ,

wobei k~xk, k~y k die Länge der Vektoren ~x bzw. ~y bezeichnet und ϕ der Winkel zwischen ~x und ~y ist.

P

3

~x ϕ

O

k~xk · cos ϕ =

~

x·~

y

k~

yk

-

Q

~y

Beispiele:

a) ~x · ~0 = 0 für jedes ~x ∈ E 3 , da k~0k = 0.

b) ~i · ~i

~j · ~j

~k · ~k

~i · ~j

~i · ~k

~j · ~k

= 1, da k~ik = 1 und <

) (~i,~i) = 0

=1

=1

= 0, da <

) (~i, ~j) = 90◦

=0

=0

c) Für ~x, ~y 6= ~0 gilt ~x · ~y = 0

⇐⇒

~i, ~j, ~k stehen paarweise senkrecht und

haben die Länge 1

~x steht senkrecht auf ~y

(3.1)

3. Multiplikation von n–Tupel bzw. Vektoren

d) ~x · ~x = k~xk · k~xk · 1, da <

) (~x · ~x) = 0

= k~xk2

√

oder k~xk = ~x · ~x

Es ist k~xk = 0

Länge (Betrag oder Norm) von ~x

⇐⇒

~x = ~0.

Durch geometrische Überlegungen findet man folgende Rechenregeln:

Satz 3.1 Für beliebige Vektoren ~x, ~y , ~z und jedes λ ∈ R gilt:

a) ~x · ~y = ~y · ~x

(Kommutativität)

b) ~x · (~y + ~z) = ~x · ~y + ~x · ~z

(Distributivität)

c) ~x · (λ~y ) = (λ~x) · ~y = λ · ~x · ~y

d) ~x · ~y = 0 ⇐⇒ ~x = ~0 oder ~y = ~0 oder <

) (~x, ~y ) =

(Homogenität)

π

2

Beweis:

(a), (c), (d) sind offensichtlich, (b) ergibt sich gemäß folgender Konstruktion:

:

3

~z ~y

~y + ~z

~

x

-

|

|

{z

~

x·~

y

k~

xk

}|

{z

~

x·~

z

k~

xk

{z

~

x·(~

y +~

z)

k~

xk

}

}

Koordinatendarstellung des Skalarproduktes

Gemäß Satz 2.1 gilt für je zwei Vektoren ~x, ~y die Darstellung

)

~x = x1~i + x2~j + x3~k

mit eindeutig bestimmten Koordinaten xi bzw. yi

~y = y1~i + y2~j + y3~k

Wegen Satz 3.1 gilt:

26

3.1. Das Skalarprodukt

x1 y1~i · ~i + x1 y2~i · ~j + x1 y3~i · ~k +

~x · ~y =

+ x2 y1~j · ~i + x2 y2~j · ~j + x2 y3~j · ~k +

+ x3 y1~k · ~i + x3 y2~k · ~j + x3 y3~k · ~k

=

x1 y1 + x2 y2 + x3 y3

Satz 3.2 Sind x1 , x2 , x3 bzw. y1 , y2 , y3 die Koordinaten von ~x bzw. ~y bezüglich

(der Basis) ~i, ~j, ~k, dann gilt:

~x · ~y = x1 y1 + x2 y2 + x3 y3 .

(3.2)

Speziell gilt:

~x · ~x = x21 + x22 + x23 ,

also

q

√

k~xk = ~x · ~x = x21 + x22 + x23

(Länge von ~x).

(3.3)

x3

6

Z

Z

Z

Z

Z

Länge =

Z

~x ~k

6

~j

~i Z Z

Z

p

x21 + x22 Z

p

x21 + x22 + x23

x

-2

Z

x1

Winkelberechnung

a) Allgemeine Winkelberechnung

27

3. Multiplikation von n–Tupel bzw. Vektoren

Pr

*

~x ϕ

-r

O

~y

Q

−→

−→

Für den Winkel ϕ zwischen zwei Vektoren ~x, ~y (genauer Ortsvektoren OP ,OQ)

gilt nach Definition 3.1

·~

y

cos ϕ = k~x~xk·k~

yk

Sind x1 , x2 , x3 bzw. y1 , y2 , y3 die Koordinaten von ~x, ~y (bezüglich ~i, ~j, ~k), dann

gilt nach Satz 3.2

cos <

) (~x, ~y ) = √ 2x1 y12+x22y√2 +x2 3 y32 2 .

x1 +x2 +x3

28

y1 +y2 +y3

3.1. Das Skalarprodukt

b) Cosinus–Satz

B

B

α B

~a

B ~b

B

B

B

B

-BN

~c

Es ist ~c = ~b − ~a, also

k~ck2 = (~b − ~a) · (~b − ~a)

= k~bk2 − 2~a · ~b + k~ak2

= k~bk2 − 2k~ak · k~bk · cos α + k~ak2 , oder

k~ck2 = k~ak2 + k~bk2 − 2k~ak · k~bk · cos α

Eigenschaften der Länge k~xk von ~x

Satz 3.3 Es gilt:

a) k~xk ≥ 0

b) k~xk = 0

⇐⇒

~x = ~0

c) kλ~xk = |λ| · k~xk für jedes λ ∈ R

Weitere Eigenschaften folgen später.

3.1.2. Das Skalarprodukt im

Rn

Definition 3.2 (Skalarprodukt II) Unter dem Skalarprodukt <x, y> zweier n–

Tupel x, y versteht man die Zahl

<x, y>:=

n

X

xk yk

|k=1{z }

V erallgemeinerung von (3.2)

Beispiele:

a) <x, 0> = 0 für alle x

b) <ei , ej> = 0 für i 6= j

<ei , ei> = 1 für alle i, wobei ei = (0, . . . , 0, 1, 0, . . . , 0)

z

}|

{

i−te Stelle

29

3. Multiplikation von n–Tupel bzw. Vektoren

Nach (3.1) gilt:

~x · ~y = 0

~x ⊥ ~y (~x, ~y 6= ~0)

⇐⇒

Man definiert deshalb:

Definition 3.3 (Orthogonalität)

a) Zwei n–Tupel x, y 6= 0 heißen orthogonal,

x ⊥ y, falls <x, y>= 0.

b) Gilt für n–Tupel x1 , x2 , . . . , xr 6= 0

<xi , xj>= 0 für i 6= j,

dann heißt {x1 , x2 , . . . , xr } ein Orthogonalsystem.

c) Gilt für n–Tupel x1 , x2 , . . . , xr 6= 0

<xi , xj>=

0 für i 6= j

1 für i = j

dann heißt {x1 , x2 , . . . , xr } ein Orthonormalsystem.

Beispiel:

e1 , e2 , . . . , en ist ein Orthonormalsystem.

Eigenschaften des Skalarproduktes im

Rn

Satz 3.4 Für alle n–Tupel x, y, z ∈ Rn und jedes λ ∈ R gilt:

a) <x, y>=<y, x>

b) <x, y + z>=<x, y> + <x, z>

c) <λx, y>=<x, λy>= λ <x, y>

d) <x, x>≥ 0, <x, x>= 0

⇐⇒

x=0

Beweis: Durch Ausrechnen !

Bemerkung: Die Eigenschaften von ~x · ~y (siehe Satz 3.1) und <x, y> stimmen

überein!

30

3.2. Die Norm (Betrag) eines n–Tuppels

3.2. Die Norm (Betrag) eines n–Tuppels

Nach (3.2) gilt:

q

k~xk = x21 + x22 + x23 = Länge von ~x

Man definiert deshalb:

Definition 3.4 (Norm) Unter der Norm (Betrag) k~xk eines n–Tupels x versteht man die Zahl

! 21

n

X

√

kxk = <x, x> =

x2k

k=1

Beispiele:

kxk =

a) n = 1: x = (x1 ) =⇒

n = 2: x = (x1 , x2 )

p

x21 = |x1 |

x2 r

Betrag von x1

rP

3

l

l=

p

−→

x21 + x22 = Länge OP

O

r

x1

b) kei k = 1 für alle i = 1, 2, . . . , n

Satz 3.5 Für die Norm kxk im

Rn gilt analog zu Satz 3.3

a) kxk ≥ 0

b) kxk = 0

⇐⇒

x=0

c) kλxk = |λ| · kxk ∀λ ∈ R, x ∈ Rn

Beweis: Durch Ausrechnen !

3.3. Die Schwarzsche Ungleichung

Satz 3.6 (Schwarzsche Ungleichung)

a) Für beliebige n–Tupel x, y gilt:

| <x, y> | ≤ kxk · kyk

31

3. Multiplikation von n–Tupel bzw. Vektoren

b) Für beliebige Vektoren ~x, ~y ∈ E 3 gilt:

|~x · ~y | ≤ k~xk · k~y k

Beweis: Wegen (3.2) folgt (b) aus (a).

Beweis von (a):

a1) Sei x = 0 oder y = 0

=⇒ <x, y>= 0 und kxk = 0 oder kyk = 0.

a2) Sei x 6= 0 und y 6= 0

Betrachte die Funktionen Q = Q(t), t ∈ R,

Q(t) :=<x + ty, x + ty>= kx + tyk2

Es gilt:

i) Q(t) ≥ 0 für alle t ∈ R

Q∗ = min Q(t) ≥ 0

=⇒

2

2

t∈

ii) Q(t) = kxk + 2t <x, y> +t kyk

Minimalpunkt von Q : t∗ = −

=⇒

R

2

<x,y>

kyk2

0 ≤ Q∗ = Q(t∗ ) = kxk2 −

<x,y>2

kyk2

=⇒ <x, y>2 ≤ kxk2 · kyk2

=⇒

| <x, y> | ≤ kxk · kyk

Folgerung:

Satz 3.7 (Dreiecks–Ungleichung)

a) Für alle n–Tupel x, y gilt:

kx + yk ≤ kxk + kyk

b) Für alle ~x, ~y ∈ E 3 gilt:

k~x + ~y k ≤ k~xk + k~y k

Beweis:

a) Mit Satz 3.6 ist

32

3.4. Das Vektorprodukt

kx + yk2 = <x + y, x + y>

= kxk2 + 2 <x, y> +kyk2

≤ kxk2 + 2kxk · kyk + kyk2

= (kxk + |yk)2 ,

also ist

kx + yk ≤ kxk + kyk.

Ebenso zeigt man b).

Geometrische Interpretation

~x + ~y

~x *

x

~

O

-

~y

Die Summe der Längen zweier 4–Seiten ist ≥ der Länge der dritten Seite.

Aus Satz 3.3, Satz 3.5, Satz 3.7 folgt für k.k

Satz 3.8 Für beliebige n–Tupel x, y bzw. Vektoren ~x, ~y gilt:

a) kxk ≥ 0

b) kxk = 0

a) k~xk ≥ 0

⇐⇒

b) k~xk = 0

x=0

⇐⇒

~x = ~0

c) kλxk = |λ| · kxk

c) kλ~xk = |λ| · k~xk

d) kx + yk ≤ kxk + kyk

d) k~x + ~y k ≤ k~xk + k~y k

3.4. Das Vektorprodukt

Definition 3.5 (Vektorprodukt) Unter dem Vektorprodukt ~c = ~a × ~b zweier

Vektoren ~a, ~b ∈ E 3 versteht man den (eindeutig bestimmten) Vektor ~c, so dass

1. k~ck = k~ak · k~bk · sin α

mit

α =<

) (~a, ~b), 0 ≤ α ≤ π

2. ~c steht senkrecht auf ~a und ~b

3. ~a, ~b, ~c bilden ein Rechtssystem, d.h. dreht man den ersten Faktor ~a auf dem

33

3. Multiplikation von n–Tupel bzw. Vektoren

kürzesten Weg in die Richtung des zweiten Faktors ~b, so zeigt ~c = ~a × ~b in

Richtung in die sich eine Rechtsschraube bewegen würde.

(Rechtsschraubenregel oder Korkenzieherregel)

6

6

~c = ~a × ~b

~b × ~a

*PPP

PP

~b PP

PP

A

F

A

α

A

PP

PP

A

PP

A

~a

PP

A

q

P

?

F sei der Flächeninhalt des von ~a, ~b aufgespannten Parallelogramms.

Es ist

F = g · h = k~bk · (k~ak · sin α) = k~ak · k~bk · sin α = k~ck

Somit gilt:

k~ck = F = Fläche des von ~a, ~b aufgespannten Parallelogramms

3.4.1. Eigenschaften des Vektorproduktes

a) ~a × ~a = ~0 (wegen sin <

) (~a, ~a) = 0)

b) ~a × ~b = ~0

c) ~a ⊥ ~b

=⇒

⇐⇒

~a = ~0 oder ~b = ~0 oder <

) (~a, ~b) = 0 oder π

k~a × ~bk = k~ak · k~bk

d) ~b × ~a = −~a × ~b (also ~a × ~b 6= ~b × ~a)

Satz 3.9 Für beliebige Vektoren ~a, ~b, ~c ∈ E 3 und beliebiges λ ∈ R gilt:

a) (λ~a) × ~b = ~a × (λ~b) = λ~a × ~b

b) ~a × (~b + ~c) = ~a × ~b + ~a × ~c

c) (~a + ~b) × ~c = ~a × ~c + ~b × ~c

34

3.4. Das Vektorprodukt

Beweis: Mittels geometrischer Überlegungen !

Koordinatendarstellung des Vektorproduktes

Nach Satz 2.1 ist

~a = a1~i + a2~j + a3~k

mit eindeutig bestimmtem

a = (a1 , a2 , a3 )

~b = b1~i + b2~j + b3~k

mit eindeutig bestimmtem

b = (b1 , b2 , b3 ).

Nach Satz 3.9 darf man Klammern ausmultiplizieren, es gilt:

~a × ~b =

(a1~i + a2~j + a3~k) × (b1~i + b2~j + b3~k)

=

a1 b1~i × ~i + a1 b2~i × ~j + a1 b3~i × ~k +

+ a2 b1~j × ~i + a2 b2~j × ~j + a2 b3~j × ~k +

+ a3 b1~k × ~i + a3 b2~k × ~j + a3 b3~k × ~k

Nach Definition 3.3 gilt:

~i × ~j = ~k,

~i × ~k = −~j,

~j × ~k = ~i,

~j × ~i = −~k,

~k × ~i = ~j,

~k × ~j = −~i

~i × ~i = ~j × ~j = ~k × ~k = ~0.

Somit gilt:

Satz 3.10 Sind a = (a1 , a2 , a3 ), b = (b1 , b2 , b3 ) die Koordinaten–Tripel von ~a, ~b,

dann gilt:

~a × ~b = (a2 b3 − a3 b2 )~i + (a3 b1 − a1 b3 )~j + (a1 b2 − a2 b1 )~k

~a × ~b = a × b := (a2 b3 − a3 b2 , a3 b1 − a1 b3 , a1 b2 − a2 b1 ).

~i a1 b1

Merkregel: ~a × ~b = det ~j a2 b2 (siehe Kapitel 10).

~k a3 b3

oder

35

3. Multiplikation von n–Tupel bzw. Vektoren

36

4. Lineare Gleichungssysteme (LGS)

— Teil I

Seien a1 , a2 , . . . , an beliebige, aber fest vorgegebene Zahlen und x ∈ Rn

Definition 4.1 (Linearform, Lineare Funktion) Die Funktion y = L(x) = L(x1 , x2 , . . . , xn ) =

n

P

ak xk heißt eine Linearform in x (in den Variablen x1 , x2 , . . . , xn ).

k=1

Ist b eine weitere Konstante, so heißt y = L(x) + b eine lineare Funktion in x.

Beispiel:

n = 3: L1 (x) = 4x1 −x2

L2 (x) =

x2 + x3

L3 (x) = 4x1 +x2 + 2x3

sind Linearformen in x ∈ R

Satz 4.1 (Eigenschaften von Linearformen) Sind L1 (x), L2 (x) zwei Linearformen in x ∈ Rn und λ ∈ R, so sind auch

a) L(x) := L1 (x) + L2 (x) und L(x) := λL1 (x) wieder Linearformen

b) L(x + y) = L(x) + L(y) und L(λx) = λL(x).

Beweis:

a) L1 (x) = a11 x1 + a12 x2 + . . . + a1n xn =

n

P

a1k xk ,

L2 (x) =

k=1

n

P

a2k xk

k=1

Linearform in x

=⇒

L(x) := L1 (x) + L2 (x) =

n

P

a1k xk +

k=1

n

P

a2k xk =

k=1

Linearform in x

=⇒

z

}|

{

n

n

X

P

a1k xk =

(λa ) x

L(x) := λL1 (x) = λ

| {z1k} k

k=1

k=1

z

n

X

}|

{

(a1k + a2k ) xk

| {z }

k=1

neue konst. Koeff.

4. Lineare Gleichungssysteme (LGS) — Teil I

neue konst. Koeff.

b) rechnet man leicht nach !

4.1. Lineare Gleichungssysteme (LGS)

Obiges Beispiel: L3 (x) = L1 (x) + 2L(x)

Seien nun L1 , L2 , . . . , Lm

=⇒

m gegebene Linearformen in x ∈ Rn

es gibt eine sog. Matrix A von m · n Zahlen (Konstante Koeffizenten)

A=

a11 a12 . . . a1k

a12 a22 . . . a2k

..

..

..

.

.

.

ai1 ai2 . . . aik

..

..

..

.

.

.

am1 am2 . . . amk

. . . a1n

. . . a2n

..

.

. . . ain

..

.

. . . amn

⇐⇒

⇐⇒

L1

L2

..

.

⇐⇒

Li

..

.

⇐⇒ Lm

so dass

L1 (x) =

..

.

Li (x) =

..

.

Lm (x) =

n

P

a1k xk

k=1

n

P

aik xk = ai1 x1 + ai2 x2 + . . . + aik xk + . . . + ain xi

k=1

n

P

amk xk .

k=1

Definition 4.2 (Lineares Gleichungsssystem) Sind dann b1 , b2 , . . . , bm weitere

Zahlen, so heißt

L1 (x) = b1

..

.

Li (x) = bi

(LGS)

..

.

Lm (x) = bm

ein lineares Gleichungssystem (LGS) in x (in den Unbekannten x1 , x2 , . . . , xn ).

Die Konstanten aik heißen die Koeffizienten des LGS. Das m–Tupel b =

(b1 , b2 , . . . , bm ) heißt die rechte Seite des LGS.

38

4.1. Lineare Gleichungssysteme (LGS)

Homogenes LGS: bi = 0, für alle i = 1, 2, . . . , m

Inhomogenes LGS

: mindestens ein bi 6= 0

Definition 4.3 Eine Lösung eines LGS ist jedes n–Tupel x = (x1 , x2 , . . . , xn ), so

dass Li (x) = bi für jedes i = 1, 2, . . . , m.

Beispiel:

a b c

A= 0 d e

0 0 f

=⇒

ax1 + bx2 + cx3 = b1

dx2 + ex3 = b2

f x 3 = b3

Fall 1: a 6= 0, d 6= 0, f 6= 0

=⇒

x3 =

b3

,

f

x2 =

1

d

b2 −

b3

f

, x1 =

1

a

b1 −

b

d

b2 −

e bf3

−

cb3

f

=⇒ eindeutig bestimmte Lösung

Fall 2: a 6= 0, d 6= 0, f = 0

b3 6= 0

=⇒

0 · x3 = b3 6= 0

=⇒ Widerspruch =⇒ LGS nicht lösbar

b3 = 0

=⇒

0 · x 3 = b3 = 0

=⇒

x3 kann beliebige Werte annehmen

Weiter gilt x2 = d1 (b2 − ex3 ) und x1 = a1 b1 − db (b2 − ex3 ) − cx3

=⇒ LGS hat ∞ viele Lösungen

Praktische Verwendung LGS

— Ausgleichsprobleme

— Stromverteilung in Netzwerken

— Beschreibung von Input − Output−

prozessen (Produktionsprozesse)

— Mischungs- /Legierungsprobleme

— Lösung von DGLn

— Statik

Berechnung eines Netzwerkes

x = (x1 , x2 , x3 , x4 , x5 , x6 ) mit xk = (absolute) Stromstärke im betreffenden Leiter

39

4. Lineare Gleichungssysteme (LGS) — Teil I

@

R2

x2

@

@

@

@

@

@ @

@ R@

1

@ @

@ @

@

x1

I

@

@

@

@

R5

@

x4

@

x3

@

I

@

@

@ @

x

@

@

?5

@ R@

R4

3

@ @

@

@ @

@

@

?

@

-

6x6

R6

-

V

Kirchhoffsche Gesetze

−x1

x1

−x4

−x2

x2

R1 x1

R2 x 2

R1 x1 +R2 x2

+x6 = 0

−x5

= 0

+x3

−x6 = 0

−R4 x4 +R5 x5

= 0

−R3 x3

−R5 x5

= 0

+R6 x6 = V

LGS für Stromstärke x

4.1.1. Grundlegende Eigenschaften linearer Gleichungssysteme

A) Homogene LGS (HLGS)

a11 x1 + a12 x2 + . . . + a1n xn = 0

a21 x1 + a22 x2 + . . . + a2n xn = 0

..

..

..

..

.

.

.

.

am1 x1 + am2 x2 + . . . + amn xn = 0

Satz 4.2 (Eigenschaften homogener linearer Gleichungssysteme)

ab

(a) Ein HLGS hat zumindest die Lösung x = 0

40

4.1. Lineare Gleichungssysteme (LGS)

(b) Sind u, v zwei Lösungen eines HLGS, so sind auch u + v, λu und

λu + µv für alle λ, µ ∈ R wieder Lösungen des HLGS.

Beweis: Mit Satz 4.1b !

Beispiel: x = (1, 0, 1, 0), y = (−7, −5, 0, 1) sind 2 Lösungen von

x1 − x2 − x3 + 2x4 = 0

(4.1)

−x1 + 2x2 + x3 + 3x4 = 0

Satz 4.2

=⇒

λx + µy = (λ − 7µ, −5µ, λ, µ) sind wieder Lösungen von (4.1)

für alle λ, µ ∈ R.

B) Inhomogene LGS (ILGS)

Definition 4.4 Ist

a11 x1 + a12 x2 + · · · + a1n xn = b1

a21 x1 + a22 x2 + · · · + a2n xn = b2

..

..

..

..

.

.

.

.

am1 x1 + am2 x2 + · · · + amn xn = bm

ein inhomogenes LGS, so heißt

a11 x1 + a12 x2 + · · · + a1n xn = 0

a21 x1 + a22 x2 + · · · + a2n xn = 0

..

..

..

..

.

.

.

.

am1 x1 + am2 x2 + · · · + amn xn = 0

das zugehörige homogene System.

Satz 4.3 (Eigenschaften inhomogener linearer Gleichungssystemem)

(a) Sind u = (u1 , u2 , . . . , un ), v = (v1 , v2 , . . . , vn ) zwei Lösungen des

ILGS, so ist w = u − v = (u1 − v1 , u2 − v2 , ldots, un − vn ) eine

Lösung des zugehörigen HLGS.

(b) Ist u = (u1 , u2 , . . . , un ) irgend eine spezielle Lösung des ILGS und

y = (y1 , y2 , . . . , yn ) eine beliebige Lösung des zugehörigen homogenen LGS, so ist z = u + y = (u1 + y1 , u2 + y2 , . . . , un + yn ) wieder

eine Lösung des ILGS.

41

4. Lineare Gleichungssysteme (LGS) — Teil I

(c) Es sei a = (a1 , a2 , . . . , an ) eine spezielle Lösung des ILGS. Jede

(weitere) Lösung hat dann die Gestalt y = a + x, wobei x eine

Lösung des zugehörigen homogenen LGS ist.

Geometrische Interpretation einer einzelnen Gleichung eines LGS

L(x) = b (L = Li , b = bi )

n = 3:

L(x) = b

⇐⇒

a1 x 1 + a2 x 2 + a3 x 3 = b

=⇒ • L(x) = b unlösbar, wenn b 6= 0

• jedes x ∈ R erfüllt L(x) = b, wenn b = 0.

Fall 1: a1 = a2 = a3 = 0

Fall 2: mindestens ein ai 6= 0, sei a1 6= 0

L(x) = b

⇐⇒

x1 =

1

(b

a1

− a2 x2 − a3 x3 )

Mit x2 := λ und x3 := µ, λ, µ ∈ R, folgt dann

x = (x1 , x2 , x3 ) = ab1 − aa12 x2 − aa31 x3 , x2 , x3

= ab1 , 0, 0 + − aa12 λ, λ, 0 + − aa31 µ, 0, µ

= ab1 , 0, 0 + λ − aa21 , 1, 0 + − aa31 , 0, 1

=

=⇒ Ebene im

n = 2:

n > 3:

a

+

R

λd1

+

µd2

R (falls L(x) 6≡ 0)

L(x) = b beschreibt eine sogenannte Hyperebene des Rn

L(x) = b beschreibt eine Gerade im

Beispiel: (n = 3, Fall 2)

6

H

HH

HH

g1

d1 , d2 sind linear

d1 unabhängig

H

r

HH a 3x

H

:

HH

H

HH

j

H

H

d2 HH

g2

H

HH

42

4.1. Lineare Gleichungssysteme (LGS)

µ = 0 =⇒ x = a + λd1

λ = 0 =⇒ x = a + µd2

=⇒

⇐⇒ Gerade g1

⇐⇒ Gerade g2

L(x) = b ist eine Ebene die durch die beiden Geraden g1 , g2 und den

Punkt a bestimmt ist.

Achsenabschnittsgleichung einer Ebene

a1 x1 + a2 x2 + a3 x3 = b, b 6= 0

a1

x

b 1

+

a2

x

b 2

+

a3

x=

b 3

1

x2 = x3 = 0 =⇒ x1 = A :=

x1 = x3 = 0 =⇒ x2 = B :=

x1 = x2 = 0 =⇒ x3 = C :=

L(x) = b

b

a1

b

a2

b

a3

⇐⇒

Achsenabschnitte der Ebene

x1 x2 x3

+

+

=1

A

B

C

Geometrische Deutung eines LGS:

Die obige Betrachtung zeigt, dass sich die Lösungsmenge eines LGS als Schnitt

mehrerer (Hyper-)Ebenen darstellen lässt.

43

4. Lineare Gleichungssysteme (LGS) — Teil I

4.1.2. Darstellung eines LGS als n-Tupel - oder

Vektorgleichung

a11 x1 + a12 x2 + · · · + a1k xk + · · · + a1n xn = b1

a21 x1 + a22 x2 + · · · + a2k xk + · · · + a2n xn = b2

..

..

..

..

..

.

.

.

.

.

am1 x1 + am2 x2 + · · · + amk xk + · · · + amn xn = bm

|{z}

|{z}

|{z}

|{z}

|{z}

a2

ak

an

a1

b

Setze

a1 =

a11

a12

..

.

=

,

a

2

am1

a21

a22

..

.

=

,

.

.

.

a

k

am2

a1k

a2k

..

.

amk

=

,

.

.

.

a

n

a1n

a2n

..

.

(4.2)

=

,

b

amn

Satz 4.4 Das LGS (4.2) kann in der äquivalenten Form einer Vektorgleichung

n

X

(4.3)

x k ak = b

k=1

geschrieben werden.

Folgerung aus (4.2) ≡ (4.3)

Satz 4.5 LGS (4.1) ist genau dann lösbar, wenn die rechte Seite b eine Linearkombination der Spaltenvektoren a1 , a2 , . . . , an ist.

Satz 4.6

a) Sind die Spalten a1 , a2 , . . . , an linear unabhängig, so hat LGS (4.2) höchstens

eine Lösung.

b) Hat das LGS (4.2) eine eindeutig bestimmte Lösung, so sind die Spalten

a1 , a2 , . . . , an linear unabhängig.

44

b1

b2

..

.

bn

.

Teil II.

Matrizen

45

5. Der Matrizenbegriff

Definition 5.1 (Matrix) Ein System von m · n Zahlen aik , i = 1, 2, . . . , m, k =

1, 2, . . . , n A = Am,n

=

a11 a12 . . . a1k

a21 a22 . . . a2k

..

..

..

.

.

.

ai1 ai2 . . . aik

..

..

..

.

.

.

am1 am2 . . . amk

. . . a1n

. . . a2n

..

.

. . . ain

..

.

← i–te Zeile

. . . amn

↑ k–te Spalte

heißt eine ((m, n) −) Matrix. Die Zahlen aik heißen Elemente von A und man

schreibt kurz A = (aik ).

Das n – Tupel

ai = (ai1 , ai2 , . . . , ain ),

i = 1, 2, . . . , m

heißt i-te Zeile (i-ter Zeilenvektor) von A.

Das m–Tupel

ak =

a1k

a2k

..

.

,

k = 1, 2, . . . , n

amk

heißt k-te Spalte (k-ter Spaltenvektor) von A.

Bemerkung: Zwei Matrizen Am,n = (aik ) und Bm,n = (bik ) sind genau dann

gleich, wenn

m = m, n = n und aik = bik für alle i = 1, 2, . . . , m, k = 1, 2, . . . , n.

Definition 5.2 (Vektor) Ein n–Tupel x, dargestellt in Spaltenform

x1

x2

x = ..

.

xn

5. Der Matrizenbegriff

nennen wir n-Vektor (n-Spaltenvektor)

Konvention: Falls nichts anderes vereinbart wird, werden n-Tupel in Zukunft

stets als

n-Spaltenvektoren dargestellt.

Definition 5.3 (Matrix mal n-Vektor) Sei A = Am,n und x ∈ Rn ein n–Vektor.

Unter Ax versteht man den m–Vektor

a11 a12 . . . a1n

x1

a11 x1 + a12 x2 + · · · + a1n xn

n

a21 a22 . . . a2n x2 a21 x1 + a22 x2 + · · · + a2n xn X

Ax = .. ..

=

=

x k ak

.. ..

..

..

..

. .

k=1

. .

.

.

.

xn

am1 x1 + am2 x2 + · · · + amn xn

am1 am2 . . . amn

<a1 , x>

..

.

i

m

=⇒ Ax = y ∈ R mit y = <a , x> ← i–te Zeile von A mal x

..

.

<am , x>

Beispiele:

1

13 1

2

a)

1 0 −1

1

d11 0 . . . 0

0 d22 . . . 0

b) .. .. . . ..

. .

. .

0

=

0 . . . dnn

1 · 1+3 · 2+

1·1

1 · 1 + 0 · 2 + (−1) · 1

x1

x2

..

.

=

xn

d11 x1

d22 x2

..

.

=

wobei x =

x1

x2

..

.

xn

48

=

8

0

dnn xn

Anwendung: LGS ⇐⇒

a11 x1 + a12 x2 + · · · + a1n xn

a21 x1 + a22 x2 + · · · + a2n xn

..

..

..

.

.

.

am1 x1 + am2 x2 + · · · + amn xn

|

{z

Def.5.1

Ax

und A =

}

=

=

..

.

=

bm

| {z }

b

b1

b2

..

.

=: b (rechte Seite)

a11 a12 . . . a1n

a21 a22 . . . a2n

.. ..

..

. .

.

am1 am2 . . . amn

die Koeffizientenmatrix

des LGS ist.

Satz 5.1 Jedes LGS kann dargestellt werden in der Form

Ax = b,

wobei A die Koeffizientenmatrix des LGS, b die rechte Seite des LGS und x

der n–Vektor der Unbekannten xk , k = 1, 2, . . . , n ist.

Beispiel:

x1 − x2 − x3 + 2x4 = b1

−x1 − 2x2 + x3 + 3x4 = b2

⇐⇒

x

1

1 −1 −1 2

x 2 = b1

−1 −2 1 3 x3

b2

x4

Spezielle Matrizen

(a) A = Am,n heißt quadratische Matrix, wenn m = n

a11 a12

z.B. a) A1,1 = (a11 ), A2,2 =

a21 a22

b) An,n x = b ist ein LGS mit n Gleichungen und n Unbekannten.

Unter der (Haupt-) Diagonalen von An,n versteht man die Elemente

a11 , a22 , . . . , ann

a11 a12

a21 a22

..

..

.

.

an1 an2

. . . a1n

. . . a2n

. . . ..

.

. . . ann

&

Diagonale

(b) Eine quadratische Matrix An,n mit aik

d11 0

0 d22

D= 0 0

..

..

.

.

0 0

Beispiel Dx = b

=⇒

= 0 für i 6= k heißt Diagonalmatrix.

0 ... 0

0 ... 0

d33 . . . 0

.. . .

..

.

.

.

0 . . . dnn

x =?

(c) Gilt aik = 0 für alle Elemente einer Matrix A = Am,n , so heißt A

((m, n)-)Nullmatrix, man schreibt A = 0.

(d) −A = −(aik ) := (−aik ) ist die negative Matrix zu A.

49

5. Der Matrizenbegriff

50

6. Operationen mit Matrizen

Definition 6.1 (Addition) Seien A = (aik ), B = (bik ) zwei (m, n)–Matrizen.

A + B = (A + B)m,n := (aik + bik )

(elementenweise Add.)

Definition 6.2 (λ–faches) Sei A = Am,n = (aik ), λ ∈ R

λA = (λA)m,n := (λaik )

(elementenweise Multipl. mit λ)

Definition 6.3 (Transposition) Sei A = Am,n . Die zu A transponierte Matrix ist die (n, m)–Matrix

0

a11 . . . ai1 . . . am1

a11 a12 . . . a1k . . . a1n

a12 . . . ai2 . . . am2

..

..

..

..

.

..

..

.

.

.

.

.

.

.

.

A0 (= AT , At ) = ai1 ai2 . . . aik . . . ain :=

.

a1k . . . aik . . . amk

..

..

..

..

..

..

.

.

.

...

.

.

am1 am2 . . . amk . . . amn

a1n . . . ain . . . amn (n,m)

i–te Zeile →

7 i–te Spalte

k–te Spalte →

7

k–te Zeile

=⇒ A = (aik ) −→ A0 = (αki ), αki := aik

k = 1, 2, . . . , n

für alle

i = 1, 2, . . . , m

Beispiel

0

1 3

1 −3 0

−3 5

a)

=

3 5 7

0 7

x1

x2

b) x = .. ist (n, 1)–Matrix =⇒

.

xn

a = (a1 , a2 , . . . , an )

=⇒

a0 =

x0 = (x1 , x2 , . . . , xn ) ist (1, n)–Matrix

a1

a2

..

.

an

6. Operationen mit Matrizen

Satz 6.1 (Eigenschaften der Transposition) Eigenschaften von A0

a) (A0 )0 = A

b) (A + B)0 = A0 + B 0

c) (λA)0 = λA0 , für alle λ ∈ R

Definition 6.4 (Symmetrische Matrix) Eine Matrix A = An,n heißt symmetrisch, wenn:

A = A0

⇐⇒

aik = aki , für alle i, k = 1, 2, . . . , n

Beispiel

1

0

−1

0 −1

3 2

2 8

ist symmetrisch.

Definition 6.5 (Produkt) Seien A = A(m,r) = (aij ) und B = B(r,n) = (bjk ) zwei

Matrizen, so dass die Spaltenzahl r von A mit der Zeilenzahl r von B übereinstimmt. Das Produkt AB (in dieser Reihenfolge!) ist dann definiert durch

AB = C = (cik ), i = 1, . . . , m, k = 1, . . . , n,

wobei

cik :=

r

X

aij bjk =< ai , bk >,

j=1

d.h. i-te Zeile von A mal k-te Spalte von B.

Merksatz:

i–te Zeile von A mal k–te Spalte von B

Satz 6.2 Für AB gilt auch die Darstellung:

AB = (Ab1 , Ab2 , . . . , Abk , . . . , Abn ),

|

{z

}

n Spalten von AB

wobei bk die k–te Spalte von B ist.

Beispiele

1)

1 1

2 0 ·

0 1

52

1 2

ist nicht definiert !

2)

1 1

1 · 1+1 · 3 1 · 2+1 · 1

4 3

2 0 · 1 2 = 2 · 1+0 · 3 2 · 2+0 · 1 = 2 4

3 1

0 1

0 · 1+1 · 3 0 · 2+1 · 1

3 1

3) 0 1

·

=

0 1

0 1

1 0

·

=

0 1

1 0

1 0

1 0

=⇒

1 0

1 0

0 1

0 1

i.a. AB 6= BA (wenn überhaupt AB und BA

definiert sind)

Satz 6.3 (Eigenschaften der Matrixmultiplikation) Wenn die entsprechenden Produkte definiert sind, gilt:

(a) A(BC) = (AB)C = ABC,

(b) A(B + C) = AB + AC,

(c) (A + B)C = AC + BC,

(d) (λA)B = A(λB) = λAB für alle λ ∈ R,

(e) (AB)0 = B 0 A0 .

(Achtung: i.a. AB 6= BA !)

53

6. Operationen mit Matrizen

54

7. Die Inverse einer Matrix

Definition 7.1 (Einheitsmatrix)

1 0 0 ...

0 1 0 ...

I = In,n = 0 0 1 . . .

.. .. .. . .

. . .

.

0 0 0 ...

0

0

0

..

.

heißt (n,n)–Einheitsmatrix

1

Satz 7.1 Für alle x ∈ Rn und für alle A = An,n gilt:

Ix = x, AI = IA = A

(I spielt die Rolle der Eins !)

Definition 7.2 (Inverse Matrix) Sei A = An,n . Existiert eine (n,n)–Matrix X,

so dass

AX = XA = I,

so heißt A−1 := X die inverse Matrix oder die Inverse von A.

Beispiele:

a) I −1 = I, da II = I

−1

0 0

b)

existiert nicht ! =⇒ Inverse existieren nicht immer !

0 0

c) (a11 )−1 = a111 , wenn a11 6= 0

Satz 7.2 A = An,n hat höchstens eine Inverse A−1 = X.

7. Die Inverse einer Matrix

Satz 7.3 (Eigenschaften von Inversen) Sei A = An,n , B = Bn,n mit Inversen

A−1 , B −1 .

a) (A−1 )−1 = A

b) (AB)−1 = B −1 A−1

c) (λA)−1 = λ1 A−1 für alle λ 6= 0

d) (A0 )−1

= (A−1 )0

Anwendung auf LGS mit A = An,n

LGS: Ax = b

=⇒

A−1 (Ax) = A−1 b

| {z }

(A−1 A) x = A−1 b

| {z }

Ix = x = A−1 b

x = A−1 b, wenn A−1 existiert !

Berechnung der Inversen A−1 = X

Bedingung für X: AX = XA = I

Bemerkung: AX = I

Kap. 8

=⇒

XA = I

=⇒ Die Bedingung AX = I ist ausreichend zur Darstellung von A−1 = X !

Es ist AX = (Ax1 , Ax2 , . . . , Axk , . . . , Axn ), wobei

{z

}

|

n–Spalten von AX

xk = k–te Spalte der unbekannten Matrix A−1 = X

I = (e1 , e2 , . . . , ek , . . . , en )

|

{z

}

n–Spalten von I

=⇒

AX = I

⇐⇒

Ax1 = e1

Ax2 = e2

..

.

Axn = en

Beispiel

n=2:

a11 x11

x1 :

a21 x11

a11 x12

x2 :

a21 x12

+ a12 x21 = 1

+ a22 x21 = 0

zu lösen bei der Berechnung

von A−1 = X sind somit:

n LGS mit je n Unbekannten

und n Gleichungen

=⇒

x1 =

x11

x21

=

a22

D

− aD21

a12 + a12 x22 = 0

x12

−D

=⇒ x2 =

=

a11

+ a22 x22 = 1

x22

D

a22

a12

−

D

D

=⇒ A−1 =

, falls D 6= 0

− aD21 aD11

=⇒

56

A−1 existiert ⇐⇒

mit D = det(A)

:= a11 a22 − a21 a12

det(A) := a11 a22 − a12 a21 6= 0

(entsprechendes gilt auch allgemein !)

n=3:

A−1 = X = (x1 , x2 , x3 )

x1 :

a11 t1 + a12 t2 + a13 t3 =

a21 t1 + a22 t2 + a23 t3 =

a31 t1 + a32 t2 + a33 t3 =

x2 :

a11 t1 + a12 t2 + a13 t3 =

a21 t1 + a22 t2 + a23 t3 =

a31 t1 + a32 t2 + a33 t3 =

x3 :

a11 t1 + a12 t2 + a13 t3 =

a21 t1 + a22 t2 + a23 t3 =

a31 t1 + a32 t2 + a33 t3 =

=⇒ 3 LGS

1

0

=⇒

0

0

1

=⇒

0

0

0

=⇒

1

sind zu lösen:

t = x1

t = x2

t = x3

57

7. Die Inverse einer Matrix

58

8. Rang von Matrizen

Anwendung: Kriterium für die Existenz und Eindeutigkeit von Lösungen von

linearen Gleichungssystemen.

Sei A = Am,n

A = (a1 , a2 , . . . , an ) =

|

{z

}

n Spalten von A

a1

a2

..

.

am

| {z }

m Zeilen von A

Definition 8.1 (Spaltenrang, Zeilenrang) Unter dem Spaltenrang Rgs A bzw.

Zeilenrang Rgz A einer Matrix A versteht man die Elementzahl der größtmöglichen Mengen linear unabhängiger Spalten bzw. Zeilen von A oder kurz:

Die maximale Anzahl linear unabhängiger Spalten bzw. Zeilen von A !

Satz 8.1 0 ≤ Rgs A ≤ n, 0 ≤ Rgz A ≤ m.

Beispiele:

1.

A=

0 0 0

0 0 0

B=

1 −1 2

=⇒

Rgs A = Rgz A = 0

=⇒

Rgs B = Rgz B = 1

1 1 1

C= 2 2 2

3 3 3

=⇒

Rgs C = Rgz C = 1

=⇒

Rgs D = Rgz D = 2

2.

3.

4.

D=

5.

1 0 2 3

0 1 0 0

8. Rang von Matrizen

1 0 0

E = 0 1 0 = I =⇒

0 0 1

Rgs E = Rgz E = 3

(in diesen Beispielen ist stets Rgs A = Rgz A)

Satz 8.2 Stets gilt:

Rgs A = Rgz A

(für beliebige Matrizen A)

Definition 8.2 (Rang) Unter dem Rang Rg A einer Matrix versteht man:

Rg A := Rgs A = Rgz A

Aus Satz 8.1 folgt:

Satz 8.3

Rg A ≤ m, Rg A ≤ n

⇐⇒

Rg A ≤ min(m, n)

8.1. Berechnung des Ranges einer (m, n)-Matrix A

8.1.1. Treppenmatrizen

Definition 8.3 (Treppenmatrix) Unter einer (m, n)-Treppenmatrix T = Tr

mit einer natürlichen Zahl r, 1 ≤ r ≤ min(m, n), versteht man eine Matrix der

Gestalt

t1r+1 t1r+2 . . . t1n

t11 t12 t13 . . . t1r

0 t22 t23 . . . t2r

t2r+1 t2r+2 . . . t2n

0 0 t33 . . . t3r

t3r+1 t3r+2 . . . t3n

.

..

.. . .

..

..

..

. . . ..

.

.

.

.

.

.

.

.

.

trr+1 trr+2 . . . trn

T = 0 0 0 . . . trr

0

0

... 0

0 0 0 ... 0

.

..

.. . .

.

..

..

.

..

..

. ..

. ..

.

.

.

.

0 0 0 ... 0

0

0

... 0

wobei

t11 6= 0, t22 6= 0, . . . , trr 6= 0.

Beispiele:

1) 60

1 |0 1 0 1

mit r = 1

8.1. Berechnung des Ranges einer (m, n)-Matrix A

2)

1 0 |1 0 0 4

0 1 | 2 −1 3 5

0 0 |0 0 0 0

3)

4)

−1 0 2 |

0 1 3 |

0 0 −2 |

0 0 0 |

1 0 0

0 1 0 ,

8 3 1

mit r = 2

mit r = 3

1 8 7

0 0 2 sind keine T –Matrizen !

0 0 3

Satz 8.4 Rg T = Rg Tr = r

Bedeutung der T –Matrizen

bel. Matrix A

e.U.

−→

T = Tr

=⇒

Rg A = Rg Tr = r

8.1.2. Elementare Umformung von Matrizen

Achtung: Dienen auch zur Lösung LGS !

Definition 8.4 (Elementare Umformungen) Elementare Umformungen (e.U.)

einer beliebigen (m, n)-Matrix A sind folgende Operationen:

I. Vertauschen zweier Zeilen der Matrix,

II. Vertauschen zweier Spalten der Matrix,

III. Addition des λ-fachen einer Zeile zu einer anderen Zeile der Matrix.

Beispiele

1 1 2

0 −1 1

2 1 3

1 1 2

0 −1 1

2 1 3

0 −1 1

I

−→ 1 1 2

2 1 3

1 1 2

II

−→ −1 0 1

1 2 3

61

8. Rang von Matrizen

1 1 2

·(−3)

1 1 2

III

0 −1 1

−→ 0 −1 1

2 1 3

−1 −2 −3

Satz 8.5 Bei e.U ändern sich Rgs A, Rgz A und somit auch Rg A nicht !

Satz 8.6 Eine beliebige Matrix A 6= 0 kann durch e.U. in eine Treppenmatrix

transformiert werden.

Beispiel:

0 1 1

0 0 3

A=

2 1 4

1 1 −1

I

−→

III

−→

1 0

0 1

0 2

0 0

1 0

0 1

0 0

0 0

0 1

·(−1)

0 3

II

III

−→

−→

2 4

1 −1

1

1 0 1

0 1 −2

−2

III

·(−2)

−→

0 0 7

3

3

0 0 3

1 |

−2 |

7 |

mit r = 3

0 |

1

0

1

1

1

0

0

0

0 1

0 3

2 3

1 −2

· − 73

8.1.3. Berechnung von RgA

Verfahren: A

e.U.

−→

Tr

=⇒

Rg A = r

Beweis: folgt aus Satz 8.4 und 8.5, 8.6 !

Obiges Beispiel: Rg A = r = 3

Weitere Folgerungen aus den Sätzen 8.2 und 8.3:

Satz 8.7 Rg A = Rg A0

Beweis:

Rg A = Rgs A = Rgz A0 = Rg A0

Satz 8.8 Im Rn sind n + 1 (und mehr) beliebige n–Tupel stets linear abhängig.

Mengen von linear unabhängigen n–Tupeln im Rn enthalten also höchstens n Elemente.

62

8.1. Berechnung des Ranges einer (m, n)-Matrix A

Beweis Zu x1 , . . . , xn , xn+1 ∈ Rn bilde die (n, n + 1)–Matrix

A = (x1 , x2 , . . . , xn+1 ).

Nach Satz 8.3 gilt dann:

Rg A ≤ min(n, n + 1) = n

I. Anwendung:

Lösungen LGS

=⇒

x1 , x2 , . . . , xn+1 linear abhängig.

Rangkriterium für Existenz und Eindeutigkeit von

Betr.: LGS Ax = b, A = Am,n

Definition 8.5 (Erweiterte Koeffizientenmatrix) Unter der erweiterten Koeffizientenmatrix [A, b] versteht man die (m, n + 1)–Matrix

[A, b] =

a11 a12 . . . a1n

a21 a22 . . . a2n

..

..

..

.

.

.

am1 am2 . . . amn

b1

b2

..

.

bm

Satz 8.9 (Existenzsatz) Ein LGS Ax = b ist genau dann lösbar, wenn Rg [A, b] =

Rg A.

Beweis: Ax = b lösbar

⇐⇒

Satz 4.5

⇐⇒

b ist Linearkombination von a1 , a2 , . . . , an

Rg [A, b] = Rg A

Satz 8.10 Eindeutigkeitssatz

a) Ist Rg A = n, so hat Ax = b höchstens eine Lösung.

b) Ist Ax = b eindeutig lösbar, so ist Rg A = n.

Beweis: Ax = b hat genau (höchstens) 1 Lösung

=⇒ (⇐=) a1 , a2 , . . . , an linear unabhängig ⇐⇒

Rg A = n (siehe Satz 4.6).

Übersicht über die Lösbarkeits– und Eindeutigkeitsverhältnisse für

verschiedene m, n

s = Rg [A, b]

Es sei

=⇒ s = r oder s = r + 1

r = Rg A

r ≤ min(m, n)

nach Satz 8.3

s ≤ min(m, n + 1)

63

8. Rang von Matrizen

A) m < n (Weniger Gleichungen als Unbekannte)

min(m, n) = m

=⇒ r ≤ s ≤ m < n

1. r = s

=⇒ System hat ∞ viele Lösungen (Sätze 8.9, 8.10)

Beispiel:

1 1 0

A=

,

0 1 2

=⇒

b=

3

−4

⇐⇒

x1 + x2

= 3

x2 + 2x3 = −4

∞ viele

Lösungen

m = 2, n = 3, r = s = 2

2. r < s (= r + 1)

=⇒ System ist unlösbar (Satz 8.9)

Beispiel:

1 0 0

A=

,

2 0 0

=⇒

b=

1

−1

⇐⇒

x2

2x2

= 1

= −1

Widerspruch

m = 2, n = 3, r = 1, s = 2

B) m = n (Gleichviele Gleichungen wie Unbekannte)

min(m, n) = m = n

=⇒

r≤s≤m=n

3. r = s < m = n

Beispiel:

1 0

A=

,

2 0

=⇒

Beispiel:

1 0

A=

,

2 1

b=

1

2

⇐⇒

x1 + 0x2 = 1

2x1 + 0x2 = 2

∞ viele

Lösungen

eindeutig

best. Lösung

=⇒ System hat genau 1 Lösung

b=

1

2

⇐⇒

x1

= 1

2x2 + x2 = 2

m=n=r=s=2

5. r < s < m = n

64

m = n = 2, r = s = 1

4. r = s = m = n

=⇒

=⇒ System hat ∞ viele Lösungen

=⇒ System ist unlösbar

8.1. Berechnung des Ranges einer (m, n)-Matrix A

Beispiel:

0 0

A=

,

0 0

=⇒

b=

1

1

⇐⇒

0x1 + 0x2 = 1

0x1 + 0x2 = 1

Widerspruch

r = 0, s = 1, m = n = 2

6. r < s = m = n

Beispiel:

1 0

A=

,

1 0

=⇒

=⇒ System ist unlösbar

b=

0

1

⇐⇒

x1

x1

= 0

= 1

Widerspruch

r = 1, s = 2, m = n = 2

C) m > n (Mehr Gleichungen als Unbekannte

=⇒

min(m, n) = n

7. r < s (= r + 1) ≤ n + 1 ≤ m

Beispiel:

1 0

A = 0 1 ,

0 0

=⇒

⇐⇒

System ist unlösbar

x1 +

=0 +

x2 =

0

Widerspruch

0x1 + 0x2 =

1

r = 2, s = 3, n = 2, m = 3

8. r = s < n < m

Beispiel:

1 0

A = 1 0 ,

0 0

=⇒

0

b= 0

1

⇐⇒

=⇒ System hat ∞ viele Lösungen

2

b= 2

0

⇐⇒

+

x1 + 0x2 = 2

∞ viele

x1 + 0x2 = 2

Lösungen

0x1 + 0x2 = 0

r = 1, s = 1, n = 2, m = 3

9. r = s = n < m

=⇒ System hat eindeutig bestimmte Lösung

Beispiel:

65

8. Rang von Matrizen

1 0

A = 0 1 ,

0 0

=⇒

1

b 2

0

⇐⇒

x1

x2

= 1

= 2

eindeutige

Lösung

r = 2, s = 2, n = 2, m = 3

II. Anwendung:

Existenz der inversen Matrix

Definition 8.6 Eine (n, n)–Matrix A heißt regulär, wenn Rg A = n.

Im Folgenden sei A = An,n regulär, also Rg A = n.

Betrachte: beliebige n–Vektoren b und das LGS Ax = b

=⇒

n = Rg A ≤ Rg [A, b]

| {z }

Satz 8.3

≤

min(n, n + 1) = n

(n, n + 1)–

Matrix

=⇒

n = Rg A = Rg [A, b]

Satz 8.9, 8.10 =⇒

Ax = b hat eine eindeutig bestimmte Lösung x.

a) Betr.: nun AX = I

A regulär =⇒

=⇒

Kap. 7

⇐⇒

Axk = ek , k = 1, 2, . . . , n wobei X = (x1 , x2 , . . . , xn )

Axk = ek hat eindeutig bestimmte Lösung x◦k

AX = I hat eindeutig bestimmte Lösung X ◦ := (x◦1 , x◦2 , . . . , x◦n )

b) Betr.: umgekehrt Y A = I

Transposition

=⇒

Rg A0

Satz 8.7

=

(Y A)0 = I 0 = I

=⇒

Rg A = n =⇒

A0 ist regulr

(Transposition)

a), b) =⇒

=⇒

A0 Y 0 = I

=⇒

w.o.

A0 Y 0 = I hat eindeutig bestimmte Lösung W ◦ mit Y 0 = W ◦

=⇒

Y A = I hat eindeutig bestimmte Lösung Y ◦ = W ◦ 0

Y ◦ = Y ◦ I = Y ◦ (AX ◦ ) = (Y ◦ A)X ◦ = IX ◦ = X ◦

Y ◦ = X◦

AX = XA = I hat eindeutig bestimmte Lösung X = X ◦

Satz 8.11 Falls A regulär ist, so existiert die Inverse A−1 (= X ◦ ) und A−1 ist

eindeutig bestimmt.

Beweis der Eindeutigkeit von A−1 :

66

8.1. Berechnung des Ranges einer (m, n)-Matrix A

Annahme: A hat zwei Inverse X und Y

=⇒

AX = XA = AY = Y A = I

=⇒

X = XI = X(AY ) = (XA)Y = IY = Y

Satz 8.12 Falls A−1 existiert, so ist A regulär.

Beweis: Annahme: A ist nicht regulär ⇐⇒

=⇒

A−1 (Ax) = A−1 0 = 0

=⇒

x=0

=⇒

Rg A = n

7→

es gibt x 6= 0 mit Ax = 0

Widerspruch zu vorher !

67

8. Rang von Matrizen

68

9. Lösungsverfahren für lineare

Gleichungssysteme (LGS)

Hilfsmittel: e.U. angewendet auf [A,b]

LGS A · x = b

(9.1)

erweiterte Koeffizientenmatrix [A, b ]

a11 x1 + a12 x2 + . . . + a1n xn = b1

a21 x1 + a22 x2 + . . . + a2n xn = b2

..

..

..

..

...

.

.

.

.

am1 x1 + am2 x2 + . . . + amn xn = bm

a11 a12

a21 a22

..

..

.

.

am1 am2

. . . a1n | b1

. . . a2n | b2

.

. . . ..

. | ..

. . . amn | bm

⇐⇒

e.U. von [A,b]

A) Vertauschen zweier Gleichungen

⇐⇒

I. Vertauschen zweier Zeilen von

[A,b]

B) Vertauschen zweier Unbekannten

xk , xj mit den zugehörigen Koeffizienten aik , aij

⇐⇒

f Vertauschen zweier Spalten

II.

der Teilmatrix A von [A,b]

C) Addition des λ–fachen einer Gleichung zu einer anderen Gleichung

⇐⇒

III. Addition des λ–fachen einer

Zeile von [A, b] zu einer anderen

Zeile von [A,b]

Operationen an (9.1)

Eigenschaften der Operationen

(A) ⇐⇒ (I),

f

(B) ⇐⇒ (II),

(C) ⇐⇒ (III)

f (III) der erweiterten Koeffizientenmatrix

Satz 9.1 Bei e.U. des Typs (I), (II),

[A, b ] wird:

9. Lösungsverfahren für LGS

[A, b] in eine (m, n + 1)– Matrix

| {z }

1.

m

[Â, b] transformiert und

| {z }

m

z

}|

{

z

}|

{

2. LGS(1) A · x = b geht über in ein LGS(1̂) Â · x̂ = b̂

Dabei gilt:

3.Die Lösungen x̂ von (1̂) unterscheiden sich von den Lösungen x von (1) höchstens

f verwendet wurde.

in einer Vertauschung der Komponenten xk , falls (II)

9.1. Beschreibung der praktischen Durchführung des

Lösungsverfahrens: Gauss–Algorithmus

Stufe 1:

e.U.

[A, b]

-

f III

I, II,

(Satz 8.6)

[Â, b̂], wobei  = Tr eine Treppenmatrix ist mit T = Tr

e.U.

(9.1): A · x = b

-

f III

I, II,

ˆ : Â · x̂ = b̂

(9.1)

m

m

x1

a11

a21

..

.

x2

a12

a22

..

.

...

...

...

..

.

xn

a1n

a2n

..

.

b1

b2

..

.

am1

am2

...

amn

bm

so dass

A

↓

= Tr

nicht vorhanden, wenn

r=m

70

xk1

â11

â21

..

.

xk2

â12

â22

..

.

0

—

0

..

.

0

|

0

—

0

..

.

. . . xkr

. . . â1r

. . . â2r

..

..

.

.

. . . ârr

— —

... 0

..

.

0

...

|

|

|

|

—

|

|

|

0

{z

(∗)

xkr+1

â1r+1

â2r+1

..

.

...

...

...

xkn

â1n

â2n

..

.

←−

b̂1

b̂2

..

.

ârr+1

—

0

..

.

...

—

...

ârn

—

0

..

.

b̂r

0

...

0

Â=Tr :â11 6=0,...,ârr 6=0

b̂r+1

..

.

b̂m

}

9.1. Praktische Durchführung

|

{z

}

nicht vorhanden wenn r = n

(∗)–Vertauschungen von Spalten von A in der Variablenzeile markiert.

1. Fall: es gibt ein r + 1 ≤ i ≤ m mit b̂i 6= 0

=⇒ Rg A = Rg Tr = r < r + 1 = Rg[A, b] =⇒ (9.1) ist unlösbar

2. Fall: r = m oder alle b̂i = 0, i = r + 1, . . . , m =⇒ Rg A = Rg [A, b]

=⇒ (9.1) ist lösbar

Stufe 2: falls r = m oder b̂i = 0 für alle i = r + 1, . . . , m

[Â, b̂]

↑

Tr

e.U.

-

III

[A∗ , b∗ ]

D | R

mit A∗ = — — —

0 | 0

wobei D: Diagonalmatrix und

R: Restmatrix

D | R

Bemerkung: A∗ = — — —

} nicht vorhanden, wenn r = m

0 | 0

| {z }

nicht vorh., wenn r = n

im Detail:

71

9. Lösungsverfahren für LGS

xk1

â11

0

..

.

xk2

â12

â22

..

.

0

—

0

..

.

0

—

0

..

.

. . . xkr

. . . â1r

. . . â2r

..

..

.

.

. . . ârr

— —

... 0

..

.

0

0

...

0

|

|

|

|

—

|

|

|

xkr+1

â1r+1

â2r+1

..

.

. . . xkn

. . . â1n

. . . â2n

..

.

ârr+1

—

0

..

.

...

—

...

ârn

—

0

..

.

0

...

0

b̂1

b̂2

..

.

·(− ââ12

)

22

b̂r

0

..

.

0

nicht vorh.,

wenn r = m

e.U.

-

III

xk1

a∗11

0

..

.

xk2

0

a∗22

..

.

...

...

...

..

.

xkr

0

0

..

.

0

—

0

..

.

0

—

0

..

.

...

—

...

a∗rr

—

0

..

.

0

0

...

0

|

|

|

|

—

|

|

|

mit a∗ii = âii 6= 0,

Folgerung: A · x = b

A∗ · x̂ = b∗ lautet:

72

⇐⇒

xkr+1

a∗1r+1

a∗2r+1

..

.

...

...

...

xkn

a∗1n

a∗2n

..

.

a∗rr+1

—

0

..

.

...

—

...

a∗rn

—

0

..

.

b∗r

0

...

0

0

i = 1, 2, . . . , r

A∗ ·x̂ = b∗

↑

keine Komponentenvertauschung in Stufe 2

· x̂ = b̂

⇐⇒

b∗1

b∗2

..

.

0

..

.