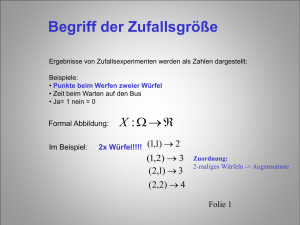

Stochastik

Werbung