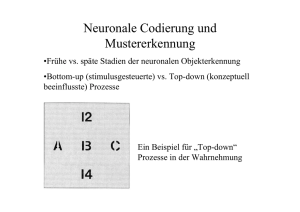

Die Rolle von Dopamin in cortico-striatalen Schaltkreisen bei der

Werbung