Wissen in Multiagentensystemen - Institut für Informatik

Werbung

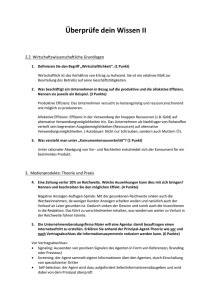

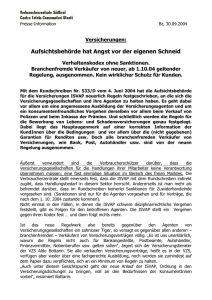

Wissen in Multiagentensystemen Timo Klerx Universität Paderborn Fakultät für Elektrotechnik, Informatik und Mathematik Institut für Informatik 33098 Paderborn [email protected] Zusammenfassung In dieser Ausarbeitung wird untersucht, wie Wissen in Multiagentensystemen gespeichert werden kann und Inkonsistenzen vermieden oder aufgelöst werden können. Zuerst werden verschiedene Möglichkeiten der Wissensrepräsentation vorgestellt. Diese reichen von konkreten Modellen wie dem Partitionenmodell bis hin zu abstrakten Modellen der Coalition Logic. Anschließend werden die Verfahren Konsensus, Revision und Fusion zur Vermeidung oder Auflösung von Inkonsistenzen erläutert. Am Schluss werden die vorgestellten Modelle und Verfahren im Bezug auf die Projektgruppe „Learning Agents in Dynamic Environments“ kurz evaluiert. 1 Einleitung Dieses Thema befasst sich mit der Repräsentation, der Verbreitung und der Verarbeitung von Wissen in Multiagentensystemen. Zuerst wird eine formale Definition für die Wissensrepräsentation eines Agenten gegeben. Es wird dabei zwischen Wissen eines einzelnen Agenten, Wissen mehrerer Agenten und allgemeinem Wissen unterschieden. Offensichtlich ist es ein Unterschied, ob ein Agent weiß, dass sich irgendwo ein bestimmter Gegenstand befindet, oder ob alle Agenten dieses Wissen teilen. Je nach Kontext reicht es aus, dass ein Agent einen Teil seines Wissen für sich behält, einen Teil einer gewissen Gruppe von Agenten und einen weiteren Teil allen Agenten mitteilt. Um das Wissen eines Agenten bestimmten (oder allen) Agenten mitzuteilen, bedarf es Schnittstellen. Dabei ist es nicht nur erforderlich, einem anderen Agenten A sein Wissen mitzuteilen. Wenn man von fehlerbehafteter Kommunikation ausgeht, muss man auch sicher sein, dass A dieses Wissen erhalten hat und A muss sich sicher sein, dass man selbst weiß, dass A dieses Wissen erhalten hat (und so weiter...). Dieses Problem ist vergleichbar mit dem sehr bekannten Zwei-Armeen-Problem (s. 2.3), das nicht lösbar ist. Zusätzlich müssen neue Entdeckungen eines Agenten in seine Wissensbasis integriert werden. Betrachtet man einen einzelnen Agenten, kann eine neue Entdeckung inkonsistent zu dem bis dato aktuellen Wissen des Agenten sein - diese Inkonsistenz muss aufgelöst werden. Erweitert man das Szenario derart, dass die Entdeckung anderen Agenten mitgeteilt werden soll, muss die Entdeckung auch von anderen Agenten in ihre Wissensbasis integriert werden. Unter Umständen ist die Entdeckung auch zu der Wissensbasis eines anderen Agenten inkonsistent. Die Frage ist dann, welcher Agent „Recht“ hat. Agent A entdeckt einen Baum. Agent B fällt diesen Baum direkt nachdem A diesen Baum entdeckt hat. Kurze Zeit später treffen sich A und B und tauschen ihr Wissen über diesen Baum aus. A ist überzeugt, der Baum steht noch, B ist jedoch auch überzeugt, dass der Baum gefällt ist. Als Beobachter 118 Timo Klerx weiß man, dass B „Recht“ hat. Jedoch gibt es in Multiagentensystemen einen solchen Beobachter nicht. Die Herausforderung besteht darin, diesen Konflikt richtig aufzulösen, sodass A und B überzeugt sind, dass der Baum gefällt wurde. 2 Wissensrepräsentation Bevor Inkonsistenzen aufgelöst werden können, muss zuerst geklärt werden, wie Wissen modelliert werden kann. Anhand eines ausführlichen Beispiels werden die formalen Definitionen zur Wissensrepräsentation gegeben: n Kinder spielen im Garten und es ist möglich, dass sie dabei Matsch auf die Stirn bekommen. Keines der Kinder weiß jedoch, dass seine Stirn dreckig ist. Als die Kinder wieder ins Haus gehen, sieht der Vater die Kinder und bittet sie, sich im Kreis aufzustellen. Jedes Kind sieht, ob andere Kinder eine dreckige Stirn haben. Der Vater sagt: „Mindestens einer hat Dreck auf seiner Stirn. Jeder, der Dreck auf der Stirn hat, hebe die Hand“. Falls keiner die Hand hebt, wiederholt der Vater seinen Satz. Bei k dreckigen Kindern heben nach k Runden alle dreckigen Kinder gleichzeitig ihre Hand, denn nach k Runden wissen alle dreckigen Kinder, dass sie Dreck auf der Stirn haben. Um das Wissen jedes Kindes zu beschreiben, wird das Partitionenmodell vorgestellt und anhand eines Beispiels mit zwei Kindern verdeutlicht. Definition 1 (Partitionenmodell). Ein n-Agenten Partitionenmodell über eine Sprache Σ ist ein Tupel A = (W, π, I1 , ..., In ), mit – W: eine Menge von möglichen Welten – π : Σ → 2W : eine Interpretationsfunktion, die bestimmt, welche Sätze der Sprache in welchen Welten wahr sind – Ii : eine Menge von möglichen Welten, die aus Sicht von Agent i äquivalent sind. Ii ist eine Partition der möglichen Welten W mit Ii = (Wi1 , ..., Wir ) und Ii (w) = {w0 |w ∈ Wij und w0 ∈ Wij }. Ii (w) enthält alle Welten der Partition, in der w enthalten ist bzgl. Agent i. Außerdem definiere Ki ϕ, dass Agent i ϕ weiß und |= den logischen Schluss für das Partitionenmodell wie folgt: Definition 2 (Logischer Schluss im Partitionenmodell). Sei A = (W, π, I1 , ..., In ) ein Partitionenmodell über Σ und w ∈ W . – Für ϕ ∈ Σ: A, w |= ϕ ⇔ w ∈ π(ϕ) – A, w |= Ki ϕ ⇔ ∀w0 ∈ W : w0 ∈ Ii (w) → A, w0 |= ϕ Der erste Teil der Definition füllt die Interpretationsfunktion π mit Semantik. Der zweite Teil sagt aus, dass man schließen kann, dass Agent i ϕ weiß, gdw. ϕ in allen Welten wahr ist, die i nicht von der wahren Welt unterscheiden kann. Als Σ wählt man Fakten, die in einer Welt auftreten können - in diesem Fall muddyk als Aussage, die angibt, dass Kind k Dreck auf der Stirn hat. Betrachtet man zwei Kinder, die im Garten gespielt haben und beide Dreck auf der Stirn haben, ergibt sich folgende Ausprägung des Partitionenmodells, wenn die Kinder sich angucken, der Vater aber noch nichts gesagt hat (zur Verdeutlichung der Partitionen werden die Partitionsmengen mit eckigen Klammern markiert): Wissen in Multiagentensystemen – – – – 119 Σ = {muddy1, muddy2} W = {{muddy1, muddy2}, {muddy1, ¬muddy2}, {¬muddy1, muddy2}, {¬muddy1, ¬muddy2}} I1 = {[{muddy1, muddy2}, {¬muddy1, muddy2}], [{muddy1, ¬muddy2}, {¬muddy1, ¬muddy2}]} I2 = {[{muddy1, muddy2}, {muddy1, ¬muddy2}], [{¬muddy1, muddy2}, {¬muddy1, ¬muddy2}]} Abbildung 1. Partitionenmodell als die Kinder sich sehen Anschaulich sagt I1 aus, dass Kind 1 zu diesem Zeitpunkt alle möglichen Welten in zwei Partitionen teilen kann (s. Abb. 1): Die Welten, in denen Kind 2 dreckig ist und diejenigen, in denen Kind 2 nicht dreckig ist. Da Kind 1 Kind 2 sieht, kann es die Partitionen, die ¬muddy2 enthalten, als „falsche“ Partitionen kennzeichnen, also gilt: K1 muddy2. Gleiches gilt analog für Kind 2. Nachdem der Vater gesagt hat, dass mindestens ein Kind dreckig ist, verändern sich I1 und I2 (s. Abb 2), denn es kann ausgeschlossen werden, dass beide Kinder sauber sind. Es bilden sich sowohl in I1 als auch in I2 eine neue Partition mit einem Element: {¬muddy1, ¬muddy2}. Dieses Element verschwindet aus den anderen Partitionen. – I1 = {[{muddy1, muddy2}, {¬muddy1, muddy2}], [{muddy1, ¬muddy2}], [{¬muddy1, ¬muddy2}]} – I2 = {[{muddy1, muddy2}, {muddy1, ¬muddy2}], [{¬muddy1, muddy2}], [{¬muddy1, ¬muddy2}]} Keines der Kinder hat seine Hand gehoben, da das jeweils andere Kind das einzig dreckige sein könnte. Daraus kann jedes Kind schließen, dass es mehr als nur ein dreckiges Kind gibt. Danach kann jedes Kind vier 1-elementige Partitionen bilden und die „wahre“ Welt erkennen (s. Abb 3). Sobald der Vater seine Frage stellt, melden sich beide Kinder. – I1 = {[{muddy1, muddy2}], [{¬muddy1, muddy2}], [{muddy1, ¬muddy2}], [{¬muddy1, ¬muddy2}]} – I2 = {[{muddy1, muddy2}], [{muddy1, ¬muddy2}], [{¬muddy1, muddy2}], [{¬muddy1, ¬muddy2}]} Es gelten also folgende Aussagen: K1 muddy1, K1 muddy2, K2 muddy1, K2 muddy2. 120 Timo Klerx Abbildung 2. Partitionenmodell nach der Aussage des Vaters Abbildung 3. finales Partitionenmodell 2.1 Modale Logik Um nicht nur „wahr“ oder „falsch“, sondern auch „vielleicht“ modellieren zu können, bedarf es der Einführung modaler Logik. Modale Logik erweitert die klassische Logik um einen oder mehr modale Operatoren. An dieser Stelle werden zuerst die beiden häufigsten Operatoren und ♦ vorgestellt. wird oft als Notwendigkeit angesehen, d. h. ϕ bedeutet, dass ϕ notwendig wahr ist. ♦ ist der duale Operator - in gewisser Weise das Gegenteil zu - und bezeichnet eine Möglichkeit. ♦ϕ bedeutet also, dass ϕ möglicherweise wahr ist. Daraus ergibt sich folgende Beziehung für und ♦: ♦ϕ ≈ ¬¬ϕ. So können durch die neuen Operatoren verschiedene „Wahrheitsstärken“ ausgedrückt werden. Es ist offensichtlich, dass eine Notwendigkeit ihre klassische Aussage impliziert (ϕ → ϕ) und eine klassische Aussage eine mögliche (ϕ → ♦ϕ). Es gilt folglich, dass Notwendigkeit auch Möglichkeit impliziert (ϕ → ♦ϕ). Semantisch wird modale Logik durch mögliche-Welten-Strukturen respektive Kripkestrukturen definiert. Eine Kripkestruktur ist ein Paar (W, R) mit W als Menge möglicher Welten und R als binäre Relation über alle w ∈ W . R wird auch Erreichbarkeitsrelation Wissen in Multiagentensystemen 121 genannt. Man kann sich Kripkestrukturen als gerichteten Graphen vorstellen, wobei jeder Knoten eine mögliche Welt ist und R die Kantenmenge definiert. Die Wahrheit einer modalen Formel wird im Bezug auf eine Welt w ∈ W in ihrer Kripkestruktur (W, R) evaluiert. Das Paar (M, |=) mit M = (W, R) wird als Kripkemodell bezeichnet. Der logische Schluss |= ist wie folgt definiert: Definition 3 (logischer Schluss für Kripkemodelle). – – – – M, w M, w M, w M, w |= p wenn p wahr ist in w für eine primitive Aussage p |= ϕ ∧ ψ ⇔ (M, w |= ϕ ∧ M, w |= ψ) |= ¬ϕ, falls M, w |= ϕ nicht gilt |= ϕ ⇔ für ein w0 ∈ M mit R(w, w0 ) M, w0 |= ϕ gilt Außerdem bedeute |= ϕ, dass ϕ in allen Kripkemodellen gültig und |=M ϕ, dass ϕ in allen Kripkemodellen einer Klasse M gültig ist. Die Gültigkeit eines Kripkemodells ist durch folgende Axiome definiert: Axiom (Klassisch). Alle aussagenlogischen Tautologien sind gültig Axiom (K). (ϕ ∧ (ϕ → ψ)) → ψ ist gültig Axiom (Modus Ponens). Wenn ϕ und ϕ → ψ gültig sind, dann ist auch ψ gültig Axiom (Notwendigkeitsregel). Wenn ϕ gültig ist, dann ist auch ϕ gültig. Dieses Axiom-System ist sowohl korrekt als auch vollständig. Korrektheit bedeutet, dass alle Aussagen, die durch diese Axiome als gültig bezeichnet werden, in allen Kripkemodellen wahr sind. Anders ausgedrückt: Was mit diesen Axiomen syntaktisch ableitbar ist, ist auch semantisch richtig. Vollständigkeit bedeutet, dass keine weiteren Axiome benötigt werden. Das Partitionenmodell (s. Definition 1) ist ein restriktives Kripkemodell. Es lassen sich Axiome aufstellen, die die Gültigkeit eines Partitionenmodells festlegen. Für dieses Axiomsystem muss das vorgestellte Kripkemodell wie folgt erweitert werden: Statt eines modalen Operators und einer Erreichbarkeits-Relation R werden n modale Operatoren und n Erreichbarkeitsrelationen eingeführt. Die Menge der möglichen Welten bleibt unberührt. Die letzte Definition für |= wird wie folgt geändert: – Für i = 1, ..., n : M, w |= i ϕ ⇔ für ein w0 ∈ W mit Ri (w, w0 ) gilt: M, w0 |= ϕ Für das Partitionenmodell müssen außerdem zusätzliche Axiome eingeführt werden, da R im Partitionenmodell die Eigenschaften einer Äquivalenzrelation erfüllen muss. Die Axiome sind Folgende: Axiom (K). (i ϕ ∧ i (ϕ → ψ)) → i ψ Axiom (D). ¬i (p ∧ ¬p) Axiom (T). i ϕ → ϕ Axiom (4). i ϕ → i i ϕ Axiom (5). ¬i ϕ → i ¬i ϕ Zusätzlich müssen Modus Ponens und die Notwendigkeitsregel gelten. Auch dieses Axiomsystem ist korrekt und vollständig. Die Namen der Axiome sind historisch bedingt. In vielen Arbeiten wird bei den Axiomsystemen für i oft Ki verwendet, was aber nicht mit dem Wissensoperator zu verwechseln ist und weswegen hier auf diese Notation verzichtet wird. 122 2.2 Timo Klerx Coalition Logic Eine besondere Form der modalen Logik ist Coalition Logic[5]. Sie verknüpft modale Logik und Spieltheorie. In der Coalition Logic werden nicht die Aktionen einzelner Agenten modelliert, sondern ihre Möglichkeiten. Es wird nur noch über Gruppen von Agenten gesprochen (C). Zusätzlich wird der modale Operator [C] eingeführt, der das Potential einer Gruppe C ausdrückt. [C]ϕ bedeutet, dass die Gruppe C ϕ erreichen kann, egal was Agenten außerhalb von C machen. Formal ist das Modell der Coalition Logic wie folgt definiert: Definition 4 (CL-Modell). Sei N eine Menge von Agenten und Φ0 eine Menge von primitiven Aussagen. Dann ist ein CL-Modell ein Tupel M = (S, E, V ) mit: – S: eine Menge von Zuständen respektive Welten – V : Φ0 → 2S gibt an, welche Aussage in welchen Welten wahr ist S – E: 2N → 22 sodass E(∅) = S und wenn C ⊂ C 0 , dann ist E(C 0 ) eine Verfeinerung von E(C) Formeln werden anhand folgender Regel gebildet: ϕ ::= ⊥|p|¬ϕ|ϕ ∨ ϕ|[C]ϕ mit p ∈ Φ0 und C ⊆ N . ⊥ ≈ p ∧ ¬p, > := ¬⊥ und ∧, → und ↔ sind wie in der Aussagenlogik definiert. Definition 5 (logischer Schluss für Coalition Logic). Sei M = (S, E, V ) ein CLModell im Zustand s und ϕ eine Formel. Der logische Schluss, kurz M, s |= ϕ, ist wie folgt definiert: – – – – – M, s 6|= ⊥ M, s |= p ⇔ p ∈ Φ0 ∧ s ∈ V (p) M, s |= ¬ϕ ⇔ M, s 6|= ϕ M, s |= ϕ ∨ ψ ⇔ M, s |= ϕ ∨ M, s |= ψ M, s |= [C]ϕ ⇔ ∃S 0 ∈ E(C), sodass ∀s0 ∈ S 0 : M, s0 |= ϕ (in Worten: [C]ϕ gilt im Zustand s, falls die Koalition C von s alle s0 ∈ S 0 mit M, s0 |= ϕ erreichen kann). Der Vorteil dieser Logik ist, dass man abstrakter über Ziele und, wenn man die Welt per Coalition Logic beschreibt, nicht mehr über Aktionen reden muss. 2.3 Gemeinsames Wissen Nachdem zusätzliche Möglichkeiten von Wissensrepräsentation vorgestellt wurden, wird auf die Frage der Koordination eingegangen, die mit der Repräsentation gemeinsamen Wissens korreliert. Im Szenario der dreckigen Kinder wird fehlerfreie Kommunikation angenommen. Ein Kind kann alle anderen Kinder sehen und kann sich sicher sein, welches Kind dreckig ist und welches nicht. In vielen Anwendungsbereichen findet man jedoch fehlerbehaftete Kommunikation. Dieses Problem lässt sich durch das Zwei-Armeen-Problem illustrieren: Auf zwei gegenüberliegenden Hügeln stehen zwei verbündete Armeen, die eine feindliche Armee im Tal zwischen den Hügeln angreifen wollen. Es ist nebelig, sodass kein Sichtkontakt herrscht. Nachrichten können nur durch einen Boten übertragen werden, wobei es jedoch passieren kann, dass der Bote auf dem Weg abgefangen wird. Die Armeen müssen gleichzeitig angreifen. Greift eine der beiden Armeen alleine an, verliert sie den Kampf gegen die Armee im Tal. Wissen in Multiagentensystemen 123 Jeder der befehlenden Generäle der Armeen L und R will nur angreifen, wenn sein gegenüber auch angreift und er auch weiß, dass sein gegenüber angreift. Sei attack die Aussage, die symbolisiert, dass angegriffen werden soll. Nehmen wir an, dass L einen Boten an R schickt und dieser auch ankommt. Also gilt KR attack (R weiß, dass L angreifen möchte). KL attack gilt jedoch nicht. Also schickt R einen Boten an L als Bestätigung. Falls der Bote ankommt, gilt KL KR attack (L weiß, dass R weiß, dass angegriffen werden soll). Allerdings gilt auch ¬KR KL KR attack, denn R weiß nicht, ob der Bote angekommen ist. Es wird klar, dass sich dieses Problem mit den hier gegebenen Annahmen nicht mit einer endlichen Anzahl von Boten lösen lässt. Wenn L und R wüssten, dass beide angreifen sollen und beide wüssten, dass der jeweils andere es auch wüsste, wäre das Problem lösbar. Daher wird gemeinsames Wissen benötigt. Gemeinsames Wissen ist Wissen, dass jedem Agenten zur Verfügung steht und von dem jeder Agent weiß, dass jeder andere Agent es weiß. Es wird ein neuer Operator EG ähnlich dem Ki Operator eingeführt, nur dass EG sich auf eine Gruppe von Agenten G bezieht. Definition 6 („Was jeder weiß“). Sei M eine Kripkestruktur, w eine mögliche Welt in M , G eine Gruppe von Agenten und ϕ eine Aussage modaler Logik. M, w |= EG ϕ ⇔ ∀w0 ∈ ∪i∈G Ii (w) : M, w0 |= ϕ In anderen Worten: Jeder weiß ϕ, wenn ϕ in allen Welten wahr ist, die von der aktuellen Welt aus gesehen als möglich angesehen werden. Gleichbedeutend ist folgende Aussage: ∀i ∈ G : M, w |= Ki ϕ. Gemeinsames Wissen lässt sich damit rekursiv wie folgt definieren: Definition 7 (gemeinsames Wissen). M, w |= CG ϕ ⇔ M, w |= EG (ϕ ∧ CG ϕ) Mit anderen Worten: Eine Aussage ϕ ist gemeinsames Wissen, wenn jeder Agent ϕ weiß und jeder Agent weiß, dass ϕ gemeinsames Wissen ist. CG ist dabei ein sogenanntes Fixpunktaxiom. Auch für gemeinsames Wissen lässt sich ein vollständiges und korrektes Axiomsystem aufstellen: V Axiom (A3). EG ϕ ↔ i∈G Ki ϕ Axiom (A4). CG ϕ → EG (ϕ ∧ CG ϕ) Axiom (R3). Aus ϕ → EG (ψ ∧ ϕ) schließe ϕ → CG ψ Außerdem lässt sich CG auch wie folgt ausdrücken: Theorem 1. Sei M eine Kripkestruktur, w eine mögliche Welt in M , G eine Gruppe von Agenten und ϕ eine modale Aussage. Dann ist M, w |= CG ϕ ⇔ M, w0 |= ϕ für jede mögliche Sequenz von möglichen Welten (w = w0 , w1 , ..., wn = w0 ) mit folgender Bedingung: ∀i ∈ [0; n)∃j ∈ G sodass wi+1 ∈ Ij (wi ) Für alle von w aus erreichbaren Welten w0 gilt: Für zwei aufeinanderfolgende Welten auf dem Weg von w zu w0 existiert ein Agent j, in dessen Partition beide aufeinanderfolgende Welten liegen. 3 Revision und Inkonsistenz In der Theorie werden verschiedene Prozesse beschrieben, wie Wissen oder auch Glauben (Belief) revidiert werden kann. Neues Wissen kann sowohl im Einklang als auch inkonsistent mit der Wissensbasis sein. Bei konsistentem Wissen kann es einfach zur Wissensbasis hinzugefügt werden (Expansion). Dieser triviale Fall wird nicht weiter betrachtet. 124 3.1 Timo Klerx Revision Bei Inkonsistenz muss entschieden werden, ob und welche Information zugunsten des neuen Wissens aus der Wissensbasis entfernt wird. In den meisten Theorien wird das neue Wissen nicht in Frage gestellt (s. [2], [3]) und es wird versucht, das neue Wissen derart in die Wissensbasis zu integrieren, dass die Wissensbasis wieder konsistent ist und möglichst wenig altes Wissen verloren geht (das neue Wissen war teilweise inkonsistent zum alten). Dazu wird in [3] der Revisionsprozess in zwei Phasen eingeteilt: In der ersten Phase revidiert der Agent, der neues Wissen „findet“, seine Wissensbasis und in der zweiten Phase wird das Wissen an alle anderen Agenten propagiert. Es wird jedoch ein Observer angenommen. Dabei werden bestimmte Anforderungen an den Revisionsoperator gestellt, ohne die Funktionsweise dieses Operators anzugeben. Der geforderte Operator ist ähnlich zu dem Operator, der durch die AGM-Postulate, nach Alchourrón, Gärdenfors und Makinson, definiert ist. Es wird dabei ein Revisionsoperator ∗, eine Theorie (=Menge von Überzeugungen) K und eine Aussage ϕ, die in K integriert werden soll, vorausgesetzt. K ∗ ϕ bezeichnet dabei die Revision von K durch ϕ. Die AGM-Postulate lauten wie folgt mit Cn(K ∗ ϕ) als Operator für den logischen Schluss: Definition 8 (AGM Postulate). – – – – – – – – K ∗ ϕ = Cn(K ∗ ϕ) ϕ∈K ∗ϕ K ∗ ϕ ⊆ Cn(K, ϕ) Wenn ¬ϕ ∈ / K, dann Cn(K, ϕ) ⊆ K ∗ ϕ Wenn ϕ erfüllbar, dann K ∗ ϕ erfüllbar Wenn |= ϕ ↔ ψ, dann K ∗ ϕ = K ∗ ψ K ∗ (ϕ ∧ ψ) ⊆ Cn(K ∗ ϕ, ψ) Wenn ¬ψ ∈ / K ∗ ϕ, dann Cn(K ∗ ϕ, ψ) ⊆ K ∗ (ϕ ∧ ψ) An dieser Stelle wird vor dem Hintergrund eines Multiagentensystems die Frage behandelt, ob Wissen überhaupt in die Wissensbasis aufgenommen werden soll. Betrachte folgendes Szenario: Zwei Agenten können sich bewegen, Gegenstände wahrnehmen, die Position der Gegenstände speichern und ihr Wissen austauschen. Agent 1 (a1 ) ist weit entfernt von Agent 2 (a2 ) und findet einen Gegenstand G an dieser Position p und integriert dieses Wissen in seine Wissensbasis, da er seinen Wahrnehmungssensoren vertraut. a1 und a2 „tauschen“ danach unkoordiniert ihre Positionen, ohne sich dabei über ihr Wissen auszutauschen. Als a2 p erreicht, ist dort kein Gegenstand mehr zu finden. Danach kommt es zum Informationsaustausch zwischen a1 und a2 . a1 sagt a2 , dass an Position p ein Gegenstand ist, a2 behauptet das Gegenteil. Offensichtlich hat a2 Recht, aber woher sollen a1 und a2 dieses Wissen beziehen? 3.2 Fusion Die Lösung heißt Fusion [1] und ist eine besondere Art der Revision. Es werden dabei nicht nur eine Wissensbasis und eine neue Tatsache, sondern zwei Wissensbasen zusammengeführt. Technisch betrachtet wird nach einer Ordnungsrelation über mögliche Welten (globale Zustände) gesucht, sodass definiert ist, welche mögliche Welt der „wahren“ Welt am nächsten ist. Wissen in Multiagentensystemen 125 Ein Agent bekommt von verschiedenen Quellen verschiedene Meinungen über mögliche Welten und muss versuchen, daraus eine möglichst genaue Aussage über die wahre Welt abzuleiten. Jede dieser Meinungen wird mit einer Annotation versehen, von welcher Quelle diese Meinung stammt. Oft stehen mehrere dieser Meinungen in Konflikt miteinander. Um diese Konflikte aufzulösen, wird eine Funktion benötigt, die über alle möglichen Welten eine strikte Reihenfolge bildet. Die Welt am Kopf dieser Reihe wird als neue Welt akzeptiert. Der sog. „pedigreed belief state“ wird wie folgt definiert: Definition 9 („pedigreed belief state“). Sei S eine endliche Menge von Zuständen über W, dann ist der „pedigreed belief state“ über W induziert durch S die Funktion Ψ : W ×W → 2S∪s0 , sodass Ψ (w1 , w2 ) = {(W, ≤) ∈ S : w2 w1 } ∪ {s0 } Umgangssprachlich ist Ψ (w1 , w2 ) die Menge aller Agenten, die nicht glauben, dass w2 mindestens genauso wahrscheinlich ist wie w1 . Der Agent s0 hat keinen Glauben und ist daher immer in dieser Menge. Im Folgenden wird S für alle Quellen über W stehen und es werden „pedigreed belief states“ betrachtet, die von einer Teilmenge von S induziert werden. ∅ und s0 induzieren dabei den gleichen „pedigreed belief state“. Durch einen Trick in der Notation wird jedoch beides als s0 deklariert. Als nächstes wird eine Policy definiert, um Konflikte innerhalb eines „pedigreed belief state“ aufzulösen. Für zwei Welten w1 und w2 gibt es zwei konkurrierende Mengen von Agenten: Ψ (w1 , w2 ) und Ψ (w2 , w1 ). Es wird eine strikte Reihenfolge (@) über S angenommen, also auch über die Quellen, die ein Ψ induzieren. s1 @ s2 wird als „s2 ist glaubhafter als s1 “ und s1 v s2 als „s2 ist glaubhafter oder genauso glaubhaft wie s1 “ definiert. Außerdem ist s0 per Definition die am wenigsten glaubhafte Quelle. Gegeben sei ein „pedigreed belief state“ Ψ , dann gebe Ψ@ die glaubhafteste Meinung zwischen zwei Welten an. Definition 10 (dominierender Glaubenszustand). Gegeben W, S, Ψ und @ wie vorher definiert, dann ist der dominierende Glaubenszustand von Ψ die Funktion Ψ@ : W × W → S, sodass ∀w1 , w2 ∈ W gilt: Wenn max(Ψ (w2 , w1 )) @ max(Ψ (w1 , w2 )), dann ist Ψ@ (w1 , w2 ) = max(Ψ (w1 , w2 )). Sonst ist Ψ@ (w1 , w2 ) = s0 . Also gilt für beliebige w1 , w2 ∈ W entweder Ψ@ (w1 , w2 ) = s0 oder Ψ@ (w2 , w1 ) = s0 oder beides. Ψ@ induziert also einen anonymen Glaubenszustand. Die Ordnung induziert von Ψ@ ist die binäre Relation 4 über W, sodass w1 4 w2 ⇔ Ψ@ (w2 , w1 )) = s0 . 4 definiert eine totale Ordnung über W und ist einer Verallgemeinerung für die normale Notation für Glaubenszustände. Damit lässt sich jetzt der Fusionsoperator definieren: Definition 11 (Fusionsoperator). Gegeben eine Menge von Quellen S und @ wie gehabt, S1 , S2 ⊂ S, den „pedigreed belief state“ Ψ1 induziert durch S1 und den „pedigreed N belief state“ Ψ2 induziert durch S2 , dann ist die Fusion aus Ψ1 und Ψ2 , notiert durch Ψ1 Ψ2 , der „pedigreed belief state“ induziert durch S1 ∪ S2 . Abbildung 4 veranschaulicht den Fusionsoperator. In dem Beispiel befinden sich drei Agenten A, B und C, die jeweils verschiedene Prioritäten haben. Die ersten drei Zeilen beschreiben die Sicht der Agenten über die vier Welten a, b, c und d in Form eines dominierenden Glaubenszustandes. Eine Kante von Kreis i zu Kreis j bedeutet, dass die Welten in Kreis j mindestens genauso wahrscheinlich sind wie die Welten in Kreis i. Jede Kante besitzt als Gewicht die Priorität des Agenten, der diesen „Belief“ hält. Die beiden letzten Zeilen 126 Timo Klerx zeigen die Fusion von A und C respektive (A und C) mit B. Die Diagramme geben dabei den Dominating belief state an. Bei der Fusion von A und C werden alle Überzeugungen von A übernommen, da A eine höhere Priorität als C besitzt. Da A keine Meinung über die Paare (a, b) und (c, d) hat, wird dafür die Meinung von C übernommen. Die verbleibende Überzeugung von C, c ≤C a wird von A’s Überzeugung a ≤A c dominiert. b ≤C d ist konsistent mit b ≤A d und taucht daher im Ergebnis nicht mehr auf. WennNdie Fusion von A und C mit B fusioniert wird, können nur die Überzeugungen von C in A C verändert werden, da A eine höhere Priorität als B hat, also können nur (a, b) und (c, d) verändert werden. Da B keine Meinung zu (c, d) hat, wird an dieser Stelle nichts geändert. Allerdings dominiert a ≤B b den Glauben b ≤A N C a, sodass die Kante zwischen a und b im Endergebnis umgekehrt wird und mit B’s Priorität gewichtet wird. Abbildung 4. Beispiel für den Fusionsoperator Wissen in Multiagentensystemen 3.3 127 Konsensus In [4] wird eine weitere Methode zum Auflösen von Inkonsistenzen vorgestellt. Sie beruht darauf, jeden Agenten nach seinem Glauben zu fragen und das als „wahr“ anzunehmen, was z.B. die Mehrheit der Agenten glaubt. Eine ähnliche Form des Konsensus besteht darin, möglichst wenig Änderungen in den Wissensbasen aller Agenten, die am Konsensus teilnehmen, vornehmen zu müssen. Es werden in [4] konkrete Algorithmen vorgestellt, die als Ergebnis eine konsistente Wissensbasis liefern. Bei einem Multiagentensystem mit n Agenten, bei dem ein Agent etwas Neues entdecken kann und es allen anderen Agenten mitteilen soll, funktioniert der Konsensus jedoch nicht wie gewollt. Da es sich bei jeder Art von Konsensus um einen Mehrheitsentscheid handelt, wird die Meinung des Agenten verworfen und die Entdeckung wird nicht in das Agentensystem integriert. Nur wenn viele Agenten - meist die Mehrheit - eine Entdeckung gleichzeitig machen und erst danach eine Inkonsistenzbehandlung stattfindet, funktioniert die Konsensusmethode. 4 Fazit Es wurden verschiedene Möglichkeiten vorgestellt, Wissen zu repräsentieren und Inkonsistenzen aufzulösen. Das Partitionenmodell bildet dabei die simpelste Variante. Mit modaler Logik und insbesondere mit Coalition Logic ist es möglich, abstrakter über Wissen zu reden. Außerdem wird dabei das Ziel und nicht der mögliche Weg in den Vordergrund gerückt. Jedoch muss zur Umsetzung der Coaltition Logic eine gewisse Basis vorhanden sein, auf der die Coalition Logic aufbaut, denn nur durch die Modellierung mit Coalition Logic ohne „Unterbau“ kann nicht ausgesagt werden, dass eine Gruppe von Agenten ein Ziel erreichen kann. Auch die Behandlung von Inkonsistenzen muss im Unterbau der Coalition Logic geregelt sein, denn Inkonsistenzen treten im Modell nicht auf. Zusätzlich zu den vorgestellten Modellen existieren weitere, die geeignet sein könnten, wie zum Beispiel die temporale Logik [6]. Diese war jedoch nicht Teil dieser Ausarbeitung. Bei der Inkonsistenzbehandlung und -auflösung wurden Konsensus, Revision und Fusion als besondere Art der Revision vorgestellt. Am sinnvollsten hat sich für ein Multiagentensystem ohne Observer und mit fehlerbehafteter Kommunikation die Fusionsmethode herausgestellt. Jedoch ist auch hier zu beachten, dass es dazu einer Ordnung über den Agenten bedarf. Revision nach den AGM-Postulaten und vor allem Konsensus scheinen hier wenig geeignet. Literatur 1. Multiagent Systems: Algorithmic, Game-Theoretic, and Logical Foundations. Cambridge University Press (December 2008) 2. Gärdenfors, P.: Belief revision: An introduction. Cambridge University Press (December 2003) 3. Kfir-Dahav, N., Tennenholtz, M.: Multi-agent belief revision. In: Proceedings of the 6th conference on Theoretical aspects of rationality and knowledge. pp. 175–194 (1996) 4. Nguyen, N.: Processing inconsistency of knowledge on semantic level. Journal of Universal Computer Science 11, 285–302 (2005) 5. Pauly, M.: Logical for Social Software. Ph.D. thesis, University of Amsterdam (2008) 6. Rescher, N., Urquhart, A.: Temporal Logic. Springer-Verlag, New York (1971)