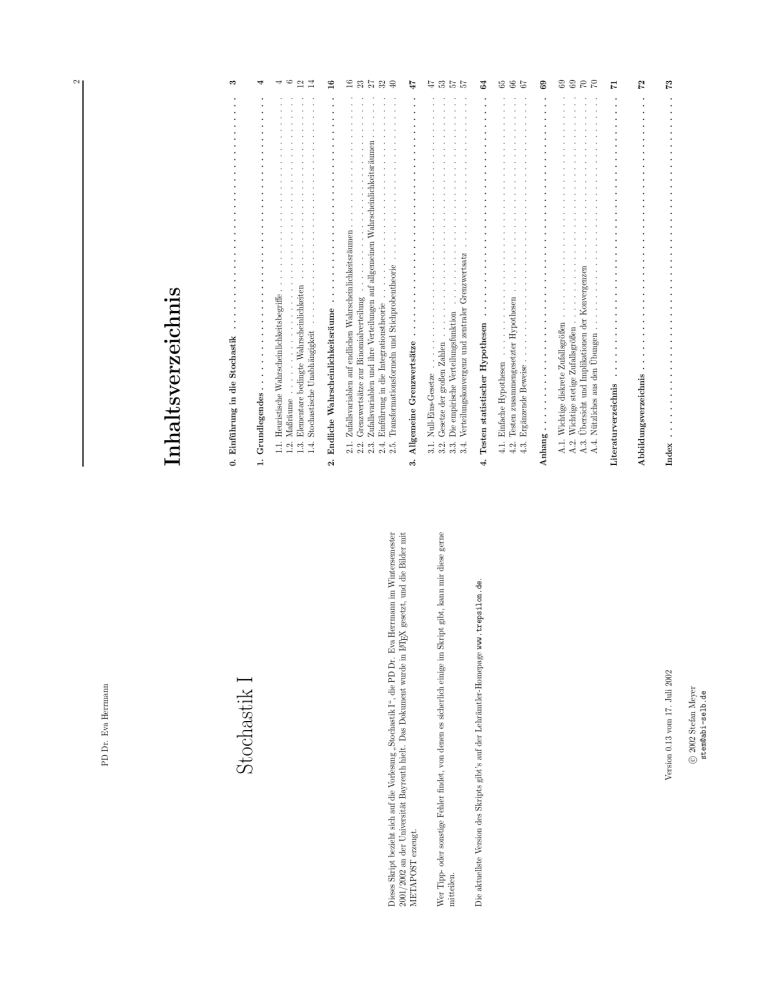

Stochastik I Inhaltsv erzeichnis

Werbung