Kompositionsmethode Sei F eine Linearkombination von mehreren

Werbung

Kompositionsmethode

Sei F eine Linearkombination von mehreren Verteilungsfunktionen Fi,

F =

k

X

iFi

i=1

Algorithmus:

Erzeuge gleichverteilte Zufallszahl U ,

Pi−1 Pi

falls U ∈ [ j=1 j , j=1 j simuliere aus Fi.

Beispiele:

Kontaminierte Normalverteilung

x − µ2 x − µ1 + Φ

F (x) = (1 − )Φ

σ1

σ2

Doppelexponential (Laplace)

X1 ∼ exp(λ)

X1

X=

−X

394

1

falls

U≤

1

2

falls

U>

1

2

W.Kössler, Humboldt-Universität zu Berlin

Verwerfungsmethode (Acceptance Sampling)

F habe Dichte f , aber die Zufallszahlen seien schwierig

direkt zu erzeugen.

Erzeugung von Zufallszahlen mit der Dichte g sei “leicht”.

f (x)

<∞

M := sup

g(x)

x

Algorithmus:

1. Simuliere U ∼ R(0, 1)

2. Simuliere Y ∼ g

3. Akzeptiere X = Y , falls U ≤

1 f (Y )

M g(Y )

sonst gehe nach 1.(neuer Versuch)

1 f (Y )

P (Y akzeptiert) = P U ≤

M g(Y )

Z 1 f (Y ) Y = y g(y) dy

=

P U≤

M g(Y )

Z

1

1 f (y)

· g(y) dy = .

=

M g(y)

M

395

W.Kössler, Humboldt-Universität zu Berlin

(Integration über den Definitionsbereich von Y )

Im Mittel müssen also M Zufallszahlen Y erzeugt werden.

Die Methode ist korrekt, denn:

Z x

P (Y = y|Y akzeptiert)g(y) dy

P (X ≤ x|Y akzeptiert) =

Z−∞

x

P (Y akzeptiert, Y = y)

=

g(y) dy

−∞ P (Y akzeptiert)

(y)

Z P U ≤ M1 fg(y)

=

g(y) dy

P (Y akzeptiert)

Z x

1 f (y)

g(y) dy

= M

M

g(y)

−∞

= F (x).

396

W.Kössler, Humboldt-Universität zu Berlin

Bsp. 4.7

1 −x2/2

f (x) = √ e

(Normal)

2π

1 −|x|

(Doppelexp)

g(x) = e

2

r

r

f (x)

2 −x2/2+|x|

2

(−x2+2|x|−1+1)/2

sup

= sup

e

=

sup e

g(x)

π

π

x

x

rx

r

2 1/2

2 1/2

2

e sup e−(x−1) =

e ≈ 1.315.

=

π

π

x,x≥0

Verwerfungsmethode.sas

397

W.Kössler, Humboldt-Universität zu Berlin

Erzeugung von zwei beliebig abhängigen Zufallsgrößen

Es seien X und Y zwei unabhängige, standardnormalverteilte Zufallsgrößen (X, Y ∼ N(0, 1)), die wie in Ab-

schnitt 4.2 erzeugt wurden. Wir definieren zwei weitere

Zufallsgrößen X ∗ und Y ∗ wie folgt:

X ∗ := X

Y

∗

p

:= % · X + 1 − %2 · Y

(% ∈ [0, 1])

Beh.: % ist der gewünschte Korrelationskoeffizient zwischen X ∗ und Y ∗. Beweis: ÜA.

Ist % = 1, dann gilt Y ∗ = X ∗ = X, d.h. die beiden

Zufallsgrößen sind identisch. Wird % = 0 gewählt, so

sind beide Zufallsvariablen unabhängig.

398

W.Kössler, Humboldt-Universität zu Berlin

4.3 Weitere Simulationen

Simulation einer Markoff’schen Kette

gegeben: Zustandsraum: S = {1, 2, . . .}

Anfangsverteilung: {p0j }j=1,2...,

(p00 = 0)

Übergangsmatrix:

pij

i=1,2,...

j=1,2,...

1. Schritt: Erzeuge eine Pseudozufallszahl U0. Falls

i

i−1

X

X

p0k

p0k ≤ U0 <

k=0

k=0

so starte im Zustand “i”.

n-ter Schritt: Im n − 1ten Schritt sei der Zustand “i”

erreicht worden. Erzeuge eine Pseudozufallszahl

Un. Falls

j−1

X

k=0

pik ≤ Un <

j

X

pik

k=0

so gehe in den Zustand “j”.

399

W.Kössler, Humboldt-Universität zu Berlin

Das Buffonsche Nadelproblem (1777)

In der Ebene seien zwei parallele Geraden im Abstand

a gezogen.

Auf die Ebene wird zufällig eine Nadel der Länge l,

l ≤ a) geworfen.

Frage: Wie groß ist die Wkt., daß die Nadel eine der

Geraden schneidet?

Was heißt Nadel zufällig werfen?

X: Abstand des Nadelmittelpunkts von der nächstgelegenen Geraden, 0 ≤ X ≤ a2 .

φ: Winkel zwischen Nadel und Geraden, 0 < φ ≤ π.

Nadel zufällig werfen:

a

X ∼ R(0, ),

2

φ ∼ R(0, π).

Wann schneidet die Nadel eine Parallele? gdw.

l

X ≤ sin φ

2

400

W.Kössler, Humboldt-Universität zu Berlin

gdw. der Punkt (φ, X) unterhalb des Sinusbogens liegt.

Fläche unterhalb des Sinunbogens

P =

Fläche des Rechtecks[0, π]x[0, a2 ]

R π/2 l

sin φ dφ

0

2

=

π · a2

2l

=

πa

Insbesondere: a = 2l:

1

P = .

π

Schätzung für π:

π̂ =

401

#Würfe

#Treffer

W.Kössler, Humboldt-Universität zu Berlin

∗

Simulation von auf der n-dimensionalen Kugelober-

fläche gleichverteilten Zufallsvariablen

Satz 4.8 Seien Xi ∼ N (0, 1), i.i.d.

Yi =

i = 1, . . . , n, und

Xi

,

R

i = 1, . . . , n,

R2 =

n

X

wobei

Xi2.

i=1

Dann gilt

Yi ∼ R(KnO (0, 1)),

wobei KnO (0, 1) die Oberläche der n-dimensionalen Einheitskugel ist.

Beweis:

Wir betrachten die Transformation

G : Rn−1 × R+ → Kn−1(0, 1) × R+

wobei Kn−1(0, 1) die n − 1 dimensionale Einheitsvollkugel ist.

402

W.Kössler, Humboldt-Universität zu Berlin

x2

y2 =

r

...

xn

yn =

r

r = r

Diese Abbildung ist injektiv und es gilt für G−1:

x2 = r · y2

...

xn = r · yn

r = r

Die Jacobi-Matrix ist

r

0

−1

∂G (y2, . . . , yn, r)

J :=

=

∂(y2 , . . . , yn, r)

0

0

403

0 . . . 0 y2

r ...0

...

0 ...r

0 ...0

y3

yn

1

W.Kössler, Humboldt-Universität zu Berlin

Also: det J = rn−1.

Die gemeinsame Dichte von (Y, R) = (Y1, Y2, . . . , Yn, R)

ist dann

fY,R(y1, . . . , yn, r)

fX,R(ry1, G−1(y2, . . . , yn, r)) · det J, y 2 = 1 − Pn y 2

1

j=2 j

=

0

sonst

r 2 yj2

Q

Pn−1 2

2

1 n n e− 2 · rn−1,

yn = 1 − j=1 yj

j=1

2

(2π)

=

0,

sonst

2

Pn−1 2

2

1 n e− r2 · rn−1

falls yn = 1 − j=1 yj

2

(2π)

=

0

sonst

Die Zufallsvektoren (Y1, . . . , Yn) und R sind also unabhängig und wegen

2

− r2

e

404

n−1

·r

(2π)n/2

2

n−1 − r2

r e

Γ( n2 )

= n −1 n ·

n

2 2 Γ( 2 ) 2π 2

1

= fχn (r) ·

AKnO (0,1)

W.Kössler, Humboldt-Universität zu Berlin

ist

R ∼ χn

und Y ∼ R(KnO (0, 1))

mit der Dichte

1

AKnO (0,1)

wobei

n

2

2π

Γ( n2 )

die Fläche der n-dimensionalen Einheitskugel ist.

AKnO (0,1) =

2

Bem.: Die Fläche der n-dimensionalen Kugeloberfläche

ist, vgl. Fichtenholz 3, S.389,

AKnO (0,r) =

n

2

2π n−1

n r

Γ( 2 )

n = 2: 2πr

n = 3: 4πr

2

n = 4: 4π 2r3

405

Γ( 32 )

=

1

1

Γ(

2

2)

=

√ π

2

W.Kössler, Humboldt-Universität zu Berlin

406

W.Kössler, Humboldt-Universität zu Berlin

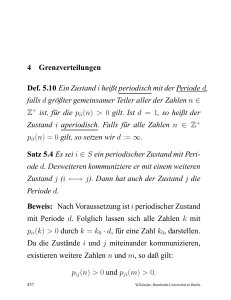

Kapitel 5

Markoff’sche Ketten

Contents

1

2

3

4

5

6

Definitionen und einfache Zusammenhänge409

Klassifikation der Zustände . . . . . . . . . . . . . 418

Rekurrente und transiente Zustände . . . 424

Grenzverteilungen . . . . . . . . . . . . . . . . . . . . . . 435

Klassische Beispiele . . . . . . . . . . . . . . . . . . . . . 453

Simulated Annealing . . . . . . . . . . . . . . . . . . . . 468

407

Beispiele

Irrfahrten (auf der Geraden, der Ebene, im Raum)

Ruin des Spielers

Markov Chain Monte Carlo (z.B. Simulated Annealing)

Fragestellungen

Rückkehrwktn., Absorptionswktn.

Erste Rückkehr

Stationäre Verteilungen

408

W.Kössler, Humboldt-Universität zu Berlin

1 Definitionen und einfache Zusammenhänge

{Xt}t∈T : Famile von Zufallsgrößen.

T : total geordnete Menge (mit kleinstem Element t0).

T endlich, o.B.d.A. T = {0, 1, 2, . . . , k} oder

T abzählber, o.B.d.A. T ∈ {0, 1, 2, . . .} = N

Wir betrachten ein System, das aus einem Anfangszustand für t = t0 schrittweise übergeht in Zustände

für t = t1, t = t2, . . ..

Menge der Zustände: Zustandsraum S,

S = {1, 2, . . . , m} oder S = N oder S = Z.

Für jedes t wird der (aktuelle) Zustand durch eine Zufallsvariable Xt beschrieben,

P (Xt ∈ S) = 1,

409

Ft(x) := P (Xt < x)

W.Kössler, Humboldt-Universität zu Berlin

Def. 5.1 Es sei T , T ⊆ Z+, eine abzählbare Menge und

S, S ⊆ Z (Zustandsraum) eine höchstens abzählbare

Menge. Die Elemente von S nennen wir Zustände. Es

sei nun {Xt}t∈T eine Familie von zufälligen Größen, für

die gelte:

P (Xt ∈ S) = 1,

∀t ∈ T.

Diese Familie von Zufallsgrößen heißt

M ARKOFF’sche Kette, falls gilt:

P (Xt+1 = j| Xt = i, Xt−1 = it−1, . . . , X0 = i0) =

(t)

P (Xt+1 = j| Xt = i) =: pij .

Die Anfangsverteilung der M ARKOFF’schen Kette be(0)

zeichnen wir mit pi = P (X0 = i).

410

W.Kössler, Humboldt-Universität zu Berlin

Bem.: Wir stellen uns also vor, daß wir, beginnend im

Zustand i0, über die Zustände i1, . . . , it−1 in den Zustand

i gelangt sind und nun in einen weiteren Zustand übergehen wollen. Eine Familie von Zufallsgrößen ist eine

M ARKOFF’sche Kette, wenn für den Übergang in diesen

Zustand nur der unmittelbar vorangegangene Zustand,

also der Zustand i, relevant ist. (Markoff-Eigenschaft)

Def. 5.2 Eine M ARKOFF’sche Kette heißt homogen, wenn

(t)

für alle i, j ∈ S und für alle t ∈ T gilt, daß pij =

pij , d.h. wenn die Übergangswahrscheinlichkeiten unabhängig vom jeweiligen Schritt t sind.

pij heißt Übergangswahrscheinlichkeit vom Zustand i

in den Zustand j.

411

W.Kössler, Humboldt-Universität zu Berlin

Def. 5.3

Die Matrix M = (pij )i,j∈S ,

p11 p12

p21 p22

M=

p p

31 32

.. ..

p13 . . .

p23 . . .

,

p33 . . .

..

heißt Übergangsmatrix der M ARKOFF’schen Kette, falls

folgendes gilt:

pij ≥ 0,

∀i, j ∈ S und

X

j∈S

pij = 1 ∀i ∈ S,

d.h. die Wahrscheinlichkeit, in irgendeinen nächsten Zustand j zu gelangen, ist Eins.

Wir werden in diesem Kapitel ausschließlich homogene

M ARKOFF’sche Ketten betrachten.

Es sei nun {Xt}t∈T eine solche homogene M ARKOFF’sche

Kette. Wir definieren:

pij (n) := P (Xm+n = j| Xm = i).

412

W.Kössler, Humboldt-Universität zu Berlin

Das ist die Wahrscheinlichkeit, daß man nach n Schritten aus dem Zustand i in den Zustand j gelangt. Da die

Kette homogen ist, gilt:

pij (n) = P (Xn| X0 = i).

Wie kann nun die Matrix für die Wahrscheinlichkeiten

pij (n) aus der Ein–Schritt–Übergangsmatrix“ berech”

net werden?

Annahme: Anfangszustand und Übergangswahrscheinlichkeiten pij bekannt.

Es gilt:

1 , falls i = j;

pij (0) =

0 , sonst.

pij (1) = pij .

Untersuchen wir die Wahrscheinlichkeit pij (2):

pij (2) = P (X2 = j| X0 = i)

X

=

P (X2 = j, X1 = k| X0 = i)

k∈S

413

W.Kössler, Humboldt-Universität zu Berlin

Wir wenden nun die Formel der totalen Wahrscheinlichkeit (vgl. Seite 75) an, und zwar mit

• Ai := {X1 = i}, für alle i ∈ S, denn:

S

Ai = Ω

i∈S

und Ai ∩ Aj = ∅, für alle i, j ∈ S mit i 6= j;

• A := {X2 = j}.

Dann erhalten wir:

X

pij (2) =

P (X2 = j| X1 = k, X0 = i) · P (X1 = k| X0 = i)

=

=

k∈S

X

k∈S

X

k∈S

P (X2 = j| X1 = k) · P (X1 = k| X0 = i)

pkj · pik

Dabei haben wir ausgenutzt, daß wir es mit einer M AR KOFF ’schen

Kette zu tun haben. Wir sehen: Tragen wir

die Werte pij (2) in eine Matrix ein, so läßt sich diese

als das Produkt der Übergangsmatrix M mit sich selbst

darstellen. Folglich gilt für die Matrix M2 der zweischrittigen Übergänge:

M2 = (pij (2))i,j∈S = M2.

414

W.Kössler, Humboldt-Universität zu Berlin

Allgemein gilt die

Rekursion von C HAPMAN –KOLMOGOROFF

Mn = Mn, bzw.:

X

pij (n) =

pik (n − m) · pkj (m)

=

k∈S

X

k∈S

pik (n − 1) · pkj ,

(m = 1).

Folg. 9

P (Xn = j) =

X

k

pkj (n) · p0k .

Beweis:

Es gilt:

X

P (Xn = j, X0 = k)

P (Xn = j) =

=

=

k

X

k

X

k

P (Xn = j|X0 = k) · P (X0 = k)

pkj (n) · p0k .

2

pj = P (Xn = j),

p=M

415

nT

pT = (p1, p2, . . .)

0

·p ,

T

p =p

0T

· Mn

W.Kössler, Humboldt-Universität zu Berlin

Bsp. 5.1 (Ein-Prozessorsystem)

mit einer I/O–Einheit, vgl. Bsp. 1.23

S = {1, 2}

1: Programmstatus, in dem sich das System befindet,

wenn es ein Programm abarbeitet (Prozessor aktiv)

2: I/O–Status, der dann angenommen wird, wenn die

I/O–Einheit aktiviert wird.

Für jeden Schritt n, den das System macht, definieren

wir eine Zufallsgröße Xn, die die Elemente der

Menge S als Werte annehmen kann, je nachdem,

in welchem Zustand sich das System in diesem

Schritt befindet. Dann haben wir für die Übergänge

zwischen den einzelnen Zuständen folgende Wahrscheinlichkeiten:

416

W.Kössler, Humboldt-Universität zu Berlin

Xn = 1 =⇒ Xn+1 = 1, mit Wahrscheinlichkeit q = 1 − p

Xn = 1 =⇒ Xn+1 = 2, mit Wahrscheinlichkeit p

Xn = 2 =⇒ Xn+1 = 1, mit Wahrscheinlichkeit 1

Xn = 2 =⇒ Xn+1 = 2, mit Wahrscheinlichkeit 0

Übergangsmatrix:

1−p p

M=

.

1 0

(0)

Die Anfangsverteilung pi

= P (X0 = i) müssen wir

festlegen. Sie ist, entsprechend der Arbeitsweise des Systems, wie folgt definiert:

(0)

• p1 = 1, d.h. die erste Aktion ist mit Wahrscheinlichkeit Eins die Ausführung eines Programms;

(0)

• p2 = 0, d.h. die erste Aktion ist mit Wahrscheinlichkeit Null die Aktivierung der I/O–Einheit.

2

(1 − p) + p p(1 − p)

M2 =

1−p

p

417

W.Kössler, Humboldt-Universität zu Berlin