Prof. Becker / Kognitive Psychologie

Werbung

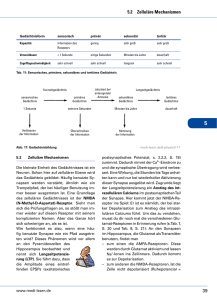

Prof. Becker / Kognitive Psychologie: Lehrbuch Anderson 1. Definition und Ziel: Die kognitive Psychologie beschäftigt sich mit den menschlichen Erkenntnisprozessen. Ziel ist, das Wesen der menschlichen Intelligenz und ihre Funktionsweise zu erfassen. 2. Leitvorstellung: Leitidee ist die Auffassung vom Menschen als ein informationsverarbeitenden Systems. 3. Eigenschaften eines informationsverarbeitenden Systems. - komplexe mentale Ereignisse lassen sich in elementare Ereignisse zerlegen, die Informationsverarbeitungsstufen mit jeweils eigenen Merkmalen darstellen und aufeinander folgen. - jede Stufe liefert einen Output, der den Input für die nächste Stufe darstellt. - Verarbeitet wird eine abstrakte Größe, Information genannt - Formal werden informationsverarbeitende Systeme als Flussdiagramme dargestellt. - Beispiel für ein sich an diesem Ansatz orientierendes Modell ist das Modell von Sternberg. 4. In anderer Form ist auch der Behaviorismus wieder aufgelebt. Vertreter des ökologischen Ansatzes und der situierten Kognition betonen, dass in der Struktur der Umwelt die adäquate Erklärung für menschliches Wahrnehmen und Erkennen liegt. 5. Situationen haben einen Aufforderungscharakter. Sie signalisieren Verhaltensmöglichkeiten, die unmittelbar erkannt werden können. 6. Akzeptiert man als Leitidee die Auffassung vom Menschen als informationsverarbeitendes System, stellt sich die Frage, auf welcher Ebene die Analyse einsetzt. Es ist nicht die physiologische Ebene. Zum einen ist diese Ebene technisch nicht realisierbar, wenn man von der plausiblen Annahme ausgeht, dass an einer mentalen Operation wie z.B. die Addition zweier Zahlen Millionen Nervenzellen oder Neurone beteiligt sind. Zum anderen ist diese Erklärungsebene viel zu detailliert, da als Erklärung eine Liste des Verhaltens von Millionen Neuronen erstellt werden müsste, die nicht mehr überschaubar ist. 7. Die Erklärungsebene, die die Psychologie gewählt hat, entspricht der Abstraktionsebene der höheren Programmiersprachen. Erklärungen entsprechen Programmen. Von physiologischen Details wird vollständig abgesehen. Man nennt diese Erklärungen auch Theorien der Symbolmanipulation. Denken aus dieser Sicht besteht darin, aus der Außenwelt aufgenommene Informationen durch Symbole zu repräsentieren und mittels mentaler Operationen zu manipulieren. 8. Ein alternativer Erklärungsansatz zur Symbolmanipulation ist der Konnektionismus. Er sucht Denken durch das Zusammenspiel von Elementen zu beschreiben, die wie Neurone miteinander verbunden sind und sich gegenseitig erregen oder hemmen können. Informationen sind durch Aktivationsmuster repräsentiert und mentale Operationen durch Veränderungen dieser Aktivationsmuster. 9. Basis der menschlichen „Hardware“ ist das Neuron, das aus Zellkörper, Dendriten und Axon besteht und zu vielen anderen Neuronen Kontakt hat. Die Kontaktstellen werden Synapsen genannt. Neurone erzeugen elektrische Impulse, die zu anderen Neuronen laufen und diese aktivieren oder hemmen. Bei einem bestimmten Ausmaß von Aktivation an einer Zelle erzeugt die Zelle einen Impulsstoß, der sich fortpflanzt. Impulsfrequenz und Erregung und Hemmung von Neuronen (Aktivationsmuster) sind die Mittel, mit denen das Nervensystem Informationen kodiert. 10. Das menschliche Gehirn setzt sich aus verschiedenen Komponenten zusammen, von denen der Cortex die wichtigste ist. 11. Kognitive Funktionen wie z.B. Sprache haben eine gewisse Lokalisation. 12. Im Cortex gibt es eine topographische Organisation. Benachbarte Körperteile sind im Cortex in benachbarten Regionen lokalisiert. Visuelle Wahrnehmung 1. Nach dem Eintreffen von Lichtstrahlen auf die Netzhaut beginnt die aktive Verarbeitung der im Licht enthaltenen Informationen. 2. Durch spezielle Zellen (on-off-Zellen, off-on-Zellen), die sich zu Kanten- und Balkendetektoren zusammenschließen, werden Umrisse ermittelt 3. In einem zweiten Verarbeitungsschritt wird die Lage der aus 1. resultierenden Oberflächen im Raum bestimmt. Informationen über Tiefe vermitteln unter anderem Textur, Stereopsis und Bewegungsparallaxe. Die daraus resultierende mentale Repräsentation wird in Anlehnung an Marr 2,1/2 D Skizze genannt. Sie ermöglicht noch keine genaue Objektbestimmung. 4. Im dritten Verarbeitungsschritt wird bestimmt, welche Kanten und Flächen zusammengehören, also ein Objekt bilden. Diese Segmentierung des Wahrnehmungsraums in Objekte oder Gestalten erfolgt auf der Basis der Gestaltgesetze beispielsweise Nähe oder glatter Verlauf. 5. Schließlich wird in einem letzten Schritt die Bedeutung eines Objektes bestimmt. Man bezeichnet diesen Schritt als Mustererkennung. Die dominierende Theorie der Mustererkennung ist die der Merkmalserkennung und –kombination. Ob es sich um einfache Muster wie Buchstaben oder komplexere Muster wie Tiere oder Häuser handelt, stets sind Elementarmerkmale (geons bei Biederman) zu erkennen (komponentiale Erkennung) und nach der Realisation einer Kombinationsregel zu suchen. Erkennen von Sprache 1. Wie das Erkennen von Objekten beruht auch das Erkennen von Sprache auf dem Erkennen von Konfigurationen von Einzelmerkmalen. 2. Von großer Bedeutung dabei ist die Segmentierung von Sprache in Wörter und der Wörter in Phoneme als den kleinsten bedeutungstragenden Spracheinheiten. Pausen sind kein zuverlässiger Segmentierungsindikator. 3. Analog zu Buchstaben bestehen auch Phoneme aus einzelnen Merkmalen: Konsonanzmerkmal, Stimmhaftigkeit und Artikulationsort. 4. Neben dem zu erkennenden Gegenstand bzw. der Sprachäußerung selbst wird auch der Kontext als erkennensrelevante Information genutzt. Man spricht von bottom-up und top-down-Verarbeitung. 5. Kontexteffekte sind der Wortüberlegenheitseffekt - im Kontext eines Wortes wird ein Buchstabe schneller erkannt als ohne Kontext- und das Phänomen des Satzkontextes- im Kontext eines Satzes wird ein Wort schneller erkannt als ohne Kontext. 6. Ebenfalls Kontexteffekte sind das Phänomen, dass Elemente von Gesichtern wie Nase, Ohren oder Mund im Kontext eines Gesicht wesentlich schneller erkannt werden als ohne Kontext und das Phänomen, dass Teile von sinnvollen Szenen besser behalten werden als von Szenen, deren Komponenten nach Zufall zusammengesetzt wurden. 7. Die Wirkung von Kontexten beruht darauf, dass sie zusätzliche, meist redundante Informationen für das Erkennen bereitstellen. Aufmerksamkeit 1. Das menschliche Informationsverarbeitungssystem hat eine eingeschränkte Kapazität. Sie muss anliegenden Aufgaben zugewiesen werden. In der Alltagssprache wird dies mit dem Begriff der Aufmerksamkeit bezeichnet. 2. Ein klassisches Untersuchungsparadigma der Verteilung von Aufmerksamkeit bei der auditiven Wahrnehmung sind Aufgaben zum dichotischen Hören. 3. Um den Beobachtungen zum dichotischen Hören Rechnung zu tragen, entwickelte Broadbent die Filtertheorie. Sensorische Informationen durchlaufen das System bis zu einer Verengung oder Flaschenhals. Hier muss entschieden werden, welche der Informationen ausgewählt werden. Das Broadbent-Modell ist ein early selection Modell. Nur die mit Aufmerksamkeit bedachte Information wird einer semantischen Analyse unterzogen. 4. Experimente zeigen jedoch, dass auch die nicht ausgewählte Information semantisch analysiert werden kann. Andere Autoren (Deutsch & Deutsch) haben deshalb ein late selection Modell vorgeschlagen, wonach beide Informationen semantisch analysiert werden, jedoch nur auf eine reagiert werden kann, beispielsweise in Form von Beschattung. 5. Treisman nimmt mit ihrer Dämpfungstheorie eine mittlere Position ein. Bestimmte Informationen werden gedämpft, aber nicht völlig herausgefiltert. Semantische Analyse ist dann schwieriger aber nicht unmöglich. 6. Untersuchungen zur visuellen Aufmerksamkeit haben gezeigt, dass maximale visuelle Verarbeitungskapazität in der Fovea vorliegt. Periphere Teile des visuellen Feldes können jedoch auch und sogar ohne Veränderung des Fixationspunktes beachtet werden durch Verlagerung der Aufmerksamkeit. 7. Ein informatives Bild für die visuelle Aufmerksamkeit ist die spotlight-Metapher. Das spotlight als der Teil des visuellen Feldes, der beachtet wird, kann in der Größe variieren. 8. Das visuelle System besitzt einen Speicher (sensorisches Gedächtnis), das sehr viele Informationen jedoch nur sehr kurz speichert. 9. Aufmerksamkeit ist nach der Merkmals-Integrationstheorie von Treisman notwendig, wenn Merkmale zu Mustern zusammengesetzt werden sollen. Automatisierung 1. Die Menge der Informationen, die verarbeitet werden kann, ist eine Funktion der Kapazität aber darüber hinaus auch des Automatisierungsgrades der Verarbeitungsprozesse. 2. Automatisierung ist eine Folge der Übung einer Tätigkeit. 3. Automatisierte Prozesse laufen mit weniger oder sogar keiner Aufmerksamkeitszuwendung ab, sind also anstrengungslos, schnell, oft unbewusst und nur zum Teil willentlich zu beeinflussen. 4. Kontrollierte Prozesse zeichnen sich durch die gegenteiligen Attribute aus. 5. Automatisierte Prozesse können mit kontrollierten Prozessen interferieren, wie das Beispiel StroopTest zeigt. 6. Das gleichzeitige Bearbeiten zweier Aufgaben ist mit Leistungsabfall verbunden, der jedoch verschwindet, wenn eine der Aufgaben automatisiert ist. 7. Die Auffassung, dass es eine einheitliche Kapazität des menschlichen Informationsverarbeitungssystems gibt, ist in den 70iger Jahren durch die Annahme multipler Ressourcen ersetzt worden. 8. Neuerdings wird das Konstrukt der Kapazität abgelehnt. Automatisiertheit wird stattdessen als Funktion des Gedächtnisses betrachtet. Wird ein Prozess wie Kopfrechnen geübt, wird er gespeichert und kann aus dem Gedächtnis abgerufen werden. Dieser Vorgang ist schneller und müheloser als die Generierung dieses Prozesses aufgrund eines Algorithmus. 9. Blindsicht ist eine neurologische Störung, bei der Menschen Objekte in bestimmten Teilen des visuellen Feldes nicht sehen, aber Aussagen über die Objekte machen können. 10. Unilaterale räumliche Vernachlässigung ist eine Störung, bei der Menschen ein Objekt sehen aber nicht auf das Objekt oder einen Teil des Objektes reagieren können. 11. Apperzeptive Agnosie ist eine Störung, bei der Menschen die Form eines Objektes nicht erkennen können. 12. Assoziative Agnosie ist eine Störung, bei der Menschen eine Form nicht mit dem Wissen über die Form verbinden können. 13. Prosopagnosie ist eine Störung, bei der Menschen Gesichter nicht wieder erkennen können, ohne dass dafür eine visuelle Störung verantwortlich gemacht werden kann. Wissensrepräsentationen 1. Informationen, die Eingang in das kognitive System gefunden haben, führen zum Aufbau von Wissensrepräsentationen. 2. Die Art der Repräsentation bestimmt, wie diese Informationen die weitere Informationsverarbeitung beeinflussen. 3. Die Forschung hat sich hauptsächlich mit seriellen wahrnehmungsbasierten und bedeutungsbezogenen Repräsentationen beschäftigt. 4. Die Theorie der dualen Kodierung postuliert verschiedene Repräsentationen für verbale und für visuelle Informationen. 5. Das Experiment von Santa zeigt, dass verbale und visuelle Informationen unterschiedlich verarbeitet werden. Neuere Forschungsergebnisse zeigen, dass sie in unterschiedlichen Hirnarealen verarbeitet werden. 6. Als Beleg für eine visuelle Repräsentation werden unsere anschaulichen Vorstellungen, häufig auch mentale Bilder genannt, gewertet. Sie enthalten neben visuellen Informationen jedoch auch räumliche Informationen, die unabhängig von einer sensorischen Modalität sind, beispielsweise den Eindruck, wo ein Objekt sich in unserer Umwelt befindet. 7. Ein Beispiel ist die mentale Rotation. Zwei gegeneinander gedrehte Objekte werden durch eine mentale Operation zur Deckung gebracht. Die Zeit, die diese mentale Operation beansprucht, ist eine lineare Funktion des Drehwinkels. Sie scheint analog zur physikalischen Rotation zu verlaufen. Man spricht daher von mentaler Rotation. 1. Eine weitere Analogie zwischen Umgang mit visuellen Vorstellungen und Handeln mit physikalischen Objekten ist das „Abtasten“ (scannen) von kognitiven Landkarten. Die Abtastzeit zwischen 2 Objekten ist eine lineare Funktion der Entfernung dieser Objekte. 2. Der Größenvergleich zweier vorgestellter Objekte ist umso schwieriger, je ähnlicher sich die Objekte hinsichtlich der Größe sind. 3. Das Abtasten mentaler Bilder wird behindert, wenn gleichzeitig räumliche Strukturen der Umgebung verarbeitet werden müssen. 4. Mentale Vorstellungen enthalten neben räumlichen Repräsentationen, die nicht an eine spezifische Modalität gebunden sind auch visuelle Repräsentationen z. B. von Farben. Die beiden Aspekte mentaler Vorstellungen werden in verschiedenen Hirnregionen verarbeitet. 5. Visuelle Vorstellungen und visuelle Wahrnehmungen haben gemeinsame Merkmale, z. B. Täuschungen. Ein Unterschied zwischen beiden ist der, dass Vorstellungen sehr viel schwieriger zu reinterpretieren sind als Wahrnehmungen. 6. Fazit: Visuelle Vorstellungen ähneln visuellen Wahrnehmungen sind aber nicht identisch mit ihnen. 7. Es gibt eine generelle Fähigkeit, serielle Ordnungen zu repräsentieren unabhängig von den zu ordnenden Objekten. 8. Die Tatsache, dass vom Anfang und vom Ende der Ordnung her besser auf Reihen zugegriffen werden kann (Absuchen einer Reihe von ihrem Anfang und ihrem Ende her ist leichter), wird als Anfangs- und Endankereffekt bezeichnet. 9. Neben wahrnehmungsbezogenen gibt es bedeutungsbezogene Repräsentationen, bei denen von den verbalen oder bildhaften Details (Stil, Form) abstrahiert wird zugunsten der Bedeutung. 10. Die von der konkreten Realisation abstrahierte Bedeutung von Sätzen und Texten kann als Proposition bzw. als propositionales Netz dargestellt werden. 11. Menschliches Wissen insgesamt kann als propositionales Netzwerk dargestellt werden mit den Verbindungen zwischen den einzelnen Propositionen als Repräsentation deren Assoziationen. 12. Propositionen stellen Abstraktionen von wahrnehmungsbezogenen Details dar. Daneben gibt es Wissen, dass durch eine Abstraktion von spezifischen Erfahrungen entstanden ist und zu Erfahrungsklassen oder Konzepten (Begriffen) führt. 13. Konzepte können als semantische Netzwerke oder Schemata repräsentiert sein. Konzeptuelle Repräsentationen 1. Schemata als Repräsentationen von Konzepten oder Kategorien bilden dieses Wissen in Form einer Struktur von Leerstellen (slots) oder Attributen ab, die Ausprägungen besitzen. Beispiel: Attribut: Material, Ausprägung: Holz, Stein. Eine solche Kombination spezifiert ein typisches Merkmal. Gegensatz zu einem typischen Merkmal ist ein notwendiges Merkmal. Typische Ausprägungen nennt man Voreinstellungen oder default-values. Enkodiert in Schemata sind also kategoriale Regelhaftigkeiten und nicht das, was für ein bestimmtes Exemplar gilt. 2. Schemata erlauben Schlüsse über die Mitglieder der Kategorie bzw. deren Attribute, auch wenn man diese nicht wahrgenommen hat. 3. Empirische Befunde belegen die psychische Realität von Schemata. 4. Die Mitglieder oder Exemplare eines Schemas (Kategorie) können Unterschiede aufweisen. Dabei gibt es typische und weniger typische bzw. untypische Mitglieder. Die Typikalität eines Kategorienmitgliedes beeinflusst verschiedene psychologische Maße wie z.B. die Schnelligkeit, mit der ein Gegenstand klassifiziert wird. 5. Die Grenzen von Kategorien sind vage und ändern sich permanent. 6. Ereigniskonzepte werden Skripts genannt. Sie enthalten das Wissen über stereotype Handlungssequenzen wie etwa ein Restaurantbesuch, das zu Schlussfolgerungen benutzt werden kann. 7. Wie Objekte klassifiziert werden, ist theoretisch umstritten. Exemplartheorien behaupten, dass Exemplare gespeichert werden und ein neues Objekt auf der Basis seiner mittleren Ähnlichkeit zu diesen Exemplaren klassifiziert wird. Abstraktionstheorien behaupten, dass aufgrund der Ähnlichkeit zu einem Prototypen bestehend aus den wichtigsten Attributen klassifiziert wird. Gedächtnis I 1. Nach Ebbinghaus haben Behaltenskurven einen typischen Verlauf: Schnelles Vergessen am Anfang, das sich immer mehr verlangsamt. Mit der Ersparnismethode lässt sich nachweisen, dass Gedächtnisspuren auch dann noch da sind, wenn nicht mehr erinnert werden kann. 2. Das klassische Modell des Gedächtnisses besteht aus sensorischem Speicher, Kurzzeitgedächtnis und Langzeitgedächtnis. 3. Wichtige Annahme des klassischen Modells: Wird der Inhalt des Kurzzeitgedächtnisses (der maximal mögliche Inhalt wird Gedächtnisspanne genannt) memoriert, erhöht sich seine Wahrscheinlichkeit, in das Langzeitgedächtnis überzutreten. 4. Heute wird die Existenz eines besonderen Kurzzeitgedächtnisses abgestritten. Die Schnelligkeit, mit der man vergisst, ist eine Funktion der Lernintensität. 5. Anders als im klassischen Modell wird Lernintensität nicht mit Ausmaß des Memorierens gleichgesetzt sondern mit Tiefe der Verarbeitung. Nur tiefe d.h. bedeutungshaltige Verarbeitung führt zu besserem Verhalten, d.h. langfristigem Behalten. 6. Der Umfang der Gedächtnisspanne hängt davon ab, wie viel wir in einer bestimmten Zeitdauer memorieren können. Etwa 1,5 Sekunden können wir mit verbalem Material füllen. Dann müssen wir wieder zum Anfang zurückkehren. Sonst ist die Information verloren. Man nennt dies die artikulatorische Schleife. Daneben gibt es einen räumlich-visuellen Notizblock und eine zentrale Exekutive, die beides koordiniert. 7. Neuronale Basis für das Arbeitsgedächtnis scheint der frontale Kortex zu sein. Bei Affen feuern in diesem Gebiet liegende Neuronen, wenn ein auf einem bestimmten Platz liegendes zu behaltendes Objekt nicht mehr zu sehen ist. 8. Die Verfügbarkeit von Gedächtnisinhalten (Zugänglichkeit) ist abhängig von ihrer Aktivationshöhe. 9. Die Aktivationshöhe eines Inhalts hängt von der seit der letzten Aktivation hängen verstrichenen Zeit ab und vom Übungsgrad des Inhalts (Benutzungshäufigkeit). 10. Die Geschwindigkeit und die Wahrscheinlichkeit des Zugriffs auf einen Gedächtnisinhalt werden durch die Aktivationshöhe bestimmt. 11. Aktivation breitet sich entlang der Pfade eines propositionalen Netzwerks aus. Dies führt zu Primingeffekten. 12. Die Aktivation baut sich etwa 50 ms nach der Reizpräsentation aus, erreicht ihre volle Stärke nach etwa 200 ms und baut dann ab. 13. Neben dem Aktivationsniveau einer Gedächtnisspur ist die Stärke der Spur ein weiterer Parameter, der über Abrufbarkeit entscheidet. Stärke ist ein sich langsam ändernder Parameter. 14. Die Stärke einer Gedächtnisspur steigert sich mit dem Ausmaß von Übung. 15. Die Beziehung zwischen Übung und Behaltensmaßen ist eine Potenzfunktion. Der Behaltenszuwachs ist anfänglich stark und sinkt mit zunehmender Übung. 16. Eine Entsprechung auf neuronaler Ebene findet das Potenzgesetz der Übung in der sog. Langzeitpotenzierung von Synapsen im Hippocampus und Arealen des Cortex. Reizung von Neuronen erhöht die Sensibilität für nachfolgende Stimulationen. Auch hier verringert sich der Sensibilitätszuwachs mit zunehmender „Übung“. 17. Neben Umfang des Lernens spielt auch die Art des Lernens für das Behalten eine Rolle. An der Bedeutung orientiertes Lernen erhöht die Behaltensleistung. 18. Die Absicht zu lernen (intentionales Lernen) bringt gegenüber Lernen ohne Absicht (inzidentelles Lernen) keinen Behaltensvorteil. 19. Die PQ4R Methode (Preview, Questions, Read, Reflect, Recite, Review) zwingt zu elaborativer Verarbeitung beim Lesen von Texten und erhöht daher die Behaltensleistung. 20. Analog zum Potenzgesetz der Übung gibt es ein Potenzgesetz des Vergessens. Der Erinnerungsverlust verlangsamt sich mit zunehmendem zeitlichem Abstand von der Lernphase. Diese Beziehung zeigt sich auch bei Vergessensanalysen über Zeitintervalle von 30 bis 50 Jahren. 21. Die neuronale Basis für diese psychologische Beziehung ist eine negativ beschleunigte Abnahme der Langzeitpotenzierung an der Synapse. Langzeitpotenzierung ist das Ergebnis von Lernen und wird als neuronale Entsprechung der Gedächtnisspur interpretiert. Die Stärke einer Gedächtnisspur zerfällt synchron zum Zerfall der durch Lernen verursachten Veränderungen an der Synapse. Diese Theorie des Vergessens nennt man daher auch Zerfallstheorie des Vergessens. 22. Neben dem Vergehen von Zeit wird als weiterer Faktor, der über den Verlust von Ge-dächtnisinhalten bestimmt, die Existenz von Interferenzen zwischen Gedächtnisinhalten postuliert. Werden zu einem Reiz zusätzliche Assoziationen gelernt, kann dies ein Vergessen alter Assoziationen bewirken. 23. Ein Beispiel für Interferenzen ist der Fächereffekt: Je mehr Fakten mit einem Begriff assoziiert sind, desto länger dauert der Abruf jedes einzelnen Faktums. Der Fächereffekt kann mit der Theorie der sich ausbreitenden Aktivation erklärt werden. 24. Dass Interferenzen die eigentliche Ursache für Vergessen sind, behauptet die Interferenztheorie des Vergessens. 25. Das Lernen von redundantem Material führt nicht zur Interferenz mit einem Gedächtnis-inhalt und kann dessen Abruf sogar erleichtern. 26. Kann man sich an einen Sachverhalt nicht mehr erinnern, besteht die Möglichkeit seiner Rekonstruktion aufgrund von Inferenzen, die zum Zeitpunkt des Abrufs vorgenommen werden. Solche Inferenzen werden auch auf der Basis von schematischem Wissen ge-macht, wobei der Prozess des Inferierens häufig automatisiert und ohne bewußte Kontrolle abläuft. 27. Die Aktivation von Schemata führt beim Erinnern zur Einpassung von Texten in die aktivierte Wissensstruktur. 28. Eine Strategie beim Abruf von Gedächtnisinhalten ist, nach solchen Sachverhalten zu suchen, die aus Plausibilitätsgründen als wahrscheinlich erscheinen. Gedächtnis II 1. Je mehr man elaboriert, desto besser behält man. Allerdings steigt auch die Zahl der Inferenzen, die man als Erinnerung wiedergibt. 2. Schematische Wissensstrukturen bilden eine Grundlage für Inferenzen, wenn gelerntes Material erinnert werden soll. 3. Der Abruf von Gedächtnisinhalten wird erleichtert, wenn es beim Lernen gelingt, dem Material eine hierarchische Organisation aufzuprägen. Mnemotechniken insbesondere die Methode der Orte basieren auf der Bildung einer Organisation des Lernmaterials, indem es an eine bestehende Organisation (Folge von Orten) angebunden (assoziiert) wird. Das Erinnern erleichternde Reize wie diese Orte bezeichnet man als Schlüsselreize. 4. Generell sind die Chancen, ein zurückliegendes Ereignis zu erinnern am größten, wenn die physikalischen, mentalen und emotionalen Umstände beim Erinnern denen beim Lernen entsprechen, anders formuliert der Kontext, in dem der Gedächtnisabruf stattfindet dem Lernkontext entspricht. Zum Kontext zählen Merkmale des Lernorts, Stimmung beim Lernen, körperlicher Zustand beim Lernen. Man spricht in diesem Zusammenhang von state dependent learning. 5. Das Prinzip der Enkodierspezifität besagt, dass Worte besser erinnert werden, wenn ihr Abruf im Kontext derselben Wörter getestet wird, in dem sie gelernt wurden. 6. Die in 4. und 5. angesprochenen Phänomene kommen dadurch zustande, dass Lernen Verbindungen zwischen Gedächtnisinhalten etabliert und diese Verbindungen als Abruf-wege dienen.Wege führen von einem Start zu einem Ziel, und um den Weg zu nutzen muss man den Anfang erwischen. Analog führt die Aktivation eines Gedächtnisinhalts über den Abrufweg zu einem weiteren Gedächtnisinhalt. Wenn jedoch das Ausgangsgedächtnis nicht aktiviert wird, ist ein Abrufweg keine Hilfe beim Auffinden eines Zielinhalts. 7. Analog sind Lernstrategien eine Hilfe für bestimmte Gedächtnistests, für andere Tests aber nicht. So führen einige Strategien zu ausgeprägtem Quellengedächtnis und weniger zu Vertrautheit, andere Strategien leisten das Gegenteil. Quellengedächtnis ist essentiell für Erinnern, Wieder erkennen basiert dagegen entweder auf Quellengedächtnis oder auf Vertrautheit plus Inferenz. 8. Neben Gedächtnisinhalten, zu denen wir einen bewussten Zugang haben, existieren auch Gedächtnisinhalte, deren Vorhandensein uns nicht bewusst ist (Beispiel Schreibmaschine). Auch wenn die Lage der einzelnen Buchstaben der Tastatur nicht erinnert werden kann, äußert sich das Wissen darum beim Schreiben. Implizites Gedächtnis (im Gegensatz zu explizitem Gedächtnis) äußert sich in Gedächtnistests, die keine Aufforderung sich zu erinnern enthalten (indirekte Gedächtnistests) nicht aber in direkten Gedächtnistests wie freies Erinnern, die mit einer Aufforderung verbunden sind. Gedächtnisinhalte, die im direkten Gedächtnistest nicht abrufbar sind, können sich durchaus im indirekten Test äußern. Man nennt dieses Phänomen eine Dissoziation. Meist ist der indirekte Test eine Form von priming (Bahnung, Erleichterung), z.B. Wortstammergänzung. Doch äußert sich das implizite Gedächtnis auch in einer Reihe von Gedächtnis basierten Täuschungen. 9. Implizites Gedächtnis kann als Konsequenz einer erhöhten Verarbeitungsflüssigkeit beschrieben werden, die durch die Begegnung mit einem bestimmten Reiz im Kontext einer bestimmten Aufgabe produziert wurde. Die Änderung der Flüssigkeit wird manchmal entdeckt als Gefühl eines mit dem Reiz verbundenen Zustands des Speziellen. Oft wird das „Spezielle“ auf eine Ursache zurückgeführt, die aber nicht unbedingt der Grund sein muss. Die Flüssigkeitsänderung ist reiz- und aufgabenspezifisch. Sie wirkt daher nur, wenn dem gleichen Reiz und der gleichen Aufgabe wieder begegnet wird. Daher wird die Behaltensleistung in einem indirekten Test wie perzeptuelle Identifikation durch eine perzeptuell orientierte Verarbeitung in der Lernphase gefördert, während Erinnern und Wieder erkennen als direkte Tests wie schon erwähnt von einer Bedeutungsorientierten Verarbeitung in der Lernphase profitieren. 10. Dissoziationen sind bei Normalen, besonders gut aber bei Amnestikern zu beobachten. Korsakoff-Amnestiker (Amnesie aufgrund einer bei Alkoholikern häufigen Fehlernährung) zeichnen sich durch eine starke anterograde Amnesie aus. Sie können keine neu aufgenommenen Informationen dauerhaft so speichern, dass sie diese Informationen bewusst erinnern können. In indirekten Gedächtnistests zeigt sich dann doch, dass sich eine Gedächtnisspur gebildet hat. 11. Neben implizitem Gedächtnis gibt es auch ein implizites Lernen. Man lernt Prozeduren (prozedurales Wissen) zur Ausführung von Aufgaben, ohne dass man beschreiben kann, worin sie bestehen, also keinen verbalen Zugriff auf sie hat. Denken 1. Kognitive Aktivitäten sind ihrem Grunde nach Problemlöseprozesse, da sie zweckgerichtet sind. Wesentliche Merkmale sind Zielgerichtetheit, Zerlegung in Teilziele und Anwendung von Operatoren, also Handlungen zur Erreichung von Teilzielen. 2. Problemlösen kann als Absuchen eines Problemraumes beschrieben werden, der aus verschiedenen Problemzuständen besteht. Es gibt einen Ausgangszustand, einen Zielzustand und intermediäre Zustände. Operatoren überführen einen Zustand des Raumes in einen anderen. 3. Operatoren werden hauptsächlich erworben durch Entdecken, Analogiebildung und direkte Instruktion. 4. Problemlösewissen bezeichnet man auch als prozedurales Wissen oder Wissen darüber, wie etwas zu tun ist im Gegensatz zu deklarativem Wissen oder Faktenwissen. 5. Prozedurales Wissen kann man als Produktionensystem formal repräsentieren. Diese bestehen aus einzelnen Produktionsregeln, die aus einem Bedingungsteil, einem Handlungsteil und einer „wenn, dann“ Beziehung zwischen den Teilen sich zusammensetzen. 6. Muß zwischen verschiedenen Operatoren gewählt werden, wenden Menschen häufig folgende Auswahlkriterien an, Vermeidung der Zustandswiederholung, Unterschiedsreduktion und Mittel-ZielAnalyse. 7. Um Probleme lösen zu können, müssen sie so repräsentiert werden, daß sich Lösungswege eröffnen. 8. Voraussetzung dafür ist, Objekte in neuen funktionalen Zusammenhängen sehen zu können und nicht der funktionalen Fixierung zu erliegen. 9. Ein anderes Hindernis für erfolgreiches Problemlösen sind sog. Einstellungseffekte. Bestimmte Operatoren werden aufgrund früherer Erfahrungen gegenüber anderen Operatoren bevorzugt. 10. Unter Inkubationseffekten versteht man das relativ schnelle Finden einer Lösung für ein Problem, nachdem man das Suchen nach einer Lösung für einige Zeit eingestellt hat. Inkubationseffekte treten bei sog. Einsichtsproblemen auf, Problemen, deren Lösung von einer einzigen entscheidenden Einsicht abhängt. 11. Problemlösekompetenzen für bestimmte Inhaltsbereiche lassen sich durch intensives Üben erwerben. Man spricht dann von Experten im Gegensatz zu Novizen. 12. Spezielle Fertigkeiten werden typischerweise in drei Phasen erworben, der kognitiven, der assoziativen und der autonomen Phase. 13. Der Leistungszuwachs durch Übung folgt einer Potenzfunktion sowohl bei einfachen als auch bei komplexen Problemen wie mathematische Beweisführungen. 14. Übung bezieht sich sowohl auf taktisches Lernen, also dem Lernen von Operationen, die der Lösung von Teilproblemen dienen, als auch auf strategisches Lernen, worunter man die optimale Organisation der Lösung des Gesamtproblems versteht. 15. Ein wichtiger Aspekt von Expertentum ist die angemessene Repräsentation von Problemen, die die Anwendung von effektiven Problemlöseprozeduren ermöglicht. 16. Experten sehen bei Problemen Muster aufeinander bezogener Elemente, die mit Lösungsmöglichkeiten verknüpft sind. 17. Experten sind besser in der Lage, problembezogene Informationen zu behalten und abzurufen. 18. Für einen Inhaltsbereich erworbene Fähigkeiten lassen sich nicht auf einen anderen Inhaltsbereich übertragen. Nach der Theorie der identischen Elemente ist ein positiver Transfer von Übung in einem Gebiet auf ein anderes Gebiet in dem Maße möglich, in dem die Gebiete gemeinsame Elemente haben. Elemente bezeichnen dabei abstrakte Wissenseinheiten. 19. Eine pädagogische Folgerung daraus ist, Inhalte auf ihre Grundbausteine hin zu analysieren und diese besonders intensiv zu üben (Komponentialanalyse). Dabei muß bei jeder Komponente die Beherrschung durch den Schüler begleitend kontrolliert werden (beherrschungsorientiertes Lernen). Intelligente Tutorensysteme können diese Kontrolle übernehmen. Kognitive Entwicklung 1. Nach der Theorie der kognitiven Entwicklung von Piaget, verläuft diese in vier Stufen, sensumotorische Stufe, präoperationale Stufe, konkret-operationale Stufe, formal-operationale Stufe. 2. Die Stufenkonzeption der kognitiven Entwicklung baut auf der Analyse der Lösungen von kognitiven Aufgaben der Kinder verschiedenen Alters auf. 3. Eine beispielhafte Klasse von Aufgaben sind Invarianzaufgaben. Mit ihnen wird das Wissen von Kindern darüber, welche Eigenschaften der Welt unter verschiedenen Änderungen erhalten bleiben. Es entwickelt sich über die Stufen hinweg. 4. In den ersten beiden Lebensjahren wird die kognitive Entwicklung stärker von der neuronalen Entwicklung getragen, danach stärker von dem Wissen, das in das Gehirn aufgenommen wird. 5. Die mentale Kapazität nimmt bis zur Pubertät zu. Es können mehr Informationen im Arbeitsgedächtnis gehalten werden, was für die Lösung geistiger Aufgaben von Bedeutung ist. Daran beteiligt sind eine Steigerung der Geschwindigkeit neuronaler Funktionen aber auch Übung, in deren Folge mentale Operationen effektiver ausgeführt werden können. 6. Die Bedeutung der Übung wird auch durch die Beobachtung gestützt, dass Kinder Experten auf bestimmten Gebieten werden können und dann bessere Leistungen erbringen als Erwachsene. 7. Mit zunehmendem Alter kommt es zu einem Rückgang der Informationsverarbeitungsgeschwindigkeit. Intelligenz 1. Intelligenzmaße haben den Charakter von Abweichungsmaßen und geben die Stellung einer Person in der Verteilung der Maße ihrer Altersgruppe an. 2. Intelligenztests sind gute Prädiktoren von Schulleistungen. 3. Zwillingsuntersuchungen haben gezeigt, dass Leistungen in Intelligenztests eine angeborene und eine erlernte Komponente haben. 4. Die Korrelation zwischen Expertise und Intelligenzquotient ist eher schwach. 5. Zu den der menschlichen Intelligenz zugrunde liegenden Faktoren gibt es unterschiedliche Auffassungen. Besonders heftig diskutier ist die Frage der Bedeutung eines allgemeinen Intelligenzfaktors. 6. Untersuchungen haben gezeigt, dass die Schnelligkeit, mit der elementare Operationen beim schlussfolgernden Denken, beim verbalen Denken und beim räumlichen Denken ausgeführt werden, mit Intelligenzmaßen korrelieren.