Wahrscheinlichkeitsrechnung und Statistik für Biologen Wiederholung

Werbung

Wahrscheinlichkeitsrechnung und

Statistik für Biologen

Wiederholung

Noémie Becker & Dirk Metzler

http://evol.bio.lmu.de/_statgen

Sommersemester 2013

Übersicht

1

Deskriptive Statistik

2

Standardfehler und t-Tests

3

Chi-Quadrat-Tests

χ2 -Test für eine feste Verteilung

χ2 -Test auf Unabhängigkeit (oder Homogenität)

χ2 -Test für Modelle mit Parametern

4

Konfidenzintervalle

5

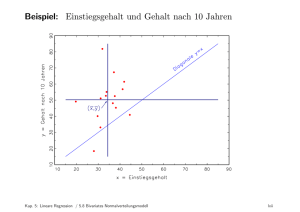

Lineare Regression

Lineare Zusammenhänge

t-Test fuer lineare Zusammenhänge

Überprüfen der Annahmen und Modellwahl

6

Varianzanalyse

7

Versuchsplanung: Stichprobenumfang

Deskriptive Statistik

Übersicht

1

Deskriptive Statistik

2

Standardfehler und t-Tests

3

Chi-Quadrat-Tests

χ2 -Test für eine feste Verteilung

χ2 -Test auf Unabhängigkeit (oder Homogenität)

χ2 -Test für Modelle mit Parametern

4

Konfidenzintervalle

5

Lineare Regression

Lineare Zusammenhänge

t-Test fuer lineare Zusammenhänge

Überprüfen der Annahmen und Modellwahl

6

Varianzanalyse

7

Versuchsplanung: Stichprobenumfang

Deskriptive Statistik

Deskriptive Statistik

40

30

20

10

0

Anzahl

50

60

Nichteiertragende Weibchen am 6. Sept. '88, n=215

1.5

2.0

2.5

3.0

Carapaxlänge [mm]

3.5

Deskriptive Statistik

40

10

20

30

Wieviele haben

Carapaxlänge

zwischen

2,0 und 2,2?

0

Anzahl

50

60

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

1.5

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

40

10

20

30

Wieviele haben

Carapaxlänge

zwischen

2,0 und 2,2?

0

Anzahl

50

60

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

1.5

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

40

30

Wieviele haben

Carapaxlänge

zwischen

2,0 und 2,2?

10

20

22

0

Anzahl

50

60

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

1.5

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Versuche, die Histogramme zusammen zu

zeigen:

1.5

1.0

0.5

0.0

Dichte

2.0

2.5

Nichteiertragende Weibchen

1.5

2.0

2.5

3.0

Carapaxlänge [mm]

3.5

Deskriptive Statistik

Versuche, die Histogramme zusammen zu

zeigen:

0.0

0.5

1.0

Dichte

1.5

2.0

2.5

Nichteiertragende Weibchen

1.5

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

0.0

0.5

1.0

1.5

2.0

Versuche, die Histogramme zusammen zu

zeigen:

1.5

1.7

1.9

2.1

2.3

2.5

2.7

2.9

3.1

3.3

3.5

3.7

Deskriptive Statistik

Versuche, die Histogramme zusammen zu

zeigen:

Deskriptive Statistik

1.5

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

0.0

0.5

Dichte

1.0

Gesamtfläche=1

1.5

2.0

2.5

3.0

Carapaxlänge [mm]

3.5

Deskriptive Statistik

1.5

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

Dichte

?

0.0

0.5

Dichte

1.0

Gesamtfläche=1

1.5

2.0

2.5

3.0

Carapaxlänge [mm]

3.5

Deskriptive Statistik

1.5

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

Dichte

Gesamtfläche=1

0.0

0.5

Dichte

1.0

=

Anteil des Ganzen

pro mm

1.5

2.0

2.5

3.0

Carapaxlänge [mm]

3.5

Deskriptive Statistik

1.5

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

Dichte

1.0

=

Anteil des Ganzen

pro mm

Gesamtfläche=1

0.0

0.5

Dichte

Welcher Anteil

hatte eine Länge

zwischen 2.8 und 3.0 mm?

1.5

2.0

2.5

3.0

Carapaxlänge [mm]

3.5

Deskriptive Statistik

1.5

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

Dichte

1.0

=

Anteil des Ganzen

pro mm

Gesamtfläche=1

0.0

0.5

Dichte

Welcher Anteil

hatte eine Länge

zwischen 2.8 und 3.0 mm?

1.5

2.0

3.0

2.5

Carapaxlänge [mm]

3.5

Deskriptive Statistik

1.5

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

Dichte

1.0

=

Anteil des Ganzen

pro mm

Gesamtfläche=1

0.5

Dichte

Welcher Anteil

hatte eine Länge

zwischen 2.8 und 3.0 mm?

0.0

(3.0 − 2.8) · 0.5 = 0.1

1.5

2.0

3.0

2.5

Carapaxlänge [mm]

3.5

Deskriptive Statistik

1.5

Nichteiertragende Weibchen am 6. Sept. ’88, n=215

Dichte

1.0

=

Anteil des Ganzen

pro mm

Gesamtfläche=1

0.5

Dichte

Welcher Anteil

hatte eine Länge

zwischen 2.8 und 3.0 mm?

(3.0 − 2.8) · 0.5 = 0.1

0.0

10%

1.5

2.0

3.0

2.5

Carapaxlänge [mm]

3.5

Deskriptive Statistik

Zwei und mehr Dichtepolygone in einem Plot

3. Nov. '88

0.5

1.0

1.5

6. Sept. '88

0.0

Anzahl

2.0

2.5

Nichteiertragende Weibchen

1.0

1.5

2.0

2.5

3.0

Carapaxlänge [mm]

3.5

4.0

Deskriptive Statistik

Beispiel:

Vergleich von mehreren Gruppen

Dichte

Dichte

12

14

8

10

12

14

8

10

12

14

8

10

12

14

0.00

10

0.0

Dichte

8

0.0

Dichte

0.00

Deskriptive Statistik

1

2

3

4

Deskriptive Statistik

8

10

12

14

Deskriptive Statistik

Der Boxplot

Boxplot, einfache Ausführung

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, einfache Ausführung

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, einfache Ausführung

50 % der Daten

2.0

50 % der Daten

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, einfache Ausführung

50 % der Daten

50 % der Daten

Median

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, einfache Ausführung

50 % der Daten

Min

50 % der Daten

Max

Median

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, einfache Ausführung

25%

Min

25% 25%

25%

Max

Median

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, einfache Ausführung

25%

25% 25%

25%

1. Quartil

3. Quartil

Median

Min

2.0

2.5

Carapaxlänge [mm]

Max

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, Standardausführung

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, Standardausführung

Interquartilbereich

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, Standardausführung

Interquartilbereich

1,5*Interquartilbereich

1,5*Interquartilbereich

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, Standardausführung

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, Profiausstattung

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Der Boxplot

Boxplot, Profiausstattung

95 % Konfidenzintervall für den Median

2.0

2.5

Carapaxlänge [mm]

3.0

3.5

Deskriptive Statistik

Es ist oft möglich,

das Wesentliche

an einer Stichprobe

mit ein paar Zahlen

zusammenzufassen.

Deskriptive Statistik

Wesentlich:

1. Wie groß?

2. Wie variabel?

Deskriptive Statistik

Wesentlich:

1. Wie groß?

Lageparameter

2. Wie variabel?

Deskriptive Statistik

Wesentlich:

1. Wie groß?

Lageparameter

2. Wie variabel?

Streuungsparameter

Deskriptive Statistik

Eine Möglichkeit

kennen wir schon

aus dem Boxplot:

Deskriptive Statistik

Lageparameter

Der Median

Deskriptive Statistik

Lageparameter

Der Median

Streuungsparameter

Deskriptive Statistik

Lageparameter

Der Median

Streuungsparameter

Der Quartilabstand (Q3 − Q1)

Deskriptive Statistik

Der Median:

die Hälfte der Beobachtungen sind kleiner,

die Hälfte sind größer.

Deskriptive Statistik

Der Median:

die Hälfte der Beobachtungen sind kleiner,

die Hälfte sind größer.

Der Median ist

das 50%-Quantil

der Daten.

Deskriptive Statistik

Die Quartile

Das erste Quartil, Q1:

Deskriptive Statistik

Die Quartile

Das erste Quartil, Q1:

ein Viertel der Beobachtungen

sind kleiner,

drei Viertel sind größer.

Deskriptive Statistik

Die Quartile

Das erste Quartil, Q1:

ein Viertel der Beobachtungen

sind kleiner,

drei Viertel sind größer.

Q1 ist das

25%-Quantil

der Daten.

Deskriptive Statistik

Die Quartile

Das dritte Quartil, Q3:

Deskriptive Statistik

Die Quartile

Das dritte Quartil, Q3:

drei Viertel der Beobachtungen

sind kleiner,

ein Viertel sind größer.

Deskriptive Statistik

Die Quartile

Das dritte Quartil, Q3:

drei Viertel der Beobachtungen

sind kleiner,

ein Viertel sind größer.

Q3 ist das

75%-Quantil

der Daten.

Deskriptive Statistik

Am häufigsten werden benutzt:

Lageparameter

Der Mittelwert x

Deskriptive Statistik

Am häufigsten werden benutzt:

Lageparameter

Der Mittelwert x

Streuungsparameter

Die Standardabweichung s

Deskriptive Statistik

Der Mittelwert

(engl. mean)

Deskriptive Statistik

NOTATION:

Wenn die Beobachtungen

x1, x2, x3, . . . , xn

heißen,

schreibt man oft

x

für den Mittelwert.

Deskriptive Statistik

DEFINITION:

Mittelwert

=

Summe der Messwerte

Anzahl der Messwerte

Deskriptive Statistik

DEFINITION:

Mittelwert

=

Summe

Anzahl

Deskriptive Statistik

DEFINITION:

Der Mittelwert von x1, x2, . . . , xn als Formel:

Deskriptive Statistik

DEFINITION:

Der Mittelwert von x1, x2, . . . , xn als Formel:

x = (x1 + x2 + · · · + xn )/n

Deskriptive Statistik

DEFINITION:

Der Mittelwert von x1, x2, . . . , xn als Formel:

x = (x1 + x2 + · · · + xn )/n

n

1X

xi

=

n

i=1

Deskriptive Statistik

Geometrische Bedeutung

des Mittelwerts:

Der Schwerpunkt

Deskriptive Statistik

Die Standardabweichung

Deskriptive Statistik

Die Standardabweichung

Wie weit weicht

eine typische Beobachtung

vom

Mittelwert

ab ?

Deskriptive Statistik

Die Standardabweichung σ (“sigma”)

ist ein

etwas komisches

gewichtetes Mittel

der Abweichungsbeträge

Deskriptive Statistik

Die Standardabweichung σ (“sigma”)

ist ein

etwas komisches

gewichtetes Mittel

der Abweichungsbeträge

und zwar

q

σ = Summe(Abweichungen2 )/n

bzw. bei Stichproben

q

σ = Summe(Abweichungen2 )/(n − 1)

als Schätzung der Standardabweichung in der

Gesamtpopulation.

Deskriptive Statistik

Die Standardabweichung von x1 , x2 , . . . , xn als Formel:

Deskriptive Statistik

Die Standardabweichung von x1 , x2 , . . . , xn als Formel:

v

u n

u1 X

(xi − x)2

σ=t

n

i=1

Deskriptive Statistik

Die Standardabweichung von x1 , x2 , . . . , xn als Formel:

v

u n

u1 X

(xi − x)2

σ=t

n

i=1

σ2 =

Pn

1

n

i=1 (xi

− x)2 heißt Varianz.

Deskriptive Statistik

Die Standardabweichung von x1 , x2 , . . . , xn als Formel:

v

u n

u1 X

(xi − x)2

σ=t

n

i=1

σ2 =

Pn

1

n

i=1 (xi

− x)2 heißt Varianz.

Bei Stichproben eher üblich:

v

u

n

u 1 X

t

σ=

(xi − x)2

n−1

i=1

Deskriptive Statistik

Die Standardabweichung von x1 , x2 , . . . , xn als Formel:

v

u n

u1 X

(xi − x)2

σ=t

n

i=1

σ2 =

Pn

1

n

i=1 (xi

− x)2 heißt Varianz.

Bei Stichproben eher üblich:

v

u

n

u 1 X

t

σ=

(xi − x)2

n−1

i=1

und σ 2 =

1

n−1

Pn

i=1 (xi

− x)2 .

Deskriptive Statistik

Faustregel für die Standardabweichung

0.6

0.4

0.2

0.0

probability density

0.8

1.0

Bei ungefähr glockenförmigen (also eingipfligen und

symmetrischen) Verteilungen liegen ca. 2/3 der Verteilung

zwischen x − σ und x + σ.

x−σ

x

x+σ

Deskriptive Statistik

Standardabweichung der Carapaxlängen

nichteiertragender Weibchen vom 6.9.88

Nichteiertragende Weibchen

1.0

0.5

0.0

Dichte

1.5

x = 2.53

2.0

2.5

Carapaxlänge [mm]

3.0

Deskriptive Statistik

Standardabweichung der Carapaxlängen

nichteiertragender Weibchen vom 6.9.88

1.5

Nichteiertragende Weibchen

σ = 0.28

x = 2.53

σ = 0.077

1.0

0.5

0.0

Dichte

2

2.0

2.5

Carapaxlänge [mm]

3.0

Deskriptive Statistik

Standardabweichung der Carapaxlängen

nichteiertragender Weibchen vom 6.9.88

1.5

Nichteiertragende Weibchen

σ = 0.28

x = 2.53

σ = 0.077

1.0

0.0

0.5

Dichte

2

2.0

2.5

3.0

Carapaxlänge [mm]

Hier liegt der Anteil zwischen x − σ und x + σ bei 72%.

Deskriptive Statistik

Varianz der Carapaxlängen

nichteiertragender Weibchen vom 6.9.88

Alle Carapaxlängen im Meer: X = (X1 , X2 , . . . , XN ).

Deskriptive Statistik

Varianz der Carapaxlängen

nichteiertragender Weibchen vom 6.9.88

Alle Carapaxlängen im Meer: X = (X1 , X2 , . . . , XN ).

Carapaxlängen in unserer Stichprobe: S = (S1 , S2 , . . . , Sn=215 )

Deskriptive Statistik

Varianz der Carapaxlängen

nichteiertragender Weibchen vom 6.9.88

Alle Carapaxlängen im Meer: X = (X1 , X2 , . . . , XN ).

Carapaxlängen in unserer Stichprobe: S = (S1 , S2 , . . . , Sn=215 )

Stichprobenvarianz:

215

σS2

1X

=

(Si − S)2 ≈ 0,0768

n

i=1

Deskriptive Statistik

Varianz der Carapaxlängen

nichteiertragender Weibchen vom 6.9.88

Alle Carapaxlängen im Meer: X = (X1 , X2 , . . . , XN ).

Carapaxlängen in unserer Stichprobe: S = (S1 , S2 , . . . , Sn=215 )

Stichprobenvarianz:

215

σS2

1X

=

(Si − S)2 ≈ 0,0768

n

i=1

Können wir 0,0768 als Schätzwert für die Varianz σX2 in der

ganzen Population verwenden?

Deskriptive Statistik

Varianz der Carapaxlängen

nichteiertragender Weibchen vom 6.9.88

Alle Carapaxlängen im Meer: X = (X1 , X2 , . . . , XN ).

Carapaxlängen in unserer Stichprobe: S = (S1 , S2 , . . . , Sn=215 )

Stichprobenvarianz:

215

σS2

1X

=

(Si − S)2 ≈ 0,0768

n

i=1

Können wir 0,0768 als Schätzwert für die Varianz σX2 in der

ganzen Population verwenden?

Ja, können wir machen.

Deskriptive Statistik

Varianz der Carapaxlängen

nichteiertragender Weibchen vom 6.9.88

Alle Carapaxlängen im Meer: X = (X1 , X2 , . . . , XN ).

Carapaxlängen in unserer Stichprobe: S = (S1 , S2 , . . . , Sn=215 )

Stichprobenvarianz:

215

σS2

1X

=

(Si − S)2 ≈ 0,0768

n

i=1

Können wir 0,0768 als Schätzwert für die Varianz σX2 in der

ganzen Population verwenden?

Ja, können wir machen. Allerdings ist σS2 im Durchschnitt um

den Faktor n−1

(= 214/215 ≈ 0, 995) kleiner als σX2

n

Deskriptive Statistik

Varianzbegriffe

P

Varianz in der Population: σX2 = N1 Ni=1 (Xi − X )2

P

Stichprobenvarianz: σS2 = n1 ni=1 (Si − S)2

Deskriptive Statistik

Varianzbegriffe

P

Varianz in der Population: σX2 = N1 Ni=1 (Xi − X )2

P

Stichprobenvarianz: σS2 = n1 ni=1 (Si − S)2

korrigierte Stichprobenvarinanz:

s2 =

n

σ2

n−1 S

Deskriptive Statistik

Varianzbegriffe

P

Varianz in der Population: σX2 = N1 Ni=1 (Xi − X )2

P

Stichprobenvarianz: σS2 = n1 ni=1 (Si − S)2

korrigierte Stichprobenvarinanz:

n

σ2

n−1 S

n

n

1 X

=

· ·

(Si − S)2

n−1 n

s2 =

i=1

Deskriptive Statistik

Varianzbegriffe

P

Varianz in der Population: σX2 = N1 Ni=1 (Xi − X )2

P

Stichprobenvarianz: σS2 = n1 ni=1 (Si − S)2

korrigierte Stichprobenvarinanz:

n

σ2

n−1 S

n

n

1 X

=

· ·

(Si − S)2

n−1 n

s2 =

i=1

=

1

n−1

n

X

·

(Si − S)2

i=1

Mit “Standardabweichung von S” ist meistens das korrigierte s

gemeint.

Deskriptive Statistik

Definition (Varianz, Kovarianz und Korrelation)

Die Varianz einer R-wertigen Zufallsgröße X ist

VarX = σX2 = E (X − EX )2 .

σX =

√

Var X ist die Standardabweichung.

Deskriptive Statistik

Definition (Varianz, Kovarianz und Korrelation)

Die Varianz einer R-wertigen Zufallsgröße X ist

VarX = σX2 = E (X − EX )2 .

√

σX = Var X ist die Standardabweichung.

Ist Y eine weitere reellwertige Zufallsvariable, so ist

Cov(X , Y ) = E [(X − EX ) · (Y − EY )]

die Kovarianz von X und Y .

Deskriptive Statistik

Definition (Varianz, Kovarianz und Korrelation)

Die Varianz einer R-wertigen Zufallsgröße X ist

VarX = σX2 = E (X − EX )2 .

√

σX = Var X ist die Standardabweichung.

Ist Y eine weitere reellwertige Zufallsvariable, so ist

Cov(X , Y ) = E [(X − EX ) · (Y − EY )]

die Kovarianz von X und Y .

Die Korrelation von X und Y ist

Cor(X , Y ) =

Cov(X , Y )

.

σX · σY

Deskriptive Statistik

Definition (Varianz, Kovarianz und Korrelation)

Ist (x1 , y1 ), (x2 , y2 ), . . . , (xn , yn ) eine gepaarte Stichprobe der

Zufallsgrößen X und Y , so schätzen wir die Varianzen σX2 und

σY2 durch

n

sx2 =

1 X

(xi − x̄)2

n−1

n

und sy2 =

i=1

1 X

(yi − ȳ)2 ,

n−1

i=1

die Kovarianz Cov(X , Y ) durch

n

1 X

cov(x, y) =

(xi − x̄) · (yi − ȳ)

n−1

i=1

und die Korrelation Cor(X , Y ) durch

cor(x, y) =

cov(x, y)

.

sx · sy

Deskriptive Statistik

x

1

2

3

y

2

1

6

Deskriptive Statistik

x

1

2

3

y

2

x̄ = 2,

1

6

ȳ = 3

Deskriptive Statistik

x

1

2

3

y

2

x̄ = 2, ȳ = 3

1

6

p

sx = ((1 − 2)2 + (2 − 2)2 + (3 − 2)2 ) /2 = 1

Deskriptive Statistik

x

1

2

3

y

2

x̄ = 2, ȳ = 3

1

6

p

sx = p((1 − 2)2 + (2 − 2)2 + (3 − 2)2 ) /2 = 1

sy = ((2 − 3)2 + (1 − 3)2 + (6 − 3)2 ) /2 ≈ 2.65·

Deskriptive Statistik

x

1

2

3

y

2

x̄ = 2, ȳ = 3

1

6

p

sx = p((1 − 2)2 + (2 − 2)2 + (3 − 2)2 ) /2 = 1

sy = ((2 − 3)2 + (1 − 3)2 + (6 − 3)2 ) /2 ≈ 2.65·

cov(x,y) =

((1 − 2) · (2 − 3) + (2 − 2) · (1 − 3) + (3 − 2) · (6 − 3)) /2 = 2

Deskriptive Statistik

x

1

2

3

y

2

x̄ = 2, ȳ = 3

1

6

p

sx = p((1 − 2)2 + (2 − 2)2 + (3 − 2)2 ) /2 = 1

sy = ((2 − 3)2 + (1 − 3)2 + (6 − 3)2 ) /2 ≈ 2.65·

cov(x,y) =

((1 − 2) · (2 − 3) + (2 − 2) · (1 − 3) + (3 − 2) · (6 − 3)) /2 = 2

cov(x,y)

2

cor(x,y) = sx ·sy = 1·2.65

≈ 0.756

Deskriptive Statistik

8

10

σX = 0.95, σY = 0.92

●

●

● ●

● ●

●

●

●●

●

●

● ●●

●●

● ●

● ●

●

● ●●

●

●

●

●

●

● ● ●

●●●

● ●

●

●

●

●

● ● ●

● ●●●

●

●

●

●

●

●

●

● ● ●● ●

●

● ●

● ●

●

● ●●

●●

●●●

●

●●

● ●

●

●

●

●

●

●

Y

6

●

● ●

●

●

●

4

●

●

●

●

●

●

0

2

●

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 0.95, σY = 0.92

8

10

Cov(X , Y ) = −0.06

●

●

● ●

● ●

●

●

●●

●

●

● ●●

●●

● ●

● ●

●

● ●●

●

●

●

●

●

● ● ●

●●●

● ●

●

●

●

●

● ● ●

● ●●●

●

●

●

●

●

●

●

● ● ●● ●

●

● ●

● ●

●

● ●●

●●

●●●

●

●●

● ●

●

●

●

●

●

●

Y

6

●

● ●

●

●

●

4

●

●

●

●

●

●

0

2

●

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 0.95, σY = 0.92

Cov(X , Y ) = −0.06

8

10

Cor(X , Y ) = −0.069

●

●

● ●

● ●

●

●

●●

●

●

● ●●

●●

● ●

● ●

●

● ●●

●

●

●

●

●

● ● ●

●●●

● ●

●

●

●

●

● ● ●

● ●●●

●

●

●

●

●

●

●

● ● ●● ●

●

● ●

● ●

●

● ●●

●●

●●●

●

●●

● ●

●

●

●

●

●

●

Y

6

●

● ●

●

●

●

4

●

●

●

●

●

●

0

2

●

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 0.95, σY = 0.92

Cov(X , Y ) = −0.06

10

●●

8

8

10

Cor(X , Y ) = −0.069

● ●

●

●

●

● ●

●

● ● ● ●●● ●

●

● ● ●●

●

●●

●●

●

●

●

● ● ● ● ●● ●

●

●

●

●●

●

● ● ●●

●

●

● ●

●

●

● ● ●

●

● ● ●● ●

●●

●●

●● ● ● ●

●

● ●●●

● ●● ●●

● ● ●

●

●

● ●● ●

●

●

● ●

●

●

●

●

●

●

6

Y

4

4

Y

6

●

● ●

● ●

●

●

●

●●

●

●

●

●

● ●●

●●

● ●

●

● ●

● ●

●

●

● ●●

●

●

●

●

●

●

●

● ● ●

●●●

● ●

●

●

●

●

●

● ● ●

● ●●●

●

●

●

●

●

●

●

● ● ●● ●

●

● ●

●

● ●

●

● ●●

●●

●●●

●

●●

● ●

●

●

●

●

●

●

2

0

0

2

●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 0.95, σY = 0.92

σX = 1.13, σY = 1.2

Cov(X , Y ) = −0.06

10

●●

8

8

10

Cor(X , Y ) = −0.069

● ●

●

●

●

● ●

●

● ● ● ●●● ●

●

● ● ●●

●

●●

●●

●

●

●

● ● ● ● ●● ●

●

●

●

●●

●

● ● ●●

●

●

● ●

●

●

● ● ●

●

● ● ●● ●

●●

●●

●● ● ● ●

●

● ●●●

● ●● ●●

● ● ●

●

●

● ●● ●

●

●

● ●

●

●

●

●

●

●

6

Y

4

4

Y

6

●

● ●

● ●

●

●

●

●●

●

●

●

●

● ●●

●●

● ●

●

● ●

● ●

●

●

● ●●

●

●

●

●

●

●

●

● ● ●

●●●

● ●

●

●

●

●

●

● ● ●

● ●●●

●

●

●

●

●

●

●

● ● ●● ●

●

● ●

●

● ●

●

● ●●

●●

●●●

●

●●

● ●

●

●

●

●

●

●

2

0

0

2

●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 0.95, σY = 0.92

σX = 1.13, σY = 1.2

Cov(X , Y ) = −0.06

Cov(X , Y ) = −1.26

10

●●

8

8

10

Cor(X , Y ) = −0.069

● ●

●

●

●

● ●

●

● ● ● ●●● ●

●

● ● ●●

●

●●

●●

●

●

●

● ● ● ● ●● ●

●

●

●

●●

●

● ● ●●

●

●

● ●

●

●

● ● ●

●

● ● ●● ●

●●

●●

●● ● ● ●

●

● ●●●

● ●● ●●

● ● ●

●

●

● ●● ●

●

●

● ●

●

●

●

●

●

●

6

Y

4

4

Y

6

●

● ●

● ●

●

●

●

●●

●

●

●

●

● ●●

●●

● ●

●

● ●

● ●

●

●

● ●●

●

●

●

●

●

●

●

● ● ●

●●●

● ●

●

●

●

●

●

● ● ●

● ●●●

●

●

●

●

●

●

●

● ● ●● ●

●

● ●

●

● ●

●

● ●●

●●

●●●

●

●●

● ●

●

●

●

●

●

●

2

0

0

2

●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 1.14, σY = 0.78

σX = 1.13, σY = 1.2

Cov(X , Y ) = −1.26

10

●●

8

8

10

Cor(X , Y ) = −0.92

●

Y

6

● ●

●

●

●

● ●

●

● ● ● ●●● ●

●

● ● ●●

●

●●

●●

●

●

●

● ● ● ● ●● ●

●

●

●

●●

●

● ● ●●

●

●

● ●

●

●

● ● ●

●

● ● ●● ●

●●

●●

●● ● ● ●

●

● ●●●

● ●● ●●

● ● ●

●

●

● ●● ●

●

●

● ●

●

●

●

●

4

4

Y

6

●

●

●

● ●

●

● ● ●

● ●

●

●

●

●

●

●

●

● ●● ●

●●

● ●●●

●

●

●

●

● ●●

●

● ● ●●

●

●●

●●

● ●

●●

●● ●

●

●● ●● ●

●

●

●●●●

●

●

●

●

●● ●

● ●● ● ●

● ●

●

●

● ●

●● ●

●●

●

● ●

●

●

●

2

2

●

0

0

●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 1.14, σY = 0.78

σX = 1.13, σY = 1.2

Cov(X , Y ) = 0.78

Cov(X , Y ) = −1.26

10

●●

8

8

10

Cor(X , Y ) = −0.92

●

Y

6

● ●

●

●

●

● ●

●

● ● ● ●●● ●

●

● ● ●●

●

●●

●●

●

●

●

● ● ● ● ●● ●

●

●

●

●●

●

● ● ●●

●

●

● ●

●

●

● ● ●

●

● ● ●● ●

●●

●●

●● ● ● ●

●

● ●●●

● ●● ●●

● ● ●

●

●

● ●● ●

●

●

● ●

●

●

●

●

4

4

Y

6

●

●

●

● ●

●

● ● ●

● ●

●

●

●

●

●

●

●

● ●● ●

●●

● ●●●

●

●

●

●

● ●●

●

● ● ●●

●

●●

●●

● ●

●●

●● ●

●

●● ●● ●

●

●

●●●●

●

●

●

●

●● ●

● ●● ● ●

● ●

●

●

● ●

●● ●

●●

●

● ●

●

●

●

2

2

●

0

0

●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

Cov(X , Y ) = 0.78

Cov(X , Y ) = −1.26

Cor(X , Y ) = 0.71

Cor(X , Y ) = −0.92

●●

8

8

10

σX = 1.13, σY = 1.2

10

σX = 1.14, σY = 0.78

●

Y

6

● ●

●

●

●

● ●

●

● ● ● ●●● ●

●

● ● ●●

●

●●

●●

●

●

●

● ● ● ● ●● ●

●

●

●

●●

●

● ● ●●

●

●

● ●

●

●

● ● ●

●

● ● ●● ●

●●

●●

●● ● ● ●

●

● ●●●

● ●● ●●

● ● ●

●

●

● ●● ●

●

●

● ●

●

●

●

●

4

4

Y

6

●

●

●

● ●

●

● ● ●

● ●

●

●

●

●

●

●

●

● ●● ●

●●

● ●●●

●

●

●

●

● ●●

●

● ● ●●

●

●●

●●

● ●

●●

●● ●

●

●● ●● ●

●

●

●●●●

●

●

●

●

●● ●

● ●● ● ●

● ●

●

●

● ●

●● ●

●●

●

● ●

●

●

●

2

2

●

0

0

●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 1.14, σY = 0.78

Cov(X , Y ) = 0.78

10

●

8

8

10

Cor(X , Y ) = 0.71

●

●

●●●

Y

6

●

●

●

●●

●●● ●

●

● ●

● ●● ●●

●

●

●

●

●● ●●

●● ●●● ●●●

●

●

●●

●

●

●

●

●●●●●

●●

●

●●●

●●

●

●

●

●

●

●

●

●●

●

●●●

●●● ●

●●

●

●

●

●●

●

●●

●

●

●●

●

4

4

Y

6

●

●

●

● ●

●

● ● ●

● ●

●

●

●

●

●

●

●

● ●● ●

●●

● ●●●

●

●

●

●

● ●●

●

● ● ●●

●

●●

●●

● ●

●●

●● ●

●

●● ●● ●

●

●

●●●●

●

●

●

●

●● ●

● ●● ● ●

● ●

●

●

● ●

●● ●

●●

●

● ●

●

●

●

2

2

●

0

0

●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 1.14, σY = 0.78

σX = 1.03, σY = 0.32

Cov(X , Y ) = 0.78

10

●

8

8

10

Cor(X , Y ) = 0.71

●

●

●●●

Y

6

●

●

●

●●

●●● ●

●

● ●

● ●● ●●

●

●

●

●

●● ●●

●● ●●● ●●●

●

●

●●

●

●

●

●

●●●●●

●●

●

●●●

●●

●

●

●

●

●

●

●

●●

●

●●●

●●● ●

●●

●

●

●

●●

●

●●

●

●

●●

●

4

4

Y

6

●

●

●

● ●

●

● ● ●

● ●

●

●

●

●

●

●

●

● ●● ●

●●

● ●●●

●

●

●

●

● ●●

●

● ● ●●

●

●●

●●

● ●

●●

●● ●

●

●● ●● ●

●

●

●●●●

●

●

●

●

●● ●

● ●● ● ●

● ●

●

●

● ●

●● ●

●●

●

● ●

●

●

●

2

2

●

0

0

●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 1.14, σY = 0.78

σX = 1.03, σY = 0.32

Cov(X , Y ) = 0.78

Cov(X , Y ) = 0.32

10

●

8

8

10

Cor(X , Y ) = 0.71

●

●

●●●

Y

6

●

●

●

●●

●●● ●

●

● ●

● ●● ●●

●

●

●

●

●● ●●

●● ●●● ●●●

●

●

●●

●

●

●

●

●●●●●

●●

●

●●●

●●

●

●

●

●

●

●

●

●●

●

●●●

●●● ●

●●

●

●

●

●●

●

●●

●

●

●●

●

4

4

Y

6

●

●

●

● ●

●

● ● ●

● ●

●

●

●

●

●

●

●

● ●● ●

●●

● ●●●

●

●

●

●

● ●●

●

● ● ●●

●

●●

●●

● ●

●●

●● ●

●

●● ●● ●

●

●

●●●●

●

●

●

●

●● ●

● ●● ● ●

● ●

●

●

● ●

●● ●

●●

●

● ●

●

●

●

2

2

●

0

0

●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 0.91, σY = 0.88

σX = 1.03, σY = 0.32

Cov(X , Y ) = 0.32

10

10

8

8

Cor(X , Y ) = 0.95

●

6

●

●●●

Y

Y

6

●

●

●

●●

●●● ●

●

● ●

● ●● ●●

●

●

●

●

●● ●●

●● ●●● ●●●

●

●

●●

●

●

●

●

●●●●●

●●

●

●●●

●●

●

●

●

●

●

●

●

●●

●

●●●

●●● ●

●●

●

●

●

●●

●

●●

●

●

●●

●

4

●

4

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

2

0

0

2

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●●

●

●

●●

●

●

●●

●●

●●●

●●●

●●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

σX = 0.91, σY = 0.88

σX = 1.03, σY = 0.32

Cov(X , Y ) = 0

Cov(X , Y ) = 0.32

10

10

8

8

Cor(X , Y ) = 0.95

●

6

●

●●●

Y

Y

6

●

●

●

●●

●●● ●

●

● ●

● ●● ●●

●

●

●

●

●● ●●

●● ●●● ●●●

●

●

●●

●

●

●

●

●●●●●

●●

●

●●●

●●

●

●

●

●

●

●

●

●●

●

●●●

●●● ●

●●

●

●

●

●●

●

●●

●

●

●●

●

4

●

4

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

2

0

0

2

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●●

●

●

●●

●

●

●●

●●

●●●

●●●

●●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Deskriptive Statistik

Cor(X , Y ) = 0

Cor(X , Y ) = 0.95

10

Cov(X , Y ) = 0.32

8

Cov(X , Y ) = 0

10

σX = 1.03, σY = 0.32

8

σX = 0.91, σY = 0.88

●

6

●

●●●

Y

Y

6

●

●

●

●●

●●● ●

●

● ●

● ●● ●●

●

●

●

●

●● ●●

●● ●●● ●●●

●

●

●●

●

●

●

●

●●●●●

●●

●

●●●

●●

●

●

●

●

●

●

●

●●

●

●●●

●●● ●

●●

●

●

●

●●

●

●●

●

●

●●

●

4

●

4

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

2

0

0

2

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●

●●

●

●

●●

●

●

●●

●●

●●●

●●●

●●

0

2

4

6

X

8

10

0

2

4

6

X

8

10

Standardfehler und t-Tests

Übersicht

1

Deskriptive Statistik

2

Standardfehler und t-Tests

3

Chi-Quadrat-Tests

χ2 -Test für eine feste Verteilung

χ2 -Test auf Unabhängigkeit (oder Homogenität)

χ2 -Test für Modelle mit Parametern

4

Konfidenzintervalle

5

Lineare Regression

Lineare Zusammenhänge

t-Test fuer lineare Zusammenhänge

Überprüfen der Annahmen und Modellwahl

6

Varianzanalyse

7

Versuchsplanung: Stichprobenumfang

Standardfehler und t-Tests

0

2

4

6

8

10

10 Stichproben vom Umfang 16 und die

zugehörigen Stichprobenmittel

0.06 0.08 0.10 0.12 0.14 0.16 0.18 0.20

Transpiration (ml/(Tag*cm^2))

Standardfehler und t-Tests

Population

Mittelwert=0.117

Standardabw.=0.026

Stichprobenmittel

Mittelwert=0.117

Standardabw.= 0.0065

40

20

0

Dichte

60

80

Verteilung der Stichprobenmittelwerte

(Stichprobenumfang n = 16)

0.06 0.08 0.10 0.12 0.14 0.16 0.18 0.20

Transpiration (ml/(Tag*cm^2))

Standardfehler und t-Tests

Die allgemeine Regel

Die Standardabweichung

des Mittelwerts einer Stichprobe vom

Umfang n

Standardfehler und t-Tests

Die allgemeine Regel

Die Standardabweichung

des Mittelwerts einer Stichprobe vom

Umfang n

ist

√

1/ n

mal

der Standardabweichung

der Population.

Standardfehler und t-Tests

Die Standardabweichung der Population

bezeichnet man mit

σ

(sigma).

Standardfehler und t-Tests

Die Standardabweichung der Population

bezeichnet man mit

σ

(sigma).

Die Regel schreibt man häufig so:

1

σ(x) = √ σ(X )

n

Standardfehler und t-Tests

In der Praxis ist

σ

unbekannt.

Standardfehler und t-Tests

In der Praxis ist

σ

unbekannt.

Es wird durch

die Stichproben-Standardabweichung

geschätzt:

s

Standardfehler und t-Tests

In der Praxis ist

σ

unbekannt.

Es wird durch

die Stichproben-Standardabweichung

geschätzt:

σ =??

s

Standardfehler und t-Tests

In der Praxis ist

σ

unbekannt.

Es wird durch

die Stichproben-Standardabweichung

geschätzt:

σ≈s

s

Standardfehler und t-Tests

√

s/ n

(die geschätzte

Standardabweichung

von x)

nennt man den

Standardfehler.

Standardfehler und t-Tests

√

s/ n

(die geschätzte

Standardabweichung

von x)

nennt man den

Standardfehler.

(Englisch: standard error of the mean,

standard error, SEM)

Standardfehler und t-Tests

Wir haben gesehen:

Auch wenn die Verteilung von

x mehrgipfelig

&

asymmetrisch

ist

Standardfehler und t-Tests

10

5

0

Dichte

15

Hypothethische Transpirationsratenverteilung

0.06 0.08 0.10 0.12 0.14 0.16 0.18 0.20

Transpiration (ml/(Tag*cm^2))

Standardfehler und t-Tests

ist die Verteilung von

x

trotzdem

(annähernd)

eingipfelig

&

symmetrisch

(wenn der Stichprobenumfang n nur groß genug ist)

Standardfehler und t-Tests

10 20 30 40 50 60

Population

Stichprobenmittel

(n=16)

0

Dichte

Hypothethische Transpirationsratenverteilung

0.06 0.08 0.10 0.12 0.14 0.16 0.18 0.20

Transpiration (ml/(Tag*cm^2))

Standardfehler und t-Tests

Die Verteilung von x

hat annähernd

eine ganz bestimmte Form:

die Normalverteilung.

Standardfehler und t-Tests

Dichte der Normalverteilung

µ

0.1

0.2

0.3

µ+σ

0.0

Normaldichte

0.4

µ−σ

−1

0

1

2

3

4

5

Standardfehler und t-Tests

Dichte der Normalverteilung

µ

0.1

0.2

0.3

µ+σ

0.0

Normaldichte

0.4

µ−σ

−1

0

1

2

3

4

Die Normalverteilungsdichte heisst

auch Gauß’sche Glockenkurve

5

Standardfehler und t-Tests

Dichte der Normalverteilung

Die Normalverteilungsdichte heisst

auch Gauß’sche Glockenkurve

(nach Carl Friedrich Gauß, 1777-1855)

Standardfehler und t-Tests

Wichtige Folgerung

Wir betrachten das Intervall

√

x − s/ n

√

x + s/ n

x

Standardfehler und t-Tests

Wichtige Folgerung

Mit Wahrscheinlichkeit ca. 2/3

liegt µ innerhalb dieses Intervalls

√

x − s/ n

√

x + s/ n

x

Standardfehler und t-Tests

Wichtige Folgerung

Mit Wahrscheinlichkeit ca. 2/3

liegt µ innerhalb dieses Intervalls

√

x − s/ n

√

x + s/ n

x

Mit Wahrscheinlichkeit ca. 1/3

liegt µ ausserhalb des Intervalls

Standardfehler und t-Tests

Demnach:

Es kommt durchaus vor, dass x

von µ

um

√ mehr als

s/ n abweicht.

Standardfehler und t-Tests

Nehmen wir an, eine Population hat Mittelwert µ und

Standardabweichung σ.

Standardfehler und t-Tests

Nehmen wir an, eine Population hat Mittelwert µ und

Standardabweichung σ.

Aus dieser Population ziehen wir eine Zufallsstichprobe

vom Umfang n, mit Stichprobenmittelwert x.

Standardfehler und t-Tests

Nehmen wir an, eine Population hat Mittelwert µ und

Standardabweichung σ.

Aus dieser Population ziehen wir eine Zufallsstichprobe

vom Umfang n, mit Stichprobenmittelwert x.

x ist eine Zufallsgröße

Standardfehler und t-Tests

Nehmen wir an, eine Population hat Mittelwert µ und

Standardabweichung σ.

Aus dieser Population ziehen wir eine Zufallsstichprobe

vom Umfang n, mit Stichprobenmittelwert x.

x ist eine Zufallsgröße

√

mit Mittelwert µ und Standardabweichung σ/ n.

Standardfehler und t-Tests

Nehmen wir an, eine Population hat Mittelwert µ und

Standardabweichung σ.

Aus dieser Population ziehen wir eine Zufallsstichprobe

vom Umfang n, mit Stichprobenmittelwert x.

x ist eine Zufallsgröße

√

mit Mittelwert µ und Standardabweichung σ/ n.

√

Man schätzt die Standardabweichung von x mit s/ n.

Standardfehler und t-Tests

Nehmen wir an, eine Population hat Mittelwert µ und

Standardabweichung σ.

Aus dieser Population ziehen wir eine Zufallsstichprobe

vom Umfang n, mit Stichprobenmittelwert x.

x ist eine Zufallsgröße

√

mit Mittelwert µ und Standardabweichung σ/ n.

√

Man schätzt die Standardabweichung von x mit s/ n.

√

s/ n nennt man den Standardfehler.

Standardfehler und t-Tests

Nehmen wir an, eine Population hat Mittelwert µ und

Standardabweichung σ.

Aus dieser Population ziehen wir eine Zufallsstichprobe

vom Umfang n, mit Stichprobenmittelwert x.

x ist eine Zufallsgröße

√

mit Mittelwert µ und Standardabweichung σ/ n.

√

Man schätzt die Standardabweichung von x mit s/ n.

√

s/ n nennt man den Standardfehler.

√

Schwankungen in x von der Größe s/ n kommen häufig

vor.

Standardfehler und t-Tests

Nehmen wir an, eine Population hat Mittelwert µ und

Standardabweichung σ.

Aus dieser Population ziehen wir eine Zufallsstichprobe

vom Umfang n, mit Stichprobenmittelwert x.

x ist eine Zufallsgröße

√

mit Mittelwert µ und Standardabweichung σ/ n.

√

Man schätzt die Standardabweichung von x mit s/ n.

√

s/ n nennt man den Standardfehler.

√

Schwankungen in x von der Größe s/ n kommen häufig

vor.

Solche Schwankungen sind nicht signifikant“: sie könnten

”

Zufall sein.

Standardfehler und t-Tests

Allgemein gilt

Sind X1 , . . . , Xn unabhängig aus einer Normalverteilung mit

Mittelwert µ gezogen und ist

v

u

n

u 1 X

t

s=

(Xi − X )2 ,

n−1

i=1

so ist

X −µ

√

s/ n

t-verteilt mit n − 1 Freiheitsgraden (df=degrees of freedom).

Standardfehler und t-Tests

Allgemein gilt

Sind X1 , . . . , Xn unabhängig aus einer Normalverteilung mit

Mittelwert µ gezogen und ist

v

u

n

u 1 X

t

s=

(Xi − X )2 ,

n−1

i=1

so ist

X −µ

√

s/ n

t-verteilt mit n − 1 Freiheitsgraden (df=degrees of freedom).

Die t-Verteilung heißt auch Student-Verteilung, da Gosset sie

unter diesem Pseudonym publiziert hat.

Standardfehler und t-Tests

Wie (un)wahrscheinlich ist nun eine

so große Abweichung wie 2.35 Standardfehler?

Pr(T = 2.34) =

Standardfehler und t-Tests

Wie (un)wahrscheinlich ist nun eine

so große Abweichung wie 2.35 Standardfehler?

Pr(T = 2.34) = 0

Standardfehler und t-Tests

Wie (un)wahrscheinlich ist nun eine mindestens

so große Abweichung wie 2.35 Standardfehler?

Pr(T = 2.34) = 0

Das bringt nichts!

Standardfehler und t-Tests

Wie (un)wahrscheinlich ist nun eine

so große Abweichung wie 2.35 Standardfehler?

Pr(T = 2.34) = 0

Das bringt nichts!

0.2

0.1

0.0

density

0.3

0.4

Zu berechnen ist Pr(|T | ≥ 2.34), der sog. p-Wert.

−4

−2

−2.34

0

2

4

2.34

Standardfehler und t-Tests

Wie (un)wahrscheinlich ist nun eine

so große Abweichung wie 2.35 Standardfehler?

Pr(T = 2.34) = 0

Das bringt nichts!

0.1

0.2

Also der Gesamtinhalt der

magentafarbenen Flächen.

0.0

density

0.3

0.4

Zu berechnen ist Pr(|T | ≥ 2.34), der sog. p-Wert.

−4

−2

−2.34

0

2

4

2.34

Standardfehler und t-Tests

Wir halten fest:

p-Wert = 0.03254

Standardfehler und t-Tests

Wir halten fest:

p-Wert = 0.03254

d.h.: Wenn die Nullhypothese “alles nur Zufall”, also in diesem

Fall die Hypothese µ = 0 gilt, dann ist eine mindestens so große

Abweichung sehr unwahrscheinlich.

Standardfehler und t-Tests

Wir halten fest:

p-Wert = 0.03254

d.h.: Wenn die Nullhypothese “alles nur Zufall”, also in diesem

Fall die Hypothese µ = 0 gilt, dann ist eine mindestens so große

Abweichung sehr unwahrscheinlich.

Wenn wir beschließen, dass wir die Nullhypothese immer

verwerfen, wenn der p-Wert unterhalb einem

Signifikanzniveau von 0.05 liegt, gilt:

Standardfehler und t-Tests

Wir halten fest:

p-Wert = 0.03254

d.h.: Wenn die Nullhypothese “alles nur Zufall”, also in diesem

Fall die Hypothese µ = 0 gilt, dann ist eine mindestens so große

Abweichung sehr unwahrscheinlich.

Wenn wir beschließen, dass wir die Nullhypothese immer

verwerfen, wenn der p-Wert unterhalb einem

Signifikanzniveau von 0.05 liegt, gilt:

Falls die Nullhypothese zutrifft, ist die Wahrscheinlichkeit, dass

wir sie zu Unrecht verwerfen, lediglich 0.05.

Standardfehler und t-Tests

0.2

0.0

0.1

density

0.3

0.4

Wenn wir uns auf ein Signifikanzniveau von α = 0.05 festlegen,

verwerfen wir die Nullhypothese also, wenn der t-Wert in den

roten Bereich fällt:

−4

−2

0

2

4

(hier am Beispiel der t−Verteilung mit df= 16 Freiheitsgraden)

Standardfehler und t-Tests

Statistische Tests: Die wichtigsten Begriffe

Nullhypothese H0 : wollen wir meistens verwerfen, denn sie

besagt, dass die interessanten Auffälligkeiten in den

Daten nur Zufallsschwankungen sind.

Standardfehler und t-Tests

Statistische Tests: Die wichtigsten Begriffe

Nullhypothese H0 : wollen wir meistens verwerfen, denn sie

besagt, dass die interessanten Auffälligkeiten in den

Daten nur Zufallsschwankungen sind.

Signifikanzniveau α : Wahrscheinlichkeit, dass wir, falls die

Nullhypothese gilt, diese zu Unrecht verwerfen.

Standardfehler und t-Tests

Statistische Tests: Die wichtigsten Begriffe

Nullhypothese H0 : wollen wir meistens verwerfen, denn sie

besagt, dass die interessanten Auffälligkeiten in den

Daten nur Zufallsschwankungen sind.

Signifikanzniveau α : Wahrscheinlichkeit, dass wir, falls die

Nullhypothese gilt, diese zu Unrecht verwerfen.

Teststatistik : Misst, auffällig unsere Daten von der

Nullhypothese abweichen.

Standardfehler und t-Tests

Statistische Tests: Die wichtigsten Begriffe

Nullhypothese H0 : wollen wir meistens verwerfen, denn sie

besagt, dass die interessanten Auffälligkeiten in den

Daten nur Zufallsschwankungen sind.

Signifikanzniveau α : Wahrscheinlichkeit, dass wir, falls die

Nullhypothese gilt, diese zu Unrecht verwerfen.

Teststatistik : Misst, auffällig unsere Daten von der

Nullhypothese abweichen.

p-Wert : Für einen beobachteten Wert t der Teststatistik ist

der p-Wert die Wahrscheinlichkeit, dass, falls die

Nullhypothese gilt, die Teststatistik (etwa bei einer

hypothetischen Wiederholung des Versuchs) einen

mindestens so extremen Wert wie t annimmt. Dabei

hängt es von der Art des Tests ab (z.B.

einseitig/zweiseitig), was “extrem” heißt.

Standardfehler und t-Tests

Wir verwerfen H0 , falls der p-Wert kleiner als α wird. (Üblich

ist α = 0.05).

Standardfehler und t-Tests

Wir verwerfen H0 , falls der p-Wert kleiner als α wird. (Üblich

ist α = 0.05).

Damit ergibt sich, dass wir nur in einem Anteil α der Fälle,

in denen H0 gilt, diese (fälschlicherweise) verwerfen.

Standardfehler und t-Tests

Wir verwerfen H0 , falls der p-Wert kleiner als α wird. (Üblich

ist α = 0.05).

Damit ergibt sich, dass wir nur in einem Anteil α der Fälle,

in denen H0 gilt, diese (fälschlicherweise) verwerfen.

Auch wer immer nur Daten ananlysiert, in denen außer

Zufallsschwankungen nichts steckt, wird in einem Anteil α

der Tests die Nullhypothese verwerfen.

Standardfehler und t-Tests

Wir verwerfen H0 , falls der p-Wert kleiner als α wird. (Üblich

ist α = 0.05).

Damit ergibt sich, dass wir nur in einem Anteil α der Fälle,

in denen H0 gilt, diese (fälschlicherweise) verwerfen.

Auch wer immer nur Daten ananlysiert, in denen außer

Zufallsschwankungen nichts steckt, wird in einem Anteil α

der Tests die Nullhypothese verwerfen.

Ein schwerer Verstoß gegen die Wissenschaftlichkeit ist

daher, so lange statistische Tests durchzuführen, bis mal H0

auf einem Signifikanzniveau von 5% verworfen werden

kann, und dann nur letzteres zu veröffentlichen.

Standardfehler und t-Tests

Welche t-Werte sind “auf dem 5%-Niveau” signifikant?

Anzahl Freiheitsgrade |t| ≥ . . .

5

2.57

10

2.23

2.09

20

30

2.04

100

1.98

∞

1.96

Standardfehler und t-Tests

Welche t-Werte sind “auf dem 5%-Niveau” signifikant?

Anzahl Freiheitsgrade |t| ≥ . . .

5

2.57

10

2.23

2.09

20

30

2.04

100

1.98

∞

1.96

> qt(0.025,df=c(5,10,20,30,100,1e100))

Standardfehler und t-Tests

Welche t-Werte sind “auf dem 5%-Niveau” signifikant?

Anzahl Freiheitsgrade |t| ≥ . . .

5

2.57

10

2.23

2.09

20

30

2.04

100

1.98

∞

1.96

> qt(0.025,df=c(5,10,20,30,100,1e100))

[1] -2.570582 -2.228139 -2.085963 -2.042272 -1.983972

-1.959964

Standardfehler und t-Tests

Wir möchten belegen, dass eine Abweichung in den Daten

vermutlich nicht allein auf Zufallsschwankung beruht.

Standardfehler und t-Tests

Wir möchten belegen, dass eine Abweichung in den Daten

vermutlich nicht allein auf Zufallsschwankung beruht.

Dazu spezifizieren wir zunächst eine Nullhypothese H0 , d.h.

wir konkretisieren, was “allein auf Zufall beruhen” bedeutet.

Standardfehler und t-Tests

Wir möchten belegen, dass eine Abweichung in den Daten

vermutlich nicht allein auf Zufallsschwankung beruht.

Dazu spezifizieren wir zunächst eine Nullhypothese H0 , d.h.

wir konkretisieren, was “allein auf Zufall beruhen” bedeutet.

Dann versuchen wir zu zeigen: Wenn H0 gilt, dann ist eine

Abweichung wie, die mindestens so groß sind wie die

beobachtete, sehr unwahrscheinlich.

Standardfehler und t-Tests

Wir möchten belegen, dass eine Abweichung in den Daten

vermutlich nicht allein auf Zufallsschwankung beruht.

Dazu spezifizieren wir zunächst eine Nullhypothese H0 , d.h.

wir konkretisieren, was “allein auf Zufall beruhen” bedeutet.

Dann versuchen wir zu zeigen: Wenn H0 gilt, dann ist eine

Abweichung wie, die mindestens so groß sind wie die

beobachtete, sehr unwahrscheinlich.

Wenn uns das gelingt, verwerfen wir H0 .

Standardfehler und t-Tests

Wir möchten belegen, dass eine Abweichung in den Daten

vermutlich nicht allein auf Zufallsschwankung beruht.

Dazu spezifizieren wir zunächst eine Nullhypothese H0 , d.h.

wir konkretisieren, was “allein auf Zufall beruhen” bedeutet.

Dann versuchen wir zu zeigen: Wenn H0 gilt, dann ist eine

Abweichung wie, die mindestens so groß sind wie die

beobachtete, sehr unwahrscheinlich.

Wenn uns das gelingt, verwerfen wir H0 .

Was wir als Abweichung auffassen, sollten klar sein, bevor

wir die Daten sehen.

Standardfehler und t-Tests

Zweiseitig oder einseitig testen?

0.2

density

0.3

0.4

Wir beobachten einen Wert x, der deutlich größer als der

H0 -Erwartungswert µ ist.

2.5%

p-Wert=PrH0 (|X − µ| ≥ |x − µ|)

0.0

0.1

2.5%

−2

0

2

4

0.2

0.1

5.0%

0.0

density

0.3

0.4

−4

−4

−2

0

2

4

p-Wert=PrH0 (X ≥ x)

Standardfehler und t-Tests

Reine Lehre des statistischen Testens

Formuliere eine Nullhypothese H0 , z.B. µ = 0.

Standardfehler und t-Tests

Reine Lehre des statistischen Testens

Formuliere eine Nullhypothese H0 , z.B. µ = 0.

Lege ein Signifikanzniveau α fest; üblich ist α = 0.05.

Standardfehler und t-Tests

Reine Lehre des statistischen Testens

Formuliere eine Nullhypothese H0 , z.B. µ = 0.

Lege ein Signifikanzniveau α fest; üblich ist α = 0.05.

Lege ein Ereignis A (“extreme Abweichung”) fest, so dass

Pr(A) = α

H0

(oder zumindest PrH0 (A) ≤ α).

Standardfehler und t-Tests

Reine Lehre des statistischen Testens

Formuliere eine Nullhypothese H0 , z.B. µ = 0.

Lege ein Signifikanzniveau α fest; üblich ist α = 0.05.

Lege ein Ereignis A (“extreme Abweichung”) fest, so dass

Pr(A) = α

H0

(oder zumindest PrH0 (A) ≤ α).

z.B. A = {X > q} oder A = {|X − µ| > r }

Standardfehler und t-Tests

Reine Lehre des statistischen Testens

Formuliere eine Nullhypothese H0 , z.B. µ = 0.

Lege ein Signifikanzniveau α fest; üblich ist α = 0.05.

Lege ein Ereignis A (“extreme Abweichung”) fest, so dass

Pr(A) = α

H0

(oder zumindest PrH0 (A) ≤ α).

z.B. A = {X > q} oder A = {|X − µ| > r }

allgemein: A = {p-Wert ≤ α}

Standardfehler und t-Tests

Reine Lehre des statistischen Testens

Formuliere eine Nullhypothese H0 , z.B. µ = 0.

Lege ein Signifikanzniveau α fest; üblich ist α = 0.05.

Lege ein Ereignis A (“extreme Abweichung”) fest, so dass

Pr(A) = α

H0

(oder zumindest PrH0 (A) ≤ α).

z.B. A = {X > q} oder A = {|X − µ| > r }

allgemein: A = {p-Wert ≤ α}

ERST DANN: Betrachte die Daten und überprüfe, ob A

eintritt.

Standardfehler und t-Tests

Reine Lehre des statistischen Testens

Formuliere eine Nullhypothese H0 , z.B. µ = 0.

Lege ein Signifikanzniveau α fest; üblich ist α = 0.05.

Lege ein Ereignis A (“extreme Abweichung”) fest, so dass

Pr(A) = α

H0

(oder zumindest PrH0 (A) ≤ α).

z.B. A = {X > q} oder A = {|X − µ| > r }

allgemein: A = {p-Wert ≤ α}

ERST DANN: Betrachte die Daten und überprüfe, ob A

eintritt.

Dann ist die Wahrscheinlichkeit, dass H0 verworfen wird,

wenn H0 eigentlich richtig ist (“Fehler erster Art”) , lediglich

α.

Standardfehler und t-Tests

Verstöße gegen die reine Lehre

“Beim zweiseitigen Testen kam ein p-Wert

von 0.06 raus. Also hab ich einseitig

getestet, da hat’s dann funktioniert.”

Standardfehler und t-Tests

Verstöße gegen die reine Lehre

“Beim zweiseitigen Testen kam ein p-Wert

von 0.06 raus. Also hab ich einseitig

getestet, da hat’s dann funktioniert.”

genauso problematisch:

Standardfehler und t-Tests

Verstöße gegen die reine Lehre

“Beim zweiseitigen Testen kam ein p-Wert

von 0.06 raus. Also hab ich einseitig

getestet, da hat’s dann funktioniert.”

genauso problematisch:

“Beim ersten Blick auf die Daten habe ich

sofort gesehen, dass x größer ist als µH0 .

Also habe ich gleich einseitig getestet”

Standardfehler und t-Tests

Wichtig

Die Entscheidung ob einseitig oder zweiseitig getestet wird darf

nicht von den konkreten Daten, die zum Test verwendet werden,

abhängen.

Standardfehler und t-Tests

Wichtig

Die Entscheidung ob einseitig oder zweiseitig getestet wird darf

nicht von den konkreten Daten, die zum Test verwendet werden,

abhängen.

Allgemeiner: Ist A das Ereignis, dass zum Verwerfen von H0

führt (falls es eintritt), so muss die Festlegung von A stattfinden

bevor man in den Daten herumgeschnüffelt hat.

Standardfehler und t-Tests

Die Wahl von A sollte von der Alternative H1 abhängen, also für

das, was wir eigentlich zeigen wollen, indem wir H0 durch einen

Test verwerfen. Es muss gelten:

PrH0 (A) = α

und

PrH1 (A) = möglichst groß,

Standardfehler und t-Tests

Die Wahl von A sollte von der Alternative H1 abhängen, also für

das, was wir eigentlich zeigen wollen, indem wir H0 durch einen

Test verwerfen. Es muss gelten:

PrH0 (A) = α

und

PrH1 (A) = möglichst groß,

damit die W’keit eines Fehlers zweiter Art, dass also H0 nicht

verworfen wird, obwohl H1 zutrifft, möglichst klein.

Standardfehler und t-Tests

Beispiele

Wenn wir von Anfang an unsere Vermutung belegen

wollten, dass sich die Trauerschnäpper bei grünem Licht

stärker auf eine Richtung konzentrieren als bei blauem,

dürfen wir einseitig testen.

Standardfehler und t-Tests

Beispiele

Wenn wir von Anfang an unsere Vermutung belegen

wollten, dass sich die Trauerschnäpper bei grünem Licht

stärker auf eine Richtung konzentrieren als bei blauem,

dürfen wir einseitig testen.

Wenn dann aber noch so deutlich herauskommt, dass die

Richtungswahl bei blauem Licht deutlicher war, so ist das

dann nicht als signifikant zu betrachten.

Standardfehler und t-Tests

Beispiele

Wenn wir von Anfang an unsere Vermutung belegen

wollten, dass sich die Trauerschnäpper bei grünem Licht

stärker auf eine Richtung konzentrieren als bei blauem,

dürfen wir einseitig testen.

Wenn dann aber noch so deutlich herauskommt, dass die

Richtungswahl bei blauem Licht deutlicher war, so ist das

dann nicht als signifikant zu betrachten.

Wenn wir von Anfang an die Vermutung belegen wollten,

dass der Kork an der Nordseite des Baumes dicker war,

dürfen wir einseitig testen.

Standardfehler und t-Tests

Beispiele

Wenn wir von Anfang an unsere Vermutung belegen

wollten, dass sich die Trauerschnäpper bei grünem Licht

stärker auf eine Richtung konzentrieren als bei blauem,

dürfen wir einseitig testen.

Wenn dann aber noch so deutlich herauskommt, dass die

Richtungswahl bei blauem Licht deutlicher war, so ist das

dann nicht als signifikant zu betrachten.

Wenn wir von Anfang an die Vermutung belegen wollten,

dass der Kork an der Nordseite des Baumes dicker war,

dürfen wir einseitig testen.

Wenn dann aber noch so deutlich herauskommt, dass der

Kork im Westen dicker ist, ist das nicht mehr signifikant.

Standardfehler und t-Tests

Angenommen, H0 wird auf dem 5%-Niveau verworfen. Welche

Aussage gilt dann?

Die Nullhypothese ist falsch.

Standardfehler und t-Tests

Angenommen, H0 wird auf dem 5%-Niveau verworfen. Welche

Aussage gilt dann?

Die Nullhypothese ist falsch.

Standardfehler und t-Tests

Angenommen, H0 wird auf dem 5%-Niveau verworfen. Welche

Aussage gilt dann?

Die Nullhypothese ist falsch.

H0 ist mit 95%-iger Wahrscheinlichkeit falsch.

Standardfehler und t-Tests

Angenommen, H0 wird auf dem 5%-Niveau verworfen. Welche

Aussage gilt dann?

Die Nullhypothese ist falsch.

H0 ist mit 95%-iger Wahrscheinlichkeit falsch.

Standardfehler und t-Tests

Angenommen, H0 wird auf dem 5%-Niveau verworfen. Welche

Aussage gilt dann?

Die Nullhypothese ist falsch.

H0 ist mit 95%-iger Wahrscheinlichkeit falsch.

Falls die Nullhypothese wahr ist, beobachtet man ein so

extremes Ergebnis nur in 5% der Fälle.

Standardfehler und t-Tests

Angenommen, H0 wird auf dem 5%-Niveau verworfen. Welche

Aussage gilt dann?

Die Nullhypothese ist falsch.

H0 ist mit 95%-iger Wahrscheinlichkeit falsch.

Falls die Nullhypothese wahr ist, beobachtet man ein so

extremes Ergebnis nur in 5% der Fälle. X

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

H0 ist wahrscheinlich wahr.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

H0 ist wahrscheinlich wahr.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

H0 ist wahrscheinlich wahr.

Es ist ungefährlich, davon auzugehen, dass H0 zutrifft.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

H0 ist wahrscheinlich wahr.

Es ist ungefährlich, davon auzugehen, dass H0 zutrifft.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

H0 ist wahrscheinlich wahr.

Es ist ungefährlich, davon auzugehen, dass H0 zutrifft.

Auch wenn H0 zutrifft, ist es nicht sehr unwahrscheinlich,

dass unsere Teststatistik einen mindestens so extrem

erscheinenden Wert annimmt.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

H0 ist wahrscheinlich wahr.

Es ist ungefährlich, davon auzugehen, dass H0 zutrifft.

Auch wenn H0 zutrifft, ist es nicht sehr unwahrscheinlich,

dass unsere Teststatistik einen mindestens so extrem

erscheinenden Wert annimmt.X

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

H0 ist wahrscheinlich wahr.

Es ist ungefährlich, davon auzugehen, dass H0 zutrifft.

Auch wenn H0 zutrifft, ist es nicht sehr unwahrscheinlich,

dass unsere Teststatistik einen mindestens so extrem

erscheinenden Wert annimmt.X

Die Nullhypothese ist in dieser Hinsicht mit den Daten

verträglich.

Standardfehler und t-Tests

Angenommen, H0 konnte durch den Test nicht verworfen

werden. Welche Aussagen sind dann richtig?

Wir müssen die Alternative H1 verwerfen.

H0 ist wahr.

H0 ist wahrscheinlich wahr.

Es ist ungefährlich, davon auzugehen, dass H0 zutrifft.

Auch wenn H0 zutrifft, ist es nicht sehr unwahrscheinlich,

dass unsere Teststatistik einen mindestens so extrem

erscheinenden Wert annimmt.X

Die Nullhypothese ist in dieser Hinsicht mit den Daten

verträglich.X

Standardfehler und t-Tests

Frage

Hipparion:

Laubfresser −→ Grasfresser

Standardfehler und t-Tests

Frage

Hipparion:

Laubfresser −→ Grasfresser

andere Nahrung −→ andere Zähne?

Standardfehler und t-Tests

Frage

Hipparion:

Laubfresser −→ Grasfresser

andere Nahrung −→ andere Zähne?

Messungen: mesiodistale Länge

distal = von der Mittellinie weg

H. libycum

H. africanum

Standardfehler und t-Tests

25

30

35

mediodistale Länge [mm]

40

xA = 25.9

xL = 28.4

H. libycum

H. africanum

Standardfehler und t-Tests

25

30

35

mediodistale Länge [mm]

40

H. libycum

H. africanum

Standardfehler und t-Tests

xA = 25.9, sA = 2.2

xA − sA

xA + sA

xL = 28.4, sL = 4.3

xL − sL

25

xL + sL

30

35

mediodistale Länge [mm]

40

H. libycum

H. africanum

Standardfehler und t-Tests

xA + Standardfehler

xL + Standardfehler

25

30

35

mediodistale Länge [mm]

40

Standardfehler und t-Tests

Wir beobachten (nA = 39, nL = 38):

x A = 25,9, sA = 2,2,

Standardfehler und t-Tests

Wir beobachten (nA = 39, nL = 38):

x A = 25,9, sA = 2,2, unser Schätzwert für die

√

Streung von x A ist also fA = sA = 2,2/ nA = 0,36

(Standardfehler)

Standardfehler und t-Tests

Wir beobachten (nA = 39, nL = 38):

x A = 25,9, sA = 2,2, unser Schätzwert für die

√

Streung von x A ist also fA = sA = 2,2/ nA = 0,36

(Standardfehler),

x L = 28,4, sL = 4,3,

Standardfehler und t-Tests

Wir beobachten (nA = 39, nL = 38):

x A = 25,9, sA = 2,2, unser Schätzwert für die

√

Streung von x A ist also fA = sA = 2,2/ nA = 0,36

(Standardfehler),

x L = 28,4, sL = 4,3, unser Schätzwert für die Streung

√

von x L ist also fL = sL = 2,2/ nL = 0,70.

Standardfehler und t-Tests

Wir beobachten (nA = 39, nL = 38):

x A = 25,9, sA = 2,2, unser Schätzwert für die

√

Streung von x A ist also fA = sA = 2,2/ nA = 0,36

(Standardfehler),

x L = 28,4, sL = 4,3, unser Schätzwert für die Streung

√

von x L ist also fL = sL = 2,2/ nL = 0,70.

Ist die beobachtete Abweichung x L − x A = 2,5 mit

der Nullhypothese verträglich, dass µL = µA ?

Standardfehler und t-Tests

t-Statistik

Ist die beobachtete Abweichung x L − x A = 2,5 mit

der Nullhypothese verträglich, dass µL = µA ?

Standardfehler und t-Tests

t-Statistik

Ist die beobachtete Abweichung x L − x A = 2,5 mit

der Nullhypothese verträglich, dass µL = µA ?

Wir schätzen die Streuung von x L − x A durch f , wo

f 2 = fL2 + fA2

Standardfehler und t-Tests

t-Statistik

Ist die beobachtete Abweichung x L − x A = 2,5 mit

der Nullhypothese verträglich, dass µL = µA ?

Wir schätzen die Streuung von x L − x A durch f , wo

f 2 = fL2 + fA2

und bilden t =

xL − xA

.

f

Standardfehler und t-Tests

t-Statistik

Ist die beobachtete Abweichung x L − x A = 2,5 mit

der Nullhypothese verträglich, dass µL = µA ?

Wir schätzen die Streuung von x L − x A durch f , wo

f 2 = fL2 + fA2

xL − xA

.

f

Wenn die Nullhypothese zutrifft, ist t (approximativ)

Student-verteilt mit g Freiheitsgraden

und bilden t =

(wobei g aus den Daten geschätzt wird.)

Standardfehler und t-Tests

Theorem (Welch-t-Test, die Varianzen dürfen ungleich sein)

Seien X1 , . . . , Xn und Y1 , . . . , Ym unabhängige normalverteilte

Zufallsvariablen mit (möglicherweise verschiedenen) Varianzen

VarXi = σX2 und VarYi = σY2 . Seien sX und sY die aus den

Stichproben berechneten Standardabweichungen. Unter der

Nullhypothese gleicher Mittelwerten EXi = EYj ist die Statistik

X −Y

t=q 2

sX

s2

+ mY

n

ungefähr t-verteilt mit

2

sX

n

+

2

sY

m

2

s4

s4

X

+ 2 Y

n2 ·(n−1)

m ·(m−1)

Freiheitsgraden.

Standardfehler und t-Tests

Theorem (Welch-t-Test, die Varianzen dürfen ungleich sein)

Seien X1 , . . . , Xn und Y1 , . . . , Ym unabhängige normalverteilte

Zufallsvariablen mit (möglicherweise verschiedenen) Varianzen

VarXi = σX2 und VarYi = σY2 . Seien sX und sY die aus den

Stichproben berechneten Standardabweichungen. Unter der

Nullhypothese gleicher Mittelwerten EXi = EYj ist die Statistik

X −Y

t=q 2

sX

s2

+ mY

n

ungefähr t-verteilt mit

2

sX

n

+

2

sY

m

2

s4

s4

X

+ 2 Y

n2 ·(n−1)

m ·(m−1)

Freiheitsgraden.

(Diese Approximation für die Freiheitsgrade brauchen Sie sich

nicht zu merken. R übernimmt das für Sie.)

Standardfehler und t-Tests

Theorem (zwei-Stichproben t-Test, ungepaart mit gleichen

Varianzen)

Seien X1 , . . . , Xn und Y1 , . . . , Ym unabhängige normalverteilte

Zufallsvariablen mit der selben Varianz σ 2 . Als gepoolte

Stichprobenvarianz definieren wir

sp2 =

(n − 1) · sX2 + (m − 1) · sY2

.

m+n−2

Unter der Nullhypothese gleicher Erwartungswerte µX = µy folgt

die Statistik

X −Y

q

t=

sp · n1 + m1

einer t-Verteilung mit n + m − 2 mit Freiheitsgraden.

Chi-Quadrat-Tests

Übersicht

1

Deskriptive Statistik

2

Standardfehler und t-Tests

3

Chi-Quadrat-Tests

χ2 -Test für eine feste Verteilung

χ2 -Test auf Unabhängigkeit (oder Homogenität)

χ2 -Test für Modelle mit Parametern

4

Konfidenzintervalle

5

Lineare Regression

Lineare Zusammenhänge

t-Test fuer lineare Zusammenhänge

Überprüfen der Annahmen und Modellwahl

6

Varianzanalyse

7