UE Stochastische Prozesse - SS 2007 1 Markovketten mit diskreter

Werbung

UE Stochastische Prozesse - SS 2007

1

Markovketten mit diskreter Zeit

1. Man zeige

P (A ∩ B | C) = P (A | C) · P (B | A ∩ C)

beziehungsweise

P (X2 = i2 ; X1 = i1 |X0 = i0 ) = P (X1 = i1 |X0 = i0 ) · P (X2 = i2 |X0 = i0 , X1 = i1 ).

(1p)

2. N schwarze und N weiße Kugeln werden in zwei Urnen aufgeteilt, sodaß jede Urne N Kugeln

enthält. In jedem Schritt wird beiden Urnen je eine Kugel entnommen und die Kugeln werden

ausgetauscht. Der Zustand des Systems ist die Anzahl der weißen Kugeln in der ersten Urne.

Berechne die Übergangwahrscheinlichkeiten.

(1p)

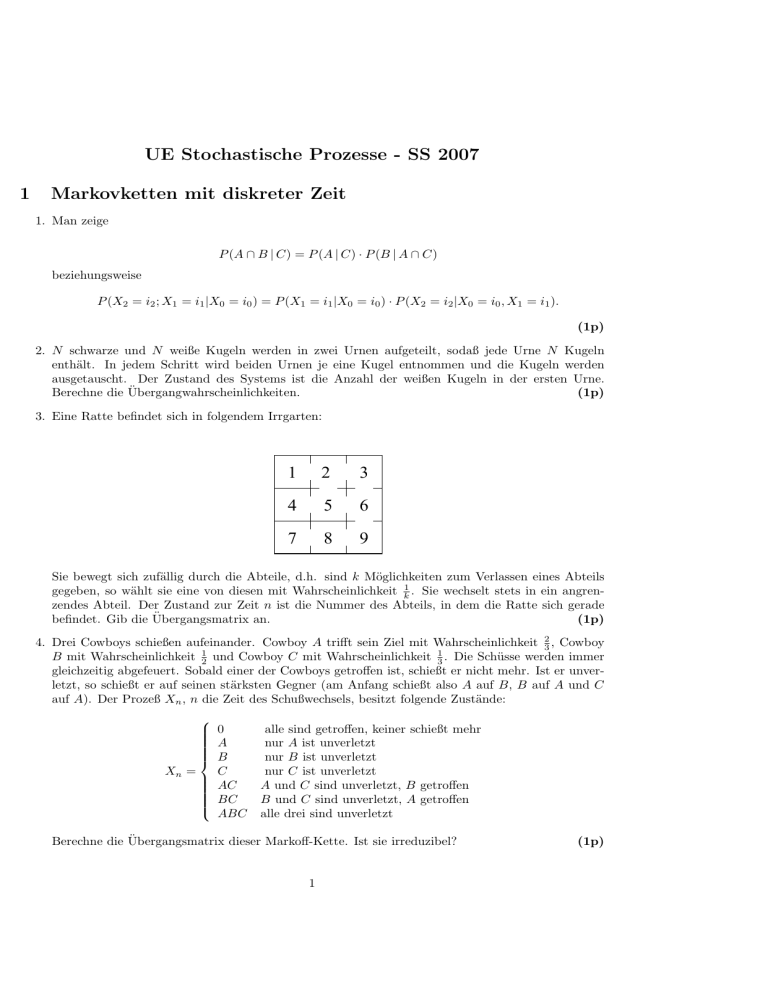

3. Eine Ratte befindet sich in folgendem Irrgarten:

1

2

3

4

5

6

7

8

9

Sie bewegt sich zufällig durch die Abteile, d.h. sind k Möglichkeiten zum Verlassen eines Abteils

gegeben, so wählt sie eine von diesen mit Wahrscheinlichkeit k1 . Sie wechselt stets in ein angrenzendes Abteil. Der Zustand zur Zeit n ist die Nummer des Abteils, in dem die Ratte sich gerade

befindet. Gib die Übergangsmatrix an.

(1p)

4. Drei Cowboys schießen aufeinander. Cowboy A trifft sein Ziel mit Wahrscheinlichkeit 23 , Cowboy

B mit Wahrscheinlichkeit 12 und Cowboy C mit Wahrscheinlichkeit 13 . Die Schüsse werden immer

gleichzeitig abgefeuert. Sobald einer der Cowboys getroffen ist, schießt er nicht mehr. Ist er unverletzt, so schießt er auf seinen stärksten Gegner (am Anfang schießt also A auf B, B auf A und C

auf A). Der Prozeß Xn , n die Zeit des Schußwechsels, besitzt folgende Zustände:

0

A

B

C

Xn =

AC

BC

ABC

alle sind getroffen, keiner schießt mehr

nur A ist unverletzt

nur B ist unverletzt

nur C ist unverletzt

A und C sind unverletzt, B getroffen

B und C sind unverletzt, A getroffen

alle drei sind unverletzt

Berechne die Übergangsmatrix dieser Markoff-Kette. Ist sie irreduzibel?

1

(1p)

5. Wie groß ist in Beispiel 3 die Wahrscheinlichkeit, daß der Kampf damit endet, daß A (bzw. B bzw.

C) allein übrig bleibt?

(1p)

6. In Beispiel 3 bildet die Zahl Yn der Unverletzten nach der n-ten Runde einen stochastischen Prozeß

Y = (Yn ). Ist Y eine Markoff-Kette?

(2p)

Anleitung: Berechne die Wahrscheinlichkeiten

P {Y4 = 0|Y3 = 2, Y2 = 3, Y1 = 3} und

P {Y4 = 0|Y3 = 2, Y2 = 2, Y1 = 3}

7. Es sei Yn das Maximum der ersten n Ausgänge einer Folge unabhängiger Würfelexperimente. (Yn ∈

{1, 2, 3, 4, 5, 6}.) Ist (Yn ) eine Markoff-Kette? Berechne die Übergangsmatrix P und deren Potenzen.

(1p)

8. Seien

1/2

P = 1/2

0

√

√

√

1/ 2

1√6

1/√3

,

U = 1/√3

√0 −2/√6

1/ 3 −1/ 2

1/ 6

1/2

0

0

1/2 ,

1/2 1/2

0

0

1/2

0 .

0 −1/2

1

D= 0

0

Zeige, dass P = U DU t und U t U = I gilt, wobei I die Einheitsmatrix ist und U t die Transponierte

von U bezeichnet. Verwende diese Ergebnisse, um die Potenzen von P zu berechnen.

(1p)

9. Man berechne die Asymptotik des folgenden Prozesses:

0.5

2

1

0.3

0.5

0.4

0.7

0.8

0.6

3

4

0.2

Dazu berechnet man den Grenzwert von

(1p)

P 2, P 4, P 6, . . .

und P, P 3 , P 5 , . . . .

10. Für zwei Wahrscheinlichkeitsvektoren µ = (µ1 , . . . , µn ) und ν = (ν1 , . . . , νn ) zeige man

kµ − νk1 = 2[1 −

n

X

min(µi , νi )],

i=1

wobei kµ − νk1 =

Pn

i=1

|µi − νi |.

(1p)

2

11. Für µ und ν wie in Beispiel 10 und Übergangsmatrix P zeige man die Kontraktionseigenschaft

kµP − νP k1 ≤ δ(P ) kµ − νk1 .

(1p)

Anleitung: Wenn µ und ν Einheitsvektoren ei bzw. ej sind, so gilt die Ungleichung nach Definition.

Mit mi = min(µi , νi ) und

2 (µi − mi ) (νj − mj )

γij =

kµ − νk1

gilt dann

µ−ν =

n

X

γij (ei − ej )

i,j=1

und

n

X

γij =

i,j=1

1

kµ − νk1 .

2

12. Man finde den Ergodizitätskoeffizient von

(1p)

0.3 0.1 0.6

P = 0.5 0.0 0.5 .

0.0 0.7 0.3

13. Sei

1

1/2

0

1/4

1

1/5

1/4

2

2/5

1

2/5

3

Sei a0 (i) = Pi (T 0 < ∞) die Absorptionswahrscheinlichkeit im Zustand 0, wenn im Zustand i gestartet wird.

3

Man berechne a0 (1), a0 (2)

(1p)

Anleitung: Die a0 (i) erfüllen folgende Gleichung:

1

4

+

1

2

a0 (1) +

1

4

a0 (2)

a0 (2) = 0 +

1

5

a0 (1) +

2

5

a0 (2)

a0 (1) =

14. Klassifiziere die Zustände des Markov-Prozesses mit der folgenden Übergangsmatrix:

0.8 0 0.2 0

0

0

1

0

.

1

0

0

0

0.3 0.4 0 0.3

Bestimme die Periode für rekurrente Zustände.

(1p)

15. Man berechne die stationäre Verteilung von

(1p)

1/2 1/2

0

1/2

P = 1/2 0

0 1/2 1/2

16. Gibt es eine Markovkette mit genau zwei verschiedenen stationären Verteilungen?

(1p)

17. Man berechne die stationäre Verteilung von

(1p)

1

p

0

p

1

1−p

2

p

3

1−p

1−p

1−p

18. Man zeige: Wenn

cj =

j

X

ck−1 cj−k

c0 = 1, c1 = 1

k=1

und

α(u) =

∞

X

cj uj

j=0

so ist

α2 (u) =

α(u) − 1

u

d.h.

α(u) =

1−

√

1 − 4u

.

2u

(1p)

4

19. Man betrachte eine Markovette mit Übergangsmatrix P gegeben durch

pi j = i + 1

ri

j=i

Pij =

qi j = i − 1

für i ≥ 1 und P01 = p0 , P00 = r0 .

P∞

i−1

. Dann gilt: Es existiert eine stationäre Verteilung genau dann, falls s < ∞

Sei s = 1+ i=1 p0q···p

1 ···qi

und in diesem Fall gilt

p0 ···pi−1 1

für i > 0

q1 ···qi · s

π(i) =

1

für i = 0

s

(2p)

20. Let τi (n) denote the times when the Markov chain Xn visits state ’i’ (assuming it started in state

’i’) i.e.

τi (1) := inf{m ≥ 1 : Xm = i} and τi (n + 1) := inf{m > τi (n) : Xm = i}.

Further let

α0 := 0,

α1 := τi (1), and αn+1 := τi (n + 1) − τi (n);

on events where they are well defined. Let B(N) denote the number of blocks that one can squeeze

into [0,N]) i.e.

B(N ) := sup{k ≥ 0 : τi (k) ≤ N }.

Notice that τi (B(N )) ≤ N ≤ τi (B(N ) + 1). Now using the fact that the sequence (ξn )n≥1 is i.i.d.

where ξn ’s are defined as

ξ1 = (α1 , X1 , . . . , Xτi (1) ) and ξn+1 = (αn+1 , Xτi (n)+1 , . . . , Xτi (n+1) )

show that τi (n)/n → Ei τi (1) and hence that N/B(N ) → Ei τi (1)

21. Let f : S → R where S is the state space of the Markov chain (Xn )n≥0 . Show that if this markov

chain is irreducible, positive recurrent, and has a unique stationary distribution, π then

lim

N →∞

N

X

f (Xn )/N = π(f ) :=

n=0

X

f (j)πj ,

j∈S

almost surely for any initial distribution.

Pτi (k+1)

Hint Apply the law of large numers to the sequence (ηk )k≥1 where ηk := n=τ

f (Xn ) and use

i (k)+1

Pτi (B(N ))

PN

Pτi (B(N )+1)

the facts that n=0

f (Xn ) ≤ n=0 f (Xn ) ≤ n=0

f (Xn ) and B(N )/N → 1/Ei τi (1) to

get the required result.

22. Für den Markov-Prozess mit der folgenden Übergangsmatrix:

1

0 0

0

0

0

0, 5 0 0, 5 0

0

0

0, 1 0 0, 5 0, 3

0

0, 1

0

0 0

0, 7 0, 1 0, 2

1/3 0 0 1/3 1/3 0

0

0 0

0

0

1

.

(a) Identifizieren Sie die kommunizierenden Klassen und klassifizieren Sie die Zustände des Prozesses.

5

(b) Bestimmen Sie die Periode für rekurrente Zustände.

23. For a Markov process with the transition matrix

0.25 0, 75

0, 75 0, 25

0

0

0

0

1

(a) Find a stationary distribution.

(b) Calculate mi = Ei τi (1), the expected return time to state ’i’ assuming the Markov chain

started in state ’i’ where i=1,2,3.

(c) Calculate limn→∞ P n

24. Does there exist a finite space Markov chain for which no stationary distribution exists?

2

Markovketten mit stetiger Zeit

25. Man berechne durch Induktion die Verteilungsfunktion der Erlang(λ, k) Verteilung:

P (T1 + . . . + Tk ≤ t) = 1 − e−λt

k−1

X

i=0

(tλ)i

i!

wobei Ti unabhängig identisch nach Exponential (λ) verteilt sind. Die Dichte der Erlang(λ, ki)

Verteilung ist

λk

e−λu uk−1 .

(k − 1)!

(1p)

26. Aus dem vorigen Beispiel Schliesse man: Die Anzahl der Ereignisse eines Poisson Prozesses im

Intervall [s, t] folgt einer Poissonverteilung

P (Π(t) − Π(s) = k) = e−λ(t−s)

(λ(t − s))k

.

k!

(1p)

27. Man zeige für exponentialverteilte T ∼ Exponential(λ), S ∼ Exponential(γ)

γ

P (min(T ; S) = S) = λ+γ

P (min(T ; S) = S| min(T, S) = u) =

γ

λ+γ

(1p)

28. Man berechne die stationäre Verteilung des Prozesses mit der Intensitätsmatrix

−9

6

3

2

Q = 4 −6

5

1 −6

(1p)

29. Zeige: Die Summe zweier unabhängiger Poisson-Prozesse mit Intensitäten λ und µ ist ein PoissonProzeß mit Intensität λ + µ.

(1p)

6

30. A spider climbs up an infinitely high wall. During day i, the spider climbs up Yi centimetres, where

the Yi are i.i.d. (independent, identically distributed random variables) with Poisson distribution

with parameter λ > 0. During the night, the spider slips back 1 centimetre. Let Xn be the net

height gained after n days and nights. Show that

P r(Xn = 0) =

e−nλ (nλ)n

n!

(1p)

31. Zeige: Löscht man in einem Poissonprozess (Intensität λ) jedes Ereignis mit der Wahrscheinlichkeit

p, so entsteht ein Poissonprozess mit Intensität (1 − p)λ.

Was ist der Unterschied im Ergebnis zwischen der zufälligen Löschung mit Wahrscheinlichkeit 0.5

und der systematischen Löschung jedes zweiten Ereignisses ?

(1,5 p)

32. Die eingebettete Markovkette: Wenn man in einer Markovkette mit stetiger Zeit nur die Sprünge,

nicht aber die Verweildauern betrachtet, so entsteht die ”eingebettete Markovkette” mit der Übergangsmatrix

qij

i 6= j

−qii

S = (sij ) =

0

i=j

Sei π die stationäre Verteilung der ursprünglichen Kette und ν jene der eingebetteten Kette, so gilt:

νi = c(−qii )πi

für eine Konstante c.

(1p)

33. Das Auftreten von Erdbeben in der Stadt A werde durch einen Poisson-Prozeß mit λ = 2 beschrieben.

Der Schaden, den ein Erdbeben jeweils anrichtet, sei exponential verteilt mit Parameter µ = 10−5

(Zeiteinheit 1 Jahr, Geldeinheit 1 Euro). Berechne den mittleren Schaden pro Jahrzehnt.

(1p)

34. In an office telephone messages arrive according to a Poisson process at the mean rate of six per

hour and fax messages at three per hour.

(a) Find the probability that exactly two messages (phone or fax) are received between 9.00 and

9.40.

(b) Find the probability that the first message after 10.00 occurs before 10.10.

35. Customers arrive at a bank according to a Poisson process at a mean rate of λ = 10 per minute. A

proportion 0.6 wish to draw out money (type A), 0.3 wish to pay in money (type B) and 0.1 wish

to do something else (type C).

(a) If twenty customers arrive in two minutes, what is the probability that just one is of type C?

(b) How amount of time must elapse before at least one customer each of type A and B will have

arrived with a probability of 0.9.?

3

Der Wiener Prozess

36. Man zeige: Ist W (t) ein Wiener Prozess, so ist

1

W2 (t) = tW ( )

t

ebenfalls ein Wiener Prozess.

7

37. Man zeige: Ist W (t) ein Wiener Prozess, so ist

W1 (t) = W (1 − t) − W (1)

für 0 ≤ t ≤ 1 ebenfalls ein Wiener Prozess.

38. Man finde die Momente der Brownschen Brücke:

W0 (t) = W (t) − tW (1).

8