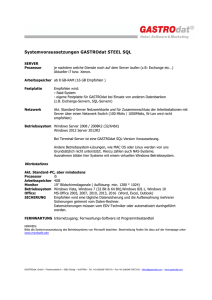

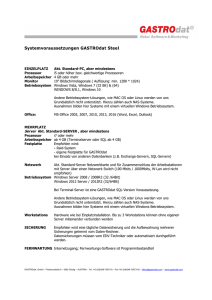

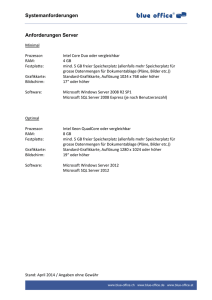

Hardware (PC)

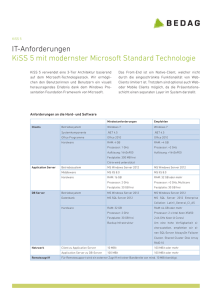

Werbung