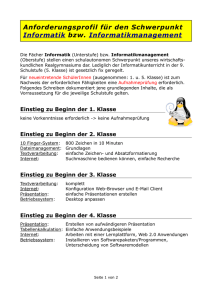

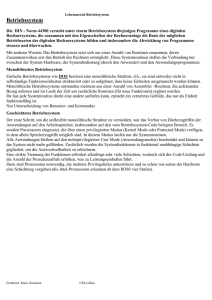

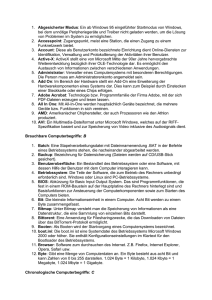

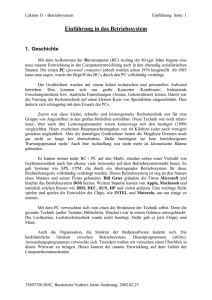

Betriebssysteme Überblick und Einordnung Die Hardware eines

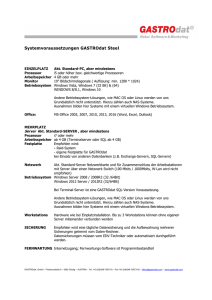

Werbung