Themen - Downloads für den Studiengang WI

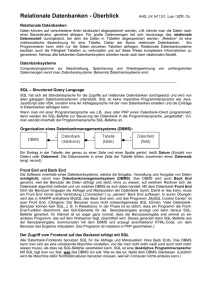

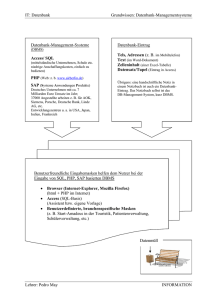

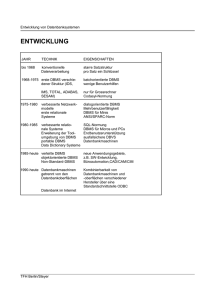

Werbung