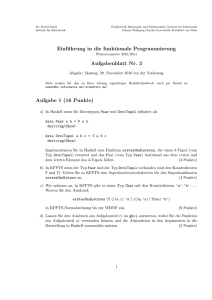

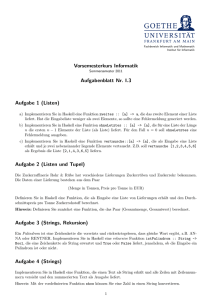

Einführung in die Funktionale Programmierung - Goethe

Werbung