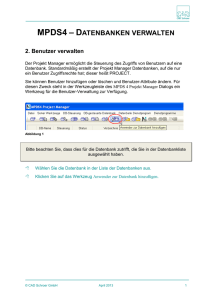

Kapitel 5 Das System IDEE

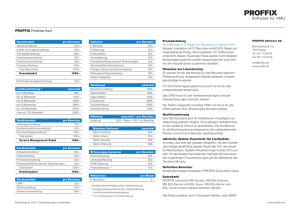

Werbung