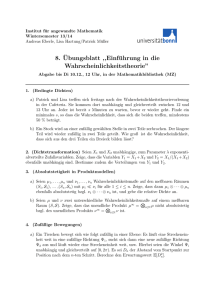

5 Die Poisson-Approximation

Werbung

5

Die Poisson-Approximation

Im vierten Kapitel hatten wir mit der Normalverteilung die sicherlich wichtigste und

meiststudierte Verteilung der W.-Theorie kennengelernt und gesehen, daß man diese als

Limes eine geeignet skalierten Binomialverteilung erhalten kann. In diesem Kapitel werden wir eine weitere zentrale Verteilung kennenlernen, die sich ebenfalls als Limes einer

(natürlich anders skalierten) Binomialverteilung schreiben läßt.

Wir wollen diese Verteilung an einem Beispiel kennenlernen.

Das Experiment von Rutherford und Geiger

In einem bekannten Experiment beobachteten die Physiker Rutherford und Geiger den

Zerfall einer radioaktiven Substanz. Genauer studierten sie die Emission von α-Teilchen

eines radioaktiven Präparates in n = 2608 Zeitabschnitten von 7.5 Sekunden. Die folgende

Tabelle gibt die Versuchsergebnisse wieder. Hierbei steht ni für jedes natürliche i für die

Anzahl der Zeitabschnitte, in denen genau i α-Teilchen emittiert wurden, ri bezeichnet

die relativen Häufigkeiten dieser Zeitabschnitte.

i

0

1

2

3

4

5

6

7

8

9

10

11

12

13

14

ni

57

203

383

525

532

408

273

139

45

27

10

4

0

1

1

ri

0.02186

0.0778

0.1469

0.2013

0.2040

0.1564

0.1047

0.0533

0.0173

0.0103

0.0038

0.0015

0

0.0004

0.0004

Offensichtlich sind diese Daten weit davon entfernt von einer Normalverteilung zu stammen. Wir benötigen vielmehr eine Verteilung, die die ”Enden”, d.h. die großen Zahlen

mit einem sehr viel kleineren Gewicht versieht. Eine solche Verteilung ist die PoissonVerteilung.

(5.1) Definition. Sei λ > 0 eine reelle Zahl. Eine Zufallsgröße X mit X(Ω) = N0 und

der Verteilung πλ gegeben durch

πλ (k) =

e−λ k

λ ,

k!

heißt Poisson-verteilt mit Parameter λ > 0.

51

k ∈ N0 ,

Zunächst bemerken wir, daß die Poisson-Verteilung auf den natürlichen Zahlen, incl. der

Null N0 konzentriert ist. Desweiteren überzeugt man sich rasch, daß

∞

X

−λ

πλ (k) = e

k=0

∞

X

λk

k=0

k!

= e−λ eλ = 1

ist. πλ ist also tatsächlich eine Wahrscheinlichkeit.

Der Erwartungswert dieser Verteilung ist leicht zu berechnen:

∞

X

−λ

kπλ (k) = e

k=0

∞

∞

∞

X

X

X

λk

λk−1

λk

−λ

−λ

k

=e λ

=e λ

= e−λ λe+λ = λ.

k!

(k − 1)!

k!

k=1

k=0

k=0

Eine Poisson-verteilte Zufallsgröße hat also Erwartungswert λ.

Als nächstes wollen wir die Varianz ausrechnen:

2

E(X ) =

∞

X

2

−λ

k πλ (k) = e

k=0

= e−λ

∞

X

k=1

∞

X

k=1

(k(k − 1) + k)

k2

λk

k!

∞

X

λk+2

λk

= e−λ

+ λ = λ2 + λ.

k!

k!

k=0

Somit gilt

V (X) = E(X 2 ) − (EX)2 = λ2 + λ − λ2 = λ.

Wir fassen diese beiden Feststellungen noch einmal in folgendem Lemma zusammen.

(5.2) Lemma. Erwartungswert und Varianz einer Poisson-verteilten Zufallsgröße sind

gleich dem Parameter λ.

Wir wollen nun einmal die eingangs gezeigten Daten aus Rutherford’s Experiment mit denen einer Poissonverteilung vergleichen. Dabei stellt sich die Frage, wie wir den Parameter

λ am geschicktesten wählen. Vor dem Hintergrund des Gesetzes der großen Zahlen, nach

dem man eine mittlere Zahl emittierter Teilchen erwarten kann, die nahe am Erwartungswert liegt und Lemma (5.2) ist eine gute Wahl die, λ als die durchschnittliche Anzahl der

Emissionen zu wählen. Diese betrug im Experiment von Rutherford und Geiger

a=

10097

∼ 3.87.

2608

Die nächste Tabelle zeigt den Vergleich der relativen Häufigkeiten rk aus dem Experiment

von Rutherford und Geiger mit den Wahrscheinlichkeiten πλ (k) einer Poissonverteilung

zum Parameter λ = 3.87.

52

k

0

1

2

3

4

5

6

7

8

9

10

11

12

13

14

rk

0.0219

0.0778

0.1469

0.2013

0.2040

0.1564

0.1047

0.0533

0.0173

0.0103

0.0038

0.0015

0

0.0004

0.0004

πλ (k)

0.0208

0.0807

0.1561

0.2015

0.1949

0.1509

0.0973

0.0538

0.0260

0.0112

0.0043

0.0015

0.0005

0.0002

4 ×10−5

Die beobachteten relativen Häufigkeiten differieren also von den durch die entsprechende

Poisson-Verteilung vorhergesagten Werten nur um wenige Tausendstel. Warum dies ein

plausibles Ergebnis ist, soll am Ende dieses Kapitels in einem Satz geklärt werden, der

zeigen wird, daß viele Prozesse, die einer Reihe von Anforderungen genügen, eine PoissonApproximation erlauben. Grundlage dieses Satzes ist eine Festellung darüber, wie genau

sich die Binomialverteilung b(·; n, p) für kleine Parameter p und große n durch die Poissonverteilung πλ (k) approximieren läßt. Wieder bleibt das Problem, λ zu wählen. Wir

lösen es so, daß wir λ so bestimmen, daß die Erwartungswerte der Binomialverteilung

und der Poissonverteilung übereinstimmen, daß also λ = np ist. Wir wollen also zeigen:

b(k; n, p) liegt nahe bei πλ (k) für λ = np.

Um das zu präzisieren, benötigen wir ein Maß für den Abstand zweier Wahrscheinlichkeiten. Dies wird in unserem Fall gegeben sein durch

∆(n, p) :=

∞

X

k=0

|b(k; n, p) − πnp (k)|.

∆(n, p) läßt sich ähnlich auf für den Abstand beliebiger anderer Wahrscheinlichkeiten

definieren und heißt Abstand der totalen Variation.

Wir zeigen das folgende Resultat, das sogar noch wesentlich weitreichender ist als unser

oben gestecktes Ziel:

(5.3) Satz. Es seien X1 , . . . , Xn unabhängige Zufallsvariablen, definiert auf einem gemeinsamen Wahrscheinlichkeitsraum, mit P (Xi = 1) = pi und P (Xi = 0) = 1 − pi mit

0 < pi < 1 für alle i = 1, . . . , n. Sei X = X1 + · · · + Xn und λ = p1 + · · · + pn , dann gilt:

∞

X

k=0

|P (X = k) − πλ (k)| ≤ 2

Es folgt also im Fall p = p1 = · · · = pn :

53

n

X

i=1

p2i .

(5.4) Satz. Für alle n ∈ N und p ∈ (0, 1) gilt ∆(n, p) ≤ 2np2 .

P

Die Schranken in den Sätzen (5.3) und (5.4) sind natürlich nur interessant, falls ni=1 p2i

klein wird bzw. p2 klein wird gegen n. Offenbar benötigt man in Satz (5.4) dazu mindestens

p ≪ √1n , d.h. die Wahrscheinlichkeit eines Einzelerfolges wird klein mit n. Aus diesem

Grund heißt die Poisson-Verteilung auch Verteilung seltener Ereignisse. Insbesondere folgt

der sogenannte Poissonsche Grenzwertsatz, der von Siméon Denis Poisson (1781-1840) im

Jahre 1832 entdeckt wurde:

(5.5) Satz. (Grenzwertsatz von Poisson) Ist λ > 0 und gilt npn → λ > 0 für n → ∞, so

gilt für jedes k ∈ N0 :

lim b(k; n, pn ) = πλ (k).

n→∞

(5.5) folgt sofort aus (5.4): Aus npn → λ folgt pn → 0 für n → ∞ und np2n → 0. Ferner

ist |b(k; n, p) − πnp (k)| ≤ ∆(n, p) für jedes k ∈ N0 . Demzufolge gilt

lim |b(k; n, pn ) − πnpn (k)| = 0.

n→∞

Wegen πnpn (k) → πλ (k) folgt (5.5).

Offenbar unterscheidet sich (5.4) von (5.5) dadurch, daß die Aussage von (5.4) auch im

Fall, wo np2n → 0, npn → ∞ gilt, von Interesse ist (z.B. pn = 1/n2/3 ). Der wichtigste

Vorzug von (5.3) und (5.4) im Vergleich zu (5.5) ist jedoch, daß eine ganz konkrete Approximationsschranke vorliegt. Dafür ist Satz (5.3) auch schwieriger zu beweisen als (5.5)

(den wir hier allerdings nur als Korollar aus Satz (5.4) ableiten wollen).

Bevor wir den Beweis von Satz (5.3) geben, stellen wir einen wichtigen Aspekt der Poissonverteilung bereit:

(5.6) Proposition. X und Y seien unabhängig und Poisson-verteilt mit Parametern λ

beziehungsweise µ > 0. Dann ist X + Y Poisson-verteilt mit Parameter λ + µ.

Beweis. Für n ∈ N0 gilt:

P (X + Y = n) =

n

X

k=0

=

n

X

k=0

P (X = k, Y = n − k)

P (X = k)P (Y = n − k) (Unabhängigkeit)

n n

X

λk µn−k −λ −µ

1 X n k n−k −(λ+µ)

e

λ µ

=

e e =

k! (n − k)!

n! k=0 k

k=0

=

1

(λ + µ)n e−(λ+µ) = πλ+µ (n).

n!

2

54

(5.7) Bemerkung. Per Induktion folgt sofort, daß die Summe von endlich vielen unabhängigen Poisson-verteilten Zufallsgrößen wieder Poisson-verteilt ist, wobei der Parameter sich als Summe der Einzelparameter ergibt.

Beweis von Satz 5.3.

Der Beweis des Satzes (5.3) verwendet eine Technik, die man Kopplung (coupling) nennt.

Dabei

P∞ verwenden wir wesentlich, daß bei der Berechnung des Abstands

k=0 |P (X = k) − πλ (k)| die Größen P (X = k) bzw. πλ (k) zwar die Verteilungen von

Zufallsvariablen sind, daß aber in die Berechnung der zugrunde liegende W.-Raum nicht

eingeht. Wir können also einen W.-Raum und Zufallsvariablen mit den gegebenen Verteilungen so wählen, daß sie für unsere Zwecke besonders geeignet sind und das bedeutet,

daß sie sich bei gegebener Verteilung möglichst wenig unterscheiden. Konkret konstruieren

wir:

−p

Sei Ωi = {−1,

Pi (0) = 1 − pi und Pi (k) = e k! i pki für k ≥ 1 sowie Pi (−1) =

P 0, 1, 2, . . .}, −p

1−Pi (0)− k≥1 Pi (k) = e i −(1−pi ). Nach Konstruktion sind somit (Ωi , Pi ) W.-Räume.

Betrachte dann den Produktraum (Ω, P ) der (Ωi , Pi ) im Sinne der Definition (2.13). Wir

setzen für ω ∈ Ω

0, falls ωi = 0,

Xi (ω) :=

1, sonst,

und

Yi (ω) :=

k, falls ωi = k, k ≥ 1,

0, sonst.

Dann haben nach Definition die Zufallsgrößen Xi die geforderte Verteilung: P (Xi = 1) =

pi und P (Xi = 0) = 1−pi . Sie sind weiter nach Definition des Produktraumes unabhängig.

Die Yi sind nach Definition Poisson-verteilt zum Parameter pi und ebenfalls unabhängig.

Also folgt mit Proposition (5.6), daß Y = Y1 + · · · + Yn Poisson-verteilt ist zum Parameter

λ. Nun stimmen die Zufallsgrößen in den Werten 0 und 1 überein, und es ist P (Xi =

Yi ) = Pi (0) + Pi (1) = (1 − pi ) + e−pi pi , und somit

P (Xi 6= Yi ) = pi (1 − e−pi ) ≤ p2i ,

denn für x > 0 gilt 1 − e−x ≤ x. Damit folgt

∞

X

k=0

=

≤

∞

X

k=0

∞

X

k=0

|P (X = k) − πλ (k)| =

∞

X

k=0

|P (X = k) − P (Y = k)|

|P (X = k = Y ) + P (X = k 6= Y ) − (P (X = k = Y ) + P (X 6= k = Y ))|

P (X = k 6= Y ) + P (X 6= k = Y )

= 2P (X 6= Y ) ≤ 2

n

X

i=1

P (Xi 6= Yi) ≤ 2

Das beweist Satz (5.3).

n

X

p2i .

i=1

2

55

Nun können wir auch klären, warum die Ergebnisse im Experiment von Rutherford und

Geiger so erstaunlich nahe an den Vorhersagen einer Poisson–Verteilung lagen. Dies geschieht im Rahmen des sogenannten Poissonschen Punktprozesses.

Der Poissonsche Punktprozeß (Poisson point process)

Wir konstruieren ein mathematisches Modell für auf einer Zeitachse zufällig eintretende

Vorkommnisse. Beispiele sind etwa: Ankommende Anrufe in einer Telefonzentrale, Registrierung radioaktiver Teilchen in einem Geigerzähler, Impulse in einer Nervenfaser etc.

Die Zeitachse sei (0, ∞), und die ,,Vorkommnisse“ seien einfach zufällige Punkte auf dieser

Achse. Die Konstruktion eines unterliegenden Wahrscheinlichkeitsraumes ist leider etwas

aufwendig und soll hier einfach weggelassen werden (wir glauben hier einfach mal, daß

man das kann).

Ist I = (t, t + s] ein halboffenes Intervall, so bezeichnen wir mit NI die zufällige Anzahl

der Punkte in I. NI ist also eine Zufallsgröße mit Werten in N0 . Statt N(0,t] schreiben wir

auch einfach Nt .

0

zufällige Punkte

An unser Modell stellen wir eine Anzahl von Bedingungen (P1) bis (P5), die für Anwendungen oft nur teilweise realistisch sind.

(P1) Die Verteilung von NI hängt nur von der Länge des Intervalls I ab. Anders ausgedrückt: Haben die beiden Intervalle I, I ′ dieselbe Länge, so haben die Zufallsgrößen

NI und NI ′ dieselbe Verteilung. Man bezeichnet das auch als (zeitliche) Homogenität

des Punktprozesses.

(P2) Sind I1 , I2 , . . . , Ik paarweise disjunkte Intervalle, so sind NI1 , NI2 , . . . , NIk unabhängige Zufallsgrößen.

(P3) Für alle I (stets mit endlicher Länge) existiert ENI . Um Trivialitäten zu vermeiden,

fordern wir:

(P4) Es existiert ein Intervall I mit P (NI > 0) > 0.

Aus (P1), (P3), (P4) lassen sich schon einige Schlüsse ziehen: Sei

λ(t) = ENt ≥ 0.

Offensichtlich gilt λ(0) = 0, denn N0 setzen wir natürlich 0. Die Anzahl der Punkte in

einer Vereinigung disjunkter Intervalle ist natürlich die Summe für die Einzelintervalle.

Insbesondere gilt:

Nt+s = Nt + N(t,t+s] .

Demzufolge:

λ(t + s) = λ(t) + EN(t,t+s] ,

56

was wegen (P1)

= λ(t) + λ(s)

ist.

Nach einem Satz aus der Analysis, der hier nicht bewiesen werden soll, muß eine derartige

Funktion linear sein, das heißt, es existiert λ ≥ 0 mit λ(s) = λs. λ = 0 können wir wegen

(P4) sofort ausschließen. In diesem Fall müßte nach (P1) ENI = 0 für jedes Intervall

gelten. Dies widerspricht offensichtlich (P4).

Für kleine Intervalle ist die Wahrscheinlichkeit dafür, daß überhaupt ein Punkt in diesem

Intervall liegt, klein. Es gilt nämlich:

P (NI ≥ 1) =

∞

X

k=1

P (NI = k) ≤

∞

X

kP (NI = k) = ENI

k=1

und demzufolge

P (N(t,t+ε] ≥ 1) ≤ λε für alle t, ε ≥ 0.

Unsere letzte Forderung besagt im wesentlichen, daß sich je zwei Punkte separieren lassen,

es also keine Mehrfachpunkte gibt. Dazu sei für T > 0

DT (ω) := inf {|t − s| : |Nt − Ns | ≥ 1}

t,s≤T

dann besagt unsere Forderung (P5):

(P5) P (DT ≤ αn ) −→ 0

n→∞

für jede Nullfolge αn und jedes endliche T .

Natürlich haben wir in keiner Weise belegt, daß eine Familie von Zufallsgrößen NI mit

den Eigenschaften (P1)–(P5) als mathematisches Objekt existiert. Wir können dies im

Rahmen dieser Vorlesung nicht tun. Wir können jedoch nachweisen, daß für einen Punktprozeß, der (P1) bis (P5) erfüllt, die NI alle Poisson-verteilt sein müssen:

(5.8) Satz. Sind (P1) bis (P5) erfüllt, so sind für alle t, s ≥ 0 die Zufallsgrößen N(t,t+s]

Poisson-verteilt mit Parameter λs.

Beweis. Wegen (P1) genügt es, Ns = N(0,s] zu betrachten. Wir halten s > 0 fest. Für

k ∈ N, 1 ≤ j ≤ k, definieren wir

(k)

Xj

(k)

X̄j

(k)

Für jedes feste k sind die Xj

:= N(s(j−1)/k,sj/k]

(

(k)

1, falls Xj ≥ 1,

:=

(k)

0, falls Xj = 0.

(k)

nach (P2) unabhängig und die X̄j

damit ebenfalls.

Wir stellen einige einfach zu verifizierende Eigenschaften dieser Zufallsgrößen zusammen:

k

X

(k)

Ns =

Xj .

j=1

57

(k)

Sei N̄s

:=

Pk

(k)

j=1 X̄j .

Dann gilt für jede mögliche Konfiguration der Punkte:

N̄s(k) ≤ Ns .

Demzufolge gilt für jedes m ∈ N:

P (N̄s(k) ≥ m) ≤ P (Ns ≥ m).

(k)

Sei pk = P (X̄i

(k)

= 1) = P (Xi

N̄s(k)

(5.1)

≥ 1) = P (Ns/k ≥ 1).

ist binomialverteilt mit Parameterk, pk .

(5.2)

(k)

Wir verwenden nun (P5), um nachzuweisen, daß sich für große k N̄s nur wenig von Ns

(k)

unterscheidet. In der Tat bedeutet ja N̄s 6= Ns , daß es mindestens ein Intervall der Länge

1/k gibt, in dem 2 Punkte liegen, also

{N̄s(k) 6= Ns } ⊆ {Ds ≤ 1/k}.

Wegen (P5) folgt

P (N̄s(k) 6= Ns ) ≤ P (Ds ≤ 1/k) → 0

(5.3)

für k → ∞. Für m ∈ N und k ∈ N gilt:

P (N̄s(k)

P (N̄s(k)

P (N̄s(k)

P (N̄s(k)

P (Ns = m) ≥

≥

P (Ns = m) ≤

≤

= m, N̄s(k) = Ns )

= m) − P (N̄s(k) 6= Ns )

= m, N̄s(k) = Ns ) + P (N̄s(k) 6= Ns )

= m) + P (N̄s(k) 6= Ns ).

Unter Benutzung von (5.2) und (5.3) folgt:

P (Ns = m) = lim P (N̄s(k) = m) = lim b(m; k, pk )

(5.4)

P (Ns ≥ m) = lim P (N̄s(k) ≥ m).

(5.5)

lim kpk = λs.

(5.6)

k→∞

k→∞

und analog

k→∞

Wir zeigen nun:

k→∞

kpk =

E N̄s(k)

=

∞

X

jP (N̄s(k)

= j) =

j=1

∞

X

l=1

P (N̄s(k) ≥ l).

(k)

P (N̄s ≥ l) ist nach (5.1) nicht größer als P (Ns ≥ l) und strebt nach (5.5) für k → ∞

gegen diese obere Grenze. Nach einem Satz über reelle Zahlenfolgen (falls nicht bekannt

oder vergessen: Übungsaufgabe!) folgt daraus

lim kpk = lim

k→∞

k→∞

∞

X

l=1

P (N̄s(k)

≥ l) =

∞

X

l=1

P (Ns ≥ l) = ENs = λs.

Damit ist (5.6) gezeigt. Unser Satz folgt nun aus (5.4), (5.6) und dem Satz (5.5).

58

2