Algorithmen und Datenstrukturen

Werbung

Algorithmen und Datenstrukturen

Dr. Beatrice Amrhein

5. Januar 2016

ii

Zur umfassenden Ausbildung eines Software-Ingenieurs gehören grundlegende Kenntnisse der wichtigsten Datenstrukturen und wie man diese verarbeitet (Algorithmen). Das Kennen von geeigneten Datenstrukturen hilft dem Programmierer, die Informationen richtig zu organisieren und besser strukturierte

Programme zu schreiben.

Lerninhalte

-

Abstrakte Datentypen, Spezifikation

Komplexität von Algorithmen,

Algorithmen-Schemata: Greedy, Iteration, Rekursion

Wichtige Datenstrukturen: Listen, Stacks, Queues, Bäume, Heaps

Suchen und Sortieren, Hash-Tabellen

Endliche Automaten, reguläre Sprachen, Pattern Matching

Kontextfreie Grammatiken, Parser

Lernziele

Die Studierenden kennen die wichtigsten Datenstrukturen mit ihren Methoden. Sie kennen die klassischen Algorithmen und können sie anwenden. Ausserdem kn̈nen sie Komplexitätsabschätzungen von

Algorithmen vornehmen.

Informationen zum Unterricht

Grundlage ist ein Skript, das die wichtigsten Lerninhalte umfasst.

Unterrichtssprache: Deutsch (Fachliteratur zum Teil in Englisch)

Umfang: 12 halbtägige Blöcke à 4 Lektionen

Dozentin: Beatrice Amrhein,

Empfohlene Literatur:

- Reinhard Schiedermeier Programmieren mit Java, Eine methodische Einführung. Pearson Studium ISBN 3-8273-7116-3.

- Robert Sedgewick Algorithms in Java. Addison-Wesley Professional; 2002 ISBN 978-0-20136120-9

- M. T. Goodrich & R. Tamassia Algorithm Design: Foundations, Analysis, and Internet Examples.

John Wiley & Sons, Inc.

ISBN: 0-471-38365-1.

- Gunter Saake, Kay-Uwe Sattler Algorithmen und Datenstrukturen, Eine Einführung mit Java.

dpunkt, 2004. ISBN 3-89864-255-0.

Inhaltsverzeichnis

1

Einführung

1-1

1.1 Die wichtigsten Ziele dieses Kurses . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1-1

1.2 Einige Begriffe: Datenstrukturen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1-2

1.3 Einige Begriffe: Algorithmen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1-9

1.4 Algorithmen Schema: Iteration . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1-12

1.5 Algorithmen Schema: Greedy (die gierige Methode) . . . . . . . . . . . . . . . . . . . . 1-12

1.6 Algorithmen Schema: Rekursion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1-15

1.7 Übung 1

2

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1-20

Komplexität von Algorithmen

2.1 Komplexitätstheorie

3

2-1

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2-1

2.2 Komplexitätsanalyse . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2-2

2.3 Asymptotische Komplexität . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2-5

2.4 Übung 2

2-9

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Datentypen: Listen, Stacks und Queues

3-1

3.1 Array Listen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3-1

3.2 Doppelt verkettete Listen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3-5

3.3 Stacks und Queues

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3-11

3.4 Iteratoren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3-13

3.5 Übung 3

4

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3-14

Datentypen: Bäume, Heaps

4-1

4.1 Baumdurchläufe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4-4

4.2 Binäre Suchbäume . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4-8

4.3 B-Bäume . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-10

4.4 Priority Queues . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-15

4.5 Übung 4

5

6

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4-21

Suchen

5-1

5.1 Grundlagen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5-1

5.2 Lineare Suche . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5-2

5.3 Binäre Suche . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5-3

5.4 Hashing . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5-5

5.5 Übung 5

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5-14

Sortieren

6-1

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6-2

6.2 Insertion Sort . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6-4

6.3 Divide-and-Conquer Sortieren . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6-5

6.4 Quicksort . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6-6

6.1 Selection Sort

iv

Inhaltsverzeichnis

6.5 Sortieren durch Mischen (Merge Sort) . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.6 Übung 6

7

Pattern Matching

7-1

7.1 Beschreiben von Pattern, Reguläre Ausdrücke

. . . . . . . . . . . . . . . . . . . . . .

7-1

7.2 Endliche Automaten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7-3

7.3 Automaten zu regulären Ausdrücken . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7-7

7.4 Übung 7

8

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7-10

Top Down Parser

8.1 Kontextfreie Grammatik

8-1

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8-2

8.2 Top-Down Parser . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8-7

8.3 Übung 8

9

6-9

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6-12

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8-14

Kryptologie

9-1

9.1 Grundlagen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9-2

9.2 Einfache Verschlüsselungmethoden . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9-3

9.3 Vernamchiffre, One Time Pad . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9-5

9.4 Moderne symmetrische Verfahren . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9-6

9.5 Asymmetrische Verfahren: Public Key Kryptosysteme . . . . . . . . . . . . . . . . . . .

9-7

9.6 Übung 9

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9-12

1

Einführung

1.1 Die wichtigsten Ziele dieses Kurses

Die wichtigsten Ziele des Algorithmen und Datenstrukturen Kurses sind:

• Die Studierenden kennen die wichtigsten Datenstrukturen, können damit arbeiten, und kennen deren

Vor- und Nachteile sowie deren Anwendungsgebiete.

• Die Studierenden erhalten die Grundlagen, um während der Design Phase die richtigen Datenstrukturen auszuwählen und dann richtig einzusetzen.

• Die Studierenden kennen die wichtigsten Komplexitätsklassen und deren Einfluss auf das Laufzeitverhalten eines Systems.

• Die Studierenden kennen die klassischen Algorithmen und können diese anwenden. Sie kennen

deren Einsatzgebiete (wann soll welcher Algorithmus benutzt werden) und kennen die Komplexität

dieser Algorithmen (in Abhängigkeit der darunterliegenden Datenstrukturen).

• Die Studierenden erhalten einen Überblick über verschiedene Vorgehensweisen bei Problemlösungen und kennen deren Stärken und Schwächen.

1-2

1 Einführung

1.2 Einige Begriffe: Datenstrukturen

Definition: Daten sind Information, welche (maschinen-) lesbar und bearbeitbar sind und in einem Bedeutungskontext stehen. Die Information wird dazu in Zeichen oder Zeichenketten codiert. Die Codierung

erfolgt gemäss klarer Regeln, der sogenannten Syntax.

Daten sind darum Informationen mit folgenden Eigenschaften:

1. Die Bezeichnung erklärt den semantischen Teil (die Bedeutung) des Datenobjekts.

2. Die Wertemenge bestimmt die Syntax (die Form oder Codier-Regel) des Datenobjekts.

3. Der Speicherplatz lokalisiert das Datenobjekts im Speicher und identifiziert dieses eindeutig.

Definition: Ein Datentyp ist eine (endliche) Menge (der Wertebereich des Typs) zusammen mit einer

Anzahl Operationen.

Der Wertebereich eines Datentyps bestimmt, was für Werte ein Objekt dieses Typs annehmen kann. Die

Elemente des Wertebereichs bezeichnet man auch als Konstanten des Datentyps.

Dazu gehören die Methoden oder Operatoren, welche auf dem Wertebereich definiert sind und somit

auf Objekte dieses Typs angewandt werden können.

Beispiel:

Der Wertebereich des Datentyps int besteht aus

Auf diesem Datentyp gibt es die Operationen

Es ist wichtig, dass wir zwischen der (abstrakten) Beschreibung eines Datentyps (Spezifikation) und

dessen Implementierung unterscheiden. Wenn wir komplizierte Probleme lösen wollen, müssen wir von

den Details abstrahieren können. Wir wollen nicht wissen (müssen) wie genau ein Datentyp implementiert

ist, sondern bloss, wie wir den Datentyp verwenden können (welche Dienste er anbietet).

1.2 Einige Begriffe: Datenstrukturen

1-3

Jedes Objekt besitzt einen Datentyp, der bestimmt, welche Werte dieses Objekt annehmen kann und welche Operationen auf diesen Werten erlaubt sind. In allen Programmiersprachen gibt es nun Variablen,

welche diese Objekte repräsentieren können. Es stellt sich nun die Frage, ob auch den Variablen zwingend ein Datentyp zugewiesen werden soll. Diese Frage wird in verschiedenen Programmiersprachen

unterschiedlich beantwortet.

In untypisierten Sprachen wird den Variablen keinen Datentyp zugeordnet. Das heisst, jede Variable

kann Objekte von einem beliebigen Typ repräsentieren. Die Programmiersprachen Smalltalk und Lisp

sind typische Repräsentanten dieser Philosophie.

In untypisierten Sprachen kann der Compiler keine sogenannten Typentests durchführen. Zur Kompilationszeit sind alle Operationen auf allen Variablen möglich. Es wird also zur Compilationszeit nicht

nachgeprüft, ob gewisse Operationen überhaupt erlaubt sind. Unerlaubte Operationen führen zu Laufzeitfehlern.

In typisierten Sprachen wird allen Variablen ein Datentyp zugeordnet. Entweder müssen alle Variablen

deklariert werden, wie in den Sprachen Pascal, C, C++ oder Eiffel, oder der Datentyp wird aus der Notation der Variablen klar wie etwa in der Sprache Fortran oder Basic (in Basic sind Variablen, welche mit

dem Zeichen % enden, vom Typ Integer).

In einer typisierten Sprache kann schon der Compiler entscheiden, ob die angegebenen Operationen

typkorrekt sind oder nicht.

Als atomare Typen bezeichnen wir Datentypen, die in einer Sprache schon vordefiniert sind. Die atomaren Typen sind die grundlegenden Bausteine des Typsystems einer Programmiersprache. Aus diesen

atomaren Typen können mit Hilfe von Mengenoperationen (Subtypen, Kartesische Produkte, Listen, ...)

weitere Typen abgeleitet werden. Welche atomaren Typen zur Verfügung stehen, hängt von der gewählten Programmiersprache ab.

In allen wichtigen Programmiersprachen existieren die atomaren Typen Integer (ganze Zahlen), Float (reelle Zahlen, Fliesskomma), Boolean (logische Werte) und Char (Schriftzeichen). Dabei ist zu bemerken,

dass diese atomaren Typen natürlich nur eine endliche Teilmenge aus dem Bereich der ganzen, bzw. der

reellen Zahlen darstellen können.

1-4

1 Einführung

Beispiel: Der strukturierte Typ Array wird aus zwei gegebenen Datentypen, einem Grundtyp und einem

Indextyp konstruiert. Der Grundtyp ist ein beliebiger atomarer oder abgeleiteter Datentyp. Der Indextyp

ist normalerweise ein Subtyp (oder Intervall) des Typs int .

Auf Arrays ist immer ein Selektor definiert, welcher es erlaubt, ein einzelnes Element des Arrays zu lesen

oder zu schreiben.

Definition: Ein strukturierter Datentyp (eine Klasse) entsteht, wenn wir Elemente von beliebigen

Typen zu einer Einheit zusammenfassen. Ein solcher Typ ist formal gesprochen das kartesische Produkt

von beliebigen Datentypen.

DT = DT1 × DT2 × DT3 × . . . × DTn

Die Datentypen DT1 , . . . , DTn können atomare oder auch strukturierte Typen sein.

Dazu gehört ausserdem die Spezifikation der zugehörigen Operationen oder Methoden auf DT .

Beispiel: Wir definieren ein einfaches Interface PushButton als Basis für einen Button auf einer Benutzeroberfläche).

1.2 Einige Begriffe: Datenstrukturen

1-5

Abstrakter Datentyp

Der abstrakte Datentyp ist ein wichtiges Konzept in der modernen Informatik: Die Philosophie der objektorientierten Sprachen basiert genau auf dieser Idee. Der abstrakte Datentyp dient dazu, Datentypen

unabhängig von deren Implementation zu definieren.

Die Idee des abstrakten Datentyps beruht auf zwei wichtigen Prinzipien: dem Geheimnisprinzip und dem

Prinzip der Wiederverwendbarkeit.

Geheimnisprinzip: Dem Benutzer eines Datentyps werden nur die auf diesem Datentyp erlaubten Operationen (mit deren Spezifikation) bekanntgegeben. Die Implementation des Datentyps bleibt für den

Benutzer verborgen (abstrakt, Kapselung).

Die Anwendung dieses Prinzips bringt folgende Vorteile:

• Der Anwender kann den Datentyp nur im Sinne der Definition verwenden. Er hat keine Möglichkeit,

Eigenschaften einer speziellen Implementation auszunutzen.

• Die Implementation eines Datentyps kann jederzeit verändert werden, ohne dass die Benutzer des

Datentyps davon betroffen sind.

• Die Verantwortungen zwischen dem Anwender und dem Implementator des Datentyps sind durch

die Interface-Definitionen klar geregelt. Die Suche nach Fehlern wird dadurch erheblich vereinfacht.

Wiederverwendbarkeit: Ein Datentyp (Modul) soll in verschiedenen Applikationen wiederverwendbar

sein, wenn ähnliche Probleme gelöst werden müssen.

Die Idee hinter diesem Prinzip ist klar. Es geht darum, die Entwicklungszeit von Systemen zu reduzieren.

Das Ziel ist, Softwaresysteme gleich wie Hardwaresysteme zu bauen, das heisst, die einzelnen Komponenten eines Systems werden eingekauft, eventuell parametrisiert und zum Gesamtsystem verbunden.

1-6

1 Einführung

Ein abstrakter Datentyp definiert einen Datentyp nur mit Hilfe des Wertebereichs und der Menge der

Operationen auf diesem Bereich. Jede Operation ist definiert durch ihre Spezifikation, also die Input- und

Output-Parameter und die Vor- und Nachbedingungen.

Die Datenstruktur ist dann eine Instanz eines (abstrakten) Datentyps. Sie beinhaltet also die Repräsentation der Daten und die Implementation von Prozeduren für alle definierten Operatoren.

Wir sprechen hierbei auch von der logischen, bzw. der physikalischen Form von Datenelementen. Die

Definition des abstrakten Datentyps ist die logische, deren Implementation die physikalische Form des

Datenelements.

Der abstrakte Datentyp spezifiziert einen Typ nicht mit Hilfe einer Implementation, sondern nur als eine

Liste von Dienstleistungen, die der Datentyp dem Anwender zur Verfügung stellt. Die Dienstleistungen

nennt man auch Operationen, Methoden oder Funktionen.

Ein abstrakter Datentyp kann viele verschiedene Implementationen oder Darstellungen haben. Der abstrakte Datentyp gibt darum nicht an, wie die verschiedenen Operationen implementiert oder die Daten

repräsentiert sind. Diese Details bleiben vor dem Benutzer verborgen.

Beispiel: Der abstrakte Datentyp Stack wird durch die Menge der angebotenen Dienste definiert: Einfügen eines Elements (push ), entfernen eines Elements (pop ), lesen des obersten Elements (peek ) und

prüfen auf leer (empty ).

Eine solche Beschreibung berücksichtigt also nur, was ein Stack dem Anwender zu bieten hat.

Bei den verschiedenen Methoden muss stehen, was die Methoden tun oder bewirken (Nachbedingung)

und was für Voraussetzungen (Einschränkungen, Vorbedingungen) an die Verwendung der Methoden

gestellt sind.1

In Java könnte ein Interface für einen Stack wie folgt aussehen:

1 Optimalerweise steht noch dabei, welchen Aufwand die Methode hat.

1.2 Einige Begriffe: Datenstrukturen

1-7

public interface Stack<E> {

/**

* Pushes an item onto the top of this stack.

* @param item

the item to be pushed onto this stack.

* @return the item argument.

*/

E push(E item);

/**

* Removes the object at the top of this stack and returns that

* object as the value of this function.

* @return

The object at the top of this stack (the last

*

item of the Vector object).

* @exception EmptyStackException if this stack is empty.

*/

E pop();

/**

* Looks at the object at the top of this stack without removing

* it from the stack.

* @return

the object at the top of this stack (the last

*

item of the Vector object).

* @exception EmptyStackException if this stack is empty.

*/

E peek();

/**

* Tests if this stack is empty.

* @return true if and only if this stack contains no items;

*/

boolean empty();

}

Bei den Methoden push und empty gibt es keine Vorbedingungen. Die Methoden pop und peek werfen

eine Runtime-Exception, wenn der Stack leer ist.

1-8

1 Einführung

Die Spezifikation eines Datentyps muss vollständig, präzise und eindeutig sein. Weiter wollen wir keine

Beschreibung, die auf der konkreten Implementation des Datentyps basiert, obwohl diese die geforderten

Kriterien erfüllen würde. Eine Beschreibung, die auf der Implementation basiert, führt zu einer Überspezifikation des Datentyps.

Konkret können wir den Datentyp Stack zum Beispiel als Arraystruktur (mit einem Zeiger auf das aktuelle

oberste Element head des Stacks) implementieren. Flexibler ist allerdings die Implementation mit Hilfe

einer Listenstruktur..

1.3 Einige Begriffe: Algorithmen

1-9

1.3 Einige Begriffe: Algorithmen

Ein Algorithmus2 beschreibt das Vorgehen oder eine Methode, mit der eine Aufgabe oder ein Problem

gelöst werden kann, bzw. mit der eine Funktion berechnet werden kann. Ein Algorithmus besteht aus

einer Folge von einfachen (Rechen-)Schritten (Anweisungen), welche zur Lösung der gestellten Aufgabe

führen. Der Algorithmusgedanke ist keine Besonderheit der Informatik. In fast allen Naturwissenschaften

aber auch im Alltag werden Arbeitsvorgänge mit Hilfe von Algorithmen beschrieben.

Jeder Algorithmus muss die folgenden Eigenschaften erfüllen:

1. Er muss aus einer Reihe von konkret ausführbaren Schritten bestehen.

2. Er muss in einem endlichen Text beschreibbar sein.

3. Er darf nur endlich viele Schritte benötigen (Termination).

4. Er darf zu jedem Zeitpunkt nur endlich viel Speicherplatz benötigen.

5. Er muss bei der gleichen Eingabe immer das selbe Ergebnis liefern.

6. Nach der Ausführung eines Schrittes ist eindeutig festgelegt, welcher Schritt als nächstes auszuführen ist.

7. Der vom Algorithmus berechnete Ausgabewert muss richtig sein (Korrektheit).

Bemerkung: Die Forderung nach Eindeutigkeit wird etwa in parallelen oder probabilistischen Algorithmen zum Teil fallengelassen. Nach dem Abschluss eines einzelnen Schrittes ist der nächste Schritt nicht

eindeutig bestimmt, sondern es existiert eine endliche Menge von (möglichen) nächsten Schritten. Die

Auswahl des nächsten Schrittes aus der gegebenen Menge ist nichtdeterministisch.

Der Anspruch, dass alle Algorithmen terminieren müssen, bedeutet, dass nicht alle von uns benutzten

Programme Algorithmen sind. Editoren, Shells oder das Betriebssystem sind alles Programme, die nicht

(von selber) terminieren.

Wir können aber jedes dieser Programme als Sammlung von verschiedenen Algorithmen betrachten,

welche in verschiedenen Situationen zur Anwendung kommen.

2 Das Wort Algorithmus stammt vom Persischen Autor Abu Ja’far Mohammed ibn Mûsâ al-Khowârizmı̂, welcher ungefähr 825 vor Christus ein

Buch über arithmetische Regeln schrieb.

1-10

1 Einführung

Algorithmen werden der Einfachheit halber oft in einer Pseudocode Sprache formuliert. Damit erspart

man sich alle technischen Probleme, welche die konkrete Umsetzung in eine Programmiersprache mitbringen könnte.

Beispiel: Grösster gemeinsamer Teiler von m und n: Die kleinere der beiden Zahlen wird so lange von

der grösseren subtrahiert, bis beide Werte gleich sind. Dies ist dann der GgT von m und n.

Initialisiere m und n

Wiederhole solange m und n nicht gleich sind

Ja

Ist m > n ?

Verringere m um n

Verringere n um m

Gib m aus

Siehe auch [4]: Programmieren in Java, Kapitel 3.

Beispiele von Algorithmen in Java

int proc( int n )

{

return n/2;

}

bool isPrim( int n )

{

return false;

}

//

Nein

return true if n is a prime

1.3 Einige Begriffe: Algorithmen

Das nächste Beispiel stammt von L. Collatz (1937):

long stepNum( long n )

{

// return number of steps

long m = 0;

while( n > 1 )

{

if( n%2 == 0 ){ n = n/2; }

else { n = 3*n + 1; }

m++;

}

return m;

}

1-11

1-12

1 Einführung

1.4 Algorithmen Schema: Iteration

Unter einem Algorithmen-Schema verstehen wir ein Verfahrens-Muster oder eine allgemeine Methode,

mit welcher ein Problem gelöst werden kann. Nicht jede Methode ist für jedes Problem gleich gut geeignet. Umso wichtiger ist es also, die verschiedenen Algorithmen-Schemata zu kennen.

Ein Problem wird durch Iteration gelöst, falls der zugehörige Algorithmus einen Loop (while- oder forSchleife) benutzt. Iteration ist zum Beispiel dann sinnvoll, wenn die Daten in einem Array (oder einer

Liste) abgelegt sind und wir mit jedem Element des Array die gleichen Schritte durchführen müssen3 .

Beispiel: Das Addieren zweier Vektoren kann wie folgt implementiert werden:

public DVector sum(DVector v1) throws VectorException {

if (v1.size != size)

throw new VectorException("Incompatible vector length");

DVector res = new DVector(size);

for (int i = 0; i < size; i++)

res.value[i] = v1.value[i] + value[i];

return res;

}

1.5 Algorithmen Schema: Greedy (die gierige Methode)

Greedy-Verfahren werden vor allem dann erfolgreich eingesetzt, wenn von n möglichen Lösungen eines

Problems die bezüglich einer Bewertungsfunktion f optimale Lösung gesucht wird (Optimierungsprobleme).

Die Greedy-Methode arbeitet in Schritten, ohne mehr als einen Schritt voraus- oder zurückzublicken. Bei

jedem Schritt wird aus einer Menge von möglichen Wegen derjenige ausgesucht, der den Bedingungen

des Problems genügt und lokal optimal ist.

3 Solche Algorithmen lassen sich oft auch sehr einfach parallelisieren.

1.5 Algorithmen Schema: Greedy (die gierige Methode)

1-13

Wir wollen die Arbeitsweise dieser Methode an einem anschaulichen Beispiel illustrieren. Wir nehmen

an, dass jemand sich irgendwo auf einem Berg befindet und so schnell wie möglich zum Gipfel kommen

möchte. Eine einfache Greedy-Strategie für dieses Problem ist die folgende: Bewege dich immer entlang

der grössten Steigung nach oben bis dies nicht mehr möglich ist, das heisst, bis in allen Richtungen die

Wege nur noch nach unten führen.

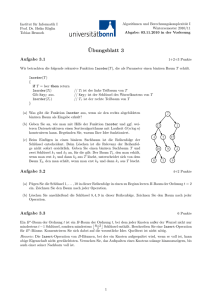

Dieser Ansatz ist in der Abbildung 1.1 dargestellt. Es ist ein typischer Greedy-Ansatz. Man schaut nicht

zurück und wählt jeweils die lokal optimale Strategie.

Abbildung 1.1: Hill climbing

Maximum

Lokales Maximum

Abbildung 1.2: Erreichen eines lokalen Maximums mit Greedy

In der Abbildung 1.2 sehen wir aber, dass diese Strategie nicht unbedingt zum (optimalen) Ziel führt. Hat

der Berg mehrere Nebengipfel, so bleiben wir vielleicht auf einem solchen Nebengipfel stehen.

Bei Problemen dieser Art liefert oft nur ein exponentieller Algorithmus eine global beste Lösung, während

ein heuristischer Ansatz4 mit Greedy nicht immer die beste Lösung liefert, dies aber in polynomialer Zeit.

Ähnliche Probleme sind das Finden von kürzesten Wegen, oder besten (Spiel-)Strategien, Verpackungsprobleme (möglichst viele verschieden grosse Kisten in einen Lastwagen packen) oder Scheduling von

verschieden langen Prozessen auf Mehrprozessor-Rechnern.

4 Eine Heuristik ist eine Richtlinie, ein generelles Prinzip oder eine Daumenregel, welche als Entscheidungshilfe benutzt werden kann.

1-14

1 Einführung

Ein weiteres Problem dieser Art ist das Suchen eines minimalen Pfades in einem allgemeinen Graphen.

Um eine optimale Lösung zu finden, müssten wir im wesentlichen sämtliche Pfade abgehen und deren

Gewichte aufschreiben. Ein Greedy-Algorithmus löst das Problem viel schneller, indem er jeweils lokal

den kürzesten (leichtesten) Pfad wählt. Allerdings findet man mit dieser Methode nicht unbedingt den

insgesamt kürzesten Pfad.

Es existieren aber auch Probleme, bei denen der Greedy-Ansatz zum optimalen Ergebnis führt. Ein

Greedy-Algorithmus löst das folgende Problem: Finde ein minimales (maximales) Gerüst in einem gewichteten Graphen. Dabei wählt man jeweils die Kante, die das kleinste (grösste) Gewicht hat und keinen

Zyklus verursacht. Der Algorithmus ist fertig, sobald ein zusammenhängender Teilgraph entstanden ist.

9

9

3

3

7

5

6

6

5

5

x

7

5

4

4

6

8

7

6

8

7

3

5

1

8

8

7

8

8

4

3

5

1

4

y

3

7

9

5

x

1.6 Algorithmen Schema: Rekursion

1-15

1.6 Algorithmen Schema: Rekursion

Rekursion ist ein fundamentales Konzept der Informatik. Eine Prozedur heisst rekursiv, wenn sie sich

direkt oder indirekt selber aufruft. Dabei müssen wir darauf achten, dass eine Abbruchbedingung existiert,

damit die Prozedur in jedem Fall terminiert.

Beispiele: Die rekursive Implementation der Fakultätsfunktion:

long factorial( int n )

{

if( n <= 1 )

return 1;

return n*factorial(--n);

}

Der rekursive Aufruf kann auch indirekt erfolgen:

int proc( int a, int b )

{

if( b-a < 5 )

return sub( b );

return a * proc(a-1, b/2)

}

int sub( int c )

{

if( c%2 == 0 )

return c*c;

return proc(c-2,c+1);

}

Bei einer rekursiven Prozedur sind die folgenden Punkte besonders zu beachten:

• Die Rekursion darf nicht unendlich sein. Es muss also in der Prozedur ein Instruktionszweig existieren, der keinen Aufruf der Prozedur enthält. Diesen Teil der Prozedur nennt man den Rekursionsanfang. Bei indirekter Rekursion (Prozedur A ruft Prozedur B auf und B ruft wieder A auf) ist jeweils

besondere Vorsicht geboten.

• Es muss sichergestellt sein, dass die Anzahl der hintereinander ausgeführten rekursiven Aufrufe

(also die Rekursionstiefe) vernünftig bleibt, da sonst zu viel Speicher verwendet wird. Beim rekursiven

Sortieren von n Elementen sollten zum Beispiel nur O(log(n)) rekursive Aufrufe nötig sein.

• Rekursion soll dann angewandt werden, wenn die Formulierung der Lösung dadurch klarer und

kürzer wird. Auch darf der Aufwand der rekursiven Lösung in der Ordnung nicht grösser werden

1-16

1 Einführung

als der Aufwand der iterativen Lösung. Insbesondere kann die Rekursion leicht eliminiert werden,

wenn die Prozedur nur einen rekursiven Aufruf enthält und dieser Aufruf die letzte Instruktion der

Prozedur ist (tail recursion, diese wird von einem optimierenden Compiler normalerweise automatisch eliminiert.)

Beispiel Die Fibonacci Funktion ist wie folgt definiert:

fibonacci(0)

= 1

fibonacci(1)

= 1

fibonacci(n + 2)

= fibonacci(n + 1) + fibonacci(n)

Diese Definition kann direkt in dieser Form als Rekursion implementiert werden:

Diese Implementierung führt zu einem exponentiellen Aufwand5 . Auf jeder Stufe sind zwei rekursive Aufrufe nötig, welche jeweils unabhängig voneinander die gleichen Funktionswerte berechnen. Eine bessere

Implementation (ohne Rekursion) benötigt nur linearen Aufwand (vgl. Übung).

1.6.1 Rekursionselimination

Wie bereits vorher erwähnt, soll Rekursion nur dann verwendet werden, wenn dadurch die Programme

einfacher lesbar werden und die Komplexität nicht grösser als die der iterativen Lösung ist.

Ist ein Problem durch eine (unnötig aufwändige) Rekursion formuliert, stellt sich die Frage, ob und wie

sich die Rekursion allenfalls eliminieren lässt. Prinzipiell kann dies durch folgendes Vorgehen versucht

werden:

5 Die Prozedur benötigt zum Berechnen von fib(n) in der Grössenordnung von 2·fib(n) rekursive Aufrufe.

1.6 Algorithmen Schema: Rekursion

1-17

Umdrehen der Berechnung (von unten nach oben).

Abspeichern der Zwischenresultate in einen Array, eine Liste oder einen Stack.

Beispiel: Gegeben ist die folgende rekursive Funktion, die wir in eine nichtrekursive Prozedur umschreiben wollen:

long rekFunction(int x, int y)

{

if( x <= 0 || y <= 0 )

return 0;

return x + y + rekFunction(x-1, y);

}

Etwas komplizierter wird die Rekursionselimination, wenn die Funktion, wie im folgenden Beispiel, von

zwei Parametern abhängt:

long Pascal(int x, int y)

{

if( x <= 0 || y <= 0 )

return 1;

return Pascal(x-1, y) + Pascal(x, y-1);

}

1-18

1 Einführung

1.6.2 Divide and Conquer

Die Divide and Conquer Methode (kurz: DAC) zerlegt das zu lösende Problem in kleinere Teilprobleme

(divide) bis die Lösung der einzelnen Teilprobleme (conquer) einfach ist. Anschliessend werden die

Teillösungen zur Gesamtlösung vereinigt (merge)6 .

Da das Problem in immer kleinere Teilprobleme zerlegt wird, welche alle auf die gleiche Art gelöst werden,

ergibt sich normalerweise ein Lösungsansatz mit Rekursion.

Ein DAC-Algorithmus hat also folgende allgemeine Form:

void DAC( problem P ) {

if( Lösung von P sehr einfach ) {

return Lösung(P)

// conquer

}

else {

divide( P, Teil1 , . . . ,Teiln );

return combine( DAC(Teil1 ),. . .,DAC(Teiln ) );

}

}

DAC-Algorithmen können grob in die beiden folgenden Kategorien unterteilt werden.

• Das Aufteilen in Teilprobleme (divide) ist einfach, dafür ist das Zusammensetzen der Teillösungen

(merge) schwierig.

• Das Aufteilen in Teilprobleme (divide) ist schwierig, dafür ist das Zusammensetzen der Teillösungen

(merge) einfach.

Wenn sowohl das Aufteilen in Teilprobleme als auch das Zusammensetzen der Teillösungen schwierig

ist, ist Divide and Conquer vermutlich nicht der richtige Ansatz.

6 Das Divide and Conquer Schema eignet sich vor allem auch zum parallelen oder verteilten Lösen von Problemen.

1.6 Algorithmen Schema: Rekursion

1-19

Bekannte Beispiele für Divide and Conquer sind die Sortieralgorithmen Quicksort und Mergesort.

Quicksort : (Hard Split Easy Join) Die Elemente werden gemäss einem Pivotelement in verschiedene

Mengen aufgeteilt. Das Einsammeln ist dann trivial.

Mergesort : (Easy Split Hard Join) Die Elemente werden in beliebige (gleichgrosse) Mengen aufgeteilt.

Beim Einsammeln der verschiedenen (sortierten) Mengen muss nachsortiert werden.

void Sort( Menge P ) {

if( P besteht aus wenigen Elementen ) // zum Beispiel aus weniger als 10

{

verwende einfachen (linearen) Sortieralgorithmus und gib sortierte Menge zurück

}

else {

divide( P, Teil1 , . . . ,Teiln ); // Zerteile P in n Teile

// Füge die sortierten Mengen zusammen (trivial oder durch Nachsortieren).

return merge( Sort(Teil1 ),. . .,Sort(Teiln ) );

}

}

1-20

1 Einführung

1.7 Übung 1

1. Nichtdeterministischer Primzahltest Das folgende Verfahren testet, ob ein Kandidat P eine Primzahl ist: Wählen Sie eine genügend grosse Menge beliebiger (zufälliger) Zahlen zi und versuchen

Sie nacheinander, P durch zi zu teilen. Falls keine der Zahlen zi ein Teiler ist, geben Sie true zurück,

andernfalls false.

Formulieren Sie für das Verfahren einen Algorithmus in Pseudocode (Initialisierung, sequenzelle Anweisungen, if, while, ...)

2. Rekursionselimination: Gegeben ist die folgende Implementation der Fibonacci-Funktion:

public long fibonacci( int n ) {

if( n < 2 )

return 1;

return fibonacci(n-1) + fibonacci(n-2);

}

Finden Sie eine effizientere Implementierung ohne Rekursion für die Berechnung der Fibonacci-Zahlen.

3. Rekursionselimination:

Eliminieren Sie aus den der folgenden Prozedur die Rekursion:

public long procRek(int n) {

if(n<=3)

return 2;

else

return 2*procRek(n-1) + procRek(n-2)/2 - procRek(n-3);

}

4. Rekursion: Zählen der Knoten eines Baumes

Implementieren Sie eine Methode countNodes(), welche mit Hilfe einer Rekursion die Anzahl Knoten

eines Baumes berechnet.

Die Anzahl Knoten eines Baumes sind rekursiv wie folgt definiert: Wenn ein Baum nur aus einem

Blatt (leaf) besteht, dann gilt countNodes(leaf) = 1.

Sonst gilt countNodes(node) = 1 + sum(countNodes(c): c the children of node)

Rahmenprogramme finden Sie unter www.sws.bfh.ch/

∼amrhein/AlgoData/uebung1

2

Komplexität von Algorithmen

2.1 Komplexitätstheorie

Nicht alle (mathematischen) Probleme (Funktionen) sind algorithmisch lösbar (berechenbar). Ausserdem sind unter den berechenbaren Funktionen viele, deren Berechnung sehr aufwändig und deshalb

undurchführbar ist.

In diesem Abschnitt wollen wir nun die prinzipiell berechenbaren Probleme weiter unterteilen: in solche,

die mit vernünftigem Aufwand lösbar sind und die restlichen.

Alle Funktionen

Berechenbare Funktionen

Durchführbare Algorithmen

Abbildung 2.1: Durchführbare Algorithmen

Für lösbare Probleme ist es wichtig zu wissen, wieviele Betriebsmittel (Ressourcen) für ihre Lösung

erforderlich sind. Nur solche Algorithmen, die eine vertretbare Menge an Betriebsmitteln benötigen, sind

tatsächlich von praktischem Interesse.

2-2

2 Komplexität von Algorithmen

Die Komplexitätstheorie stellt die Frage nach dem Gebrauch von Betriebsmitteln und versucht diese zu

beantworten. Normalerweise werden für einen Algorithmus die Betriebsmittel Zeit- und Speicherbedarf

untersucht. Mit Zeitbedarf meint man die Anzahl benötigter Rechenschritte1 .

2.2 Komplexitätsanalyse

Mit Hilfe der Komplexitätsanalyse können wir die Effizienz verschiedener Algorithmen vergleichen, bzw.

versuchen zu entscheiden, ob ein Algorithmus das Problem im Allgemeinen innert nützlicher Frist löst.

Eine Möglichkeit, die Effizienz verschiedener Algorithmen zu vergleichen wäre, alle Algorithmen zu implementieren und die benötigte Zeit und den Platzverbrauch zu messen. Allerdings ist dieses Verfahren

höchst ineffektiv. Es muss unnötig viel programmiert werden. Wir können auch nicht einschätzen, ob nicht

ein Algorithmus schlechter programmiert wurde als die anderen oder ob die Testbeispiele eventuell einen

Algorithmus begünstigen2 .

Auch mit Hilfe einer Komplexitätsanalyse können wir nicht wirklich entscheiden, ob ein Programm schnell

laufen wird. Vielleicht kann ein optimierender Compiler den einen Code besser unterstützen als den anderen. Vielleicht sind gewisse Speicherzugriffe übers Netz nötig, die den Code langsam machen. Möglicherweise ist der Algorithmus auch einfach schlecht implementiert.

Dennoch kann eine Komplexitätsanalyse einen Hinweis geben, ob ein Algorithmus überhaupt prinzipiell für unser Problem in Frage kommt. Durch das Zählen der Anzahl nötiger Rechenschritte können wir

zumindest verschiedene Algorithmen einigermassen fair vergleichen. Ein Rechenschritt besteht dabei

aus einer einfachen Operation, einer Zuweisung oder einem Vergleich (was normalerweise in einer Programmzeile steht).

Algorithmen nehmen Eingabedaten entgegen und führen mit diesen eine Verarbeitung durch. Die Anzahl

Rechenschritte hängt normalerweise von der Länge (Grösse) der Eingabedaten ab.

• Ein Problem kann durch verschiedene Algorithmen mit verschiedener Komplexität gelöst werden. Für

Probleme, welche sehr oft gelöst werden müssen, ist es von grossem Interesse, einen Algorithmus

zu finden, welcher möglichst wenig Betriebsmittel erfordert.

1 Die Komplexität eines Algorithmus ist natürlich unabhängig von der Geschwindigkeit des verwendeten Computers.

2 Wir müssten fairerweise alle möglichen Eingaben testen, was natürlich nicht machbar ist.

2.2 Komplexitätsanalyse

2-3

• Die Komplexität eines Algorithmus hängt von der Grösse der Eingabedaten ab. Je grösser die Dimension n der Matrizen, desto länger wird die Ausführung des Algorithmus dauern. Im Allgemeinen

können wir die Komplexität eines Algorithmus als Funktion der Länge der Eingabedaten angeben.

Als Vereinfachung betrachten wir normalerweise nicht die (exakte) Länge der Eingabe (zum Beispiel in

Anzahl Bytes), sondern grössere, für das Problem natürliche Einheiten. Man spricht dann von der natürlichen Länge des Problems. Will man nur eine Grössenordnung für die Komplexität eines Algorithmus

angeben, so zählt man auch nicht alle Operationen, sondern nur diejenigen, welche für die Lösung des

Problems am wichtigsten (zeitintensivsten) sind. In der folgenden Tabelle sind Probleme mit ihrer natürlichen Länge und ihren wichtigsten Operationen angegeben.

Problem

natürliche Einheit

Operationen

Algorithmen auf ganzen Zahlen

(z.B. Primzahlalgorithmen )

Suchalgorithmen

Sortieralgorithmen

Algorithmen auf reellen Zahlen

Matrix Algorithmen

Anzahl Ziffern

Operationen in

Anzahl Elemente

Anzahl Elemente

Länge der Eingabe

Dimension der Matrix

Vergleiche

Vergleiche, Vertauschungen

Operationen in IR

Operationen in IR

Beispiel: Wir berechnen die Komplexität der folgenden Prozeduren, indem wir die Anzahl Aufrufe von

do something() (abhängig vom Input n ) zählen.

int proc1( int n )

{

int res = 0;

for( i = 0; i < n; i++ )

res = do_something(i);

return res;

}

int proc2( int n )

{

int res = 0;

for( i = 0; i < n; i++ )

for( j = 0; j < n; j++ )

res = do_something(i, j);

return res;

}

Wir verändern die Prozedur etwas und berechnen wiederum die Komplexität.

2-4

2 Komplexität von Algorithmen

int proc3( int n )

{

int res = 0;

for( i = 0; i <= n; i++ )

for( j = 0; j <= i; j++ )

res = do_something(i, j);

return res;

}

Wir zählen auch hier, wie oft do something()

aufgerufen wird.

2.2.1 Best-Case, Average-Case, Worst-Case Analyse

Je nach Input kann die Anzahl benötigter Rechenschritte sehr stark schwanken. Dies geschieht beispielsweise dann, wenn die Prozedur Fallunterscheidungen (if/else) enthält.

int proc3( int n )

{

int res = 1;

if( n % 2 == 0 )

return res;

for( int i=0; i<n; i++ )

res = do_something(res, i);

return res;

}

2.3 Asymptotische Komplexität

2-5

Bei Suchalgorithmen zählen wir die Anzahl nötiger Vergleiche.

public int indexOf( Object elem ) {

// lineare Suche, elem != null

for( int i=0; i < size; i++ ) {

if( elem.equals(elementData[i]) )

return i;

}

return -1;

}

n = size

int procRek( int n )

{

int res = do_something(n);

if( n <= 1 ) return res;

if( n % 2 == 0 )

return procRek(n/2);

return procRek(n+1);

}

2.3 Asymptotische Komplexität

Eine Vereinfachung ergibt sich, wenn man nur das asymptotische Verhalten der Komplexität eines

Algorithmus betrachtet. Das asymptotische Verhalten eines Polynoms entspricht dessem grössten Term.

Konstante Faktoren werden dabei ignoriert.

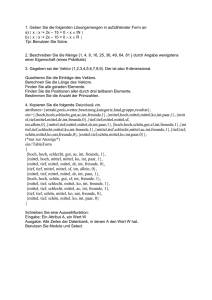

Beispiel: In der Funktion

f (n) = 2n2 − 10n + 20

fällt für wachsendes n der Ausdruck 10n + 20 gegenüber dem Ausdruck 2n2 immer weniger ins Gewicht.

Der dominierende Ausdruck ist in diesem Fall 2n2 .

2-6

2 Komplexität von Algorithmen

10000

200

8000

150

6000

100

4000

50

0

2000

2

4

6

8

10

12

0

14

20

40

n

60

80

100

n

Das asymptotische Verhalten von f ist also n2 . Man schreibt auch f (n) ∈ O(n2 ) um das Wachstumsverhalten einer Funktion zu klassifizieren.

2

n

2n

1600

2

10n log(n)

1400

20 n

1200

1000

800

10 n

600

400

log(n)

200

10

20

30

40

50

Wir sagen, eine Funktion f hat exponentielles Wachstumsverhalten, wenn der dominierende Term von

f (n) von der Form kcn ist, f hat polynomiales Wachstum, falls er von der Form knc ist (c fest!), lineares

Wachstum, falls er von der Form kn ist und logarithmisches Wachstum, falls der dominierende Term von

der Form k log(n) ist.

Wie schon vorher erwähnt, interessiert uns bei der asymptotischen Komplexität nur das proportionale

Verhalten. Die O-Notation gibt uns ein Mittel, dies mathematisch auszudrücken:

2.3 Asymptotische Komplexität

2-7

Definition: [O-Notation] Eine Funktion f (n) ist aus O(g(n)), falls es Konstanten c und N gibt, so dass

für alle m > N die Beziehung f (m) < cg(m) gilt.

Die Notation sagt genau das aus, was wir vorher schon etwas salopp formuliert hatten: Eine Funktion

f (n) gehört zu O(g(n)), falls sie (bis auf eine Konstante) nicht schneller wächst als g(n).

Man sagt auch, f hat das gleiche asymptotische Verhalten wie g.

So gehören zum Beispiel die Funktionen 300n2 + 2n − 1, 10n + 12 und 5n3/2 + n

Hingegen gehören die Funktionen 2n oder n3 nicht zu O(n2 ).

alle zu O(n2 ).

Umgekehrt sagt das Wissen, dass eine Funktion f zu O(g) gehört, nichts über die Konstanten c und

N aus. Diese können sehr gross sein, was gleichbedeutend damit ist, dass ein Algorithmus mit dieser

(asymptotischen) Komplexität eventuell erst für sehr grosse Eingabewerte sinnvoll einsetzbar ist 3 .

Nachfolgend sind einige wichtige Regeln (ohne Beweis) angegeben:

• Die Ordnung des Logarithmus ist kleiner als die Ordnung einer linearen Funktion.

log(n) ∈ O(n) n ̸∈ O(log(n))

• Die Ordnung eines Polynoms ist gleich der Ordnung des Terms mit der höchsten Potenz.

ak nk + ak−1 nk−1 + . . . + a1 n + a0 ∈ O(nk )

• Für zwei Funktionen f und g gilt:

O( f + g) = max{O( f ), O(g)}

O( f ∗ g) = O( f ) · O(g)

• Die Ordnung der Exponentialfunktion ist grösser als die Ordnung eines beliebigen Polynoms. Für alle

c > 1 und k gilt:

cn ̸∈ O(nk )

3 Der FFT-Algorithmus für Langzahlarithmetik ist zum Beispiel erst für Zahlen, die mehrere hundert Stellen lang sind, interessant.

2-8

2 Komplexität von Algorithmen

Beispiel: Wir berechnen die asymptotische Komplexität der folgenden Prozeduren.

int proc4( int n )

{

int res = 0, m = n*n;

for( i = m; i > 1; i=i/2 )

res = do_something(res, i);

return res;

}

Wir zählen wieder, wie oft do something()

aufgerufen wird:

Eine andere Methode benötigen wir zum Berechnen der Komplexität im folgenden Beispiel. Der Einfachheit halber nehmen wir an, n sei eine Zweierpotenz (n = 2k ).

int procRec( int n )

{

int res = 0;

if(n <= 1)

return res;

for( int i = 0; i < n; i++ )

res = do_something(res, i);

return procRec(n/2);

}

Wir zählen wiederum, wie oft do something()

aufgerufen wird.

2.4 Übung 2

2-9

2.4 Übung 2

1. Komplexiät von einfachen Prozeduren

Berechnen Sie die Komplexität der Prozeduren 1 bis 4. Wie oft wird do something() aufgerufen? Überprüfen Sie Ihre Lösungen, indem Sie die Prozeduren in Java implementieren und einen Zähler einbauen.

void procedure1 ( int n )

{

for(int i=0; i<=n; i++)

do something(i,n);

for(int j=n; j>=0; j--)

do something(j,n);

}

void procedure2 ( int n )

{

for(int i=0; i<n; i++)

for(int j=0; j<2*i; j++)

do something(i,j,n);

}

void procedure3 ( int n )

{

for(int i=0; i<n; i++)

{

int j = 0;

while( j < 2*n )

{

j++;

do something(i,j,n);

}

}

}

void procedure4 ( int n )

{

int j=n;

while( j > 0 )

{

j = j/2;

do something(i,j,n);

}

}

2-10

2 Komplexität von Algorithmen

2. Komplexität rekursiver Prozeduren

Berechnen Sie die Komplexität der folgenden rekursiven Prozeduren. Wie oft wird do something() ausgeführt? Wählen Sie für n eine Zweierpotenz: n = 2k .

void procRec1( int n )

{

if( n<=1 )

return;

int procRec2( int n, int res )

{

res = do_something(res, n);

if( n <= 1 )

return res;

res = procRec2(n/2, res);

res = procRec2(n/2, res);

return res;

do_something(n)

procRec1(n/2);

}

}

3. Komplexität verschiedener Java Methoden

Bestimmen Sie von den Java Klassen ArrayList und LinkedList die asymptotische Komplexität der Methoden

-

public

public

public

public

public

public

public

boolean contains(Object o)

E get(int index)

E set(int index, E element)

boolean add(E o)

void add(int index, E element)

E remove int(index)

boolean remove(Object o)

Sie müssen dazu die Algorithmen nicht im Detail verstehen. Es genügt, die Iterationen (auch der benötigten Hilfsfunktionen) zu zählen (wir werden diese Algorithmen in einem späteren Kapitel noch genauer

betrachten).

3

Datentypen: Listen, Stacks und Queues

Listen, Stacks und Queues können entweder arraybasiert oder zeigerbasiert implementiert werden. Die

Implementierung mit Hilfe von Arrays hat den Vorteil, dass ein wahlfreier Zugriff besteht. Der Nachteil

hingegen ist, dass wir schon zu Beginn wissen müssen, wie viele Elemente die Liste maximal enthält.

Viele Kopieraktionen sind nötig, wenn der gewählte Bereich zu klein gewählt wurde, oder wenn in der

Mitte einer Liste ein Element eingefügt oder gelöscht werden soll.

Eine flexiblere Implementation bietet die Realisation von Listen mit Hilfe von Zeigerstrukturen.

3.1 Array Listen

In einer Array Liste werden die einzelnen Elemente (bzw. die Referenzen auf die Elemente) in einen Array

(vom generischen Typ E) abgelegt.

initialCapacity

E[ ] elementData

....

size

Der Vorteil von Array Listen ist der direkte Zugriff auf das n-te Element. Der Nachteil ist allerdings, dass

bei jedem Einfügen oder Löschen von Elementen der Array (in sich) umkopiert werden muss. Ausserdem

3-2

3

Datentypen: Listen, Stacks und Queues

muss der Array in einen neuen, grösseren Array umkopiert werden, sobald die initiale Anzahl Elemente

überschritten wird.

Die ArrayList benutzt also einen Array von (Zeigern auf) Elementen E als Datenspeicher:

public class ArrayList<E> extends AbstractList<E> {

private Object[] elementData;

private int size; // The number of elements.

/** Constructs an empty list with the specified initial capacity. */

public ArrayList(int initialCapacity) { ... }

/** Returns true if this list contains no elements.

public boolean isEmpty() { ... }

*/

/** Returns the index of the first occurrence of the specified element. */

public int indexOf(Object elem) { ... }

/** Returns the element at the specified position in this list. */

public E get(int index) { ... }

/**

Inserts the element at the specified position in this list.

Shifts any subsequent elements to the right. */

public void add(int index, E element) { ... }

/**

Removes the element at the specified position in this list.

Shifts any subsequent elements to the left. */

public E remove(int index) { ... }

/** Increases the capacity of this ArrayList instance. */

public void ensureCapacity(int minCapacity) { ... }

...

}

3.1 Array Listen

3-3

Im Konstruktor wird der elementData Array mit Länge initialCapacity initialisiert:

public ArrayList(int initialCapacity) {

if (initialCapacity < 0) throw new IllegalArgumentException( ... );

elementData = new Object[initialCapacity];

}

Der Zugriff auf ein Element an einer gegebenen Stelle ist direkt und damit sehr schnell.

public E get(int index) {

if (index >= size || index < 0) throw new IndexOutOfBoundsException( ... );

return (E) elementData[index];

}

Das Einfügen von neuen Elementen in den Array hingegen ist aufwändig, da der hintere Teil des Array

umkopiert werden muss.

arrayCopy

....

add

public void add(int index, E element) {

if (index > size || index < 0) throw new IndexOutOfBoundsException(...)

ensureCapacityInternal(size + 1);

System.arraycopy(elementData, index, elementData, index + 1,

size - index);

elementData[index] = element;

size++;

}

3-4

3

Datentypen: Listen, Stacks und Queues

Das Gleiche gilt für das Löschen von Elementen aus einer ArrayList. Alle Elemente hinter dem gelöschten

Element müssen umkopiert werden.

public E remove(int index) {

if (index >= size || index < 0) throw new IndexOutOfBoundsException( ... );

E oldValue = elementData(index);

int numMoved = size - index - 1;

if (numMoved > 0)

System.arraycopy(elementData, index+1, elementData,

index, numMoved);

elementData[--size] = null; // Let gc do its work

return oldValue;

}

Sobald der aktuell angelegte Array voll ist, muss ein neuer Datenspeicher angelegt und der gesamte

Array umkopiert werden.

public void ensureCapacity(int minCapacity) {

if (minCapacity - elementData.length > 0) // -> grow

int oldCapacity = elementData.length;

int newCapacity = oldCapacity + (oldCapacity >> 1);

if (newCapacity - minCapacity < 0)

newCapacity = minCapacity;

// copy all elements to new (larger) memory area

elementData = Arrays.copyOf(elementData, newCapacity);

}

}

3.2 Doppelt verkettete Listen

3-5

3.2 Doppelt verkettete Listen

In einer doppelt verketteten Liste besteht jedes Listenelement aus einem Datenfeld (bzw. einer Referenz

auf ein Datenfeld) (element) und zwei Zeigern (next und prev).

Als Listenelemente dient die Klasse Node.

private static class Node<E> {

E item;

Node<E> next;

Node<E> prev;

Node(Node<E> prev, E element, Node<E> next) {

this.item = element;

this.next = next;

this.prev = prev;

}

}

Die Klasse Node ist eine innere Klasse von List und wird einzig zum Verpacken der Datenelemente

bentutzt.

3-6

3

Datentypen: Listen, Stacks und Queues

Eine (doppelt) verkettete Liste entsteht dann durch Zusammenfügen einzelner Node Elemente. Besondere Node Elemente bezeichnen dabei den Listenanfang und das Ende.

Die Definition einer Liste sieht dann zum Beispiel wie folgt aus:

public class

transient

transient

transient

LinkedList<E> {

Node<E> first;

Node<E> last;

int size = 0;

/**

* Returns true if this list contains no elements.

*/

boolean isEmpty(){ ... };

/**

* Returns the element at the specified position in this list.

* Throws IndexOutOfBoundsException if the index is out of range.

*/

E get(int index){ ... };

/**

* Inserts the element at the specified position in this list.

* Throws IndexOutOfBoundsException if the index is out of range.

*/

void add(int index, E element){ ... };

/**

* Removes the element at position index in this list.

* Returns the element previously at the specified position.

* Throws IndexOutOfBoundsException if the index is out of range.

3.2 Doppelt verkettete Listen

*/

E remove(int index){ ... };

/**

* Returns the index of the first occurrence of the specified

* element, or -1 if this list does not contain this element.

*/

int indexOf(Object o){ ... };

. . .

}

Wir betrachten hier je eine Implementation für das Einfügen und für das Löschen eines Elementes.

Suchen einer bestimmten Stelle

Node<E> node(int index) {

if (index < (size >> 1)) {

Node<E> x = first;

for (int i = 0; i < index; i++)

x = x.next;

return x;

} else {

Node<E> x = last;

for (int i = size - 1; i > index; i--)

x = x.prev;

return x;

}

}

3-7

3-8

Einfügen an einer bestimmten Stelle

public void add(int index, E element) {

checkPositionIndex(index);

if (index == size)

linkLast(element);

else

linkBefore(element, node(index));

}

void linkLast(E e) {

final Node<E> l = last;

final Node<E> newNode = new Node<>(l, e, null);

last = newNode;

if (l == null)

first = newNode;

else

l.next = newNode;

size++;

}

3

Datentypen: Listen, Stacks und Queues

3.2 Doppelt verkettete Listen

void linkBefore(E e, Node<E> succ) {

final Node<E> pred = succ.prev;

// assert succ != null;

final Node<E> newNode = new Node<>(pred, e, succ);

succ.prev = newNode;

if (pred == null)

first = newNode;

else

pred.next = newNode;

size++;

}

void addFirst(E e) {

// oder linkFirst

final Node<E> f = first;

final Node<E> newNode = new Node<>(null, e, f);

first = newNode;

if (f == null)

last = newNode;

else

f.prev = newNode;

size++;

}

public void add(E e) {

// add at the end

final Node<E> l = last;

final Node<E> newNode = new Node<>(l, e, null);

last = newNode;

if (l == null)

first = newNode;

else

l.next = newNode;

size++;

}

Am effizientesten ist also das nicht-sortierte Einfügen, das heisst am Ende oder am Anfang.

3-9

3-10

3

Datentypen: Listen, Stacks und Queues

Löschen

Beim Löschen von Elementen muss geprüft werden, ob ev. first und/oder last korrigiert werden müssen.

public E remove(int index) {

if(index >= 0 && index < size)

return unlink(node(index));

else

throw new IndexOutOfBoundsException( ... );

}

E unlink(Node<E> x) {

final E element = x.item;

final Node<E> next = x.next;

final Node<E> prev = x.prev;

if (prev == null) {

first = next;

} else {

prev.next = next;

}

if (next == null) {

last = prev;

} else {

next.prev = prev;

}

x.item = null;

size--;

return element;

}

x.prev = null;

x.next = null;

3.3 Stacks und Queues

3-11

3.3 Stacks und Queues

Ein Interface für einen Stack hatten wir im Abschnitt 1.2 bereits gesehen. Stacks sind einfache Listenstrukturen, bei denen bloss am Kopf Elemente eingefügt, gelesen, bzw. gelöscht werden dürfen.

Wir betrachten hier die Implementation eines Stacks mit Hilfe von Zeigerstrukturen.

public class Stack<E> {

private Node<E> first;

private int size = 0;

public E push(E item) {

first = new Node<E>(item, first);

size++;

return item;

}

public E pop() {

if (size==0) throw new EmptyStackException();

Node<E> e = first;

E result = e.element;

first = e.next;

e.element = null;

e.next = null;

size--;

return result;

}

public E peek() {

if (size==0) throw new EmptyStackException();

return first.element;

3-12

3

Datentypen: Listen, Stacks und Queues

}

public boolean empty() {

return size == 0;

}

private static class Node<E> {

E element;

Node<E> next;

Node(E element, Node<E> next) {

this.element = element;

this.next = next;

}

}

}

In einer Queue können Elemente nur am Ende angefügt werden. Nur am Kopf der Queue können Elemente gelesen, bzw. gelöscht werden.

3.4 Iteratoren

3-13

3.4 Iteratoren

Auf Listenstrukturen hat man üblicherweise eine Hilfsklasse, welche zum Durchlaufen der Liste dient. Die

zwei wichtigsten Methoden von Iterator Klassen sind hasNext zum Prüfen, ob das Ende der Liste erreicht

ist, sowie die Methode next, welche den Inhalt des nächsten Elements zurückgibt.

public interface Iterator<E> {

/**

* Returns true if the iteration has more elements.

*/

boolean hasNext();

/**

* Returns the next element in the iteration.

* @exception NoSuchElementException iteration has no more elements.

*/

E next();

...

}

3-14

3

Datentypen: Listen, Stacks und Queues

3.5 Übung 3

Für die Implementationsaufgabe finden Sie Rahmenprogramme unter

www.sws.bfh.ch/∼amrhein/AlgoData/

1. List Iterator

Entwerfen Sie (ausgehend vom Rahmenprogramm) eine Klasse ListItr, welche als Iterator für die

LinkedList verwendet werden kann.

Implementieren Sie dazu in der MyLinkedList Klasse eine innere Klasse ListItr mit einem Konstruktor

ListItr(int index), welcher ein ListIterator Objekt erzeugt, welches an die Position index zeigt. Implementieren Sie ausserdem die Methoden Object next(), boolean hasNext(), boolean hasPrevious()

und Object previous().

2. Queue

Implementieren Sie eine Queue gemäss dem gegebenen Rahmenprogramm.

-

Implementieren Sie die Queue zuerst als Liste.

-

Als zweites implemtieren Sie die Queue als Array.

In der Array-basierten Queue dürfen Sie annehmen, dass die Queue nicht mehr als MAX viele

Elemente enthalten muss. Überlegen Sie sich eine Implementierung, welche nicht nach jedem

Einfügen oder Löschen den ganzen Array umkopiert.

3. Das Collection Interface

Zeichnen Sie die Klassenhierarchie der (wichtigsten) Collection Klassen.

Zeichnen Sie die Hierarchie der Interfaces List, Queue, Set und SortedSet, sowie der Klassen ArrayList, HashSet, LinkedHashSet, LinkedList, PriorityQueue, Stack, TreeSet, Vector

4

Datentypen: Bäume, Heaps

Alle bisher betrachteten Strukturen waren linear in dem Sinn, dass jedes Element höchstens einen Nachfolger hat. In einem Baum kann jedes Element keinen, einen oder beliebig viele Nachfolger haben. Bäume

sind wichtig als Strukturen in der Informatik, da sie auch oft im Alltag auftauchen: zum Darstellen von

Abhängigkeiten oder Strukturen, als Organigramme von Firmen, als Familienstammbaum, aber auch

zum Beschleunigen der Suche.

Definition: Ein Graph ist definiert als ein Paar B = (E, K) bestehend aus je einer endlichen Menge E

von Ecken (Knoten, Punkten) und einer Menge von Kanten. Eine Kante wird dargestellt als Zweiermenge

von Ecken {x, y}, den Endpunkten der Kante.

Ein Baum ist ein Graph mit der zusätzliche Einschränkung, dass es zwischen zwei Ecken nur eine (direkte oder indirekte) Verbindung gibt1 .

Wir befassen uns hier zuerst vor allem mit einer besonderen Art von Bäumen: den Binärbaumen. Ein

Baum heisst binär, falls jeder Knoten höchstens zwei Nachfolger hat.

1 Ein Baum ist ein zusammenhängender Graph ohne Zyklen.

4-2

.

4 Datentypen: Bäume, Heaps

.

.

. . . .

..

. ..

Definition: Ein binärer Baum besteht aus einer Wurzel (Root) und (endlich vielen) weiteren Knoten und

verbindenden Kanten dazwischen. Jeder Knoten hat entweder keine, ein oder zwei Nachfolgerknoten.

Ein Weg in einem Baum ist eine Liste von disjunkten, direkt verbunden Kanten. Ein binärer Baum ist

vollständig (von der Höhe n), falls alle inneren Knoten zwei Nachfolger haben und die Blätter maximal

Weglänge n bis zur Wurzel haben.

Jedem Knoten ist eine Ebene (level) im Baum zugeordnet. Die Ebene eines Knotens ist die Länge des

Pfades von diesem Knoten bis zur Wurzel. Die Höhe (height) eines Baums ist die maximale Ebene, auf

der sich Knoten befinden.

Ein binärer Baum besteht also aus Knoten mit einem (Zeiger auf ein) Datenelement data , einem linken

Nachfolgerknoten left und einem rechten Nachfolgerknoten right .

left

public class BinaryTreeNode<T> {

protected T data;

protected BinaryTreeNode<T> leftChild;

protected BinaryTreeNode<T> rightChild;

right

4-3

public BinaryTreeNode(T item){ data=item; }

// tree traversals

public BinaryTreeNode<T> inOrderFind(T item) { . . . }

public BinaryTreeNode<T> postOrderFind(T item) { . . . }

public BinaryTreeNode<T> preOrderFind(T item) { . . .}

// getter and setter methods

. . .

public class BinaryTree<T> {

protected BinaryTreeNode<T> rootTreeNode;

public BinaryTree(BinaryTreeNode<T> root) {

this.rootTreeNode = root;

}

// tree traversals

public BinaryTreeNode<T> inOrderFind(T item) {

return rootTreeNode.inOrderFind(item);

}

public BinaryTreeNode<T> preOrderFind(T item) { ... }

public BinaryTreeNode<T> postOrderFind(T item) { ... }

public BinaryTreeNode<T> postOrderFindStack(T item) { ... }

//getter and setter methods

. . .

4-4

4 Datentypen: Bäume, Heaps

4.1 Baumdurchläufe

Bäume können auf verschiedene Arten durchlaufen werden. Die bekanntesten Verfahren sind Tiefensuche (depth-first-search, DFS) und Breitensuche (breadth-first-search, BFS). Tiefensuche kann unterschieden werden in die drei Typen präorder, postorder und inorder, abhängig von der Reihenfolge der

rekursiven Aufrufe.

4.1.1 Tiefensuche

Präorder

• Betrachte zuerst den Knoten (die Wurzel des Teilbaums),

• durchsuche dann den linken Teilbaum,

• durchsuche zuletzt den rechten Teilbaum.

Inorder

• Durchsuche zuerst den linken Teilbaum,

• betrachte dann den Knoten,

• durchsuche zuletzt den rechten Teilbaum.

Postorder

• Durchsuche zuerst den linken Teilbaum,

• durchsuche dann den rechten Teilbaum,

• betrachte zuletzt den Knoten.

4.1 Baumdurchläufe

.

. .

..

.

.

.

. . . .

..

. ..

.

4-5

.

. .

. ..

.

.

.

. . . .

..

. ..

Wir betrachten als Beispiel für die Tiefensuche den Präorder-Durchlauf.

public BinaryTreeNode<T> preOrderFind(T item) {

if (data.equals(item))

return this;

if (leftChild != null) {

BinaryTreeNode<T> result = leftChild.preOrderFind(item);

if (result != null)

return result;

}

if (rightChild != null) {

BinaryTreeNode<T> result = rightChild.preOrderFind(item);

if (result != null)

return result;

}

return null;

4-6

4 Datentypen: Bäume, Heaps

}

4.1.2 Tiefensuche mit Hilfe eines Stacks

Mit Hilfe eines Stacks können wir die rekursiven Aufrufe in der präorder Tiefensuche vermeiden. Auf dem

Stack werden die später zu behandelnden Baumknoten zwischengespeichert.

public BinaryTreeNode<T> preOrderFindStack(T item) {

Stack<BinaryTreeNode<T>> stack = new Stack<BinaryTreeNode<T>>();

stack.push(this.rootTreeNode);

while (!stack.isEmpty()) {

BinaryTreeNode<T> tmp = stack.pop();

if (tmp.getData().equals(item))

return tmp;

if (tmp.getRightChild() != null)

stack.push(tmp.getRightChild());

if (tmp.getLeftChild() != null)

stack.push(tmp.getLeftChild());

}

return null;

}

4.1 Baumdurchläufe

4-7

4.1.3 Breitensuche mit Hilfe einer Queue

Bei der Breitensuche besucht man jeweils nacheinander die Knoten der gleichen Ebene:

• Starte bei der Wurzel (Ebene 0).

• Bis die Höhe des Baumes erreicht ist, setze den Level um eines höher und gehe von links nach

rechts durch alle Knoten dieser Ebene.

.

.

.

. . . .

..

. ..

Bei diesem Verfahren geht man nicht zuerst in die Tiefe, sondern betrachtet von der Wurzel aus zuerst

alle Elemente in der näheren Umgebung. Um mittels Breitensuche (levelorder) durch einen Baum zu

wandern, müssen wir uns alle Baumknoten einer Ebene merken. Diese Knoten speichern wir in einer

Queue ab, so dass wir später darauf zurückgreifen können.

public BinaryTreeNode<T> levelOrderFind(T item) {

QueueImpl<BinaryTreeNode<T>> queue = new QueueImpl<BinaryTreeNode<T>>();

queue.add(rootTreeNode);

while (!queue.isEmpty()) {

BinaryTreeNode<T> tmp = queue.poll();

if (tmp.getData().equals(item))

return tmp;

if (tmp.getLeftChild() != null)

queue.add(tmp.getLeftChild());

if (tmp.getRightChild() != null)

queue.add(tmp.getRightChild());

}

return null;

}

4-8

4 Datentypen: Bäume, Heaps

4.2 Binäre Suchbäume

Ein binärer Suchbaum ist ein Baum, welcher folgende zusätzliche Eigenschaft hat:

Alle Werte des linken Nachfolger-Baumes eines Knotens K sind kleiner, alle Werte des rechten

Nachfolger-Baumes von K sind grösser als der Wert von K selber.

Der grosse Vorteil von binären Suchbäumen ist, dass wir sowohl beim Einfügen als auch beim Suchen

von Elementen immer bloss einen der zwei Nachfolger untersuchen müssen. Falls der gesuchte Wert

kleiner ist als der Wert des Knotens, suchen wir im linken Teilbaum, anderenfalls im rechten Teilbaum

weiter.

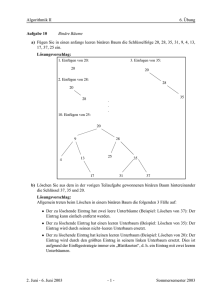

Beispiel: Die folgenden zwei Bäume entstehen durch Einfügen der Zahlen 37, 43, 53, 11, 23, 5, 17, 67,

47 und 41 in einen leeren Baum. Einmal werden die Zahlen von vorne nach hinten eingefügt, das zweite

Mal von hinten nach vorne.

4.2 Binäre Suchbäume

public class BinarySearchTreeNode <T extends Comparable<T>> {

public void add(T item) {

int compare = data.compareTo(item);

if (compare > 0) {

// (data > item)?

if (leftChild == null)

leftChild = new BinarySearchTreeNode<T>(item);

else

leftChild.add(item);

// left recursion

} else {

// (item >= data)

if (rightChild == null)

rightChild = new BinarySearchTreeNode<T>(item);

else

rightChild.add(item);

// right recursion

}

}

public BinarySearchTreeNode<T> find(T item) {

int compare = data.compareTo(item);

if (compare == 0)

return this;

if (compare > 0 && leftChild != null) // data > item

return leftChild.find(item);

if (compare < 0 && rightChild != null) // data < item

return rightChild.find(item);

return null;

}

. . .

}

4-9

4-10

4 Datentypen: Bäume, Heaps

4.3 B-Bäume

Ein B-Baum ist ein stets vollständig balancierter und sortierter Baum. Ein Baum ist vollständig balanciert,

wenn alle Äste gleich lang sind. In einem B-Baum darf die Anzahl Kindknoten variieren. Ein 3-4-5 BBaum ist zum Beispiel ein Baum, in welchem jeder Knoten maximal 4 Datenelemente speichern und

jeder Knoten (ausser der Wurzel und den Blättern) minimal 3 und maximal 5 Nachfolger haben darf (der

Wurzelknoten hat 0-4 Nachfolger, Blätter haben keine Nachfolger).

Durch die flexiblere Anzahl Kindknoten ist das Rebalancing weniger häufig nötig.

Ein Knoten eines B-Baumes speichert:

•

•

•

•

eine variable Anzahl s von aufsteigend sortierten Daten-Elementen k1 , . . . , ks

eine Markierung isLeaf, die angibt, ob es sich bei dem Knoten um ein Blatt handelt.

s + 1 Referenzen auf Kindknoten, falls der Knoten kein Blatt ist.

Jeder Kindknoten ist immer mindestens zur Hälfte gefüllt.

Die letzte Bedingung lautet formal: es gibt eine Schranke m, so dass m <= s <= 2m gilt. Das heisst,

jeder Kindknoten hat mindestens m, aber höchstens 2m Daten-Elemente.

Die Werte von k1 , . . . , ks dienen dabei als Splitter. Die Daten-Elemente der Kindknoten ganz links müssen

kleiner sein als k1 , diejenigen ganz rechts grösser als ks . Dazwischen müssen die Daten-Elemente des

i-ten Kindes grösser als ki und kleiner als ki+1 sein.

Das folgende Bild zeigt einen B-Baum mit m gleich 2. Jeder innere Knoten hat also mindestens 2 und

maximal 5 Nachfolger.

4.3 B-Bäume

4-11

Operationen in B-Bäumen

Suchen

Die Suche nach einem Datenelement e läuft in folgenden Schritten ab: Beginne bei der Wurzel als aktuellen Suchknoten k.

• Suche in k von links her die Position p des ersten Daten-Elementes x, welches grösser oder gleich e

ist.

•

•

•

•

Falls alle Daten-Elemente von k kleiner sind als e, führe die Suche im Kindknoten ganz rechts weiter.

Falls x gleich e ist, ist die Suche zu Ende.

Anderfalls wird die Suche beim p-ten Kindelement von k weitergeführt.

Falls k ein Blatt ist, kann die Suche abgebrochen werden (fail).

Einfügen

Beim Einfügen muss jeweils beachtet werden, dass nicht mehr als 2m Daten-Elemente in einem Knoten

untergebracht werden können.

Zunächst wird das Blatt gesucht, in welches das neue Element eingefügt werden müsste. Dabei kann

gleich wie beim Suchen vorgegegangen werden, ausser dass wir immer bis zur Blatt-Tiefe weitersuchen

(sogar, wenn wir den Wert unterwegs gefunden haben). Falls es in dem gesuchten Blatt einen freien

Platz hat, wird der Wert dort eingefügt.

Einfügen des Werts 31 in den folgenden Baum:

4-12

4 Datentypen: Bäume, Heaps

Der Wert 31 sollte in das Blatt (30,34,40,44) eingefügt werden. Dieses ist aber bereits voll, muss also

aufgeteilt werden. Dies führt dazu, dass der Wert in der Mitte (34) in den Vorgänger- Knoten verschoben

wird. Da das alte Blatt ganz rechts vom Knoten (20,28) liegt, wird der Wert 34 rechts angefügt (neuer,

grösster Wert dieses Knotens). Damit erhält dieser Knoten neu 3 Werte und 4 Nachfolger.

Dieser Prozess muss eventuell mehrmals (in Richtung Wurzel) wiederholt werden, falls durch das Hochschieben des Elements jeweils der Vorgänger-Knoten ebenfalls überläuft.

4.3 B-Bäume

4-13

Löschen von Elementen

Beim Löschen eines Elementes muss umgekehrt beachtet werden, dass jeder Knoten nicht weniger als

m Datenelemente enthalten muss.

Falls das gelöschte Element in einem Blatt liegt, welches mehr als m Datenelemente hat, kann das

Element einfach gelöscht werden. Andernfalls können entweder Elemente vom benachbarte Blatt verschoben oder (falls zu wenig Elemente vorhanden sind) zwei Blätter verschmolzen werden.

Verschiebung Aus dem linken B-Baum soll das Element 18 gelöscht werden. Dies würde dazu führen,

dass das linke Blatt zu wenig Datenelemente hat. Darum wird aus dem rechten Nachbarn das kleinste

Element nach oben, und das Splitter-Element des Vorgängers in das linke Blatt verschoben.

Analog könnte (falls vorhanden) aus einem linken Nachbarn das grösste Element verschoben werden.

Falls ein Element eines inneren Knotens (z.B. das Element 34) gelöscht wird, muss entweder von den

linken Nachfolgern das grösste, oder von den rechten Nachfolgern das kleinste Element nach oben verschoben werden, damit weiterhin genügend Elemente (als Splitter) vorhanden sind, und die Ordnung

bewahrt wird.

4-14

4 Datentypen: Bäume, Heaps

Verschmelzung Aus dem linken B-Baum soll das Element 60 gelöscht werden. Dies würde dazu führen,

dass das mittlere Blatt zu wenig Datenelemente hat. Weder der rechte noch der linke Nachbar hat

genügend Elemente, um eine Verschiebung durch zu führen - es müssen zwei Blätter verschmolzen

werden.

Das linke Blatt erhält vom mittleren Blatt das Element 55, sowie von der Wurzel das Element 50. Die

Wurzel muss ebenfalls ein Element abgeben, da nach der Verschmelzung bloss noch 2 Nachfolge-Knoten

existieren. Das rechte Blatt bleibt unverändert.

Mit Hilfe der Verschiebung- und Verschmelzungs-Operation können wir nun beliebige Elemente aus einem B-Baum löschen.

Beispiel

Aus dem folgenden Baum löschen wir zuerst das Element 75, danach das Element 85:

4.4 Priority Queues

4-15

4.4 Priority Queues

In vielen Applikationen will man die verschiedenen Elemente in einer bestimmten Reihenfolge (Priorität)

abarbeiten. Allerdings will man das (aufwändige!) Sortieren dieser Elemente nach möglichkeit vermeiden.

Eine der bekanntesten Anwendungen in diesem Umfeld sind Scheduling-Algorithmen mit Prioritäten. Alle

Prozesse werden gemäss ihrer Priorität in einer Priority Queue gesammelt, so dass immer das Element

mit höchster Priorität verfügbar ist. Priority Queues haben aber noch weit mehr Anwendungen, zum

Beispiel bei Filekomprimierungs- oder bei Graph-Algorithmen.

Eine elegante Möglichkeit der Implementierung einer Priority Queue ist mit Hilfe eines Heaps.

4.4.1 Heaps

Ein Heap ist ein (fast) vollständiger Baum, in welchem nur in der untersten Ebene von rechts her Blätter

fehlen dürfen.

65

56

52

37

25

48

31

18

45

6

3

15

4-16

4 Datentypen: Bäume, Heaps

Definition: [Heap] Ein Heap ist ein vollständiger binärer Baum, dem nur in der untersten Ebene ganz

rechts Blätter fehlen dürfen mit folgenden Zusatzeigenschaften.

1. Jeder Knoten im Baum besitzt eine Priorität und eventuell noch weitere Daten.

2. Die Priorität eines Knotens ist immer grösser als (oder gleich wie) die Priorität der Nachkommen.

Diese Bedingung heisst Heapbedingung.

Aus der Definition kann sofort abgelesen werden, dass die Wurzel des Baumes die höchste Priorität

besitzt. Weil der Heap im wesentlichen ein vollständiger binärer Baum ist, lässt er sich einfach als Array2

implementieren. Wir numerieren die Knoten des Baumes von oben nach unten und von links nach rechts.

Die so erhaltene Nummerierung ergibt für jeden Knoten seinen Index im Array.

Die dargestellten Werte im Baum sind natürlich bloss die Prioritäten der Knoten. Die eigentlichen Daten

lassen wir der Einfachheit halber weg.

public class Heap<T extends Comparable<T>> {

private List<T> heap;

public Heap() { heap = new ArrayList<T>(); }

public T removeMax() { . . . }

public void insert(T data) { . . . }

private

private

private

private

boolean isLeaf(int position) { . . . }

int parent(int position) { . . . }

int leftChild(int position) { . . . }

int rightChild(int position){ . . . }

2 Dies hat den Nachteil, dass die maximale Anzahl Elemente (size ) beim Erzeugen des Heaps bekannt sein muss.

4.4 Priority Queues

4-17

65

56

52

37

25

48

31

18

15

45

6

3

...

Werden die Knoten auf diese Weise in den Array abgelegt, so gelten für alle i, 0 ≤ i < length die

folgenden Regeln:

• Der linke Nachfolger des Knotens i befindet sich im Array-Element

Ferner gilt: heap[i]

heap[

]

• Der rechte Nachfolger des Knotens i befindet sich im Array Element

Ferner gilt: heap[i]

heap[

]

• Der direkte Vorfahre eines Knotens i befindet sich im Array-Element

Ferner gilt: heap[i]

heap[

]

Wir sind jetzt in der Lage, die beiden wichtigen Operationen insert und removeMax zu formulieren.

4-18

4 Datentypen: Bäume, Heaps

insert Da ein Element hinzugefügt werden muss, erhöhen wir zuerst length um eins. Das neue Element

wird dann an der Stelle length-1 eingefügt. Der Array repräsentiert immer noch einen vollständigen

binären Baum mit nur rechts unten fehlenden Blättern. Das neue Element verletzt aber eventuell die

Heapbedingung. Um wieder einen Heap zu erhalten, vertauschen wir das neue Element solange mit

seinen direkten Vorgängern, bis die Heapbedingung wieder erfüllt ist.

Diese Methode verfolgt einen direkten Weg von einem Blatt zur Wurzel. Da der binäre Baum vollständig