Kapitel 3 Eigenschaften des OLS

Werbung

Kapitel 3

Eigenschaften des OLS-Schätzers

“Die Mathematik ist eine Art Spielzeug,

welches die Natur uns zuwarf zum Troste

und zur Unterhaltung in der Finsternis.”

(Jean le Rond d’Alembert, 1717 - 1783)

Im letzten Kapitel haben wir den OLS-Schätzer hergeleitet. Ein Schätzer (‘estimator’ ) ist vereinfacht gesprochen eine Formel, die uns – wenn wir die Stichprobendaten einsetzen – Schätzungen (‘estimations’ ) für die unbeobachtbaren Parameter der

Grundgesamtheit liefert, zum Beispiel die Schätzungen b0 und b1 einer Regressionsgerade yi = b0 + b1 xi + ei für die wahren Parameter der Grundgesamtheit β0 und

β1 .

Wenn wir aus einer Grundgesamtheit (bzw. aus einem datengenerierenden Prozess

DGP) verschiedene Stichproben ziehen erhalten wir für jede Stichprobe unterschiedliche Schätzungen für die wahren Parameter der Grundgesamtheit.

Deshalb können die aus einer Stichprobe geschätzten Parameter (z.B. die Koeffizienten der Stichprobenregressionsfunktion) als Zufallsvariablen angesehen werden, von

denen man die Momente1 berechnen kann. Mit den Verteilungen dieser Zufallsvariablen, den so genannten Stichprobenkennwertverteilungen (‘sampling distributions’ ),

werden wir uns in diesem Kapitel etwas näher beschäftigen.

Im Abschnitt über die Monte Carlo Simulationen haben wir bereits gezeigt, dass die

Idee der wiederholten Stichprobenziehungen (‘repeated sampling’ ) ganz natürlich zur

Idee der Stichprobenkennwertverteilungen führt. Dort haben wir zwar gesehen, dass

aufgrund des Gesetzes der Großen Zahl der Mittelwert der Stichprobenkennwertverteilungen meist ‘ziemlich’ genau dem wahren Wert der Grundgesamtheit entspricht,

und dass aufgrund des Zentralen Grenzwertsatzes bei einer genügend großen Anzahl

von Ziehungen die Stichprobenkennwertverteilung einer Normalverteilung ‘ziemlich’

ähnlich sieht, aber dies gab uns nur eine intuitive Vorstellung, keine ‘hard facts’ mit

denen man rechnen kann.

1

Momente sind Kenngrößen einer Zufallsvariablen, bzw. einer Verteilungsfunktion. Das k-te

zentrale Moment ist definiert als

µk = E[x − E(x)]k

Das zentrale Moment erster Ordnung (für k = 1) ist stets gleich Null (µ1 = 0), da µ1 = E(x−µ)1 =

µ−µ = 0; das zentrale Moment zweiter Ordnung (für k = 2) ist die Varianz (µ2 = E[x−E(x)]2 ), das

zentrale Moment dritter Ordnung ist die Schiefe, das zentrale Moment vierter Ordnung entspricht

der Wölbung bzw. Kurtosis.

89

Eigenschaften des OLS-Schätzers

90

In diesem Kapitel werden wir diese Idee etwas weiter treiben und den Erwartungswert und die Varianz der Stichprobenkennwertverteilungen der geschätzten Koeffizienten b0 und b1 allgemein berechnen. Diese werden uns im nächsten Kapitel schließlich die Durchführung von Hypothesentests erlauben.

Vorher werden wir uns aber noch in diesem Kapitel mit einigen statistischen Eigenschaften des OLS-Schätzers beschäftigen. Wir haben im letzten Kapitel mehrmals

erwähnt, dass OLS-Schätzer ‘bestmögliche’ Schätzer sind, ohne allerdings genauer

zu spezifizieren, was wir darunter verstehen. Dies werden wir in diesem Kapitel

nachholen.

Das Konzept der Stichprobenkennwertverteilungen erlaubt es uns nämlich, die Eigenschaften von Schätzfunktionen etwas präziser zu definieren. Konkret wünschen

wir uns Schätzfunktionen, die ‘im Durchschnitt richtig’ und ‘möglichst genau’ sind.

Mit ‘im Durchschnitt richtig’ meinen wir, dass der Erwartungswert) der Stichprobenkennwertverteilung gleich dem wahren Wert der Grundgesamtheit sein sollte. In

der Sprache der Ökonometrikerinnen wird diese Eigenschaft einer Schätzfunktion

Erwartungstreue genannt. Mit ‘möglichst genau’ meinen wir, dass die Stichprobenkennwertverteilung eine möglichst kleine Varianz haben sollte, oder etwas genauer,

dass die Varianz der Stichprobenkennwertverteilung der OLS Schätzer kleiner sein

sollte als die Varianz der Stichprobenkennwertverteilungen aller vergleichbaren alternativen Schätzfunktionen. Eine Schätzfunktion, die diese zweite Eigenschaft erfüllt,

wird in der Sprache der Ökonometrikerinnen ‘effizient’ genannt.

In diesem Kapitel werden wir zuerst zeigen, dass die OLS-Schätzer unter bestimmten Annahmen tatsächlich erwartungstreu und effizient sind (d.h. genauer sind als

alle anderen vergleichbaren linearen Schätzfunktionen). Dies ist das Ergebnis des bekannten Gauss-Markov Theorems, das in der Ökonometrie eine zentrale Rolle spielt.

Tatsächlich wird sich ein großer Teil dieser Veranstaltung mit der Frage beschäftigen, was zu tun ist, wenn eine oder mehrere der Gauss-Markov Annahmen verletzt

sind. Da das Gauss-Markov Theorem in der Ökonometrie eine derart grundlegende

Rolle spielt, werden wir es etwas ausführlicher beweisen.

Die Erwartungstreue und Effizienz der OLS-Schätzer, die mit Hilfe des GaussMarkov Theorems bewiesen werden, sind sogenannte ‘Kleine Stichprobeneigenschaften’, d.h. sie gelten auch in kleinen Stichproben (oder genauer, unabhängig von der

Stichprobengröße).

Leider lassen sich diese ‘Kleine Stichprobeneigenschaften’ in komplizierteren Fällen

nicht immer beweisen (z.B. wenn einige der Gauss-Markov Annahmen nicht erfüllt

sind). Deshalb werden wir im letzten Abschnitt einige ‘asymptotische Eigenschaften’

diskutieren. Die wichtigste dieser asymptotischen Eigenschaften ist die Konsistenz.

Etwas vereinfachend gesprochen ist eine Schätzfunktion konsistent, wenn sie mit

zunehmender Stichprobengröße ‘immer genauer’ wird.

Schließlich werden wir noch ganz kurz den ‘mittleren quadratischen Fehler’ (mean

square error ) vorstellen.

Nach dieser etwas ausführlichen Vorschau können wir uns nun an die Arbeit machen.

Für alle, denen dieses Kapitel etwas schwierig erscheint, ein kleiner Trost vorab: dieses Kapitel wird im übernächsten Kapitel Schritt für Schritt wiederholt – allerdings

in Matrixschreibweise.

91

Eigenschaften des OLS-Schätzers

3.1

Kleine Stichprobeneigenschaften

Kleine Stichprobeneigenschaften sind – wie bereits erwähnt – unabhängig von der

Stichprobengröße gültig, das heißt, sie gelten auch in kleinen Stichproben. Die beiden

wichtigsten ‘kleine Stichprobeneigenschaften’ sind:

1. Erwartungstreue (Unverzerrtheit): Eine Schätzfunktion b für den wahren Wert

β der Grundgesamtheit ist erwartungstreu (‘unbiased ’), wenn

E(b) = β

und zwar für jeden beliebigen Stichprobenumfang N.

Bei nicht erwartungstreuen Schätzern wird E(b)−β Verzerrung (bias) genannt.

Erinnern wir uns, der Erwartungswert ist einfach ein mit den Wahrscheinlichkeiten gewichtetes Mittel über alle möglichen Ausprägungen einer Zufallsvariable. Erwartungstreue sagt also nichts über das Ergebnis einer einzelnen

Schätzung aus, sondern ist eine Eigenschaft einer Schätzfunktion. Dahinter

steht meist die Vorstellung eines ‘repeated sampling’.

2. Effizienz: Eine Schätzfunktion heißt effizient, wenn sie

• erwartungstreu ist, und

• varianzminimal unter allen vergleichbaren erwartungstreuen Schätzfunktionen ist:

var(b) ≤ var(b∗ )

wobei b∗ jede beliebige lineare und erwartungstreue Schätzfunktion für β

sein kann. Effizienz bezieht sich immer auf die theoretische Varianz und

beruht auf einem Vergleich von Schätzfunktionen, ist also ein relatives

Konzept. Deshalb muss stets angeben werden, innerhalb welcher Klasse

von Schätzfunktionen ein Schätzer effizient ist. In diesem Kapitel werden

wir zeigen, dass der OLS-Schätzer unter einer Reihe von Annahmen innerhalb der Klasse aller unverzerrten linearen Schätzfunktionen effizient

ist.

Wie schon erwähnt, diese Eigenschaften beziehen sich nicht auf eine gegebene Stichprobe, sondern auf Erwartungswerte, d.h. das gemittelte Ergebnis wiederholter

Stichprobenziehungen (repeated sampling)!

3.1.1

Einführung und Wiederholung

Zur Erläuterung starten wir mit einem bekannten Fall aus der einführenden Statistik,

einer univariaten Zufallsvariable y. Dabei wird üblicherweise angenommen, dass alle

Beobachtungen aus der gleichen Verteilung gezogen wurden (also identisch verteilt

sind), und dass die einzelnen yi untereinander statistisch unabhängig sind. Dies

wird üblicherweise mit iid abgekürzt für ‘independent and identically-distributed’.

Zudem nehmen wir an, dass der Erwartungswert von y in der Grundgesamtheit µ

sei (d.h. E(y) = µ), und dass die theoretische Varianz eine endliche Zahl σ 2 sei

92

Eigenschaften des OLS-Schätzers

(d.h. var(y) = σ 2 ). Man beachte, dass die empirische Varianz, die auf Grundlage

von Realisationen berechnet wird, immer eine endliche Zahl ist, dies muss für die

theoretische Varianz aber keineswegs gelten.

Dieser datengenerierende Prozess (DGP) wird kompakt angeschrieben als

yi ∼ iid(µ, σ 2 )

Aus der Statistik wissen wir, dass unter diesen Annahmen der Mittelwert einer

Stichprobe ȳ ein unverzerrter Schätzer für den Mittelwert der Grundgesamtheit µ

ist

E(ȳ) = µ

Die Verteilung dieser Stichprobenmittelwerte ȳ, die man bei wiederholten Stichprobenziehungen erhält, ist eine Stichprobenkennwertverteilung (sampling distribution).

In der einführenden Statistik wird gezeigt, dass die Varianz der Mittelwerte gleich

der Varianz der Grundgesamtheit (var(y) := σ 2 ) dividiert durch die Stichprobengröße N ist:

σ2

var(ȳ) := σȳ2 =

N

Da die Varianz der Grundgesamtheit σ 2 üblicherweise ebensowenig beobachtbar ist

wie der Mittelwert µ der Grundgesamtheit, muss die ‘wahre’ Varianz σ 2 ebenfalls aus

der Stichprobe geschätzt werden. Den Schätzer für die Varianz der Grundgesamtheit

σ 2 bezeichnen wir mit s2 (in der Literatur wird für den Schätzer von σ 2 manchmal

auch das Symbol σ

b2 verwendet, d.h. s2 := σ

b2 ).

In der einführenden Statistik (sowie im statistischen Appendix) wird gezeigt, dass

im Fall univariater Verteilungen der Schätzer

s2 =

1 X

(yi − ȳ)2

N −1 i

ein erwartungstreuer Schätzer für die Varianz der Grundgesamtheit σ 2 ist.

Genau das gleiche wollen wir nun für den bivariaten Fall

yi = b0 + b1 xi + ei

zeigen, nur untersuchen wir anstelle der Stichprobenkennwertverteilung des Mittelwertes ȳ (der als Schätzer für µ verwendet wird) die Stichprobenkennwertverteilungen von b0 und b1 , die als Schätzer für β0 und β1 dienen.

Wir werden im Folgenden annehmen, dass die erklärende Variable x deterministisch

(d.h. nicht stochastisch) ist. Im Zusammenhang mit wiederholten Stichprobenziehungen (‘repeated sampling’) bedeutet dies, dass immer nur neue yi generiert werden,

da bei jedem Durchgang ein neuer Störterm εi gezogen wird, nicht aber die x; d.h.

wir nehmen an, die x sind ‘fixed in repeated sampling’. Konkret nehmen wir im

Folgenden an, dass die x keine Zufallsvariablen sind.

Dies mag vielleicht etwas willkürlich erscheinen, denn tatsächlich gibt es häufig keinen vernünftigen Grund anzunehmen, warum nur die y stochastisch sein sollen und

93

Eigenschaften des OLS-Schätzers

die x nicht, werden doch häufig sowohl die x als auch die y von datengenerierenden

Prozessen (DGP) erzeugt, die außerhalb unserer Einflussnahme stehen.

Wenn wir zum Beispiel eine Konsumfunktion ‘Konsumausgabeni = b0 +

b1 Einkommeni + ei ’ schätzen, so macht es tatsächlich wenig Sinn anzunehmen, dass

die Konsumausgaben stochastisch sind, das Einkommen aber deterministisch sei.

Der einzige Grund für die Annahme deterministischer x ist tatsächlich, dass dies die

folgenden Ableitungen ganz erheblich erleichtern wird. Allerdings ist diese Annahme

nicht ganz so streng wie es auf den ersten Blick scheinen mag. Wir werden später

sehen, dass die meisten Schlussfolgerungen auch für stochastische x gültig bleiben,

wenn (und nur wenn!) die x und die ε in der Grundgesamtheit unkorreliert (oder

genauer, stochastisch unabhängig) sind.

In anderen Worten, das meiste was wir im folgenden zeigen werden gilt asymptotisch

(d.h. für sehr große Stichproben) auch für stochastische x, solange – vereinfacht gesprochen – die Kausalität eindeutig von x zu y läuft, oder in anderen Worten, wenn

der datengenerierende Prozess, der die x erzeugt, unabhängig ist vom datengenerierenden Prozess ist, der die y erzeugt.

3.1.2

Erwartungstreue der geschätzten OLS-Koeffizienten

Wir werden nun zeigen, dass der auf Seite 52 berechnete Schätzer

P

P

P

ẍi yi

(xi − x̄)yi

ẍi ÿi

i

i

b1 = P 2 = P 2 := Pi

2

i ẍi

i ẍi

i (xi − x̄)

(mit i = 1, . . . , N) tatsächlich erwartungstreu ist (zwei Punkte über einer Variable

bezeichnen wieder Abweichungen vom Mittelwert, z.B. ẍi := xi − x̄).

Dazu ist es wichtig zu erkennen, dass diese Schätzfunktion für b1 linear in den yi ist,

d.h. der Schätzer b1 kann auch geschrieben werden als

b1 =

N

X

wi y i

(3.1)

i=1

d.h. b1 ist eine gewichtete Summe der yi mit den Gewichten

ẍi

wi := PN

2

j=1 ẍj

(xi − x̄)

:= P

2

j (xj − x̄)

Dies ist unproblematisch, da die xi annahmegemäß deterministisch sind (‘fixed in repeated sampling). Offensichtlich ist b1 also eine lineare Schätzfunktion; der geschätzte

Parameter b1 ist eine Linearkombination der stochastischen yi , wobei die wi die (deterministischen) Gewichte darstellen, die eine Funktion der x sind.

P

Die Gewichte wi := ẍi / j ẍ2j haben drei wichtige Eigenschaften, die wir gleich

benötigen werden:

1.

X

i

wi = 0 (die Summe der Gewichte ist Null)

94

Eigenschaften des OLS-Schätzers

da

X

wi =

i

2.

X

i

ẍ

Pi 2

j ẍj

!

P

ẍi

= Pi 2 = 0

j ẍj

mit i, j = 1, . .P

. , N, weil

Pdie Summe der Abweichungen vom Mittelwert immer

Null ist, d.h.

ẍi := (xi − x̄) = N x̄ − N x̄ = 0!

X

i

da

wi2 = 1/

X

ẍ2i

i

X

wi2

=

i

ẍ

Pi 2

j ẍj

i

mit i, j = 1, . . . , N.

X

X

3.

wi ẍi =

wi xi = 1

i

X

!2

P

ẍ2

1

= P i 2i 2 = P 2

ẍi

( i ẍi )

i

wir zeigen, dass

P

wi xi = 1

P

X

(xi − x̄)xi

wi xi = P

(xi − x̄)2

P 2

P

xi − x̄ xi

P

= P 2

xi − 2x̄ xi + N x̄2

P 2

x − N x̄2

= P 2 i

x − 2N x̄2 + N x̄2

P 2i

x − N x̄2

= P i2

xi − N x̄2

= 1

i

(da

X

xi = N x̄)

Mit diesen drei Eigenschaften ‘bewaffnet’ können wir uns nun an den eigentlichen

Beweis für die Erwartungstreue machen.

Beweis der Erwartungstreue: Um die Unverzerrtheit (Erwartungstreue) von

b1 zu zeigen müssen wir einen Zusammenhang zwischen der Schätzfunktion b1 und

dem entsprechenden Wert β1 der Grundgesamtheit herstellen, und davon den Erwartungswert bilden.

Dazu wird in der Regel nach dem folgenden Muster vorgegangen: man setzt den wahren Zusammenhang der Grundgesamtheit, yi = β0 + β1 xi + εi , in die Schätzfunktion

(3.1) ein:

X

X

b1 =

wi y i =

wi (β0 + β1 xi + εi )

i

= β0

X

i

= β1 +

i

wi + β1

X

i

X

i

wi εi

wi xi +

X

wi εi

i

(3.2)

95

Eigenschaften des OLS-Schätzers

da wir gerade gezeigt haben, dass

P

wi = 0 und

Nun bilden wir davon den Erwartungswert

E(b1 ) = E

β1 +

= β1 +

X

X

wi εi

i

!

E(wi εi )

i

= β1 +

X

i

= β1 + E

E

P

ẍ ε

Pi i 2

j ẍj

P

wi xi = 1.

(weil E(c) = c)

!

− x)(εi − 0)

2

i (xi − x)

i (x

Pi

(3.3)

Der OLS-Schätzer b1 für β1 ist nur dann erwartungstreu, d.h. E(b1 ) = β1 , wenn die

x mit den Störtermen ε der Grundgesamtheit im Erwartungswert unkorreliert sind,

oder genauer, wenn die erklärenden x Variablen und die Störterme ε der Grundgesamtheit stochastisch unabhängig sind.

Man beachte, dassP

aus der Mechanik des OLS Schätzers (d.h. aus den Bedingungen

1. Ordnung) zwar i xi ei = 0 folgt, dass dies aber nur für die Stichprobe gilt, nicht

notwendigerweise aber für die Störterme εi der Grundgesamtheit!

Wie wir aus Gleichung (3.3) erkennen können, gilt E(b1 ) = β1 nur, wenn die Störterme der Grundgesamtheit nicht mit der erklärenden Variable x korreliert sind! Wann

immer cov(x, ε) 6= 0 ist der OLS Schätzer verzerrt!

Exogenität: x Variablen, die mit den Störtermen ε der Grundgesamtheit unkorreliert sind (oder genauer, stochastisch unabhängig sind), nennt man in der Ökonometrie exogene Regressoren. In anderen Worten, exogene Regressoren sind unkorreliert mit der nicht-systematischen (unbeobachteten) Komponente von y. Umgekehrt

werden x Variablen, die mit dem Störterm ε korreliert sind, endogene Regressoren

genannt.

Wie aus Gleichung (3.3) hervorgeht, führen endogene Regressoren immer zu einem

Bias, d.h. verzerrten Schätzungen.

Leider sind endogene Regressoren ein ziemlich häufiges Problem, es gibt mehrere Ursachen die zu einer stochastischen Abhängigkeit zwischen Störtermen ε und

erklärenden Variablen x führen. Einige Beispiele dafür sind Messfehler in den xVariablen, wenn relevante x Variablen nicht berücksichtigt wurden, oder wenn die

Variablen durch ein simultanes System erzeugt werden.

In solchen Fällen von Endogenität sind – wie wir soeben gesehen haben – die OLSSchätzer systematisch verzerrt! Diese ‘tieferen’ Probleme werden wir erst in späteren

Kapiteln ausführlich diskutieren.

Im Moment wollen wir uns das Leben aber noch einfach machen und deterministische x annehmen. Wenn xi deterministisch ist, ist natürlich auch wi deterministisch

(‘fixed in repeated sampling’ ), also können die wi vor den Erwartungswertoperator

96

Eigenschaften des OLS-Schätzers

geschrieben werden. Für deterministische x reicht die wesentlich weniger strenge

Annahme E(εi ) = 0, damit der Schätzer unverzerrt ist, denn

X

E(b1 ) = β1 +

wi E(εi )

= β1

wenn E(εi ) = 0

Viel einfacher lässt sich zeigen, dass b0 = ȳ − b1 x̄ ebenfalls ein unverzerrter Schätzer

für β0 ist

E(b0 ) = E[(β0 + β1 x̄) − b1 x̄)] = β0

Wir fassen zusammen: b1 = cov(y, x)/ var(x) ist ein erwartungstreuer (unverzerrter)

Schätzer für β1 , wenn die Störterme der Grundgesamtheit εi mit den xi unkorreliert

sind. Bei deterministischen x reicht die wesentlich weniger strenge Annahme E(εi ) =

0.

Wir halten also fest, dass die OLS-Schätzer zumindest bei deterministischen x erwartungstreu sind, wenn E(εi ) = 0!

3.1.3

Die Varianz und Kovarianz der geschätzten OLS Koeffizienten

Wir haben mehrfach betont, dass die geschätzten Koeffizienten b0 und b1 Zufallsvariablen sind. Den Erwartungswert dieser Koeffizienten haben wir bereits berechnet

und festgestellt, dass die OLS-Schätzer zumindest für deterministische x erwartungstreu sind!

Als nächstes wollen wir die Varianzen von b0 und b1 berechnen. Diese Varianzen

werden es uns schließlich erlauben statistische Tests durchzuführen.

Die Varianz von b1 ist definiert

var(b1 ) = E[b1 − E(b1 )]2

= E[b1 − β1 ]2

(da E(b1 ) = β1 , siehe oben)

!2

X

X

= E

wi εi

(da b1 = β1 +

wi εi ; s. Gleichung (3.2))

i

2 2

w1 ε1

2 2

= E

+ w22 ε22 + · · · + wN

εN + · · ·

· · · + 2w1 w2 ε1 ε2 + · · · + 2wN −1 wN εN −1 εN )

(3.4)

Dieser letzte Ausdruck ist mit all den Kreuztermen etwas ‘unappetitlich’ lang, um

hier weiter zukommen benötigen wir zusätzliche Annahmen über die Störterme εi .

Das Problem wird massiv vereinfacht, wenn wir

εi ∼ iid 0, σ 2

annehmen.

Dies ist eine sehr kompakte Schreibweise für εi ist unabhängig und identisch verteilt

(iid steht für ‘independent and identically distributed’ ) mit E(εi ) = 0 und var(εi ) =

97

Eigenschaften des OLS-Schätzers

σ 2 ; das heißt, vor der Klammer steht die Art der Verteilung, das erste Argument

in der Klammer ist der Erwartungswert, das zweite Argument die Varianz (generell

werden in der Klammer die Parameter der Verteilung angegeben, in diesem Fall sind

dies Erwartungswert und Varianz).

Im einzelnen umfasst dies folgende Annahmen:

1. alle Störterme εi sind identisch verteilt (d.h. werden aus der gleichen Verteilung gezogen); dies kommt im zweiten i von iid (identically distributed ) zum

Ausdruck. Die Varianz dieser Verteilungen ist konstant, d.h. eine reelle Zahl

σ 2 . Anders ausgedrückt, alle εi haben die gleiche Varianz σ 2 . Ist diese Annahme erfüllt spricht man von homoskedastischen Störtermen, ist die Annahme

verletzt spricht man von Heteroskedastizität.

2. Unabhängigkeit der Ziehungen, d.h. E(εi εj ) = 0 für i 6= j (dies impliziert auch

cov(εi , εj ) = 0 für i 6= j); dies kommt im ersten i von iid (independent) zum

Ausdruck. Wenn diese Annahme verletzt ist spricht man von Autokorrelation.

3. E(εi ) = 0: Diese Annahme haben wir bereits für den Beweis der Erwartungstreue benötigt. (Wenn die x stochastisch sind wird die wesentlich strengere

Annahme E(εi |x) = 0 benötigt, d.h. der bedingte Erwartungswert der εi muss

Null sein. Damit werden wir uns erst später beschäftigen.)

Um Gleichung (3.4) zu vereinfachen benötigen wir die ersten zwei dieser drei Annahmen, d.h E(ε2i ) = σ 2 und E(εi εj ) = 0 für i 6= j.

Wenn die Annahme E(εi εj ) = 0 erfüllt ist (d.h. keine Autokorrelation vorliegt) fallen

die Kreuzterme in Gleichung (3.4) weg, deshalb gilt bei Gültigkeit dieser Annahme

!

X

2 2

var(b1 ) = E

wi εi

i

Wenn die xi (und damit automatisch auch die wi ) deterministisch sind können die

wi vor den Erwartungswertoperator gezogen werden

X

var(b1 ) =

wi2 E(ε2i )

i

Wenn zusätzlich die erste Annahme E(ε2i ) = σ 2 (keine Heteroskedastizität) erfüllt

ist gilt schließlich

X

X

var(b1 ) =

wi2 σ 2 = σ 2

wi2

i

i

2

da σ ein fixer Parameter der Grundgesamtheit ist.

Nun haben wir bereits vorhin gezeigt (Seite 94), dass

P

wi2

=

Deshalb ist die Varianz des OLS-Schätzers für b1 gleich

σ2

2

i (xi − x̄)

var(b1 ) = P

P

(

P

ẍ2i

ẍ2i )

2

=

P

1

.

(xi −x̄)2

98

Eigenschaften des OLS-Schätzers

yi = 0.5 + 0.7xi + εi ,

ε ∼ N (0, 2)

yi = 0.5 + 0.7xi + εi ,

ε ∼ N (0, 0.5)

y

6

b

y

6

b

b

5

b

b

5

b

b

b

b

b

b

4

4

b

b

b

b

b

3

b

b

b

b

2

3

2

b

b

b

1

b

1

b

0

0

1

b

2

3

4

5

6

7

x

b

b

0

0

1

2

3

4

5

6

7

x

Abbildung 3.1: ‘Wahrer’ Zusammenhang (‘Population Regression Function’)

strichliert) und Stichprobenregessionsfunktionen mit unterschiedlicher Varianz von ε (σ 2 ).

Dies ist ein wichtiges Ergebnis! Die Varianz von b1 ist ein Maß für die ‘Genauigkeit’

des Schätzers, d.h. ein Schätzer ist umso genauer, je kleiner die Varianz von b1

ist. Anhand dieser Formel können wir bereits erkennen, wovon die Präzision des

Schätzers für die Steigung β1 abhängt. Ceteris paribus ist die Varianz von b1 umso

kleiner, . . .

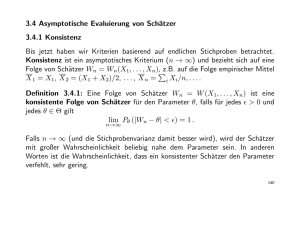

1. . . . je kleiner die Varianz der Grundgesamtheit σ 2 ist. Abbildung 3.1 zeigt zwei

Stichproben, die sich nur in der Varianz der Grundgesamtheit σ 2 unterscheiden

(die ‘Population Regression Function’ oder PRF ist in beiden Fällen yi =

0.5 + 0.7xi + εi , aber im linken Panel ist σ 2 = 0.5, im rechten Panel ist σ 2 = 2).

Offensichtlich ist die Schätzung umso genauer, je kleiner σ 2 ist!

P

2

2. . . . je größer die Streuung der x, d.h.

i (xi − x̄) ist, da diese im Nenner

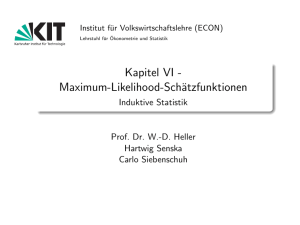

steht. Abbildung 3.2 zeigt zwei Stichproben mit gleichem σ 2 , die sich nur in

der Streuung der x unterscheiden (im linken Panel liegen die x zwischen 0.5

und 7, im rechten Panel zwischen 2.5 und 4.5. Offensichtlich ist die Schätzung

umso genauer, je größer die Streuung (bzw. Varianz) der x ist!

P

2

3. . . . je größer der Stichprobenumfang N ist, da N

i=1 (xi − x̄) mit dem Stichprobenumfang N zunimmt. Offensichtlich können wir b1 umso genauer schätzen,

je größer die Stichprobe ist.

Ähnlich (wenngleich etwas mühsamer) kann man zeigen, dass die Varianz des

Interzepts b0 folgendermaßen berechnet werden kann:

P 2

x

Pi 2

var(b0 ) = E[b0 − E(b0 )] = σ

N ẍi

2

2

99

Eigenschaften des OLS-Schätzers

yi = 0.5 + 0.7xi + εi ,

εi ∼ N (0, 0.5)

yi = 0.5 + 0.7xi + εi ,

εi ∼ N (0, 0.5)

y

6

y

6

b

b

5

b

4

5

b

b

4

b

b

b

b

b

b

3

b

b

b

2

3

b

b

b b

b

b

b

b

1

b

0

0

b

b

b

2

b

1

b

1

2

3

4

5

6

7

0

x

0

1

2

3

4

5

6

7

x

Abbildung 3.2: Unterschiedliche Varianz der x, ‘Wahrer’ Zusammenhang (Population Regression Function PRF, strichliert) und SRF (Sample

Regression Function, durchgezogen).

Da b0 und b1 Zufallsvariablen sind kann man auch die Kovarianz zwischen den

beiden Schätzern berechnen. Diese ist definiert

cov(b0 , b1 ) = E{[b0 − E(b0 )][b1 − E(b1 )]}

= E[(b0 − β0 )(b1 − β1 )]

Wir erinnern uns, dass b0 = ȳ − b1 x̄ und bei Erwartungstreue von b1 gilt E(b0 ) =

ȳ − β1 x̄. Daraus folgt b0 − E(b0 ) = −x̄(b1 − β1 ).

Wenn wir dies oben einsetzen erhalten wir

cov(b0 , b1 ) = E[(b0 − β0 )(b1 − β1 )]

= −x̄ E(b1 − β1 )2

= −x̄ var(b1 )

Die Kovarianzen zwischen den Koeffizienten werden wir später für Tests von gemeinsamen Hypothesen (‘joint hypothesis’ ) benötigen.

Wir fassen zusammen: unter den bisher getroffenen Annahmen deterministischer x

und εi ∼ iid(0, σ 2 ) gilt

E(b1 ) = β1

var(b1 )

=

E(b0 ) = β0

var(b0 )

=

cov(b0 , b1 ) =

2

P σ

[xi −x̄]2

P 2

σ2

xi

P

N [xi −x̄]2

2

P−x̄σ 2

[xi −x̄]

100

Eigenschaften des OLS-Schätzers

3.1.4

Ein Schätzer für die Varianz des Störterms der Grundgesamtheit σ 2

Nun haben wir zwar einen Schätzer für b0 und b1 sowie eine Formel für deren Varianzen, aber in diesen Formeln für die Varianzen kommt die unbekannte Varianz des

Störterms der Grundgesamtheit σ 2 vor.

Deshalb müssen wir als nächstes einen erwartungstreuen Schätzer s2 (bzw. σ

b2 ) für

das wahre σ 2 der Grundgesamtheit herleiten.

2

Leider

P kommt das σ 2in dem nach der OLS Methode zu minimierenden Ausdruck

min i (yi − b0 − b1 xi ) nicht vor, deshalb müssen wir im folgenden einen indirekten

und teilweise etwas mühsamen Weg gehen, um einen Schätzer für σ 2 zu erhalten.2

Wir erinnern uns, das wahre Modell der Grundgesamtheit ist

yi = β0 + β1 xi + εi

und für die Mittelwerte gilt3

ȳ = β0 + β1 x̄ + ε̄

Das Modell in Abweichungsform ist also

yi − ȳ = β1 (xi − x̄) + (εi − ε̄)

Man beachte, dass das Interzept β0 bei der Differenzenbildung wegfällt.

Wir sind an einem Schätzer für die Varianz der unbeobachtbaren Störterme der

Grundgesamtheit εi interessiert. Da wir diese nicht kennen ist es naheliegend, dazu

von den beobachtbaren Stichprobenresiduen e auszugehen. Deshalb versuchen wir

einen Zusammenhang zwischen den Störtermen ε und den Stichprobenresiduen e

herzustellen (bzw. zwischen deren Varianzen).

Dazu setzen wir den wahren Zusammenhang der Grundgesamtheit ÿi = β1 ẍi +(εi −ε̄)

in den Stichproben-Zusammenhang ei = ÿi − b1 ẍi ein und erhalten

ei = β1 ẍi + (εi − ε̄) − b1 ẍi = (β1 − b1 )ẍi + (εi − ε̄)

Wir sind letztendlich an einer Varianz interessiert, deshalb quadrieren wir diesen

Ausdruck

e2i = (b1 − β1 )2 ẍ2i + (εi − ε̄)2 − 2(b1 − β1 )ẍi (εi − ε̄)

P

und summieren über alle N Beobachtungen auf (beachte, dass N

i=1 ẍi = 0)

X

X

X

X

e2i = (b1 − β1 )2

ẍ2i +

(εi − ε̄)2 − 2(b1 − β1 )

ẍi εi

und nehmen von beiden Seiten den Erwartungswert

hX i

hX

i

h

i

X

X

e2i = E(b1 − β1 )2

ẍ2i + E

E

(εi − ε̄)2 − 2E (b1 − β1 )

ẍi εi

|

{z

} |

{z

} |

{z

}

A

2

3

B

C

Die

P folgenden Ausführungen

P

Phalten sich eng an Gujarati 1995.

i y i = N β0 + β1

i xi +

i εi . Dividieren durch N gibt ȳ = β0 + β1 x̄ + ε̄.

101

Eigenschaften des OLS-Schätzers

Die folgende Rechnerei ist etwas umständlich, sie werden später sehen, dass sich dies

in Matrixschreibweise deutlich einfacher darstellen lässt.

Nun aber ans Werk! Wir haben bereits gezeigt dass

σ2

σ2

var(b1 ) = E(b1 − β1 )2 = P 2 = P

2

ẍi

i (xi − x̄)

Daraus folgt, dass der erste Term A = σ 2 .

P

Der zweite Term B = E [ i (εi − ε̄)2 ] = (N − 1)σ 2 , wenn die εi ∼ iid(0, σ 2 ), denn

"

#

"

#

X

X

2

2

2

E

(εi − ε̄)

= E

(εi − 2εi ε̄ + ε̄ )

i

i

= E

X

i

1 X

εj

N j

ε2i − 2εi

!

+

1 X

εj

N j

!2

#

X

X

1

E

εj ) +

=

E(εi )2 − 2E

(εi

N

j

i

i

i

!

X 2

X 1 X

E(εi )2 +

E(εj )2

= Nσ 2 −

2

N

N

i

i

j

!

X

X 1 X

2

σ2 +

σ2

= Nσ 2 −

2

N i

N j

i

X

X

"

1 X

εj

N j

!2

= Nσ 2 − 2σ 2 + σ 2

= (N − 1)σ 2

wobei wiederholt von den Annahmen E(εi )2 = σ 2 und E(εi εj ) = 0 für i 6= j (d.h.

Unabhängigkeit) Gebrauch gemacht wird.

Übungsaufgabe: Zeigen Sie, dass E(ε̄2 ) = σ 2 /N. Welche Annahmen sind dazu

erforderlich?

P

Für den dritten Term C = 2E [(b1 − β1 ) ẍi εi ] berücksichtigen wir, dass

P

P

P

ẍi ÿi

ẍi (β1 ẍi + εi )

ẍi εi

i

i

P 2

b1 = P 2 =

= β1 + Pi 2

i ẍi

i ẍi

i ẍi

P

P 2

P

weshalb

ẍi εi ] unter

i ẍi εi = (b1 − β1 )

i ẍi . Einsetzen in C = 2E [(b1 − β1 )

P

.

. . xi gibt

Berücksichtigung von var(b1 ) = E[b1 − E(b1 )]2 = σ 2 /

i

"

C = 2E (b1 − β1 )

2

X

i

ẍ2i

#

P

2σ 2 i ẍ2i

= P 2 = 2σ 2

i ẍi

Wir fassen nun die Terme A, B und C zusammen

hX i

E

e2i = σ 2 + (N − 1)σ 2 − 2σ 2 = (N − 2)σ 2

102

Eigenschaften des OLS-Schätzers

Daraus können wir wieder einen erwartungstreuen Schätzer für die Varianz der

Grundgesamtheit σ 2 bestimmen, denn aus der letzten Gleichung folgt

P

E( e2i )

= σ2

N −2

Also ist

P 2

ei

2

s :=

N −2

2

ein erwartungstreuer Schätzer für σ , weil E(s2 ) = σ 2 .

Wir können also tatsächlich aus den Stichprobenresiduen ei einen erwartungstreuen Schätzer s2 für die VarianzPder Grundgesamtheit σ 2 berechnen, indem wir die

Quadratsumme der Residuen i e2i durch die Anzahl der Freiheitsgrade N − 2 dividieren.

Die Wurzel dieses erwartungstreuen Schätzers wird in der Literatur Standardfehler

der Regression (‘standard error of regression’ oder ‘standard error of estimate’)

genannt

s := σ

b=

sP

2

i ei

N −2

(3.5)

Man beachte aber, dass wir für die Herleitung wiederholt die Annahme gemacht

haben, dass die Varianz der Störterme konstant ist, E(ε2i ) = σ 2 (d.h. keine Heteroskedastizität vorliegt), und dass die Störterme untereinander unkorreliert sind,

E(εi εj ) = 0 für i 6= j (d.h. keine Autokorrelation vorliegt).

Ist mindestens eine dieser Annahmen verletzt wird der nach obiger Formel berechnete Standardfehler der Regression falsche Ergebnisse liefern, d.h. ein verzerrter

Schätzer für σ 2 sein.4

Freiheitsgrade: Wir haben gesehen, dass wir zur Berechnung eines P

erwartungs2

treuen Schätzers für σ 2 die Quadratsumme der Stichprobenresiduen

i ei durch

N − 2 dividieren müssen, nicht durch N, wie man das ad hoc erwarten würde.

Warum ist das so?

Die Schätzung von Parametern ist eng verbunden mit der jeweils zur Verfügung stehenden Information. Für eine intuitive Erklärung erinnern wir uns an die Herleitung

des OLS-Schätzers. Dazu haben wir folgenden Ausdruck minimiert

min

b0 ,b1

N

X

i=1

e2i

= min

b0 ,b1

N

X

(yi − b0 − b1 xi )2

i=1

Für jeden zu schätzenden Parameter erhalten wir eine Bedingungen erster Ordnung

P

X

X

∂ e2i

= −2

(yi − b0 − b1 xi ) = −2

ei = 0

|

{z

}

∂b0

ei

P 2

X

X

∂ ei

= −2

(yi − b0 − b1 xi ) xi = −2

xi ei = 0

|

{z

}

∂b1

ei

4

Man beachte aber, dass wir diese beiden Annahmen nicht benötigt haben, um die Erwartungstreue der Schätzer b0 und b1 zu zeigen.

103

Eigenschaften des OLS-Schätzers

Diese beiden Gleichungen legen eine Restriktion auf die Residuen. Wenn wir z.B.

nur die Residuen e1 , e2 , . . . , eN −2 kennen würden, könnten wir die beiden fehlenden

P

Residuen

eN −1 und eN mit Hilfe dieser beiden Bedingungen 1. Ordnung i ei =

P

0,

i xi ei = 0 berechnen. Zwei der Residuen sind deshalb nicht ‘frei’, sondern

sind durch die Bedingungen erster Ordnung determiniert, und enthalten deshalb

‘keine Information’ über die Störterme der Grundgesamtheit εi . Da wir für jeden

zu schätzenden Parameter eine Bedingung erster Ordnung haben, verlieren wir mit

jedem geschätzten Parameter einen Freiheitsgrad. In diesem Fall haben wir zwei

Parameter geschätzt (b0 und b1 ), deshalb verlieren wir zwei Freiheitsgrade.

Mit Hilfe des Schätzers s (Standardfehler der Regression) können wir nun die erwartungstreuen Schätzer für die Varianz der Parameter b0 und b1 , d.h. s2b0 und s2b1

aus den Stichprobendaten berechnen, die uns später die Durchführung statistischer

Tests ermöglichen wird.

Wir fassen nochmals zusammen:

b1

=

s2b1

=

b0

s2b0

P

(xi − x̄)(yi − ȳ)

P

(xi − x̄)2

2

s

P

(xi − x̄)2

= ȳ − b1 x̄

P 2

s2

xi

P

=

N (xi − x̄)2

−x̄s2

P

(xi − x̄)2

P 2

ei

2

:= σ̂ =

N −2

cov(b0 , b1 ) =

s2

3.2

Gauss-Markov Theorem

“Beweisen muss ich diesen Käs’,

sonst ist die Arbeit unseriös.”

(F. Wille)

Bisher haben wir uns ausschließlich mit der Erwartungstreue des OLS-Schätzers und

mit der Schätzung von dessen Varianz beschäftigt. In diesem Abschnitt werden wir

nun die Effizienz des OLS-Schätzers beweisen. Das Gauss-Markov Theorem besagt

nämlich, dass der OLS-Schätzer unter bestimmten Annahmen von allen möglichen

linearen und erwartungstreuen Schätzfunktionen die kleinste Varianz hat, bzw.

104

Eigenschaften des OLS-Schätzers

Unter den (Gauss’schen) Annahmen des ‘klassischen linearen Regressionsmodells’ hat der OLS-Schätzer innerhalb der Klasse aller

linearen und erwartungstreuen Schätzfunktionen die kleinste Varianz, oder in anderen Worten, er ist BLUE, d.h. ein Best Linear

Unbiased Estimator.

Die

P OLS-Schätzfunktion

P 2

P ist – wie wir bereits gesehen haben – linear, da z.B. b1 =

( i ẍi / j ẍj ) yi = wi yi .

Wir werden nun zeigen, dass – wenn die unten angeführten Gauss-Markov Annahmen erfüllt sind – der OLS-Schätzer effizient ist, d.h. var(bOLS ) ≤ var(b∗ ) wobei b∗

jede beliebige lineare und erwartungstreue Schätzfunktion für β sein kann.

Das Gauss-Markov Theorem und die zugrunde liegenden Gauss-Markov Annahmen spielen in der Ökonometrie eine ähnlich fundamentale Rolle wie das Modell

vollständiger Konkurrenz in der Mikroökonomik, sie stellen das Referenzmodell

schlechthin dar. Einen Großteil der restlichen Veranstaltung werden wir uns mit

Fällen beschäftigen, wenn die Gauss-Markov Annahmen nicht erfüllt sind. Einige

dieser Annahmen haben wir bereits bei der Herleitung des Schätzers für σ 2 kennen

gelernt, aber wir werden sie nun noch einmal ausführlich und etwas übersichtlicher

zusammenstellen.

3.2.1

Annahmen des ‘klassischen linearen Regressionsmodells’ (CLRM)

Die Annahmen beziehen sich auf die funktionale Spezifikation des Modells (Annahme 1), auf den Störterm (Annahmen 2 – 4) oder auf die erklärenden Variablen x

(Annahmen 5 – 8).

1. Die wahre Beziehung zwischen den erklärenden Variablen x und der zu erklärenden Variablen y (d.h. die ‘Population Regression Function’ ) ist linear in

den Parametern (Wahl der richtigen Funktionsform). Wenn wir K erklärende

x Variablen haben

yi = β0 + β1 x1i + β2 x2i + · · · + βK xKi + εi

Die Parameter der Grundgesamtheit β0 , β1 , . . . , βK gelten für alle N Beobachtungen und sind konstant.

Außerdem sei das Regressionsmodell korrekt spezifiziert, d.h. es wurden die

‘richtigen’ x Variablen gewählt (Wahl der richtigen Variablen). Das bedeutet, es fehlen keine relevanten x Variablen, und die im Modell verwendeten x

Variablen sind nicht irrelevant.

2. Die Störterme ε der Grundgesamtheit haben einen Erwartungswert Null:

E(εi ) = 0

105

Eigenschaften des OLS-Schätzers

Y vs. X

Y vs. X

600

900

500

800

400

700

300

Y

Y

600

200

500

100

400

0

300

-100

200

-200

0

20

40

60

80

100

0

20

X

40

60

80

100

X

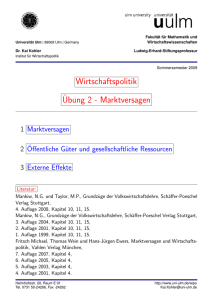

Abbildung 3.3: Heteroskedastische Störterme: Die Varianz der Störterme σ 2 ist

nicht konstant.

3. Homoskedastizität: alle εi haben die gleiche konstante Varianz σ 2 :

var(εi ) := E[εi − E(εi )]2 = E(εi )2 = σ 2

Wenn die Residuen diese Annahme verletzen spricht man von Heteroskedastizität. Abbildung 3.3 zeigt zwei Regressionen, bei denen die Annahme einer

konstanten Varianz der Grundgesamtheit offensichtlich verletzt ist, bei denen

also Heteroskedastizität vorliegt.

4. Die Störterme ε der Grundgesamtheit sind nicht autokorreliert, d.h. die Korrelation zwischen den Störtermen εi und εj für i =

6 j ist gleich Null:

E (εi εj ) = 0

für i 6= j

Wie bereits mehrfach erwähnt impliziert diese Annahme auch Cov(εi , εj ) = 0,

aber umgekehrt folgt aus einer Kovarianz von Null nicht notwendigerweise

stochastische Unabhängigkeit, da die Kovarianz nur lineare Abhängigkeiten

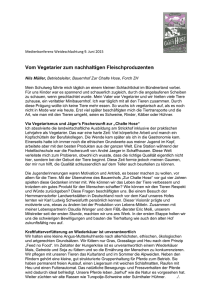

misst. Abbildung 3.4 zeigt zwei Fälle mit autokorrelierten Störtermen.

Die drei vorhergehenden Annahmen betreffen den Störterm der Grundgesamtheit und können folgendermaßen kompakt angeschrieben werden

εi ∼ iid(0, σ 2 )

Die restlichen Annahmen betreffen die erklärenden Variablen x.

5. Die erklärenden Variablen x sind deterministisch, d.h. die x werden bei wiederholten Stichprobenziehungen (‘repeated sampling’) als fest gegebene (deterministische) Größen angenommen. Da wir uns für die Parameter β0 , β1 und

σ 2 der bedingten Verteilung f (y|x) interessieren darf die Randverteilung von

x, d.h. f (x) keine Information über β0 , β1 oder σ 2 enthalten. Dies wird der

Fall sein, wenn der datengenerierende Prozess, der die x erzeugt, unabhängig

vom Prozess ist, der die y erzeugt.

106

Eigenschaften des OLS-Schätzers

Positive Autokorrelation: ρ = +0.8

yi = 0.5 + 0.7xi + εi , (strichliert)

εi = 0.8εi−1 + εi , εi ∼ N (0, 1)

Negative Autokorrelation: ρ = −0.9

yi = 0.5 + 0.7xi + εi , (strichliert)

εi = −0.9εi−1 + εi , εi ∼ N (0, 1)

y

6

y

6

‘Wahrer’ Zusammenhang

ŷ = β0 + β1 x

5

‘Wahrer’ Zusammenhang

ŷ = β0 + β1 x

5

b

b

4

b

3

b

2

b

b

b

OLS

ŷ = b0 + b1 x

b

b

b

b

b

b

b

b

3

b

2

b

1

OLS

ŷ = b0 + b1 x

b

4

b

b

1

b

0

0

1

2

3

4

5

6

7

x

0

0

1

2

3

4

5

6

7

x

Abbildung 3.4: Autokorrelierte Störterme: Die Störterme sind untereinander korreliert, d.h. Cov(εi , εj ) 6= 0 (strichlierte Linie:Population Regression Function, durchgezogene Linie:Sample Regression Function).

Wir werden später zeigen, dass die Annahme

E(εi |xi ) = E(εi ) = 0

das heißt, dass die auf x bedingten Erwartungswerte von ε gleich Null sind, stochastische Unabhängigkeit zwischen x und ε impliziert, was auch cov(εi , xi ) =

0 impliziert.

6. Die erklärenden Variablen x sind linear unabhängig (d.h. keine perfekte Multikollinearität).

7. Die Stichprobenvarianz von x, Var(xi ), ist eine positive und endliche Zahl.

8. Die Anzahl der Beobachtungen N ist größer als die Anzahl der zu schätzenden

Parameter K.

3.2.2

Beweis für die Effizienz des OLS-Schätzers

(Gauss-Markov Theorem)

Der Beweis der Effizienz des OLS-Schätzers ist einer der Höhepunkte jeder einführenden Ökonometrie-Veranstaltung, genießen Sie also das Folgende.5 Die Grundidee

dieses Beweises funktioniert folgendermaßen:

1. Wir gehen von einer beliebigen linearen Schätzfunktion aus.

2. Wir ermitteln die notwendigen Bedingungen, unter denen diese lineare Schätzfunktion erwartungstreu ist.

5

Wer mit dem ‘Genießen’ Probleme hat sei getröstet, Sie werden in der Veranstaltung auch

noch ‘Anwendungsorientierteres’ erleben.

107

Eigenschaften des OLS-Schätzers

3. Wir minimieren die Varianz dieser beliebigen linearen Schätzfunktion unter

der Nebenbedingung, dass diese lineare Schätzfunktion erwartungstreu ist.

4. Wir werden sehen, dass die aus der Minimierung resultierende – also varianzminimale – Schätzfunktion genau der OLS-Schätzer ist. Deshalb ist der OLS

Schätzer varianzminimal.

Allerdings werden wir im Laufe der Beweisführung einige Annahmen benötigen, die sogenannten Gauss-Markov Annahmen, die wir im letzten Kapitel

bereits aufgezählt haben, und deshalb gilt der Beweis nur unter Gültigkeit

dieser Annahmen.

Wir beginnen mit dem Steigungsparameter b1 . Um die Effizienz des OLS-Schätzers

b1 zu beweisen minimieren wir nun die Varianz von b1 unter der Nebenbedingung,

dass der Schätzer erwartungstreu sein soll.

Um die Bedingungen für die Erwartungstreue herzuleiten starten wir mit einer beliebigen linearen Schätzfunktion b̃1 (sprich b1 Schlange) für den Steigungsparameter

b̃1 =

N

X

ci y i

i=1

wobei die ci (beliebige) deterministische Gewichte sind und natürlich Funktionen

der xi sein können.

Unverzerrtheit bedeutet

E(b̃1 ) = β1

Einsetzen des obigen Schätzers gibt:

X

E(b̃1 ) = E(

ci y i )

X

=

ci E(yi )

(da ci deterministisch)

X

=

ci (β0 + β1 xi )

[E(εi ) = 0]

X

X

= β0

ci + β1

ci xi

X

X

= β1

wenn

ci = 0 und

ci xi = 1

P

Das

Schätzer für β1 ist müssen die Bedingungen

P heißt, damit

P ci yi ein unverzerrter

6

ci = 0 und

ci xi = 1 erfüllt sein.

Nun minimieren wir die Varianz von b1 unter diesen beiden Nebenbedingungen für

Unverzerrtheit.

Die Varianz von b̃1 ist

6

X

ci y i

var(b̃1 ) = var

X

=

c2i var (yi )

(weil die yi statistisch unabhängig sind)

X

X

=

c2i σ 2 = σ 2

c2i

Man beachte, dass die Gewichte wi = ẍi /

P

j

ẍ2j auf Seite 93 diese Bedingungen erfüllten.

108

Eigenschaften des OLS-Schätzers

da unter den Annahmen deterministischer x und E(εi ) = 0 gilt var(yi ) = var(εi ) =

σ 2 , weil var(yi ) := E[β0 +β1 xi +εi −E(β0 +β1 xi +εi )]2 = E[εi −E(εi )]2 ) = E(εi )2 = σ 2 .

Man beachte, dass wir dabei auch von den Gauss-Markov Annahmen über den

Störterm εi ∼ iid(0, σ 2 ) (d.h. unter anderem, keine Autokorrelation und keine Heteroskedastizität) Gebrauch gemacht haben.

Wir suchen nun P

die Gewichte cP

1 , c2 , . . . , cN , die die Varianz von b̃1 unter den Nebenbedingungen

ci = 0 und

ci xi = 1 (Erwartungstreue) minimieren. Dies ist

eine einfache Minimierungsaufgabe unter Nebenbedingungen und kann z.B. mit der

Lagrange Methode einfach gelöst werden. Da wir zwei Nebenbedingungen haben

benötigen wir zwei Lagrangemultiplikatoren λ1 und λ2 .

Die Lagrangefunktion ist

L(c1 , . . . , cN , λ1 , λ2 ) = σ 2

X

c2i − λ1

X X

ci − λ 2

ci xi − 1

und die Bedingungen erster Ordnung für ein Optimum sind

∂L

= 2c1 σ 2 − λ1 − λ2 x1 = 0

∂c1

∂L

= 2c2 σ 2 − λ1 − λ2 x2 = 0

∂c2

..

.

∂L

= 2cN σ 2 − λ1 − λ2 xN = 0

∂cN

X

∂L

=

ci = 0

∂λ1

X

∂L

=

ci xi − 1 = 0

∂λ2

Aus diesen N + 2 Gleichungen können die Unbekannten c1 , . . . , cN , λ1 und λ2 berechnet werden.

Die ersten N Gleichungen können geschrieben werden als

1

(λ1 + λ2 x1 )

2σ 2

1

=

(λ1 + λ2 x2 )

2σ 2

..

.

1

=

(λ1 + λ2 xN )

2σ 2

c1 =

c2

cN

Aufsummieren dieser Gleichungen gibt

X

i

da

P

i ci

ci = 0 =

X

1

(λ

N

+

λ

xi )

1

2

2σ 2

i

= 0 eine Bedingung erster Ordnung ist.

109

Eigenschaften des OLS-Schätzers

Wir können die erste Gleichung von obigem Gleichungssystem mit x1 , die zweite

mit x2 usw. multiplizieren

1

(λ1 x1 + λ2 x21 )

2

2σ

1

=

(λ1 x2 + λ2 x22 )

2

2σ

..

.

1

=

(λ1 xN + λ2 x2N )

2

2σ

c1 x1 =

c2 x2

cN xN

Aufsummieren gibt

X

i

wobei

P

i ci xi

1

ci xi = 1 = 2

2σ

λ1

X

xi + λ2

i

X

(x2i )

i

!

= 1 wieder eine Bedingung erster Ordnung ist.

Diese beiden Gleichungen können nach λ1 und λ2 gelöst werden (nicht so schüchtern,

versuchen Sie’s ruhig mal!)

P

−2σ 2 xi

P

P

λ1 =

N( x2i ) − ( xi )2

2Nσ 2

P 2

P

λ2 =

N( xi ) − ( xi )2

Diese Gleichungen können schließlich in

ci =

1

(λ1 + λ2 xi )

2σ 2

eingesetzt werden und geben die Lösung

P

Nxi − j xj

(xi − x̄)

ẍi

P 2

P

ci =

=P

=P 2

2

2

N( j xj ) − ( j xj )

j (xj − x̄)

j ẍj

P 2

P 2 P

1

Übungsaufgabe: Zeigen Sie, dass (x

)

−

(

xi ) = P(xi − x̄)2 . P

i

N

P

Hinweis: es ist einfacher zu zeigen, dass (xi − x̄)2 gleich (x2i ) − N1 ( xi )2 ist.

Deshalb ist

b̃1 =

n

X

i=1

P

ẍi yi

ci y i = P 2

ẍi

eine effiziente (d.h. erwartungstreue und varianzminimale) Schätzfunktion. Aber dies

ist genau die Gleichung des OLS-Schätzers (vgl. Seite 52). Damit haben wir gezeigt,

dass der OLS-Schätzer tatsächlich die minimale Varianz unter allen linearen erwartungstreuen Schätzfunktionen hat, wenn die Gauss-Markov Annahmen erfüllt sind.

QED

Dieser Ansatz liefert auch eine alternative Möglichkeit die

P Varianz von b1 zu berechnen, denn wir haben vorhin gezeigt, dass Var(b̃1 ) = σ 2 c2i .

110

Eigenschaften des OLS-Schätzers

Wir multiplizieren

P

Nxi − j xj

P

P

ci =

N( j x2j ) − ( j xj )2

mit ci und Summieren über alle i (für i, j = 1, . . . , N)

P

P P

X

N i (ci xi ) − i ci j xj

2

P

P

ci =

N( j x2j ) − ( j xj )2

Da

folgt

also

X

X

ci = 0

c2i =

N(

und

P

X

ci xi = 1

1

N

P 2 =P 2

− ( xi )

ẍi

x2i )

σ2

var(b̃1 ) = P 2

ẍi

Dies ist wiederum exakt die Varianz des OLS-Schätzers.

Ähnlich kann ein BLU7 Schätzer für b̃0 und dessen Varianz berechnet werden:

b̃0 = ȳ − b̃1 x̄

P

σ 2 ( x2i )

P

var(b̃0 ) =

N ẍ2i

Eine allgemeinere untere Abschätzung der Varianzen einer erwartungstreuen Schätzfunktion erlaubt die Rao-Cramer’sche Ungleichung (siehe z.B. Kmenta 1990, S.

160f, Frohn 1995).

3.3

Asymptotische Eigenschaften (‘Große Stichprobeneigenschaften’)

Wir haben bisher Schätzfunktionen für b0 und b1 hergeleitet, die es uns erlauben

aus den beobachtbaren Daten einer Stichprobe Informationen über interessierende

Parameter einer unbekannten Grundgesamtheit zu ermitteln. Um die Anwendbarkeit dieser Schätzer unter verschiedenen Bedingungen beurteilen zu können, müssen

deren Eigenschaften beurteilt werden können.

Die zwei wichtigsten Eigenschaften von Schätzfunktionen, die wir bisher untersucht

haben, sind die Unverzerrtheit und Effizienz. Diese Eigenschaften gelten unabhängig

von der Stichprobengröße, also auch in kleinen Stichproben. In manchen Fällen sind

auch die Stichprobenkennwertverteilungen von solchen Schätzern bekannt, zum Beispiel die Verteilung der Mittelwerte aus wiederholten Zufallsstichprobenziehungen,

die aus einer normalverteilten Grundgesamtheit gezogen wurden.

7

BLUE bedeutet Best Linear Unbiased Estimator, man spricht also von von einem BLU

Schätzer.

Eigenschaften des OLS-Schätzers

111

Aber oft kennt man die Verteilung der Grundgesamtheit nicht, und manchmal

können diese sogenannten ‘Kleine-Stichproben Eigenschaften’ aufgrund mathematischer Probleme nicht ermittelt werden. In solchen Fällen wird meist auf sogenannte

‘Große-Stichproben Eigenschaften’ (asymptotische Eigenschaften) zurückgegriffen.

Am einfachsten können die grundlegenden asymptotischen Konzepte anhand der

Verteilung des Mittelwertes einer Zufallsvariablen veranschaulicht werden. Sei X eine Zufallsvariable mit unbekannter Dichtefunktion, von der aber bekannt ist, dass

Mittelwert µ und Varianz σ 2 fixe Zahlen sind, d.h. nicht unendlich groß sind. Aus

dieser Verteilung werden N Zahlen gezogen und daraus der Stichprobenmittelwert

x̄N berechnet, wobei das tiefgestellte N angibt, auf wievielen Beobachtungen der

Stichprobenmittelwert beruht. Dieses N bringt zum Ausdruck, dass wir eigentlich

eine Folge von Schätzern untersuchen, denn wenn zusätzliche Beobachtungen dazukommen, ändert sich in der Regel auch die Schätzfunktion. Für den einfachen

Stichprobenmittelwert ist eine solche Folge von Schätzfunktionen z.B.

x1 + x2 + · · · + xN

x1 + x2 x1 + x2 + x3

,

,...,

{x̄}N = x1 ,

2

3

N

Diese Mittelwerte sind natürlich selbst wieder Zufallsvariablen mit einer Dichtefunktion f (x̄N ). Die asymptotische Theorie untersucht z.B., wie sich eine Zufallsvariable

x̄N und deren Verteilung verhält, wenn die Stichprobengröße N gegen Unendlich

geht, d.h. N → ∞.

Asymptotische Eigenschaften sind vor allem in Fällen von Bedeutung,

• in denen sich ‘kleine Stichprobeneigenschaften’ nicht ermitteln lassen, oder

• wenn man wissen möchte, ob sich der Erwartungswert einer verzerrten Schätzfunktion wenigstens mit steigender Stichprobengröße (d.h. für N → ∞) einem

wahren Parameter µ zubewegt.

Da die folgenden Ausführungen ziemlich allgemein gehalten sind schreiben wir θ für

einen beliebigen Parameter einer Verteilung, und mit θ̂ bezeichnen wir wie üblich

die Schätzfunktion für diesen Parameter (θ könnte zum Beispiel der Mittelwert µ

oder der Steigungskoeffizient β1 aus unserem früheren Beispiel sein).

3.3.1

Konsistenz (Consistency )

Die Konsistenz ist vermutlich die für uns wichtigste asymptotische Eigenschaft, da

sie in der Regel am einfachsten zu beweisen ist. Die Grundidee ist ziemlich einfach,

Konsistenz bedeutet einfach, dass ein Schätzer umso genauer werden sollte, umso

größer die Stichprobe ist.

Die formale Definition sieht zunächst etwas schwierig aus:

θ̂N ist eine konsistente Schätzfunktion für θ wenn gilt

h

i

lim P |θ̂N − θ| < δ = 1

δ>0

N →∞

das heißt, dass die Wahrscheinlichkeit(P ), dass mit steigendem Stichprobenumfang

der Absolutbetrag der Differenz zwischen θ̂N und θ kleiner als eine beliebig kleine

Zahl δ wird, gegen 1 konvergiert.

112

Eigenschaften des OLS-Schätzers

f (θ̂)

N = 10000

N = 1000

N = 100

N = 50

N = 10

θ θ̂100

θ̂10

θ̂

Abbildung 3.5: Konsistente Schätzer können in kleinen Stichproben verzerrt

sein, konvergieren aber mit steigendem Stichprobenumfang der

Wahrscheinlichkeit nach gegen den wahren Wert θ.

Etwas ungenau lässt sich dies folgendermaßen ausdrücken: wenn der Stichprobenumfang sehr sehr groß wird, wird es sehr wahrscheinlich, dass der Schätzer sehr nahe

beim wahren Wert θ der Grundgesamtheit liegt.

Wenn der Stichprobenumfang N unendlich groß wird “ kollabiert” die Dichtefunktion

einer konsistenten Schätzfunktion θ̂N im Punkt θ (siehe Abb. 3.5).

Eine hinreichende, aber nicht notwendige Bedingung für Konsistenz ist, dass

lim E(θ̂N ) = θ

N →∞

und

lim var(θ̂N ) = 0

N →∞

d.h. wenn der Schätzer asymptotisch unverzerrt 8 ist und die Varianz gegen Null

geht.

Um die tiefere Bedeutung der Konvergenz zu verstehen benötigt man einige Begriffe

aus der Stochastik, die hier nur ganz kurz gestreift werden.

Konvergenz der Wahrscheinlichkeit nach (‘Convergence in Probability’, auch

Stochastische Konvergenz genannt) ist ein zentrales Konzept zur Klärung des Verhaltens von Zufallsvariablen bei wachsendem Stichprobenumfang. Sie gibt – vereinfacht

gesprochen – an, in welchem Bereich sich im Falle unendlich vieler Experimente die

Zufallsvariable befindet. Das Konzept der stochastischen Konvergenz wird benötigt

um ‘Gesetze der großen Zahl’ zu beweisen.

Gesetze der großen Zahl Generell sind ‘Gesetze der großen Zahlen’ meist Aussagen über das Verhalten von Parametern (Mittelwerten oder anderen Momenten)

einer großen Zahl von Zufallsvariablen.

8

Asymptotische Erwartungstreue (Asymptotic Unbiasedness): θ̂N ist eine asymptotisch erwartungstreue Schätzfunktion für θ wenn gilt: limN →∞ E(θ̂N ) = θ.

113

Eigenschaften des OLS-Schätzers

Beispiel: Für eine unendliche Folge von Zufallsvariablen x1 , x2 , . . ., die alle denselben Erwartungswert µ besitzen, wird folgende Konvergenzaussage als (ein) schwaches Gesetz der großen Zahlen bezeichnet:

Das arithmetische Mittel von N Zufallsvariablen x̄N = (x1 + x2 + · · · + xN )/N

konvergiert stochastisch gegen µ; das bedeutet, für jede positive Zahl δ (beliebig

klein) gilt

lim P (|x̄N − µ| < δ) = 1

N →∞

Dieses schwache Gesetz der großen Zahl gilt beispielsweise, wenn die Zufallsvariablen

x1 , x2 , x3 , . . . endliche Varianzen σ12 , σ22 , . . . haben, die zudem durch eine gemeinsame obere Grenze beschränkt sind, sowie untereinander unkorreliert sind (d.h.,

Cov(xi , xj ) = 0, falls i 6= j).

Konsistenz eines Schätzers bedeutet, dass eine Folge von Schätzfunktionen θ̂N

stochastisch gegen das wahre θ konvergiert, also ein Gesetz der großen Zahl erfüllt

ist, oder in anderen Worten, eine Folge von Schätzfunktionen θ̂N konvergiert in

Wahrscheinlichkeit gegen den wahren Wert θ.

Dies wird oft kürzer geschrieben als

p

θ̂ −→ θ

Dafür hat sich auch die Notation des sogenannten probability-limits (plim) eingebürgert:

plim θ̂N = θ

ist also äquivalent zu

h

i

lim P |θ̂N − θ| < δ = 1

N →∞

δ>0

wobei δ beliebig klein gewählt werden kann.

Die Bedeutung der Konsistenz resultiert wesentlich daraus, dass das Rechnen mit

‘probability-limits’ relativ einfach ist.

Regeln für das Rechnen mit ‘probability-limits’

1. Wenn c eine Konstante ist gilt

plim c = c

2. Wenn θˆ1 und θˆ2 konsistente Schätzfunktionen sind gilt

plim (θ̂1 + θ̂2 ) = plim θ̂1 + plim θ̂2

plim (θ̂1 θ̂2 ) = plim θ̂1 plim θ̂2

plim

θ̂1

θ̂2

=

plim θ̂1

plim θ̂2

(für θ̂2 6= 0, plim θ̂2 6= 0)

Man beachte, dass die letzten beiden Eigenschaften für den Erwartungswertoperator nur dann gelten, wenn θˆ1 und θˆ2 stochastisch unabhängig sind. Aus

diesen Gründen ist Konsistenz üblicherweise einfacher zu beweisen als Erwartungstreue oder Effizienz.

114

Eigenschaften des OLS-Schätzers

3. Slutsky-Theorem: Wenn θ̂ eine konsistente Schätzfunktion für θ ist und h(θ̂)

eine stetige Funktion von θ̂ ist gilt:

plim h(θ̂) = h(θ)

Man sagt auch, dass sich die Konsistenz ‘überträgt’. Wenn θ̂ eine konsistente

Schätzfunktion für θ ist, dann ist z.B. 1/θ̂ auch eine konsistente Schätzfunktion

für 1/θ (für θ̂ 6= 0), oder ln θ̂ ist eine konsistente Schätzfunktion für für ln θ

(für θ̂ > 0). Dies gilt nicht für den Erwartungswertoperator!.

3.3.2

Beispiel: Unverzerrtheit und Konsistenz des OLSSchätzers bei stochastischen Regressoren (x)

Bisher haben wir angenommen, dass die erklärende Variable x deterministisch ist,

d.h. dass bei wiederholten Stichprobenziehungen nur verschiedene y gezogen werden,

aber die x fix gegeben sind.

In diesem Unterabschnitt interessieren uns die Eigenschaften des OLS-Schätzers,

wenn die erklärende Variable x ebenso stochastisch ist. Auf Seite 52 haben die die

Formel für den OLS-Schätzer bereits hergeleitet:

P

ẍi ÿi

b1 = P 2

ẍi

wobei ẍi = xi − x̄ und ÿi = yi − ȳ. Um die Erwartungstreue zu überprüfen setzen wir

wieder den wahren Zusammenhang ÿi = β1 ẍi +εi ein und bilden den Erwartungswert

P

ẍi εi

E[b1 ] = β1 + E P 2

ẍi

Wenn nun die ẍi stochastisch sind hängt die Erwartungstreue von der gemeinsamen Wahrscheinlichkeitsverteilung von ẍi und εi ab (man beachte, dass E(x/y) 6=

E(x)/ E(y)!).

Die Erwartungstreue des Schätzers b1 können wir nur zeigen wenn wir annehmen, dass alle ẍi (d.h. ẍ1 , ẍ2 , . . . ẍN ) stochastisch unabhängig von allen εi (d.h.

ε1 , ε2 , . . . εN ) sind. In diesem Fall gilt

P

X ẍi

ẍi εi

E P 2

=

E P 2 εi

ẍi

ẍi

X ẍi =

E P 2 E(εi )

ẍi

X (xi − x̄) =

E P

E(εi ) = 0

(xi − x̄)2

da E(εi ) = 0.

115

Eigenschaften des OLS-Schätzers

Um die Konsistenz zu zeigen bilden wir das probability-limit und wenden die entsprechenden Rechenregeln an

P

ẍi εi

plim b1 = plim β1 + plim P 2

ẍ

P

i

plim ẍi εi

P

= β1 +

plim ẍ2i

P

plim N1

ẍi εi

P 2

= β1 +

ẍi

plim N1

Wir haben Zähler und Nenner des zweiten Ausdrucks durch N dividiert und erhalten

damit konsistente Schätzer für die Varianz und Kovarianz der Grundgesamtheit.9

Der Schätzer b1 ist also konsistent, wann immer die Störterme der Grundgesamtheit

εi und die erklärenden Variablen ẍi unkorreliert sind, d.h. wenn

X

1

plim

ẍi εi = 0

N

da in diesem Fall

plim b1 = β1 +

0

= β1

σẍ

Im Unterschied zum Beweis für die Erwartungstreue müssen für Konsistenz nicht

alle x1 , x2 , . . . xN mit allen ε1 , ε2 , . . . εN unkorreliert sein, sondern es genügt für Konsistenz, wenn die xi einer Beobachtung oder Zeitperiode mit den entsprechenden εi

der gleichen Beobachtung oder Periode unkorreliert sind!

Wichtig ist aber nach wie vor die Annahme, dass die Störterme der Grundgesamtheit

εi mit dem Regressor xi unkorreliert sind. Ist diese Annahme nicht erfüllt ist der

OLS-Schätzer auch nicht konsistent!

Im wesentlichen verlangen wir von den Regressoren x also, dass sie nur über den

spezifizierten Zusammenhang yi = β0 + β1 xi + εi mit den y verknüpft sind, und

dass es keine anderen nicht spezifizierten Zusammenhänge zwischen x und y gibt –

wie z.B. bei simultanen Gleichungssystemen – da diese anderen nicht spezifizierten

Zusammenhänge eine Korrelation zwischen den ε und x bewirken würden, die zu

systematisch verzerrten Schätzern führt.

3.3.3

Asymptotische Normalverteilung

Ein Schätzer ist asymptotisch normalverteilt, wenn seine Stichprobenkennwertverteilung mit zunehmender Stichprobengröße gegen die Normalverteilung konvergiert.

Das dahinter liegende stochastische Konzept ist eine Konvergenz hinsichtlich der

Verteilung (‘Convergence in Distribution’ ). Vereinfacht gesprochen bedeutet dies,

dass die Verteilung einer Folge von Schätzern θ̂N aus Stichproben des Umfangs N,

die alle derselben Grundgesamtheit entnommen wurden, mit zunehmendem Stichprobenumfang in eine Normalverteilung übergeht, und das unabhängig von der Verteilung der Grundgesamtheit! Beweise der Konvergenz hinsichtlich der Verteilung

führen zu den Zentralen Grenzwertsätzen.

9

Ob wir durch N oder N − 1 dividieren spielt keine Rolle wenn N → ∞.

116

Eigenschaften des OLS-Schätzers

f (θ̂)

verzerrt, aber

kleine Varianz

erwartungstreu, aber

große Varianz

bc

b

θ

θ̂

Abbildung 3.6: Mean Square Error Abwägung zwischen erwartungstreuen

Schätzfunktionen mit großer Varianz und verzerrten Schätzfunktionen mit kleiner Varianz.

3.3.4

Asymptotische Effizienz

θ̂ sei ein Schätzer für θ. Die Varianz der asymptotischen Verteilung von θ̂ heißt

asymptotische Varianz von θ̂. Wenn θ̂ konsistent ist und die asymptotische Varianz

kleiner ist als die aller anderen konsistenten Schätzer, dann heißt θ̂ asymptotisch

effizient.

3.4

Der Mittlere Quadratische Fehler (Mean

Square Error, MSE)

Wir haben uns bisher nur mit erwartungstreuen Schätzfunktionen beschäftigt.

Manchmal ist aber keine erwartungstreue Schätzfunktion verfügbar. In solchen

Fällen wird manchmal auf den ‘Mean Square Error’ (MSE) zurückgegriffen, der

Varianz und Verzerrung zusammenfaßt und sich deshalb besonders zur Beurteilung

nicht erwartungstreuer Schätzfunktionen eignet (siehe Abb. 3.6).

Wir beginnen wieder ganz allgemein und bezeichnen einen interessierenden Parameter einer Verteilung mit θ, und den Schätzer für diesen Parameter mit θ̂. Eine

konkrete Schätzung erhält man, wenn man die Stichprobenbeobachtungen in die

Formel für θ̂ einsetzt.

Folgende Konzepte sind im folgenden von Bedeutung:

117

Eigenschaften des OLS-Schätzers

Stichprobenfehler

Verzerrung

Mean Square Error

Varianz

= θ̂ − θ

= E(θ̂) − θ

= E(θ̂ − θ)2

h

i2

= E θ̂ − E(θ̂)

Der Stichprobenfehler ist einfach der Unterschied zwischen dem Schätzer aus der

Stichprobe und dem wahren Wert der Grundgesamtheit. Die Größe des Stichprobenfehlers wird sich üblicherweise von Stichprobe zu Stichprobe unterscheiden. Die

Verzerrung ist die Differenz zwischen dem Mittelwert der Stichprobenverteilung eines

Schätzers und dem wahren Wert der Grundgesamtheit. Diese ist für einen Schätzer

ein fester Wert der Null oder ungleich Null sein kann, sich aber nicht zwischen

Stichproben unterscheidet.

Der Mean Square Error misst die Streuung der Verteilung eines Schätzers um den

wahren Wert. Er ähnelt darin der Varianz, aber während die Varianz die Streuung um den Erwartungswert der Verteilung misst, gibt der MSE die Streuung um

den wahren Wert an. Für erwartungstreue Schätzfunktionen sind Varianz und MSE

natürlich gleich, aber für nicht erwartungstreue Schätzfunktionen müssen sie unterschieden werden.

Dies kann folgendermaßen gezeigt werden:

E(θ̂ − θ)2

E[θ̂ − E(θ̂) + E(θ̂) − θ]2

E[θ̂ − E(θ̂)]2 + E[E(θ̂) − θ]2 + 2 E[θ̂ − E(θ̂)][E(θ̂) − θ]

E[θ̂ − E(θ̂)]2 + E[E(θ̂) − θ]2 +

+2{[E(θ̂)]2 − [E(θ̂)]2 − θ E(θ̂) + θ E(θ̂)}

= E[θ̂ − E(θ̂)]2 + E[E(θ̂) − θ]2

= Var(θ̂) + [Verzerrung(θ̂)]2

MSE(θ̂) =

=

=

=

Dieser Zusammenhang gilt für alle Schätzer. Akademische Forscher neigen oft dazu

unverzerrte Schätzer selbst auf Kosten eines größeren MSE zu bevorzugen, da sie

ihre Studie als eine von vielen Studien wahrnehmen und hoffen, dass sich die größere Streuung über die vielen Studien mittelt. In vielen praktischen Anwendungen

gibt es allerdings nur eine Schätzung (Studie), und da spielt es keine Rolle, ob der

Fehler aus einer systematischen Verzerrung oder einer größeren Varianz resultiert –

Fehler ist Fehler. Für Prognosen ist zum Beispiel ein kleiner MSE oft wichtiger als

Unverzerrtheit.