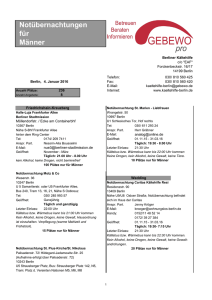

Diplomarbeit

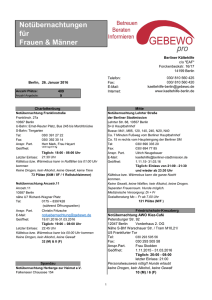

Werbung