Optisch-basiertes low-cost Referenzsystem für die inertiale Indoor

Werbung

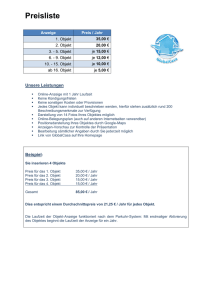

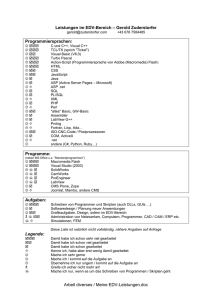

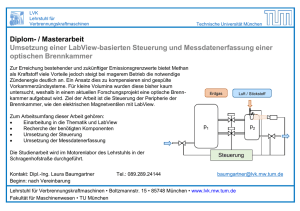

PräsentatiPP12 P12 Optisch-basiertes low-cost Referenzsystem für die inertiale Indoor-Navigation Haid, Markus; Schüller, Christian; Günes, Ersan; Chobtrong, Thitipun Competence Center for Applied Sensor Systems (CCASS), Hochschule Darmstadt, Birkenweg 8 64295 Darmstadt, E-Mail: [email protected], Tel.: 0170 1670205, Fax: 06151 16 8930, WWW: www.eit.h-da.de Kurzfassung Das vorliegende Entwicklungsprojekt, des Competence Center for Applied Sensor Systems (CCASS) der Hochschule Darmstadt, beschäftigt sich mit der optisch-basierten Orts und Lagebestimmung von Objekten im dreidimensionalen Raum als LabVIEW Applikation. Dazu wird ein Kamerasystem, bestehend aus Controller und Farbkamera eingesetzt und in LabVIEW von National Instruments (NI) eingebunden. Um die Tiefeninformation aus dem zweidimensionalen Kamerabild zu bestimmen, werden verschiede Methoden mit einer oder mit zwei Kameras vorgestellt und deren Realisierung beschrieben. Die Lagebestimmung erfolgt mit Hilfe eines optischen Marker und basiert auf der Ortsbestimmung von vier farbigen Markerpunkten und den Lagevektoren zwischen ihnen. Abstract The development project by the competence center of applied sensor systems (ccass), at the university of applied science in Darmstadt, deals with the optical-based, three dimensional determination of location and orientation of objects as LabVIEW application. A camera system and a color-camera involved in LabVIEW from National Instruments (NI). To determine the depth from the two-dimensional cameraimage, different methods with one or two cameras are introduced the respective realization described. The further on mentioned determination of the orientation is conducted with the help of an optical marker and is based on four colored marker-points and the related vectors. 1 Einleitung Das Bestimmen von Ort und Lage eines beweglichen Objektes im dreidimensionalen Raum gewann in den letzten Jahren immer mehr an Bedeutung. In unzähligen Anwendungen müssen heute der Ort und die Lage von Objekten im Raum bestimmt werden. Autonome Roboter müssen beispielsweise den Standort und die Lage einzelner Karosserieteile kennen, um dieses für die Montage aufzunehmen. Felgenhersteller setzen optische Systeme ein, um die unterschiedlichen Lagen der Felgen auf einem Fördersystem zu bestimmen, damit die Befestigungslöcher gebohrt werden können. In der SpieleIndustrie werden optische Systeme zur Orts- und Lagebestimmung von Eingabegeräten, sogenannten Gamecontroller verwendet, um damit in Echtzeit das Spielgeschehen zu steuern. Aber auch in der Verkehrsüberwachung, der Informationstechnik und in der Medizintechnik haben optische Systeme zur Ort- und Lagebestimmung von Objekten längst ihren Platz eingenommen. Auch die Navigation von Geräten und Personen in Gebäuden gewinnt immer mehr an Bedeutung. Das CCASS der Hochschule Darmstadt forscht unter der Leitung von Professor Dr. Markus Haid auf dem Fachgebiet der Objektverfolgung und Navigation mit low-cost inertialen Navigationssystemen (in folgenden kurz INS genannt). Die mittlerweile immer kleineren und preiswerteren, auf der Basis von orthogonal angeordneten Beschleunigungs- und Orientierungssensoren funktionierenden Systeme sind allerdings mit einem stochastischen Sensortrift verbunden. Daher müssen diese Systeme in regelmäßigen Abständen referenziert werden. Auch hier lassen sich möglicherweise optische Systeme zur Orts- und Lagebestimmung einsetzen. Daher ist im CCASS die Idee entstanden diese Referenzierungen berührungslos mit einer low-cost Kamera, wie z.B. eine handelsübliche Webcam, die die Position und Lage der INS-Plattform bestimmt, durchzuführen. 2 Das Kamerasystem Das bisher in diesem Projekt eingesetzte industrielle Kamerasystem, ist das Embedded Vision System der Firma National Instruments, das mit der Basler Scout Kamera Farbbilder aufnimmt. S E N S O R + T E S T C o n f e r e n c e s 2 0 1 1 O P T O P r o c e e d i n g s 1 6 6 Bild1 Optische Orts- und Lagebestimmung anstatt mit einem industriellen Kamerasystem mit einer Webcam Es besitzt eine maximale Auflösung von 1392 x 1040 Pixeln und hat einen Marktwert von zirka 1400 Euro. Heutige Webcams gibt es im Handel schon für wenige Euros mit einer Bildauflösung von 5 Megapixel oder mehr zu kaufen. Sie lassen sich in Verbindung mit einem Personal Computer auch als Kamerasystem betreiben. Als Bildverarbeitungssoftware dient die Entwicklungsumgebung LabVIEW von National Instruments. In Verbindung mit dem Vision Development Module lässt sich die graphische Programmierumgebung hervorragend zur Bilderkennung und Bildverarbeitung erweitern. Mit den in LabVIEW integrierten Analyse und Darstellungsfunktionen kann dann das Objekt auf dem Kamerabild detektiert und seine Größe vermessen werden, so dass anschließend der Aufenthaltsort und die Lage des Objektes im Raum bestimmt werden kann. Die Objektdetektion erfolgt mit einem Pattern-Matching Algorithmus, der ein Bildtemplate über das Kamerabild schiebt und an jeder Stelle ein Ähnlichkeitswert berechnet. An der Position im Bild, an der der Ähnlichkeitswert ein Maximum einnimmt, muss sich das zu detektierende Objekt befinden. [1] Zum Vermessen des Objektes, kommt eine Kantendetektion zu Einsatz, bei der die Pixel-Grau-Werte in jedem Pixel entlang einer Detektionslinie gemessen und miteinander verglichen werden. Steigt der PixelGrau-Wert über einen maximalen Schwellwert, so wurde ein Übergang zwischen Hell auf Dunkel und damit die erste Objektkante erkannt. Fällt der Pixel-Grau-Wert unter einen minimalen Schwellwert, so wurde ein Übergang zwischen Dunkel auf Hell und damit die zweite Kante des Objektes detektiert. [1] Auf Bild2 ist ein Bildausschnitt zu sehen, in dem eine rote Kugel mit dem Patternmatching Algorithmus detektiert und mit dem Kantendetektionsalgorithmus vermessen wurde. blau - Objektdetektion gelb - Kantendetektion Bild2 S E N S O R + T E S T C o n f e r e n c e s 2 0 1 1 O P T O P r o c e e d i n g s 1 6 7 3 Orts- und Lagebestimmung Die optisch-basierte Ortsbestimmung erfolgt in drei Schritten. 1. Zuerst wird das Objekt mit dem Pattern-Matching Algorithmus detektiert, mit dem Kantendetektionsalgorithmus ausgemessen und anschließend die Position des Objektes auf dem Kamerabild zwischengespeichert. 2. Im zweiten Schritt wird der Abstand des Objektes zur Kamera bestimmt. Ist die tatsächliche Objektgröße bekannt, kann man sich den optischen Parallaxefehler zu nutzenmachen und die genaue Tiefeninformation über den Strahlensatz der Geometrie bestimmen. Außerdem ist es auch möglich mit Hilfe der Stereoskopie das Objekt mit zwei zueinander versetzen Kameras aufzunehmen und anschließend die aufgenommenen Bilder miteinander zu vergleichen. Über den seitlichen Versatz, die Deviation, lässt sich auch die Tiefeninformation bestimmen. 3. Im letzten Schritt der Ortsbestimmung wird die genaue Position des Objektes, mit den Informationen die aus den vorhergehenden Schritten bekannt sind, bestimmen (Bild3). [2], [3] Bild3 Die optisch-basierte Lagebestimmung basiert auf der Ortsbestimmung eines farbigen, am Objekt angebrachten Markers. Um den Marker-Ursprung, an dem sich das zu detektierende Objekt befindet, sind drei verschiedenfarbige Kugeln mit einem festen Abstand zueinander verteilt. Diese Kugeln stehen für die drei rotatorischen Freiheitsgrade eines Körpers. Zunächst wird die Position des Objektes und anschließend die Positionen der drei farbigen Kugeln im Raum bestimmt. Bedient man sich nun der Vektorrechnung lassen sich die in unterschiedliche Richtung zeigenden Vektoren zwischen Objekt und Kugeln bestimmen. Durch den Richtungskosinus und mit Hilfe der einzelnen Vektorkomponenten lässt sich dann schließlich die Lage des Objektes im Raum berechnen (Bild4). y Y Bild4 S E N S O R + T E S T C o n f e r e n c e s 2 0 1 1 O P T O P r o c e e d i n g s 1 6 8 4 Ergebnis und Ausblick Die optisch-basierte Orts- und Lagebestimmung mit Kamerasystemen ist prinzipiell möglich. Doch muss sich das Objekt und die Marker im Sichtbereich der Kamera befinden und nicht von Hindernissen oder vom Objekt selbst verdeckt werden. Außerdem erschweren verschiedenfarbige Objekthintergründe und wechselnde Lichtverhältnisse die Objektdetektion mit dem Pattern-Matching Algorithmus, so dass in vielen Fällen die Orts- und Lagebestimmung fehl schlägt. Daher besteht bei der Objektdetektion noch Entwicklungsbedarf. Durch Bildfilter oder aktive Markerpunkte, wie Infrarotdioden sollte es allerdings möglich sein das Objekt besser zu detektieren und dessen Position und Lage im Raum zu berechnen. Zukünftig sollen auch die bereits in LabVIEW implementierten Algorithmen auf low-cost Kamerasysteme, wie handelsübliche Webcams übertragen werden, damit eine kostengünstige Alternative zu teuren Kamerasystemen, wie die, die in der Industrie eingesetzt werden, geschaffen wird. 5 Literatur [1] National Instruments, NI Vision Concepts Manual, November, 2005 [2] Steinmüller Johannes, Bildanalyse: Von der Bildverarbeitung zur räumlichen Interpretation von Bildern, Springer Verlag, Berlin, 2008 [3] Blaschek Roman, Tiefeninformationsgewinnung aus Stereobildern, Dip-lomarbeit, Institut für Informatik der Humboldt-Universität zu Berlin, 2004 S E N S O R + T E S T C o n f e r e n c e s 2 0 1 1 O P T O P r o c e e d i n g s 1 6 9