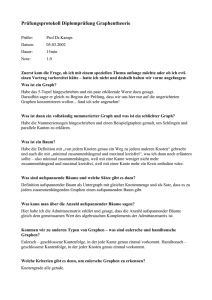

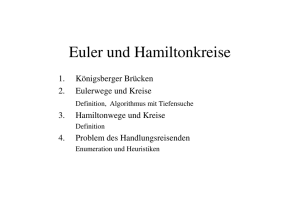

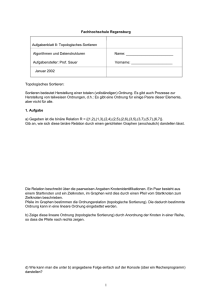

Ausarbeitung - Sebastian Schöps

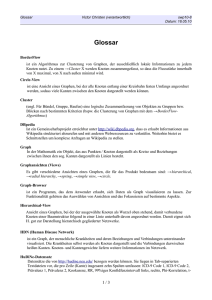

Werbung