I Hardware – Software – Vernetzung

Werbung

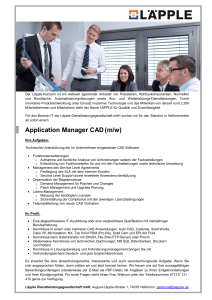

I Hardware – Software – Vernetzung Computer sind universell einsetzbare Rechenanlagen, die nicht für bestimmte Anwendungen gebaut sind, sondern für alle Aufgaben, die programmiert werden können, Während der Computer selbst unverändert bleibt, erbringt er abhängig von den jeweils geladenen Programmen genau jene Leitungen, für die das Programm gedacht ist. Computer sind Datenverarbeitungsmaschinen mit Eingabe- und Ausgabeeinheiten. RAM Random Access Memory ROM Read Only Memory INPUT Arbeitsspeicher (RAM) OUTPUT Steuerwerk Steuersignal Rechenwerk Daten Prozessor Arbeitsspeicher (flüchtiger Speicher) – Festplatte (permanenter Speicher) Input Tastatur Maus Joystick Scanner Light pew Andere Computer Input/Output Floppy Festplatte DVD/CD Netzwerkanschlüsse USB-Stick Output Monitor Drucker Lautsprecher Lasercutter CPU Central Prozessing Unit: Prozessor, Rechenwerk + Steuerwerk + interner Bus = CPU Chip = Microprozessor AGP Accelerated Graphic Port: ein spezieller Steckplatz für Grafikkarten im Computer IDE Integradet Drive Electronics: eine Schnittstelle in einem Computer, meistens für Festplatten und CD/DVDLaufwerke USB Universal Serial Bus USB Wird verwendet für einfache Geräte (Maus, Tastatur) Braucht Master, unidirektional USB 2.0: 480 Mbit/sec Universal serial Bus „hot-pluggable“, seriell s Stromübertragung möglich Firewire Wird verwendet für große Datenmengen (Video) Erlaubt mehrdirektionale Verbindungen Firewire 400: 400 Mbit/sec Firewire 800: 800 Mbit/sec i.Link oder IEEE 1394 Bus standard „hot-pluggable“, seriell Stromübertragung möglich 1 GPU Graphics Processing Unit: Prozessor auf Grafikkarte Stereolithografie (.stl) ist ein technisches Prinzip des Rapid Prototyping, oder des Rapid-Manufactoring in dem ein Werkstück durch frei im Raum materialisierende (Raster-)Punkte schichtweise aufbaut wird. Die Fertigung eines oder mehrerer Teile erfolgt üblicherweiße vollautomatisch aus den am Computer in erstellten CAD-Daten. II Geschichte 1642: „Pascaline“: Blaise Pascal erschuf die erste mechanische Rechenmaschine 1671: Gottfried Willhelm Leibniz erbaute eine „Rechenmaschine“, Kalkulator mit vier Funktionen (addieren, subtrahieren, multiplizieren, dividieren) Leibniz war der Erste, der das Binärsystem befürwortete; 1801: Joseph Marie Jacquard erfand einen Webstuhl, der nach einem auf Lochkarten „gespeicherten“ Muster webt; 1822: Charles Babbage erbaute „Diffrence Engine“, eine mechanische Rechenmaschine, die dem Prinzip des modernen elektronischen Computers ändelte; 1833: Babbage formulierte grundlegende Ideen der modernen Computertechnologie, er übernahm das System der Lochkarten, um einen universellen, programmgesteuerten Rechenautomaten zu realisieren; „Analytical Engine“ Zur selben Zeit arbeitete Ada Augusta Lovelace an Fragen der Programmierung; zu Ehren dieser ersten Programmiererin der Geschichte wurde die moderne Programmiersprache ADA benannt; 1952: Grace Hooper konstruierte den ersten Computer Compile, ein Programm der die Instruktionen für den Computer aus dem Englischen in die Maschinensprache übersetzt Um 1820 publizierte Abu Abdullah Muhammad bin Musa al-Khwarizmi ein Lehrbuch über Algebra. Die darin verwendete Technik Al’Jabr führte zum Wort Algebra, das Wort Algorithmus entstand aus dem Namen dieses Mannes; Algorithmus (Def.) Endliches, schrittweißes Verfahren zur Berechnung von gesuchten aus gegebenen Größen, in dem jeder Schritt aus einer Anzahl ausführlicher eindeutiger Operationen und einer Angabe über den nächsten Schritt besteht. Binärsystem Konrad Zuse „Für die Maschine kommt es nicht darauf an, Rechnungen im Kopf ausführen zu können, oder Zahlen leicht überblicken zu können. Was das maschinellle Rechnen vom menschlichen Rechnen unterscheidet ist, dass die Maschine gleichzeitig eine große Anzahl an Einzeloperationen parallel ausführen kann. Ist es möglich Rechenmaschinen dieser Art zu bauen, so ist die Art der damit zu rechnenden Aufgaben lediglich durch die von der Maschine ausführbaren Grundrechnungsarten und der Umfang lediglich durch die Größe des Speichers begrenzt. Beim System mit kleinerer Basis sind also auf Grund der höheren Stellenzahl mehr Einzelmultiplikationen ausführen, dafür sind diese aber in sich einfacher, da die Zifferwerter kleiner sind. Das ist für die Maschine wesentlich, denn diese ist im Gegensatz zum Menschen besser im Stande viele einfache Operationen auszuführen, als wenige komplizierte, Das System mit der kleinst-möglichen Basis ist für die Maschine am besten geeignet. Die kleinstmögliche Basis ist 2.“ 1945: Konrad Zuse Z4, Computer 2 John von Neumann (1903 – 1957) gilt als einer der Väter der Informatik. Nach ihm wurde die so genannte VonNeumann-Architektur (auch: Von-Neumann-Rechner) benannt, ein Computer in dem Daten und Programme selber kaum im laufenden Rechnervorgang verändert werden und durch bedingte Sprungebefehle von der festgelegten Reihenfolge der gespeicherten Anweisungen abgewichen werden. Es definiert in loser Analogie zum menschlichen Hirn eine Rechnerarchitektur aus Steuereinheite und arithmetischer Einheit sowie eine Speichereinheit. Die Befehle werden seriell abgearbeitet. Er beschrieb dieses Prinzip 1945 im First Draft of a Report on the EDVAC. Der Bericht war als Diskussionsbericht mit der ENIAC-Gruppe gedacht und blieb zunächst unveröffentlicht, kursiert jedoch schnell in wissenschaftlichen Kreisen. So gut wie alle modernen Rechner beruhen auf der Idee Von Neumanns. Alan Turning (1912 – 1954) war ein britischer Logiker, Mathematiker und Kryptoanalytiker. Er schuf einen großen Teil der theorethischen Grundlagen für die modernen Informations- und Computertechnologien. Turning gilt heute als einer der einflussreichsten Theorethiker der frühen Computerentwicklung und Informatik. Das von ihm entwickelte Berechenbarkeitsmodell der „Universal Maschine“ (auch bekannt als Turningmaschine) bildet einer der Fundamente der theorethischen Informatik. Nach ihm benannt ist der Turning-Preis, die bedeutenste Auszeichnung in der Informatik, sowie der Turning-Test zum Nachweiß künstlicher Intelligenz. Lawie Anderson (Film mit 0 und 1) analog: so wie man es sieht diskret: das Bild oder Kurve ist unverbunden digital: mit Zahlen ganz detailiert 0 und 1 Alles was zählbar oder messbar ist, kann codiert werden. Alles was codiert werden kann, kann ein Computer verarbeiten. Abstraktion: Programmierung, Architektur, Logik, Elektronik high level prog -> low level prog. Betriebssystem -> Hardware Ivan E. Sutherland erfand mit dem Sketchpad das erste Grafikprogramm. First interactive Computer. 1963 Reale Welt Gegenstände Handlungen Eigenschaften Beziehungen Informatik Daten Algorithmen Attribute Relationen Computer als Werkzeug Zeichnen, Modelieren, Image Processing, Desktop Publishing, Rendering, Animationen, Web-Design, 3D- Interaktion, VR, Simulationen (Licht, Energie, Statik), CAD-Cam, Prototyping, ... Computer als Medium Netzwerke, Kommunikation, Cyberspace, Ecommerce, Distance Learning, Computer supported Collaboractive Work (CSCW), Ubiquitous Computing, Handhelds, Wearables, … Synergie: produzieren und austauschen, “Bauen im Informationsraum”; 3 Moon`s Law (1964): bits/inch2 = 2 (+- 1962) Gordon Moon sagte vorher, dass sich die Geschwindigkeit der Computer alle 2 Jahre verdoppeln wird; Heute warden Computer alle 5 Jahre 10mal so schnell; d.h.: Verdoppelung der Geschwindigkeit alle 1,5 Jahre Marcos Novak ist der führende Befürworter von Cyberarchitektur, sein Ziel ist die Einführung von VR in der reale Welt III Datenstrukturen Pixel: Bildpunkt, Bildzelle, Bildelement; bezeichnet sowohl die kleinste Einheit einer digitalen Rastergrafik als auch deren Darstellung auf einem Bildschirm mit Rasteransteuerung. Die Pixel der Rastergrafik sind rasterförmig angeordnete Punkte, denen eine bestimmte Information zugeordnet ist. Diese Information enthält mindestens Werte, die eine bestimmte Farbe oder Helligkeit definieren. Oft werden Pixel als rechteckig betrachtet. The Daguerreotype, 1835; Edgar Allan Poe „Wenn wir ein gewöhnliches Kunstwerk unter einen starken Mikroskop betrachten, werden alle Spuren der Ähnlichkeit mit der Natur verschwinden – hingegen eröffnet die minutiöse Untersuchung der photogenetischen Zeichnung eine nur umso absolutere Wahrheit, eine noch perfektere Identität des Aspektes mit der dargestellten Sache. Die Variation der Schattierung und die Tonwertigverläufe sowohl von linearen Perspektiven als auch Luftaufnahmen sind jene der Wahrheit selbst, in der Unübertreffbarkeit ihrer Perfektion.“ Daguerreotype war der vorgänger des Fotoapparats. Visuelle Wahrheit kann man auch mit dem Computer manipulieren, oder mit einer natürlichen Illusion. Auflösung:die Fähigkeit eines Objektives oder Fokus, kleinste Strukturen wiederzugeben, Räumliche, Tonwert, Farbe Bilderauflösung: das Maß der Auflösung einer Rastergrafik (relativ, absolut) Kompression: die sparsamere Darstellung von Informationen GIF Graphics Interchange Format: ein Grafikformat mit guter, verlustfreier Komprimierung für Bilder mit geringer Farbtiefe (bis 8Bit). Farben die ähnlich sind werden nebeneinander gestellt. JPEG: ein Grafikformat, bei dem nicht jeder Pixel einzeln gespeichert wird so wie bei GIF, sondern die Einheit. Qualität ist schlechter. Algorythmisch; lässt sich schlecht vergrößern, schlechte auslösung; Pixel: Points, Gescannte Handzeichnung, Image Processing Vector: Linie, Dreidimensionales Drahtmodell, Zweidimensionales Flächenmodell Fläche: Explodiertes Flächenmodell, Dreidimensionales Flächenmodell Objekt: Volumen, Explodiertes Volumensmodell, Subtraktion mit Volumenmodellen Ivan S. Sutherland: Sketchpad hatte Vectorscan Display Geometrische Elemente im CAD (2D) Punkt [x,y] Linie [x0,y0], [x1,y1] Polylinie [x0,y0], [x1,y1], [x2,y2] + ... etc. Kreis [x0,y0], п Polygon [x0,y0], [x1,y1], [x2,y2] + ... etc. 4 Geometrische Elemente in CAD (3D) Punkt [x,y,z] Linie [x0,y0,z0], [x1,y1,z1] Polylinie [x0, y0,z0], [x1,y1,z1], [x2, y2,z2] + ... etc. Kreis [x0,y0,z0], п (+Lage im Raum) Fläche [x0, y0,z0], [x1,y1,z1], [x2,y2,z2] + ... etc. Kartesisches Koordinatensystem: CAD Programme liegen auf dem Prinzip dieses Systems Analytische Geometrie (1637) ist das mathematische Gebiet, in welchem algebraische Symbolismen und Methoden verwendet werden, um geometrische Probleme darzustellen und zu lösen. Das Wichtigste an der analytischen Geometrie ist es, dass sie eine Korrespondenz zwischen geometrischen Kurven und algebraischen Gleichungen etabliert. Diese Korrespondenz ermöglicht es, geometrische Probleme zu formulieren und umgekehrt. Die Methode des einen können dann verwendet werden, um die Probleme des anderen zu lösen. Matrix: geometrische Transformationen: Translation, Rotation, Skaling Oswald Spengler (1880 – 1936): „Der Untergang des Abendlandes“; klassisches Denken blind für das Konzept des Unendlichen; René Descartes (1596 – 1650): „cogito ergo sum“ Dualität von Körper und Geist Descartes Geometrie war wichtig wegen der Konzeption einer neuen Zahlenidee. Es kam zur Analyse des Unendlichen. Das kartesische Koordinatensystem wurde nicht weiter erforscht sondern überwunden, der vorige Repräsentant von meßbaren Größen. Die Konstruktion ist die Herstellung einer einzelnen, sichtbare vorliegenden Figur. Der Zirkel ist der Meißel dieser zweiten bildeneden Kunst. Die Arbeitsweise bei funktionstheorethischen Untersuchungen (Operationen), deren Zweck keinem Resultat vom Charakter einer Größe sondern die Diskussion allgemein formaler Möglichkeiten ist, lässt sich als eine Art Kompositionslehre von naher Verwandschaft zur musikalischen bezeichnen. Jede Konstruktion bejaht, jede Operation verneint den Augenschein, indem jene das optisch Gegebene herrausarbeiten, ... Die analytisch gewordene Geometrie löste alle konkreten Formen auf. Sie ersetzte den mathematischen Körper an dessen starrem Bilde geometische Werte gefunden werden, durch abstrakträumliche Beziehungen, die zuletzt auf Tatsachen der sinnlichgegenwärtigen Anschauung überhaupt nicht mehr anwendbar sind. CAD Programme heben die von Sprengler beklagte Abtrennung der analytischen Geometrie vom sinnliche Erfahrbarem gewissermassen wieder auf. Die Arbeit im CAD ist mit dem geometrischen Konstruieren eng verwandt, man sieht immer was man macht. Dahinter verbergen sich die letztlich auf Descartes zurückgehende Matrizenoperation. Konstruktion und Operation sind durch die graphische Benutzeroberfläche wieder vereint. Struktur (def.) Alle gewachsenen oder gebauten Formen weisen eine Struktur auf. Die Struktur ist eine bestimmte Organisation der Teile, eine innere Qualität.Dieser Struktur können sehr unterschiedliche Formen zugrunde liegen. Ähnliche Formen können sehr unterschiedliche Strukturen haben. Traditionell: drawing -> plan CAD: 1file -> plan1 ->plan2 ->plan3 ... 5 CAD Multidimensionalität Projektion, Ausschnitt, Maßstab, Struktur (inhaltliche Filter: Gewerbe, Material, Autor, Zeit, Farbe, etc.) Projektion: Lineare Transformation auf die Bildfläche fasst die Möglichkeit zusammen 3D Objekte aus einer 2D Fläche abzubilden, dass dennoch ein räumlicher Eindruck entsteht [x,y,z] -> [x/c*z, y/c*z] Ortographische Projektionen: Abbildung eines Objektes auf eine 2D Fläche [x,y,z] -> [x,y] Grundriss und Aufriss Axonometrie ist eine rasche konstruierbare graphische Darstellungsmethode von räumlichen Körpern und 3DStrukturen, bei der die 3 Koordinaten jeweils parallel zu passend gewählten Achsen mit dazugehörigen Maßstäben aufgetragen werden. Schrägriss, Trimetrisch, Dimetrisch, Isometrisch Strukturierungsmöglichkeiten in gängigen CAD Programmen Element (Primitives) Farben (colors) Linienarten (linetypes) Ebenen (layers) Komplexe Elemente (groups, blocks) Referenz Files (Xref) externe Datenbank Immer kann nur ein Layer (Ebene) als aktuell angewählt werden. visible/invisible, freeze/thaw, lock/unlock Layers können sichtbare Attribute haben (colors, linetype) Zweck: Konsistenz, Informationsaustausch, Einheitlichkeit Intelligente Layer Layer können die Mehrfachzuordnung derselben Objekte ermöglichen. Name der Layer besteht aus vielen Feldern -> wie Spalten in einer Relationalen Datenbank. Standard User Interface ungenügend -> Strukturierungsfragen sind auch Interfacefragen Layer Standards: Kompatiblität mit verschiedenen Programmen AIA Layer (und entsprechende Standards in anderen Ländern) reflektieren den Status Quo -> passen auch besser für AutoCAD MicroStation hat nur 64 Layers Vectorworks hat Classes und Layers -> Austauschformate! IGES Initial Graphic Exchange Specification: ANS (American National Standard), Erste Version 1980, zur Zeit: 5.3; 6.0 soll endgültiger Version sein; 6 STEP Standard for the Exchange of Product Model Data (ISO 10303):Multi-Part Iso Standard; Covers geometry, topology, tolerances, relationships, attributes, assemblies, configuration and more; provides unambiguous, computer sensible description of the physical and function characteristics of a product throughout it’s a life circle DXF Drawing Interchange Format (de-facto Standard, Autodesk proprietär), reflektiert exakt dei AutoCAD Datenstruktur; nie als Standard gedacht, schlecht dokumentiert aber von so gut wie jedem CAD Programm am Markt unterstützt; verliert in letzter Zeit an Bedeutung Strukturen und Standards: die Zukunft Objekt-orientierte Standards statt Layerkonventionen, International Alliance for Interoperability, IFC: Industry Foundation Classes; Sutherland: “Es hat sich herausgestellt, dass die Nützlichkeit von Computerzeichnungen moistens in ihrem strukturierten Wesen begründet ist. Ein gewöhnlicher Designer sorgt sich nicht um die Struktur seiner Zeichnung. Bleibstift und Tinte haben keine inhärente Struktur. Sie machen nur schmutzige Zeichen auf’s Papier.“ Stiny: „Mehrdeutigkeit erfüllt wichtige Aufgaben beim Entwerfen, wo sie Phantasie und Kreativiät fördert und vielschichtige Ausdrucksweisen und Auffasungen unterstützt. Aber Mehrdeutigkeit ist bemerkenswert abwesend, wenn das Entwerfen vom Computer unterstüzt wird, selbst in dem einfachen Fall, wo Entwürfe als Linienzeichnungen dargestellt werden. Es scheint, dass die Unbrauchbarkeit von Computerzeichnungen beim Entwerfen gerade in ihrem strukturierten Wesen begründet ist,“ IV CAD Datenstrukturen Raytracing ist ein auf der Aussendung von Strahlen basierter Algorithmus zur Ermittlung der Sichtbarkeit von 3D Objekten von einem bestimmten Punkt im Raum aus. Light types Ambient Light: nicht gerichtet, diffus Spot Light: gerichteter Strahl, Fall-off Point Light: strahlen in alle Richtungen, Glühbirne Distant Directional Light: parallele Strahlen, Sonne Für die Wahrnehmung, für unser Denken besteht die Welt aus Objekten. Objekte wir klassifizieren Objekte automatisch wir erwarten bestimmte Eigenschaften von bestimmten Klassen von Objekten wir erweitern unser Wissen über Objekte täglich wir wenden unsere bisherige Erfahrung mit Objekten einer bestimmten Klasse auf neue Objekte derselben Klasse an, denen wir das erste Mal begegnen Objekt-Orientierung Metapher in der Computerprogrammierung Näher an unserem Denken, flexibler, produktiver Objekte: Attribute + Methode Klassen, Subklassen: Vererbung Bsp.: Programmiersprache (C++, Java), Datenbanken, GUI, Maya 7 Sketchpad war auch schon Objektorientiert Blocks/Symbole Gruppierung von Einzelteilen zu neuer Einheit Wiederverwertbarkeit Variationen Ermöglicht kollektive Änderung von Eigenschaften Typen und Instanzen Instanzen erben essentielle Eigenschaften eines Typs, aber es sind einzigartige physische Eigenschaften, die wir an einem bestimmten Ort zu einer bestimmten Zeit finden (accidental properities). Objektorientierung in CAD Types and Instances Types (AutoCAD: Blocks): Attributes, Methods Variations Levels of detail Hierarchies Objekte können hierarchisch geordnet warden Maya ist nicht gerade ein Arch.Programm, viel meh rein Animationsprogramm. Xfrog ist ein Programm bei dem auf dem Prinzip der Hierarchie die Objekte aufgebaut werden V Computergraphik: Kurven & Digitale Perspektiven Kurven gerade Linien sind Sinderfälle von Kurven ebene Flächen sind Sonderfälle von gekrümmten Flächen Tech-Talk Polygonal modeling vs. NURBS modeling Bezier Curves, B-Splides und NURBS Bezierkurve ist eine parametrisch modelierte Kurve, die ein wichtiges Werkzeug in der Vektorgrafik darstellt. NURBS Non-Uniform Rational B-Spline: sind mathematisch definierte Kurven oder Flächen, die im ComputergrafikBereich (CGI/CAD) zur Modelierung beliebiger Formen verwendet warden. NURBS Patches: man kann das Gewicht dazu geben Bezier-Patch: Surface formed by a Bezier Curve swpt along a Bezier Curve Polygons vs. Curved Surfaces Die Figuren in Videogames waren zuerst mit Polygons gemacht und jetzt Bezier Curves. So sind sie schneller und besser geformt, nicht mehr eckig. Boolsche Operationen: Union (Vereinigen), Substract (Differenz), Intersect (Schnittmenge) 8 Geometrie engines (Geometrische Werkzeuge): Modellierkern bezeichnet man den Kern zur Geometriebeschreibung und –darstellung, der in 3D CAD Systemen verwendet wird. Derzeit gibt es 2 kommerzielle Modellierkerne, die an verschiedene CAD-Hersteller kizenziert sind und somit in unterschiedlichen CAD-Programmen verwendet werden: ACID (AutoCAD): entwickelt von Fa. Spotial Corp, gehört zur Dassault Group, Dateinamen-Erweiterung: .sat Parasolid (MicroStation): entwickelt von UGS und verwendet u.a. von SolidWork und SolidEdge. DateinamenErweiterung: .x_t oder .x_b CSG Constructive Solid Geometry: eine Technik zum Modellieren von Körpern durch boolsche Operationen, um Objekte zu Kombrimieren B-rep Boundary Representation Solid: eine Darstellungsform eines Flächen- oder Volumenmodells in der Objekte durch ihre begrenzenden Oberflächen beschrieben werden; Digitale Perspektiven Projektionen: Camera vs. Computer Onthografisch vs. Perspektive Paradoxe Ding-Konstanz: Die Erfindungen der Perspektive und der Realismus von perspektivischen Bildern und einer immersiven BibaoGuggenheim CD; Digitale Photogrammetrie: Umkehrung des Perspektivverfahren zur Rekonsttruktion der Wirklichkeit aus Bildern; DIPAD: ETI+ research proj. 1994-97 aktuelle Methoden: tracking system im no_lab „Intuitive Perspektive“ E.H.Gombrich: The Image and the Eye (Bild und Auge) „Die Welt sieht nicht aus wie ein flaches Bild, aber ein flaches Bild kann so gemacht werden, dass es aussieht wie die Welt.“ Paradoxe Ding-Konstanz: „Stabilisiernde Tendenz, die verhindern, dass uns schwindelig wird in einer Welt von fluktuierenden Erscheinungen.“ Bei der Klassischen Perspektive ist der Horizont in Aufenhöhe. Im Computer in der Bildschirmhälfte. Bei einer horizontalen Blickrichtung bleiben vertikale Linien vertikal. Spattial Ambiquity: interpreting wireframe model perspective provides depth cueo Optical Trianqulation: - Single Station - does not permit 3D position - projective transformation - results only 2D (z.B.: plan of facade) - application: digital rectification - Two Stations - do not permit even detections - missing reliability 9 - - possible application: cartography Multiple Station - even detection - bundle advestment - results are full 3D Mann konnte zuerst die Perspektive gar nicht zeichnen; Zentralperspektive wurde in der Renaissance entdeckt; für Architekten war das zeichnen in der Perspektive immer sehr wichtig; Paradoxe-Ding-Konstanz ist im Bild wenn in der Perspektive Dinge hinten kleiner sind als Gegenstände im Vordergrund VI Computergraphik II: Licht- und Materialsimulation Visual Realism: „... ein Bild, welches viele der Effekte einfängt, welche entstehen, wenn Licht auf physische Objekte trifft.“ Fotorealismus ist ein nach der Pop Art vor allem in der USA entwickelter Stil, der extrem realistischen Malerei; hdr hight dynamic range: Hochkontrasbild; ist ein digitales Bild, dass die in der Natur vorkommen großen Helligenunterschiede detailgetreu speihern kann. herkömmliche digitale Bilder, die dazu nicht in der Lage sind, werden als LDR-Bilder oder Low Dynamic Range Images bezeichnet. Rendering ist visueller Realismus. Beim Fotorealismus sind Licht und Oberfläche sehr wichtig. Rendering pipeline surface model -> Projection -> Visible surface determination -> shading Shading Reflexionseigenschaft der Oberfläche Spektrale Emission der Lichtquelle Relation der Oberfläche zu anderen Oberflächen Standpunkt des Betrachters Basic Material Types Lambert: Flat material that doesn’t create highlights and works for material; unglazed ceramics or other matte surface Phong: creates surface like a bling material but with tighter highlights, perfect for plastics; PhongE: a faster rendering version of the phong material that has softer highlights Blinn: calculates highlights based on surface curvature, amount of light and camera angle. The highlights created are often soft and suitable for brass and aluminum Anisotropic: adjusts highlights based on users position, perfect for hair, satin, brushed metal, any surface with grooves that change relative do user position Lambert shading: Johann Heinrich Lambert (1728 – 1777); Lambert`s cosine law: Id=IpKcosφ (flat shading) Gowand shading: Herni Gowand (*1944) Phong Shading: Bui Tuong Phong (*1942) Blinn-Phong: James F. Blinn 10 Phong vs. Phong E Phong E is a faster rendering version of Phong that yields something softer highlights than Phong. Most artists use regular Phong for objects with intense highlights and Blinn for everything else. Anisotropic: ungleiche physische Eigenschaften entlang verschiedener Achsen Transparenz: das Licht geht ganz durch die transparenten Elemente, obwohl in der Wirklich so nicht gibt; Schattenwurf Spiegelung „Convel box“ ist ein Test, bestimmt als Warnung für die Genauigkeit der Rendering Software, bei dem Vergleich der Rendering Szene mit eigentlicher Fotografie der selben Szene; Das physische Modell der „box“ wird mit einer CCD Kamera fotografiert. Die genaue Aufstellung wird dann aus der Szene gemessen: Emissionsspektrum von Lichquellen, Reflektionsspektrum von allen Flächen, genaue Position und Größe von Objekten, Wänden, Lichquellen und Kamera. Die Farben der Wände reflektieren auf die weißen Objekte innerhalb der „box“, welche die Farbe übernehmen. Radiosity, Radiosität ist ein Verfahren zur Berechnung der Verteilung von Wärme- oder Lichtstrahlung eines virtuellen Modells. In der Bildsynthese ist Radiosität neben Raytracing basierenden Algorithmen eines der beiden wichtigsten Verfahren zur Berechnung des Lichteinfalls innerhalb der Szene. Es beruht auf dem Energieerhaltungsatz: Alles Licht, das auf eine Fläche fällt und von dieser nicht absorbiert wird, wird von ihr zurückgeworfen. Auserdem kann die Fläche auch selbstleuchtend sein. Das Radiositätsverfahren basiert auf der Annahme, dass alle Oberflächen ideal diffuse Reflektoren bzw. alle Lichquellen ideal diffuse Strahler sind. Ideal diffus bedeutet dabei, dass Licht in alle Richtungen gleichmäßig reflektiert bzw. abgestrahlt wird. Textur Im Bereich der Computergrafik verwendet man Texturen als „Überzug“ für 3D-Modelle um deren Detailgrad zu erhöhen ohne den Detailgrad der Geometrie zu erhöhen. Bei der 3D-Computeranimation bezeichnet eine Textur ein Bild, das auf der Oberfläche eines virtuellen Körpers dargestellt wird. Bei dieser Abbildung handelt es sich um Texture Mapping. Ein Pixel der Textur wird als „Texel“ bezeichnet. Texturen können praktisch jede Eigenschaft einer Oberfläche gezeilt verändern, z.B. Farbe, Rauheit, Oberflächennormale, ... Bump mapping, auch: Reliefzuordnung ist eine Technik zur Darstellung von externen detailreichen Objekten, ohne die Geometriekomplexität des Objektes zu erhöhen, die vor allem in 3D-Visualisierungsprogrammen zum Einsatz kommt. Der Trick dabei ist, dass die benötigten Informationen in einer Textur gelagert werden, mit deren Hilfe Schattierungen auf eine Oberfläche gezeichnet werden. Bump mapping ist also nur eine Illusion, welche Unebenheiten auf Oberflächen simuliert, die in der Geometrie des Modells gar nicht vorhandel sind. Prozedurale Texturen erzeugen aus dem Nichts eine neue Textur und ist eine von 2 grundlegend verschiedenen Arten der Textursysthese. Unter Textursysthese versteht man die automatische Erzeugung von Texturen also 2D digitalen Bildern, die Oberflächenstrukturen oder vergleichbare Inhalte haben. 11 Displacement Mapping, auch: Ersetzungszuordnung bezeichnet eine Technik in der Computergrafik, die angewandt wird, um einer Oberfläche eines 3D Objektes eine höhere Detailtreue zu geben und damit ine realistischere Darstellung zu erreichen. Stachastisches Raytracing, auch: diffuses Raytracing ist eine Erweiterung des normalen Raytracing, bei dem in bestimmten Situationen nicht nur ein Strahl, sondern mehrere zufällig generierte Strahlen zu Bestimmung eines Wertes verwendet werden. Global Illumination (GI) bezieht sich auf einer Gruppe von Algorithmen, welche potentiell alle bekannten Beleuchtungsphänomene berechnen können, z.B. direkte und indirekte Beleuchtung ausgehend von rauen, stumpfen, glänzenden, reflektierenden, transparenten und lichtdurchlässigen Oberflächen. Alle GI-Algorithmen basieren auf Monte-Carlo-Schätzungen. Das bedeutet, sie benutzen eine hohe Anzahl an Zufallsproben um einen Näherungswert zu bestimmen, der der Realität so nah wie möglich ist. Und das ist der größte Nachteil der meisten GI-Algorithmen. Weil Zufallsproben benutzt werden, kommt es zu Störungen, wenn nicht genug Proben gemacht werden. So ist es nicht ungewöhnlich, ein GI-Render mit Milliarden von Proben und Beleuchtungsinteraktionen zu machen, was eine Renderdauer von Tager oder Wochen zur Folge haben kann. Based GI, auch Gewichtetes GI: Gis brauchen lange Renderdauern, weil mit Tausenden von Proben pro Pixel versucht wird, so genau wie möglich die Realität zu simulieren. Dabei kann jede Lichtprobe sehr lang in einer Szene auf- und abprallen. Exakte Lösungen werden ungewichtete Schätzungen genannt. Sie mögen zwar für die Forschung interessant sein, aber für die Unterhaltungsbranche sind sie eher nicht geeignet, da hier die Renderdauer eine besonders hohe Bedeutung hat. Gewichtete GI-Algorithmen wurden entwickelt, um nicht sehr lange nach einer exakten Lösung zu suchen, sondern einen Näherungswert zu finden, der „gut genug“ ist. Photonen Mapping gehört zu den Gewichteten GI-Algorithmen. Photonen Mapping ist zurzeit einer der am schnellsten verfügbaren Algorithmen, um eine globale Beleuchtung zu simulieren. Es ist eine auf der Monte-CarloMethode basierte Technik, welche einen Großteil der globalen Beleuchtungslösung mit Hilfe eines groben aber akzeptablen, statistischen Schätzwert ermittelt, anstatt zu versuchen, eine exakte Lösung zu berechnen. Eine weiterer Vorteil des Photonen Mappings ist, dass es die schon vorhandene Ray-Tracing-Engine benutzt. 10 Punkte, die man beachten sollte, um dem cheesy look bei Architekturrenderings aus dem Weg zu gehen: - Diffuse: lighting for objects and lighting for architecture is different; for architecture diffuse illumination is essential - Spotlight: careful with spotlights in exteriors: they give a wrong sense of scale - Green: careful with vegetation greens; they tend to look unnatural and get too much attention - Monochrome: is a safe way to go and it’s also the way the old masters went; (gleiche Farben, enges Farbenspektrum) - Scale: Textures, viewpoint, objects and people define the perceived scale of a scene (Proportionen müssen stimmen) - Dirt: add dirt for a more natural look (Flecken) - Vertical: Horizontal lines of vision will leave vertical elements truly vertical - Shift (Verschiebung): to capture an architectural scene well, it is often necessary to shift the center of the projection out of the center of the image - Frame: no need to show everything in every picture: aim for a visual balance rather than a complete description of a scene (it’s ok to be subjective) (Bildausschnitt) - Attitude: Personal expression, uniqueness, speak in a visual language, the picture plane, estrangement, abstraction, appropriately complex 12 VII Datenmodelle, Datenbanken, BIM Nicht geometrische Daten im CAD Material, Oberfläche, Wärmeleitfähigkeit, Farbe, Reflexionseigenschaften, Dauerhaftigkeit, Gewicht, Statische Belastbarkeit, Witterungsbeständigkeit, Liefertermin, Schallschutzwert, Hersteller, Kosten, Graue Energie, … Tabelle ist eine geordnete Zusammenstellung von Texten oder Daten. Die darzustellenden Inhalte werden dabei in Zeilen und Spalten gegliedert, die grafisch aneinaner ausgerichtet werden. Tabellenkalkulation/Spreadsheet Eine Tabellenkalkulation ist eine Software für die Interaktive Eingabe und Verarbeitung von numerischen und alphanumerischen Daten in Tabellenform. Vielfach erlaubt sie zusätzlich die grafische Darstellung der Ergebnisse in verschiedenen Anzeigeformaten. Das Bildschirmfenster der Software ist dabei in Zeilen und Spalten eingeteilt. Je nach Programm bzw. Bedienungsfeldkonzept heißt dieser Bereich z.B. Arbeitsblatt, Worksheet oder Spreadsheet. Jede Zelle der Tabelle kann eine Konstante (Zahl, Text, Datum, Uhrzeit,...) oder eine Formel enthalten. Für die Formel stehen meist zahlreiche Biblotheksfunktionen zur Verfügung. Die Formeln können Werte aus anderen Zellen benutzen. Wozu Datenbanken? Archive: Langlbigkeit (statisch) Prozesse verwalten (dynamisch) Database/Datenbank: „eine selbstbeschreibende Sammlug von integrierten Aufzeichnungen“ (A. G. Taylor) Ein Datenbanksystem ist ein System zur elektronischen Datenverwaltung. Die wesentliche Aufgabe eines DBS ist es, große Datenmengen effizient, wiederspruchsfrei und dauerhaft zu speichern und benötigte Teilmengen in unterschiedlichen, bedarfsgerechten Darstellungsformen für Benutze und Anwendungsprogramme bereitzustellen. Eine DBS besteht aus 2 Teilen: der Verwaltungssoftware, genannt Datenbankmanagementsystem (DBMS) und der Menge der zu verwaltenden Daten, der eigentlichen Datenbank. Die Verwaltungssoftware organisiert intern die strukturierte Speicherung der Daten und kontrolliert alle lesenden und schreibenden Zugriffe auf die Datenbank. Zur Abfrage und Verwaltung der Daten bietet ein Datenbanksystem einen Datenbanksprache an. Datenbanksysteme gibt es in verschiedenen Formen. Die Art und Weise, wie ein solches System Daten speichert und verwaltet, wird durch das Datenbankmodell festgelegt. Die bekannteste Form eines DBS ist das relationale. Database Managment System DBMS: „Programme, welche verwendet werden, um Datenbanken und ihre assoziierten Anwendungen zu definieren, zu verwalten und zu bearbeiten“ (A. G. Taylor) 4 Haupttypen: - hierarchisch - netzwerkartig - relational - objektorientiert - Klassen und Methoden - undefinierte Typen - höchste Flexibilität - bisher nicht durchgesetzt - sehr gut für komplexe Daten - Michtypen: objekt-relational 13 DBSS: Daten Definition, Daten Manipulation, Daten Kontrolle, Daten Visualisierung SQL Structures Query Language: DBMS-Sprache für relationale DB; standarisiert (ISO, FIPS, ANSI, etc.); nicht proprietär Personal Infostructure (Michele Milaus): hat alle seine Bücher in eine Datenbank gegeben, um zu wissen, wo er sie hat. Datenbanksysteme: Aufgaben - Daten archivieren (sichern, Zuverlässigkeit) - Daten verwalten (kontrollierter Zugriff) - Daten definieren (Typen, Datenarchitektur) - Daten bearbeiten (Pflege, Erweitern, Transaktionen) - Daten kontrollieren (Redundanzfreiheit, Plausibilität) - Daten weiterverwenden (Export, Umformung, Austausch) - Daten sichtbar machen (Übersicht, Analyse, Auswertung) Redundenz bedeutet, dass sich eine Info bei allen Anträgen verändert, wenn sie an der richtigen Stelle im System geändert wird. Kevin Kelly, Borge’s Liberary: eine Bibliothek mit allen möglichen Büchern, wurden mit einer Landschaft verbunden, und wenn die Bücher nicht richtig geordnet waren ... Grammatikalische Richtigkeit war die Frage; Internet ist die größte Datenbank. Information Visualization: The use of computer supported, interactive visual representation of abstract data to augment cognition (Carol, McKinlay) Informationsarchitekt: - Individiuum, welches dateninkorente Muster organisiert, die Komplexität klärend - eine Person, welche Strukturen oder die Karte von Information erstellt, die es anderen erlaubt ihren eigenen Weg zum Wissen zu finden - der im angehenden 21.Jh entstehende Beruf, welcher sich der Bedürfnisse nach Klarheit, menschlichem Verstehen und der Wissenschaft der Organisation von Informationannimmt Darstellungsformen in Architekturplänen - Analog - maßstäbliche Darstellung, Maßstäbliche Verzerrung - Dimensionen und Proportionen werden auf die Bildebene übertragen - Informationsdichte: Maßstabkonventionen - Ikonisch - vereinfachte Form - Ähnlichkeit ohne Maßstabstreue - Bildlegende überflüssig - Symbolisch - keine Ähnlichkeit - nur durch Koventionen etabliert, Vokabular - ermöglicht hohe Informationsdichte 14 - Implizierrt Grammatik, richtige und falsche Verwendung Paul Laseau: Graphic thinking for architects and designers Farbe und Information Menschen sehen bis zu 1.000.000 Farben; Farberinnerung ist nicht perfekt; mehr als 20-30 Farben sind nicht empfehlenswert, man kann nicht mehr als 20-30 Farben unterscheiden Organisation LATCH: Location Alphabet Time Category Hierarchy VIII Simulationstechnik Graz Design Science Labs Integration of architectural simulation technology into the design process digital and physical models as key to study performativity aspects of architecture in a holistic way Graz Labs: Lighting Lab, EnergyLab, CAD/CAMLab, MediaLab Coming soon: structuresLab, landscapeLab IFC Industry Foundation Classes sind ein offener Standard im Bauwesen zur digitalen Beschreibung von Gebäudemodellen, heute unter dem Begriff BIM (Building Information Modeling) bekannt. Abgebildet werden die logischen Gebäudestrukturen (z.B. Fenster, Öffnungen, Wand) zugehörige Eigenschaften (Attribute) sowie optionale Geometrie. Es lassen sich u. a. komplexe 3D Planungsdaten mit den Bauelementen und beschreibenden Attributen zwischen Bausoftwaresysteme übertragen. Definiert werden die IFC von der Industrieallianz für Interoperabilität (IAI); registriert sind die IFC unter ISO16739 IFC wird von zahlreichen Software zum Austausch von Gebäudedaten unterstüzt. Anwendungsbereiche sind z.B. 2D/3D CAD. Statik- und Energieberechnungen, Mengen- und Kostenermittlung. Der Austauch erfolgt durch IFC Daten mit der Endung .ife. Daneben sind auch .ifvXML (für IFC Daten im XML Standard) und .ifcZIP (standardmäßig gezpte IFC Dateien) gebräuchlich. IAI Industrieallianz für Unteroperabilität wurde mit dem Ziel gegründet, den modellbasierten Ansatz für die Optimierung der Planungs-, Ausführungs- und Bewirtschaftungsprozesse im Bauwesen im Rahmen der buildingSMART Initiative zu etablieren und dabei die IFC als den offenen Standard für Gebäudemodelle durchzusetzen. BuildingSMART steht für den neuen Ansatz, innovative, nachhaltige und kosteneffizente Gebäude und bauliche Anlagen zu schaffen, indem moderne IT Lösungen mit durchhängigeren Datennutzung für integrierte Prozesse gnutz werden. Simulation ist eine Vorgehensweise zur Analyse von Systemen, die für theoretische und formelmäßige Behandlung zu kompliziert sind. Dies ist überwiegend bei dynamischen Systemverhalten gegeben. Bei der Simulation werden Experimente an einem Modell durchgeführt, um Erkenntnisse über das reale System zu gewinnen. Jede Simulation beruht auf einer Abstraktion (Datenmodell). Simulationstechnik bedeutet, dass die Realität vorweggenommen wird. Anwendungsbereiche: Licht, Akkustik, Statik, Fluid Dynamik, Gebäude Energie, Raumsoziologie; IX Künstliche Intelligenz 15 IT als Querschnittsdisziplin Datenbanken: Verwalten Visualisierung: Analysieren, Verstehen Simulation: Überprüfen, Entscheiden Vernetzung: Kommunikation, Koordinieren Entwerfen?: Künstliche Intelligenz Was ist Intelligenz? Der Hauptgedanke in der Phsychologie über die menschliche Intelligenz ist nicht die einfache Fähigkeit oder kognitive Prozesse oder eine reihe von einzelnen Komponenten. Die Forschung in KI (AI) hat sich aufs folgende konzentriert: lernen, denken, Problemlösungen finden, rationales denken, Wahrnehmung, Verständnis (Sprache); Alan Turning: „Turning Test“ wenn eine Maschine in einem Gespräch nicht von einem Menschen unterschieden werden kann: künstliche Intelligenz Joseph Weizenbaum (1923 – 2008) erfand mit ELIZA einen virtuellen Psychiater. Er war ein deutsch-amerikanischer Informatiker sowie Wissenschafts- und Gesellschaftskritiker. Er bezeichnete sich selbst als Dissident und Ketzer der Informatik. Bewusstsein, Consciousness „Ganz egal, wie gut sie bestimmte Aufgaben erledigen, Computer werden nie intelligent sein, weil sie kein Bewusst sein haben.“ Marvin Minsky: „Das ist auch gar nicht nötig. Du kannst die Intelligenz aus unintelligenten Teilen zusammenbauen.“ Die Neurowissenschaftler sind sich heute sicher, dass eine oberste Intelligenz im Hirn nicht existiert. Intelligenz liegt zwischen Intuition (Handeln) und Rationalität (Denken) Marvin Minsky: „In general we are least aware of what our mind do best.“ Frank Lloyd Wright: “An expert is a man who has stopped thinking – he knows!” Intelligenz - Erkennen - Computer Vision: interpretieren von visuellem Input durch die Maschine - Speech Recognition (Spracherkennung): - Natural Language Processing: das inhaltliche Verstehen von Sprache, das generieren von inhaltlich sowie sprachlich korrektem Text und die Fähigkeit Konversation zu führen. - Wissen - ES – Experten Systeme: Regeln programmieren - Case – Based Reasoning (Fallbasiertes Schliessen): Fälle speichern und für die Problemlösung einsetzen. - Verhalten - AL – Antificial Life: Systeme, welche Leben simulieren mit dem Ziel, das Leben zu verstehen, indem fundamentale dynamische Prinzipien mit dem Computer nachvollzogen werden. Den einzelnen Teilen werden Verhalten und Interaktionsmöglichkeiten einprogrammiert. Das Ziel ist das Verstehen. 16 - Regelbasierte Systeme (Rule-Based Systems): Prozedurale Verfahren, Formengrammatiken (shape grammars) induction design) Lernen - NN – Neuronale Netzwerke: Simulatione der Neuronen, wie sie in den Gehirnen von Tieren und Menschen vorkommen - GA – Genetische Algorithmen: Evolution von künstlichen Wesen; die DNA wird simuliert und für die Fortpflanzung nur die Beste zugelassen; z.B.: die Kreaturen von Carl Sims. Genetische Algorithmen - Suchtechnik: Optimierungsprobleme - Inspiriert von Evolutionsbiologie: Vererbung, Mutation, Crossover - Grundbestandteile: Genetische Repräsentation (beliebig viele Parameter), Fitness Funktion (Analyse/Evaluation) - Genetische Algorithmen sind Algorithmen, die auch nicht analytisch lösbare Probleme behandeln können, indem sie wiederholt verschiedene „Lösungsvorschlage“ generieren, dabei verändern sowie miteinander kombinieren und einer Auslese unterziehen, so dass diese Lösungsvorschläge den gestellten Annforderungen immer besser entsprechen. Units Robots = Physische Erscheinubgen, welche mit KI Fähigkeiten ausgerüstet sind. Oft eine Kombination verschiedener KI Aspekte: Computer Vision, Speech Recognition und weiterer Fähigkeiten, welche vielleicht mit genetischen Algorithmen entwickelt wurden. Agents Roboter ohne den physischen Teil. Im Moment sind vor allem Agents verbreitet, welche Informationen aus dem Internet suchen und filtern. Wichtig ist, dass zwischen Menschen und Agents ein Vertrauen aufgebaut werden kann. 17