Kapitel 7 Tensoren und Differentialformen

Werbung

Kapitel 7

Tensoren und

Differentialformen

7.1

Einführung

In der Physik umgibt die Tensoren ein Hauch von Mystik. Sie werden oft verwendet, aber viele wissen nicht wirklich was sich dahinter verbirgt. Meist wird

nicht mehr als die Definition angegeben. Wir wollen versuchen, die Tensoren

anschaulich zu vermitteln und wählten dazu eine moderne Vorgehensweise,

welche stark von klassischen Darstellungen abweicht.

Unsere Betrachtungen haben wir mit den Vektoren begonnen. Vektoren

sind mathematische Objekte, die in einem Raum existieren. Dies kann der kartesische oder ein gekrümmter Raum, wie zum Beispiel die eine durch Massen

gekrümmte Raum-Zeit, sein. Mit Hilfe von Vektoren können Punkte und Richtungen in diesem Raum beschrieben werden. Stellen wir uns im kartesischen

Raum den Ortsvektor ~x vor, der vom Ursprung eines Koordinatensystems zum

Punkt P zeigt. Es ist nun möglich, den Vektor ~x in einem Kugelkoordinatensystem zu finden, der auch auf den selben Punkt P zeigt. Es handelt sich jeweils um denselben Vektor, doch die Komponenten der Vektoren sehen je nach

verwendetem Koordinatensystem anders aus. Man sagt daher, dass Vektoren

Koordinaten unabhängig sind, jedoch bestimmte Transformationsgesetzen von

einem Koordinatensystem in ein anderes gehorchen müssen.

Dass Koordinaten transformiert werden können und wie dies geschieht,

haben wir in Abschnitt 6.4.3 gesehen. Dazu wurden lineare Abbildungen eingeführt, die in Form von Matrizen leicht beschrieben werden konnten. Eine

Matrix kann also eine Verknüpfung bzw. Abbildung zwischen verschiedensten

Koordinatensystemen herstellen.

In der Physik gilt das Postulat dass die ganzen physikalischen Gesetze

überall gelten müssen. Das heißt, es sollte eigentlich auch egal sein, welches

Koordinatensystem gewählt wird, um die Gesetze zu beschreiben. Die Gesetze, und somit die Vektoren bzw. Tensoren, die sie beschreiben, sollen invariant

vom Bezugssystem sein. So kann das Gravitations-Potential sowohl in karte-

231

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

232

sischen Koordinaten mit

GM

φ(x, y, z) = − p

2

x + y2 + z2

als auch in sphärischen Koordinaten mit

φ(r) = −

GM

r

beschrieben werden. Doch schauen die Gleichungen sofort anders aus. Teilweise werden sie in anderen Koordinatensystemen extrem ”hässlich”.

Ein Problem ergibt sich zum Beispiel in der Relativitätstheorie, wo sich die

Koordinatensysteme die ganze Zeit ändern. Da ist die Raum-Zeit abhängig

von Massen (bzw. allgemeiner Energien) und dem Inertialsystem. Es wäre

also schön, wenn es eine Möglichkeit gäbe, Beziehungen zwischen physikalischen Größen unabhängig von ihren Koordinatensystemen darzustellen. Genau dazu werden Tensoren verwendet, und deswegen sind sie in der Physik

auch so beliebt. Sie vermitteln multilineare Abbildungen von Größen, zwischen

verschiedenen Bezugssystemen, wobei die Metrik, die eine fundamentale Eigenschaft des Raumes ist, lokal verschieden sein kann.

Wir werden den Abstraktionsprozess im Detail betrachten und hoffen, damit die Tensoren verständlich erklären zu können. Bevor wir mit einer kleinen

Motivation beginnen können, müssen wir noch die schon öfters erwähnte Einsteinsche Summenkonvention einführen.

7.1.1

Einsteinsche Summenkonvention

In der Physik und Mathematik stößt man immer wieder auf Ausdrücke der Art

yi = ai1 x1 + ai2 x2 + ai3 x3 + . . . =

n

X

aij xj

j=1

Um nicht jedes Mal die Summe ausschreiben oder das Summationszeichen

hinschreiben zu müssen, wird die Einsteinsche Summenkonvention eingeführt.

Definition 7.1.1. Einsteinsche Summenkonvention. Anstelle von

yi =

n

X

aij xj

j=1

wird abkürzend

yi = aij xj

geschrieben, wobei immer über gleich auftretende Indizes summiert

wird.

In allen Betrachtungen zu Tensoren kommen sowohl Indizes im Subskript,

als auch im Superskript vor. Dabei müssen wir unsere Definition erweitern und

wann immer zwischen Indizes im Sub- und Superskript unterschieden wird gilt:

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

233

Definition 7.1.2. Die Summation findet nur über gleich auftretende

Indizes statt, die sich nicht auf gleicher Indexstufe befinden. Es ist

dann also

n

X

y=

Aα ωα = Aα ωα

j=1

In dieser Konvention ist also Aα B α nicht zu summieren.

Die Summenkonvention mag anfänglich ungewohnt und mühsam erscheinen, doch sollte man sich nicht davor fürchten. Durchhaltevermögen ist dabei

gefragt, denn sie erleichtert das Leben ungemein. Nochmals, in allen Betrachtungen zu Tensoren, verwenden wir die zweite Form der Einsteinschen Summenkonvention.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

7.2

7.2.1

234

Definition von Tensoren

Motivation anhand des Metrischen Tensors

Wir wollen unsere Betrachtung mit einem kleinen Vorausgriff starten. Sei ein

Koordinatensystem O mit einer dazugehörigen Basis {êα } gegeben. Die Stellung der Indizes mag im Moment egal sein. Dann gilt

~ = Aα êα , B

~ = B β êβ

A

Wir betrachten nun das Skalarprodukt zwischen den beiden Vektoren und werden dies genauer analysieren.

~·B

~ = Aα êα · B β êβ = Aα B β êα · êβ = Aα B β ηαβ

A

(7.2.1)

Der Ausdruck Aα B β ist die Multiplikation zwischen den einzelnen Komponenten des Vektors, somit sind dies nur Zahlen. Das Skalarprodukt ist eine Invariante, also unabhängig vom Bezugssystem. 7.2.1 im R3 hingeschrieben ergibt

~·B

~ = A1 B 1 + A2 B 2 + A3 B 3

A

Die Zahlen ηαβ sind die Komponenten des sogenannten metrischen Tensors. Der metrische Tensor ist jene Schlüsselgrösse, welche die Geometrie

des Raumes festlegt und somit den Zahlen Aα und B β eine Bedeutung zuweist. Wäre es nun nicht schön, wenn wir einen Weg finden würden, wo wir

nur mit den Zahlen Aα und B β rechnen müssen und nicht immer den Balast

der Geometrie mitberücksichtigen müssen? Dieser Frage wollen wir nun nachgehen.

In diesem kleinen Beispiel sind nun alle Bestandteile vorgekommen, mit

welchen wir uns in den nächsten Kapiteln beschäftigen werden. Auf der einen

~

Seite haben wir gesehen, dass die Komponenten Aα und B β der Vektoren A

~

und B nur Zahlen sind. Sie enthalten keinerlei Information über die verwendete Geometrie. Diese Information steckt in den Einheitsvektoren êα und êβ oder

abstrakter im metrischen Tensor ηαβ , der als das äußere Produkt der Einheitsvektoren aufgefasst werden kann.

Betrachten wir den metrischen Tensor auf dem niedrigsten Level, so kann

man ηαβ als eine Größe auffassen, die auf zwei Vektoren angewendet einen

Skalar generiert. Diese Zahl ergibt sich aus der Summation über folgenden

Ausdruck:

Aα B β ηαβ

Dies ist nicht mit dem Skalarprodukt zu verwechseln, welches aus zwei Vektoren einen Skalar macht, d.h. eine Abbildung R3 × R3 → R bewirkt

7.2.2

Definition eines Tensors vom Typ

0

N

Stürzen wir uns gleich ins kalte Wasser und fangen mit der Definition eines

Tensors an:

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

235

0

Definition 7.2.1. Ein Tensor vom Typ

ist eine Funktion von N

N

Vektoren, die eine Abbildung in die reellen Zahlen erzeugt und linear

in allen N Argumenten ist.

Dass Tensoren linear sind ist essentiell. Linearität in N Argumenten bedeutet

für den Fall N = 2 (s.u):

~ ·B

~ =α A

~·B

~

i

αA

Linearität auf dem 1. Argument

~+B

~ ·C

~ =A

~·C

~ +B

~ ·C

~ Linearität auf dem 1. Argument

ii

A

~·B

~

~ · βB

~ =β A

Linearität auf dem 2. Argument

iii

A

~· B

~ +C

~ =A

~·B

~ +A

~·C

~ Linearität auf dem 2. Argument

iv A

..

..

.

.

Ein Wort noch zur Notation. Bei Vektoren schreiben wir von nun an die

~ sind dann also in der InIndizes oben! Die Komponenten eines Vektors A

α

dexnotation A . Wir werden später noch sehen, warum wir dieser Konvention

folgen.

Tensoren verfolgenim Grunde

ein einfaches Konzept. Möge g ein metri

0

sein. Dann gilt

scher Tensor vom Typ

2

~ B

~ =A

~·B

~

g A,

(7.2.2)

Der Tensor g ( , ) ist nun nichts anderes als eine ”Maschine” mit zwei ”Schlitzen”, in die man jeweils einen Vektor stecken kann und die dann als Ergebnis

eine reelle Zahl liefert. Im obigen Fall berechnet die Maschine das Skalarprodukt. g ( , ) kann also zwei Argumente aufnehmen und ist in jedem linear, so

dass für das erste Argument gilt:

~ + β B,

~ C

~ = αg A,

~ C

~ + βg B,

~ C

~

g αA

Das analoge gilt auch für das zweite Argument.

Wir können also die Definition eines Tensors nun auch etwas plakativer

formulieren:

0

Definition 7.2.2. Ein Tensor vom Typ

ist eine Regel (MaschiN

ne), die auf Vektoren angewendet dieselbe reelle Zahl unabhängig

vom Bezugssystem ergibt, in dem die Komponenten der Vektoren berechnet werden.

Wir haben dies bereits für das Skalarprodukt, d.h. für ηαβ gezeigt. Nochmals,

Tensoren sind Funktionen von Vektoren selbst und nicht von deren Komponenten, sprich sie ”fressen” Vektoren!

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

236

Anzumerken sei dabei, dass eine gewöhnliche Skalarfunktion φ (t, x, y, z)

eine reellwertige Funktion ist, die

als Argument keine Vektoren hat. Sie wird

0

daher als Tensor vom Typ

klassifiziert.

0

Einschub: Der Begriff Funktion In der reellen Analysis kennt man y = f (x)

wobei x, y ∈ R Zahlen sind. Die Funktion ist nun nicht f (x), da f (x) eine Zahl

ist, sondern f ( ), die eine reelle Zahl x in eine andere reelle Zahl y abbildet. x

nennt man das Argument von f .

Normalerweise machen wir diese Unterscheidung nicht und nennen f (x)

eine Funktion, weil wir für x alle Zahlen im Definitionsbereich durchlaufen lassen. Doch um das Konzept des Tensors besser verstehen zu können, müssen

wir diese Unterscheidung durchführen.

In

wollen wir daher explizit und exakt sein: g ( , ) ist

der Tensor-Analysis

0

~ B

~ ist eine reelle Zahl.

ein

-Tensor und g A,

2

7.2.3

Komponenten eines Tensors

1

-Tensor bezeichnen) hat

Analog zu einem Vektor (den wir übrigens als

0

auch ein Tensor Komponenten. Sie sind wie folgt definiert:

0

-Tensors in einem

Definition 7.2.3. Die Komponenten eines

N

Bezugssystem O sind die Werte der Funktion, wenn die zugehörigen

Argumente die Basisvektoren {êα } im System O sind.

Daraus folgt, dass die Komponenten also Zahlen sind, die vom Bezugssystem

abhängen, da wir hier explizit die Basisvektoren {êα } von O benötigen. Wir

wollen dies wieder anhand des metrischen Tensors erläutern.

Die Komponenten des metrischen Tensors bekommen wir also, wenn wir

die Basisvektoren eines Systems O in die ”Maschine” stecken.

g (êα , êβ ) = êα · êβ = ηαβ

(7.2.3)

Die Matrix (ηαβ ) kann als eine Anordnung der Zahlen ηαβ verstanden werden, die die Komponenten von g ( , ) im Bezugssystem O mit der Basis {êα }

darstellen. Betrachten wir die Einheitsvektoren des kartesischen Koordinatensystems êx = (1, 0, 0), êy = (0, 1, 0) und êz = (0, 0, 1) und bilden nach der

Vorschrift 7.2.3 die Matrix (ηαβ ), so erhalten wir:

1 0 0

(ηαβ ) = 0 1 0

(7.2.4)

0 0 1

An dieser Stelle machen wir auf eine kleine Inkonsistenz bei der Indexschreibweise aufmerksam. Während z.B. Aα die verschiedenen Komponenten

~ bezeichnen, sind unter êα die verschiedenen Einheitsvektoren

des Vektors A

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

237

ê1 , ê2 , ê3 , ... zu verstehen, die ihrerseit wieder Komponenten besitzen. Diese

Notation hat keinen tieferen Gund, sondern ist einfach praktisch.

7.3

Die (0, 1)-Tensoren: 1-Formen

Wir wollen nun das ganze systematisch

angehen und betrachten die einfach

0

ste Art der Tensoren, die

-Tensoren oder auch als 1-Formen bekannt.

1

Wie immer, zuerst mal eine Definition:

0

Definition 7.3.1. Einen Tensor des Typs

nennt man einen Ko1

vektor oder einen kovarianten Vektor. Oder mit Bezug auf differenzierbare Mannigfaltigkeiten und Differentialformen eine 1-Form.

Wir wollen 1-Formen mit einer ”Tilde” kennzeichnen, d.h. p̃. Im Gegensatz

dazu ist p~ ein normaler (kontravarianter) Vektor.

1-Formen sind genauso wie Vektoren linear. So ist die Summer zweier 1Formen wieder eine 1-Form (α, β ∈ R)

s̃ = p̃ + q̃

(7.3.1)

r̃ = α (p̃ + q̃) = αp̃ + αq̃

(7.3.2)

(α + β) p̃ = αp̃ + β p̃

(7.3.3)

desgleichen gilt auch

beziehungsweise

Durch die Gültigkeit dieser Regeln befolgt die Menge aller 1-Formen auch automatisch alle Axiome eines linearen Vektorraumes. Dadurch sind auch die

entsprechenden Synonyme wie z.B. kovariante Vektoren gerechtfertigt. Diesen

speziellen Vektorraum der 1-Formen nennt man auch den Dualraum. Später

dazu mehr.

7.3.1

Komponenten der 1-Formen

Die Komponenten einer 1-Form p̃ bezeichnen wir mit pα . Diese bekommen wir,

indem wir der 1-Form einen Einheitsvektor zum Fraße vorwerfen, also eine

Kontraktion zwischen einer 1-Form und einem Einheitsvektor durchführen.

pα = p̃ (êα )

(7.3.4)

Es muss beachtet werden, dass der Index unten steht. Dies bezeichnet eine

1-Form. Steht der Index hingegen oben, so meinen wir die kontravariante

Komponente eines üblichen Vektors. Diese sind in der Regel verschieden

und nur im euklidischen Raum gleich, weshalb meist zwischen 1-Formen und

Vektoren unterschieden wird.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

7.3.2

238

Kontraktion

0

Wir haben gesagt,

-Tensoren sind Funktionen, die auf N Vektoren anN

gewendet immer eine reelle Zahl erzeugen. Dieses ”einen Vektor in die Maschine namens Tensor stecken” nennt man Kontraktion (oder in der deutschen Literatur auch oft Verjüngung) und wird mit p̃ ( ) angeschrieben.

Es er~ ∈ R.

~ als Argument also eine reelle Zahl, d.h. p̃ A

gibt p̃ ( ) mit einem Vektor A

”Frisst” eine 1-Form also einen Vektor, so kommt eine Zahl raus. Eine Kontraktion kann immer nur zwischen einer 1-Form und einem Vektor, bzw. zwischen

einem Ko- und Kontravarianten Index eines Tensors, stattfinden. Die Umkehrung gilt ebenfalls. Frisst ein Vektor eine 1-Form, so ergibt sich ebenfalls eine

reelle Zahl.

Auch die Kontraktion ist wieder linear, also gilt

~

~

~

~

s̃ A = (p̃ + q̃) A = p̃ A + q̃ A

~ = αp̃(A)

~ + αq̃(A)

~

~ = α (p̃ + q̃) A

r̃ A

(7.3.5)

Weiters gilt

~ = αp̃ A

~

p̃ αA

(7.3.6)

~ genau? Wir schreiben (unter VerwenWas bedeutet denn nun dieses p̃ A

dung von 7.3.6 und 7.3.4)

~ = p̃ (Aα êα ) = Aα p̃ (êα ) = Aα pα ∈ R

p̃ A

(7.3.7)

Wenn wir die Einsteinsche Summenkonvention ausschreiben, sehen wir die

Bedeutung von 7.3.7 besser.

~ = Aα pα = A1 p1 + A2 p2 + A3 p3 + . . .

p̃ A

(7.3.8)

Im Gegensatz zum Skalarprodukt haben hier alle Terme ein ”+” Zeichen. Beim

Skalarprodukt ist dies nicht immer der Fall, je nach gewählter Metrik können

die Vorzeichen wechseln. Dies ist z.B. in der Relativitätstheorie bei den Vie~·B

~ =

rervektoren der Fall. Dort ist das Skalarprodukt zweier Vierervektoren A

0

0

1

1

2

2

3

3

−A B + A B + A B + A B .

Der Vergleich mit dem Skalarprodukt hat gezeigt, dass die Kontraktion eine fundamentalere Operation ist, als das Skalarprodukt, weil sie zwischen jedem Vektor und jeder 1-Form stattfinden kann. Das Skalarprodukt produziert

nur mittels einer Metrik, also einem metrischen Tensor, eine reelle Zahl. Die

Kontraktion hingegen funktioniert ohne Bezugnahme auf eine Metrik, ist also

deswegen viel allgemeiner.

Dies zeigt uns auch, dass zwei kontravariante Vektoren

keinen Skalar er0

zeugen können. Dazu benötigt man die Hilfe eines

-Tensors. Im obigen

2

Beispiel mit dem Skalarprodukt der beiden Vierervektoren waren wir nicht exakt genug. Denn wie gesagt, wir hätten dazu explizit einen metrischen Tensor

verwenden müssen.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

7.3.3

239

Transformationsverhalten der Komponenten von 1-Formen

Wir wollen jetzt untersuchen, wie sich die Komponenten der 1-Formen unter

Transfomationen verhalten. Wie in 7.3.1 erwähnt, hilft uns die Kontraktion beim

Auffinden ihrer Komponenten. Bei den Komponenten eines Vektors ist uns das

Transformationsverhalten ja schon grob bekannt (siehe 6.4).

n o

Die Komponenten der 1-Form p̃ in einer (transformierten) Basis êβ sind

durch

(7.3.9)

pβ = p̃ êβ = p̃ Λβ α êα ⇔ pβ = Λβ α p̃ (êα ) = Λβ α pα

gegeben, wobei Λβ α eine beliebige Transformation darstellen mag. Vergleiche

dazu die uns schon bekannte Form der Basis-Transformation

êβ = Λβ α êα

(7.3.10)

Wir konnten also motivieren, dass folgende fundamentale Regel gilt:

Die Komponenten von 1-Formen transformieren sich exakt wie die BasisVektoren und entgegengesetzt zu den Komponenten von Vektoren.

Dieses ”entgegengesetzt” garantiert die Invarianz bezüglich des Bezugssy~ und jede beliebige

stems des Ausdruckes pα Aα für jeden beliebigen Vektor A

1-Form p̃. Die Verjüngung ist also unabhängig vom Koordinatensystem (man

benötigt keine Metrik)!

Dies wollen wir nun explizit beweisen:

Aα p α =

Λβ α Aβ (Λα µ pµ )

= Λβ α Λα µ Aβ pµ = Λα µ Λβ α Aβ pµ

| {z }

δβ µ

= δβ µ Aβ pµ

= Aβ p β

(7.3.11)

Dabei haben wir von der Orthogonalitäts-Bedingung analog zu 6.4.5 Gebrauch

gemacht. Der Ausdruck in 7.3.11 ist invariant, d.h. unabhängig vom Bezugssystem. In Kapitel 7.3 haben wir gesagt, dass die 1-Formen einen Dualraum

bilden. Genau diese inversen Transformationen geben dem Ausdruck ”dual”

seinen Namen. Und genau weil sich eine 1-Form p̃ wie die Basisvektoren {êα }

transformieren, werden sie kovariante Vektoren oder Ko-Vektoren genannt.

Da sich die Komponenten (und nur die Komponenten) eines Vektors entgegengesetzt zu den Basisvektoren transformieren, nennt man sie kontravariant.

Wer nun komplett verwirrt ist sollte beachten, dass die Bezeichnungsweise

”Transformation” unglücklich gewählt ist, da sie zwei unterschiedliche Konzepte miteinander vermischt:

• die Transformation einer Basis drückt neue Vektoren durch alte Vektoren

aus

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

240

• die Transformation von Komponenten drückt dasselbe Objekt in einer

neuen Basis aus

Über diese Unterscheidung muss man etwas länger und in Ruhe nachdenken.

Sollte der Unterschied aber mal klar sein, dann ist das obige relativ trivial.

7.3.4

Basis-1-Formen (duale Basis)

Da die 1-Formen im Prinzip sowas wie Vektoren sind (aber eben gerade auch

wieder nicht wegen ihres ”entgegengesetzten” Transformationsverhalten), ist

es möglich, auch eine Basis aus 1-Formen zu basteln. Wir haben dies schon

im vorherigen Kapitel angekratzt. Nur wollen wir das expliziter fassen und sagen, die Menge aller 1-Formen stellt einen Vektorraum dar, mit denen aus n 1Formen n-dimensionale Räume erzeugt werden können. Sei dies der Rn oder

der Robertson-Walker-Raum in der Kosmologie, man kann sie mit 1-Formen

alle haben. Diese Basis nennt man die duale Basis.

Analog zu Vektoren sind 1-Formen linear unabhängig, wenn es keine triviale Linearkombination gibt. Das heisst, dass die Linearkombination dann und

nur dann Null ist, wenn alle Zahlen λ = µ = . . . = ν = 0 sind, damit

λp̃ + µq̃ + . . . + ν r̃ = 0

(7.3.12)

wird.

Wir bezeichnen die dual Basis mit {ω̃ α }, α = 0, 1, 2, 3, . . . analog zur ”normalen” Basis {êα }. Dabei beachte man wie schon so oft die Stellung der Indizes. Eine 1-Form lässt sich also in der dualen Basis wie folgt anschreiben

p̃ = pα ω̃ α

(7.3.13)

wobei hier die ω̃ α nicht die Komponenten einer einzelnen Basis-1-Form darstellen, sondern die jeweils ganzen 1-Formen der Basis, die zusammen das

Erzeugendensystem bilden.

Nun stellen wir uns die Frage, was passiert, wenn wir einen kontravari~ mit einem Basisvektor der dualen Basis kontrahieren. Diese

anten Vektor A

Frage in umgekehrter Richtung haben wir uns schon im vorhergehenden Kapitel gestellt. Diese spezielle Kontraktion liefert uns wie schon in 7.3.4 gesagt

die Komponenten einer 1-Form. Somit setzen wir das Problem wie folgt an

~ (ω̃ α ) = Aα

A

Nachdem auch für die Kontraktion das Kommutativgesetz und 7.3.6 gilt, schreiben wir

~ = ω̃ α Aβ êβ = Aβ ω̃ α (êβ ) = Aβ δβ α = Aα

ω̃ α A

(7.3.14)

Wir haben das Resultat sicher schon erahnt, die Lösung sind die Komponenten

des Vektors. Ganz unverfroren haben wir in 7.3.14 die Relation

ω̃ α (êβ ) = δβ α

(7.3.15)

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

241

verwendet. Diese wollen wir nun zeigen. Es ist ja

~ = p̃ (Aα êα ) = Aα p̃ (êα ) = Aα pα

p̃ A

Mittels 7.3.13 können wir aber auch schreiben

~ = pα ω̃ α Aβ êβ

~

= pα ω̃ α A

p̃ A

= pα Aβ ω̃ α (êβ ) = pα Aα

Also kann nur aus dem Vergleich der beiden Rechenwege ω̃ α (êβ ) = δβ α sein.

Ebenso muss

~ (ω̃ α ) = Aβ êβ (ω̃ α )

A

gelten. Dies ist schnell gezeigt

~ (p̃) = Aβ êβ (pα ω̃ α ) = Aβ pα êβ (ω̃ α ) ≡ Aβ pα δβ α = Aα pα

A

Nun können wir mit Hilfe von

ω̃ α (êβ ) = δβ α

(7.3.16)

die euklidische Basis der 1-Formen aufschreiben

ω̃ 0 = (1, 0, 0) ω̃ 1 = (0, 1, 0) ω̃ 2 = (0, 0, 1)

1-Formen werden immer als Zeilenvektoren angeschrieben, damit man sie von

den kontravarianten Vektoren unterscheiden kann. Betrachten wir einen dem

euklidischen verschiedenen Raum, so muss immer die Bedingung ω̃ α (êβ ) =

δβ α erfüllt sein. Die Kontraktion der Basisvektoren und Basis-1-Formen muss

immer δβ α ergeben.

Wie transformiert sich nun {ω̃ α } unter einem Basiswechsel? Wir können

uns ja schon denken wie die Transformation stattfinden wird. Nämlich über

ω̃ α = Λβ α ω̃ β

(7.3.17)

Wir wollen unsere Vermutung nun kontrollieren. Wir haben schon gezeigt, dass

Aα pα invariant ist. Dies machen wir uns jetzt zunutze.

⇒ Aα pα = Λβ α Aβ p̃ (êα ) = Λβ α Aβ pµ ω̃ µ (êα )

Nachdem Λβ α nur eine Zahl ist, können wir diese in die Kontraktion reinziehen

= Aβ pµ ω̃ µ Λβ α êα = Aβ pµ ω̃ µ (êβ )

= Aβ pν Λµ ν ω̃ µ (êβ ) = Aβ pν ω̃ ν (êβ )

= Aβ pν δβ ν = Aβ pβ

Somit ist also die Transformation in die eine Richtung

ω̃ ν = Λµ ν ω̃ µ .

Auf die inverse Transformation kommt man analog in Kurzform:

Λν β ω̃ ν = Λν β Λµ ν ω̃ µ = δµ β ω̃ µ = ω̃ β

Also bestätigt sich unsere Vermutung von 7.3.17.

(7.3.18)

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

7.3.5

242

Zusammenfassung der Unterschiede zwischen 1-Formen und

Vektoren

• Vektoren und 1-Formen sind dual zueinander. Sie sind somit Objekte

aus dualen Räumen.

• Dualräume sind sehr wichtig und existieren auch in anderen Bereichen

der Mathematik bzw. der mathematischen Physik

Ein Beispiel. Spalten- und Zeilenvektoren sind dual, da das Produkt

a1

a2

(a1 , a2 , . . . , an ) · . = a21 + a22 + . . . + a2n

.

.

an

eine reelle Zahl ist. Zeilenvektoren sind somit 1-Formen.

Die Operation, ein Element eines Dualraumes von einem Raum zu finden,

nennt man die Adjunktion, das Element die Adjungierte. Sie ist eindeutig

und umkehrbar.

7.3.6

Darstellung von 1-Formen (Geometrisch)

Anschaulich gesprochen waren Vektoren für uns bis jetzt immer Pfeile. Sie haben einen Ursprung und zeigen in eine Richtung. Daran wird sich auch nicht

viel ändern, denn die kontravarianten Vektoren bleiben immer noch gleich.

Doch existiert auch ein geometrisches Bild der kovarianten Vektoren, also der

1-Formen?

Was wir sicher gleich sagen können ist, dass eine 1-Form kein Pfeil sein

kann, denn eine 1-Form muss einen Vektor in eine reelle Zahl abbilden. Und

das geht mit einem Pfeil recht schlecht (ohne Zuhilfenahme des metrischen

Tensors). Ein Bild einer 1-Form muss also gewährleisten, dass ein Vektor immer in eine Zahl abgebildet wird und dies eben unabhängig von einer Metrik!

Definition 7.3.2. Eine 1-Form wird durch eine Folge von parallelen

(Hyper-) Flächen dargestellt. Der ”Betrag” ist dann durch den Abstand

der Flächen gegeben. Je grösser der Abstand zwischen den Flächen,

desto kleiner ist der ”Betrag” und umgekeht.

Nun wird auch relativ klar, wie eine 1-Form einen Vektor immer in eine Zahl

abbildet. Setzt man einen Vektor in eine solche Folge von Flächen ein, durchstösst der Vektor eine bestimmte Anzahl von Flächen. Die Zahl der durchstossenen Flächen ergibt dann die reelle Zahl, was genau der Kontraktion entspricht.

Die 1-Form definiert keine Richtung, da sie eben kein Vektor ist. Stattdessen definiert sie eine Art und Weise den Raum ”in Scheiben zu schneiden”

oder generell nur wie man ihn ”aufschneidet”. Das ist der wesentliche geometrische Unterschied zwischen einem Vektor und einer 1-Form.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

243

Abbildung 7.3.1: Illustration von kontravarianten Vektoren und 1-Formen

7.3.7

Der Gradient als 1-Form

Wir wollen nun zeigen, dass der Gradient nichts anderes als eine 1-Form ist.

Dass dies plausibel ist, möchten wir kurz mit den neu gewonnenen Erkenntnissen erörtern. Eine 1-Form ist nichts anderes, als Flächen, die an Punkten so

angelegt werden, dass sie der Geometrie des Raumes folgen. Eine gute und

eindeutige Möglichkeit dies zu tun ist, sie immer als Tangentialebenen eines

bestimmten Punktes P zu definieren. Somit sind 1-Formen nichts anderes,

als die Hypertangentialflächen eines Raumes. Damit kann ebenfalls gezeigt

werden, dass der Gradient eine 1-Form ist. Dies wollen wir nun zeigen.

Wir betrachten ein Skalarfeld φ(~x) = φ(x, y, z), welches an jedem Punkt

~x definiert sei. Dieses Skalarfeld sei zur Veranschaulichung ein Potentialfeld.

Von Punkt zu Punkt kann das Potential φ einen anderen Wert annehmen.

Wenn wir alle Punkte mit gleichem φ verbinden, erhalten wir sogenannte Äquipotentialflächen. Wir wollen nun entlang eines Weges s(τ ) durch dieses Skalarfeld gehen, d.h. der Weg wird mit dem Parameter τ parametrisiert. Es ist

somit x = x(τ ), y = y(τ ) und z = z(τ ).

Betrachten wir nun die Geschwindigkeit, die wir entlang dieses Weges erfahren werden.

dx dy dz

~

U=

, ,

= (U x , U y , U z )

(7.3.19)

dτ dτ dτ

Da nun

φ(τ ) = φ (x(τ ), y(τ ), z(τ ))

ist die Änderung des Potentialfeldes entlang unseres Weges s und mittels

7.3.19 (Richtungsableitung)

dφ

dτ

=

=

∂φ dx ∂φ dy ∂φ dz

+

+

∂x dτ

∂y dτ

∂z dτ

∂φ x ∂φ y ∂φ z

U +

U +

U

∂x

∂y

∂z

(7.3.20)

Wenn wir nun diesen Ausdruck etwas genauer betrachten stellen wir fest, dass

auf der linken Seite von 7.3.20 eine Zahl dφ

dτ steht. Auf der rechten Seite steht

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

244

~ = (U x , U y , U z ), der mit einem Objekt verknüpft ist, welches die

ein Vektor U

Komponenten

∂φ ∂φ ∂φ

∂φ ∂φ ∂φ

≡

,

,

(7.3.21)

,

,

∂x ∂y ∂z

∂x1 ∂x2 ∂x3

∂φ

aufweisst. Allgemein also ∂x

α ≡ φ,α .

Aufgrund der Eigenschaft, dass 1-Formen verknüpft mit einem Vektor eine

reelle Zahl erzeugen, muss die Grösse 7.3.21 eine 1-Form sein (zumal sie mit

~ linear verknüpft ist).

U

Definition 7.3.3. Unter dem Gradient versteht man eine 1-Form der

Gestalt

∂φ ∂φ

∂φ

˜

(7.3.22)

dφ =

,

,..., n

∂x1 ∂x2

∂x

Diese wird auch äussere Ableitung von φ genannt.

Die Grösse dφ

dτ ist wie gesagt ein Skalar und gibt die zeitliche Änderung von φ

~ immer tangential

auf einer Kurve s(τ ) an, auf der der Geschwindigkeitvektor U

dazu ist.

Wir können also unser Bild einer 1-Form vervollständigen. Betrachten wir

ein Skalarfeld, welches wir anhand von Höhenlinien (Äquipotentialflächen) aufzeichnen (siehe Bild 7.3.2). Höhenlinien repräsentieren Orte gleicher Höhe,

wie z.B. auf einer Wanderkarte.

Abbildung 7.3.2: Darstellung eines Skalarfeldes mittels Höhenlinien.

In der Region A liegen die Linien dichter zusammen, als in der Region B.

In A ist die Änderung des Skalarfeldes deswegen steiler, als in B. Wir halten

fest, dass senkrecht zu einer Höhenlinie sich das Feld am stärksten ändert

und parallel zur Linie das Feld konstant bleibt.

˜ eine 1-Form und am grössten in

Sei h die Höhe am Ort P , dann ist dh

Gebieten wie A, wo die Höhenlinien eng beieinander liegen.

Wenn wir nun wissen wollen, wie gross der Höhenunterschied zwischen

zwei Punkten P und Q ist, so betrachten wir einen Vektor ∆~x = P~Q und zählen

die Anzahl der durchstossenen Höhenlinien. Im Falle von Punkt 1 wären das 4,

bei Punkt 2 lediglich nur 3.5 und bei Punkt 3 also 0.5. Mathematisch gesehen

˜ mit dem Vektor

ist dieses ”Zählen” gerade die Kontraktion des Gradienten dh

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

245

∂h

i

˜

∆~x, also ∆h = dh(∆~

x) = ∂x

i ∆x .

Der Gradient beschreibt eine Tangentialfläche, welche an jedem Punkt des

Skalarfeldes φ eine andere Ausrichtung besitzt. Dessen kann man sich leicht

vergewissern, indem der 2-dimensionale Fall der Tangentialfläche (die Tangentiallinie) in Bild 7.3.2 entlang den Höhenlinien verfolgt wird. Wir haben in

Kapitel 7.3.4 gesagt, die 1-Formen bilden den Dualraum. Nachdem wir nun gezeigt haben, dass die 1-Formen Tangentialflächen an den Raum sind, können

wir den Dualraum auch Tangential-Raum nennen.

Es ist nun klar, dass der Gradient kein Vektor sein kann, sondern eine 1Form sein muss.

7.3.7.1

Transformationseigenschaft eines Gradienten

Um nun definitv sagen zu können, dass ein Gradient wirklich eine 1-Form ist

(in der Mathematik kann man sich nie einer Behauptung sicher sein, solange

man sie nicht allgemein bewiesen hat), untersuchen wir dessen Transformationseigenschaft. Diese müsste gleich jener einer 1-Form sein. Wir müssen also

zeigen, dass

˜

˜

dφ

= Λα β dφ

(7.3.23)

α

β

ist. Dazu zeigen wir lediglich, wie sich die partiellen Ableitungen in 7.3.22

transformieren.

∂φ

∂φ ∂xβ

∂xβ ∂φ

∂xβ ˜ ˜

=

dφ

=

=

=

dφ

(7.3.24)

∂xα

∂xα ∂xβ

∂xα

∂xβ ∂xα

α

β

Und da xβ = Λα β xα , gilt

α

∂ Λ α β xα

∂xβ

β ∂x

=

=

Λ

= Λα β

α

∂xα

∂xα

∂xα

(da Λα β nur Zahlen sind). Somit ist

∂xβ ˜ β ˜

˜

dφ

=

dφ

=

Λ

dφ

α

∂xα

α

β

β

Q.E.D.

Vergleichen wir dies mit der Transformationseigenschaft eines Vektors

Aα = Λβ α Aβ ; ∆xα = Λβ α ∆xβ

(7.3.25)

sehen wir, dass dies beim Gradienten genau invers dazu erfolgt. Der Gradient

ist somit die archetypische 1-Form.

7.3.8

Ableitungen bei Tensoren

Da wir bei Ableitungen leicht mit den Indizes in Verwirrung kommen können

und wir uns auch immer die viele Schreibarbeit ersparen wollen, führen wir

nun für die Ableitungen folgende Notation ein:

∂φ

= φ,x ;

∂x

∂φ

= φ,α

∂xα

(7.3.26)

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

246

Der Index α erscheint unten, was äquivalent zu oben unter dem Bruchstrich

ist. Dies ist mit den Transformations-Regeln konsistent. Insbesondere ist

xα,β ≡

∂xα

= δβ α

∂xβ

(7.3.27)

Dies ist ähnlich zur schon bekannten Beziehung

ω̃(êβ ) = δβ α

(7.3.28)

Wir können dies nun auch mit 7.3.22 vergleichen und sehen, dass auch

˜ α (êβ ) = δβ α

dx

(7.3.29)

gilt. Somit können wir den durchaus folgeschweren Schluss

˜ α ≡ ω̃ α

dx

(7.3.30)

ziehen, was bedeutet, dass die Basis der 1-Formen die einzelnen ”Differentiale” sind. Nun wissen wir zum ersten Mal konkret, wie die Basis im Dualraum

aussieht. Somit können wir für eine beliebige Funktion f

∂f α

∂f ˜ α

∂f ∂f ∂f

˜

, 2, 3 =

ω̃ =

dx

(7.3.31)

df =

1

α

∂x ∂x ∂x

∂x

∂xα

˜

schreiben. Dabei

nun beachtet werden, dass df kein Differential an sich

muss

0

˜ apriori keine Richtung

-Tensor. Dies muss so sein, da df

ist, sondern ein

1

angibt, sondern erst, wenn es mit einem Vektor kontrahiert wird.

˜ (êβ ) = ∂f dx

˜ α (êβ ) = ∂f δ α = ∂f = f,β

df

α

∂x

∂xα β

∂xβ

(7.3.32)

˜ kann auch einen infinitessimalen Wert haben, aber nur wenn

Der Ausdruck df

er wieder mit einem Vektor kontrahiert wird, d.h.

D

E

˜ ~v

∂~v f = df,

D

E

∂f

˜

∂α f =

=

f

=

df,

ê

(7.3.33)

,α

α

∂xα

Diese Schreibweise ist vergleichbar mit jener der bra-ket-Vektoren der Diracformulierung der Quantenmechanik. Dies ist auch nicht zufällig, doch auf das

wollen wir hier nicht genauer eingehen.

7.3.9

Normale (senkrechte) 1-Formen

Ein Normalenvektor ist ein Vektor, welcher senkrecht zu einer Fläche steht.

Um ihn zu definieren, wird ein Skalarprodukt und damit eine Metrik benötigt.

Er ist dann senkrecht zu einem Tangentialvektor einer Fläche.

Doch wie sieht es nun mit einem Pendant bei den 1-Formen aus? Das interessante ist, dass eine normale 1-Form ohne Bezug auf eine Metrik definiert

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

247

werden kann. Sie ist nämlich dann normal zu einer Fläche, wenn sie mit einem

Tangentialvektor kontrahiert Null ergibt. Dies wie gesagt ohne Metrik.

ω̃⊥ (T~ ) = 0

(7.3.34)

Dies rührt daher, dass die Kontraktion wie schon erwähnt fundamentaler als

das Skalarprodukt ist. Für eine geschlossene Fläche ist eine normale 1-Form

auswärts gerichtet, wenn ihre Kontraktion mit Vektoren die auswärts weisen

positiv ist.

7.4 (0, 2)-Tensoren: 2-Formen

Wir haben uns nun ausgiebig mit den 1-Formen beschäftigt. Es stellt sich nun

die Frage, was ist

dienächst höhere Stufe einer 1-Form. Wir haben gesagt,

0

1-Formen seien

-Tensoren, welche einen Vektor als Argument ”fressen”

1

0

konnte. Die nächst höhere Stufe, also die

-Tensoren, haben 2 Vektoren

2

0

-Tensoren können

als Argumente, wie z.B. der metrische Tensor g ( , ).

2

am einfachsten durch das äußere Produkt zweier 1-Formen gebildet werden

(wobei dies nicht die einzige Möglichkeit ist):

Falls p̃ und q̃ zwei

1-Formen sind, dann ist p̃ ⊗ q̃ das äußere Produkt

0

-Tensor. Steckt man in die ”Schlitze” zwei Vektoren, dann

und somit ein

2

ergibt sich eine reelle Zahl, d.h.

~

~ · q̃ B

~ B

~ = p̃ A

(7.4.1)

p̃ ⊗ q̃ A,

Dabei steht auf der linken Seite das äußere (oder auch tensorielle) Produkt

⊗ der beiden 1-Formen p̃ und q̃ und auf der rechten Seite steht das einfache

arithmetische Produkt ·, da hier nur zwei reelle Zahlen miteinander multipliziert

werden (erinnere: eine 1-Form die einen Vektor frisst ergibt eine reelle Zahl).

Wir haben gesehen, dass das äußere Produkt ⊗ einen Tensor höherer

Stufe erzeugen kann. Dabei haben wir das äußere Produkt noch sehr abstrakt

definiert und ihm nur diese Eigenschaft zugeschrieben.

Definition 7.4.1. Das äußere Produkt ⊗ erzeugt aus zwei Tensoren

niedrigerer Stufe einen Tensor höherer Stufe. Es ist wie folgt definiert:

~

~

~ · q̃ B

~

p̃ ⊗ q̃ A, B = p̃ A

(7.4.2)

Das äußere Produkt ⊗ ist nicht kommutativ! Dies ergibt sich aus der Definition,

da

~ B

~ = q̃ A

~ · p̃ B

~ 6= p̃ A

~ · q̃ B

~

q̃ ⊗ p̃ A,

(7.4.3)

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

7.4.1

248

Die Komponenten eines (0, 2)-Tensors

0

Der allgemeinde

-Tensor ist nicht einfach ein äußeres Produkt zweier

2

0

0

-Tensoren, doch kann er als Summe von

-Tensoren dargestellt

1

1

werden.

0

Betrachten wir nun die Komponenten eines allgemeinden

-Tensors:

2

fαβ = F (êα , êβ )

(7.4.4)

Da jeder Index z.B. für N = 3 drei Werte annehmen kann, gibt es 3 × 3 = 9

Komponenten, die man sich als Matrix angeordnet vorstellen kann. Hierbei ist

anzumerken, dass die oft gebrauchte Formulierung ein Tensor ist ”so etwas

wie eine Matrix” falsch ist, denn erstens würde dies ohnehin nur für Tensoren

0

2. Stufe gelten, und zweitens wird der wichtige Unterscheid zwischen

-,

2

1

2

- und

-Tensoren nicht gemacht. Der Wert (eine reelle Zahl) von F

1

0

~ und B

~ ist

bei Anwendung auf zwei Vektoren A

~ B

~ = F Aα êα , B β êβ = Aα B β F (êα , êβ ) = Aα B β fαβ

(7.4.5)

F A,

Es stellt sich nun die Frage, können wir eine einfach

Basis für diese Ten0

-Tensoren (sogenannte

soren angeben? Wir müssten jetzt 3 × 3 = 9

2

2-Formen) ω̃ αβ finden, so dass

F = fαβ ω̃ αβ

(7.4.6)

gilt. Damit würde für die Komponenten gelten:

fµν = F (êµ , êν ) = fαβ ω̃ αβ (êµ , êν )

(7.4.7)

Analog zu 7.3.16 folgt nun eindeutig, dass

ω̃ αβ (êµ , êν ) = δµ α δν β

(7.4.8)

denn dann wäre

fµν = fαβ δµ α δν β

Nun gilt ja aber nach 7.3.16 δµ α = ω̃ α (êµ ) und δν β = ω̃ β (eˆν ). Somit ist dann

also

ω̃ αβ (êµ , êν ) = δµ α δν β = ω̃ α (êµ ) · ω̃ β (êν )

(7.4.9)

und dies ist ja

ω̃ αβ = ω̃ α ⊗ ω̃ β

Daraus folgt aber, dass die Tensoren ω̃ α ⊗ ω̃ β die Basis aller

(7.4.10)

0

-Tensoren

2

bilden!

F ( , ) = F = fαβ ω̃ αβ = fαβ ω̃ α ⊗ ω̃ β

(7.4.11)

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

249

Es ist leicht

zu erkennen, dass das Transformationsverhalten der Kompo0

nenten eines

-Tensors für eine beliebige Transformation

2

fαβ = Λα µ Λβ ν fµν

(7.4.12)

gehorchen muss.

7.4.2

Symmetrisierung

0

Wir haben gesehen, dass ein

-Tensor zwei Vektoren als Argument hat,

2

wobei die Reihenfolge eine wichtige Rolle spielt. Wir definieren nun

Definition 7.4.2. Ein Tensor f heißt symmetrisch, wenn gilt

~ A

~

~ B

~

~ B

~ = f B,

∀A,

(7.4.13)

f A,

Dies entspricht der Bedingung für eine symmetrische Matrix, bei der ja die

Elemente gespiegelt an der Hauptdiagonalen

sind.

gleich

0

-Tensor einen symmetrischen

Wir können nun aus einem beliebigen

2

Tensor durch folgende Regel bilden:

~ B

~ = 1 H A,

~ B

~ + 1 H B,

~ A

~

H(s) A,

2

2

(7.4.14)

In Komponenten entspricht dies

1

1

H(s) (êα , êβ ) = H(s)αβ = H (êα , êβ ) + H (êβ , eˆα )

2

2

1

= (Hαβ + Hβα )

2

=: H(αβ)

(7.4.15)

Hier is H(s) der aus H konstruierte symmetrische Tensor, der die Komponenten

H(αβ) hat. Beachte dabei, dass der Tensor H(αβ) nicht das Gleiche wie Hαβ

ist.

Wir zeigen dies am Beispiel einer Matrixdarstellung.

Beispiel Sei

C=

dann ist nach 7.4.15 C(αβ) =

1

2

1 2

3 4

(Cαβ + Cβα ).

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

250

Die einzelnen Komponenten des symmetrischen Tensors sind somit

1

(C11 + C11 ) = C11 = 1

2

1

= (C22 + C22 ) = C22 = 4

2

1

1

= (C12 + C21 ) = (2 + 3) =

2

2

1

1

= (C21 + C12 ) = (3 + 2) =

2

2

C(11) =

C(22)

C(12)

C(21)

5

2

5

2

Der symmetrische Tensor C(s) ist nun

C(s) =

7.4.3

1 5/2

5/2 4

Anti-Symmetrisierung

Analog werden auch anti-symmetrische Tensoren definiert.

Definition 7.4.3. Ein Tensor f heißt anti-symmetrisch, wenn gilt

~ A

~

~ B

~

~ B

~ = −f B,

∀A,

(7.4.16)

f A,

~ = êα und B

~ = êβ erhalten wir

Setzen wir wiederum A

F (êα , êβ ) = fαβ = −F (êβ , êα ) = −fβα

(7.4.17)

Ein anti-symmetrischer Tensor kann immer durch folgende Vorschrift definiert werden:

~ B

~ = 1 H A,

~ B

~ − 1 H B,

~ A

~

H(A) A,

2

2

1

1

⇒ H(A) (êα , êβ ) = H (êα , êβ ) − H (êβ , êα )

2

2

1

= (Hαβ − Hβα )

2

=: H[αβ]

(7.4.18)

Somit ist

1

1

(Hαβ + Hβα ) + (Hαβ − Hβα )

2

2

= H(αβ) + H[αβ]

Hαβ =

(7.4.19)

Daraus lässt

sich

eine sehr wichtige Eigenschaft ableiten:

0

Jeder

-Tensor kann eindeutig in seinen symmetrischen und anti2

symmetrischen Anteil zerlegt werden.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

251

Beispiel Es sei wieder

C=

Nach 7.4.18 gilt C[αβ] =

Tensors sind nun

1

2

1 2

3 4

(Cαβ − Cβα ). Die Komponenten des anti-symmetrischen

1

(C11 − C11 ) = 0

2

1

= (C22 − C22 ) = 0

2

1

1

1

= (C12 − C21 ) = (2 − 3) = −

2

2

2

1

1

1

= (C21 − C12 ) = (3 − 2) =

2

2

2

C[11] =

C[22]

C[12]

C[21]

und es folgt

C(A) =

0

1/2

−1/2 0

Wir wollen nun zeigen, dass der symmetrische und anti-symmterische Tensor

in der Tat den ursprünglichen Tensor C erzeugen

0 −1/2

1 5/2

+

C = C(S) + C(A) =

1/2

0

5/2 4

1 2

1+0

5/2 − 1/2

=

=

3 4

5/2 + 1/2

4+0

Der metrische Tensor ist ebenfalls symmetrisch:

~ B

~ = g Aα êα , B β êβ = Aα B β g (êα , êβ ) = Aα B β gαβ

g A,

~ A

~ = g B β êβ , Aα êα = B β Aα g (êβ , êα ) = Aα B β gβα

g B,

(7.4.20)

Da nun das Skalarprodukt ja eine Zahl ist und diese unabhängig der Reihenfolge wie es gebildet wird immer die gleiche Zahl ergibt ist nun ersichtlich,

warum

~·B

~ = Aα B β gαβ = B

~ ·A

~ = B β Aα gβα

A

(7.4.21)

also

~ B

~ = g B,

~ A

~

g A,

(7.4.22)

und somit gilt natürlich auch gαβ = gβα

7.5

Die Metrik als Abbildung von Vektoren in 1-Formen

Sicherlich hat sich der Leser schon die Frage gestellt, ob Vektoren in 1-Formen

umgewandelt werden können. Die Antwort zu dieser Frage ist ja. Wie das ganze funktioniert? Mit der schon so oft erwähnten Metrik.

Betrachten wir g ( , ) = g:

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

252

0

2

Der metrische Tensor ist vom Typ

, was bedeutet, dass er zwei

~,

~ ein Vektor. Dann ist g V

Vektoren als Argumente braucht. Es sei also V

nichts anderes als eine 1-Form, da dieses Konstrukt einen Vektor als Argument braucht um eine reelle Zahl zu erzeugen, genau wie eine 1-Form auch.

Somit ist

~,

≡ Ṽ ( )

(7.5.1)

g V

~

~ ,A

~ =V

~ ·A

~

⇒ Ṽ A

≡ g V

da g ( , ) symmetrisch ist, gilt somit auch

~

Ṽ ( ) = g , V

Wie wollen uns nun fragen, wie die Komponenten von Ṽ ( ) aussehen. Dazu

setzen wir in bekannter Manier den Basis-Einheitsvektor in 7.5.1 ein.

~ · êα = êα · V

~ = êα · V β êβ

Vα = Ṽ (êα ) = V

= (êα · êβ ) V β

≡ gαβ V β

Wir sehen also

Vα = gαβ V β

(7.5.2)

~ mit den Komponenten V β eine 1Die Metrik macht also aus einem Vektor V

Form mit Komponenten Vα . Hier erkennen wir auch wieder die Notwendigkeit

zwischen Ko- und Kontravarianten Vektoren zu unterscheiden.

Es gibt jedoch Fälle wo dieser Unterschied nicht zum Vorschein kommt.

Dies ist leider (oder zum Glück) bei der Euklidischen Metrik der Fall:

1 0 0

(δαβ ) = 0 1 0

(7.5.3)

0 0 1

Deswegen war es bis vor kurzem auch nicht notwendig, zwischen Vektoren

und 1-Formen zu unterscheiden. Es galt also Vα = V β . Doch schon bei einer

kleinen Änderung in der Metrik, wie z.B. im Minkowski-Raum in der speziellen

Relativitätstheorie, ist die Unterscheidung extrem wichtig.

−1 0 0 0

0 1 0 0

(ηαβ ) =

(7.5.4)

0 0 1 0

0 0 0 1

Betrachten wir als Beispiel die nullte Komponente eines Vektors im MinkowskiRaum.

V0 = ηαβ V β = η00 V 0 + η01 V 1 + η02 V 2 + η03 V 3

= −1V 0 + 0

= −V 0

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

253

Wir sehen, die Komponente ist nicht mehr gleich. Die äquivalente Betrachtung

für die erste Komponente liefert

V1 = η1β V β = η10 V 0 + η11 V 1 + η12 V 2 + η13 V 3

= 0V 0 + 1V 1 + 0V 2 + 0V 3

= V1

Die anderen Komponenten berechnen sich gleich und wir erhalten für den Vek~

tor V

0

V

V1

~ =

V

V2

V3

die 1-Form

Ṽ = (V0 , V1 , V2 , V3 ) = −V 0 , V 1 , V 2 , V 3

Bei komplizierteren Metriken können die Unterschiede zwischen Vektor und

1-Form erheblich größer sein.

Die ganze Geschichte funktioniert natürlich auch in umgekehrter Richtung,

also von 1-Form zu Vektor. Auch dies geschieht wiederum mit der Metrik.

Da Vα = ηαβ V β ist, und ηαβ als Komponenten einer Matrix aufgefasst werden können, müssen wir für die Umkehrung lediglich die ”inverse Matrix” finden. Jene existiert jedoch nur, wenn die Determinante nicht verschwindet (siehe 6.3.1).

Wir sehen schnell, dass dies für den Euklidischen- und Minkowski-Raum

gilt. Die inverse

von 7.5.3 und 7.5.4 existieren also.

Sei η αβ die inverse von (ηαβ ); dann gilt:

Aα = η αβ Aβ

(7.5.5)

Aβ = ηαβ Aα = ηαβ η αγ Aγ = δβ γ Aγ

(7.5.6)

Weiters gilt

Wie sieht nun η αβ aus? Wegen ηαβ η αγ = δβ γ folgt mit Hilfe von 7.5.4

η 00 = −1,

η 0i = 0, η ij = δ ij i, j = 1, 2, 3

(7.5.7)

d.h. die Komponenten, von η αβ sind gleich denen von (ηαβ ).

Wir wollen an dieser Stelle nochmals eine Anmerkung zum Gradienten

˜ können wir nun auch einen

machen. Mit dem Gradienten, d.h. der 1-Form dφ,

~ assoziieren. Seine Komponenten sind durch

Gradientenvektor dφ

(dφ)α = η αβ (dφ)β

(7.5.8)

~ ist wie gewohnt orthogonal zu Flächen gerichtet. Das innere Progegeben. dφ

dukt dieses Vektors mit einem Vektor, der in der

Tangentialfläche liegt, ist somit

˜

~ , was die Änderungsrate von

Null. Dies wäre aber auch identisch mit dφ V

~ angibt. Liegt nun V

~ in der Tangentialfläche, ist auch jene Ändeφ entlang V

rungsrate Null, da hier φ = const.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

254

Für was brauchen wir überhaupt eine Metrik? In der Physik ist das Skalarprodukt von Vektoren sehr oft nützlich.

Um aus zwei Vektoren einen Skalar

0

zu generieren braucht man einen

-Tensor, also eine Metrik.

2

Weiters gibt die Metrik dem Raum eine Struktur. Sie beschreibt, wie stark

er gekrümmt ist, wie ich von Punkt A zu Punkt B komme und wie groß die Abstände zwischen den einzelnen Punkten sind. Es ist die Metrik, die letztendlich

dem euklidischen Raum seine typischen Eigenschaften gibt.

Räume, bei denen die Norm eines Vektors positiv definit ist (siehe weiter unten) nennt man Riemann’sche Räume. Räume, bei denen die Norm

indefinit ist (wie etwa der Minkowski-Raum), werden Pseudo-Riemann’sch

genannt.

Es sei hier auch noch erwähnt, dass es durchaus auch antisymmetrische

Metriken gibt. In der Quantenmechanik findet z.B. eine solche Metrik Anwendung, nämlich jene des Spinor-Raumes.

7.6

Exkurs: Die Quantenmechanik als Beispiel einer

Anwendung in der Physik

In der Quantenmechanik wird sehr viel vom bis jetzt Besprochenen Gebrauch

gemacht. Die Lösung der Schrödingergleichung ist die Wellenfunktion Ψ (~x).

Diese ist komplex (und nicht nur im Auffinden der Lösung...). Sie ist ein Element des sogenannten Hilbert-Raumes eines Vektorraumes, der quadrat integrablen Funktionen φ (~x).

In der Quantenmechanik ist das innere Produkt zwischen einer Funktion

φ (~x) und einer Wellenfunktion Ψ (~x) nicht

Z

φ (~x) Ψ (~x) d3 x

sondern

Z

φ∗ (~x) Ψ (~x) d3 x

wobei φ∗ (~x) die zu φ (~x) komplex konjugierte Funktion ist.

Wir können somit sagen, dass φ∗ (~x) wie eine 1-Form auf Ψ (~x) wirkt und

nur so das innere Produkt auch wirklich eine reelle Zahl ist. Die Operation des

komplex Konjugierens wirkt wie eine Metrik und transformiert φ (~x) → φ∗ (~x),

d.h. einen Vektor in eine 1-Form.

Dieser Dualismus zwischen φ und φ∗ kann am besten in der Dirac’schen

”bra”- und ”ket”-Schreibweise gesehen werden. Die Elemente des Raumes

aller Teilchenzustände sind ket-Vektoren | i, während die Elemente aus dem

Dualraum bra-Vektoren h | sind.

So bilden die Vektoren |1i und |2i keine reelle Zahlen, sondern nur zum

Beispiel h2| 1i bildet eine reelle Zahl und damit einen meßbaren Zustand.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

7.7

255

Norm und Skalarprodukt von 1-Formen

Dass ein Vektor eine Norm (respektive einen Betrag) besitzt und dass dieser

eine Zahl ist, braucht hier wohl nicht genauer diskutiert zu werden. Für jeden

Vektor gilt

p2 = pα pα = gαβ pα pβ = p~2 = p̃2

(7.7.1)

und dies gilt somit auch für die 1-Form. Dies haben wir in 7.7.1 etwas intuitiv

aufgeschrieben und wollen es nun explizit zeigen. Dazu bilden wir die Vektoren

p~ in eine 1-Form ab und bilden so die Norm.

p̃2 = gαβ (g αµ pµ ) g βν pν

(7.7.2)

Es muss hier beachtet werden, dass jede unabhängige Summation in 7.7.2

durch einen eigenen Index beschrieben wird, einem sogenannten DummyIndex. Da nun gαβ und g βν zueinander invers sind, kollabiert eine Summation

über β zu gαβ g βν = δα ν (siehe 6.1.10). Somit wird aus 7.7.2

p̃2 = g αµ pµ δα ν pν = g αµ pµ pα

(7.7.3)

Wir sehen, dass mit Hilfe des inversen metrischen Tensors die Norm einer

1-Form aus ihren Komponenten gebildet werden kann.

Als Beispiel dazu die Norm einer 1-Form im Minkowski-Raum:

p̃2 = − (p0 )2 + (p1 )2 + (p2 )2 + (p3 )2

(7.7.4)

Als Vergleich dazu die Norm eines Vektors im Minkowski-Raum (wir sehen,

der inverse metrische Tensor ist mit dem nicht inversen identisch)

~ 2 = − A0

A

7.7.1

2

+ A1

2

+ A2

2

+ A3

2

(7.7.5)

Inneres Produkt zweier 1-Formen

Analog zu Vektoren, kann man nun auch das innere Produkt (Skalarprodukt)

für eine 1-Form definieren. Ausgehend von der Definition der Norm schreiben

wir das innere Produkt in der Form

i

1h

p̃ · q̃ =

(p̃ + q̃)2 − p̃2 − q̃ 2

(7.7.6)

2

1

= [g αµ (pµ + qµ ) (pα + qα ) − g αµ pµ pα − g αµ qµ qα ]

2

an. Dass dies Zweckmässig ist und zum gewünschten Resultat führt, wollen

wir nun zeigen. Wir müssen diese Schreibweise wählen, da wir bis jetzt nur die

Norm definiert haben und in 7.7.6 auch nur Normen verwendet (die Summe

zweier 1-Formen ist ja wiederum eine 1-Form) haben. Es ist dann also z.B. im

euklidischen Raum in Komponenten-Schreibweise

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

p̃ · q̃ =

256

1h

(p1 + q1 )2 + (p2 + q2 )2 + (p3 + q3 )2 − (p1 )2 − (p2 )2 − (p3 )2

2

i

− (q1 )2 − (q2 )2 − (q3 )2

1h

=

(p1 )2 + 2p1 q1 + (q1 )2 + (p2 )2 + 2p2 q2 + (q2 )2 + (p3 )2 + 2p3 q3 + (q3 )2

2

i

− (p1 )2 − (p2 )2 − (p3 )2 − (q1 )2 − (q2 )2 − (q3 )2

Dabei fallen einige Terme weg und wir erhalten

1

[2p1 q1 + 2p2 q2 + 2p3 q3 ]

2

= p1 q1 + p2 q2 + p3 q3

=

Im Minkowski-Raum erhält man analog

p̃ · q̃ = −p0 q0 + p1 q1 + p2 q2 + p3 q3

7.8

Allgemeine (M, N )-Tensoren

Bis jetzt haben wir uns nur mit speziellen Formen der Tensoren beschäftigt

und dadurch einen Einblick in diese Welt bekommen.

Nun

möchten wir die

M

abstrahieren.

Eigenschaften zu allgemeinen Tensoren der Stufe

N

Der Dualismus zwischen Vektoren und 1-Formen ist vollständig. Wir haben

1-Formen als lineare Funktionen von Vektoren kennengelernt, d.h. Vektoren

werden die Argumente von 1-Formen, die dann als Ergebnis reelle Zahlen

produzieren. Wir konnten auch zeigen, dass die Umkehrung ebenfalls gilt, also

D

E

~ ≡V

~ (p̃) ≡ pα V α ≡ p̃, V

~

p̃ V

(7.8.1)

Auf diese Weise haben Vektoren als Argument von Tensoren (z.B. 1-Formen)

ihre Sonderstellung verloren und wurden selbst zu Tensoren. Die Notation h , i

soll diese Gleichstellung von Vektoren mit Tensoren veranschaulichen. Wir erkennen auch, dass die Kontraktion (Verjüngung) von Tensoren die fundamentale Operation ist durch die sich der Dualismus manifestiert.

7.8.1 (M, 0)-Tensoren

M

Definition 7.8.1. Ein

-Tensor ist eine lineare Funktion, die M

0

1-Formen in die reellen Zahlen abbildet.

2

~ ⊗W

~ erzeugt. Dieser

So ist zum Beispiel ein einfacher

-Tensor durch V

0

besitzt 2 ”Slots”, in die jeweils eine 1-Form (z.B. p̃ oder q̃) gesteckt werden

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

257

kann. Es gilt dann

~ = V α pα W β qβ

~ q̃ W

~ ⊗W

~ (p̃, q̃) = V

~ (p̃) W

~ (q̃) ≡ p̃ V

V

Die Komponenten des

2

0

(7.8.2)

~ ⊗W

~ ( , ) sind also durch V α W β ge-Tensors V

geben.

Die Basis eines solchen Tensors finden wir leicht und ist z.B.

êα ⊗ êβ

(7.8.3)

M

Analog zum obigen Beispiel werden

-Tensoren gebildet. Die Operation

0

⊗ steht für das äußere Produkt, welches als Resultat einen Tensor höherer

Stufe erzeugt.

M

Die Komponenten eines

-Tensors sind die reellen Zahlen, welche

0

M

entstehen, wenn die Argumente von

die Basis-1-Formen ω̃ α sind. Be0

M

-Tensoren nur kontravariante Indizes haben (also

achte dabei, dass

0

solche, die oben stehen).

7.8.2 (M, N )-Tensoren

Die naheliegende Verallgemeinerung aus dem Vorhergegangen ist somit:

M

-Tensor ist eine lineare Funktion die M

Definition 7.8.2. Ein

N

1-Formen und N Vektoren als Argumente hat und in die reellen Zahlen

abbildet.

1

-Tensor, dann besitzt dieser zwei ”Schlitze” um

Sei zum Beispiel < ein

1

eine reelle Zahl erzeugen zu können. Einen für eine 1-Form p̃ und einen für

~ Die Komponenten dieses Tensors sind dann durch

einen Vektor A.

Rβ α = < (ω̃ α ; êβ )

(7.8.4)

gegeben.

M

Ein

-Tensor hat somit M kontravariante und N kovariante Indizes.

N

Transformieren wir nun Rβ α in ein neues Bezugssystem, so gilt:

Rβ α = < ω̃ α ; êβ = < Λµ α ω̃ µ ; Λβ ν êν

= Λµ α Λβ ν < (ω̃ µ ; êν ) = Λµ α Λβ ν Rν µ

(7.8.5)

Die Transformation im allgemeinen Fall funktioniert analog und ist sehr einfach.

Jeder Index bringt eine Tranformationsmatrix Λ ins Spiel, wobei die Indizes

gemäß der Summenkonvention angeordnet werden.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

Ein Wort noch zur Notation. Wir schreiben für einen

< p̃, q̃, . . . ; ~b, ~c, . . .

258

M

N

-Tensor

(7.8.6)

wobei ein Komma hier die Trennung der einzelnen gleichartigen Elemente angibt (trennt die einzelnen Vektoren und 1-Formen ab) und ein Semikolon die

Trennung zwischen den 1-Formen und Vektoren als Gesamtheit bezeichnet.

Die Komponenten von 7.8.6 schreiben wir wie folgt

Rµν... αβ... = < ω̃ α , ω̃ β , . . . ; êµ , êν , . . .

(7.8.7)

7.8.3

”Index-Gymnastik”

~

Wir haben gesehen, dass wir mit Hilfe des metrischen Tensors einen Vektor V

in eine 1-Form Ṽ überführen können.

Vα = ηαβ V β

M

-Tensor

In gleicher Weise erzeugen wir mittels der Metrik aus einem

N

M −1

-Tensor. Analog dazu, können wir auch mittels der inversen

einen

N +1

M +1

M

-Tensor ge-Tensor einen neuen

Metrik η αβ aus einem

N −1

N

nerieren. Allgemein wird in der deutschen Literatur als Überschiebung die

Kontraktion eines oberen Indizes eines Tensors mit einem unteren eines anderen Tensors bezeichnet. Die Kontraktion über einen Index eines Tensors,

d.h. das Gleichsetzen eines oberen und eines unteren Indizes und anschließenderSummation

wird als

bezeichnet. Hierdurch entsteht aus

Verjüngung

M −1

M

-Tensor.

einem

-Tensor ein

N −1

N

2

-Tensor Tγ αβ , dann gilt

Ein Beispiel: Betrachten wir den

1

Tβγ α = ηβµ Tγ αµ

(7.8.8)

2

1

Wir haben also aus einem

-Tensor einen

-Tensor generiert. Wei1

2

ters können wir unter anderem die Tensoren

Tα β γ = ηαµ Tγ µβ

(7.8.9)

3

(beachte, dieser Tensor ist komplett verschieden zu 7.8.8) oder den

0

Tensor

T αβγ = η γµ Tγ αβ

(7.8.10)

generieren.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

7.8.4

259

Metrik mit gemischten Komponenten

Wir haben gesehen, dass die Komponenten der Metrik durch ηαβ gegeben

sind und jene der inversen durch η αβ . Wir können nun auch für den metrischen

Tensor einen Index rauf oder herunter ziehen,

ηβ α = η αµ ηµβ ≡ δβ α

(7.8.11)

da (η αµ ) und (ηµβ ) inverse Matrizen sind.

Ziehen wir noch einen Index hoch, ergibt sich lediglich eine Identität

η αβ = η µβ ηµ α = η µβ δµ α ≡ η αβ

(7.8.12)

Für den metrischen Tensor g sind die kontravarianten Komponenten gleich

jener Elemente der Matrix, die zu den kovarianten Komponenten von g invers

sind. Der metrische Tensor ist der einzige Tensor, für den dies gilt!

7.9

Differentiation von Tensoren allgemein

Wie Tensoren abgeleitet werden, haben wir schon im Kapitel 7.3.8

ange kurz

0

-Tensor

sprochen. Wir wollen uns erinnern, dass eine Funktion F ein

0

M

0

˜ ein

-Tensor. Die Differentiation eines

ist, und der Gradient dF

N

1

M

-Tensor.

Tensors erzeugt somit einen

N +1

1

-Tensor mit den Komponenten R(t)β α .

Es sei zum Beispiel <(t) ein

1

Wir können nun allgemein < schreiben als

<(t) = R(t)β α ω̃ β ⊗ êα

(7.9.1)

Die Ableitung von <(t) nach t ist dann gegeben durch den Differenzenquotient

d<(t)

<(t + ∆t) − <(t)

= lim

∆t→0

dt

∆t

(7.9.2)

Da die Basisvektoren und Basis-1-Formen sich nicht mit t ändern sollen, d.h.

ω̃(t + ∆t) = ω̃(t) folgt

dRβ α

d<(t)

=

ω̃ β ⊗ êα

(7.9.3)

dt

dt

da wie gesagt

dω̃ β

dêα

=

≡0

dt

dt

Wie im Falle des Gradienten gilt aber

φ,α ≡

∂φ

∂xα

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

und

260

dφ

∂φ α

=

U

dt

∂xα

womit also gilt

dφ

= φ,α U α

dt

Wir können nun also folgendes schreiben

dRβ α

= Rβ,γ α U γ

dt

1

1

Dabei ist

ein

-Tensor, da er ja nach der Definition des Differenzen 1

quotientes nur die Differenz von zwei

-Tensoren ist. Aufgrund der Kon1

~ ist Rβ,γ α aber ein 1 -Tensor. Es ist somit

traktion mit U

2

d<

dt

(7.9.4)

d< = Rβ,γ α ω̃ β ⊗ êα U γ

dt

da U γ =

dxγ

dt .

Es ist nun

∂xγ

∂<

α β

σ

α β

=

R

ω̃

⊗

ê

⊗

ω̃

=

R

ω̃

⊗

ê

⊗ δσ γ ω̃ σ

α

α

β,γ

β,γ

∂xσ

∂xσ

(7.9.5)

Der Gradient des Tensors < ist nun

~ = ∂< = Rβ,γ α ω̃ β ⊗ êα ⊗ δσ γ ω̃ σ

∇<

∂xσ

= Rβ,γ α ω̃ β ⊗ ω̃ γ ⊗ êα

(7.9.6)

~ da d˜ bereits für einen anderen Zweck reserWir benützen die Schreibweise ∇,

viert ist. Es gilt ferner als Notation

d<

~ ~<

≡∇

U

dt

~ differenziert wird, sondern entlang einer KurDies bedeutet nicht, dass nach U

~ tangential ist.

ve, zu der U

d<

~ ~ < → {Rβ,γ α U γ }

≡∇

U

dt

Bei dieser Herleitung wurde benutzt, dass sich die Basis-Vektoren und Basis

1-Formen nicht mit dem Ort ~x ändern. Genau das ist aber zum Beispiel in der

allgemeinen Relativitätslehre nicht mehr gegeben, da ändert sich die Metrik

von Ort zu Ort.

Wir werden dann sehen, dass die örtliche Änderung der Metrik mit Hilfe

der Christoffel-Symbole beschrieben werden kann.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

7.10

Spezielle Tensoren

7.10.1

Kronecker-Delta

261

Wir haben es schon oft benutzt, jetzt wollen wir es endlich systematisch einführen: das Kronecker-Delta. Wir haben die exakte Definition bewusst bis jetzt

herausgezögert, damit wir die Tensorform des Kronecker-Deltas sichtbar machen konnten um es entgegen gängigen Lehrbüchern auch gleich so zu definieren. Wir verwenden von jetzt an immer die Tensorform des KroneckerDeltas.

Definition 7.10.1. Das Kronecker-Delta ist wie folgt definiert:

(

0, i 6= j

δj i =

(7.10.1)

1, i = j

Das Kronecker-Delta ist also ein symmetrischer Tensor, der in der Diagonalen

nur die Elemente 1 enthält, ansonsten 0.

Eine wichtige Eigenschaft des Kronecker-Delta ist es, dass es gleiche Indizes austauscht. Also in einem Beispiel:

n j

δj i δm n Aklm i = δm

Aklm = Akln j

Weiters betrachten wir noch eine andere Eigenschaft, die hauptsächlich

von der einsteinschen Summenkonvention herrührt. Was bedeutet der Ausdruck δi i ? Nachdem über gleiche Indizes von 1 . . . N summiert wird gilt

δi i = δ1 1 + δ2 2 + . . . + δN N = 1 + 1 + . . . + 1 = N

(7.10.2)

Da im euklidischen Raum nicht zwischen ko- und kontravarianten Indizes unterschieden wird, gilt dort: δj i = δij = δ ij

7.10.2

Epsilon-Tensor (Levi-Civita Symbol)

Auch schon oft angetroffen aber nie richtig definiert wurde der Epsilon-Tensor

(auch Levi-Civita Symbol genannt). Er ist ein vollständig anti-symetrischer Tensor.

Definition 7.10.2. Der Epsilon-Tensor (Levi-Civita Symbol) ist wie

folgt definiert:

+1, gerade Anz. von paarweisen Permutationen

ij...k

ij...k = = −1, ungerade Anz. von paarweisen Permutationen

0,

wenn zwei oder mehrere Indizes gleich sind

(7.10.3)

Zum Beispiel gilt:

ijkl = −jikl = +jkil = . . .

Die erste Vertauschung von i und j ist ungerade, daher das Minuszeichen.

Werden zusätzlich noch i und k vertauscht, so hat man eine gerade Anzahl

von Permutationen, daher das Pluszeichen.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

262

Der Epsilon-Tensor kann auch in einer gemischten Form auftreten. Dabei

gelten die gleichen Eigenschaften wie bei der nicht gemischten Form. Es gilt

deswegen zum Beispiel für einen Tensor 6. Stufe

ijklmn = ijklmn = ijk lmn = ijkl mn = . . .

(7.10.4)

Das Transformationsverhalten des Epsilon-Tensors ist analog zu normalen

Tensoren

µνρ = Λµ η Λν σ Λρ τ ηστ

(7.10.5)

und im allgemeinen sind die Λµ η 6= 1.

Gehen wir nochmals kurz darauf ein, wie die Permutationen vorzunehmen

sind. Im Falle von drei Indizes kann man die geraden und ungeraden Permutationen auch als zyklisch und anti-zyklisch betrachten.

k

i

k

j

i

anti-zyklisch

j

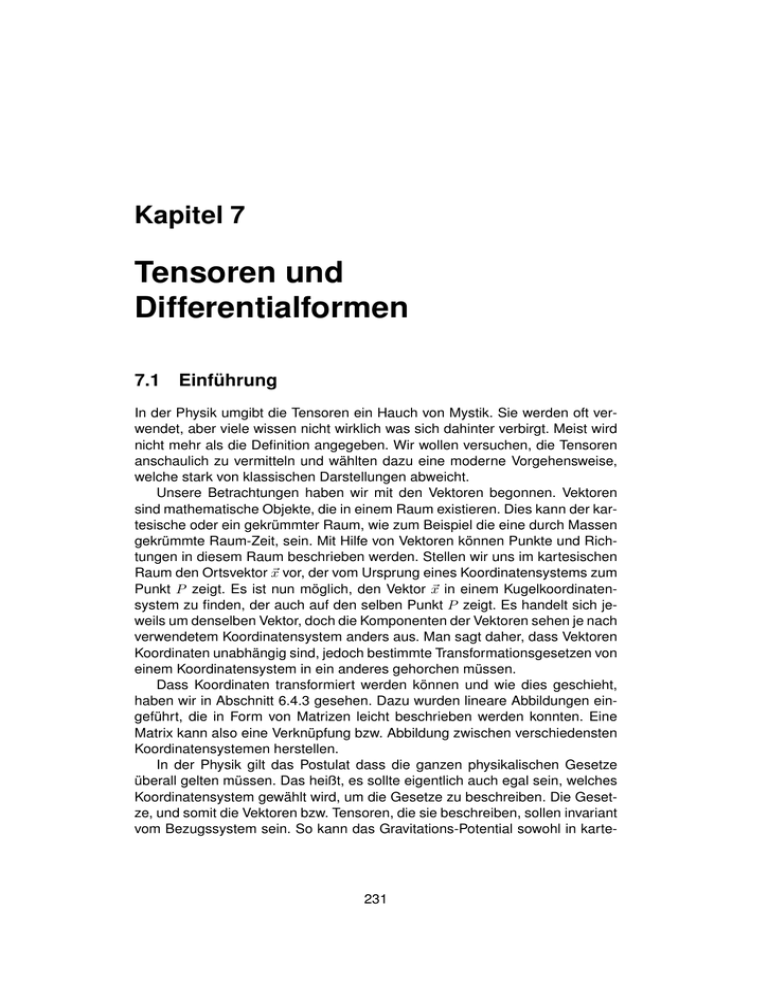

Abbildung 7.10.1: Graphische Darstellung einer zyklischen und antizyklischen Vertauschung

zyklisch

Eine zyklische Permutation liegt dann vor, wenn die Indizes im mathematisch positiven Sinn (der vordere Index wird immer nach hinten geschoben)

permutiert werden. Die Ausgangssituation ist i, j, k.

i, j, k j, k, i k, i, j

Eine anti-zyklische Permutation ist das exakte Gegenteil, z.B. es wird von

k, j, i gestartet (es kommt nicht darauf an, wo gestartet wird).

k, j, i j, i, k i, k, j

Für alle, die sich lieber was graphisches merken wollen, sind die Permutationstypen auch nochmals in 7.10.1 abgebildet. Da der Epsilon-Tensor 3. Stufe sich

auch gut visualisieren lässt, haben wir dies anhand eines Würfels in 7.10.2

gemacht.

7.10.2.1

Rechenregeln für den Epsilon-Tensor

Wir wollen nun die Rechenregeln für den Epsilon-Tensor angeben.

Man kann sich schnell vergewissern, dass der Epsilon-Tensor in folgender

Form aufgeschrieben werden kann.

1

1

1 δi

2 δj 2 δk 2 δj

δk (7.10.6)

ijk = δi

δi 3 δj 3 δk 3 KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

0

263

0

0

0

1

3

0

0

0

-1

0

0

0

j

0

0

1

-1

2

0

0

-1

0

3

0

1

0

2

0

k

0

1

0

1

2

0

1

3

i

Abbildung 7.10.2: Bildform des Epsilon-Tensors.

Multiplikation zweier Epsilon-Tensoren, keine gleichen Indizes Das Produkt zweier Epsilon-Tensoren 3. Grades schreibt sich in der allgemeinsten

Form

1

δi

δj 1 δk 1 δ1 l δ1 m δ1 n ijk lmn = δi 2 δj 2 δk 2 δ2 l δ2 m δ2 n δi 3 δj 3 δk 3 δ3 l δ3 m δ3 n Damit wir nicht die Determinanten ausschreiben müssen und alles ausmultiplizieren, erinnern wir uns an die Determinanten-Rechenregel det A · det B =

det A · B und transponieren die erste Matrix (das verändert ja den Wert der

Determinante nicht), erhalten wir

1 2 3 δi δi δi δ1 l δ1 m δ1 n δi l δj l δk l ijk lmn = δj1 δj2 δj3 δ2 l δ2 m δ2 n = δi m δj m δk m (7.10.7)

δ 1 δ 2 δ 3 δ3 l δ3 m δ3 n δi n δj n δk n k

k

k

Um zu zeigen, wie man das herleitet, schauen wir uns das erste Element der

resultierenden Determinante an. Nachdem die beiden Matrizen miteinander

multipliziert werden (siehe Rechenregel für Determinaten oben), besteht das

erste Element der Determinante rechts aus

δi 1 δ1 l + δi 2 δ2 l + δi 3 δ3 l = δi k δk l = δi l

Dabei haben wir die Einsteinsche Summenkonvention angewendet.

7.10.6 und 7.10.7 können sinngemäss auch auf höherstufige Epsilon-Tensoren

ausgeweitet werden, sollte der Bedarf bestehen.

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

264

Multiplikation zweier Epsilon-Tensoren, ein gemeinsamer Index Wir betrachten nun den Fall, bei dem zwei Epsilon-Tensoren über einen gemeinsamen Index summiert werden. Dazu nützen wir die Kontraktion eines Tensors

aus.

ijk lmk = ijk lmk = ij lm

Dies ist mittels 7.10.7

ij

lm

δ l δj l

= im

δj m

δi

= δi l δj m − δi m δj l

Somit ist also

ijk lmk = δi l δj m − δi m δj l

(7.10.8)

Wir merken an, dass im euklidischen Raum dies identisch ist mit ijk lmk , da

hier die ko- und kontravarianten Komponenten der Tensoren gleich sind.

Multiplikation zweier Epsilon-Tensoren, zwei gemeinsame Indizes Sind

zwei Indizes gleich, können wir von der vorher hergeleiteten Relation ausgehen.

ijk ljk = δi l δj j − δi j δj l

Nachdem über gleiche Indizes summiert wird, ist δj j = 3. Im zweiten Term

δi j δj l werden die Indizes ausgetauscht und wir erhalten

ijk ljk = 3δi l − δi l = 2δi l

(7.10.9)

Multiplikation zweier Epsilon-Tensoren, drei gleiche Indizes Sind alle drei

Indizes gleich, wird es ganz einfach. Auch hier wenden wir die gerade erst hergeleitete Identität an

ijk ijk = 2δi i = 6

(7.10.10)

da ja wie schon gezeigt, δi i = 3 ist.

Beispiel Und wozu kann man das alles brauchen? Der Epsilon-Tensor erleichtert oft das Rechnen mit Kreuzprodukten. Zum Beispiel haben wir im Kapitel mit den Vektoren schon vorweggenommen, dass das Kreuzprodukt mit

5.2.43 als

~a × ~b = jk i aj bk

geschrieben werden kann. Damit können wir beliebige Kombinationen von

Kreuzprodukten ausrechnen, ohne dass wir das alles komponentenweise ausrechnen müssen (was man vielleicht mal gemacht haben muss, damit man

vom Epsilon-Tensor endgültig überzeugt ist - zwei Minuten oder einige halbe

Stunden rechnen macht schon einen Unterschied).

Wir wollen das Verfahren am folgenden Beispiel zeigen.

~a × (~b × ~c)

KAPITEL 7. TENSOREN UND DIFFERENTIALFORMEN

265

Als erstes möchten wir zeigen, wie wir so einen Ausdruck in die Indexschreibweise übersetzen. Am sichersten ist es, einen Ausdruck von innen nach aussen umzuschreiben, also die innerste Klammer zuerst, und sich dann immer

weiter nach außen. vorarbeiten

Nachdem im Falle eines Kreuzprodukts ein Vektor resultiert, bleibt immer

h

ii

ein Index übrig, der den neuen Vektor charakterisiert. Für ~a × ~b = jk i aj bk

wäre dies der Index i. Damit der Überblick über solche Indizes nicht verloren

geht, schreiben wir diese immer hinter die zugehörigen Klammern. Wichtiger

noch: während die linke Seite ohne den Index i den neuen Vektor bezeichnen

würde gibt jk i aj bk nur die i-te Komponente an, dafür aber eine beliebige. Man

sieht also den Vorteil gegenüber dem explixiten Ausrechnen aller Komponenten.

In unserem Beispiel würde das dann der Reihe nach so ausschauen. Wir

beginnen mit der Klammer

h

im

~a × (~b × ~c) → ~a × (~b × ~c) = li m al jk i bj ck

Nun gilt es, diesen Ausdruck auszuwerten. Dazu verwenden wir hauptsächlich die Gleichung 7.10.8, da wir zwei Epsilon-Tensoren miteinander multiplizieren, die einen gemeinsamen Index besitzen. Es ist nun extrem wichtig,

welche Reihenfolge die Indizes einnehmen. In Gleichung 7.10.8 steht der gemeinsame Index immer am Schluss der Epsilon-Tensoren. mli jki In unserem

Fall aber, steht im zweiten Tensor der gemeinsame Index i an erster Stelle. Unter Berücksichtigung der Eigenschaften der Permutationen von Indizes

können wir den Ausdruck mli ijk in die gewünschte Form bringen. Dazu wird

aus ijk → jki und wir erhalten und formen dies mit den entsprechenden Rechenregeln des Kronecker-Deltas um auf

al bj ck li m jk i = al bj ck (δj m δlk − δk m δlj ) = ak bj ck δj m − aj bj ck δk m

= ak ck bm − aj bj cm → (~a · ~c) ~b − ~a · ~b ~c

Der resultierende Ausdruck kann nun wieder in die Vektorform rückübersetzt

werden, indem die Definition des Skalarproduktes in Indexschreibweise 5.2.10

berücksichtigt wird.

~a × ~b × ~c = ~b (~a · ~c) − ~c ~a · ~b

Man beachte die Klammersetzung, die

durch

das Skalarprodukt vorgegeben

ist, d.h. im allgemeinen ist ~b (~a · ~c) 6= ~b · ~a ~c. Die beschriebene Rechenmethode ist vielleicht am Anfang etwas ungewohnt, aber erleichtert zum Glück

das Rechnen erheblich.