Schema-Management in NoSQL

Werbung

Hochschule Darmstadt

- Fachbereich Informatik -

Schema-Management in

NoSQL-Datenbanksystemen

Abschlussarbeit zur Erlangung des akademischen Grades

Master of Science (M.Sc.)

vorgelegt von

Helena Glatzel

Referentin:

Korreferentin:

Prof. Dr. Uta Störl

Prof. Dr. Inge Schestag

Ausgabedatum:

02.10.2013

Abgabedatum:

02.04.2014

Erklärung

Ich versichere hiermit, dass ich die vorliegende Arbeit selbständig verfasst und

keine anderen als die im Literaturverzeichnis angegebenen Quellen benutzt habe.

Alle Stellen, die wörtlich oder sinngemäß aus veröffentlichten oder noch nicht

veröffentlichten Quellen entnommen sind, sind als solche kenntlich gemacht.

Die Zeichnungen oder Abbildungen in dieser Arbeit sind von mir selbst erstellt

worden oder mit einem entsprechenden Quellennachweis versehen.

Diese Arbeit ist in gleicher oder ähnlicher Form noch bei keiner anderen

Prüfungsbehörde eingereicht worden.

Darmstadt, den 02.04.2014

___________________________________________________

(Helena Glatzel)

I

Abstract

In der Anwendungsentwicklung finden sich mittlerweile immer kürzere ReleaseZyklen, auf die auch im Bereich der Datenbanken entsprechend reagiert werden

muss. Gerade im Umfeld der Webanwendungen erfreuen sich daher NoSQLDatenbanksysteme zunehmender Beliebtheit. Durch deren Schema-Flexibilität

kann effizient auf die schnellen Änderungen von Anwendung und Datenschema

eingegangen werden.

Üblicherweise ist es in NoSQL-Systemen nicht erforderlich im Voraus ein Schema

zu definieren. Dieses ergibt sich implizit durch die Struktur der Daten und muss

nicht gesondert definiert und verwaltet werden. Dadurch können jederzeit flexibel

Änderungen am Schema vorgenommen werden.

Allerdings bedeutet dies auch, dass die Verwaltung des Schemas zum Großteil in

der

Verantwortung

der

Anwendung

liegt.

Um

die

Komplexität

der

Anwendungsentwicklung zu begrenzen, ist ein gewisses Maß an Unterstützung

durch das eingesetzte Datenbanksystem wünschenswert.

Diese Arbeit gibt daher einen Überblick über die momentane Unterstützung des

Schema-Managements

durch

die

gängigsten

NoSQL-Datenbanken

und

vielversprechendsten zusätzlichen Entwicklungen. Zu diesem Zweck werden

anhand eines zuvor definierten Anforderungskataloges die sechs meist genutzten

NoSQL-Systeme sowie sechs erweiternde Aufsätze analysiert.

Im Anschluss werden die gewonnenen Erkenntnisse genutzt, um eine SchemaManagement-Komponente zu entwerfen. Diese erfüllt sämtliche Aufgaben des

Schema-Managements und ist systemunabhängig einsetzbar.

II

Abstract

In application development release cycles are getting shorter and shorter which

also leads to some consequences for databases. Especially in web applications

NoSQL databases are gaining more popularity. Due to their schema flexibility, an

efficient reaction to fast changes of applications and database schemas is

possible.

Usually, in NoSQL-systems it is not necessary to define a schema upfront. The

schema is implicitly described by the data itself and does not need to be defined

and managed explicitly. Thereby, schema changes can be performed very flexible

at any time.

However, this means the application has to take responsibility for the schema

management. In order to limit the complexity of application development a certain

level of support by the database system would be desirable.

This thesis gives an overview of the support of schema management supplied by

the most established NoSQL Databases and most promising developments. For

this purpose the six most popular NoSQL systems and six other Tools are

analysed using a requirements catalogue that was defined beforehand.

The gathered informations is used afterwards to design a schema management

component. This component is able to fulfill all schema management tasks and

can be used independently from a certain database system.

III

Inhaltsverzeichnis

Abbildungsverzeichnis......................................VI

Tabellenverzeichnis.......................................VIII

1 Einleitung.................................................1

1.1 Motivation............................................... 1

1.2 Zielsetzung..............................................2

1.3 Struktur der Arbeit.........................................2

2 Grundlagen............................................... 4

2.1 Definition des Begriffs Schema................................4

2.2 Definition Schema-Management...............................4

2.3 Eager vs. Lazy Migration....................................5

2.4 Arten von NoSQL-Datenbanken...............................6

2.4.1 Column Family Datenbanken..............................6

2.4.2 Document Datenbanken................................. 7

2.4.3 Key/Value Datenbanken.................................8

2.4.4 Graphdatenbanken.....................................9

3 Status Quo Analyse........................................10

3.1 Anforderungen an ein Schema-Management.....................10

3.2 Datenmodell und Schema-Management in ausgewählten NoSQLDatenbanksystemen..........................................12

3.2.1 HBase.............................................12

3.2.2 Cassandra..........................................20

3.2.3 BigTable............................................ 28

3.2.4 Google App Engine Datastore............................ 28

3.2.5 MongoDB........................................... 35

3.2.6 CouchDB...........................................44

3.2.7 Couchbase.......................................... 53

3.2.8 Gesamtüberblick NoSQL-Datenbanksysteme.................60

IV

3.3 Aktuelle Entwicklungen im Bereich des Schema-Managements.......64

3.3.1 KijiSchema.......................................... 64

3.3.2 Mongoose.......................................... 75

3.3.3 Hibernate Object/Grid Mapper............................81

3.3.4 Kundera............................................89

3.3.5 Objectify-Appengine................................... 96

3.3.6 JSON Schema...................................... 103

3.3.7 Gesamtüberblick aktueller Entwicklungen...................111

3.4 Ergebnisse der Analysen..................................114

4 Modulare Schema-Management-Komponente...................117

4.1 Anforderungen an die zu entwerfende Schema-Management-Komponente

........................................................117

4.2 Entwurf der Schema-Management-Komponente.................119

4.2.1 Architektur......................................... 119

4.2.2 Technische Konzeption................................ 124

4.2.3 Umsetzung......................................... 127

5 Fazit und Ausblick........................................ 142

5.1 Fazit.................................................142

5.2 Ausblick.............................................. 143

6 Literatur................................................144

V

Abbildungsverzeichnis

Abbildung 1: Beispiel einer Column Family Datenbank....................6

Abbildung 2: Beispiel eines JSON-Dokuments..........................7

Abbildung 3: Ausschnitt Timeline-Table, [Cas-12].......................22

Abbildung 4: Physisches Layout der Timeline-Table in Cassandra, [Cas-12]. . .23

Abbildung 5: Beispiel eines Avro-Schemas für eine User-Entity.............66

Abbildung 6: Beispiel für die Definition einer Existenzbedingung in Mongoose. .77

Abbildung 7: Realisierung eines Composite-Keys in OGM [OGM-13c]........84

Abbildung 8: Beispiel der Speicherung von Beziehungen in OGM mit der

Konfiguration IN_ENTITY [OGM-13c]...............................85

Abbildung 9: Kundera Architektur, [Kun-14c].......................... 89

Abbildung 10: Kundera Annotation-to-NoSQL-Mapping, [Kun-14d]..........90

Abbildung 11: Beispiel für List Validation in JSON Schema [JSc-13g]........105

Abbildung 12: Beispiel für Tupel Validation in JSON Schema [JSc-13g]......105

Abbildung 13: Beispiel-Definition eines Objektes in JSON Schema.........106

Abbildung 14: Eingliederung der Schema-Management-Komponente als externe

Schicht.................................................... 120

Abbildung 15: Schichten-Architektur der Schema-Management-Komponente..122

Abbildung 16: Architektur der Schema-Management-Komponente.........123

Abbildung 17: UML-Klassendiagramm der Doctor Who-Datenbank mit den beiden

Entity-Typen InkarnationDesDoktors und Schauspieler..................128

Abbildung 18: Beispielhafte JSON Schema-Definition der beiden Entity-Typen

InkarnationDesDoktors und Schauspieler...........................129

Abbildung 19: Erweiterung des Meta-Schemas.......................131

Abbildung 20: Beispielhafte JSON Schema-Definition der beiden Entity-Typen

InkarnationDesDoktors und Schauspieler nach Einführung des Meta-Schemas 132

Abbildung 21: Beispiel Insert-Statement, angelehnt an SQL bzw. CQL. . . . . .135

Abbildung 22: Beispiel-Entity vom Typ InkarnationDesDoktors............135

Abbildung 23: Erweitertes UML-Klassendiagramm der Doctor Who-Datenbank mit

den Entity-Typen InkarnationDesDoktors, Schauspieler und Begleiter.......137

VI

Abbildung 24: JSON Schema-Definition des Entity-Typs InkarnationDesDoktors

nach der Durchführung von Schema-Updates........................139

Abbildung 25: Beispiel-Entity vom Typ InkarnationDesDoktors nach der

Durchführung von Schema-Updates...............................140

VII

Tabellenverzeichnis

Tabelle 1: Überblick der von HBase erfüllten Anforderungen an ein SchemaManagement.................................................19

Tabelle 2: Überblick der von Cassandra erfüllten Anforderungen an ein SchemaManagement.................................................27

Tabelle 3: Überblick der von GAE Datastore erfüllten Anforderungen an ein

Schema-Management.......................................... 34

Tabelle 4: Überblick der von MongoDB erfüllten Anforderungen an ein SchemaManagement.................................................43

Tabelle 5: Überblick der von CouchDB zur Verfügung gestellten GET-Calls zur

Abfrage der Schemainformationen, [CDB-14d, CDB-14e, CDB-14f, CDB-14g,

CDB-14h]................................................... 48

Tabelle 6: Überblick der von CouchDB erfüllten Anforderungen an ein SchemaManagement.................................................52

Tabelle 7: Überblick der von Couchbase erfüllten Anforderungen an ein SchemaManagement.................................................59

Tabelle 8: Gesamtüberblick der von den analysierten NoSQL-Systemen erfüllten

Anforderungen an ein Schema-Management..........................63

Tabelle 9: Überblick der von KijiSchema zur Verfügung gestellten DDL-Befehle zur

Schema-Evolution, [Kij-14e, Kij-14f]................................72

Tabelle 10: Überblick der von KijiSchema erfüllten Anforderungen an ein SchemaManagement.................................................74

Tabelle 11: Überblick der von Mongoose erfüllten Anforderungen an ein SchemaManagement.................................................80

Tabelle 12: Überblick der von Hibernate OGM erfüllten Anforderungen an ein

Schema-Management.......................................... 88

Tabelle 13: Von Kundera unterstützte JPQL-Konstrukte nach NoSQL-Systemen,

[Kun-14f]....................................................93

Tabelle 14: Überblick der von Kundera erfüllten Anforderungen an ein SchemaManagement.................................................95

VIII

Tabelle 15: Überblick der von Objectify-Appengine erfüllten Anforderungen an ein

Schema-Management.........................................102

Tabelle 16: Überblick der von JSON Schema erfüllten Anforderungen an ein

Schema-Management.........................................110

Tabelle 17: Gesamtüberblick der von den analysierten aktuellen Entwicklungen

erfüllten Anforderungen an ein Schema-Management...................113

Tabelle 18: Gesamtüberblick der Analyseergebnisse....................116

IX

1

Einleitung

1.1

Motivation

Gerade im heutigen Web 2.0-Umfeld findet man in der Anwendungsentwicklung

immer kürzere Release-Zyklen. Dies wirkt sich auch auf Datenbanken und die

Struktur der Daten aus. Es ist nicht mehr möglich im Vorfeld ein festes Schema zu

definieren, das nur wenigen Änderungen unterliegt und über viele Releases stabil

bleibt.

Um

diesen

Eigenschaften

gerecht

zu

werden,

eignen

sich

NoSQL-

Datenbanksysteme, denn die Schemaflexibilität bzw. Schemalosigkeit wird als

eines ihrer Kern-Features betrachtet [Tiw-11]. Im Gegensatz zu relationalen

Datenbanksystemen muss in den meisten NoSQL-Systemen a priori kein Schema

definiert werden. Dies bedeutet jedoch nicht automatisch das komplette Fehlen

eines Schemas. Die Daten selbst weisen implizit ein Schema auf, selbst wenn

dieses nicht explizit modelliert wird.

Weiterhin verhalten sich NoSQL-Datenbanken hinsichtlich Schema-Änderungen

sehr flexibel. Es ist beispielsweise jederzeit problemlos möglich Objekten neue

Eigenschaften zuzuweisen. Da außerdem die Heterogenität von Objekten

unterstützt wird, können sich die Schema-Änderungen bei Bedarf auf ein einziges

Objekt beschränken und müssen nicht wie in relationalen Datenbanken für die

gesamte Tabelle vorgenommen werden. Dadurch können zwei Objekte der selben

(logischen) Klasse durch vollkommen unterschiedliche Attribute beschrieben

werden.

Die Verwaltung des Schemas obliegt in NoSQL-Datenbanksystemen im Normalfall

der Anwendung. Diese Übertragung der Verantwortung für das SchemaManagement

bringt

Datenbanksystemen

zusammen

eine

mit

neue

der

Ebene

Schemaflexibilität

der

von

Komplexität

NoSQLin

die

Anwendungsentwicklung. Da Anwendungen mit jeglichen Varianten von Objekten

1

umgehen können sollen, ist viel Eigenentwicklung (Custom Programming)

erforderlich. Dies ist sowohl kosten- und zeitintensiv als auch fehleranfällig. Daher

wäre eine (teilweise) Automatisierung des Schema-Managements und somit eine

tiefergehende

Unterstützung

seitens

der

NoSQL-Datenbanksysteme

wünschenswert.

1.2

Zielsetzung

Die Erarbeitung eines Überblicks der derzeitigen Unterstützung des SchemaManagements in NoSQL-Datenbanksystemen ist eines der Hauptziele dieser

Arbeit. Zu diesem Zweck sind zunächst die Anforderungen zu identifizieren, die an

ein Schema-Management gestellt werden. Anschließend werden die sechs

wichtigsten NoSQL-Systeme anhand dieser Kriterien analysiert.

Zusätzlich sind die vielversprechendsten, aktuellen Entwicklungen in diesem

Bereich zu ermitteln. Diese werden, basierend auf den gleichen Kriterien,

ebenfalls untersucht.

Als zweites Hauptziel ist im Anschluss eine modular aufgebaute SchemaManagement-Komponente zu entwerfen. Diese soll sämtliche Aufgaben des

Schema-Managements erfüllen können. Da von der Komponente möglichst viele

verschiedene Systeme unterstützt werden sollen, ist die Unabhängigkeit vom

Datenbanksystem bei dem Architekturentwurf zwingend zu berücksichtigen.

1.3

Struktur der Arbeit

Im Anschluss an das einleitende erste Kapitel werden im zweiten Kapitel die

relevanten Grundlagen beschrieben. Es werden verschiedene Begriffsdefinitionen

erläutert sowie die Kategorisierung von NoSQL-Datenbanksystemen vorgestellt.

Das

darauffolgende

Anforderungskataloges

dritte

die

Kapitel

Analysen

enthält

neben

ausgewählter

der

Definition

NoSQL-Systeme

eines

und

zusätzlicher Entwicklungen im Bereich des Schema-Managements.

2

An diesen Teil schließt sich der Entwurf einer Schema-Management-Komponente

im vierten Kapitel an. Zunächst wird der Anforderungskatalog um einige

zusätzliche Kriterien erweitert. Danach werden die Architektur, Technische

Konzeption und Umsetzung der Komponente beschrieben.

Im abschließenden fünften Kapitel erfolgt ein rückblickendes Fazit auf die

erarbeiteten Ergebnisse sowie ein Ausblick auf mögliche zukünftige Arbeiten zu

diesem Thema.

3

2

Grundlagen

2.1

Definition des Begriffs Schema

Unter dem Begriff Datenbank-Schema ist eine strukturelle Beschreibung der

Datenbank zu verstehen. Dies umfasst zum einen die Definition verschiedener

Entity-Typen und ihrer jeweiligen Eigenschaften, also ihren Attributen (Properties).

[EN-05]

Zum anderen werden im Schema auch Bedingungen bezüglich der Properties

festgelegt. Auf diese Weise kann z.B. der Wertebereich eingeschränkt werden.

Das kann durch die Angabe eines bestimmten Datentyps oder andere

weitergehende Einschränkungen erfolgen. Aber auch die Einzigartigkeit (unique)

oder Existenz (not null) eines Attributes kann definiert werden. [EN-05]

Des Weiteren werden in einem Schema Beziehungen zwischen gleichen und

unterschiedlichen Entity-Typen bzw. zwischen deren Properties festgelegt. [EN-05]

Außerdem erfolgt beim Hinzufügen bzw. Ändern von Daten eine Validierung gegen

das definierte Schema, um sicher zu stellen, dass sich die Datenbank in einem

gültigen Zustand befindet. [EN-05]

2.2

Definition Schema-Management

Das Schema-Management umfasst neben der eigentlichen Modellierung sowohl

die Schema-Extraktion basierend auf einer vorhandenen, mit Objekten gefüllten

Datenbank, als auch die Schema-Evolution, also das Management der späteren

Weiterentwicklungen des Schemas. Außerdem muss die erforderliche Migration

vorhandener Daten unterstützt werden. Im besten Fall werden sowohl Eager als

auch Lazy Migration angeboten.

4

2.3

Eager vs. Lazy Migration

Unter eager Migration ist die Anpassung aller Datensätze an das neue Schema

nach einer Schema-Änderung zu verstehen. Dies ist relativ aufwendig und kann

unter Umständern sogar eine Downtime des Systems erfordern. Allerdings kann

auf diese Weise sichergestellt werden, dass nach Abschluss der Migrationsroutine

alle Datensätze dem neuen Schema entsprechen.

Lazy Migration führt die Migration eines Datensatzes erst dann durch, wenn das

erste mal nach einer Schema-Änderung auf ihn zugegriffen wird. Dies hat den

Vorteil, dass keine Downtime des Systems notwendig ist. Außerdem werden durch

lazy Migration überflüssige Migrationen vermieden. Werden in einer Datenbank

beispielsweise Blog-Einträge verwaltet, so wird auf ältere Einträge nicht mehr oder

nur noch selten zugegriffen. Diese Einträge müssen daher nicht an das neue

Schema angepasst werden und verbleiben in der ursprünglichen Schema-Version.

Allerdings müssen Anwendungen sowohl die alte als auch neue Version des

Schemas unterstützen. Soll ein veraltetes Schema irgendwann als ungültig erklärt

werden, muss für die bis zu diesem Zeitpunkt noch nicht migrierten Daten eine

eager Migration durchgeführt werden, um sicher zu stellen, dass alle Daten dem

neuen Schema entsprechen und weiterhin von der Anwendung verarbeitet werden

können.

Theoretisch ist auch eine dritte Variante denkbar. Es ist auch möglich, dass sowohl

alte und neue Schema-Version nach einem Schema-Update erhalten bleiben. In

diesem Fall ist keinerlei Migration erforderlich. Lediglich Anwendungen müssen so

angepasst werden, dass sie (dauerhaft) mit beiden Versionen umgehen können.

5

2.4

Arten von NoSQL-Datenbanken

2.4.1

Column Family Datenbanken

Eine Column Family Datenbank kann als Menge von verschachtelten Maps

betrachtet werden, die üblicherweise als Row bezeichnet und über einen Row-Key

eindeutig identifiziert wird. Die Keys der Key/Value-Paare werden als Columns

bezeichnet. [EFH-11]

Beliebig viele Columns werden in sogenannten Column Families gruppiert.

Column Families werden physisch zusammenhängend gespeichert und müssen

normalerweise im Vorfeld definiert werden. Die Columns einer Family sollten

logisch miteinander in Verbindung stehen. Dies ist jedoch keine Voraussetzung,

sondern dient der besseren Performanz der Abfragebearbeitung, da davon

auszugehen ist, dass diese Daten häufig gemeinsam abgefragt werden. [EFH-11]

Für jede Row werden nur die Columns gespeichert, in denen tatsächlich Werte

vorhanden sind. Null-Werte wie in einem relationalen Datenbanksystem werden

nicht gespeichert. [Tiw-11]

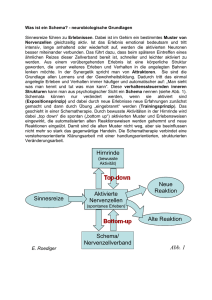

Abbildung 1: Beispiel einer Column Family Datenbank

6

Üblicherweise gibt es in Column-Family-Systemen kein Update im klassischen

Sinn, sondern es werden multiple Versionen jeder Row gespeichert. Die Rows

selbst werden in der Datenbank nach dem Row-Key sortiert abgelegt. [Tiw-11]

Die bekanntesten Column-Family-Datenbanken sind Google BigTable, HBase und

Cassandra. Wobei die beiden letzteren Systeme nach dem Vorbild von BigTable

entwickelt wurden. [RW-12]

2.4.2

Document Datenbanken

Document Datenbanken sind nicht zu verwechseln mit klassischen DokumentManagement-Systemen. Unter Dokumenten sind strukturierte Sammlungen von

Key/Value-Paaren z.B. in Form von JSON- oder BSON-Dokumenten zu verstehen.

Die Values können üblicherweise einen vom Dokumentformat unterstützten

Datentyp annehmen oder ebenfalls wieder ein Dokument bzw. eine Menge von

Dokumenten

sein.

Also

werden

auch

beliebig

tief

verschachtelte

Dokumentstrukturen unterstützt. [RW-12]

Document Datenbanken speichern die (JSON-/ BSON-) Dokumente zusammen

mit einer identifizierenden ID und ermöglichen Indexe basierend sowohl auf der

Dokument-ID als auch auf anderen Keys. [Tiw-11]

{

"id": 1,

"Vorname": "Christina",

"Nachname": "Schmidt",

"Adresse": {

"Strasse": "Bahnhofstraße",

"Hausnummer": "7a",

"PLZ": 64283,

"Ort": "Darmstadt"

}

}

Abbildung 2: Beispiel eines JSON-Dokuments

Systemabhängig können Dokumente ggf. in Collections gruppiert werden. Ähnlich

7

wie bei Column Families sollten diese gruppierten Dokumente zwecks

Performanceverbesserung der Abfrage als auch zur Unterstützung effektiver

Indexierung möglichst ähnlich sein. Dies ist allerdings keine bindende Vorgabe. Es

können theoretisch beliebig verschiedene Dokumente in einer Collection gruppiert

werden. [EFH-11]

Bekannte Vertreter dieser NoSQL-Datenbank-Kategorie sind MongoDB, CouchDB

und Couchbase. [EFH-11]

2.4.3

Key/Value Datenbanken

Key/Value Datenbanken nutzen ein sehr einfaches Datenmodell. In ihnen werden,

wie der Name bereits vermuten lässt, einfache Key/Value-Paare gespeichert.

Dieses einfache Datenmodell ermöglicht sehr schnelle Zugriffszeiten. Komplexe

Abfragen können im Normalfall nicht vom System unterstützt werden, da dieses

keinerlei Informationen über Typ oder Struktur des Values hat. [RW-12]

Es gibt jedoch eine Vielzahl von Key/Value-Datenbanken - Redis, Riak oder

Berkeley DB seien als kleine Auswahl genannt - die verschiedene, zusätzliche

Features bieten. Je nach System können auch Hashes, Listen oder sogar JSONDokumente als Value gespeichert werden. Des Weiteren werden systemabhängig

auch diverse Datenzugriffsmethoden bereitgestellt. [EFH-11]

Durch die fehlenden Informationen über Value-Typ und -Struktur ist nicht davon

auszugehen, dass Key/Value-Datenbanken eine Unterstützung des SchemaManagements zur Verfügung stellen können. Daher werden im Rahmen dieser

Arbeit keine Systeme dieser Kategorie betrachtet.

8

2.4.4

Graphdatenbanken

Der Vollständigkeit halber seien an dieser Stelle ebenfalls Graphdatenbanken

erwähnt.

Im

weiteren

Verlauf

der Arbeit

werden

diese

aufgrund

ihrer

Andersartigkeit zu Datenbanksystemen der vorherigen drei Kategorien jedoch

nicht weiter betrachtet.

In Graphdatenbanken werden Graph- oder Baumstrukturen mit Beziehungen

zwischen deren Knoten verwaltet. Sowohl Knoten als auch Kanten können mit

Key/Value-Paaren zur Beschreibung weiterer Eigenschaften ergänzt werden. [RW12] Der herausstechende „Vorteil der Graphdatenbanken ist daher natürlich, die

Relationen viel schneller traversieren zu können, als dies z.B. auf einer

relationalen Datenbankstruktur möglich wäre“ [EFH-11, S. 9].

Das bekannteste Datenbanksystem dieser Kategorie ist Neo4j. [EFH-11]

9

3

Status Quo Analyse

Nachfolgend wird eine Menge an Anforderungen an ein Schema-Management

definiert. Diese bauen auf typischen Eigenschaften eines Schema-Managements

in relationalen Datenbanksystemen sowie [SKS-13] auf. Die Analysen der

betrachteten NoSQL-Datenbanken und zusätzlicher Aufsätze im weiteren Verlauf

dieses Kapitels erfolgen anhand dieser Kriterien.

3.1

Anforderungen an ein Schema-Management

● Es wird eine geeignete Möglichkeit zur Schemabeschreibung und

-speicherung benötigt. Basierend auf der Definition des Begriffs Schema

aus 2.1 müssen die nachfolgenden Eigenschaften beschrieben werden

können:

•

verschiedene Entity-Typen

•

Struktur der Entity-Typen (Properties)

•

Einschränkungen der Properties

–

Dies umfasst die Unterstützung der benötigten Datentypen (die

konkreten Datentypen sind datenbankabhängig)

–

Die

weitergehende

Einschränkung

des

Wertebereiches

auf

bestimmte Wertgrenzen (z.B. Value between 0 and 10) sollte

ebenfalls beschrieben werden können

–

Außerdem gehört dazu auch die Möglichkeit Eigenschaften wie

Einzigartigkeit (unique) oder Existenz (required, not null) festlegen zu

können.

•

Kennzeichnung einer Property als Primary Key

•

Beziehungen zwischen gleichen und unterschiedlichen Entity-Typen

bzw. deren Properties

● Schema-Extraktion

•

Ableiten des Schemas auf Basis des existierenden Datenbestandes

10

● Schema-Evolution

folgende Operationen zur Schemamanipulation müssen bereitgestellt

werden: [vgl. SKS-13]

•

Hinzufügen eines neuen Entity-Typs zum Schema

•

Löschen eines Entity-Typs aus dem Schema

•

Umbenennen eines Entity-Typs

•

Update eines Entity-Typs

- Hinzufügen eines Attributes (add property)

- Löschen eines Attributes (delete property)

- Umbenennen eines Attributes (rename property)

- Verschieben eines Attributes von einem Entity-Typ zu einem anderen

(move property)

Kopieren eines Attributes von einem Entity-Typ zu einem anderen

(copy property)

● Es sollte eine Validierung gegen das Schema erfolgen

● Die Koexistenz mehrerer, ggf. parallel gültiger Schema-Versionen sollte

unterstützt werden

● Eine Unterstützung der Datenmigration wäre wünschenswert

•

Eager Migration

•

Lazy Migration

11

3.2

Datenmodell

und

Schema-Management

in

ausgewählten NoSQL-Datenbanksystemen

3.2.1

HBase

HBase gehört zur Kategorie der Column-Family-NoSQL-Datenbanken. Als OpenSource-Klon von Googles BigTable ist es laut [EFH-11] und [HBa-13a] ein

spaltenorientiertes Datenbanksystem zur verteilten, versionierten Speicherung

großer Mengen semistrukturierter Daten.

HBase speichert Daten in Tabellen. Diese bestehen aus Zeilen (eine Zeile = ein

Datensatz) und Spalten (Properties). Jede Zeile hat einen eindeutigen Row-Key,

über den sie identifiziert wird und über den jegliche Datenzugriffe erfolgen. Die

Daten werden in HBase nach dem Row-Key, der nicht geändert werden kann,

sortiert. Daher ist das Row-Key-Design ein wichtiger Punkt der Schema-Definition.

[HBa-13b]

HBase gruppiert Spalten in Column Families. Jede Spalte muss einer Column

Family zugeordnet werden. Die Daten einer Column Family werden physisch

zusammenhängend

gespeichert.

Es

ist

außerdem

möglich

bestimmte

Eigenschaften der Column Families zu spezifizieren, z.B. die Anzahl der zu

speichernden Versionen. Diese Metadaten werden allerdings nur für Tabellen und

Column Families verwaltet. Bezüglich Columns kennt HBase keine Metadaten.

[HBa-13b, HBa-13c] Laut [HBa-13c] sollten nicht mehr als zwei bis drei Column

Families genutzt werden, da andernfalls die Performance deutlich abnehmen

kann.

Sowohl Tabellen als auch Column Families sollten im Vorfeld bei der SchemaDefinition angelegt werden. Es existiert aber auch die Möglichkeit im späteren

Verlauf Column Families bzw. deren Metadaten zu ändern oder neue Column

Families hinzuzufügen. Dies ist üblicherweise jedoch sehr kostenintensiv. Im Fall

der Änderung von Metadaten muss HBase beispielsweise eine neue Column

12

Family mit den neuen Parametern erzeugen und anschließend alle Daten

kopieren. [RW-12]

Die Möglichkeit Online-Schema-Updates durchzuführen gibt es seit der Version

0.92.x [HBa-13c]. Ob dies unterstützt wird, kann in der HBase-Konfiguration

festgelegt werden. Standardmäßig ist die Online-Durchführung von SchemaUpdates möglich. [HBa-13d]

Im Gegensatz zu Column Families ist das Hinzufügen neuer Columns generell

problemlos, jederzeit zur Laufzeit möglich, sofern die zugehörige Column Family

bereits definiert wurde. Dies geschieht durch einfaches Einfügen eines

Datensatzes mit neuer Column. [EFH-11]

In HBase sind Datensätze unveränderbar. Da jede Zeile durch Hinzufügen eines

Timestamps (explizit angegeben oder von HBase automatisch generiert)

versioniert wird, führen Update-Operationen nicht zum Überschreiben des „alten“

Datensatzes, sondern es wird eine neuere Version der Zeile erzeugt. [Tiw-11]

HBase unterstützt, bezogen auf ihre Columns, heterogene Datensätze. Daher ist

der einzige Weg, alle Columns, die zu einer Tabelle oder Column Family gehören,

zu finden, ein Full-Table-Scan. [HBa-13b]

Mittlerweile werden von HBase auch Constraints unterstützt. So kann z.B. der

zulässige Wertebereich eines Column-Values eingegrenzt werden. Eine weitere

Einsatzmöglichkeit wäre es mittels Constraints die referentielle Integrität der Daten

sicherzustellen. Dies sollte allerdings in der Praxis nicht genutzt werden, da es mit

großer Wahrscheinlichkeit den Schreibdurchsatz stark reduzieren würde. [HBa13c]

Verschiedene Datentypen, wie aus relationalen Datenbanksystemen bekannt,

werden von HBase nicht unterstützt. Alle Daten, auch die Row-Keys, werden als

uninterpretierte Byte-Arrays gespeichert. Die Validierung zu speichernder Werte

13

muss, genauso wie die Umwandlung gelesener Daten in den jeweiligen Datentyp,

auf Anwendungsebene realisiert werden. [RW-12]

HBase ist also relativ flexibel hinsichtlich der Schemaorganisation, jedoch kein

komplett schema-freies System. Allerdings hat sich HBase mittlerweile zu einem

flexibleren System entwickelt. Mit der Unterstützung von Online-Schema-Updates

müssen nur noch Tabellen zwingend im Voraus definiert werden. Column Families

können bei Bedarf auch zur Laufzeit, ohne Downtime, eingefügt oder geändert

werden.

Ein eigenes, explizites, integriertes Schema-Management wird nicht von HBase

zur Verfügung gestellt.

Wie bereits weiter oben erläutert speichert HBase Metadaten zu Tabellen und

Column Families. [HBa-13b] Ob dies zur Verwaltung von Entity-Typen ausreichend

ist, hängt von der konkreten Modellierung ab. So können unterschiedliche EntityTypen, wie auch in relationalen Modellen, z.B. als verschiedene Tabellen

gespeichert werden. Aber auch die Nutzung von Column Families zur

Repräsentation von Entity-Typen oder anderer Varianten ist denkbar.

Eine tiefergehende Modellierung der Entity-Typen ist allerdings nicht realisierbar,

da HBase keine Metadaten zu Columns verwaltet [HBa-13b]. Somit ist es nicht

möglich die konkrete Struktur von Entities im Schema zu modellieren. Dies

umfasst logischerweise neben der grundsätzlichen Modellierung von Properties

der Entity-Typen auch sämtliche zusätzlichen Informationen über diese Properties

(Einschränkungen, Kennzeichnung als Primary Key und Kennzeichnung von

Beziehungen). Allerdings ist zu erwähnen, dass eine Speicherung der Datentypen

der Properties ohnehin theoretisch unnötig ist, da in HBase alle Daten als ByteArray abgelegt werden.

Konstrukte um Beziehungen zwischen Entity-Typen im klassischen Sinn, wie aus

relationalen Dtenbanksystemen bekannt, zu modellieren, werden von HBase nicht

zur Verfügung gestellt. In HBase existiert keine Unterstützung von Joins oder

14

Foreign Keys. Üblicherweise werden Beziehungen mittels Denormalisierung oder

in der Anwendung verwalteten Referenzen modelliert. [HBa-13b] Da die

Repräsentation von Beziehungen zwischen Entity-Typen bzw. ihren Properties von

der individuellen Umsetzung abhängig ist, bietet HBase keine Möglichkeit diese im

Schema zu definieren.

Ein Datenbankschema beschränkt sich bei HBase also auf Tabellen und ihre

zugehörigen Column Families inklusive deren konfigurierbarer Parameter. Um

eine auch nur annähernd vollständige Schema-Beschreibung zu erstellen, sind

diese Möglichkeiten natürlich bei weitem nicht ausreichend.

Eine weitere Anforderung, die ein Schema-Management erfüllen sollte, ist die

Schema-Extraktion, um aus einer existierenden, gefüllten Datenbank ein Schema

abzuleiten. Auch in diesem Fall bietet HBase nur wenig Unterstützung.

Es existiert die Möglichkeit die von HBase gespeicherten Metadaten auszulesen.

Daher können Informationen sowohl zu Tabellen als auch zu den jeweils

zugehörigen Column Families ausgelesen werden. Dies kann z.B. über den

HTableDescriptor und den HColumnDescriptor der Java-API erfolgen.

[vgl. HBa-13e, HBa-13h]

Da zu den Columns keinerlei Metadaten gespeichert werden, muss, wie schon im

Vorfeld erwähnt, ein Full-Table-Scan durchgeführt werden, um alle Columns, die

zu einer Tabelle gehören, zu ermitteln. [HBa-13b]

Die von HBase bereitgestellten Möglichkeiten der Schema-Beschreibung können

also aus einer bestehenden, mit Daten gefüllten Datenbank extrahiert werden.

Allerdings sind, wie oben erläutert, diese Schema-Informationen sehr begrenzt

und umfassen lediglich Metadaten zu Column Families und Tabellen.

Als dritte wichtige Anforderung an ein Schema-Management wurde in 3.1 die

Unterstützung der Schema-Evolution genannt. Ob das Hinzufügen und Löschen

15

eines Entity-Typs von HBase unterstützt wird, ist von der Art und Weise wie EntityTypen in der konkreten Modellierung repräsentiert werden abhängig.

In jedem Fall gibt es die Möglichkeit sowohl Tabellen als auch Column Families

neu anzulegen oder zu löschen.

Eine neue Tabelle kann beispielsweise mit der createTable(...)-Methode des

HBaseAdmin der Java-API hinzugefügt werden. Ebenso ist das Löschen einer

Tabelle mittels der deleteTable(...)-Methode möglich. [HBa-13f] Das

Umbenennen einer Tabelle wird von HBase nicht unterstützt und muss in der

Anwendung geschehen. Hierfür bietet HBase die Möglichkeit eines Snapshots der

Datenbank. [HBa-13j]

Das

Hinzufügen

einer

neuen

Column

Family

kann

z.B.

über

die

addColumn(...)-Methode des HBaseAdmin der Java-API erfolgen. Analog

kann

zur

Löschung

einer

Column

Family

beispielsweise

die

deleteColumn(...)-Methode des HBaseAdmin genutzt werden. [HBa-13f] Das

Umbenennen einer Column-Family wird von HBase nicht unterstützt.

Die Möglichkeit Properties der Entities im Schema zu verändern (alle unter 3.1

genannten Varianten inklusive Hinzufügen und Löschen) existiert nicht, da HBase

hierzu keinerlei Informationen im Schema speichert [HBa-13b] und diese somit

auch nicht im Zuge der Schema-Evolution geändert werden können.

Zumindest die wenigen von HBase verwalteten Schema-Informationen werden zur

Validierung eingesetzt. So ist es nicht möglich Daten einzufügen oder zu ändern,

ohne dass die angesprochene Tabelle bereits existiert. Ebenso können keine

Daten gespeichert werden, deren Columns nicht einer bestimmten Column Family

zugeordnet werden. Gleichermaßen wird es nicht unterstützt, Daten in die

Datenbank zu schreiben, ohne dass die Column Family bereits angelegt wurde.

Das Einfügen von Daten erfolgt über die Put-Operation. Mittels Put wird eine neue

Version einer Zelle gespeichert. Eine Zelle wird identifiziert durch die Tabelle zu

16

der sie gehört, sowie durch den Row-Key, die Column Family, die Column und den

Timestamp. Daher sind alle diese Informationen beim Einfügen von Daten

anzugeben. Beim Versuch die Operation mit unvollständigen Parameterangaben

durchzuführen, kommt es zu einer Fehlermeldung. Einzige Ausnahme bildet der

Timestamp. Er kann wahlweise auch von HBase generiert werden und muss nicht

zwingend angegeben werden. [HBa-13b, HBa-13i]

Eine weitergehende Validierung kann nicht erfolgen, da HBase keine SchemaInformationen zur Struktur der Entity-Typen speichert und so natürlich die Daten

nicht entsprechend überprüft werden können. Eine solche Art der Validierung

muss innerhalb der Anwendung realisiert werden.

Mehrere Schema-Versionen, im besten Fall parallel gültige, werden von HBase

nicht unterstützt. Ein HBase-Schema besteht nur aus Metadaten zu Tabellen und

Column Families. Eine Historisierung der Schema-Änderungen existiert nicht.

Weiterhin ist es nicht möglich, dass parallel verschiedenen Tabellen oder Column

Families nur für einen Teil der Daten existieren.

Aufgrund der wenigen von HBase verwalteten Schema-Informationen gibt es im

Grunde nur zwei Schema-Änderungen bei denen eine Datenmigration in Frage

kommt. Wird eine Tabelle neu angelegt, existieren noch keine Daten für die eine

Migration notwendig wäre. Beim Löschen einer Tabelle werden die enthaltenen

Daten ebenfalls gelöscht und müssen nicht migriert werden.

Somit sind im Hinblick auf die Datenmigration nur das Hinzufügen und Löschen

einer Column Family zu betrachten. Wird eine neue Column Family angelegt,

existiert diese automatisch (zumindest theoretisch) für alle Rows, auch wenn der

jeweilige Datensatz (noch) keine Columns in dieser Family speichert. Analog wird

eine Column Family beim Löschen für alle Rows gelöscht, unabhängig davon ob

ein konkreter Datensatz Columns in dieser Family gespeichert hat oder nicht. Zu

beachten ist, dass die in der gelöschten Column Family gruppierten Columns

zusammen mit der Column Family gelöscht werden. [HBa-13b, HBa-13f] Dieses

17

Verhalten ist allerdings nicht ausreichend, um es als (teilweise) Unterstützung der

Datenmigration seitens HBase zu werten.

Eine Unterstützung der Datenmigration bei Änderung der Struktur eines EntityTyps kann von HBase aufgrund der fehlenden Metadaten nicht zur Verfügung

gestellt werden. Eine solche Migration muss von der Anwendung angestoßen und

gesteuert werden.

Als Ergebnis dieser Analyse kann gesagt werden, dass HBase nur wenig

Mechanismen zum Schema-Management bietet. Es fehlt schon alleine eine

Möglichkeit ein Schema bis in die benötigte Tiefe, inklusive Struktur und weiteren

Eigenschaften der Entities, zu beschreiben. Aus diesem Grund können auch die

weiteren unter 3.1 genannten Anforderungen an ein Schema-Management nicht

oder nur unzureichend erfüllt werden. In Tabelle 1 sind die Analyseergebnisse

abschließend zusammengefasst.

18

Feature

Schemabeschreibung & -speicherung

Entity-Typen

Struktur der Entity-Typen

Einschränkung der Properties

Kennzeichnung als Primary Key

Beziehungen

Schema-Extraktion

Schema-Evolution

Add Entity-Type

Delete Entity-Type

Rename Entity-Type

Update Entity-Type

Add Property

Delete Property

Rename Property

Move Property

Copy Property

Validierung

unterstützt

(✓)

(✓)

Column Families (CF)

modellierungsabhängig, Tabellen &

Column Families (CF)

(✓)

(✓)

Nur Metadaten

(✓)

(✓)

X

X

X

X

X

X

X

Einfügen neuer CF / Tabelle möglich

(✓)

X

Unterstützung der Datenmigration

X

Lazy Migration

Metadaten zu Tabellen &

X

X

X

X

Mehrere Schema-Versionen

Eager Migration

Erläuterung

modellierungsabhängig

Löschen von CF / Tabelle möglich

Keine Modellierung von Properties

Nur Metadaten, keine Validierung

gegen Entity-Struktur

Beim Löschen von Tabelle/ CF

werden Daten auch gelöscht

X

X

Tabelle 1: Überblick der von HBase erfüllten Anforderungen an ein Schema-Management

19

3.2.2

Cassandra

Cassandra gehört genauso wie HBase zur Kategorie der Column Family

Datenbanksysteme, verfolgt aber einen hybriden Ansatz. Vorbild für Cassandra

waren Amazon Dynamo (Key/Value-Store) und Googles BigTable. Ziel hierbei ist

es „einerseits eine größtmögliche Flexibilität und Skalierbarkeit und andererseits

auch eine durch SQL-Datenbanken vertraute Schemasicherheit“ [EFH-11, S. 82]

zu bieten. [EFH-11, Tiw-11]

Oberste Struktureinheit ist der Keyspace. Ein Keyspace ist vergleichbar mit der

Datenbank in der Welt der relationalen Datenbanksysteme. Er kapselt alle

anwendungsrelevanten Daten. Unter einem Keyspace lassen sich Column

Families definieren. [EFH-11] Der Begriff Column Family meint in Cassandra

allerdings nicht das Gleiche wie in HBase oder BigTable, sondern ist mit einer

Tabelle in einem relationalen System vergleichbar. In der Cassandra Query

Language (CQL) wird mittlerweile anstelle von Column Family der Begriff Table

genutzt. Teilweise wird aber auch noch der Begriff Column Family synonym zu

Table verwendet. [Cas-14a]

Eine Tabelle (Column Family) enthält eine Menge von Rows, die über einen

eindeutigen Schlüssel identifiziert werden. [Cas-14a] Tabellen können mit diversen

Eigenschaften, z.B. Compaction- und Compression-Eigenschaften, konfiguriert

werden. [CQL-13a]

Cassandra bietet die Möglichkeit zu jeder Tabelle einen Metadatensatz zu

hinterlegen. Dieser definiert sowohl den Datentyp (Cassandra arbeitet mit

spezifischen Datentypen wie ASCII, bigint, blob,...) der einzelnen Columns als

auch eventuelle zusätzliche Indexe. Jedoch wird hierdurch nicht definiert, dass

diese Columns in einer Row enthalten sein müssen, sondern nur dass die

beschriebene Column den angegebenen Datentyp haben muss, falls die Column

in einer Row überhaupt existiert. Beim Einfügen von Daten werden alle Columns

nach dem Namen sortiert. [EFH-11]

20

Da Cassandra genauso wie HBase eine automatische Versionierung mitbringt,

bestehen Columns im einfachsten Fall aus 3-Tupeln aus Name, Wert und

Timestamp [CQL-14a]. Timestamps können explizit angegeben oder von

Cassandra generiert werden [CQL-13b].

Für die Datendefinition und -manipulation bietet Cassandra mit der Cassandra

Query Language (CQL) eine sehr umfangreiche, SQL-ähnliche Sprache. Im

Gegensatz zu HBase müssen in Cassandra nicht nur Keyspace und Table im

Vorfeld

angelegt

werden.

Sollen

Daten

eingefügt

angegebenen Spalten zuerst mittels ALTER

TABLE

werden,

ADD

müssen

die

column_name

column_type dem Schema hinzugefügt werden, falls sie nicht bereits mit

Erzeugung der Tabelle angelegt wurden. Allerdings ist es möglich Tabellen und

Columns jederzeit zur Laufzeit zu erzeugen oder zu ändern, ohne dass Updates

und Queries blockiert werden. [CQL-13a, CQL-14b]

Abfragen lassen sich in Cassandra nur auf Indexen ausführen. Falls es sich um

eine Abfrage mit mehreren Kriterien handelt, muss das erste Kriterium auf eine

indexierte Column bezogen sein. Daher werden von Cassandra Secondary

Indexes unterstützt. [EFH-11] Ein Secondary Index auf einer existierenden Column

lässt sich mit dem Statement CREATE INDEX ON table_name(column_name)

erzeugen. Existieren bereits Daten in der angegebenen Column, werden diese

automatisch asynchron indexiert. Werden neue Daten in der Column gespeichert,

fügt Cassandra beim Einfügen automatisch einen neuen Indexeintrag hinzu. [CQL13a]

Damit Daten bei Bedarf stärker strukturiert werden können, gibt es in Cassandra

sogenannte Composite Columns. Diese können mittels Compound Primary Key

eine tiefere Verschachtelung bieten. Ein Compound Primary Key nutzt mehr als

eine

Column

als

Identifizierungsmerkmal.

Hier

ist

die

Reihenfolge

der

angegebenen Columns entscheidend. Die erste Column wird als Partition Key

bezeichnet und als Primary Key der Row genutzt. Die weiteren Columns werden

Clustering Columns genannt. Sie bestimmen die Sortierreihenfolge mit der

Cassandra die Rows speichert. Intern werden alle Datensätze mit dem selben

21

Partition Key physikalisch als eine einzige Row gespeichert. Mit Hilfe der

Clustering Columns kann so eine beliebige Verschachtelungstiefe erreicht werden.

[Cas-12, CQL-13a]

Das nachfolgende Beispielszenario aus [Cas-12] verdeutlicht die Anwendung von

Composite Columns zur Realisierung weiterer Strukturierungsebenen.

In der Tabelle „Timeline“ sollen Tweets für Follower verwaltet werden. Hierfür

werden User_Id, Tweet_Id, Author und Inhalt des Tweets (= body) gespeichert.

Mittels Primary Key (user_id, tweet_id) wird der Compound Primary

Key definiert. Bei einem neuen Tweet wird für jeden Follower ein entsprechender

Eintrag inklusive einer Kopie des Tweets in der Timeline gespeichert. Abbildung 3

zeigt einen Beispiel-Ausschnitt der Timeline-Tabelle.

Abbildung 3: Ausschnitt Timeline-Table, [Cas-12]

Intern speichert Cassandra in diesem Beispiel, wie in Abbildung 4 dargestellt, zwei

Rows, jeweils eine pro eindeutiger user_id, und erzeugt so eine neue

Strukturierungsebene.

22

Abbildung 4: Physisches Layout der Timeline-Table in Cassandra, [Cas-12]

Im Gegensatz zu HBase ist Cassandra relativ inflexibel hinsichtlich des Schemas.

Ähnlich zu relationalen Systemen müssen sowohl Keyspace und Table als auch

Columns vor dem Einfügen von Daten im Schema definiert werden. Jedoch

verhält sich Cassandra nicht so strikt wie man es von relationalen Systemen

kennt. Das definierte Schema legt nicht fest, dass jede Row die beschriebenen

Columns enthalten muss. Es wird lediglich definiert, welche Columns genutzt

werden können. Somit kann Cassandra dank relativ umfangreicher Metadaten viel

Unterstützung für das Schema-Management bieten und trotzdem eine gewisse

Schema-Flexibilität bewahren, die von NoSQL-Systemen erwartet wird.

Ob die von Cassandra verwalteten Metadaten zur Modellierung von Entity-Typen

und ihrer Struktur ausreicht, ist auch in Cassandra abhängig von der konkreten

Umsetzung. Es ist z.B. möglich die unterschiedlichen Entity-Typen mittels

verschiedener Tabellen zu repräsentieren. Da Metadaten zu den Columns

gespeichert werden, ist es auf diese Art und Weise möglich auch die Struktur der

Entity-Typen im Schema darzustellen. Die Datentypen der Columns werden

ebenfalls von Cassandra im Schema verwaltet. Weitere Einschränkungen der

Properties (Columns), wie etwa die Einschränkung auf einen bestimmten

Wertebereich, werden nicht von Cassandra unterstützt. [CQL-13a, CQL-14c]

Es ist allerdings möglich bzw. sogar erforderlich eine oder mehrere Column/s als

Primary Key zu kennzeichnen. Dies geschieht während der Tabellendefinition.

Besteht ein Primary Key aus nur einer Column, kann diese direkt nach Angabe

ihres Datentyps als Primary Key spezifiziert werden (CREATE Table t (key

int PRIMARY KEY, otherColumn text) ). Handelt es sich um einen

Compound Primary Key, der aus mehreren Columns besteht, muss der Schlüssel

23

im Anschluss an die Column-Definitionen mittels PRIMARY KEY(column_1,

column_2, …) spezifiziert werden. [CQL-13a]

Beziehungen zwischen verschiedenen Entity-Typen und/ oder ihren Properties

werden in Cassandra nicht unterstützt. Es existieren keine Joins oder Foreign

Keys. Logische Beziehungen werden üblicherweise per Denormalisierung oder mit

Hilfe von Collection Columns (Listen u.ä.) realisiert. Daher können Beziehungen

nicht im Schema modelliert werden. [CQL-14b]

Mit den von Cassandra gespeicherten Metadaten lässt sich ein Schema

weitgehend beschreiben. Es ist möglich Entity-Typen inklusive ihrer Struktur,

Datentypen der Properties und Angabe des Primary Keys zu modellieren.

Lediglich weitergehende Einschränkungen der Properties und Beziehungen lassen

sich nicht mit den von Casandra angebotenen Mitteln verwalten.

Die von Cassandra verwalteten Schema-Informationen lassen sich aus einer

gefüllten Datenbank auch wieder extrahieren. Dies kann z.B. über eine Query auf

die von Cassandra verwalteten System Tables realisiert werden (SELECT * FROM

system.schema_columnfamilies). [CQL-14c]

Alternativ können Metadaten auch mit Hilfe der entsprechenden get-Methoden der

Klassen TableMetadata und ColumnMetadata der Java-API (z.B. des

Datastax Java Treibers) extrahiert werden. [Cas-13a, Cas-13b]

Da sich im Laufe der Zeit das Schema weiterentwickelt, ist es wichtig, dass die

Schema-Evolution vom Schema-Management unterstützt wird. Inwieweit die in

3.1 definierten Anforderungen von Cassandra erfüllt werden, ist abhängig von der

konkreten Modellierung der Entity-Typen. Ausgehend von der Annahme, dass

verschiedene Entity-Typen in unterschiedlichen Tabellen gespeichert werden,

können einige der Anforderungen aus 3.1 von Cassandra erfüllt werden.

Es ist möglich mit dem CREATE TABLE-Kommando der CQL neue Tabellen zu

erzeugen, sowie mittels DROP TABLE existierende Tabellen inklusive der darin

24

enthaltenen Daten zu löschen. [CQL-13a] Das Umbenennen einer Tabelle wird in

Cassandra nicht unterstützt. In früheren Versionen wurde dieses Feature

angeboten, allerdings wieder entfernt, da das Umbenennen von Tabellen (und

Keyspaces) sehr fehleranfällig war. Mittlerweile ist es nur noch manuell durch

Erzeugen einer neuen Tabelle, Kopieren sämtlicher Daten und Löschen der alten

Tabelle realisierbar. [Cas-13c]

Da Cassandra Metadaten zu Columns speichert, gibt es auch die Möglichkeit im

Zuge der Schema-Evolution die Struktur der Entity-Typen zu verändern. Um

Columns, die zum Zeitpunkt der Erzeugung einer Tabelle noch nicht angelegt

wurden, zu einer Tabelle hinzuzufügen wird das

ALTER

TABLE

ADD

column_name column_type -Kommando der CQL genutzt. Wird anstelle von

ADD die Instruktion DROP gewählt, können mit dem ALTER TABLE-Kommando

Columns aus dem Schema einer Tabelle gelöscht werden. Das Umbenennen von

Columns muss, genauso wie das Verschieben oder Kopieren einer Column in eine

andere Tabelle, in der Anwendung erfolgen. Cassandra bietet hier keine

Unterstützung. [CQL-13a]

Die von Cassandra verwalteten Schema-Informationen werden auch zur

Validierung genutzt. Bei dem Versuch einen bereits existierenden Keyspace oder

eine existierende Tabelle erneut anzulegen, kommt es zu einer Fehlermeldung,

sofern nicht die Option IF NOT EXISTS genutzt wird. In diesem Fall wird die

Operation nicht ausgeführt, falls der Keyspace/ die Tabelle schon existiert.

Gleiches gilt für das Löschen von Keyspace und Tabelle mit der Option IF

EXISTS. Ebenso ist es nicht möglich Werte mit einem invaliden Datentyp in

Columns einzufügen. [CQL-13a]

Mehrere ggf. sogar parallel gültige Schema-Versionen werden von Cassandra

nicht unterstützt, da bei Schema-Änderungen die Metadaten der Tabelle bzw. des

Keyspaces geändert werden. Es ist z.B. auch nicht möglich, dass eine Column

mehrere verschiedene, gültige Datentypen besitzt. [CQL-13a]

25

Da mit den im Schema von Cassandra verwalteten Column-Metadaten, keine

Existenzbedingung (abgesehen von den Primary Key-Columns) einhergeht und

auch kein entsprechendes Constraint unterstützt wird, gibt es keine SchemaEvolutions-Operationen für die eine Datenmigration erfolgen muss. Beim

Hinzufügen eines neuen Entity-Typs existieren noch keine Daten, die migriert

werden müssten. Beim Löschen eines Entity-Typs werden die Daten zusammen

mit der Tabelle gelöscht. Mit dem Hinzufügen oder Löschen einer Column ist auch

keine Datenmigration notwendig, da Columns, die im späterem Verlauf dem

Schema hinzugefügt werden, nicht Teil des Primary Keys und daher für jede Row

optional sind. Wie beim Löschen eines Entity-Typs werden auch beim Löschen

einer Column die Daten dieser Column gelöscht. Das Mitlöschen der Daten beim

Entfernen von Entity-Typ bzw. Column kann allerdings noch nicht als (teilweises)

zur Verfügung Stellen einer automatischen Datenmigration gewertet werden.

Cassandra bietet also einige Unterstützung des Schema-Managements. So

können zum Beispiel Entity-Typen inklusive Struktur und Primary Key im Schema

modelliert werden. Dennoch können, wie Tabelle 2 zusammenfassend zeigt, nicht

alle Anforderungen an ein Schema-Management aus 3.1 erfüllt werden.

26

Feature

unter-

Erläuterung

stützt

Schemabeschreibung & -speicherung

Entity-Typen

Struktur der Entity-Typen

Einschränkung der Properties

Kennzeichnung als Primary Key

Beziehungen

(✓)

(✓)

✓

X

(✓)

Schema-Evolution

(✓)

Delete Entity-Type

Rename Entity-Type

Update Entity-Type

Add Property

Delete Property

Rename Property

Move Property

Copy Property

Validierung

Mehrere Schema-Versionen

Unterstützung der Datenmigration

Eager Migration

Lazy Migration

zu

Keyspace,Tabellen

und Columns

✓

✓

Schema-Extraktion

Add Entity-Type

Metadaten

✓

✓

X

(✓)

✓

✓

X

X

X

Datentypen unterstützt, aber keine

weiteren Einschränkungen

Single/ Compound Primary Key

Auslesen

aller

verwalteter

Metadaten möglich

Einfügen neuer Tabelle

Löschen einer Tabelle

Einfügen neuer Column

Löschen einer Column

✓

X

X

X

X

Tabelle 2: Überblick der von Cassandra erfüllten Anforderungen an ein SchemaManagement

27

3.2.3

BigTable

Googles BigTable ist Vorreiter im Bereich der NoSQL-Datenbanken und gehört zur

Kategorie der Column-Family-Systeme. HBase und Cassandra nahmen sich

BigTable als Vorbild, daher entspricht die Datenmodellierung in BigTable der oben

unter HBase beschriebenen Umsetzung. Allerdings handelt es sich bei BigTable,

anders als bei HBase oder Cassandra, um ein Closed Source System. [Tiw-11]

Aus diesen beiden Gründen wird BigTable an dieser Stelle nicht weitergehend

betrachtet.

3.2.4

Google App Engine Datastore

Google App Engine (GAE) ist Googles Cloud Plattform zur Entwicklung und dem

Betrieb von Webanwendungen. Es werden verschiedenen Programmiersprachen

wie z.B. Java, Python oder PHP unterstützt. Google stellt u.a. eine Untermenge

der Standard-APIs JDO (Java Data Objects) oder JPA (Java Persistence API) zur

Anwendungsentwicklung zur Verfügung. Entwickler können so wie gewohnt mit

Entities und Beziehungen arbeiten. [GAE-13a]

Momentan existieren drei Varianten der Datenspeicherung im Google App Engine

Umfeld. Zum einen der Google App Engine Datastore, der auf dem NoSQLDatenbanksystem BigTable basiert. Zum anderen Google Cloud SQL, ein

relationaler Datenbankservice basierend auf MySQL, sowie Google Cloud

Storage, ein Objekt- und Dateispeicherdienst. [GAE-13a, EFH-11] Im Folgenden

wird nur der GAE Datastore betrachtet, da die beiden anderen Varianten im

Rahmen dieser Arbeit nicht relevant sind.

Im GAE Datastore werden Entities, die eine oder mehrere Properties haben,

gespeichert. Im Gegensatz zu BigTable arbeitet der GAE Datastore mit

spezifischen Datentypen für die Property-Values. Eine Entity wird durch einen

Entity-Typ und einen Key eindeutig identifiziert. Optional kann eine Entity eine

andere Entity als Parent definieren und so eine hierarchische Struktur festlegen.

Entities ohne Parent-Entity werden als Root-Entity bezeichnet. Entities, die zur

gleichen Root-Entity gehören, werden der gleichen Entity-Gruppe zugeordnet. Für

28

Entities einer Gruppe werden atomare Abfragen unterstützt. Schreiboperationen

werden innerhalb von sogenannten Cross-Group-Transaktionen für bis zu fünf

verschiedene Entity-Gruppen als atomare Operation ausgeführt. Der GAE

Datastore unterstützt also auch Transaktionen. [GAE-14a]

Da der GAE Datastore auf BigTable aufbaut, handelt es sich um ein schemaloses

System. Die Entities eines Typs müssen nicht die gleichen Properties haben.

Weiterhin können Properties mehrere Werte, die unterschiedliche Datentypen

haben können (z.B. eine Liste von Values, deren Datentypen sich unterscheiden),

besitzen. Es ist auch möglich, dass zwei Entities für gleiche Properties

verschiedene Datentypen definieren. Der GAE Datastore macht keinerlei

Schemavorgaben bezüglich der Struktur von Entities. Falls ein formales Schema

erforderlich ist, ist es Aufgabe der Anwendung die Einhaltung des Schemas

sicherzustellen. [GAE-14a, GAE-14b]

Die nachfolgende Analyse basiert weitestgehend auf der Nutzung von GAE

Datastore mit dem Python SDK (Software Development Kit). Wird ein anderes

SDK, z.B. das Java-SDK, genutzt, ist davon auszugehen, dass die Analyse anders

ausfallen kann und z.B. weniger oder andere Anforderungen an ein SchemaManagement erfüllt werden können.

Das Python App Engine SDK beinhaltet eine Data Modeling Library, mit der

Entities als Instanz einer von drei verfügbaren Modell-Klassen repräsentiert

werden können. In der Python Datastore API wird der Entity-Typ durch diese

Model-Klassen definiert. [GAE-14c]

Zum einen gibt es die model-Klasse, mit der das Daten-Schema, ähnlich wie in

relationalen Systemen, im Voraus festgelegt wird. Es handelt sich also um ein

inflexibles Schema. Auch können hier Existenzbedingungen oder Default-Values

für Properties festgelegt werden. Beim Einfügen von Daten erfolgt eine Validierung

gegen das definierte Schema. [GAE-13b, Tiw-11]

29

Eine weitere Klasse ist expando. Mit ihr können Schemata dynamischer und

flexibler modelliert werden. Es existieren zwei Typen von Attributen. Erstens die

fixed Properties, die wie Properties der model-Klasse a priori definiert werden,

dafür aber auch validiert werden können. Zweitens die dynamic Properties, die zur

Laufzeit mit einer Entity in die Datenbank geschrieben werden, aber nicht validiert

werden können. [GAE-13b, Tiw-11]

Die letzte Schema-Modellierungsklasse heißt polymodel. Mit dieser Klasse ist es

möglich

eine

Hierarchie

zwischen

verschiedenen

Modellierungsklassen

festzulegen. Mittels dieser Hierarchie werden bei einer Abfrage Entities der

angesprochenen

Klasse

sowie

ihrer

Subklassen

in

die

Ergebnismenge

aufgenommen. [GAE-13b, Tiw-11]

Mit Hilfe der verschiedenen Schema-Modell-Klassen kann in Google App Engine

also der Grad der Schemafreiheit flexibel - vom festen, a priori zu definierenden

Schema bis zur kompletten Schemalosigkeit - vom Entwickler festgelegt werden.

Zur Definition und Manipulation sowie der Abfrage von Entities existieren

verschiedene Möglichkeiten. Neben Implementierungen von JDO und JPA stellt

Google App Engine für Python eine SQL-ähnliche Abfragesprache, die Google

Query Language (GQL), zur Verfügung. [Tiw-11]

Jede Abfrage innerhalb des Google App Engine Datastore basiert auf Indexen.

Der GAE Datastore legt automatisch für alle Properties der Entity-Typen einen

Index an. Teilweise müssen zusätzliche Indexe definiert werden, um Queries

effizient ausführen zu können. Indexe werden mit dem Einfügen von Entities oder

der Durchführung von Änderungen an ihnen automatisch aktualisiert. [GAE-13c]

Obwohl der GAE Datastore die schemalose NoSQL-Datenbank BigTable nutzt,

bietet er einige Möglichkeiten des Schema-Managements. So kann z.B. mit den

Python-Model-Klassen ein Schema, mit vom User konfigurierbarer Flexibilität,

angelegt werden.

30

Da GAE Datastore Daten als verschiedene Entity-Typen speichert, ist es

logischerweise möglich eine entsprechende Schema-Beschreibung zu erstellen.

Es werden Metadaten zu Entity-Gruppen, Namespaces, Entity-Typen und

Properties gespeichert. [GAE-13d] Daher ist es auch möglich die Struktur der

Entity-Typen zu modellieren.

Wie bereits oben beschrieben, werden zu den Properties auch Datentypen

hinterlegt. Eine weitere Einschränkung des Wertebereichs ist nur durch Angabe

einer

Liste

möglicher

Werte

(choices=set([„value1“,

„value2“]))

realisierbar. Die Einzigartigkeit von Properties kann nicht im Schema modelliert

werden. Allerdings können Existenzbedingungen mittels required=True im

Schema hinterlegt werden. [GAE-13e]

Standardmäßig wird der Primary Key in dem Property key gespeichert, das nicht

explizit definiert wird. Es ist allerdings möglich anderen Properties diese

Eigenschaft zuzuweisen, indem dem Property-Konstruktor das Argument name

mit

der

Option

übergeben

“key“

wird,

beispielsweise

myEntity_key=db.StringProperty(name=“key“). Zugriffe können dann

mit dem jeweiligen Property-Namen erfolgen. Im Datastore wird der Primary Key

dennoch in dem Feld key gespeichert. [GAE-13e, GAE-13f]

Mit der ReferenceProperty-Klasse stellt GAE Datastore eine Möglichkeit,

Beziehungen zwischen Entities zu modellieren, zur Verfügung. Damit kann einer

Property eine Referenz auf einen bestimmten Entity-Typ zugewiesen werden. Als

Value dieser Property wird automatisch der Key des referenzierten Entities

genutzt. Außerdem wird die automatische Dereferenzierung unterstützt. Der Value

der referenzierenden Property kann genutzt werden, als wäre er eine Instanz der

referenzierten Entity. Mit der Klasse SelfReferenceProperty werden auch

Selbstreferenzen unterstützt. [GAE-13b]

Die von GAE Datastore verwalteten Metadaten können mit Hilfe sogenannter

Helper Functions ausgelesen werden. Die Methode get_kinds(...) kann

beispielsweise

genutzt

werden,

um

alle

Entity-Typen

einer Anwendung

31

abzufragen. Analog dazu liefert die Methode get_properties_of_kind(...)

eine Liste aller indexierter Properties des als Parameter übergebenen Entity-Typs.

Falls nicht im Schema explizit anders konfiguriert, werden alle Properties

automatisch indexiert und sind somit in der Ergebnismenge enthalten. [GAE-13d]

Mit den Helper Functions ist es also möglich aus einer gefüllten Datenbank das

Schema zu extrahieren.

Als weitere wichtige Anforderung an ein Schema-Management sollte weiterhin die

Schema-Evolution

unterstützt

werden.

Auch

hier

stellt

GAE

Datastore

verschiedene Möglichkeiten zur Verfügung.

Ein neuer Entity-Typ kann beispielsweise mit der Python-API als neue ModelKlasse im Code hinzugefügt werden. [GAE-13b] Eine Unterstützung zum Löschen

oder Umbenennen eines Entity-Typs gibt es in GAE Datastore nicht. [Sta-11]

Wird die oben beschriebene Expando-Model-Klasse genutzt, ist es möglich zur

Laufzeit Properties durch Einfügen eines Entities, mit den jeweiligen neu

einzufügenden Properties, hinzuzufügen. [GAE-13b]

Weitere Update-Operationen bezüglich der Properties werden nicht von GAE

Datastore unterstützt und müssen in der Anwendung erfolgen. Es gibt zwar die

Möglichkeit Properties zu löschen, aber selbst wenn diese aus der Definition der

Model-Klasse

gelöscht wurden,

können

bereits existierende Entities die

betroffenen Properties weiterhin besitzen. Um die Properties endgültig zu löschen,

müssen sie mittels Full-Table-Scan auf Anwendungsebene in jeder Entity gelöscht

werden. [GAE-12]

Der GAE Datastore nutzt die verfügbaren Metainformationen zur Validierung. So

ist es beispielsweise nicht möglich Entities zu speichern, deren Typ vorher nicht

definiert wurde. Da eine Entity eindeutig durch den Typ und einen Key identifiziert

wird, kommt es zu einer Fehlermeldung, falls der Entity-Typ nicht existiert. [GAE14a]

32

Werden die Model-Klassen model oder expando genutzt, erfolgt eine

automatische Validierung gegen Datentyp und Existenzbedingung der fixed

Properties. [GAE-13b]

Mit Hilfe der verwalteten Metadaten zu fixed und dynamic Properties der

Expando-Modell-Klasse werden von GAE Datastore mehrere, parallel gültige

Schema-Versionen unterstützt. Beispielsweise können zwei Entities des selben

Typs gleiche Properties mit unterschiedlichen Datentypen besitzen. Allerdings

erfolgt keine Validierung gegen die dynamischen Properties.

Eine automatische Datenmigration steht in GAE Datastore nicht zur Verfügung.

Auch bei Änderungen der fixed Properties eines Entity-Typs werden existierende

Entities nicht automatisch angepasst. Werden beispielsweise neue Properties mit

einem Default-Wert hinzugefügt, haben zwar alle neu eingefügten Entities diese

Properties mit entsprechendem Value, bereits existierende Entities werden

allerdings nicht automatisch migriert und müssen in der Anwendung mittels FullTable-Scan angepasst werden. [GAE-12]

GAE Datastore bietet somit relativ umfangreiche Mittel zur Beschreibung von

Entity-Typen

und

ihren

Properties.

Es

wird

sogar

eine

automatische

Dereferenzierung von Beziehungen zur Verfügung gestellt. Dennoch fehlt, wie in

Tabelle 3 ersichtlich, vor allem eine Unterstützung der Schema-Evolution.

33

Feature

unter-

Erläuterung

stützt

Schemabeschreibung & -speicherung

Entity-Typen

Struktur der Entity-Typen

Einschränkung der Properties

✓

✓

✓

(✓)

Kennzeichnung als Primary Key

✓

Beziehungen

✓

Schema-Extraktion

✓

Schema-Evolution

(✓)

(✓)

X

X

X

Add Entity-Type

Delete Entity-Type

Rename Entity-Type

Update Entity-Type

Add Property

Delete Property

Rename Property

Move Property

Copy Property

Validierung

Mehrere Schema-Versionen

Unterstützung der Datenmigration

Eager Migration

Lazy Migration

✓

X

X

X

X

✓

(✓)

Datentypen, Existenzbedingung &

Liste akzeptierter Werte

Metadaten

zu

Entity-Typen

und

Properties verfügbar

mittels neuer Model-Klasse im Code

z.B. Nutzung von Expando-Klasse

gegen Entity-Typ, fixed Properties:

Datentyp, required-constraint

Durch dynamische Properties und

Property-Metadaten

X

X

X

Tabelle 3: Überblick der von GAE Datastore erfüllten Anforderungen an ein SchemaManagement

34

3.2.5

MongoDB

MongoDB ist der Kategorie der Document Datenbanken zuzuordnen. Der Name

MongoDB ist abgeleitet vom englischen „humongous“ (= riesig) und lässt auf die

Ausrichtung auf die Speicherung von sehr großen Datenmengen schließen. [EFH11]

Daten werden in MongoDB in Form von BSON-Dokumenten gespeichert. Es

werden

alle BSON-Datentypen

unterstützt. Allerdings

können in

BSON-

Dokumenten theoretisch mehrere Felder den selben Namen (=Key) haben. Dies

wird jedoch nicht empfohlen und von den meisten MongoDB Interfaces auch nicht

unterstützt. [Mon-13a, vgl. auch RFC-4627 „The names within an object SHOULD

be unique“]

MongoDB garantiert keine feste, gleichbleibende Speicherreihenfolge der

Key/Value-Paare eines Dokumentes. Die Felder innerhalb eines Dokumentes

können durch spätere Update- oder Einfüge-Operationen umsortiert werden. Um

festzustellen, ob zwei Dokumente die gleiche Struktur aufweisen, mit anderen

Worten die gleichen Key/Value-Paare besitzen, müssen also alle Paare der

Dokumente mittels Full-Table-Scan miteinander verglichen werden. [Mon-13a]

BSON-Dokumente können in MongoDB maximal 16 MB groß sein, damit eine

möglichst effiziente Speicherauslastung erreicht werden kann. Außerdem dient

diese Begrenzung der Einschränkung der benötigten Bandbreite bei der

Übertragung von Dokumenten. Zur Speicherung größerer Dokumente stellt

MongoDB eine Spezifikation namens GridFS zur Verfügung. [Mon-13a]

Dokumente sind vergleichbar mit Tupeln in einer relationalen Datenbank und

werden eindeutig über eine ID, die explizit angegeben oder von MongoDB

generiert werden kann, identifiziert. Die Dokumente werden in sogenannten

Collections gruppiert. [EFH-11, Mon-13a]

35

MongoDB ist ein schemaloses System. Nicht einmal eine Datenbank oder

Collection muss im Voraus definiert werden. Sie werden erst zum Zeitpunkt des

ersten Einfügens eines Dokumentes angelegt. [RW-12]

Verschiedene Dokumente können eine beliebig voneinander abweichende

Struktur aufweisen. Auch Collections schränken Dokumente nicht hinsichtlich ihres

Schemas ein. Dokumente innerhalb der selben Collection müssen nicht die

gleichen Felder besitzen. Dennoch ist es aus Performancegründen sinnvoll,

Dokumente mit ähnlicher Struktur in Collections zu gruppieren. [EFH-11]

In MongoDB gibt es die Möglichkeit die Größe einer Collection zu beschränken.

Solche Collections werden als Capped Collections bezeichnet. Erreicht eine

Capped Collection ihre Maximalgröße, so werden alte Dokumente automatisch

beim Einfügen weiterer Dokumente gelöscht. [Tiw-11] Explizit gelöscht werden

können einzelne Dokumente einer Capped Collection nicht. Es besteht nur die

Möglichkeit die gesamte Capped Collection zu leeren oder komplett zu löschen.

Weiterhin können Dokumente nur dann geändert werden, wenn sich dadurch der

von ihnen benötigte Speicherplatz nicht vergrößert. [Mon-13d]

Indexierung wird von MongoDB in dem Umfang, wie es von relationalen Systemen

bekannt ist, unterstützt. Indexe werden auf Collection-Ebene erstellt. Auf der

Dokument-ID wird automatisch beim Einfügen des Dokumentes ein Index erzeugt.

Weitere Indexe können beliebig vom User angelegt werden. MongoDB unterstützt

hierfür eine Vielzahl von Indexstrukturen, von klassischen B-Bäumen bis zu zweioder mehrdimensionalen Geoindexen. [RW-12]

MongoDB

stellt

eine

eigene,

SQL-ähnliche

Abfragesprache

sowie

eine

Implementierung von Map Reduce zur Verfügung. Die Abfragesprache bietet

allerdings umfangreiche Möglichkeiten in Bezug auf Filter und Selektion, sodass in

vielen Fällen kein Einsatz vom aufwendigeren Map Reduce notwendig ist [EFH11].

36

In mehreren der bisher vorgestellten Datenbanken werden Daten automatisch

versioniert. MongoDB bietet kein solches Feature und Updates werden in-place

ausgeführt. [Mon-13b]

Zur Änderung von Dokumenten existieren zwei Methoden. Der Update-Methode

kann ein Filter übergeben werden, der die zu ändernden Dokumente definiert. Mit

dieser Methode können also mehrere Dokumente mit nur einem Befehl geändert

werden. Je nach übergebenen Parametern ändert diese Methode Werte

bestimmter Felder oder ersetzt das komplette Dokument. [Mon-13b]

Die zweite Variante zur Änderung von Dokumenten ist die Save-Methode. Diese

Methode kann immer nur ein einzelnes Dokument ändern und ersetzt es mit

einem neuen Dokument. Eine Änderung einzelner Felder des existierenden

Dokumentes ist mit dieser Methode nicht möglich. [Mon-13b]

Der markanteste Unterschied der MongoDB-Syntax und SQL sind fehlende JoinOperationen. Joins werden in MongoDB nicht unterstützt und sollten im Normalfall

auch nicht erforderlich sein. [Mon-13c]

Üblicherweise wird in MongoDB, wie in den meisten NoSQL-Systemen, ein

denormalisiertes Datenmodell genutzt und Dokumente verschachtelt gespeichert.

Dies macht es auch möglich mit nur einer einzigen Datenbankoperation ein

Dokument inklusive aller Sub-Dokumente abzufragen oder zu ändern. [Mon-13e]

Dennoch ist es manchmal nützlich, wenn sich Dokumente gegenseitig

referenzieren.

In MongoDB gibt es zwei Möglichkeiten Referenzen zu realisieren. Zum einen gibt

es die Möglichkeit der manuellen Referenzen. Hier wird in einem Dokument die ID

des referenzierten Dokumentes gespeichert und die Anwendung muss sich um die

Auflösung der Referenz kümmern. MongoDB bietet in diesem Fall keine

Unterstützung. [Mon-13c]

37

Die zweite Möglichkeit sind sogenannte DBRefs. Sie bieten ein standardisiertes

Format Referenzen zwischen verschiedenen Dokumenten zu beschreiben. Im

Normalfall werden diese Referenzen allerdings nicht automatisch aufgelöst. In wie

weit die Dereferenzierung tatsächlich unterstützt wird und in welchem Maß die

Anwendung verantwortlich ist, ist treiberabhängig. Daher sind DBRefs nur

empfehlenswert, wenn ein Dokument auf mehrere Dokumente aus verschiedenen

Collections referenziert. [Mon-13c]

Als schemaloses NoSQL-System bietet MongoDB also viele Features, die in

relationalen Datenbanksystemen üblich sind. Jedoch mit dem Vorteil, dass im

Voraus kein Schema zu definieren ist und jederzeit flexibel Änderungen am

Schema durch simples Einfügen neuer Daten vorgenommen werden können. Ein

explizites Schema-Management wird jedoch nicht von MongoDB angeboten.

Verschiedene Metadaten werden von MongoDB in sogenannten System

Collections

gespeichert.

In

der

systems.indexes-Collection

werden

Informationen zu allen Indexen verwaltet. Die system.namespaces-Collection

enthält Metadaten zu allen Collections. Weitere Metadaten zum Namespace

werden in der .ns-Datei abgelegt. [Mon-13f]

Ob diese Metadaten zur Beschreibung von Entity-Typen ausreichen, ist wie auch

schon in vorherigen Systemen abhängig von der konkreten Modellierung. Es ist

denkbar, dass die verschiedenen Entity-Typen durch unterschiedliche Collections

repräsentiert

werden.

Aber

auch

andere

Modellierungsvarianten

können

umgesetzt werden. Die Struktur von Entity-Typen nähergehend zu modellieren ist

in MongoDB nicht möglich, da keine Metadaten zu einzelnen Dokumenten bzw.

ihren Feldern verwaltet werden.

Eine Möglichkeit zumindest indirekt einige Feldinformationen in MongoDB zu

verwalten wäre es, Indexe zu nutzen. Die zu Indexen gespeicherten Metadaten

enthalten auch Informationen zu den indexierten Feldern. Diese aus den

Metadaten zu extrahieren müsste jedoch auf Anwendungsebene erfolgen.

38

Auf diese Weise wäre es auch möglich die Einzigartigkeit von Properties mittels

Erzeugung eines Unique Index auf dem entsprechendem Feld zu verwalten.

Durch den Unique Index wird sichergestellt, dass keine Dokumente in die

Datenbank eingefügt werden, deren Wert des indexierten Feldes bereits innerhalb

eines anderen, schon in der Datenbank gespeicherten, Dokumentes vorkommt.

[Mon-13g] Aber auch in diesem Fall müsste die Information von der Anwendung

aus den Index-Metadaten extrahiert werden.

Eine tatsächliche Modellierung von Entity-Strukturen und Einschränkungen der