(0≤k≤n) P(AUB) = P(A)+P(B) für A = P(AUB) = P(A)+P(B)

Werbung

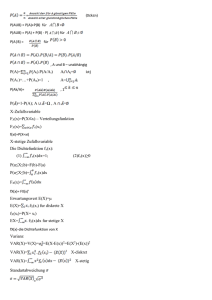

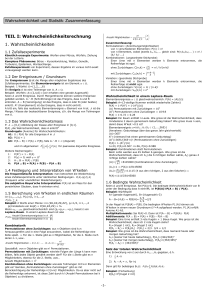

(0≤k≤n) = P(AUB) = P(A)+P(B) für A P(AUB) = P(A)+P(B)-P(A P(A|B) = ) = für A für , A und B – unabhängig P(A)= Ai).P(A/Ai) P(A1)+…+P(An)=1 , P(Ak/A)= Ai Aj= A= i j i ,1 =Ω , A P( )=1-P(A); A = X-Zufallsvariable FX(x)=P(X x) – Verteilungsfunktion FX(x)= x(xi) f(xi)=P(X=xi) X-stetige Zufallsvariable Die Dichtefunktion fx(x): (1) x(x)dx=1; P(a≤X≤b)=F(b)-F(a) P(a≤X≤b)= x(x)dx FX(x)= fX(x)= FX(x)’ Erwartungswert E(X)=µ E(X)= i.fX(xi) fur diskrete X fX(xi)=P(X= xi) EX= . fX(x)dx fur stetige X (2)fx(x)≥0 fX(x)-die Dichtefunktion von X Varianz VAR(X)=V(X)= =E(X-E(x))2=E(X2)-(E(x))2 2 VAR(X)= X-diskret VAR(X)= X-stetig Standartabweichung = Eigenschaften des Erwartungswertes 1)E(C)=C 2)E(C.X)=C.E(X) 3)E(X+Y)=EX+EY 4)E = = ) 5)E(X.Y)=E(X).E(Y) X,Y-unabhängig Eigenschaften der Varianz 1)V(X)≥0 2)V(C)=0 3)V(C.X)= C=const , C=const 4)(X+Y)=V(X)+V(Y), X,Y unabhängig Momente um Null Diskreten Fall Stetigen Fall E( E( )= )= dx Zentralle Momente Diskreten Fall = xi E ( x ) . f ( xi ) k i Stetigen Fall E(x-E(x))k= ( x E ( x)) k . f x ( x)dx = x Standartizierte Zufallsvariable EX Schiefe von X E( ) = f(x) Binominalverteilung Bin(n;p) P(x=k) = f (x=k) = C nk . p k .(1 p) n k n n(n 1)( n 2)...( n k 1) n! C nk k! k!(n k )! k EX=n.p VAR(X)=n.p.(1-p) p=P(a) Geometrishe Verteilung P(X=k)=(1-p)k-1.p 1 E(x)= p 1− p VAR(x)= p 2 Poissonverteilung P(X=k) = k k! e EX=λ (μ=λ)=VAR(x) Hypergeometrische Verteilung M N M k n k C M k .C N M nk P(X=k) = = n N CN n E(X) = n. M N VAR(X) = n( N n) M M . .1 N 1 N N Gleichverteilung 1 ,a x b f X (x) = b a 0, sonst E(X)= V(x) = ab 2 b a 2 12 Exponentialverteilung: f X x e x , x 0, 0 0, sonst 1 VAR( X ) 1 2 Normalverteilung (Gauss-Verteilung): f X x 1 2 e ( x )2 2 2 , x (, ) VAR X 2 a X b a Z b Pa X b P P Z ~ N 0;1 Tabelle: Verteilung: Bin(n;p) Po(λ) Hyp(M,N,n) G(p) U(a,b) Erwartungswert: n p n Varianz: n p1 p M N 1 p ab 2 n N n M 1 M N 1 1 p p2 b a 2 12 N N Exp(λ) 1 1 N(μ,σ) 2 2 Zweidimensionale Zufallsvariablen: (X, Y) f XY xi , y j PX xi Y y j 1 f xi , y j 0 2 f xi , y j 1 i j Die Dichtefunktion: f XY x, y f x, y dxdy 1 f x, y 0 Marginale Verteilung: f X xi f xi , y j j f Y y j f xi , y j - diskreter Fall i f X x f x, y dy fY y f x, y dx - stetige Funktion X und Y – stochastische unabhängig, wenn: f (xi, yj) = fx (xi) . fy (yj) – diskret f (x, y) = fx (x) . fy (y) – stetig Kovarianz: cov (x, y) cov x, y E [(X – E x . Y – E y cov x, y i j x i – E x . y j E y . f x i , y j cov x, y x – E x . y E y . f x, y . dxdy Korrelationskoeffizient von x und y: s ( x, y ) cov( x, y ) var( x).var( y ) wenn s (x,y) = 0 , dann x und y sind unkorreliere s (x,y) ≠ 0 , dann x und y sind korreliere Deskriptive Statistik X: (x1, x2, ..., xn) – Stichprobe hx (xi) – absolute Häufigkeit von xi 1 f x x i .h x x i - relative Häufigkeit n Fx x f x – statistische Verteilungsfunktion i:xi x i Statistische Maßzahlen 1 n x . xi - das Stichprobemittel n i 1 1 n S . xi x n 1 i 1 2 X 2 - die Stichproben – Varianz s x S x2 - die Stichproben – Standardabweichung x x1 , x 2 ,...., x n - die geordnete Stichprobe zu X x n 1 , falls n - ungerade x̃ 2 1 2 x n x n 1 , falls n - gerade 2 2 x̃– der Stichproben – Median Sei α (0,1) und K = [n. α] x k 1 , falls n. N x 1 x k x k 1 , sonst 2 – das Stichproben – - das untere Quartil - Quantil ( [-0,5] = -1; [3] = 3; [1,2] = 1) - das obere Quartil - - – Quartilabstand - Spannweite Zweidimensionale Daten Lineare Regression (X,Y) : (( - ,Y1), ( ,Y2),...(Xn,Yn)) Stichprobe: y = a + b.x = = – = E(Y) = = . 1 n . xi x n 1 i 1 = . 1 n . y i y n 1 i 1 2 2 . = E(X) = ; = - Empirischer Korrelationskoeffizient y= a + bx = . ; 1 n xi ; n i 1 = - 1 n yi n i 1 = Punkt-Schätzung.Die Momenten Methode.Die Maximum - Likelihood - Methode. 1.Momenten - Methode Schätzer Stichprobenmittel µ - Erwartungswert (EX) µ̃=x̄ Varianz VAR(X) x̄ Stichprobenvarianz S2 (x) 2.Die Maximum – Likelihood - Methode n L((x1,x2...xn),Ѳ)= f ( x , ) c i 1 M= ln L(x1,x2,…xn,Ѳ). Mmax→Ѳ̃ M̒(Ѳ)=0 , d.h. Ѳ̃ M˝(Ѳ̃)<0 , d.h. max Konfidenzintervall P(µu≤µ≤µo)=1-α 1. σ-unbekannt X~N(µ,σ) <0,05 P( x̄ - t. µu= x̄ - t. s n 1 x t. s n 1 s n 1 )=1-α s n 1 µo= x̄ + t. 2.σ-bekannt P(µu≤µ≤µo)=1-α µu=x̄ - z. µo=x̄ + z. (z aus der Tabelle) 3.σ-unbekannt ≥0,05 P(µu≤µ≤µo)=1-α µu=x̄ - t. . ; µ0=x̄ + t. . t , z-aus der Tabelle Konfidenzintervalle fuer die Varianz χ ~N(ϻ,σ) (naeherungsweise) P( σu2 σ 2 σo2)=1-α, σu2=(n.S2)/ χo2, σo2=(n.S2)/ χu2 χo2= χ2(1- α/2;n-1) , χu2= χ2(1- α;n-1) , χ2 aus Tabele der χ2-verteilung Statistische Tests der χ2 -Anpassungstest Ho:Fx(x)=Fo(x) gegen H1:Fx(x)=Fo(x) 1) Testgroesse χ∗2=∑i=1k((ni-n*pi)2/ (n*pi)) pi=P(X=xi) 2)Co= χ2(1- α,k-r-1) ,0< α<1 3) χ∗2 > Co =>Ho abgelehnt. χ∗2 < Co =>Nullhypothese(Ho) kann nicht abgelehnt werden