Einführung Begriffe Kardinal/Metrisch

Werbung

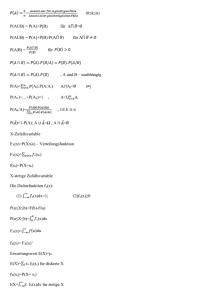

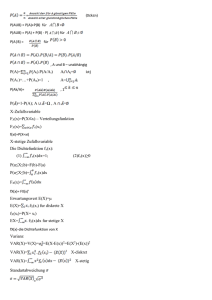

Einführung Begriffe Kardinal/Metrisch -intervall: Abstände interpretierbar, kein sinnvoller Nullpkt. (Temp.) -verhältnis: Abstände interpretierbar, sinnvoller Nullpkt. (Gewicht) Ordinal Ordnung mögl., aber Abstände nicht interpretierbar (Noten) Nominal Ausprägungen sind Namen, keine Ordnung mögl. (Haarfarbe) Qualitativ endlich viele Ausprägungen (höchstens ordinal!) Quantitativ Ausprägungen geben Intensität wieder (metrisch!) Wachstum Modell Formel Absolut. Wachstum Wachstumsrate x t x t 1 x x Steigung x t t t 1 t x t 1 Konstant. Lineares Wachstum x t x0 a t Konstant. %-Wachstum Konstantes expon. W. Verteilungen a a x 0 a(t 1) a i xo ln(1 i) (1 i)t eb 1 x0 b eb t t 1 i x0 (1 i) xt x0(1 i) t x0 eb(t 1) (eb 1) xt x0 eb t Absol. kumm. Häufigkeitsverteilung H(x)=Anzahl d. Werte x i mit xi x : H(x) h(a1) ... h(a j ) h i:aj x j H(x) =Anteil d. Werte x i mit xi x : n Relative kumm. Häufigkeitsverteilung F(x)= F(x) f(a1) ... f(a j ) f i:aj x i Lagemasse Arithm. Mittel ( x ) nicht robust; grösser als geom. Mittel; für additive Verknüpfungen 1 1) x (x1 ... x n ) n 2) x (q1f1 ... qnfn) mit 0 q 1 Median 1 3) x (n1x1 ... n n x n ) n 50% Quantil; resistent; Lage: Datenmitte; für metrische,ordinalskal. Merkmale minimiert die Summe der absoluten Abweichungen 1 (x n x n ) 1 2 2 2 n gerade: Modus n 1 ) n ungerade: x( 2 Ausprägung mit grössten Häufigkeit ist eindeutig, falls Häufig.verteilung ein eindeutiges Max. hat 1 Geom. Mittel xgeom (x1 ... xn )n =mittlerer Wachstumsfaktor Harmon. Mittel xhar Getrimmtes Mittel Lagesymmetrisch: regeln linkssteil: rechtssteil: 1 1 n 1 n i 1 xi wie x , aber Ausreisser weglassen (=robust) Übersicht Nom.skal Ord.skal x xmed xmod x x xmed Modus xmod xmed xmod Kard.skal Modus Modus Median Median AM Streuungsmasse Boxplot s s2 Standardabweichung Gesamtvarianz Schule Berufsausbildung Uinversität Gesamt 1 (xi x)2 =Streuung um AM=mittlere quadr. Abweichung v. Mittelwert n i1 wenn kleinWerte nahe am AM; für metrische M. sinnvoll verletzt Prinzip d. Skalenunabhängigkeit s2 Varianz =Streuung um AM; Var. kleinWerte nahe am AM skalenunabhängig; für metrische M. sinnvoll n n n 2n 2 2n s s j j x j x j =innere + äussere Varianz j 1 n j1 n ~2 nj xj sj 2 n ~ n 2n n 10.884 0.277 244 s j j 0.227 x j x j 0.025 11.216 0.200 1751 j 1 j 1 n n 11.536 0.342 301 11.222 0.252 2296 k Kovarianz m sxy ai x b j y fij i 1 j 1 Mass für gemeinsame Variabilität zweier Variabeln x u. y =Arithm. Mittel der Abweichungsprodukte d. einzelnen Punktepaare Stichprobenvarianz 1 n (xi x)2 n 1 i1 s2 2 Division durch “n-Freiheitsgrade“; je grösser n s2 s Interquartilsabstand s v ,x 0 Dimensionslose Grösse; für Vgl. d. Streuung zw. Merkmalen x dq x 0.75 x0.25 resistent gegen Ausreisser Spannweite xmax xmin Optimalität Q(z,x1,...,xn ) (xi z)2 Variationskoeffizient n je weiter d. Wert vom Mittelwert wegliegt, i 1 desto stärker d. Gewichtung (Quadrierung) 68-95-99%-Regel in x s liegen 68% aller Daten (bei Normalverteilung) in x 2s liegen 95% aller Daten in x 3s liegen 99% aller Daten Schiefe/Wölbung Quartilkoeff. der Schiefe (x1p xmed ) (xmed xp ) es gilt: 1 gp 1 resistent gegen Ausreisser! x1p xp für p=0.25Quartilskoeff. - gm , gp=0 : symmetr. Verteilung - gm, gp>0 : linkssteile Verteilung - gm, gp<0 : rechtssteile Verteilung gp Momentenkoeff. d. Schiefe gm Wölbungsmass v. Fisher γ 1 n (xi x)3 n i1 nicht resistent; massstabsunabh. 3 s 1 n (x j x)4 n j 1 3 4 s γ 0 : Normalverteilung γ 0 : Spitzere Verteilung γ 0 : Flachere Verteilung Konzentrationsmasse Lorenzkurve Aussagen bez. rel. Konzentration; immer monoton wachsend; Konvexe Linkskurve Relative Konz.: ∟ Gini-Koeff. G Fläche zw. Diagonale und Lorenzkurve Fläche zw. Diagonale und x Achse n -für geordnete Urliste G 2 ixi i 1 n n xi n 1 n i 1 k -für Häufigkeitsdaten G (u i 1 i 1 ui ) h ja j k h a j 1 j 1 j i i hj j 1 n wobei: ui ( kumm. Anteil Merkmalsträger) ; v i ( kumm. rel. Merkmalssumme) h a j h a j j 1 k j 1 j j Gmin=0 bei Nullkonz. (=45Grad Gerade) Gmax= WB: 0 G 1 n 1 bei max. Konz. n Absol. Konz.: ∟ Konzentrationsrate n CRg i n g 1 xi pi , wobei pi den Merkmalsanteil der i-ten EH bezeichnet n x j 1 j Mit x1 ... xn (Daten werden geordnet)=man nimmt die grössten Anteile zuerst; wenn CRg↑Konz.↑; rechnen in %Resultat in % g CR g 1 (=max. Konz.) n WB: ∟ Herfindahl-Index n H pi2 , wobei pi i 1 xi d. Merkmalsanteil der i-ten EH bezeichnet n x j wenn H↑Konz.↑ Hmin=(1/n)min. Konz.=vollk.Konk.; Hmax=1max. Konz.=Monopol WB: (1/n) H 1; “Rechnen mit 0,...-AnteilenResultat auch 0,…“ Axiomatische Überlegungen 1) Transferprinzip: Transfer v. reicheren zu ärmeren Person soll Kennzahl der Ungleichheit verkleinern 2) Skalenunabhängigkeit: proport. Δ aller Einkommen darf Ungleichheit nicht beeinflussen 3) Replikationsprinzip: eine Zusammenlegung mehrerer identischer Populationen sollte die Ungleichheit nicht beeinflussen 4) Zerlegbarkeit: es sollte ein systemat. Zusammenh. zw. d. Gesamtungleichheit u. d. Ungleichheit in Teilpopulationen bestehen Multivariate Daten Kontingenztabellen mögl. mit ablsol. od. rel. Häufigkeiten j 1 Bedingte Häufigkeit man schaut eine Zeile/Spalte als ganzes (100%) an 1.)bilde bedingte rel. Häufigkeiten 2.)prüfe ob Verteilung v. Bedingung abhängt 3.)wenn ja: Zusammh. vorhanden 4.)wenn nein: die beiden Merkm. sind unabh. h11 / h12 wenn γ =1: “gleiche Chancen“ h21 / h22 macht Aussagen über Ausmass d. relativ. Chance einer Population zur anderen u. um wie viel besser diese Chancen sind Kreuzproduktverhältnis,“Odds-Ratio“ (rel. Chance) γ hij Frauen oec. Frauen Bsp. : =Grundprinzip d. Unabhängigkeit Studis oec. Studis hj n Emp. Unabhängigkeit X2-Koeffiz. X2 hi hi h j 2 ) n WB: X2 0, hi h j n wenn X2 gross: X u. Y abh. / wenn X2 klein: X u. Y unabh. Nachteil: Wert hängt v. Dimension der Tabelle ab (nicht normiert!) k m (hij i 1 j 1 ∟ Kontingenzkoeff. X2 M 1 K 0, WB: 0,1 n X2 M macht Aussagen ob 2 Merkm. unabh./abh. sind K M 1 WB: 0,1 (K:Ausprägung Klassen / M:Auspräg. Geschlecht) M Eigenschaften v. X2, K, K* 1) nur Stärke des Zusammenhangs, nicht Richtung 2) Vergleichendes Mass zw. Prop. X und Prop. Y 3) Abhängigkeit vom Stichprobenumfang 4) Invarianz Korrelation (symmetrisch) Def. Kennzahl für Stärke eines linearen Zusammenh. bei qualit. Merkmalen Richtung/kausale Zusammenh. werden nicht durch Korr.koeffizienten erfasst misst die Streuung v. Pkt. um Gerade herum; ist unabh. v. Lage u. Skalierung ∟ Korrig. Kontingenzkoeff. K* K / sxy Kovar ianz X,Y i1 xi yi nxy 2 2 n n (i1 xi2 n x )(i1 yi2 n y ) sx sy Standardabw. X Standardabw. Y r>0: +Korrelation, gleichsinn. linearer Zusammenh., +Steigung r<0: -Korrelation, gleichsinn. linearer Zusammenh., -Steigung r=0: keine Korrelation, kein linearer Zusammenh., Steigung=0 r<0.5: schwach / 0.5<r<0.8: mittel / r>0.8: stark für metrische Merkm. Bereich der Korrelation: 1 r 1 Mass für Stärke d. linearen Z`hangs zw. 2 Variabeln (bez. Stand.abweichung!) n Emp. Korrelationskoeff. (Bravais-Pearson) Rangkorrelationskoeff. (Spearman) r rSP x y nxy nxy)(y i i (x 2 i 2 i n 6 di2 oder rsp 1 i1 (n2 1) n nxy) WB: 1 rSP 1 (r u. rsp: sind gegenüber linearen Transformationen invariant!) di=Differenz zw. den Rängen (di=xi-yi) ACHTUNG: Rangsumme muss gleich gross sein-unbedingt Ränge richtig verteilen! bei gleichen Rängen werden Durchschnittsränge vergeben allgemeiner als Bravais-Pearson Koeff. (nicht d. Daten sondern d. Ränge sind entscheidend!) =“nicht parametrische“ Kennzahl; für ordinale/metrische Merkmale rSP>0: gleichsinn. monotoner Zusammenh. rSP<0: gegensinn. monotoner Zusammenh. rSP=0: kein monotoner Zusammenh. rSP=1: funktionaler monotoner Zusammenhang vorhanden Scheinkorrelat. drittes Merkmal welches mit d. gemessenen 2 Merkmalen hochkorreliert, wird vergessen Verdeckte Korr. eine Population zerfällt hinsichtlich d. interessierenden Zusammenh. in Teilpopulationen Regression (nicht symmetrisch) Allg. y i a bx i ei (y=Regressand,abhäng. / x=Regressor,unabh. (kann binär sein) / ei=Residuen) Ausgleichsgerade y a bx Steigung/Schwerpkt. b n i 1 n yi xi nyx i 1 xi2 nx 2 n i 1 (xi x)(yi y) n i 1 (xi x)2 cov(x,y) Ko var ianz , a y bx sx 2 Varianz Y-Achsenabschnitt a y bx Expon. Regress.gleichung 1) Modell linearisieren 2) Zurückrechnen yi a bxi Linearisierung ln yi lna lnb xi a`b` xi x ln(y ) nx ln(y) x nx lnb b` ∟ Komponenten: i i 2 2 i lna a` ln(y) b`x ∟ Für Rückrechnung: b eb` x yi a b i a ea` Streuungszerlegung SQT SQE SQR i1(yi y) i1(yi y)2 i1(yi yi ) SQT=Gesamte Streuung / SQE=Erklärte St. / SQR=Residual St. Bestimmtheitsmass R2 2 n SQE SQT n i 1 n (yi y)2 (yi y)2 i 1 n 1 i 1 n n (yi yi )2 i 1 (yi y)2 n 1 2 SQR SQT WB: 0,1 , je näher R2 bei 1 ist, desto genauer ist d. Annahme (R2=1: alle Pkt. liegen auf d. Geraden) =d. Quadrat d. Korrelationskoeffizienten; =d. Anteil d. Gesamtvariation R2=erklärte Varianz / 1-R2=unerklärte Varianz macht Aussagen über d. Güte d. Anpassung (Ausgleichsgeraden) R2x100=Anteil d. Gesamtvariation d. abhäng. Variabeln in % Residuen (Abweich. v. Gerade) ei yi yi wobei: yi=effektiver Ausprägungspkt. / y i =Pkt. auf Ausgleichsgeraden Wahrscheinlichkeit Allg. Zufallsvorgang=mögl. Ergebnisse sind bekannt, wobei d. Ergebnis v. Zufall abh. ist / Zufallexp.=Zufallvorgang, Ablauf unter kontoll. Bedingungen, beilieb. wiederholbar / Ereignisraum( Ω )=Menge aller Elementarereignisse / Elementarereignis( ω )=Ergebnis eines Zufallexp.(einelementig) / Zufallereignis(A)=Teilmenge v. Ereignisraum / Subj. W.Begriff=individ. Einschätzung / Obj. W.Begriff=basiert auf Häufigkeitsinterpretation / Axomiatisch. W.begriff=Wahrsch. als Funktion (0<P<1) sicheres Ereignis:A= Ω / unmögl. E.:A= / ausschöpfendes E.:A B= Ω / disjunktes E.:A B= Eigenschaften (disjunkt=entw. A od. B) 1) 0 P(A) 1 2) P( ) 0 3) P(A) P(B) falls A B 4) P(A) 1 P(A) 5) P(A) P(A B) P(A B) 6) P(B) P(A B) P(A B) 7) P(A B) P(A) P(B) P(A B) Additionssatz 3 4 2 5 P(A B) P(A) P(B) P(A B) Würfelbsp.: P(gerade od. grösser gleich 3) 6 6 6 6 d. Wahrsch. d. Vereinigung zweier Mengen A und B ist gleich d. Summe d. Wahrsch. beider Mengen abzüglich d. Wahrsch. der Schnittmenge Anz. der für A günstigen Ergebnisse Anz. aller mögl. Ergebnisse für einfache Zufallsstichprobe (Bsp.:Würfeln) Voraussetzung ist Gleichwahrsch. der Ergebnisse Laplace (Gleichwahrsch.) P(A) ∟ Bedingte Wahrsch. P(A / B) P(A B) Anz. der für A u. B günstigen Ergebnisse = Anz. der für B günstigen Ergebnisse P(B) eine neue Info kommt hinzu und beeinflusst! P(A B) P(A / B) P(B) P(B / A) P(A) Gemeinsame Wahrsch.=Produkt d. bedingten W. u. d. Randw. ∟ Produktregel Allg. Schema mit Berücksichtig. der Reihenfolge ohne Zurückleg. Mit Zurückleg. Nn N! (N n)! ohne Berücksicht. der Reihenfolge N N n 1 n n N! z.B.:aus Urne alle Lose ziehen u. notieren d. Nr. (Modell ohne Zurückleg.) es gibt N! viele versch. Mögl. Permutation Unabhängigkeit (2) N N! =Modell: “ohne ZL+ohne Berücksichtigung d. Reihenfolge“ n n!(N n)! 2 Ereignisse sind voneinander unabh. wenn gilt: P(A B) P(A) P(B) Disjunkte Ergebnisse=nicht unabh. (wenn A eingetreten, kann B nicht eintreten!) P(A / B) P(A) bzw. P(B / A) P(B) d. Eintreten d. einen Ereignisses hat Satz v. Bayes keinen Einfluss auf Eintreten d. AndrerenBei Unabh. gilt: P(A B) P(A) P(B) Unbabh. Ergebnisse: “Ziehen mit Zurücklegen“ Abh. Ergebnisse: “Ziehen ohne Zürückl.“ P(A B) P(A B) P(B) P(A B) P(B A) P(A) P(A B) P(B) P(B A) P(A)... Totale Wahrscheinlichk. P(B A) P(A) ...bzw. P(A B) P(B) gibt an wie man v. Daten neuer Infos lernt; =“Regel für induktives Lernen“ Sei A1,...,Ak eine disjunkte Zerlegung von Ω. Dann gilt für Binomialkoeffizient Unabhängigkeit (1) B Ω : P(B) i1P(B / A i ) P(A i ) k Axiome Kolmogorof 1 2 3 Normalfall P(A) 0 Für unendliche GG P(A) 0 P(Ω) 1 falls A B P(Ω) 1 gilt: Seien A1,...,Ak Ω paarweise disjunkt : P(A B) P(A) P(B) a-priori-Wahrsch. a-posteriori-Wahrsch. P(A1 ... Ak ...) i1P(Ai ) Wahrsch., subj. Wahrsch., d. vor d. Ankunft neuer Infos besteht, beruht i.d.R. auf vergangenem Lernen früherer Infos aktualisierte Wahrsch.die neue Info wird berücksichtigtP(A/B) Diskrete Zufallsvariabel (Skalierung: nominal-, ordinal-, kardinal-, ist möglich!) Def. ZV eine Variabel od. ein Merkmal X, dessen Werte od. Ausprägungen d. Ergebnisse eines Zufallvorgangs sind heisst ZV X d. Zahl x R , d. X bei einer Durchführung d. Zufallvorgangs annimmt, heisst Realisierung od. Wert v. X ZV X=Abbildung, d. jedem ω Ω eine reelle Zahl X(ω) x zuordnet X : Ω R Def. diskrete ZV ZV X=diskret, falls sie nur endlich od. abzählbar unendlich viele Werte annehm. kann Wahrsch.keitsverteilung Verteilungsfunktion P(X xi ) pi, x xi x1,x 2...,xk ,... f(x) 0, sonst d. ZV X ist d. wahrscheinl.keitstheoret. Analogon zur relativ. Häufigkeitsverteil. F(x) P(X x) f(xi ) =Kumulieren d. Wahrscheinlichkeitsverteilung Standardabweichung σ Var(X) Varianz Var(X) σ2 i1(xi μ)2 f(xi ) ∟ Verschiebungsregeln ∟ Transformationregel 1) Var(X) E(X2 ) (E(X))2 E(X2 ) μ2 E(X μ)2 2) Var(X) E((X c)2 ) (μ c)2 Sei g(x) eine reelle Funktion, dann gilt für Y=g(X): Wahrscheinlichkeitsfkt. Y=g(X): E(Y) E(g(X)) g(xi )f(xi ) τx Bei Linearität gilt: E(Y) (a bxi )f(xi ) a f(xi ) b xif(xi ) a bE(X) τx ∟ Additionsregel Erwartungswert (Allg.) τx τx Var(X Y) Var(X) Var(Y) =d. zu erwartende Abweichung d. ZV v. ihrem Erwartungswert Transformationsregeln v. Varianz/Standardabw.=Regeln im deskriptiven Bereich E(X) xp i i μx μ charakterisiert d. Verhalten eines Zufallsexperimentes (ACHTUNG: E(X) AM )Transformationsregeln=analog wie bei AM ∟ Additionsregel E(X Y) E(X) E(Y) ∟ Produktregel E(X Y) E(X) E(Y) (gilt für unabhängige ZV`s) Unabhängigk. diskr. ZV`s für beliebige Werte aus Wertebereich muss gelten: P(X1 x1, X2 x 2,....., Xn xn ) P(X1 x1) P(X2 x 2 ) ..... P(Xn x n ) Diskr. Gleichverteilung Fall: “Augenzahl beim Würfeln“ Geometrische Verteil. 1 P(X xi ) Wahrscheinlichkeitshistogramm: k Fall: “Anzahl d. Versuche bis zum ersten Mal A eintritt“ (gleich bleibende Wahr.!) P(X xi ) (1 π)x1 π Wahrscheinlichkeitshistogramm: Verteilungsfunktion: 1 π ∟ Erwartungswert E(X) ∟ Varianz Var(X) Poissonverteilung ∟ Erwartungswert ∟ Varianz 1 π π2 λx λ e , x 0,1,... λ Erwartungswert f(x) P(X x) x! 0 , sonst Fall: “Anzahl d. Ereignisse, d. innerhalb d. Intervalls 0,1 eintreten“ (Bsp.: Schadensmeldungen bei Versicherung innerhalb eines Jahres) gegeben wenn folgendes erfüllt ist: 1) 2 Ereignisse können nicht genau gleichzeitig auftreten 2) wenn Δt klein wird, wird d. W. d. Eintreffens d. Ereignisses ebenfalls kl. λ Intensitätsrate (“Verteilung d. seltenen Ereignisse!“) 3) d. W. d. Eintretens hängt nicht v. Lage d. Teilintervalles ab, sondern v. Länge E(X) λ Var(X) λ ∟ Additionsregel n x n x n unabh. Wiederholungen π (1 π) ,x 0,1,2,...,n f(x) x π Erfolgswahrscheinlichkeit 0, sonst Fall: “Ziehen mit Zurücklegen“ (Wahrsch. d. interessierenden Ereignisse= π ) Fall: “Anzahl Versuche bei denen A eintritt“ E(X) n π Var(X) n π(1 π) Sind X B(n,π) und Y B(m,π) unabh., so ist X Y B(n m, π) ∟ Symetrieeigenschaft. Sei X B(n,π) und Y n X . Dann gilt: Y B(n,1 π) Binomialverteilung ∟ Erwartungswert ∟ Varianz Hypergeom. Verteilung ∟ Erwartungswert M N M x n x ,x τ xmax min(n,M) f(x) WB: N xmin max(0,n (N M)) n 0, sonst Fall: “Ziehen ohne Zurücklegen / Anz. d. gezogenen Objekte mit Eigenschaft A“ Wahrscheinlichkeit ändert mit jedem Zug! N: Umfang d. Grundgesamtheit / M: Anzahl EH,d. Eigenschaft A besitzt / n:Grösse d. Stichprobe E(X) n M N ∟ Varianz Multinomialverteilung M M Nn 1 N N N 1 Var(X) n π π 2d2 ... π Jdj , j 1,2,...,J wobei : π J 1 π1 ... π J1 f(j) 0, sonst Bsp: folgende Parteistärke ist gegeben: “SP=25% / SVP=25% / FDP=25% / CVP=12.5% / Üb.=12.5% “ Wie gross ist d. W.,das sich unter 8 zufällig ausgewählten Wählern d. genau gleiche Verteilung einstellt? d1 1 … P(2,2,2,1,1) Übersicht Verteilungen 8! 0.252 0.252 0.252 0.1251 0.1251 0.0192 2% 2!2!2!1!1! X G(π) geom. Verteilung X B(n,π) Binomialverteilung X H(n,M,N) hypergeom. Verteilung X Po(λ) Poisson Verteilung Lageregeln Symmetrische Verteilung : xmod xmed E(X) Linkssteile Verteilung : xmod xmed E(X) Rechtssteile Verteilung : xmod xmed E(X) M=Anzahl / n=Grösse d. Stichprobe / N=Grundgesamtheit / λ =Erwartungswert / π =Erfolgswahrscheinlichkeit Stetige Zufallsvariabel (Skalierung: metrisch-, ordinal-, ist möglich!) Zeichenerklärung Def. ZV welche jeden Wert im Intervall a,b annehmen kann Werte sind nicht mehr abzählbar, sondern überabzählbar die Fkt. f(x) heisst (Wahrscheinlichkeits-) Dichte von X ZV X=stetig, wenn es eine Fkt. f(x) 0 ,sodass für jedes Intervall a,b gilt: P(a X b) f(x)dx a Wahrscheinlichkeit P(a X b) P(a X b) P(a X b) P(a X b) und P(X x) 0 für jedes x R (ist d. Fall wenn : a b x) b ∟ Normierungseigenschaft Dichtefunktion f(x)dx 1 gesamte Fläche 1 gegeben falls erfüllt: 1.) f(x) 0 (da es keine negativen Wahrsch. gibt!) 2.) f(x)dx 1 ( sichere Ereignis) Verteilungsfunktion x F(x) P(X x) f(t)dt 1) F(x) stetig und monoton wachsend (Mit Werten im Intervall 0,1) 2) Für Grenzen gilt : F( ) lim F(X) 0 (unmögl. Ereignis) x F( ) lim F(X) 1 (sicheres Ereignis) ∟ Eigenschaften Erwartungswert x dF(x) f(x) Dichte Ableitung d. Verteilungsfkt.! dx 4) Für Intervalle gilt : P(a X b) F(b) F(a) P(X a) 1 F(a) 3) F`(x) μ E(X) f(x)dx E(X Y) E(X) E(Y) 1) Additionsregel: ∟ Eigenschaften 2) Lin. Transformation: für Y aX b gilt : E(Y) E(aX b) aE(X) b 3) Symmetr. Verteilung: ist die Dichte f(x) symmetr. um Pkt. c,d.h. f(c x) f(c x) für alle x,so gilt :E(X) c 4) Produktregel bei Unabhängigkeit Varianz σ 2 Var(X) (x μ)2f(x)dx E(X2 ) E(X) Standardisierung Z 2 Unabhängigkeit X μ σ P(X x,Y y) P(X x) P(Y y) Fx (x) Fy (y) Stetige Gleichverteilung oder allgemeiner: P(X x1,..., Xn x n ) P(X1 x1) ... P(Xn x n ) Fall: “Stelle des Glückrades auf die der Pfeil zeigt“ 1 für a x b f(x) b a a,b=Intervallgrenzen 0 sonst eine auf Intervall 0,1 gleichverteilte ZV nennt man auch Standardgleichverteilt ∟ Verteilungsfunktion ∟ Erwartungswert ∟ Varianz Exponentialverteilung xa 0, x a ergibt sich aus Intergration: F(x) ,a x b b a 1, x b ba E(X) 2 (b a)2 Var(X) 12 =Pendant zur geometr. Verteilung (bei diskreten ZV`s) =gedächtnislos=vorgängige Aktionen haben keinen Einfluss auf Zukunft λe λx für x 0 λ Anz. Aktionen pro Zeiteinheit f(x) für x 0 0 je grösser λ , desto schneller geht d. Exp.fkt. für x gegen 0 u. d. Verteilungsfkt. gegen 1 (Fläche unter f(x)ist immer=1) ∟ Verteilungsfunktion ∟ Erwartungswert ∟ Varianz ∟ Poissonverteilung 1 e λx ergibt sich aus Intergration: F(x) 0 1 E(X) 0 xλe λx dx λ 1 Var(X) 2 λ für x 0 für x 0 λx λ e , x 0,1,... E(X) λ Var(X) λ f(x) P(X x) x! 0 , sonst steht im engen Zusammenhang mit Exponentialverteilung: d. Anzahl v. Ereignissen in einem Zeitintervall ist genau dann Po(λ) verteilt, wenn d. Zeitdauern zw. aufeinander folgenden Ereignissen unabhängig und exponentialverteilt mit Parameter λ sind 2 1 x μ σ 1 e 2 2πσ Normalverteilung Dichtefunktion f(x) ∟ Erwartungswert E(X) μ ,x R ∟ Varianz Var(X) σ 2 ∟ Transformationen Sei X N(μ,σ2 ) und Y a bX X N(a bμ,b2σ2 ) Standardnormalverteil. =symmetrisch um Erwartungswert; Max. liegt bei μ ; Wendepunkte bei μ σ ist d. gleiche Verteilung wie Normalverteilung ausser dass: E(X) μ 0 und σ2 1 und σ 1 1 21 x2 e 2π Sei X N(μ,σ2 ) und Y a bX X N(a bμ,b2σ2 ) für Verteilung v. nicht-negativen ZV`s wie Lebensdauern usw.;=Linkssteil d. Parameter μ und σ 2 haben für d. Lognormalverteilung nicht d. Bedeutung v. Ertwartungswert u. Varianz! X LN(μ,σ2 ) Y lnX N(μ,σ2 ) Dichtefunktion (x) ∟ Transformationen Log. Normalverteil. ∟ Erwartungswert ∟ Varianz Logistische Verteilung E(X) eμσ 2 /2 2μσ2 2 Var(X) e (eσ 1) ähnlich zur Normalverteilung (mit σ 1,6 ) f(x) e x /(1 e x )2 x X2-Verteilung F(x) f(t)dt e x /(1 e x ) für AnpassungstestSeien X1,…,Xn unabh. und identisch N (0,1)-verteilte ZV`s., dann heisst d. Verteilung d. ZV`s: Z X21 ... X2n Chi-Quadr. Verteilung ∟ Erwartungswert E(Z) n (n Anzahl Freiheitsgrade) ∟ Varianz t-Verteilung Var(Z) 2n (n Anzahl Freiheitsgrade) =Student-Verteil.; für Parametertest u. Konfidenzinterv.; für robuste Verfahren X T ∟ Erwartungswert Z/n E(T) 0 (n Anzahl Freiheitsgrade) ∟ Varianz Var(T) Fisher-Verteilung ∟ Erwartungswert n (n 3) n2 X/m Z für Testverfahren d. Regressions- und Varianzanalyse Y /n n für n 3 (n Anzahl Freiheitsgrade) E(Z) n2 2n (n m 2) Var(Z) für n 5 m(n 4)(n 2)2 68-95-99,7% Regel alle Normalverteilungen erfüllen die folgenden Beziehungen: 1)ca. 68% aller Beobachtungen liegen innerhalb einer Standardabweichung um d. Mittelwert (zw. μ σ und μ σ ) 2)ca. 95% aller Beobachtungen liegen innerhalb zweier Standardabweichung um d. Mittelwert (zw. μ 2σ und μ 2σ ) 3)ca. 99.7% aller Beobachtungen liegen innerhalb dreier Standardabweichung um d. Mittelwert (zw. μ 3σ und μ 3σ ) 2 ∟ Varianz Beobachtungen jenseits der 3σ sind also extrem unwahrscheinlich! Grafik (Grafik auf Seite 303) Standardisierung Erwartungswert ∟ Eigenschaften Z X μ σ 1) σ und μ einsetzen 2)nach X auflösen 3)Intervallgrenzen setzenTabelle ablesen! μ E(x) x f(x) dx (einer stetigen ZV X mit Dichte f(x)) 1.) Transformationen : g(x) reelle Funktion. Dann gilt für Y g(X) : E(Y) E(g(X)) g(x) f(x)dx 2.) Lineare Transformation : für Y a X b ist : E(Y) E(a X b) a E(X) b 3.) Symmetrische Verteilungen : Ist d. Dichte f(x) symmetrisch um den Pkt. c, d.h. f(c x) f(c x) für alle x, so gilt : E(X) c 4.) Additivität : für 2 ZV`s X und Y ist : E(X Y) E(X) E(Y) Allgemeiner : E(a1X1 ... an Xn ) a1E(X1) ... anE(Xn ) Modus bezieht sich auf d. Maxima der Dichtefunktionxmod falls Maxima eindeutig ist, u. f(x) keine weitere besitzt, heisst f(x) unimodal falls f(x) unimodal und symmetrisch um c istc=xmod=E(x) 1 Median xmed=50% Quantil: F(xmed ) 1 F(xmed ) 2 ab bei stetiger Gleichverteilung: F(x med ) Grafik 13 2 xmed 1 Achtung : richtig auflösen (mit logarithmieren) bei Exponentialverteil.: 0 λ e λxdx 2 Quantil F(xp ) P(X xp ) p bzw. xp F1(p) für 0<p<1 ist das p-Quantil xp die Zahl auf der x-Achse! Symmetrie E(X) xmod xm e d (…bez. einem Punkt c) Standardabweichung Varianz σ Var(X) einer stetigen ZV X mit Dichte f(x): ∟Normalfall: σ 2 Var(X) (x μ)2 f(x)dx E (X E(X))2 , mit μ E(X) ∟Exponentialverteilung: Var(X) 1 λ2 1.) Var(X) E((X μ)2 ) Var(X) E(X 2 ) (E(X))2 E(X2 ) μ2 2.) Verschiebungsregel : Var(X) E((X c)2 ) (μ c)2 ∟ Eigenschaften 3.) Lineare Transformation : für Y a X b : Var(Y) Var(a X b) a2 Var(X) , σ Y a σx 4.) Varianz der v. unabhäng. ZV`s : Var( X Y) Var(X) Var(Y) allgemeiner : Var(a1X1 ... an Xn ) a12Var(X1) ... an2Var(Xn ) Symmetrisch wenn : xmed xp x1p xmed Symmetrie / Schiefe Linkssteil wenn : x med x p x1p xmed Rechtssteil wenn : x med x p x1p xmed Lageregeln Symmetrische Verteilung : xmod xmed E(X) Linkssteile Verteilung : xmod xmed E(X) Rechtssteile Verteilung : xmod xmed E(X) Summen von ZV`s Y X1 ... Xn bzw. in allg. Form : Y a1X1 ... anXn ∟ Erwartungswert E(Y) E(X1) ... E(Xn ) bzw. E(Y) a1E(X1) ... anE(Xn ) 1 ∟ Erwartungw. v. Mittelwert E(X) E (X1 ... Xn ) μ n ∟ Varianz Var(Y) Var(X1) ... Var(Xn ) bzw. Var(Y) a12Var(X1) ... an2Var(Xn ) ∟ Varianz v. Mittelwert 2 1 σ Var(X) Var (X1 ... Xn ) n n ist kleiner als die Varianz der Komponenten je grösser n, desto kleiner wird d. Varianz d. Mittelwertes Gesetz d. grossen Zahlen P( Xn μ c) 1 für n Zentraler Grenzwertsatz für Binomial- u. Poissonapproximationen Allg. gilt: D. Verteil. einer Summe v. ZV konverg. für n gegen Normalverteil. Zn X1 ... Xn nμ nσ X1 ... Xn nμ 1 n n i 1 Xi μ X μ Zn σ σ/ n N(0,1) X nπ ∟ Binomialapproximation Zn X N(nπ,nπ(1 π)) nσ n π(1 π) diese Approximation gilt für: nπ 5 und n(1 π) 5 ∟ Poissonapproximation Zn Punktschätzung Def. Schätzfunktion Rückschluss aus ZSP auf Parameter d. Verteilung in GG ergibt für jede Stichprobe einen SchätzwertSchätzfkt.=selber eine ZV X1 ... Xn nμ X nλ X N(nλ,nλ) nσ nλ diese Approximation gilt für: nλ 10 σ Schätzfkt.=ZVWurzel aus d. Varianz dieser ZV=Standardfehler= n ∟ Eigenschaften der Schätzfunktion: 1.) Erwartungstreue -Schätzstatistik sollte tendenziell d. richtigen Wert liefert, d.h. weder systematisch über- noch unterschätzen! -wenn gilt: Eθ(T) θ Bias 0 (Bias Verzerrung system. Über /Unterschätzen) Standardfehler - Biasθ (T) Eθ (T) θ (θ exakte Wert) E(x) E(x) also ist x eine uverzerrte Schätzfunktion für : --E(x) beliebige Verteilung -- μ der Normalverteilung -- π der Bernoulli-Verteilung S2 2 n 1 S (xi x)2 Stichproben var ianz ist unverzerrt für σ 2 n 1 n 1 -Standardfehler v. erwartungstreuer Schätzstat. gibt Auskunft üb. Genauigk. d. Schätzverfahrens,da σ X S2 n -asymptotisch erwartungstreu, falls gilt: limEθ(T) θ n -d. Genauigkeit des Schätzverfahrens wird durch d. Varianz d. Schätzstatistik bestimmt -d. Standardabweichung d. Schätzstatistik = Standardfehler: σg Var g(X1,...,Xn ) 2.) Wirksamkeit (Effizienz) -je kl. Varianz (u. damit SP-Fehler!), desto besser; mit steigender Stichprobengrösse (Info`s) nimmt Varianz ab -MSE-Wirksamkeit v. Schätzstatistiken: Von zwei Schätzstatistiken T1 und T2 heisst T1 MSE-wirksamer, wenn gilt: MSE(T1) MSE(T2 ) -Wirksamkeit v. erwartungstreuen Schätzstatistiken: Von zwei erwartungstreuen Schätzstatistiken T1 und T2 heisst T1 wirksamer oder effizienter, wenn gilt: Var(T1) Var(T2 ) - MSE E(T θ ) Var(T) E(T) θ erwart. Abwertung zw. Schätzfkt. u. wahrem θ 2 2 Bias -eine effiziente Schätzfkt. minimiert die MSE! 3.) Konsistenz -Konsistenz=Verzerrung=0Varianz=0 -=eine Eigenschaft die d. Verhalten bei grossen Stichprobenumfängen reflektiert! - MSE E(T θ ) Var(T) E(T) θ 2 2 (MSE=mittlere quad. Abweich.) 0 -MSE-Konsistenz falls: MSE “konsistent im quadratischen Mittel“ n -ACHTUNG: Schätzfunktionen können konsistent sein auch wenn sie nicht erwartungstreu sind!!! -schwache Konsistenz: limP( T θ ε) 1 bzw. limP( T θ ε) 0 n n -Prinzipiell gilt: jede Schätzstatistik die im quadr. Mittel konsistent ist, ist auch schwach konsistent -jede erwartungstreue Schätzstatistik ist schwach konsistent, wenn Var(T)=0 für n Konstruktion von Schätzfunktionen 1.) Maximum Likelihood-Schätzung -Max. Likelihood Fkt.=Produkt aus n identischen Dichte- bzw. Wahrsch.fktionen - θ =unbekannt, soll als Fkt. für Realisation von X1…Xn aufgebaut werden: L(Q) f(x1...xn θ) diese Fkt. ist zu maximieren!meist verwendet man ln: lnL(θ) i1ln f(xi θ) -ML-Schätzer sind assymptotisch normalverteiltkonsistent und asymt. effizient! n -Max. Likelihood-Schätzer für Poissonverteilung: λ n i 1 n xi x 1 -Max. Likelihood-Schätzer für Normalverteilung: σ (xi x)2 n i 2.) Kleinste Quadrate Schätzung (OLS) -d. Parameterschätzung besteht darin, d. aufsummierten quadr. Abweichungen zw. Beobachtungswert u. geschätztem Wert zu minimieren: n i 1 (Xi μ)2 min daraus resultiert nach einfacher Ableitung als Schätzer das AM X Intervallschätzung Def. gibt Auskunft über d. Mass d. Unsicherheit d. Stichprobe α =Irrtumswahrscheinlichkeit / 1 α =Gegenwahscheinlichkeit (kofidenzniveau) liefern den wahren Wert θ 1.) ( 1 α )-Konfidenzintervall (bei normalverteiltem Merkmal) a) σ σ σ 2 bekannt: X z α ,Xz α , wobei Z 1 1 n n 2 2 X μ σ n S S 1 σ 2 unbekannt: X t α (n 1) , X t α (n 1) mit S (Xi X)2 und T 1 1 n 1 i n n 2 2 2.) ( 1 α )-Konfidenzintervall (bei beliebiger Verteilung, n>30) b) a) σ σ σ 2 bekannt: X z α ,Xz α , wobei Z 1 1 n n 2 2 X μ S n X μ σ n S S 1 ,Xz α b) σ 2 unbekannt: X z α mit S (Xi X)2 und T 1 1 n 1 i n n 2 2 3.) ( 1 α )-Konfidenzintervall für den Anteilswert π X μ S n π z α π(1 π) , π z α π(1 π) , wobei π X die relative Häufigkeit bezeichnet und Z 1 1 n n 2 2 Stichprobenfehler Interpretation KI Breite des KI ππ π(1 π) n 1 α halbe Breite d. KI=Standardfehler+ Wert des 1 Quantils (hat bei Anteilswerten 2 2 d. Dimension:%) bei wiederholten SP-Ziehungen deckt d. KI mit seinen zufälligen Intervallsgrenzen d. wahren Parameter in (1 α)% aller Fälle ab ist abhängig von: n, α, σ2 in der GG (Bsp.: 2 z 1 α 2 σ ) n ist grösser, je mehr Anteilswert in d. Mitte d. WB liegen!max für: π 0,5 Hypothesentest Def. Allg. Vorgehen ∟ 1)Hypothese Hypothese bezügl. eines Parameters in der GG, prüft anhand SP, ob d. empir. Befund für od. gegen d. Hypothese spricht H0=“Wie gehabte Annahmen“ H1=Forschungshypothese=die zu untersuchende Hypothese a) H0 : π π0; H1 : π π0 zweiseitig b) H0 : π π0 oder π π0 ; H1 : π π0 einseitig Allg. gilt: π μ c) H0 : π π0 oder π π0; H1 : π π 0 rechtsseitig ∟ 2)Signifik. Niveau α =Wahrsch. dass eine Teststatistik bei Gültigkeit H0 in Ablehnungsbereich fällt wenn Teststat. in Abl.bereich, ist es unwahrsch., dass SP aus Verteilung unter H0 generiert wurde ∟ 3)Annahme-/Abl.bereich Bedingungen d. wahr od. unwahr sind, wenn H0 Methode 1: verwerfen H0 falls: a) z z 1 α 2 b) z z1α c) z z1α Methode 2: verwerfen H0 falls: P α signifikant ∟ 4)Prüfgrösse ∟ Methode 3: verwerfen H0 falls Prüfgrösse ausserhalb des (1 α) -KI liegt >falls: σ 2 bekannt: X a N(μ, σ ) , X N(0,1) od. beliebig verteilt mit n 30 n Gauss (Z-Test)st.normalvert. Tab. X μ0 n a N(0,1) σ >falls: σ 2 unbekannt: n<30 (für n 30 ersetze t(n 1) durch N(0,1)) Z ∟ t-Test (od. approx. t-Test für n 30 )t-Tab. X μ0 n t(n 1) Varianz muss geschätzt werden: S2 (Xi X)2 /(n 1) S >Anteilswerte: ZSP 0/1, π P(X 1), X B(n,π), X a N(nπ,nπ (1 π)) T ∟ appr. Bin-Test (Z-Test)t-Tab. falls: n π 5, n(1 π) 5 π π0 a N(0,1) π 0 (1 π 0 ) n >Exakter Binomialtest (Berechnung d. Abl.bereich durch exakte Wahrsch. d. Binomialverteilung um H0)Bin.vert. Tab falls H0 verworfen wird, heisst das: 1.) Unterbruch zw. geschätztem Wert aus d. SP u. d. H0-Parameter d. GG ist nicht nur wegen SP-Fehler 2.) Geschätzt. Wert ist stat. signifikant von μ 0 unterschiedlich “Wir können nicht beweisen, dass eine Hypo. richtig ist. Wir können nur zeigen, dass sie (wahrscheinlich) falsch ist (Falsifizieren!)“ Z ∟ ∟ 5)Entscheidung Fehler X nπ n π(1 π) Zutreffendes Ereignis H0 ist korrekt H0 ist falsch Gütefunktion=Macht Testentscheidung H0 wird abgelehnt H0 wird angenommen =“Fehler 1. Art“ Richtiger Entscheid = α Fehler Richtiger Entscheid =“Fehler 2. Art“ = β Fehler μ μ0 g(μ) 1 "β Fehler " 1 Φ z1α n σ =Wahrsch. die falsche Ho zu verwerfen. “Konsistent“ wenn Macht für n 1 ein Test heisst “optimal“, wenn er die grösste Macht besitzt (in einer Klasse!) Macht :1.) n 2.) je weiter wahresμ vonH0 abweicht 3.) α ( je grösser α, der Fehler 1.Art) p-Wert p PH0 (Z z) 1 PH0 (Z z) lässt sich bei allen Tests anwenden bei p-Wert Methode ist entscheid. welche Prüfgrössenwerte noch stärker gegen H0 sprechen=z die Nullhypothese kann nicht abgelehnt werden wenn d. p-Wert grösser als der α -Wert ist Signifikanztest gegeben falls: P(H1 annehmen H0 wahr) α d.h. P(Fehler 1. Art) α es wird dasjenige α (Signifikanzniveau)ausgewählt welches d. kleinste Wahrscheinlichkeit für d. Fehler 2. Art mit sich bringt! Zweistichprobenfall von Hypothesentests Allg. H0: Homogenität / H1: Heterogenität π1 π 2 (π1 π 2 ) 1 1 π (1 π)( ) n m Vgl. v. Anteilswerten Z ( 1 α )-KI im ZSP Fall X Y Z α 1 2 Verteilungsfreie Tests ∟ 1)X2 Anpassungstest S12 n1 n1π1 n2 π 2 n1 n2 n2 H0 : P(X i) πi, i 1,...,k H1 : P(X i) πi, für ein i (h nπ ) i (Durchschnitt rel. Häufigkeit) 2 2 X2 ∟ 2) X Unabh.test S2 2 N(0,1) wobei π Vgl. zw. emp. u. hypothet. Verteilungen / Verteilungsmodell H0:ZSP aus spez. Verteilung generiert / H1:ZSP nicht aus spez. Verteilung generiert 2 a i = nπi Durchschnitt Bei voll spezifiz. Verteilung : approx. X2 (k 1) verteilt Bei l geschätzten Parametern : approx. X2 (k 1 l) verteilt k m X2 (hij hij )2 hij , wobei hij hi h j n H0 : P(x i,y j) P(x i) P(y j) , H1 : P(x i,y j) P(x i) P(y j) Unabhängigkeit ∟ 3.)Vorzeichentest Verteilung unter H0 : approx. X 2 ((k 1)(m 1)) Ablehnungsbereich : X 2 X 21 α ((k 1)(m 1)) H0 : xmed δ0 , H1 : xmed δ0 A Anzahl der Xi mit einem Wert δ0 Unter H0 gilt :P(Xi δ0 ) 0,5 B(n,0.5) H0 wird verworfen wenn A nahe bei 0 od.1 A Freiheitsgrade allg. gilt: A B(n,π) Gleichverteilung: Poissonverteilung: Binomialverteilung: Normalverteilung: k-1 k-2 k-2 k-3 Multivariate Statistik (Mehrdimensionale ZV`s) Def. Einem Ergebnis eines Zufallvorganges werden simultan mehrere Ergebnisse (reelle Zahlen) zugeordnetmehrdimensionale Abbildungen! Gemeinsame W.fkt. P(X x,Y y) für (x,y) (x1,y1),(x 2,y 2 ),... f(x,y) sonst 0 =(gemeinsame) diskr. Dichte / Verteilung m P(X xi ) πi πij j 1 k von y : P(Y yi ) π j πij i 1 f(x,y) von X : fX (x y) für festen Wert y fY (y) von x : Randverteilungen Bedingte W.fkt. Gemeinsame Verteilungsfkt. f(x,y) für festen Wert x fX (x) F(x,y) P(X x,Y y) f(xi,y j ) Gemeinsame stetige Verteilung und Dichte P(a X b,c Y d) von Y : fY (y x) xi x y j y b a d c f(x,y)dydx Randdichte von X : fX (x) f(x,y)dy von Y : fy (y) f(x,y)dx von X Y y : fX (x y) von Y X x : fY (y x) Bedingte Dichte f(x,y) für festes x mit fX(x) 0 fX (x) a b P(X a,Y b) f(x,y)dydx Gemeinsame Verteilungsfkt. Erwartungswert f(x,y) für festes y mit fY (y) 0 fY (y) E g(X,Y) g(x,y)f(x,y)dxdy ∟ Normalfall E(Y x) yf(y x)dy d. ZV`s X u. Y heissen unabhängig, wenn für alle x und y gilt: f(x,y) fX (x) fY (y) πij πi π j (…ansonsten heissen X und Y abhängig!) die ZV X1,…,Xn heissen unabhängig, wenn für alle x1,...,x n gilt: P(X1 x1,..., Xn xn ) P(X1 x1) ... P(Xn xn ) äquivalent ist die Produktbedingung: f(x1,...,xn ) fX1(x1) ... fXn (xn ) ist massstabsunabhängig=Erwartungswert d. ZV die selbst ein Prod. von ZV ist! macht Aussagen üb. Z`hang. d. beiden ZV`s (wenn=0kein Z`hang/Unabh.) positiv: gleichsinn. Z`hang (pos. Steigung)/negativ: gegensinn. Z`hang (neg. St.) Cov(X,Y) E( X E(X) Y E(Y)) 1 x1 x y i y n ∟ bei stetiger. ZV Cov(X,Y) ∟ Verschiebungssatz ∟ Symmetrie Cov(X,Y) E(XY) E(X) E(Y) Cov(X,Y) Cov(Y,X) Bedingter Erwart.wert Unabhängigkeit (v. 2 ZV`s) Unabhängigkeit (v. ZV`s) Kovarianz ∟ Lineare Transform. (x E(X))(y E(Y))f(x,y)dx Die Kovarianz der transformierten ZV`s X aXX bX, Y aYY bY ist bestimmt durch : Cov(X,Y) aXaYCov(X,Y) Bsp.: Cov(10x,y)=10*Cov(x,y) ∟ Eigenschaften E(X,Y) Korrelationskoeffizient Cov(X, Y) Cov(Y, X) Cov(X, Y) E(YX) E(X)E(Y) Cov(aX b, cY d) acCov(Y, X) Cov(X, X) Var(X) Cov(X, Y) 0 Unabhängigkeit!!! bei stetig : x y f(x,y) dydx bei diskret : f(xi yi )xi yi besser interpretierbar als Kovarianz (=geeignete Normierung!) positiv: gleichsinn. Z`hang (pos. Steigung)/negativ: gegensinn. Z`hang (neg. St.) σ Cov(X,Y) Cov(X,Y) wobei WB: 1 ρ(X,Y) 1 xy σ xσ y Var(X) Var(Y) σ xσ y ρ(X,Y) 0 Sind 2 ZV`s unabhängig, so sind sie auch unkorreliert! ρ(X,Y) 0 Varianz d. Summe zweier Zufallszahlen Var(X1 X2 ) Var(X1) Var(X2 ) 2Cov(X1, X2 ) ρxy ∟ Unkorreliertheit ∟ Korreliertheit Gewichtete Summe X a1X1 ... an Xn ∟ Erwartungswert E(X) a1E(X1) ... anE(Xn ) ∟ Varianz Var(aX1 bX2 ) a2Var(X1) b2Var(X2 ) 2abCov(X1,X2 ) Bivariat. Dreieckverteil. f(x,y) x y für 0 x 1, 0 y 1 (=normale Fläche im Raum!) 2-dim. Normalverteil. für ZV`s X und Y gilt: f(x,y) 1 2 2 y μ2 y μ2 x μ1 2ρ x μ1 2 1 2(1ρ ) σ1 σ1 σ2 σ2 e 2πσ1σ2 1 ρ2 Korrelation ρ :bestimmt d. Ausrichtung/Breite d. Bergrücken auf d. (x-y)-Ebene! ( ρ um0:breiter Rücken / ρ um1: schmaler Rücken )falls ρ 1 :Verteilung entartet! …d.h. Bergrücken wird beliebig schmal! Varianzen σ12,σ22 :bestimmen d. Höhe d. Bergrücken ( σ12,σ22 desto flacher! ) positiv: gleichsinn. Z`hang (pos. Steigung)/negativ: gegensinn. Z`hang (neg. St.) Sind 2 ZV`s unabhängig, so sind sie auch unkorreliert! Regressionsanalyse Allg. Deskript. Stat.-Fall=Beschreibung d. Z`hangs zweier Variabeln für bestimmten Datensatz Inferenzstat.-Fall=Punktschätzung für zwei Variabeln der GG Modell d. linearen Einfachregressession Emp. Beziehung: yi α βxi i , i 1,...,n (wobei i =Fehler/Störvariabel) i wird nun neu als Realisierung von ZV aufgefasst (wobei vereinfachend E(i ) 0 , i 1,...,n ) angenommen wird: ∟ Stochast. Grundmodell yi α βxi i , E(i ) 0 , i 1,...,n - E(Yi ) E(α βxi i ) α βxi ∟ Eigensch. d. Zielvariabel 2 - Var(Y) i Var(α βxi i ) σ Homoskedastizität Heteroskedastizität Normalverteil.annahme Schätzen =d. Eigenschaft gleicher Varianz σ 2 d. Fehlervariablen i =es wird zugelassen, dass d. Varianzen ungleich sind i N(0,σ2 ) bzw. Yi N(α βxi , σ2 ) , i 1,...,n ∟ Ziel v. KQ-Prinzip bestimme d. Schätzer α und β so, dass: n i 1 (Yi α βxi )2 minα,β also die Summe d. quadr. Abweichungen durch α, β minimiert wird. ∟ Kleinste Quadr. Schätzer β n i 1 (xi x)(Yi Y) n i 1 2 1 1 n n i n 2 i1(Yi α βxi )2 ,... n 2 i1 2 , α Y βx , σ (xi x)2 mit den Residuen i Yi Yi und den gefitteten Werten Yi α βxi 2 α,β,σ2 sind erwartungstreue Schätzer: E(α) α , E(β) β , E(σ ) σ 2 , Var(α) σα2 σ2 x i n (xi x)2 falls für n→ gilt: n i 1 n i 1 σ2 2 i n( xi2 nx ) 2 , Var(β) σβ2 σ 2 2 σ2 (x x) x i 2 i nx 2 (xi x) α,β,σ sind auch noch konsistent! 2 Unter Normalverteilung gilt: σα σ x 2 xi 2 2 αα n σβ t(n 2) mit... σ , σβ ni1(xi x)2 β β t(n 2) , σα n i 1 (xi x)2 Kofidenzintervall: α σαt1α (n 2) , β σβt1α (n 2) 2 2 ...für n 30 : t-Quantile d. t(n-2)-Verteil. durch Qunatile d. N(0,1)-Verteil. ersetzen Testen H0 : β 0 bedeutet, dass Yi α i , i 1,...,n gilt, u. somit X keinen Erklärungswert für Y besitzt. Ablehnung v. H0 zugunsten v. H1 bedeutet, dass es sinnvoll ist, X in Form d. ∟ systematisch. Komponente α βx zur Erklärung v. Y einzusetzen >Teststatistiken und Ablehnungsbereiche: Tα0 α α0 β β0 bzw. Tβ0 σα σβ Tα0 t1 α (n 2) bzw. Tβ0 t1 α (n 2) 2 2 für n 30 : t Quantile der t(n 2) Verteilung durch Quantile der N(0,1) Verteilung ersetzen. ∟ >F-Wert (zur Prüfung ob: H0 : β 0 ): F R2 (n 2) , F Tβ0 2 , F F(1,n 2) 1 R2 Prognose Y0 α βx0 0 weil E(0 ) 0 Y0 α βx0 ∟ >Prognose für Konfidenzintervall von Y0 α βx0 : 1 n α βx t1 α (n 2)σ 1 (x x)2 n n x 2 nx 2 2 n x 2 nx i 1 i >Konfidenzintervall für d. “wahre“ Regressionsgerade α βx (ohne Fehler 0 ): 2 ∟ (x 0 x)2 Y 0 t1 α (n 2)σ 1 2 i 1 i Multiple Lineare Regression Def. Mehrere Variabeln (X1,…, Xn=sog. Regressoren) beeinflussen Y Zielvariable=metrisch / Regressoren=metrisch, binär, mehrkategorial Cov( μi,μ j )=0Störterme beeinflussen sich nicht keine Multikollinearität Multikollinearität Modell Fehlerterm ( μi )=unbestimmbare Abstände zu Reg.gerade in GG (Autokorrelation: Störterm sind korreliert!) Residuen ( i )=bestimmbare Abstände d. Stichprobenwerte in d. Stichprobe keine lin. Abhängigkeit zw. d. Regressoren exakter lin. Zusammenhang zw. d. Regressoren yi β0 β1xi1 ... βp xip i , E(i ) 0 , i 1,...,n ∟ Erwartungswert E(Yi ) β0 β1xi1 ... βp xip ∟ Varianz Schätzen 2 Var(Y) i σ ∟ Ziel v. KQ-Prinzip bestimme d. Schätzer β0,β1,...,βp so, dass: n i 1 (Yi βo β1xi1 ... βp xip )2 minβ0 ,β1,...,βp also d. Summe d. quadr. Abweichungen durch β0 ,β1,...,βp minimiert wird. (Voraussetzungen:1.) n p 1 / 2.) keine Multikollinearität) 2 2 1 1 n n i n p 1i1(Yi Yi )2 n p 1 i1 ∟ KQ- Schätzer σ ∟ Varianz σ j2 Var(β j ) , j 0,...,p mit den Residuen i Yi Yi und den gefitteten Werten Yi β0 β1xi1 ... βpxip ∟ Geschätzt. Standardabw. σ j Var(βj ) , j 0,...,p ∟ Streuungszerlegung n (Yi Y)2 i1(Yi Yi )2 i1(Y Y)2 n i 1 SQT ∟ Bestimmtheitsmass R2 n SQR (Yi Y)2 SQE SQE SQR 1 , wobei WB : 0 R2 1 SQT (Yi Y) SQT je näher bei 1 desto, besser wird d. Zielvariabel durch d. Regression erklärt! ∟ Verteilung d. standard. Schätzer 2 βj βj σj t(n p 1) , j 0,...,p ∟ Konfidenzintervall für β j : βj σ jt1α (n p 1) , j 0,...,p 2 Testen (a) H0 : β j β0 j , H1 : β j β0 j ∟ Hypothesen (b) H0 : β j β0 j , H1 : β j β0 j (c) H0 : β j β0 j , H1 : β j β0 j falls: H0 : β j 0 , H1 : β j 0 wenn H0 zutrifft, hat d. Regressor Xj keinen signifikanten Erklärungswert für Y u. kann aus dem Regressionssatz entfernt werden! β j β0 j (a) Tj t1 α (n p 1) 2 , j 0,...,p H0 ablehnen falls: (b) Tj t1 α (n p 1) ∟ Teststatistiken Tj ∟ Overall F-Test (c) Tj t1 α (n p 1) Frage: “Tragen X überhaupt zur Erklärung von Y bei?“ - Hypothesen : H0 : β1 β2 ... βp 0 , H1 : β j 0 für mind. ein j σj R2 n p 1 SQE n p 1 1 R2 p SQR p - Unter Ho gilt : F F(p,n p 1) - Teststatistik : F - Ho ablehnen, falls gilt : F F1 α(p,n p 1) Prognose ∟ Prognosewert Y0 β0 β1x01 ... βpx0p für Schätzfehler: Y0 Y0 gilt : E(Y0 Y0 ) 0 ∟ Varianz Var(Y0 Y 0 ) σ Y0 Var(Y0 Y 0 ) ∟ ( 1 α )-Prognoseintervall für Y0 gegeben x 0 Y0 σY0 t1α (n p 1) 2