Skript_Statistik_e

Werbung

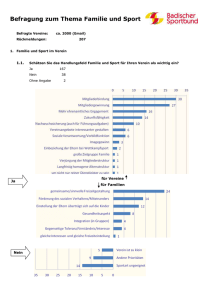

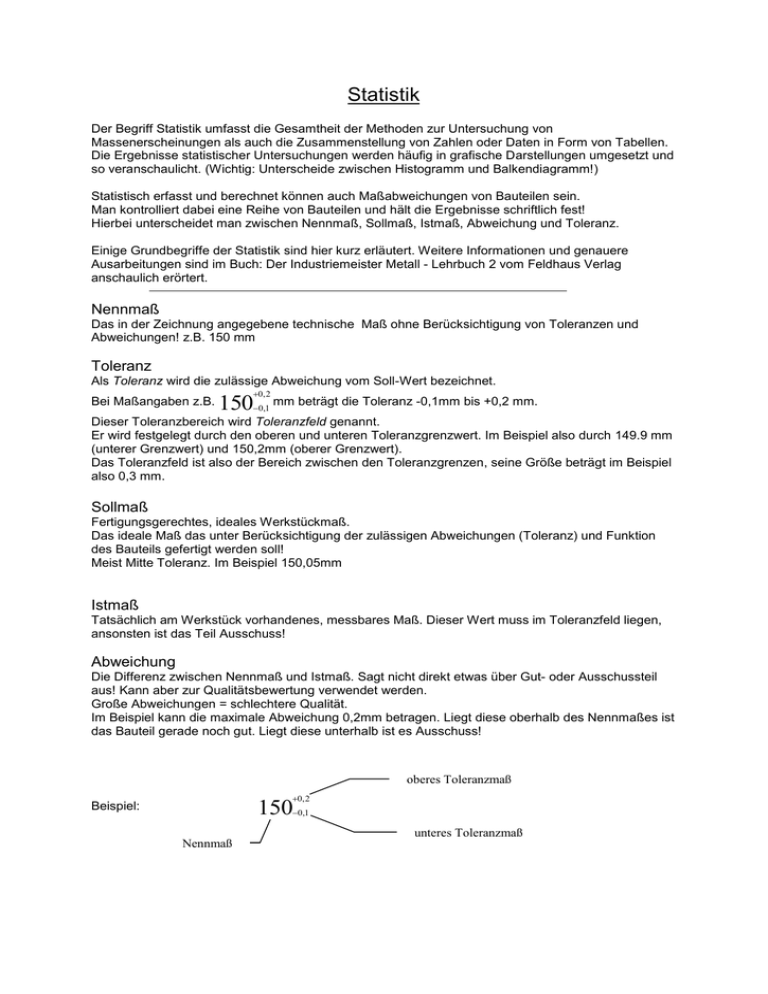

Statistik Der Begriff Statistik umfasst die Gesamtheit der Methoden zur Untersuchung von Massenerscheinungen als auch die Zusammenstellung von Zahlen oder Daten in Form von Tabellen. Die Ergebnisse statistischer Untersuchungen werden häufig in grafische Darstellungen umgesetzt und so veranschaulicht. (Wichtig: Unterscheide zwischen Histogramm und Balkendiagramm!) Statistisch erfasst und berechnet können auch Maßabweichungen von Bauteilen sein. Man kontrolliert dabei eine Reihe von Bauteilen und hält die Ergebnisse schriftlich fest! Hierbei unterscheidet man zwischen Nennmaß, Sollmaß, Istmaß, Abweichung und Toleranz. Einige Grundbegriffe der Statistik sind hier kurz erläutert. Weitere Informationen und genauere Ausarbeitungen sind im Buch: Der Industriemeister Metall - Lehrbuch 2 vom Feldhaus Verlag anschaulich erörtert. Nennmaß Das in der Zeichnung angegebene technische Maß ohne Berücksichtigung von Toleranzen und Abweichungen! z.B. 150 mm Toleranz Als Toleranz wird die zulässige Abweichung vom Soll-Wert bezeichnet. Bei Maßangaben z.B. 0, 2 150 0,1 mm beträgt die Toleranz -0,1mm bis +0,2 mm. Dieser Toleranzbereich wird Toleranzfeld genannt. Er wird festgelegt durch den oberen und unteren Toleranzgrenzwert. Im Beispiel also durch 149.9 mm (unterer Grenzwert) und 150,2mm (oberer Grenzwert). Das Toleranzfeld ist also der Bereich zwischen den Toleranzgrenzen, seine Größe beträgt im Beispiel also 0,3 mm. Sollmaß Fertigungsgerechtes, ideales Werkstückmaß. Das ideale Maß das unter Berücksichtigung der zulässigen Abweichungen (Toleranz) und Funktion des Bauteils gefertigt werden soll! Meist Mitte Toleranz. Im Beispiel 150,05mm Istmaß Tatsächlich am Werkstück vorhandenes, messbares Maß. Dieser Wert muss im Toleranzfeld liegen, ansonsten ist das Teil Ausschuss! Abweichung Die Differenz zwischen Nennmaß und Istmaß. Sagt nicht direkt etwas über Gut- oder Ausschussteil aus! Kann aber zur Qualitätsbewertung verwendet werden. Große Abweichungen = schlechtere Qualität. Im Beispiel kann die maximale Abweichung 0,2mm betragen. Liegt diese oberhalb des Nennmaßes ist das Bauteil gerade noch gut. Liegt diese unterhalb ist es Ausschuss! oberes Toleranzmaß 0, 2 150 Beispiel: 0,1 unteres Toleranzmaß Nennmaß Erstellen einer Statistik Datengewinnung Um eine Statistik erstelle zu können braucht man zuerst einmal Daten. Diese erhält man durch Befragungen, Beobachtungen und Experimente (zum Ermitteln technischer Werte). Näher betrachtet wird die Erhebung von Daten zum ermitteln technischer Werte. Alle angefertigten / gelieferten Teile nennt man Los. Die daraus zur Prüfung entnommen Teilmenge nennt man Prüflos. Die gesamte Menge der zur Verfügung stehenden Einheiten einer statischen Masse (das gesamte Prüflos) nennt man Grundgesamtheit. Werden alle diese Werte betrachtet spricht man von einer Vollerhebung. Falls nur ein Teil der Grundgesamtheit statistisch betrachtet wird, spricht man von einer Teilerhebung. Die dabei betrachtete Teilmenge heißt Stichprobe. Damit diese Aussagekräftig ist muss sie ausreichend groß sein und die Auswahl der Teile zufällig erfolgen. Diese Stichprobenbetrachtung ist die in der Praxis aus Kostengründen am häufigsten vorkommende Grundlage der Datenerhebung einer Statistik. Werden Daten zum ersten Mal gesammelt spricht man von einer Primärerhebung. Wird auf bereits vorhandenes Datenmaterial (aus einer früheren Primärerhebung) zurückgegriffen, spricht man von einer Sekundärerhebung. Stichprobenkontrollen erfolgen als Eingangskontrolle bezüglich der Eigenschaften der eingehenden Ware. Als Fertigungskontrolle bezüglich der vorab definierten Spezifikationen eines gefertigten Teils, und als Endkontrolle zum überprüfen der Eigenschaften der gefertigten Teile. Die Endkontrolle dient auch als Tauglichkeitskontrolle der vorangegangenen Fertigungskontrolle. Das Ergebnis der Stichprobenauswertung entscheidet über Annahme oder Ablehnung des gesamten Los. Maßgeblich hierfür ist die vorab festzulegende annehmbare Qualitätsgrenze (AQL). Diese besagt das ein Los angenommen wird, wenn bei der Prüfung nach Stichprobenvorschrift n-c geprüft wurde, und dabei festgestellt wurde dass die Chance, dass der Fehleranteil der Stichprobe annehmbar ist, mindestens 98% beträgt. Die Stichprobenvorschrift n-c besagt das ein bestimmtes Verhältnis des Stichprobenumfangs n zur zulässigen Fehlerzahl c nicht überschritten sein darf. Prüfvereinbarungen werden in der betrieblichen Praxis meist bezugnehmend auf DIN 2859, die Qualitätsgrenzlagen mit dazugehörigen Stichprobenumfängen und zulässigen Fehlern beinhaltet, getroffen. Datenaufbereitung Um die erfassten Daten Aufbereiten und Auswerten zu können müssen diese zuerst geordnet werden! Diese Ordnung erfolgt anhand der Merkmalsausprägungen und –werte. Ein Merkmal ist eine Eigenschaft, die das Erkennen oder Unterscheiden von Einheiten ermöglicht. Hierzu ein Beispiel: Merkmal Material Länge Gewicht Anzahl Bohrungen Bestellkategorie Merkmalsausprägungen Aluminium, Eisen, Stahl…. 325 mm, 322 mm, 320 mm, … 1,984 kg, 1,2 kg, … 1, 2, 3 …. A, B, C Quantitative Merkmale, auch Intensitätsgrößen genannt können in eine natürliche Reihenfolge Ordinalskala (Rangskala) - gebracht werden. Diese Reihenfolge sagt nichts über den Wert einer Merkmalsausbildung aus. Sind diese messbar, kontinuierlich (Temperatur, Gewicht, Länge, Lebensdauer…) so bezeichnet man sie als stetige Merkmale. Sind sie zählbar (Anzahl Bohrungen, Anzahl Messwerte im Toleranzbereich, Anzahl fehlerhafte Einheiten im Los, Anzahl Lackläufer je Fahrzeug,…) so bezeichnet man sie als diskrete Merkmale. Im Beispiel: Länge, Gewicht und Anzahl der Bohrungen. Quantitative Merkmale können stets einer Skala zugeordnet und somit in eine objektive Rangreihung gebracht werden. Ein Durchschnittswert kann berechnet werden! Besteht die Möglichkeit mit den Intensitätsmäßigen Merkmalen direkt zu rechnen wie ihre Intervalle, Differenzen, oder Quotienten miteinander verglichen werden können, so bezeichnet man diese Merkmale als kardinal skalierbare Merkmale. Die dazugehörige Skala ist eine Kardinalskala. Qualitative Merkmale sind Merkmale, deren Werte einer Skala zugeordnet sind, auf der keine Abstände definiert sind. Sie können nur nach dem Kriterium >gleich< oder >verschieden< geordnet werden. Man bezeichnet diese Skala als Nominalskala. Diese lässt keine Rangreihung zu. Entweder entspricht ein Material der geforderten Güte, oder es entspricht ihr nicht, dazwischen gibt es nichts. Besteht eine Ordnungsbeziehung so handelt es sich um Ordinalmerkmale: kalt – lauwarm – warm – heiß Schulnoten: 1 – 2 – 3 – 4 – 5 – 6, sehr gut, gut … bei Messwerten: zu klein – im Toleranzbereich – zu groß Besteht keine Ordnungsbeziehung so handelt es sich um Nominalmerkmale: Farbe von Spielfiguren: blau, rot, gelb,… Kostenstellen: 666, 777, 145 Messwert: i.O – n.i.O (Alternativmerkmal) Ein Durchschnittswert für qualitative Merkmale kann nicht berechnet werden! Klassieren Aufgrund der vielfach großen Anzahl von Merkmalsausprägungen ist es oftmals nicht oder nur unter großem Aufwand möglich alle Ausprägungen aufzuzählen. Daher werden in solchen Fällen benachbarte Merkmalsausprägungen zu möglichst gleich breiten Klassen zusammengefasst. Nachteil: Informationsverlust Vorteil: Übersichtlichkeit steigt Reihen Die erhobenen Merkmalswerte bilden eine statistische Reihe. Diese wird in den meisten Fällen ungeordnet sein. Zur weiteren Bearbeitung ist diese auf- oder absteigend zu ordnen. Eine Sonderform ist eine Reihe im zeitlichen Verlauf. Hier wird die Ordnung durch den zeitlichen Verlauf vorgenommen. Häufigkeit Meist kommen in statistischen Reihen einige Merkmalsausprägungen mehrfach vor. Man spricht dabei von Häufigkeit. Verteilung Bei umfangreichen Erhebungen lassen sich die erhobenen Daten übersichtlicher Darstellen wenn man diese Merkmalsausprägungen nur einmal notiert und um die Angabe der Häufigkeit ergänzt. Dies kann in Tabellen (Matrix) erfolgen. Datenauswertung Die Messung und Verarbeitung von Messwerten kann auf zwei Arten erfolgen: Zum einen kann der Messwert manuell erfasst und bestimmte Maßnahmen eingeleitet werden. Zum anderen kann der Wert automatisch von einem Prozessrechner erfasst und bei Überschreitung von festgelegten Grenzwerten eine Handlung und/oder Warnung ausgegeben werden. Bei gefährlichen und daher äußerster Vorsicht verlangenden Anlagen können beide Vorgehensweisen an ein und derselben Anlage parallel eingesetzt werden. Es wird zwischen Signalanalyse (Untersuchung der Verläufe von Messsignalen – Frequenzen, Schwingungen, usw.) und Messdatenverarbeitung (Aufbereiten, Verrechnen und Verknüpfen von Messergebnissen) unterschieden. Sind die vorzunehmenden Berechnungen nur allgemeiner mathematischer oder logischer Natur, bezeichnet man dies als elementare Messwertverarbeitung. Werden komplexe Operationen der höheren Mathematik benötigt bezeichnet man dies als höhere Messwertverarbeitung. Die wichtigsten Maßzahlen bei der Verarbeitung von Messwerten sind: - Mittelwerte, - Streuungsmaße, - Verhältniszahlen, - Zeitreihen, - Indexzahlen. Diese Werte werden im Folgenden in sehr einfacher Weise verdeutlicht. Hier einige Hinweise zur Schreibweise: Zur Kennzeichnungen von Maßzahlen, die aus Werten der Grundgesamtheit ermittelt wurden, werden griechische Buchstaben verwendet: Mittelwert Standartabweichung 2 Varianz Die Anzahl der Einheiten einer Grundgesamtheit wird mit N bezeichnet. Die aus einer Stichprobe berechneten statistischen Kennzahlen werden mit lateinischen Buchstaben abgekürzt: x Mittelwert s Standartabweichung s 2 Varianz Die Anzahl der Einheiten einer Stichprobe wird mit n bezeichnet. Mittelwerte Mittelwerte beschreiben eine statistische Masse durch eine einzelne charakteristische Größe. Sie ermöglichen den Vergleich verschiedener Mengen und können als Maßstab (Norm) dienen. Die wichtigsten Mittelwerte sind: - Modalwert (Modus) als häufigster Wert -Zentralwert (Median) mittlerer Wert einer geordneten Reihe. Voraussetzung ist die Ordnung der Werte anhand einer Skala. - arithmetisches Mittel setzt sich aus der Summe der Beobachtungswerte, dividiert durch die Anzahl der Beobachtungen zusammen. Dieser am häufigsten verwendete Mittelwert kann nur auf kardinal skalierbaren Merkmale angewendet werden. Da die Mittelwerte keine Aussage über die Breite in welcher sich die beobachteten Werte um den Mittelwert verteilen zulassen, sind diese nur begrenzt einsetzbar! Der rechnerische Mittelwert der Zahlen 1, 50 und 99 ist beispielsweise ebenso groß wie für die Zahlen 49, 50 und 51, nämlich 50! Um eine statistische Masse hinreichend zu charakterisieren sind folglich Angaben nötig, welche diese Streubreite berücksichtigen. Die Streuungsmaße! Streuungsmaße Als Streuungsmaße bezeichnet man: - die Spannweite w: Die Differenz zwischen dem kleinsten und dem größten Wert. Im Beispiel: 1, 50, 99 w = 99-1 = 98 49,50,51 w = 51-49 = 2 Für die erste Reihe ergibt sich ein absolut größter Fehler von 49, für die zweite Reihe von 1! Durch die gleichzeitige Angabe von Mittelwert und Spannweite sind die Reihen charakterisiert und deutlich unterscheidbar! - mittlere absolute Abweichung d (häufig: MAD): Das rechnerische Mittel der absoluten Abstände der einzelnen Werte vom Mittelwert. Aus den einzelnen Abständen wird ein Mittelwert errechnet: Man zieht von jedem Einzelwert den Mittelwert ab und teilt das Ergebnis durch die Anzahl der Werte. Beispiel: Es wurden folgende 10 Werte ermittelt: 403, 404, 407, 410, 410, 412, 413, 413, 415 d= (403 410) (404 410) (407 410) (410 410) (410 410) (412 410) (413 410) (413 410) (413 410) (415 410) 10 Da mit Abständen gerechnet werden und diese nicht negativ sein können erhält man: d= 7 63 0 0 23335 = 3,2 10 - Varianz ( bei Grundgesamtheit oder s bei Stichprobe): Sie ist die mittlere quadratische Abweichung der Reihenwerte vom arithmetischen (rechnerischen) Mittelwert. Durch die Verwendung quadratischer Abweichungen werden größere Abstände vom Mittelwert (in diesem Fall das arithmetische Mittel) stärker berücksichtigt, als dies bei der mittleren absoluten Abweichung der Fall ist! 2 2 siehe Beispiel von vorher (mittlere absolute Abweichung): 2= 7 2 6 2 32 0 2 0 2 2 2 32 32 32 52 150 = =15 10 10 - Standardabweichung ( bei Grundgesamtheit oder s bei Stichprobe): Sie ist das gebräuchlichste Streuungsmaß, um die Streuung von Einzelwerten einer Grundgesamtheit oder von Stichprobenwerten um den Mittelwert auszudrücken! Sie wird aus der Varianz errechnet. 2 im Beispiel also: 15 3,873 Handelt es sich bei den auszuwertenden Messzahlen um Stichprobenwerte, erfolgt die Berechnung der so genannten empirischen (n-1)-Standartabweichung nach der Formel: sx 1 n ( ( x1 x) 2 ) n 1 i 1 wobei: n = Anzahl der Einzelwerte der Stichprobe, ( n 1) ist der Freiheitsgrad, auf den hier nicht eingegangen wird! im Beispiel also: s 1 150 16,667 4,082 10 1 s ist größer als . Obwohl beiden dieselben Werte zugrunde liegen. Merke: Einmal wurde die Grundgesamtheit betrachtet (Standartabweichung ) und einmal wurden die Werte als Stichprobenwerte aus einer Grundgesamtheit betrachtet (Standartabweichung s ). Bei der Stichprobe wurde mit Freiheitswert ( n 1 ) gerechnet. Damit wurde die Unsicherheit der Stichprobe gegenüber den vollständigen Werten der Grundgesamtheit berücksichtigt! Anwendung Statistische Methoden werden hauptsächlich zum Verfolgen von Entwicklungen –Trendanalyse- und darauf basierend für die Zukunft vorausberechnend –Prognose- zum Einsatz. Es können wesentliche Kennzahlen aufbereitet und tabellarisch oder grafisch aufbereitet werden. Im Fertigungsbereich kommt das Stichprobenverfahren am häufigsten vor. Dabei werden aus einer Grundgesamtheit einige Teile -Prüflos- entnommen und überprüft. Die erhaltenen Prüfwerte liegen im Regelfall eng um den Mittelwert. Die am häufigsten anzutreffende Verteilung ist die: Gauß’sche Normalverteilung Wenn eine Stichprobe der Normalverteilung entspricht ergibt sich eine so genannte Glockenkurve. Ist dies der Fall kann daraus für die Grundgesamtheit gefolgert werden, dass 68,26% zwischen den Wendepunkten der Verteilungskurve in einer Verteilung von +/- 1s um den Mittelwert zu finden sind. Bei +/- 2s sind es 95,44 % und bei +/- 3s 99,73%. Bei +/- 4s erhöht sich der Wert auf 99,994%. Falls bei im Zeitverlauf verschiedentlich vorgenommenen Stichproben eine Abweichung in der Verteilung festgestellt wird, liegt die Vermutung nahe, dass systematische und damit beeinflussbare Größen wirksam sind. Man spricht von einem Prozess der außer statistischer Kontrolle ist. Um diese Prozesse unter statistische Kontrolle zu bringen, werden diese in einen kontinuierlichen Regelkreis aus Datensammlung, -aufbereitung, -auswertung und ggf. Eingriffen mit Hilfe von Prozessregelkarten gebracht. Zeigt die Auswertung das sich der Prozess unter statistischer Kontrolle befindet, kann eine Aussage über die so genannte Prozessfähigkeit getroffen werden. Statistische Prozessregelung (SPR) Bei der statistischen Prozessregelung wird ein Prozess unter statistische Kontrolle gebracht bzw. befindet sich unter solcher. Alle anhand von statistischen Verfahren (Stichprobenauswertung) festgestellten systematischen Abweichungen sind identifiziert und abgestellt. Alle noch zu beobachtenden Streuungen beruhen auf Zufallseinflüssen. Ist die zu beobachtende Streuung für den Herstellungsprozess immer noch zu groß, so ist der Prozess ganz oder teilweise ungeeignet und muss neu überarbeitet oder verworfen werden! Statistische Prozessregelung ist eine zukunftsorientierte Fehlervermeidung. Es werden alle beteiligten Elemente einbezogen: Personal, Sachmittel, Methode, Umwelt und Material. Systematische Fehler werden frühzeitig erkannt und ihre Ursachen schnellstmöglich beseitigt. Dies führt zu einer raschen Ausschussreduzierung und Qualitätssteigerung. Voraussetzung für den Einsatz von SPR ist die Messbarkeit von Prozessen und Produkteigenschaften mindestens im Sinne einer Attributprüfung, bei der eine gut-schlecht Prüfung und eine Unterscheidung zwischen annehmbaren und nicht annehmbaren Stücken angegeben werden kann. Maschinen- und Prozessfähigkeitsuntersuchung (MPU) Fähigkeit: Das Maß der tatsächlichen Güte einer Maschine oder eines Prozesses, bezogen auf die Spezifikation. (Ist die Maschine/Anlage fähig mindestens 99.76% aller Teile innerhalb der Grenzwerte zu fertigen) Maschinenfähigkeit Es handelt sich um Kurzzeitanalyse bei der die Leistungsfähigkeit einer Maschine oder Anlage geprüft wird. Ein Prüflos sollte n 50 Teile umfassen. Dabei sollen alle äußeren Störeinflüsse wie unterschiedliche Materialchargen, Temperatur- und Stromschwankungen usw. ausgeschlossen sein, um das tatsächliche Verhalten der Maschine zu erfassen. Sie sagt aus ob eine Maschine geeignet zur Fertigung bestimmter Teile geeignet ist. Dies ist der Fall wenn mindestens 3s also 6s , d.h. 99,73% (Gauß’sche Normalverteilung) der gefertigten Teile innerhalb der Spezifikationsgrenzen liegen. Die Kennzahl mit der dies ausgedrückt wird ist der Maschinenfähigkeitskennwert: cm undcmk OTG UTG 6s Dieser Wert soll gemäß einer Empfehlung der DGQ (Deutsche Gesellschaft für Qualität) In Unternehmen werden unterschiedliche Werte verwendet! VDA Empfehlung: 1.33 sein. cm 1,66 Für die Prüfung der Maschinenfähigkeit ist es wichtig das alle verwendeten Teile und Materialien bis zu dem zu untersuchenden Bearbeitungsschritt der Spezifikation entsprechen. Sonst werden möglicherweise im Vorfeld liegende Fehler der Maschine zugerechnet! Prozessfähigkeit Bei der Prozessfähigkeitsuntersuchung werden bzw. sollen alle Einflussgrößen berücksichtigt werden. Also auch Chargenschwankungen, Temperaturunterschiede …. Da manche Schwankungen nur über einen größeren Zeitraum verteilt auftreten, handelt es sich folglich um eine Langzeitanalyse (über mehrere Wochen). Dabei werden regelmäßig Stichproben entnommen und ausgewertet. Ein Prüflos soll n 5 Teile sein, es sollen m 25 Stichproben genommen werden. Die Anzahl der Beobachtungen soll n m 100 sein. Die Prozessfähigkeit sagt aus ob eine Maschine oder eine Anlage fähig ist, unter Einbeziehung aller Umgebungsfaktoren 99,73 % aller Teile innerhalb der Spezifikationsgrenzen zu fertigen. Die Kennzahl mit der dies ausgedrückt wird ist der Prozessfähigkeitskennwert: cp OTG UTG 6ˆ c pk krit 3ˆ Dieser Wert soll gemäß einer Empfehlung der DGQ (Deutsche Gesellschaft für Qualität) 1.33 sein. Prüfmittel Bisher wurde immer nur auf die Feststellung von Abweichungen an Bauteilen eingegangen. Um diese feststellen zu können braucht der Prüfende geeignete Prüfmittel. Geeignete Prüfmittel sind solche die in einwandfreiem und fehlerlosem Zustand sind. Der Prüfende ist daher anzuhalten nur mit solchen Mitteln zu prüfen! Stellt er einen Fehler oder ein nicht mehr geeignetes Prüfmittel fest, so muss er dieses sofort wechseln! Wichtig ist das dem Prüfenden durch die Meldung des Fehlers oder Schadens selbst bei Selbstverschulden keine Nachteile entstehen! Alle Prüfmittel sind vor der ersten Verwendung und in regelmäßigen Abständen durch unabhängige Stellen im oder außerhalb des Betriebs zu prüfen! Bei Verdacht einer Abweichung ist eine sofortige Prüfung zu veranlassen! Messmittelfähigkeit Bei Messmitteln lassen sich ebenfalls Fähigkeitszahlen ermitteln, indem an kalibrierten Normalen (z.B. Endmaßen) Wiederholungsmessungen ( 50 ) durchgeführt werden und ausgewertet werden. x und s ergeben sich aus den Normalverteilten Messwerten. Die Toleranzgrenze ermittelt man häufig als Bruchteil (z.B. 20%) des kleinsten zu messenden Toleranzbereichs. Es werden häufig Messmittelfähigkeitswerte gefordert: c g = c gk 1,33 Fehlermöglichkeits- und Fehlereinflussanalyse (FMEA) Die verschiedenen Fehler müssen gesammelt und auf Fehlersammelkarten eingetragen werden. Die Fehlersammelkarten können als einfache Strichlisten geführt werden. Im nächsten Schritt müssen ihre Ursachen untersucht und dokumentiert werden. Größte Schwierigkeit ist hierbei meist die Differenzierung zwischen Fehlerquelle, Fehler, Folgefehler und das Auffinden der eigentlichen Ursache. Erfahrungswerte und ein systematisches Vorgehen sind dringend geboten! Häufig angewendete Werkzeuge zur Analysierung von Ursachen für Ergebnisabweichungen ist das Ursachen Wirkungsdiagramm (Fischgräte) nach Ishikawa sowie die PARETO-Analyse (Säulendiagramm in das die prozentuale Häufigkeit der einzelnen Fehler eingetragen wird.) Eine weitere Möglichkeit besteht in der Fehlerbaumanalyse. Eine moderne Qualitätssicherung basiert aber auf Fehlervermeidung und nicht auf Fehlerauswertung! Ein Verfahren der vorbeugenden Qualitätssicherung ist die FMEA (Filure Modes and Effects Analyses). Diese setzt bereits im Vorfeld der Produktentwicklung ein. Das nur auf dem Reißbrett fertige Produkt wird systematisch von oben nach unten in einzelne Bauteile und Funktionen zerlegt. Diese werden auf Einhaltung der konstruktiven und ganzheitlichen Forderungen untersucht. Mögliche Fehler und ihre Ursachen werden festgehalten. Anschließend werden im Rahmen einer Risikobewertung die Auswirkung, die Wahrscheinlichkeit des Auftretens und die Schwierigkeit der Fehlerentdeckung je Fehler durch Faktoren bewertet. Die daraus resultierende Risikoprioritätszahl (RPZ) ermöglicht eine rasche Identifizierung größerer Fehlerquellen, auf die sich das weitere Vorgehen konzentrieren kann. Im Rahmen der Risikominimierung werden geeignete Maßnahmen zur Vermeidung und Aufdeckung des Fehlers erstellt und unter der Annahme das diese zur Anwendung kommen eine neue Analyse erstellt. Qualitätsregelkarten Qualitätsregelkarten sind Formblätter, die die in Stichproben gewonnenen Prüfergebnisse in zeitlicher Folge grafisch abbilden. Anhand der eingetragenen Werte kann frühzeitig ein Abweichen der Werte von der Normalverteilung erkannt werden. Sobald sich die Werte in Richtung eines Grenzwertes zu verschieben beginnen, sind korrigierende Maßnahmen zu veranlassen. Da bei der Auslegung von Qualitätsregelkarten die Gesetzmäßigkeiten der Statistik beachtet werden müssen, spricht man auch von statistischer Prozessregelung (SPC = Statistical Prozess Control).