Effiziente Algorithmen und Datenstrukturen II

Werbung

Effiziente Algorithmen und Datenstrukturen II

Sven Kosub

getippt von Martin von Gagern

Sommersemester 2005

2

Organisatorisches

Zu dieser Mitschrift

Ich kann keinerlei Garantie geben, dass diese Mitschrift korrekt ist, geschweige denn vollständig.

Ich behalte mir vor, irgendwann während dem Semester die Lust am Mitschreiben zu verlieren.

Wer einen Fehler irgendeiner Art findet, darf mir diesen gerne mitteilen, ich werde ihn dann

vermutlich korrigieren.

Martin von Gagern

Literatur

• M.T. Goodrich, R. Tamassia:

Algorithm Design: Foundations, Analysis and Internet Examples, 2002

• T.H. Cormen, C.E. Leiserson, R.L. Rivest, C. Stein:

Introduction to Algorithms, 2001

• K. Schöning:

Algorithmik, 2001

Webseite: http://www14.in.tum.de/Lehre/2005SS/ea

Inhaltsverzeichnis

1 Graphenalgorithmen

1.1

1.2

1.3

1.4

7

Datenstrukturen für Graphen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7

1.1.1

Kantenlisten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7

1.1.2

Adjazenzlisten . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

1.1.3

Adjazenzmatrizen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

Graphentraversierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

1.2.1

Tiefensuche (depth-first search) . . . . . . . . . . . . . . . . . . . . . . . .

10

1.2.2

Breitensuche (breadth-first search) . . . . . . . . . . . . . . . . . . . . . .

11

Erreichbarkeitsprobleme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13

1.3.1

Zweifach zusammenhängender Teilgraph . . . . . . . . . . . . . . . . . . .

13

1.3.2

Starker Zusammenhang . . . . . . . . . . . . . . . . . . . . . . . . . . . .

18

1.3.3

Transitive Hülle

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

20

Minimale Spannbäume . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

21

1.4.1

Kruskal-Algorithmus (1956) . . . . . . . . . . . . . . . . . . . . . . . . . .

22

1.4.2

Prim-Jarnik-Algorithmus (1957 Prim, 1930 Jarnik) . . . . . . . . . . . . .

24

1.4.3

Algorithmus von Boruvka (Boruvka, 1926) . . . . . . . . . . . . . . . . . .

26

1.4.4

Algorithmus von Chazelle (Chazelle, 2000) . . . . . . . . . . . . . . . . .

28

2 Algorithmen für Flüsse und Matchings

41

2.1

Flüsse und Schnitte . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

41

2.2

Maximaler Fluss . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

43

2.2.1

46

Algorithmus von Ford und Fulkerson . . . . . . . . . . . . . . . . . . . . .

3

4

INHALTSVERZEICHNIS

2.2.2

Algorithmus von Edmonds und Karp . . . . . . . . . . . . . . . . . . . . .

48

2.3

Maximale Matchings . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

49

2.4

Flüsse mit minimalen Kosten . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

51

3 Lineare Programmierung

3.1

3.2

59

Standardformulierungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

59

3.1.1

Beispiele für LP-Modellierungen . . . . . . . . . . . . . . . . . . . . . . .

63

Simplex-Algorithmus . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

64

3.2.1

Grundlagen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

64

3.2.2

Formaler Simplex-Algorithmus . . . . . . . . . . . . . . . . . . . . . . . .

67

3.2.3

Terminierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

69

3.2.4

Optimalität und Dualität . . . . . . . . . . . . . . . . . . . . . . . . . . .

71

3.2.5

Initialisierung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

75

INHALTSVERZEICHNIS

5

Algorithmen

1

DFS . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

10

2

BFS . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

12

3

EquiClasses . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

17

4

StrongConnectivityTest . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

19

5

Floyd-Warshall . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

20

6

Kruskal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

22

7

Prim-Jarnik . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

24

8

Prim-Jarnik-2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

25

9

Boruvka . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

27

10

Minoren-Hierarchie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

34

11

Chazelle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

36

12

Ford-Fulkerson . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

46

13

MinCostFlow . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

57

14

Pivot . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

67

15

Simplex . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

69

16

InitializeSimplex . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

76

6

INHALTSVERZEICHNIS

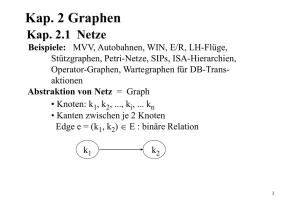

Kapitel 1

Graphenalgorithmen

1.1

Datenstrukturen für Graphen

Implementierung von Graphen

Konvention: n:

m:

1.1.1

Anzahl der Knoten

Anzahl der Kanten

Kantenlisten

• Knotenobjekt für Knoten v ∈ V und Objekt o:

1. Zeiger auf o

2. Zähler für deg(v) bzw. indeg(v) und outdeg(v)

• Kantenobjekt für Kante e ∈ E und Objekt o:

1. Zeiger auf o

2. Markierung für gerichtet“ oder ungerichtet“

”

”

3. Zeiger auf die beteiligten Knoten

Beispiel: A •

5

•B

0

−2

3

4

C

•

−1

•

D

V und E sind jeweils doppelt verkettete Listen; Zeiger weggelassen.

7

8

KAPITEL 1. GRAPHENALGORITHMEN

Komplexitäten von Operationen auf Kantenlisten:

• Bestimmung Knotenanzahl und Kantenanzahl in O(1)

• Bestimmung Knotengrade in O(1)

• Einfügen von Knoten in O(1)

• Einfügen / Löschen von Kanten in O(1)

• Bestimmung inzidenter Kanten an einem Knoten usw. in O(m)

• Adjazenztest in O(m)

• Löschen von Knoten (mit allen inzidenter Kanten) in O(m)

1.1.2

Adjazenzlisten

Erweiterung von Kantenlisten durch Zeiger auf inzidente Kanten

• Knotenobjekt für Knoten v ∈ V und Objekt o:

1. Zeiger auf o

2. Zeiger auf Listen für eingehende und ausgehende Kanten

• Kantenobjekt für Kante e ∈ E und Objekt o:

1. Zeiger auf o

2. Markierung für gerichtet“ oder ungerichtet“

”

”

3. Zeiger auf die beteiligten Knoten

4. Zeiger auf die Position in den Kantenlisten der Knoten

Komplexitäten von Operationen auf Adjazenzlisten

• Bestimmung Knotenanzahl und Kantenanzahl in O(1)

• Bestimmung Knotengrade in O(1)

• Einfügen von Knoten in O(1)

• Einfügen / Löschen von Kanten in O(1)

• Bestimmung inzidenter Kanten an einem Knoten usw. in O(deg(v))

• Adjazenztest in O(min{deg(v), deg(u)})

• Löschen von Knoten (mit allen inzidenter Kanten) in O(deg(v))

1.2. GRAPHENTRAVERSIERUNG

1.1.3

9

Adjazenzmatrizen

Adjazenzmatrix A(G) für Graphen G = (V, E) mit V = {0, . . . , n − 1} ist eine n × n-Matrix mit

(

1 wenn (i, j) ∈ E

aij =

0 wenn (i, j) 6∈ E

Datenstruktur bestehend aus

• Knotenobjekt für Knoten v und Objekt o:

1. Zeiger auf o

2. Index von v; d.h. seine Nummer in V

3. Zähler für Knotengrad deg(v) bzw. indeg(v) und outdeg(v)

• Kantenobjekte wie bei Kantenlisten

• Matrixobjekt als n × n-Array A mit A[i, j] enthält Zeiger auf Kante e = (i, j) (für ungerichtete Graphen: A[i, j] = A[j, i]), sonst Nil

Komplexitäten von Operationen auf Adjazenzmatrizen

• Bestimmung Knotenanzahl und Kantenanzahl in O(1)

• Bestimmung Knotengrade in O(1)

• Einfügen von Knoten in O(n) amortisiert

• Einfügen / Löschen von Kanten in O(1)

• Löschen von Knoten in O(n) amortisiert

• Bestimmung inzidenter Kanten an einem Knoten usw. in O(deg(v))

• Adjazenztest in O(min{deg(v), deg(u)})

• Löschen von Knoten (mit allen inzidenter Kanten) in O(deg(v))

Problem: Für n Knoten stets O(n2 ) Speicherplatz inabhängig von Anzahl tatsächlich vorhandener Kanten

⇒ nur für dichte Graphen sinnvoll

1.2

Graphentraversierung

Traversierung = systemaitisches Ablaufen aller Knoten eines Graphen

10

KAPITEL 1. GRAPHENALGORITHMEN

1.2.1

Tiefensuche (depth-first search)

Tiefensuche produziert zwei Arten von Kanten:

1. Baumkanten

2. Rückwärtskanten

Algorithmus DFS(G, v)

Eingabe: (ungerichteter) Graph G, Knoten v in G

Ausgabe: Markierung der Kanten (in der Zusammenhangskomponente) von v als Baumkante“

”

oder Rückwärtskante“

”

1

2

3

4

5

6

7

8

9

10

11

markiere Knoten v als besucht“

”

for jede Kante e = {u, v}

do

if e nicht markiert

then

Markiere e als Baumkante“

”

DFS(G, u)

else

Markiere e als Rückwärtskante“

”

fi

od

Algorithmus 1: DFS

= Baumkanten

= Rückwärtskanten

A

A

A

B

C

B

A

E

B

C

D

I

D

G

E

H

F

I

E

D

F

H

C

G

B

D

E

F

G

H

G

H

I

I

F

C

Beachte: Die Reihenfolge der Knoteninspektion ist wichtig für die Höhe des DFS-Baumes.

1.2. GRAPHENTRAVERSIERUNG

11

Bemerkungen:

1. Höhe des DFS-Baumes entspricht Platzbedarf der Traversierung (bei Realisierung mit

Stacks)

2. Folgendes Problem ist NP-vollständig (Hamilton-Pfad):

Eingabe: G, k

Frage: Gibt es einen DFS-Baum T für G mit h(T ) ≥ k?

3. Dies gilt auch für die Frage: Gibt es einen DFS-Baum T für G mit h(T ) ≤ k?

Eigenschaften der Tiefensuche (beginnend bei s ∈ V )

1. Tiefensuche besucht alle Knoten der Zusammenhangskomponente von s

2. Baumkanten bilden Spannbaum der Zusammenhangskomponente von s

3. Tiefensuche benötigt O(ms ) Schritte zur Traversierung der Zusammenhangskomponente

von s

Folgende Probleme können mit Tiefensuche in Zeit O(m + n) gelöst werden.

1. Test, ob G zusammenhängend ist

2. Berechnung eines Spannwaldes von G

3. Berechnung aller Zusammenhangskomponenten von G

4. Berechnung eines Pfades zwischen Knoten von G

5. Berechnung eines Kreises in G

1.2.2

Breitensuche (breadth-first search)

Breitensuche produziert zwei Arten von Kanten:

1. Baumkanten

2. Querkanten

12

KAPITEL 1. GRAPHENALGORITHMEN

Algorithmus BFS(G, v)

Eingabe: Graph G, Knoten v in G

Ausgabe: Markierung der Kanten in Zusammenhangskomponente von v als Baumkanten“ oder

”

Querkanten“

”

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

Initialisiere Queue Q

Enqueue(Q, v)

Markiere v als besucht“

”

while Q nicht leer

do

w := Dequeue(Q)

for jede Kante e = {w, u}

do

if e nicht markiert

then

Markiere e als Baumkante“

”

Markiere u als besucht“

”

Enqueue(Q, u)

else

Markiere e als Querkante“

”

fi

od

od

Algorithmus 2: BFS

= Baumkanten

= Querkanten

A1

B4

C7

D2

E3

F9

G5

H8

I6

A

D

E

B

G

I

C

H

F

Eigenschaften der Breitensuche (beginnend bei s ∈ V )

1. Breitensuche besucht alle Knoten in der Zusammenhangskomponente von s

2. Baumkanten bilden Spannbaum in der Zusammenhangskomponente von s

3. Für alle Knoten v der Tiefe i hat Pfad in T von s nach v genau i Kanten und jeder andere

Pfad in G von s nach v mindestens i Kanten.

4. Ist {u, v} Querkante, so unterscheiden sich Tiefen in T um höchstens 1.

5. Breitensuche benötigt O(ms ) Schritte zur Traversierung.

1.3. ERREICHBARKEITSPROBLEME

13

Folgende Probleme können mit Breitensuche in Zeit O(n + m) gelöst werden:

1. Test, ob G zusammenhängend ist

2. Berechnung eines Spannwaldes von G

3. Berechnung aller Zusammenhangskomponenten von G

4. Gegeben Knoten s ∈ V berechne für alle Knoten v ∈ V einen Pfad mit geringster Anzahl

von Kanten

5. Berechnung eines Kreises in G

1.3

Erreichbarkeitsprobleme

1.3.1

Zweifach zusammenhängender Teilgraph

Es sein G ein zusammenhängender ungerichteter Graph.

Ein Artikulationsknoten ◦ ist ein Knoten, nach dessen Entfernung aus G der Graph nicht

mehr zusammenhängend ist.

Eine Brücke (Trennkante)

nicht mehr zusammenhängend ist.

•

•

•

◦

•

•

◦

•

•

ist eine Kante, nach deren Entfernung aus G der Graph

◦

•

Motivation: Artikulationsknoten und Brücken sind kritische Elemente für z.B. Ausfallsicherheit

un Kommunikationsnetzen.

Ein zusammenhängender Graph G ist zweifach zusammenhängend gdw. für alle Knoten u, v

von G gibt es zwei (Knoten-)disjunkte Pfade u und v

Eine zweifach zusammenhängende Komponente von G ist ein Teilgraph G′ , der eine der

folgenden Eigenschaften erfüllt:

1. G′ ist zweifach zusammenhängend und Hinzufügen beliebiger Knoten und Kanten aus G

zu G′ würde zweifach-Zusammenhang zerstören.

2. G′ besteht nur aus einer Brücke in G

Lemma 1:

Es sei G ein zusammenhängender Graph. Dann sind folgende Aussagen äquivalent:

1. G ist zweifach zusammenhängend.

2. Jeweils zwei Knoten von G liegen auf einem Kreis in G.

14

KAPITEL 1. GRAPHENALGORITHMEN

3. G besitzt keine Brücken oder Artikulationsknoten.

Beweis: klar.

Beispiel: Abbildung 1.1 auf Seite 16

Idee:

• Bestimme alle Artikulationsknoten (in O(n2 + nm))

• Bestimme alle Zusammenhangskomponenten in Graph ohne Artikulationsknoten (in O(n+

m))

• Ergänze Knoten zu Komponente geeignet (in O(m2 ))

=⇒ Damit insgesamt O((n + m)2 )

Ziel: Algorithmus, der Zweizusammenhang in O(n + m) bestimmt

Definiere Relation ≡ auf Kantenmenge E von G:

e ≡ f ⇔def e = f oder es gibt einen einfachen Kreis in G (d.h. Kreis ohne doppelte

Knoten), der e und f enthält.

Lemma 2:

Es sei G = (V, E) ein zusammenhängender Graph.

1. Relation ≡ ist eine Äquivalenzrelation auf E

2. Zweizusammenhangskompnenten sind genau die Teilgraphen, die durch Äquivalenzklassen

bzgl. ≡ induziert werden.

3. Kante e ∈ E ist eine Brücke gdw. {e} ist Äquivalenzklasse bzgl. ≡

4. Knoten v ∈ V ist Artikulationsknoten gdw. es gibt zwei Kanten aus unterschiedlichen

Äquivalenzklassen bzgl. ≡, die inzident an v sind.

Beweis: Mit Hilfe von Lemma 1 folgen die Aussagen 2.–4. aus Aussage 1.

Zu 1.

Reflexivität (e ≡ e): aus Definition klar

Symmetrie (e ≡ f ⇒ f ≡ e): klar, da Graph ungerichtet ist.

Transitivität ((e ≡ f ∧ f ≡ g) ⇒ e ≡ g): Es gelte e ≡ f und f ≡ g. Unterscheide drei Fälle:

1. e = g, dann ist die rechte Seite der Implikation wahr, also stimmt die Implikation.

2. e 6= g ∧ (e = f ∨ f = g), dann gibt es einfachen Kreis, der e und g enthält.

3. Es seien nun e, f, g paarweise verschieden. Damit gibt es einfachen Kreis Cef mit e

und f sowie einfachen Kreis Cf g mit f und g. Betrachte Graph Cef ∪ Cf g . Dieser

Graph enthält Kreis mit e und g, der aber im Allgemeinen nicht einfach ist.

1.3. ERREICHBARKEITSPROBLEME

15

zu zeigen: Es gibt stets einen einfachen Kreis Ceg mit e und g.

Es seien pef , qef jeweils die Halbkreise in Cef ; analog seien pgf , qgf definiert.

Für Pfad p = (v0 , v1 , . . . , vk ) sei der Abstand zu Knotenmenge C definiert als

d(p, C) =def min({j|vj ∈ C} ∪ {∞})

Betrachten nun Abstände d(pef , pgf ), d(pef , qgf ), d(qef , pgf ), d(qef , qgf ).

O.B.d.A. sei d(pef , pgf ) minimal; sei vpp der Berührungspunkt. Sei vqq der Berührungspunkt von qef , qgf . Dann ist der Kreis Ceg bestehend aus:

e, pef bis vpp , pgf bis vpp , g, qgf bis vqq , qef bis vqq

einfach und enthält e und g. Damit e ≡ g

Lemma 2 gibt uns einen Ansatz für die Berechnung der Zweizusammenhangskompnenten. Benötigen dazu folgenden Hilfsgraphen H basierend auf einer Tiefensuche in G:

1. V (H) =def E(G), d.h. die Knoten von H sind gerade die Kanten von G.

2. Ist e eine Rückwärtskante von G und sind f1 , . . . , fk die Bauimkanten von G, die zusammen

mit e einen Kreis in G bilden, so gilt: {e, f1 }, . . . , {e, fk } ∈ E(H)

Beachte: Da G genau m − n + 1 Rückwärtskanten besitzt, gilt kE(H)k = O(n · m)

Beispiel: Abbildungen 1.2 bis 1.3 auf der nächsten Seite

Nach Konstruktion von H(G): Die durch Zusammenhangskomponenten von H(G) induzierten

Teilgraphen von G entsprechen genau den Zweizusammenhangskomponenten von G.

Damit ergibt sich folgender Algorithmus für Äquivalenzklassenbestimmung:

1. Traversiere G mittels DFS

2. Berechne H(G) auf Basis der DFS

3. Berechne Zusammenhangskomponenten von H(G), z.B. mittels DFS

4. Gebe für jede Zusammenhangskomponente von H(G) die beteiligten Knoten (d.h. die Kanten von G) aus

Aber: Konstruktion von H(G) benötigt O(n · m) Schritte!

Idee: Berechne lediglich Spannwald von H(G)!

16

KAPITEL 1. GRAPHENALGORITHMEN

•

•

•

•

•

•

•

◦

◦

•

•

◦

•

•

◦

•

•

•

•

•

•

Abbildung 1.1: Zweizusammenhangskomponenten im Graphen G

K1

A19

B18

C16

D15

E14

F20

G17

H7

I8

J13

L2

M21

N6

O9

P12

Q3

R4

S5

T10

U11

Abbildung 1.2: DFS im Graphen G

KL

LQ

HI

QR

IO

TU

RS

OJ

UP

CH

SN

ML

JE

EI

NH

MQ

ED

DH

HG

MR

DC

GM

MN

OT

GB

AG

BA

AF

Kanten, die der Algorithmus EquiClasses nicht ermittelt.

Abbildung 1.3: Hilfsgraph H

PO

FG

1.3. ERREICHBARKEITSPROBLEME

17

Algorithmus EquiClasses(G)

Eingabe: zusammenhängender Graph G

Ausgabe: Zusammenhangskomponenten von H(G)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

H sei leerer Graph

DFS-Traversierung von G beginnend bei beliebigem Knoten s

Füge jede Baumkante f als Knoten in H ein und markiere f als isoliert“

”

for jedes v ∈ V (G) in DFS-Reihenfolge do

for Rückwärtskante e = (u, v) do

Füge e als Knoten in H ein

while u 6= v do

sei f = (Parent(u), u), wobei Elternknoten in DFS-Baum gemeint ist

Füge {e, f } als Kante in H ein

if f isoliert“

”

then Markiere f als verbunden“

”

u :=Parent(u)

else u := v

fi

od

od

od

Bestimme Zusammenhangskomponenten von H

Algorithmus 3: EquiClasses

Komplexität von EquiClass:

O(n + m) für DFS auf G

+ O(m)

für Einfügen aller Baumkanten

+ O(m)

für Spammwaldberechnung (beachte: kV (H)k = m)

+ O(m)

für Berechnung von Zusammenhangskomponenten in H

⇒ O(n + m) Schritte zur Berechnung von Zweizusammenhangskomonenten

von G, Artikulationsknoten und Brücken

Zeile 2

Zeile 3

Zeilen 4-17

Zeile 18

Bemerkung: Zweifacher Zusammenhang läßt sich verallgemeinern: Es sei G(V, E) ein ungerichteter Graph, s, t ∈ V, s 6= t.

λG (s, t) =def

λ(G) =def

κG (s, t) =def

κ(G) =def

minimale Anzahl von Kanten, die aus G

entfernt werden müssen, damit zwischen s

und t kein Pfad mehr existiert.

mins,t∈V,s6=t,{s,t}6∈E λG (s, t)

minimale Anzahl von Knoten, die aus G

entfernt werden müssen, damit zwischen s

und t kein Pfad mehr existiert.

mins,t∈V,s6=t,{s,t}6∈E κG (s, t)

(lokaler Kantenzusammenhang)

(globaler Kantenzusammenhang)

(lokaler Knotenzusammenhang)

(globaler Knotenzusammenhang)

18

KAPITEL 1. GRAPHENALGORITHMEN

Es gilt:

1. κ(G) ≤ λ(G) ≤ δ(G), wobei δ(G) der minimale Grad des Graphen ist.

2. Sind s, t ∈ V nicht benachbart, dann gilt λG (s, t) =maximale Anzahl Knoten-disjunkter

Pfade zwischen s und t (Satz von Menger)

3. Methode zur Bestimmung von λG (st, t) und λG in Kapitel 3 auf Seite 59.

1.3.2

Starker Zusammenhang

Betrachte nun Erreichbarkeit in gerichteten Graphen. Wir sagen: Knoten u erreicht Knoten v

~ falls es einen (gerichteten) Pfad von u nach v gibt.

in G,

~ heißt stark zusammenhängend, falls für alle Knotenpaare u, v ∈ V

Ein gerichteter Graph G

mit u 6= v gilt: u erreicht v und v erreicht u.

Beispiel:

A

C

B

D

F

E

G

~ nicht stark zusammenhängend

• G

• Teilgraph mit {A, B, C, D, F } stark zusammenhängend

Interessieren uns für folgende algorithmischen Probleme:

1. Gegeben u und v bestimme, ob u den Knoten v erreicht.

~ die ein gegebener Knoten s erreicht.

2. Finde alle Knoten von G,

~ stark zusammenhängend ist.

3. Teste, ob G

Lösungsansatz: DFS auf gerichteten Graphen

DFS produziert vier Arten von Kanten:

1. Baumkanten (eines gerichteten DFS-Baumes)

2. Rückwärtskanten (Nichtbaumkanten zu Vorgängern im DFS-Baum)

3. Vorwärtskanten (Nichtbaumkanten zu Nachfolgern im DFS-Baum)

4. Querkanten (Nichtbaumkanten zu Knoten in einem anderen DFS-Teilbaum)

1.3. ERREICHBARKEITSPROBLEME

19

= Baumkanten

= Rückwärtskanten

= Vorwärtskanten

= Querkanten

A4

B3

A1

G

B4

A

E

C5

D6

C

B

E2

C2

D3

E

A

F7

G1

C

F

D

B

F

F5

G

D

Abbildung 1.4: DFS-Traversierung eines gerichteten Graphen

~ ein gerichteter Graph. DFS-Traversierung von G

~ beginnend bei Knoten

Beobachtung: Es sei G

~

s besucht alle Knoten von G, die s erreicht. Insbesondere enthält DFS-Baum einen gerichteten

Pfad von s zu jedem erreichbaren Knoten.

Komplexität von DFS beginnend bei s: O(ns + ms ) Schritte (bei Verwendung von Adjazenzlisten), wobei ns Anzahl der von s erreichbaren Knoten und ms Anzahl der in diesem Teilgraph

enthaltenen Kanten ist.

Folgende Probleme können in O(n2 + n · m) Schritten gelöst werden:

• Bestimme für jeden Knoten v den induzierten Teilgraphen der erreichbaren Knoten.

~ stark zusammenhängend ist.

• Teste, ob G

Aber: Test auf starken Zusammenhang in O(n + m) möglich.

~

Algorithmus StrongConnectivityTest(G)

1

2

3

4

5

6

7

8

9

10

11

Führe DFS auf einem beliebigen Knoten s (z.B. erster Knoten der Knotenliste) aus

if Menge nicht besuchter Knoten nicht leer

then return Nicht stark zusammenhängend“

”

else

~ um

Drehe Orientierung aller Kanten von G

Führe DFS auf umgedrehten“ Graphen auf s aus

”

if Menge nicht besuchter Knoten nicht leer

then return Nicht stark zusammenhängend“

”

else return Stark zusammenhängend“

”

fi

fi

Algorithmus 4: StrongConnectivityTest

20

KAPITEL 1. GRAPHENALGORITHMEN

1.3.3

Transitive Hülle

Ziel: Wollen Zusammenhangs- und Erreichbarkeitsinformationen nach Berechnung festhalten,

d.h. berechnen transitive Hülle.

~ ist der gerichtete Graph G

~ ∗ mit

Transitive Hülle eines gerichteten Graphen G

~ ∗ ) = V (G)

~

• V (G

~ ∗ ) gilt (u, v) ∈ E(G

~ ∗ ) ⇔ u erreicht v in G

~

• Für alle u, v ∈ V (G

Klar: Transitive Hülle kann in O(n2 + n · m) Schritten berechnet werden (mittels wiederholter

DFS)

alternativ: Floyd-Warshall-Algorithmus (1962)

~ ∗ in Runden (V = {v1 , . . . , vn })

Konstruiere G

~

~ 0 =def G

G

~

~ k−1 ∪ (V, {(vi , vj )|(vi , vk ) ∈ E(Gk−1 ) ∧ (vk , vj ) ∈ E(Gk−1 )

Gk =def G

~

Algorithmus Floyd-Warshall(G)

~

Eingabe: gerichteter Graph G

~∗

Ausgabe: transitive Hülle G

1

2

3

4

5

6

7

8

9

10

11

12

13

14

~ 0 := G

~

G

for k := 1 to n do

~ k := G

~ k−1

G

for i := 1 to n do

for j := 1 to n, i 6= j, j 6= k do

~ k−1 ∧ (vk , vj ) ∈ G

~ k−1

if (vi , vk ) ∈ G

~

then if (vi , vj ) 6∈ Gk

~ k hinzu

then Füge (vi , vj ) zu G

fi

fi

od

od

od

~n

return G

Algorithmus 5: Floyd-Warshall

Komplexität von Floyd-Warshall: 3 geschachtelte For-Schleifen ⇒ Θ(n3 ) Schritte (bei Verwendung von Adjazenzmatrizen)

1.4. MINIMALE SPANNBÄUME

1.4

21

Minimale Spannbäume

Betrachte gewichtete ungerichtete zusammenhängende Graphen G. Es sei T ⊆ G ein Spannbaum

von G. Definiere

X

w(e)

w(T ) =def

e∈E(T )

als Gewicht von G. T mit minimalem Gewicht heißt minimaler Spannbaum.

Ziel: Schnelle Algorithmen zur Bestimmung minimaler Spannbäume.

Motivation: Bestimme minimale Leitungslänge, um alle Rechner einer Organisationseinheit

geeignet zu verbinden.

Lemma 3: (blaue Regel)

Es sei G = (V, E, w) ein gewichteter zusammenhängender Graph. Sei V ′ nicht-leere Teilmenge

von V .

1. Ist e ∈ E die einzige Kante mit minimalem Gewicht unter allen Kanten aus

{u, v} ∈ E | u ∈ V ′ , v 6∈ V ′ , so ist e in jedem minimalen Spannbaum enthalten.

2. Ist e ∈ E eine Kante mit minimalem

Gewicht unter allen Kanten aus

{u, v} ∈ E | u ∈ V ′ , v 6∈ V ′ , so gibt es einen minimalen Spannbaum, der e enthält.

Beweis:

1. Übungsaufgabe

2. Sei e ∈ E gewichtsminimale Kante von V ′ nach V \ V ′ . Angenommen e kommt in keinem

minimalen Spannbaum vor. Sei T ein beliebiger minimaler Spannbaum von (V, E, w). Dann

besitzt (V, E(T ) ∪ {e}) einen Kreis C, d.h. es gibt e′ ∈ E(T ) ∩ C von V ′ nach V \ V ′ . Es

gilt jedoch w(e) ≤ w(e′ ). Dann gilt für den Spannbaum T ′ =def (V, E(T ) \ {e′ } ∪ {e}).

w(T ′ ) ≤ w(T ), d.h. T ′ minimaler Spannbaum mit e.

Folgerung 4: Es sei G ein gewichteter zusammenhängender Graph. Sind die Kantengewichte

von G alle verschieden, so ist der minimale Spannbaum eindeutig.

Lemma 5: (rote Regel)

Es sei G = (V, E, w) ein gewichteter, zusammenhängender Graph.

1. Gibt es für eine Kante e ∈ E einen Kreis C in G, der e enthält und für den w(e) > w(e′ )

für alle Kanten e′ ∈ E(C) \ {e} gilt, so kommt e in keinem minimalen Spannbaum vor.

2. Ist C = {e1 , . . . , ek } ein Kreis in G und ist ei ∈ C eine Kante mit w(ei ) ≥ w(ej ) für

1 ≤ j ≤ k, so gibt es einen minimalen Spannbaum, der ei nicht enthält.

Beweis: (Widerspruch)

1. Angenommen es gibt minimalen Spannbaum T von G mit solch einer Kante

e = {u, v} ∈ E(T ). Wenn e aus T entfernt wird, entstehen zwei Teilbäume Tu , Tv mit

22

KAPITEL 1. GRAPHENALGORITHMEN

u ∈ V (Tu ), v ∈ V (Tv ). Da e aber auf Kreis C in G liegt mit w(e) > w(e′ ) für alle e′ 6= e,

gibt es einen Weg in G von u nach v, der e nicht enthält. Dann gibt es auch Kante e′ ∈ E,

die Knoten von Tu mit Knoten von Tv verbindet. Damit ist T ′ =def (V, E(T ) \ {e} ∪ {e′ })

Spannbaum von G mit w(T ′ ) < w(T ). Minimalität von T .

2. Angenommen die beschriebene Kante ei ∈ C = {e1 , . . . , ek } liegt in jedem minimalen

Spannbaum von G. Sei T ein beliebiger minimaler Spannbaum von G. Wenn ei = {u, v}

aus T entfernt wird, entstehen Tu , Tv mit u ∈ V (Tu ), v ∈ V (Tv ). Analog zu 1. können

wir ei durch jede Kante ej ∈ C ersetzen, die Tu mit Tv verbindet. Dann ist T ′ =def

(V, E(T ) \ {ei } ∪ {ej }) Spannbaum von G ohne ei . Außerdem gilt: w(T ′ ) ≤ w(T ) wegen

w(ei ) ≥ w(ej ). D.h. T ′ minimaler Spannbaum.

1.4.1

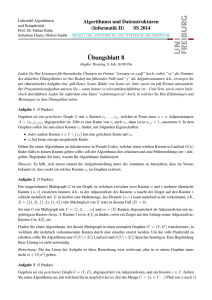

Kruskal-Algorithmus (1956)

Idee: Wähle iterativ Kante mit minimalem Gewicht unter Beachtung der Kreisfreiheit. (Korrektheit folgt direkt aus der blauen Regel, Lemma 3 auf der vorherigen Seite)

Verwenden zur Implementierung

• Priority Queues

• Union-Find-Strukturen

Algorithmus Kruskal(G)

Eingabe: gewichteter zusammenhängender Graph G = (V, E, w) mit n Knoten und m Kanten

Ausgabe: Minimaler Spannbaum T

1

2

3

4

5

6

7

8

9

10

11

12

13

14

for v ∈ V do

MakeSet(v)

od

Initialisiere Priority Queue Q mit allen Kanten und Kantengewichten als Schlüssel

E(T ) := ∅

while kE(T )k < n − 1 do

{u, v} := ExtractMin(Q)

r1 := Find(u)

r2 := Find(v)

if r1 6= r2

then E(T ) := E(T ) ∪ {u, v}

Union(r1 , r2 )

fi

od

Algorithmus 6: Kruskal

Beispiel: Abbildung 1.5 auf der nächsten Seite

1.4. MINIMALE SPANNBÄUME

23

Kante noch in Queue

r1 6= r2 , in Spannbaum

r1 = r2 , nicht im Spannbaum

A

A

1

8

2

E

1

B

9

6

D

8

2

5

7

3

4

6

D

8

9

3

6

D

8

2

B

9

6

D

4

4

B

9

C

10

8

2

7

3

6

D

4

C

10

1

5

E

B

7

A

1

5

7

3

E

C

10

5

A

1

E

B

9

3

8

2

7

A

2

1

5

E

C

10

A

4

E

B

7

9

3

C

10

5

6

D

4

C

10

Abbildung 1.5: Algorithmus von Kruskal

Kante, die noch nicht betrachtet wurde

Kante e, die durch ExtractMin erhalten wird

Kanten, die bereits im Spannbaum sind

A0

A

1

8

2

E∞

3

1

5

B∞

7

6

D∞

4

E1

3

E

10

2

B6

6

10

C5

4

E

6

8

1

C5

10

8

2

5

B4

6

10

4

A

9

D

B7

9

3

D2

7

3

5

7

C5

1

5

9

D

4

E

A

8

7

3

B8

6

D2

8

2

9

A

1

2

1

5

7

C∞

10

8

2

9

A

C

4

E

5

B

7

3

9

D

Abbildung 1.6: Algorithmus von Prim und Jarnik

6

10

C

24

KAPITEL 1. GRAPHENALGORITHMEN

Komplexität von Kruskal:

Zeilen 1–3:

O(n)

Zeile 4:

O(m)

Zeilen 6–14:

maximal m Durchläufe der while-Schleife

Zeile 7:

O(log m)

Zeilen 8–9:

O(log∗ n) amortisiert

Zeile 12:

O(log∗ n) amortisiert

=⇒

O(m log m) = O(m log n) Schritte

1.4.2

Prim-Jarnik-Algorithmus (1957 Prim, 1930 Jarnik)

Dijkstra-ähnliche“ Idee: Beginne mit einer leeren Knotenmenge und ziehe dann stets den Kno”

ten in die Menge, der leichteste Kante zu irgendeinem Knoten der Menge hat. (Korrektheit folgt

aus der blauen Regel, Lemma 3 auf Seite 21)

Algorithmus Prim-Jarnik(G)

Eingabe: gewichteter zusammenhängender Graph G = (V, E, w) mit n Knoten und m Kanten

Ausgabe: Minimaler Spannbaum T

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

D[v] := 0 (für gewähltes v ∈ V )

for u ∈ V \ {v} do

D[u] := +∞

od

T := (∅, ∅)

Initialisiere Priority Queue Q mit Objekten ((u, Nil), D[u]) für alle u ∈ V und Schlüssel D[u]

while Q nicht leer do

(u, e) := ExtractMin(Q)

T := T ∪ {(u, e)}

; e ist Kante

for Nachbar z von u mit z ∈ Q do

if w(u, z) < D[z]

then D[z] := w(u, z)

Aktualisiere D[z] in Q (DecreaseKey)

Aktualisiere (z, (u, z)) für z ∈ Q

fi

od

od

return T

Algorithmus 7: Prim-Jarnik

Komplexität von Prim-Jarnik (mit Fibonacci-Heaps):

1.4. MINIMALE SPANNBÄUME

Zeilen 1–6:

Zeilen 7–17:

25

O(n)

Für jeden Knoten u ∈ V ein Durchlauf der while-Schleife

Zeile 8:

O(log n) amortisiert

Zeilen 10–16: O(deg(u)) amortisiert

!

X

⇒ O

(log n + deg(u)) = O(n log n + m)

u∈V

⇒

O(n log n + m) Schritte

Zweiter Algorithmus von Prim-Jarnik (nach Fredman, Tarjan, 1987)

Idee: Beschränkiung der Größe der Priority Queues

Algorithmus Prim-Jarnik-2(G)

Eingabe: gewichteter zusammenhängender Graph G = (V, E, w)

Ausgabe: Minimaler Spannbaum T

1

2

3

4

5

6

7

8

9

10

11

12

13

while kV k > 1 do

t := 0

T := ∅

while V 6= T

t := t + 1

Wähle zt aus V \ T

Baue Baum Tt mit Hilfe von Prim-Jarnik nur mit Knoten aus V \ T auf,

so lange bis Priority Queue Qt mehr als r Elemente enthält (beachte:

Element wird erst in Qt eingefügt, wenn Schlüssel verschieden von ∞

ist)

T := T ∪ Tt

od

V := {1, . . . , t}

E := {i, j}|1 ≤ i, j ≤ t, i 6= j und es gibt Kante von Knoten aus Ti zu Knoten aus Tj

w(i, j) := min w(u, v) für {i, j} ∈ E, u ∈ T, v ∈ Tj , u, v benachbart

od

Algorithmus 8: Prim-Jarnik-2

Komplexität einer möglichen Implementierung:

Zeilen 2–9:

O(t · log r + m) bei Realisierung mit Fibonacci-Heaps;

t Anzahl der Knoten vor Durchlauf

Zeilen 10–12: O(m)

mit baumbasierten Union-Find-Strukturen

(Union-Operationen vor Find-Operationen)

Problem: Wie ist r zu wählen?

• Ist r klein, dann Zeit pro Durchlauf klein

• Ist r groß, dann Anzahl der Durchläufe klein

Setze r =def 2

2m/t

, t Anzahl der Knoten vor Durchlauf

26

KAPITEL 1. GRAPHENALGORITHMEN

•

T1

•

•

•

•

•

•

•

T3

•

1

•

•

T2

2

3

•

•

•

7

•

6

•

5

4

•

1

T1

3

T3

T2

1

•

•

T2

2

3

•

•

•

•

7

•

•

•

•

•

T4

6

T3

•

T1

•

•

•

•

•

4

6

T4

T4

5

4

Abbildung 1.7: Algorithmus von Prim und Jarnik nach Fredman und Tarjan

=⇒

O(m) Schritte pro Durchlauf

Bestimmen Anzahl t′ der Bäume, die nach einem Durchlauf verbleiben auf Graphen mit t Knoten

und m′ Kanten:

t′ ≤

2m′

r

Begründung:

• Jeder Baum Ti ist mit mindestens r Kanten inzident, die einen Knoten in Ti haben.

• Jede Kante verbindet genau zwei Knoten.

2m

t′

2m

≥ 2 2m′ ·r ≥ 2r

2m

Zu Beginn: kV k = n ≥

n

=⇒ Anzahl Durchläufe (while-Schleife in Zeile 1) ≤ min{i | log log . . . log n ≤ 1} = log∗ n

{z

}

|

Damit: r′ = 2

=⇒ Prim-Jarnik-2 läuft in O(m · log∗ n)

1.4.3

i

Algorithmus von Boruvka (Boruvka, 1926)

Idee: Verteilte Version von Prim-Jarnik; lasse viele Bäume (Cluster, Superknoten) gleichzeitig

wachsen (bis sie sich berühren).

1.4. MINIMALE SPANNBÄUME

27

Kante, die noch nicht betrachtet wurde

Kante, die gerade betrachtet wird

Kanten, die bereits im Spannbaum sind

A

A

1

E

3

5

B

9

6

10

E

4

C

3

5

B

9

6

10

8

2

7

D

1

8

2

7

D

1

8

2

A

C

4

E

3

5

B

7

9

D

6

10

4

C

Abbildung 1.8: Algorithmus von Boruvka

Algorithmus Boruvka(G)

Eingabe: gewichteter zusammenhängender Graph G = (V, E, w)

Ausgabe: Minimaler Spannbaum T

1

2

3

4

5

6

7

8

T := (V, ∅)

while kE(T )k < n − 1 do

for Zusammenhangskomponente Ci von T do

Bestimme leichteste Kante e = {u, v} ∈ E mit u ∈ Ci , v 6∈ Ci

E(T ) := E(T ) ∪ {e}

od

od

return T

Algorithmus 9: Boruvka

Korrektheit des Algorithmus folgt aus der blauen Regel, Lemma 3 auf Seite 21 (bis auf Behandlung von Tie-Breaks).

Implementierungsaspekte:

• Datenstruktur für Verwaltung des Waldes T unter Kanteneinfügung (⇒ O(1) Schritte pro

Einfügung)

• Nach jedem Durchlauf von Zeilen 3–6 folgt Traversierung von T mittels Tiefensuche (⇒

O(n) Schritte)

• Zur Bestimmung leichtester Kanten Adjazenzliste

28

KAPITEL 1. GRAPHENALGORITHMEN

Komplexität einer möglichen Implementierung:

Zeilen 3–6:

Traversierung von T in O(n)

Bestimmung leichtester Kanten in O(m)

⇒ O(n + m) = O(m) Schritte

Anzahl Durchläufe: Jede neue Kante vereinigt zwei Zusammenhangskomponenten. D.h.

nach jedem Durchlauf höchstens Hälfte der Komponenten noch vorhanden ⇒ O(log n) Durchläufe

Damit O(m log n) Schritte für Boruvka

1.4.4

Algorithmus von Chazelle (Chazelle, 2000)

Betrachten noch einmal einen Boruvka zu unserem Beispiel:

A

ABCDE

1

8

2

E

3

5

5

1

9

6

10

C

BC

ADE

B

7

D

5

2

1

1

4

4

A

D

E

B

C

Boruvka-Algorithmus produziert Hierarchie bei Berechnung des minimalen Spannbaums bottom”

up“.

Beobachtung: Wenn wir Hierarchie wüssten, dann könnten wir auch Spannbaum leicht berechnen.

Idee: Berechne Hierarchie top-down“!

”

Es sei G = (V, E, w) ein gewichteter, ungerichteter zusammenhängender Graph. Vereinfachung:

Alle Kantengwichte verschieden.

MST(G) bezeichne eindeutigen minimalen Spannbaum von G.

Eine Knotenmenge U ⊆ V heißt kontrahierbar gdw. G[U ] ∩ MST(G) zusammenhängend.

(G[U ] =

b durch U induzierter Teilgraph von G)

Es sei e = {x, y} ∈ E. Dann heißt der Graph G/e = (V ′ , E ′ ) Kontraktion von G nach e, falls

V ′ =V \ {x, y} ∪ {ve }

E ′ = {u, v} ∈ E | {u, v} ∩ {x, y} = ∅

∪ {u, ve } | {x, u} ∈ E \ {e} oder {y, u} ∈ E \ {e}

Es sei[X ein weiterer ungerichteter Graph und {Vx | x ∈ V (X)} eine Partition von V , d.h.

V =

Vx und Vx ∩ Vy = ∅ für x 6= y, mit folgender Eigenschaft: G[Vx ] zusammenhängend für

x

alle x ∈ V (X).

G heißt Minor von X ged. für alle x, y ∈ V (X) gilt: {x, y} ∈ E(X) ⇔es gibt u ∈ Vx , v ∈ Vy mit

1.4. MINIMALE SPANNBÄUME

29

{u, v} ∈ E

Beispiel:

X:

Minor von X:

1

2

kein Minor von X:

•

1

257

6

7

3

5

4

34

•

6

•

•

•

G heißt zulässiger Minor von X falls Vx kontrahierbar für alle x ∈ V (X)

Proposition 6: Es seien G und X ungerichtete zusammenhängende Graphen. G ist Minor von

X gdw. X kann durch Kantenkontraktion aus G gewonnen werden.

Beweis: klar

Betrachten Minoren-Hierarchie H, d.h. Graphenfolge (X0 , X1 , . . . , Xα ) mit X0 = G, Xi ist

zulässiger echter Minor von Xi+1 für 0 ≤ i ≤ α − 1 und Xd besteht nur aus einzelnem Knoten.

H kann aufgefasst werden als balancierter Baum, d.h. Blätter liegen auf gleichem Level. Höhe

von H ist d.

Es sei z ∈ V (Xi ). Zu z korrespondiert in H eine Menge Vz ⊆ V (Xi−1 ). Insbesondere hat z in H

genau kVz k Kinder.

Zur Berechnung von MST(G) berechne rekursiv beginnend bei Wurzel von H für alle Knoten z

in H MST(G[Vz ]) und vereinige“ alle Minimalen Spannbäume.

”

1

2

A

B

C

D

4

3

7

E

9

F

I

15

M

16

22

H

13

12

J

6

8

G

11

10

14

5

K

19

L

18

17

21

20

N

23

O

24

P

X4

A...P

X3

CDGHKLOP

ABEF IJM N

X2

IM

ABEF

X1

AB

X0

A

EF

B

E

F

JN

CDGH

I

M

J

N

CD

I

M

J

N

C

KP

GH

D

G

H

LO

K

P

L

O

K

P

L

O

30

KAPITEL 1. GRAPHENALGORITHMEN

1

A

B

4

3

7

E

I

15

M

A

K

N

23

B

7

E

15

M

14

11

K

D

A

N

23

L

X4

16

15

M

P

24

14

22

A...P

X3

ABEF IJM N

X2

ABEF

9

IM

4

4

10

CDGH

13

12

18

JN

14

CDGHKLOP

21

KP

LO

22

X1

AB

CD

4

3

EF

9

I

15

M

14

16

22

10

GH

11

J

17

N

5

13

12

K

19

L

18

21

20

23

O

24

P

6

H

13

12

K

L

19

21

20

23

O

C

24

2

4

11

P

D

5

G

J

N

8

18

F

17

D

5

G

11

B

10

I

21

O

7

E

9

20

N

3

H

19

22

1

2

4

J

17

6

18

17

22

M

13

12

J

16

8

15

P

5

G

10

I

24

2

C

F

9

O

16

C

F

10

14

I

21

4

3

E

L

20

B

3

7

9

18

17

22

1

6

H

19

1

A

13

12

J

16

8

G

11

10

14

D

5

F

9

2

C

8

6

H

13

12

K

19

L

18

21

20

23

O

24

P

1.4. MINIMALE SPANNBÄUME

31

Problem: Wie können wir kontrahierbare Teilmengen entdecken, ohne MST zu berechnen?

vorläufige Antworten:

• Verwende Soft Heaps

• Verwende rote Regel (Lemma 5 auf Seite 21)

• Traversiere H in Postorder (berechne dafür Hierarchien für Graphen G[Vz ] rekursiv neu)

Werden zeigen:

(*) Für Graphen mit n Knoten und m Kanten kann eine Hierarchie der Höhe d in O(m+d3 ·n)

Schritten berechnet werden.

Wir können Höhe selbst wählen (keine Konstante!)

• d groß ⇒ nz klein (nz = kVz k)

• d klein ⇒ nz groß

Geschickte Wahl: Es sei dz die Tiefe von z in H, d.h. die Anzahl der Kanten auf Pfad in H

bis Blatt unterhalb von z.

Definiere die Anzahl der Verzweigungen eines Knotens als

3

für dz = 1

s(t, 1)

nz =def s(t − 1, s(t, dz − 1))3 für dz > 1

0

für dz = 0

mit

t = min{i > 0 | n ≤ s(i, d)3 }

1 m /3

d=c

n

und

s(1, j) = 2j

für i > 0

s(i, 1) = 2

für i > 0

s(i, j) = s(i, j − 1) · s(i − 1, s(i, j − 1))

s(i, 0) = 0

für i, j > 1

für i > 0

Für Knoten z in H sei die Expansion von z in H, bezeichnet mit ξ(z), die Anzahl der Blätter

in H unterhalb von z, d.h. die Anzahl der Knoten in G, die zu z kontrahiert werden.

Proposition 7: Es gilt ξ(z) = s(t, dz )3 für alle z in H (falls n = s(t, d)3 )

32

KAPITEL 1. GRAPHENALGORITHMEN

Beweis: Induktion über dz

Induktionsannahme: Fall dz = 0 klar. Für dz = 1 gilt ξ(z) = nz = s(t, 1)3

Induktionsschritt: Es sei dz > 1. Dann gilt

ξ(z) =

X

ξ(z ′ )

z ′ Kind von

z in H

= nz · s(t, dz − 1)3

= s(t − 1, s(t, dz − 1))3 · s(t, dz − 1)3

= s(t, dz )3

Komplexität von Algorithmus“ von Chazelle mit (*) auf der vorherigen Seite:

”

Vereinfachung: n = s(t, d)3

Zu zeigen: Algorithmus von Chazelle benötigt B · t · (m + d3 n) Schritte zur MST-Berechnung

in Graphen mit m Kanten und n Knoten (B groß genug).

Induktion über t.

Induktionsannahme: t = 1: D.h. n = s(1, d)3 = (2d)3 = 8d3 ≤ 8c̃ ·

2

2

m

n

1/3 3

Damit gilt

n ≤ 8 · c̃ · m. Verwende Boruvka-Algorithmus in der O(n ) Version (Übung) um den MST zu

berechnen. Damit A · n2 ≤ 8| · {z

c̃ · A} ·m ≤ B · t · (m + d3 n) Schritte.

≤B

Induktionsschritt: Es sei t > 1. Damit nimmt die Induktionsvoraussetzung folgende Gestalt an

(z innerer Knoten in H unterhalb der Wurzel):

Induktionsvoraussetzung: MST für mz Kanten, nz Knoten und Tiefe dz benötigt B · (t − 1) ·

(mz + s(t, dz − 1)3 · nz ) Schritte wegen nz = s(t − 1, s(t, dz − 1))3

(dz > 2)

Für die Berechnung von MST(G) benötigen wir dann höchstens (ohne Vorberechnung von H)

≤

X

z∈H

B · (t − 1) · (mz + s(t, dz − 1)3 · nz )

=B · (t − 1) ·

=B · (t − 1) ·

=B · (t − 1) ·

Prop. 7

Jedes Blatt höchstens

in d Expansionen

=B · (t − 1) ·

m+

X

z

m+

X

z

m+

X

3

s(t, dz − 1) nz

3

m+

3

s(t, dz − 1) s(t − 1, s(t, dz − 1))

3

s(t, dz )

z

X

!

!

ξ(z)

z

=B · (t − 1) · (m + d · n)

!

!

1.4. MINIMALE SPANNBÄUME

33

Inklusive Vorberechnung ergeben sich damit höchstens

B · (t − 1)(m + dn) + B(m + d3 n) ≤ B · t(m + d3 n) Schritte

Wie groß ist O(t · (m + d3 · n)) gemessen an n und m?

Definieren Ackermann-Funktion und ihr Inverses:

2j

A(i, j) =def 2

A(i − 1, A(i, j − 1))

für i = 0, j ≥ 0

für i > 0, j = 1

für i > 0, j > 1

Es gilt:

• A(0, n) = 2n

• A(1, n) = A(0, A(1, n − 1)) = 2 · A(1, n − 1) = 2n

o

···2

n

• A(2, n) = A(1, A(2, n − 1)) = 2A(2,n−1) = 22

···2

• A(3, n) = A(2, A(3, n − 1)) = 22

o

A(3, n − 1)

Inverse“ Ackermann-Funktion nach Tarjan:

”

i

α(i, j) =def min k ≥ 1 | A k, 4

> log j

j

Lemma 8:

l

Es sei G ein Graph mit m Kanten und n Knoten. Für d = c·

gilt t = O(α(m, n)).

m

n

1/3 m

und t = min i > 0 | n ≤ S(i, d)3

Beweis: Mit A(i, j) ≥ 2j+1 für i ≥ 2, j ≥ 3 gilt für i ≥ 1, j ≥ 4:

A(3i, j) = A(3i − 1, A(3i, j − 1)) ≥ A(3i − 1, 2j ) ≥ A(i, 2j )

(1.1)

Außerdem gilt für i ≥ 1, j ≥ 4:

A(3i, j) = A(3i − 1, A(3i, j − 1)) ≥ 2A(3i,j−1) = 2A(3i−1,A(3i,j−2)) ≥ 2A(i,j)

(1.2)

Damit:

(1.2)

(1.1)

d

S(9α(m, n) + 1, d) ≥ A(9α(m, n), d) ≥ 2A(3α(m,n),d) ≥ 2A(α(m,n),2

c groß

)

≥ 2A(α(m,n),4·⌈ n ⌉) > 2log n = n

m

D.h. kleinstes t mit n ≤ S(t, d)3 erfüllt auch t ≤ 9α(m, n) + 1

Jetzt: Hierarchie-Berechnung

Berechne Hierarchie der Höhe d mit den spezifizierten Parametern n, nz usw. in PostorderReihenfolge über den Graphen G. Zunächst noch ohne Soft-Heaps.

34

KAPITEL 1. GRAPHENALGORITHMEN

Algorithmus Minoren-Hierarchie(z, az )

Eingabe: Knoten z in H mit Tiefe dz

Ausgabe: Knotenmenge Vz und Priority Queue aller Schnittkanten

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

if dz = 0

then Vz := {z}

Initialisiere Priority Queue Qz aller zu z inzidenten Kanten in X0 = G

return (Vz , Qz )

else

while kVz k < nz do

if kVz k = 0 . . . fi

in Vorlesung nicht weiter erklärt

{u, v} := ExtractMin(Qz )

(o.B.d.A. u ∈ Vz ; beachte: {u, v} ∈ E(Xdz ))

(Vv , Qv ) := Minoren-Hierarchie(v, dz − 1)

Kontrahiere Vv in Xdz −1 → Xdz

Vz := Vz ∪ {v}

Entferne aus Qv alle Kanten, die inzident zu Vz sind

Qz := Qz ∪ Qv

od

return (Vz , Qz )

fi

Algorithmus 10: Minoren-Hierarchie

Erinnerung:

1. Soft Heap ist Datenstruktur, die Operationen

• Insert(o, k), Merge(Q1 , Q2 ), Delete(k) amortisiert in O(1) Schritten

• ExtractMin amortisiert in O(log 1ε ) Schritten

unterstützt und zu jedem Zeitpunkt höchstens ε · n verdorbene Schlüssel enthält, wibei n

die Gesamtzahl der Einfügungen ist.

2. verdorbene Schlüssel haben einen höheren Schlüsselwert als ursprünglich.

Problem bei Verwendung von Soft Heaps: Es können die falschen Kanten aus Priority Queue

herausgezogen werden, d.h. Kanten müssen nicht minimale Gewichte besitzen. Damit ist blaue

Regel (Lemma 3 auf Seite 21) nicht mehr anwendbar für Korrektheit.

Sei H die zu traversierende Minorenhierarchie. Es sei z der aktuell besuchte Knoten in H. Ein

Pfad (z1 , . . . , zk ) in H heißt aktiv gdw. z1 ist Wurzel (dz1 = d) und zk = z. (Vz1 , . . . , Vzk ) sind

die zugehörigen Knotenmengen; ist zi+1 linkes Kind von zi in H, dann ist Vzi = ∅.

Eine Kante e ∈ E(G) heißt Schnittkante bzgl. (z1 , . . . , zk ) gdw. e ist inzident zu genau einem

Knoten in Vz1 ∪ · · · ∪ Vzk

Klar: Status von Kanten als Schnittkanten ändert sich im Zeitlauf.

Eine Kante e = {u, v} heißt kritisch, gdw. e ist Schnittkante mit verdorbenem Gewicht, d.h. e

ist in einem Soft Heap H mit w(e) < key H (e), u ∈ Vz und Vz wird kontrahiert.

1.4. MINIMALE SPANNBÄUME

35

Wir halten Informationen über Beziehungen der Vz1 , . . . , Vzk entlang eines aktiven Pfades (z1 , . . . , zk )

aufrecht:

Invariante 1:

Für alle 1 ≤ i < k besteht Kettenlink c(Vzi , Vzi+1 ) aus Kante e, deren aktuelle Kosten wakt (e)

(Schlüsselwert von e in einem Soft Heap) folgende Eigenschaften erfüllen:

1. wakt (e) ≤ wakt (f ) für alle Schnittkanten bzgl. Vz1 ∪ · · · ∪ Vzi

2. wakt (e) ≤ wwork (i, j) für alle 1 ≤ j < i mit

(

wakt (f ) , f kritisch

wwork (f ) =

w(f )

, sonst

und wwork (i, j) = min{wwork (f ) | f ∈ E(Vzi , Vzj )}

Bemerkung: Invariante 1 garantiert Kontrahierbarkeit.

Invariante 2:

Für alle 1 ≤ j ≤ k und für alle Schnittkanten e = {u, v} mit u ∈ Vzj gilt: e ist genau in einem

der Soft Heaps H(j) oder H(i, j) mit 1 ≤ i < j enthalten. Außerdem gilt:

• e ∈ H(j)

⇒

es gibt w mit {v, w} ∈ H(i, j) für 1 ≤ i < j

• e ∈ H(i, j) ⇒ es gibt w ∈ Vzi mit {v, w} ∈ E(G) aber für alle w ∈ Vzi+1 ∪ · · · ∪ Vzj−1

gilt {v, w} 6∈ E(G)

Bemerkung: Invariante 2 wird zur Kontrolle kritischer Kanten verwendet.

Betrachten nun Operationen Retraction ind Extension zur Traversierung von H.

1. Retraction (=

b Pop auf Rekursionsstack)

Sei (z1 , . . . , zk ) aktiver Pfad. Folgendes wird ausgeführt:

(a) Kontrahiere Vzk und neuer Knoten v̂k wird in Vzk−1 aufgenommen.

(b) Aktualisiere Kettenlink c(Vzk−1 , Vzk )

Invarianten:

• Invariante 1: klar

• Invariante 2:

→ O(k) Schritte

(a) Soft Heaps H(k), H(k − 1, k) werden zerstört

(b) alle verdorbenen Kanten werden entfernt

(c) verbleibende Kanten werden entsprechend ihrer Endpunkte partitioniert, d.h. in

Mengen Pv mit gleichem Endpunkt v eingeordnet.

(d) für alle Pv wähle Kante e mit minimalem Gewicht und eliminiere alle anderen

Kanten aus G.

(e) füge Kanten ev in entsprechenden Soft Heap ein

36

KAPITEL 1. GRAPHENALGORITHMEN

(f) Verschmelze H(i, k) mit H(i, k − 1)

2. Extension (=

b Push auf Rekursionsstack)

Sei (z1 , . . . , zk ) aktiver Pfad. Folgendes führen wir aus:

(a) Führe ExtractMin auf allen Soft-Heaps aus; sei e = {u, v} Kante mit minimalem

aktuellem Gewicht; e heißt Erweiterungskante.

(b) Bestimme i∗ = min 1 ≤ i ≤ k es gibt i < j ≤ k mit wwork (i, j) ≤ wakt (e) ∪ {∞}

Falls i∗ < ∞ führe Fusion aus:

Es sei f Kante mit wwork (I ∗ , j ∗ ) = wwork (f ) ≤ wakt (e); es sei außerdem a ∈ Vzi∗

der zu f inzidente Knoten. Kontrahiere alle Knotenmengen Vzi∗ +1 , . . . , Vzk in a (wie

bei Retraction, aber ohne Einfügen neuer Kanten).

(c) Vzk∗ := {v} und der Kettenlink zwischen Vzk∗ −1 und Vzk∗ wird e;

(

i∗ + 1 falls Fusion erforderlich

beachte k ∗ :=

k + 1 sonst

(d) Entferne alle Kanten aus Heaps 6= e inzident zu v

(e) Neuer aktiver Pfad ist nun (z1 , . . . , zk∗ )

(f) Füge alle neuen Schnittkanten, die zu v inzident sind, in die entsprechenden Heaps

ein.

Hierarchietraversierung nun wie folgt:

Für jeden Knoten zk mit dzk ≥ 1 führe Extension aus, so lange es geht (d.h. bis Größenbedingung

erfüllt ist).

Algorithmus Chazelle(G, t)

Eingabe: ungerichteter gewichteter Graph G, Parameter t

Ausgabe: Minimaler Spannwald MSF(G)

1

2

3

4

5

6

7

8

if t = 1 oder kV k ≤ N0

then Bestimme MSF(G) mittels Boruvka-Algorithmus in O(n2 )-Version

fi

Führe c Boruvka-Phasen aus; X Menge der kontrahierten Kanten

Berechne Minorenhierarchie H mittels Retraktion und Extension

Bestimme

S Graph B der kritischen Kanten

F := z∈H MSF(G[Vz ] \ B, t − 1)

return MSF(F ∪ B, t) ∪ X

Algorithmus 11: Chazelle

Zur Korrektheit des Algorithmus:

Es sei G = (V, E, w) zusammenhängender gewichteter Graph. Eine Knotenmenge U ⊆ V heißt

streng kontrahierbar gdw. für alle Kanten e, f ∈ E(G) mit ke ∩ U k = kf ∩ U k = 1 ein Pfad

(h0 , h1 , . . . , hℓ ) mit h0 = e, hℓ = f und hi ∈ E(G[U ]) für 1 ≤ i ≤ ℓ − 1 existiert, für den

w(hi ) ≤ min{w(h0 = e), w(hℓ = f )} für alle 1 ≤ i ≤ ℓ − 1 gilt.

Proposition 9: Es sei G = (V, E, w) zusammenhängender gewichteter Graph. Ist U ⊆ V streng

kontrahierbar, so ist U kontrahierbar.

1.4. MINIMALE SPANNBÄUME

37

Beweis: Angenommen U wäre nicht kontrahierbar. D.h. G[U ] ∩ MST(G) hat mehr als eine

Zusammenhangskomponente. Sei p = (e1 , . . . , eℓ ) kürzester Pfad in MST(G) zwischen zwei Zusammenhangskomponenten U1 und U2 , seien u1 und u2 die zugehörigen Knoten. Es gilt ℓ ≥ 2

und ei 6∈ E(G[U ]) für alle 1 ≤ i ≤ ℓ, da p kürzester Pfad ist. Betrachten Pfad q in G[U ], der

u1 und u2 verbindet. Damit ist (p, q) Kreis in G. Nach Lemma 5 (rote regel) auf Seite 21 liegt

schwerste Kante g nicht in MST(G). D.h. g ∈ E(G[U ]). Widerspruch zu U streng kontrahierbar.

Lemma 10: Zum Zeitpunkt der Kontraktion ist jede Knotenmenge Vz streng kontrahierbar

bezüglich wwork .

Beweis: Verwende Invariante 1 auf Seite 35.

Für gewichteten Graphen G sei G0 der zugehörige Graph nach Ausführung der Boruvka-Phasen.

Lemma 11: Ist eine Kante e ∈ E(G) nicht kritisch und liegt e nicht in F , dann gehört e nicht

zu MSF(G0 ).

Beweis: Sei G∗0 der Graph, der aus G0 hervorgeht, indem alle in Schritt (5) entfernten Kanten

eliminiert werden. Wir unterscheiden zwei Fälle:

1. Es gilt e ∈ E(G∗0 ).

Dann gibt es maximalen“ Minor Xi , der e enthält (in Xi+1 wäre e kontrahiert). D.h. es

”

gibt z mit e ∈ Vz . Da e nicht kritisch und nicht in F , folgt e nicht in MSF(G∗0 ). Damit e

nicht in MSF(G0 ).

2. Es gilt e 6∈ E(G∗0 ).

Verwende Lemma 10 auf dieser Seite. Es folgt (mit einigen Argumenten) e 6∈ MSF(G0 )

Zeigen mittels Induktion, dass Algorithmus von Chazelle für Graphen G den MSF(G) berechnet:

Induktionsanfang: t = 1 oder n ≤ N0 : Klar wegen zeilen 1–3.

Induktionsschritt: t > 1, n > N0 :

Wir können annehmen, dass G zusammenhängend ist. In Zeile (4) werden nur MST-Kanten

kontrahiert. Nach Induktionsvoraussetzung bestimmen Zeile (7) (für t − 1) und in Zeile (8)

der Aufruf MSF(F ∪ B, t) (für n′ < n) korrekte MSF. Nach Lemma 11 folgt deshalb

Korrektheit von Zeile 8.

Überlegungen zur Komplexität des Algorithmus von Chazelle:

Lemma 12: Für Graph G sei G0 der Graph nach den Boruvka-Phasen im Algorithmus von

Chazelle, m0 sei die Anzahl der Kanten von G0 . Zum Aufbau der Hierarchie H werden maximal

4m0 Kanteneinfügungen in Soft Heaps vorgenommen.

Beweis: Führen amortisierte Analys mittels Bankkontomethode durch. Kanten werden zum

ersten Mal bei Extension eingefügt. Wählen:

• Gehalt G = 4e(bei Ersteinfügung)

• Sparstrategie:

38

KAPITEL 1. GRAPHENALGORITHMEN

– Jede Kante in H(j) spart 2e.

– Für alle i, j und Knoten v außerhalb Vz1 ∪· · ·∪Vzk haben die ℓ zu v inzudenten Kanten

Gesamtsparvolumen von ℓ + 2e falls ℓ > 0, sonst 0e.

Klar: mit 4e kann Sparstrategie bei erster Einfügung eingehalten werden; Kante kommt in Heap

H(i, k).

Betrachte Retraktion: Sei e = {u, v} Kkante aus H(k − 1, k) ∪ H(k), die wieder eingefügt werden

soll.

1. e ∈ H(k − 1, k), d.h. v inzident zu Kante ẽ ∈ H(i, k − 1), nach Invariante 2 auf Seite 35;

damit: Füge e ub H(k−1): Nach Sparstrategie ≥ 3e für e, k−1, k; bezahle 1e für Einfügen,

behalte 2e für Sparstrategie.

2. e ∈ H(k) und v inzident zu Kante ẽ ∈ H(k − 1, k), so füge e in H(k − 1) ein. Nach

Sparstrategie ≥ 2e+3e; bezahle 1e für Einfügen, behalte ≥ 2e für Sparstrategie.

3. e ∈ H(k), füge e in H(i, k − 1) ein. Nach Sparstrategie ≥ 2e für e; bezahle 1e für Einfügen,

behalte 1e für Sparstrategie.

Fusion wird analog behandelt.

Wie viele kritische Kanten gibt es? Mpssen kritische Kanten in Heaps H(·) und H(·, ·) zählen.

Für Knoten z und z ′ in H mit z ′ ∈ Hz (Knoten in H unterhalb von z):

• C(z, z ′ ) =def Menge der kritischen Kanten im Heap H(i, j) mit zi = z und zj = z ′ auf

aktivem Pfad (z1 , . . . , zi , . . . , zj , . . . , zk ) zum Zeitpunkt des Verschwindens

von H(i, j) (durch Merge oder Verwerfen).

• µ(z, z ′ ) =def maximake Anzahl von Kanten mit inzidentem Knoten v außerhalb Vz1 ∪ · · · ∪

Vzk in H(i, j) (mit i und j wie oben)

Wollen µ beschränken:

• Merge von H(i, j) und H(i, j ′ ) mit j ′ > j: µ(z, z ′ ) bleibt unverändert (nach Invariante 2

auf Seite 35)

• Insert in H(i, j) bei Extension: µ(z, z ′ ) := 1

• Insert in H(i, j) bei Retraktion: µ(z, z ′ ) höchstens inkrementiert (mit sofortiger Verschmelzung nach H(i, j − 1) (?))

→

µ(z, z ′ ) ≤ h(H) ≤ d.

1.4. MINIMALE SPANNBÄUME

39

Damit: sei C =def Menge aller kritischen Kanten.

H(·, ·)

[

[

′′

C(z, z ′ ) \

|Ck ≤4ε · m0 + C(z,

z

)

z,z′ ∈H

z ′′ ∈Hz ′

′

z ∈Hz

[

X ′′ C(z, z ′ ) \

C(z,

z

)

=4ε · m0 +

z ′′ ∈Hz ′

z,z ′ ∈H H(·)

z ′ ∈Hz

=4ε · m0 +

≤4ε · m0 +

X

kC(z, z ′)k −

z,z ′ ∈H

z ′ ∈Hz

X

′

X

′′

z ∈Hz ′

z,z ∈H

z ′ ∈Hz z ′′ Kind von z ′

≤4ε · m0 +d ·

X

z ′′ ∈Hz ′

z ′′ Kind von z ′

µ( z, z ′′) +

| {z }

≤d

d+1

· n 0 + 4 · ε · m0

2

kC(z, z ′′ )k +

′

X

′

z ,z ∈H

z ′ Kind von z

z ′′

Anzahl kritischer KanX

ten, die aus H(i, j ′ )

gelöscht

werden

′′

z ∈Hz ′

während Extension

Kind von z ′

kC(z, z ′)k

≤8ε · m0 +d3 · n0 = O(m0 + d3 · n0 )

Damit: Schritte 4 und 5 benötigen O(m0 + d3 · n0 ) Schritte.

Gesamtkomplexität von MSF ergibt sich mittels ähnlicher Analyse wie eingangs zu O(t·(m+d3 n))

40

KAPITEL 1. GRAPHENALGORITHMEN

Kapitel 2

Algorithmen für Flüsse und

Matchings

2.1

Flüsse und Schnitte

Betrachten folgendes Szenario:

1/1

1

1/1

1/2

s

4

1/1

2

2/2

5

0/1

1/2

3/3

3

2/2

1/3

1/2

3/3

t

1/1

6

Frage: Sind 5 Pakete maximale Anzahl Pakete, die von s nach t gesendet werden können?

Ein Flussnetzwerk N = (V, E, e, s, t) ist ein gerichteter Graph G = (V, E) mit nicht-negativen

Kantengewichten, d.h. c : E → N, der zwei Knoten s, t ∈ V enthält, so dass s keine eingehenden

und t keine ausgehenden Kanten besitzt.

Der Knoten s ∈ V heißt Quelle von N , der Knoten t ∈ V heißt Senke von N . Für eine Kante

e ∈ E heißt c(e) die Kapazität von e.

1

1

1

s

2

4

1

2

3

5

1

3

2

3

2

2

2

3

t

1

6

Es sei N = (V, E, c, s, t) ein Flussnetzwerk. Ein (zulässiger) Fluss f für N ist eine Abbildung

f : E → N, die folgende Bedingungen erfüllt:

41

42

KAPITEL 2. ALGORITHMEN FÜR FLÜSSE UND MATCHINGS

1. Für alle e ∈ E gilt:

0 ≤ f (e) ≤ c(e)

(Kapazitätsregel)

2. Für alle Knoten v ∈ V \ {s, t} gilt:

X

f (e) =

X

f (e)

e∈E + (v)

e∈E − (v)

(Erhaltungsregel), wobei

E − (v) =def {(u, v) ∈ E | u ∈ V }

E + (v) =def {(v, u) ∈ E | u ∈ V }

Für Kante e ∈ E heißt f (e) Fluss über e. Der Betrag eines Flusses f , bezeichnet mit |f |, ist

definiert als

X

f (e)

|f | =def

e∈E + (s)

Der maximale Fluss f ∗ für N ist Fluss mit maximalem Betrag:

1

1/1

s

2/2

1/1

4

1/1

2

3

5

1/1

1/2

3/3

1/2

2/2

1/3

2/2

3/3

t

1/1

6

Ziel: Berechne maximale Flüsse möglichst effizient.

Alternativer Zugang zu Nerzwerkflüssen:

Es sei N = (V, E, c, s, t) ein Flussnetzwerk. Ein Schnitt in N ist eine Partition ξ = (Vs , Vt ) mit

s ∈ Vs , t ∈ Vt , Vs ∩ Vt = ∅ und Vs ∪ Vt = V . Eine Kante e ∈ E, e = (u, v) heißt bezüglich ξ

1. Vorwärtskante gdw. u ∈ Vs und v ∈ Vt

2. Rückwärtskante gdw. u ∈ Vt und v ∈ Vs

Es sei f : E → N ein Fluss in N . Der Fluss über den Schnitt ξ = (Vs , Vt ), bezeichnet f (ξ),

ist definiert als

X

X

f (ξ) =def

f (e) −

f (e)

e Vorwärtskante

e Rückwärtskante

2.2. MAXIMALER FLUSS

1

1/1

s

2/2

43

1/1

4

1/1

2

3

5

1/1

1/2

3/3

1/2

2/2

1/3

2/2

3/3

t

1/1

6

Vs = {s, 1, 2, 6}

Vt = {t, 3, 4, 5}

Fluss über ξ = (Vs , Vt ):

f (ξ) = 8 − 2 = 6

Lemma 13:

Es sei N ein Flussnetzwerk und es sei f ein Fluss. Für jeden Schnitt ξ von N gilt |f | = f (ξ).

Beweis: Betrachte für ξ = (Vs , Vt ) den Wert

X

X

F =def

v∈Vs

e∈E + (v)

f (e) −

X

e∈E − (v)

Nach Erhaltungsregel (für alle Knoten in Vs \ {s}) gilt

X

f (e) = |f |

F =

f (e)

e∈E + (s)

Andererseits: Ist e weder Vorwärts- noch Rückwärtskante für ξ, so enthält F entweder f (e) und

−f (e) oder nichts. D.h. F = f (ξ).

Für ein Flussnetzwerk N und einen Schnitt ξ ist die Kapazität von ξ definiert als

X

c(ξ) =def

c(e)

e Vorwärtskante

Lemma 14:

Es sei N ein Flussnetzwerk und ξ ein Schnitt von N . Für jeden Fluss f gilt f (ξ) ≤ c(ξ).

Beweis: klar wegen Kapazitätsregel.

Satz 15:

Es sei N ein Flussnetzwerk. Für jeden Fluss f und jeden Schnitt ξ gilt |f | ≤ c(ξ).

2.2

Maximaler Fluss

Es sei N = (V, E, c, s, t) ein Flussnetzwerk. Es sei f : E → N ein Fluss in N . Für eine Kante

e = (u, v) ∈ E ist die Restkapazität von u nach v bezüglich f , bezeichnet mit ∆f (u, v), definiert

als

∆f (u, v) =def c(e) − f (e)

∆f (v, u) =def f (e)

wenn keine bidirektionalen Kanten im Netzwerk vorkommen.

44

KAPITEL 2. ALGORITHMEN FÜR FLÜSSE UND MATCHINGS

Es sei p ein Pfad in N von s nach t, wobei Kanten in beiden Richtungen traversiert werden

können. Die Restkapazität von e in p ist definiert als

(

c(e) − f (e) falls e Vorwärtskante in p

∆f (e) =def

f (e)

falls e Rückwärtskante in p

Die Restkapazität eines Pfades p ist definiert als

∆f (p) =def min ∆f (e)

e∈p

Ein augmentierender Pfad p für den Fluss f ist ein Pfad von s nach t mit ∆f (p) > 0, d.h.

1. f (e) < c(e) für Vorwärtskante e

2. f (e) > 0 für Rückwärtskante e

1

0/1

1/2

s

(1)

0/1

4

(1)

1/1

0/2

(1)

(1)

2

0/1

0/2

2/3

3

|f | = 3

1

2/2

5

2/3 (2)

1/2

2/3

1/1

t

s

1/2

1/1

2

0/2

2/3

6

3

1/2

0/2

1/1

(1)

0/1

4

0/1

5

2/3

1/3

2/2

t

1/1

6

|f | = 4

∆f (p) = 1

Lemma 16:

Es sei N ein Flussnetzwerk und es sei f ein Fluss in N . Für jeden augmentierenden Pfad p in N

gibt es einen Fluss f ′ mit |f ′ | = |f | + ∆f (p).

Beweis: Wir definieren f ′ : E → N wie folgt:

falls e 6∈ p

f (e)

f ′ (e) = f (e) + ∆f (p) falls e Vorwärtskante in p

f (e) − ∆f (p) falls e Rückwärtskante in p

Es gilt:

1. f ′ (e) ≤ c(e) für alle Kanten e ∈ E

2. f ′ (e) ≥ f (e) ≥ 0 für alle Nicht-Rückwärtskanten e; für Rückwärtskante e gilt:

f ′ (e) = f (e) − ∆f (p) ≥ 0

| {z }

≤f (e)

3. Erhaltungsregel gilt klarerweise.

2.2. MAXIMALER FLUSS

45

Damit: f ′ zulässiger Fluss in N mit |f ′ | = |f | + ∆f (p).

Lemma 17:

Es sei N ein Flussnetzwerk. Gibt es für einen Fluss f in N keinen augmentierenden Pfad bezüglich

f , so ist f maimaler Fluss. Darüber hinaus gibt es einen Schnitt ξ mit |f | = c(ξ).

Beweis: Angenommen es gibt keinen augmentierenden Pfad in N . Wir konstruieren einen Schnitt

ξ wie folgt: Ein augmentierender Pfad von s nach v ∈ V ist ein Pfad mit echt positiven Restkapazitäten.

Definiere

Vs =def {v ∈ V | es gibt augmentierenden Pfad von s nach v} ∪ {s}

Vt =def V \ Vs

Es gilt: t 6∈ Vs , d.h. ξ = (Vs , Vt ) ist Schnitt. Es sei e eine Kante über ξ. Dann gilt ∆f (e) = 0, d.h.

(

c(e) falls e Vorwärtskante in ξ

f (e) =

0

falls e Rückwärtskante in ξ

Dann gilt |f | = f (ξ) = c(ξ). Nach Satz 15 auf Seite 43 ist |f | maximal.

Satz 18: (Max-Flow, Min-Cut Theorem)

Es sei N ein Flussnetzwerk. Dann gilt

max

f Fluss in N

|f | =

min

ξ Schnitt in N

c(ξ)

Beweis: Folgt direkt aus Satz 15 auf Seite 43 und Lemma 17.

Satz 18 gibt Idee zu Algorithmen: Suche solange nach augmentierenden Pfaden und aktualisiere

Flüsse, bis kein augmentierender Pfad mehr existiert.

46

KAPITEL 2. ALGORITHMEN FÜR FLÜSSE UND MATCHINGS

2.2.1

Algorithmus von Ford und Fulkerson

Algorithmus Ford-Fulkerson(N )

Eingabe: Flussnetzwerk N = (V, E, c, s, t)

Ausgabe: Maximaler Fluss f in N

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

Stop := FALSE

for e ∈ E

do f (e) := 0 od

while ¬Stop

Traversiere (V, E, c) von s aus, um augmentierenden Pfad p für f zu finden

if Pfad p existiert

then ∆ := +∞

for e ∈ p do

if ∆f (e) < ∆

then ∆ := ∆f (e)

fi

od

for e ∈ p do

if e Vorwärtskante in p

then f (e) := f (e) + ∆

else f (e) := f (e) + ∆

fi

od

else Stop := TRUE

fi

od

Algorithmus 12: Ford-Fulkerson

Beispiel: Abbildung 2.1 auf der nächsten Seite

Implementierungshinweise zu Zeile 5:

Zum Finden eines augmentierenden Pfades betrachte Restnetzwerk Rf = (V, Ẽ) zum Fluss f ,

definiert als

Ẽ =def {(u, v) | e = (u, v) ∈ E, f (e) < c(e)} ∪ {(v, u) | e = (u, v) ∈ E, f (e) > 0}

Beispiel: Abbildung 2.2 auf der nächsten Seite

Damit (für Zeile 5):

• bestimme Restnetzwerk Rf zum aktuellen Fluss f

• traversiere Rf mittels z.B. Tiefensuche oder Breitensuche ausgehend von s und bestimme

Pfad von snach t

⇒ benörigen zur Bestimmung eines augmentierenden Pfades O(m) Schritte

2.2. MAXIMALER FLUSS

0/1

1

0/1

s

0/2

0/1

0/1

0/1

2

1/1

0/3

0/2

0/3

3

1/1

0/1

1/1

2/2

1/1

2/3

0/2

2/3

3

3/3

2/2

s

t

0/1

0/3

0/2

0/1

∆f (p) = 2

1/1

4

1/1

2

2/2

1/2

3/3

5

1/1

1/3

1/2

3

1/1

6

2/2

|f ∗ | = 6

|f | = 6

Abbildung 2.1: Algorithmus von Ford-Fulkerson

s

1

4

2

5

3

6

t

Abbildung 2.2: Restnetzwerk Rf für |f | = 2

•

0/k

s

0/k

t

0/1

0/k

0/k

•

•

0/k

s

1/k

t

1/1

0/k

1/k

t

6

0/2

3/3

∆f (p) = 1

3/3

5

1/1

1/1

6

2/2

|f | = 5

5

0/2

2/2

2

|f | = 3

2/2

4

1/1

1

0/2

2

1/1

3

4

0/1

∆f (p) = 1

0/3

∆f (p) = 1

1/1

1

2/2

s

t

t

6

0/2

1/1

6

0/2

|f | = 2

2/3

5

0/3

0/2

1

1/2

1/3

5

1/1

|f | = 1

0/2

0/2

2

3

0/2

4

0/1

0/3

4

1/1

2/2

1/2

s

t

∆f (p) = 1

0/1

1

0/1

6

0/2

|f | = 0

0/2

0/3

5

0/3

0/2

0/1

1

0/2

2

3

s

4

0/1

0/3

s

47

•

1/k

s

t

0/1

1/k

1/k

•

Abbildung 2.3: Kritisches Beispiel für Ford-Fulkerson

1/k

•

t

48

KAPITEL 2. ALGORITHMEN FÜR FLÜSSE UND MATCHINGS

Komplexität von Ford-Fulkerson:

In jedem Durchlauf (Zeile 5 – 20) wird Betrag des aktuellen Flusses mindestens inkrementiert,

d.h. im schlechtesten Fall |f ∗ | Durchläufe.

⇒ Algorithmus von Ford-Fulkerson benötigt O(|f ∗ | · m) Schritte

In einem kritisches Beispiel für Ford-Fulkerson (Abbildung 2.3 auf der vorherigen Seite) werden

2k Iterationen ausgeführt, dabei sind zwei genug unabhängig von k!

2.2.2

Algorithmus von Edmonds und Karp

Verwende Breitensuche zur Bestimmung augmentierender Pfade (im Restnetzwerk) und führe

genauere Analyse durch.

Es sei N = (V, E, c, s, t) ein Flussnetzwerk und es sei f ein Fluss in N . Für einen Pfad p =

(e1 , . . . , eℓ ) mit ei ∈ E heißt ℓ die Länge von p.

Für einen Knoten v ∈ V ist die Restdistanz df (v) von v bezüglich f definiert als

df (v) =def

minimale Länge eines augmentierenden Pfades in N bezüglich f von s nach v,

oder +∞, falls kein solcher Pfad existiert.

Lemma 19:

Es sei N = (V, E, c, s, t) ein Flussnetzwerk. Es seien f, g Flüsse in N , wobei g aus f hervorgeht

durch Augmentierung eines Pfades p minimaler Länge. Dann gilt für alle v ∈ V

df (v) ≤ dg (v)

Beweis: (Widerspruch)

Angenommen es gibt Knoten, für die Restdistanzgleichung nicht gilt. Es sei v ∈ V Knoten mit

dg (v) minimal unter allen diesen Knoten. D.h. es gilt

1. df (v) > dg (v)

2. dg (v) ≤ dg (w) für alle w ∈ V mit df (w) > dg (w)

Es sei q ein augmentierender Pfad bezüglich g minimaler Länge von s nach v. Es sei w der

Vorgängerknoten von v in q; es sei e die Kante in q, die v mit w verbindet. Damit gilt:

q

3. ∆g (w, v) > 0

w

s

4. dg (v) = dg (w) + 1

p

t

p

v

5. df (w) ≤ dg (w) (wegen 1. und 2.)

Zeigen zunächst ∆f (w, v) = 0. Angenommen ∆f (w, v) > 0, d.h. es gibt augmentierenden Pfad

von w nach v bezüglich f . Damit

5.

4.

df (v) ≤ df (w) + 1 ≤ dg (w) + 1 = dg (v)

zu 1.

2.3. MAXIMALE MATCHINGS

49

D.h. obere Annahme oder ∆f (w, v) = 0. Betrachte Fall, dass ∆f (w, v) = 0.

Wegen ∆f (w, v) = 0 und ∆g (w, v) > 0 (3.) muss p die Kante e von v nach w traversieren. Damit

(5.)

(4.)

df (v) = df (w) − 1 ≤ dg (w) − 1 < dg (v) − 2 < dg (v)

zu 1.

Lemma 20:

Algorithmus von Edmonds und Karp benötigt zur Bestimmung eines maximalen Flusses in Netzwerk mit n Knoten und m Kanten höchstens n · m Augmentierungen.

Beweis: Es sei fi der aktuelle Fluss vor der i-ten Augmentierung bei Edmonds-Karp, pi sei der

zugehörige augmentierende Pfad. Kante e in pi heißt Engpass von pi , falls ∆fi (e) = ∆fi (pi ).

Beachte: Jeder augmentierende Pfad besitzt einen Engpass. Wir zeigen, dass jede Kante höchstens

n-mal Engpass sein kann.

Es seien u, v ∈ V Knoten mit inzidenter Kante e ∈ E. Seien pi und pk zwei augmentierende

Pfade kürzester Länge mit i < k, so dass e Engpass ist und von u nach v traversiert wird. Damit

gilt:

1. ∆fi (u, v) > 0

2. ∆fi+1 (u, v) = 0

3. ∆fk (u, v) > 0

D.h. es gibt pj mit i < j < k, so dass e von v nach u traversiert wird. Damit gilt:

pj kürzester

Pfad

dfj (u)

=

dfj (v) + 1

Lemma 19

≥

pi kürzester

Pfad

dfi (v) + 1

=

dfi (u) + 2

Da Restdistanz höchstens n ist, kann jede Kante höchstens n-mal Engpass sein ( n2 -mal für jede

Orientierung). D.h. höchstens n · m Augmentierungen.

Komplexität von Edmonds-Karp:

• O(n · m) Augmentierungen

• O(m) pro Augmentierung für Breitensuche

⇒ O(n · m2 ) Schritte

Bemerkung: Es gibt Algorithmen, die nicht auf Max-Flow, Min-Cut

z.B.

Theorem 2basieren,

Push-Relabel-Algorithmus von Goldberg und Tarjan mit Laufzeit O n · m · log nm

2.3

Maximale Matchings

Ziel: Anwendung von Flussalgorithmen auf Matching-Probleme in bipartiten Graphen.

50

KAPITEL 2. ALGORITHMEN FÜR FLÜSSE UND MATCHINGS

Es sei G = (V, E) ein ungerichteter Graph. G heißt bipartit gdw. es gibt X, Y ⊆ V mit X ∩ Y =

∅, X ∪ Y = V und für alle e ∈ E gilt ke ∩ Xk = ke ∩ Y k = 1, d.h. ein Endpunkt liegt in X und

einer in Y .

Ein Matching in G ist eine Kantenmenge M ⊆ E mit e ∩ f = ∅ für alle e, f ∈ M, e 6= f , d.h.

Kanten in M haben keine gemeinsamen Knoten.

Matching maximaler Kardinalität heißt maximales Matching, bezeichnet M ∗ .