Head-Driven Phrase Structure Grammar. Eine Einführung

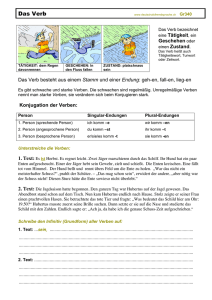

Werbung